基于HOURGLASS網絡語義關鍵點提取的光學圖像空間目標姿態估計方法

李孟錫 任笑圓 王粲雨 逄 博,2 蔣李兵 王 壯

(1. 國防科技大學自動目標識別重點實驗室, 湖南長沙 410073; 2. 杭州電子科技大學通信工程學院, 浙江杭州 310018)

1 引言

隨著人類航天活動持續活躍,以衛星為代表的航天器在數目不斷增加的同時,其所處的空間環境也變得日趨復雜。空間目標的三維姿態是反映其運動狀態的重要參數,掌握準確的空間目標在軌姿態對于判斷航天器工作狀態、開展空間在軌操作、保障空間活動和太空資產安全具有重要的意義[1- 4]。近年來,以地基大口徑望遠鏡、天基光學載荷等為代表的光學探測設備能力的不斷提升,基于光學探測設備的空間目標三維姿態估計問題越來越受到研究人員的重視[5]。

目前,基于光學圖像的空間目標姿態估計解決途徑主要可歸為兩大類:(1)建立圖像和姿態映射關系的方法[6-9];(2)根據特征關聯解算姿態的方法[10-15]。第一類建立圖像和姿態映射關系的方法通過構建目標在不同姿態下的圖像模板庫,然后將觀測圖像與模板庫進行匹配,最終確定觀測圖像中目標的姿態[6-7]。隨著深度學習被廣泛應用在各個領域,李想[8]和徐云飛等人[9]開展了將深度學習應用于空間目標姿態估計的初步嘗試,其基本做法是把姿態空間劃分成不同的子空間,從而將姿態估計問題轉換為分類問題或回歸問題。然而,此類方法大多僅從二維觀測圖像出發,其估計精度取決于姿態空間的劃分粒度。顯然,隨著估計精度要求的提升,這類方法需要更多的觀測數據以實現姿態的精細化映射。考慮到空間目標的實測數據十分有限,此類方法在估計精度上存在天然的數據瓶頸。

不同于第一類建立圖像和姿態映射關系的方法僅從二維觀測圖像出發的處理思路,第二類基于特征關聯的方法是在已知目標三維模型的前提下,建立二維觀測圖像和三維模型之間的特征關聯,然后根據特征關聯結果解算目標的三維姿態。相比于第一類方法,這類基于特征關聯的方法可解釋性強且運算效率高。然而,目前主流的基于特征關聯的方法大多都分解為特征提取和匹配關聯兩個階段進行序貫處理[12],其在面對空間目標光學圖像時,復雜多變的太空環境往往會導致觀測圖像出現降質從而顯著降低圖像特征提取的可靠性,影響后續特征關聯匹配的正確率,并最終影響姿態估計結果的準確性。

針對上述空間目標光學圖像姿態估計中存在的問題,本文提出了一種基于語義關鍵點提取的光學圖像空間目標姿態估計方法,利用Hourglass網絡端到端地提取包含語義信息的關鍵點,直接實現了光學圖像中二維特征點與目標三維實體結構的關聯映射,并在此基礎上利用EPnP算法求解待估計的目標姿態值。仿真實驗結果表明,其相比于現有方法能更好地兼顧算法估計精度和效率。

2 基于Hourglass網絡語義關鍵點的空間目標姿態估計

如前所述,空間目標姿態估計的核心問題是建立二維光學圖像特征點與目標三維實體結構的準確關聯,其本質上是一個語義關鍵點提取的問題,即所提取的圖像關鍵點中包含了與目標實體結構的映射關系。為此,本文引入深度學習領域中具備語義提取能力的Hourglass網絡,其通過特定關鍵點對應特定通道的方法能夠同時提取出關鍵點及其語義關聯信息,可以為本文所研究的空間目標光學圖像特征提取與特征關聯問題提供端到端的一步解決途徑。

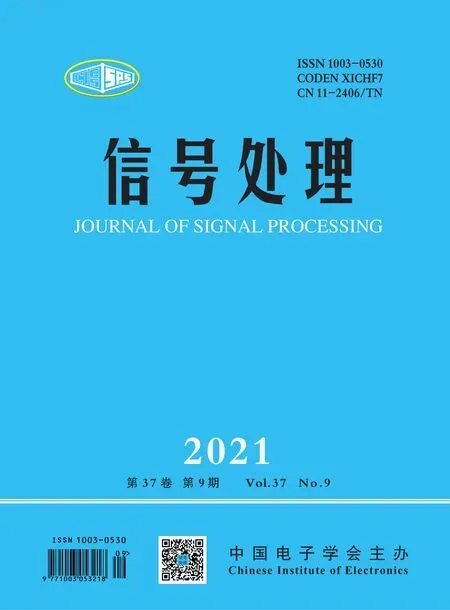

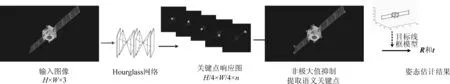

本文所提方法的基本流程如圖1所示,首先將空間目標光學圖像輸入至訓練好的Hourglass網絡,得到語義關鍵點,直接構建出光學圖像中二維特征點與目標三維實體結構的關聯映射,此時可把姿態估計問題轉換為一個PnP問題。PnP為Perspective-n-Point的簡稱,是指已知三維空間和二維圖像的n對特征點對之間的匹配關系,根據投影關系解算相機相對于目標的位姿的問題。基于Hourglass網絡語義關鍵點提取的空間目標姿態估計方法流程圖如圖1所示。

圖1 基于Hourglass網絡語義關鍵點提取的空間 目標姿態估計方法流程圖Fig.1 Flow chart of pose estimation method based on semantic key-point extraction via Hourglass network

2.1 基于Hourglass網絡的語義關鍵點提取

Hourglass網絡是一種可挖掘多尺度信息的網絡,因其結構形如沙漏又被稱為“沙漏網絡”,常被用于人臉或人體關鍵點提取任務[16]。

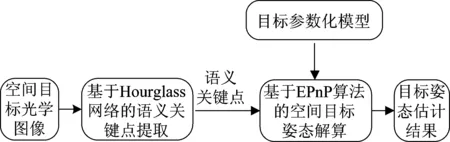

Hourglass網絡的基本組成為Residual模塊,該模塊的主要特點是在普通網絡層中加入跳躍連接,其結構為由三個卷積層串聯組成的普通網絡層,中間交替插入ReLU,其結構如圖2所示。

圖2 Residual模塊示意圖Fig.2 Schematic diagram of Residual module

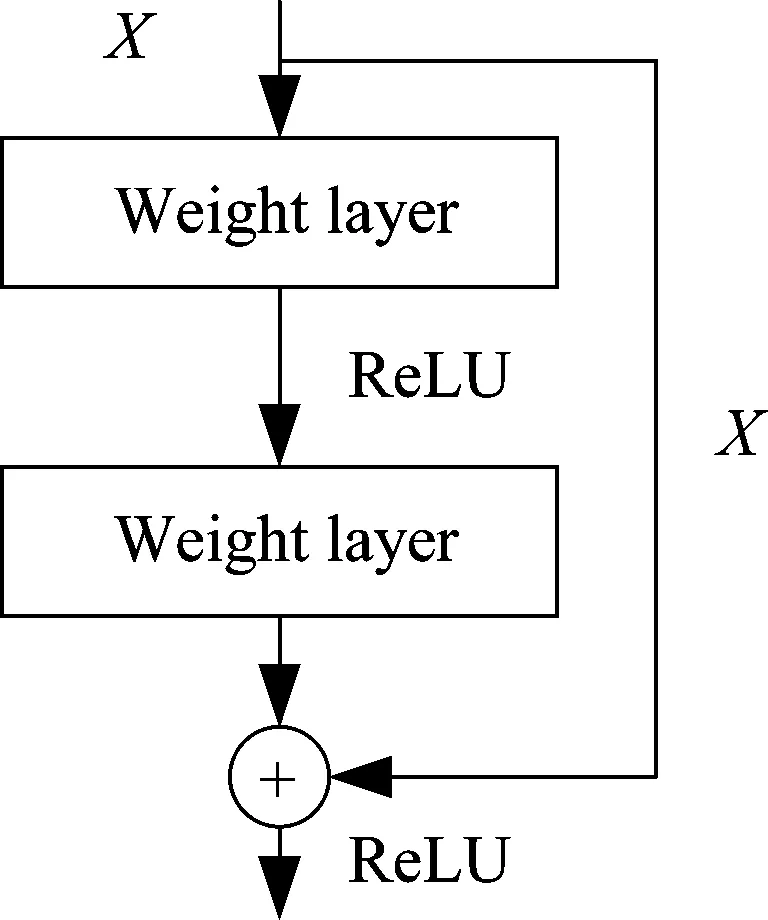

由Residual模塊可構建Hourglass模塊,二階的Hourglass模塊結構如圖3所示,其內部包含兩次下采樣和兩次上采樣的過程,這種結構的設計可讓網絡提取到不同尺度下的特征信息。

圖3 Hourglass模塊示意圖Fig.3 Schematic diagram of Hourglass module

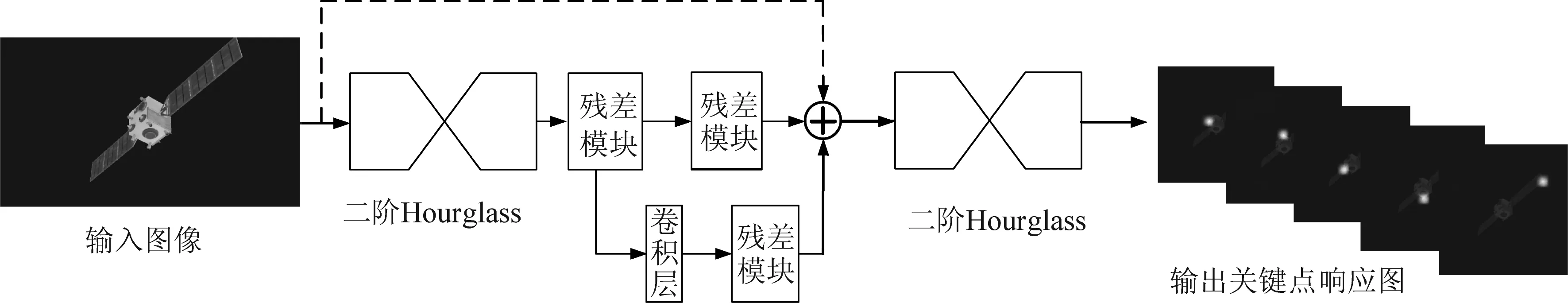

針對本文所研究的問題背景,圖4給出了本文采用的完整網絡結構,它由兩個二階Hourglass模塊堆疊形成,網絡的輸入是光學圖像,其尺寸為H×W×3。因為在網絡里有兩次降采樣的過程,所以輸出關鍵點響應圖的尺寸為輸入圖像尺寸的四分之一,為了讓提取到的關鍵點具有語義性,每個通道響應圖都只對應著特定的單一關鍵點,所以網絡最終輸出的關鍵點響應圖尺寸為(H/4)×(W/4)×n,n為目標關鍵點數量。

圖4 基于Hourglass模塊的語義關鍵點提取網絡結構圖Fig.4 Key point extraction network structure diagram based on Hourglass module

結合空間目標光學圖像的特點,在網絡訓練過程中,我們設計了基于l2范數的損失函數Loss(×),其表達式如下式所示,

(1)

2.2 基于EPnP算法的空間目標姿態解算

由2.1節Hourglass網絡提取出語義關鍵點后,便可獲得三維空間和二維圖像之間的匹配點對。此時,目標的姿態求解問題轉換為PnP問題,本文利用EPnP算法[17]求解。

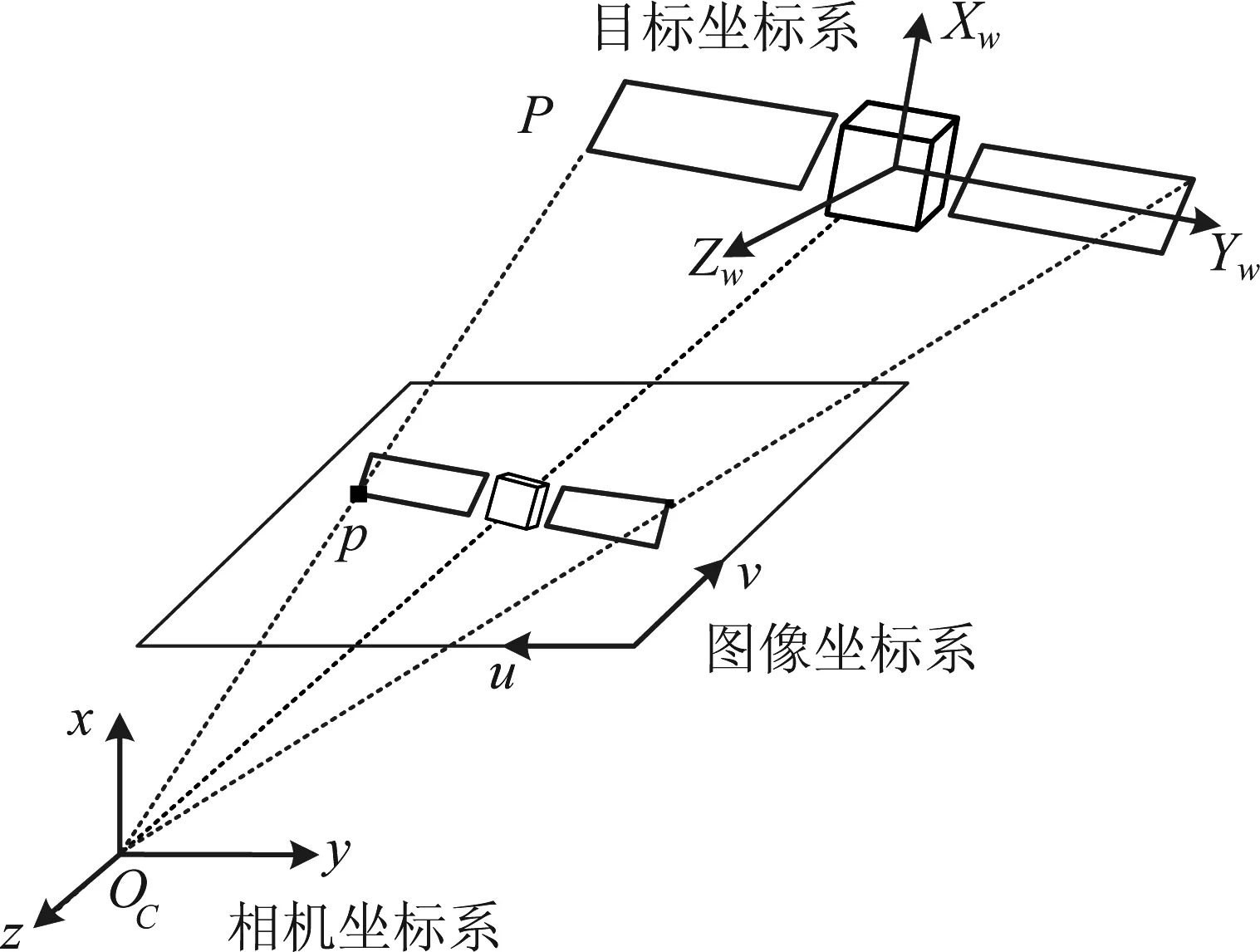

EPnP算法是目前解決PnP問題的常用方法,與其他求解方法相比其運算效率更高。EPnP的核心思想是在世界坐標系下選取四個不共面的控制點,然后根據投影模型解算出其在相機坐標系下的坐標,然后根據世界坐標系和相機坐標系下的對應點可解算出旋轉矩陣R與平移向量t。具體來說,在如圖5所示的坐標系定義下:

圖5 攝像機坐標系和目標坐標系示意圖Fig.5 Camera coordinate system and target coordinate system

設空間中某一點P在目標坐標系與攝像機坐標系下的齊次坐標分別是Xw=(Xw,Yw,Zw,1)T與x=(x,y,z,1)T,則存在以下關系:

(2)

將式(2)與經典的針孔成像模型聯立可得到式(3):

(3)

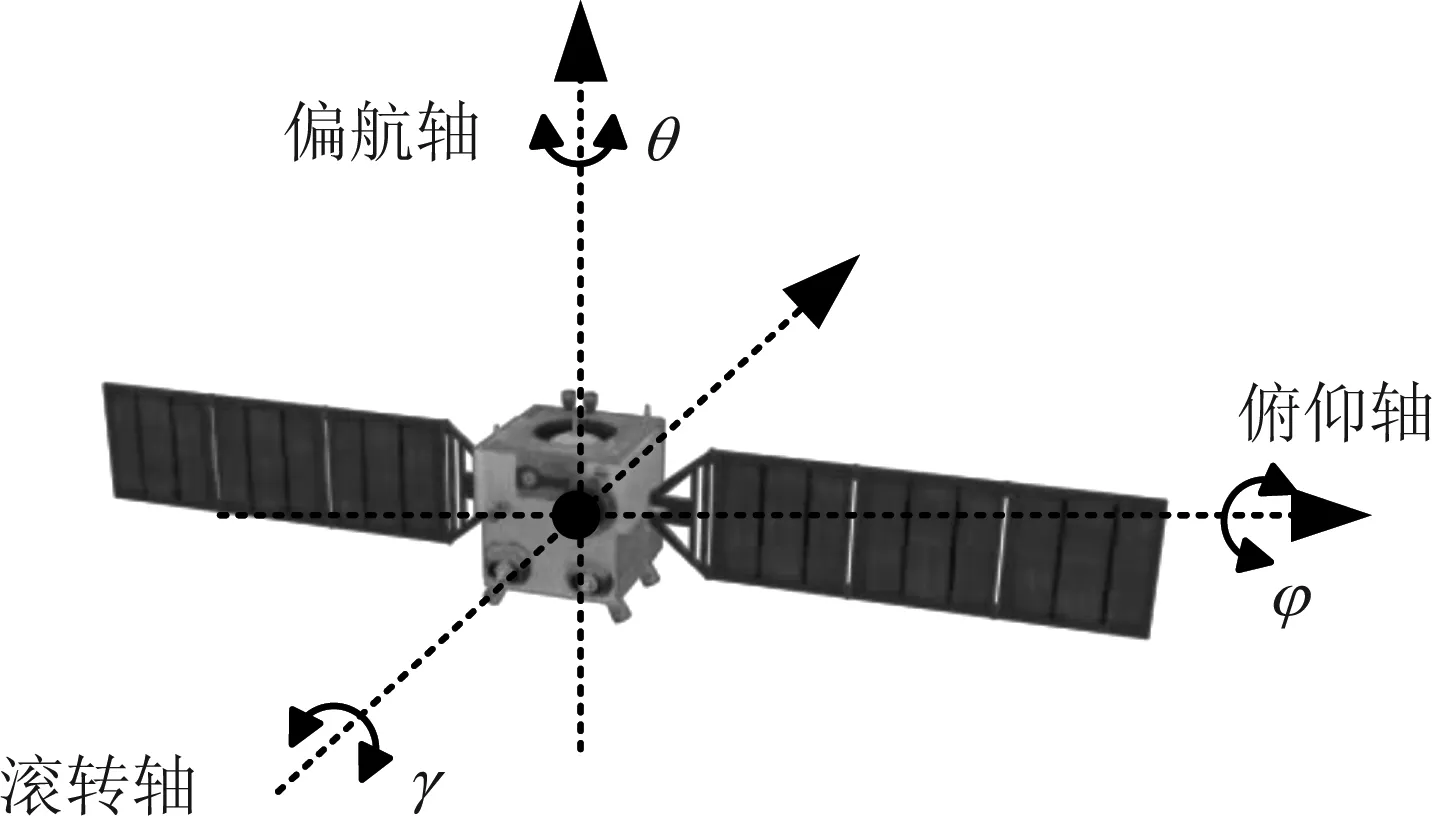

其中,K為內參數矩陣,其只與攝像機的內部參數有關;H由攝像機相對于目標坐標系的方位決定,稱為攝像機外部參數。所以對空間目標進行姿態估計的過程,就是已知攝像機的內參數矩陣求解出H中的R和t的過程。本文采用三維姿態角(俯仰角φ、偏航角θ和翻滾角γ)表示目標的三維姿態,目標三維姿態角定義如圖6所示。

圖6 三維姿態角定義示意圖Fig.6 Schematic diagram of three-dimensional attitude angle

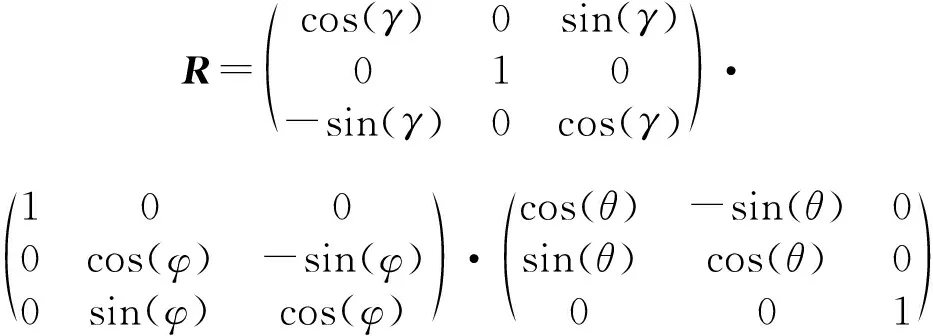

旋轉矩陣R與三個姿態角(俯仰角φ、偏航角θ和翻滾角γ)之間存在如式(4)所示的轉換關系:

(4)

(5)

(6)

獲得重心后,分別定義矩陣A和B

(7)

(8)

根據3D-3D相機位姿估計理論可知通過對H=BTA進行SVD分解便可求解姿態:

H=BTA=UΣVT

(9)

則旋轉矩陣為:

R=UVT

(10)

平移量為:

(11)

3 實驗結果與分析

3.1 實驗數據集說明

因為實測圖像數據難以獲得且對應的空間目標真實姿態無法準確獲知,所以本文利用仿真圖像構造實驗數據集來對本文姿態估計方法的性能進行驗證。

實驗數據集通過開源軟件Blender對目標三維模型進行渲染仿真得到。在數據集構造過程中,我們對目標在{φ∈(-180°,180°],γ∈(-180°,180°],θ∈(-180°,180°]}的姿態角區間內每隔10°進行采樣渲染,總共形成了46656幅仿真圖像。在得到仿真圖像后,還需要進一步標注出訓練樣本圖像的關鍵點坐標以支持網絡的訓練。以“嫦娥一號”為例,我們選取出能反映目標結構特性和部件位置的12個關鍵點,其標注結果如圖7所示。在具體的網絡訓練過程中,按照慣常做法,我們從實驗數據集中隨機挑選出其中的70%作為訓練集,剩下的30%作為測試集。

圖7 關鍵點標注示意圖Fig.7 Schematic diagram of key-point marking

3.2 實驗環境

實驗測試的硬件平臺主要參數為:Ubuntu 16操作系統,CPU為Intel(R)Core(TM)i-7800X,GPU為單塊NVIDIA GeForce GTX1080 Ti顯卡。深度網絡實現框架為Pytorch1.1.0。

3.3 姿態估計結果與分析

利用本文方法進行空間目標姿態估計的過程如圖8所示。輸入圖像首先通過Hourglass網絡得到關鍵點響應圖,關鍵點響應圖表示關鍵點在各個位置上的置信度。顯然,如果關鍵點在該位置上的置信度越高其對應的響應值也越大,所以對關鍵點響應圖進行非極大值抑制操作便能得到關鍵點的準確位置。需要指出的是,關鍵點響應圖的數目與選定的關鍵點數量相同,每個關鍵點響應圖都對應著特定語義的關鍵點(如圖8中的關鍵點響應圖第一幅結果對應著主體上方左頂點)。通過這種方式,便使得由Hourglass網絡提取到的關鍵點具有語義信息。因此,提取出語義關鍵點后便同時完成了特征提取和特征關聯的操作,最后利用EPnP算法解算出目標的姿態。

圖8 基于Hourglass網絡的空間目標姿態估計的過程圖Fig.8 Process diagram of space target pose estimation based on Hourglass network

3.3.1無降質情況下姿態估計結果對比與分析

下面給出利用本文方法進行姿態估計的定性結果圖如圖9所示。其中,圖9(a)是輸入圖像,圖9(b)是提取出的語義關鍵點,圖9(c)是根據姿態估計值把目標對應的線框模型投影疊加在圖像形成的結果。受篇幅限制,這里只展示了第一個關鍵點響應圖(對應主體上方左頂點)的結果。

圖9 空間目標姿態估計定性結果圖Fig.9 Qualitative results of space target pose estimation

對實驗結果從統計角度進行定量分析以評估算法性能優劣。設對目標三個姿態角(俯仰角、偏航角、滾轉角)的估計誤差分別為Δφ、Δθ、Δγ,而姿態真值和估計值對應的旋轉矩陣分別為Rtrue和Rest,則選用總體姿態估計誤差[18]作為誤差評價指標,其定義如式(12)所示,其表征了三個姿態角估計誤差的模距。

(12)

令平移量真值為ttrue,方法估計值為test,則平移量估計值的誤差te為:

te=|ttrue-test|

(13)

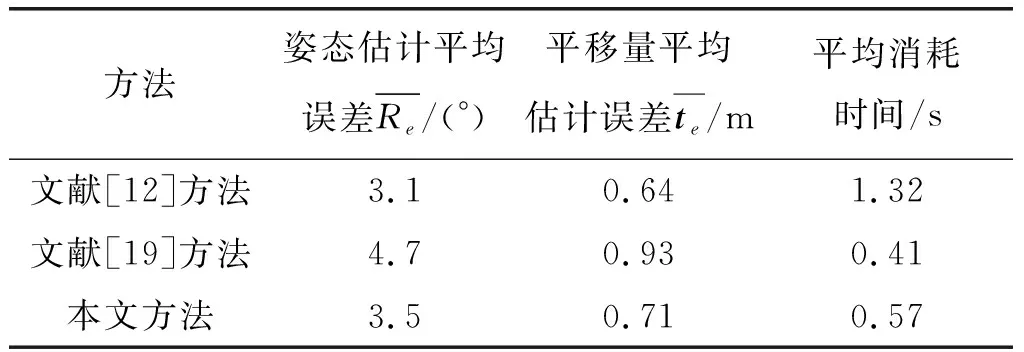

為了客觀度量本文姿態估計算法的性能,我們在3.1節所構造的仿真數據集上,不僅計算了本文姿態估計平均誤差和平均消耗時間,還挑選了[12]和[19]兩種具有代表性的基于特征關聯解算姿態的方法進行比對。其中文獻[12]使用的是點特征,基于ORB算子提取的輪廓點對圖像和目標模型進行關聯,進而求解出目標姿態;文獻[19]使用了線特征,將觀測圖像中提取的直線特征與太陽能帆板結構進行關聯,從而求解姿態的方法。在評價指標上,本文選用平均誤差作為方法的評價指標,取所有測試樣本估計誤差的平均值作為最終的誤差結果,實驗結果如表1所示。

表1 三種方法的實驗結果對比

從表中可以看出,文獻[19]方法平均消耗時間最少,因為其只包含閾值分割和直線檢測兩個步驟,通過提取帆板直線特征然后建立特征關聯,然而直線特征描述目標整體結構特征的能力有限,所以其準確率也最低,姿態估計平均誤差為4.7°。為了提高姿態估計準確率,文獻[12]通過構建候選空間的方法獲得合適姿態初值,同時還提取復雜ORB特征描述子進行特征關聯,雖然方法準確率較高,但其平均消耗時間為1.32 s,明顯慢于其他兩種方法,這說明該方法計算效率較低。本文通過提取語義關鍵點的方法同時完成特征提取和特征關聯操作進而求解姿態,在獲得了與文獻[12]準確率相當的估計結果(姿態估計平均誤差只相差0.4)條件下,其在計算效率上相比于文獻[12]有明顯的優勢(算法平均耗時僅為其一半)。其原因在于,本文方法不需要進行模板匹配以構建候選空間的耗時操作。同時,相比于文獻[19],本文方法姿態估計準確率上有較大的優勢,并且仿真實驗證明在理想條件下,其姿態估計最小誤差為0.83°,這表明本文所提的語義關鍵點算法能反映目標整體結構。綜上所述,本文方法相較于兩種方法能兼顧算法的精度和效率。

3.3.2降質情況下姿態估計結果對比與分析

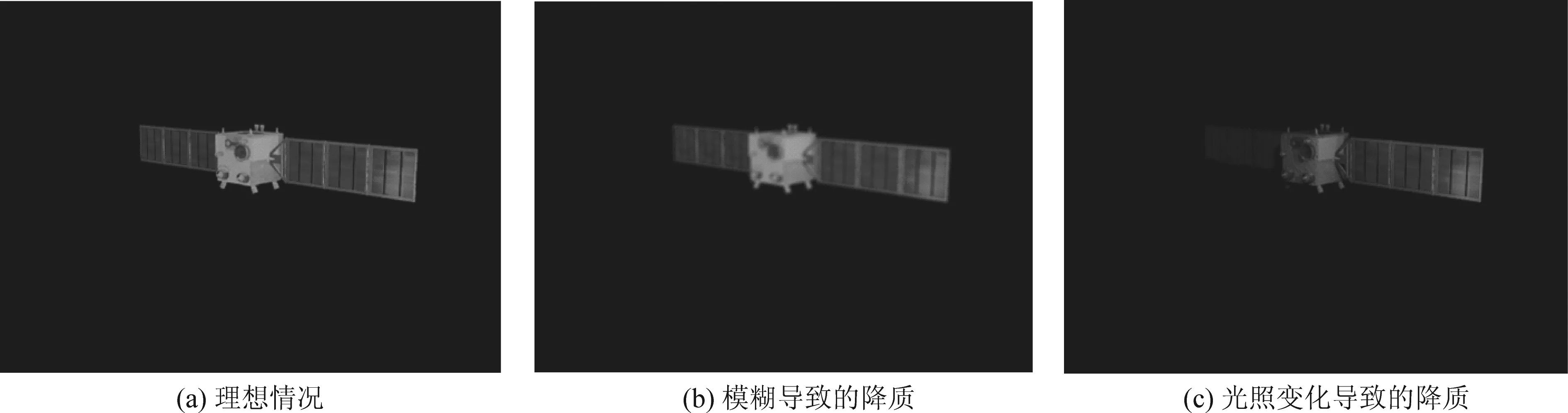

考慮太空實際觀測環境的復雜多變性,觀測圖像往往因光照變化、高速運動等因素出現降質模糊,因此,我們進一步在3.1節所構造的實驗仿真數據集上,加入不同程度的降質條件,從而進一步分析在降質情況下本文所提方法與前述兩種方法的姿態估計性能變化情況。以“嫦娥一號”為例,其由光照和運動引起的降質情況示意圖如圖10所示。

圖10 “嫦娥一號”圖像降質情況示意圖Fig.10 Images quality deterioration of “Chang’e-1”

下面再給出利用本文方法在降質條件下姿態估計的定性結果圖如圖11所示,圖11(a)是輸入圖像,圖11(b)是提取出的語義關鍵點,圖11(c)是根據姿態估計值把目標對應的線框模型投影疊加在圖像形成的結果。受篇幅限制,這里只展示了第一個關鍵點響應圖(對應主體上方左頂點)的結果。與圖9對比發現對圖像進行降質后會對姿態估計結果產生一定影響。

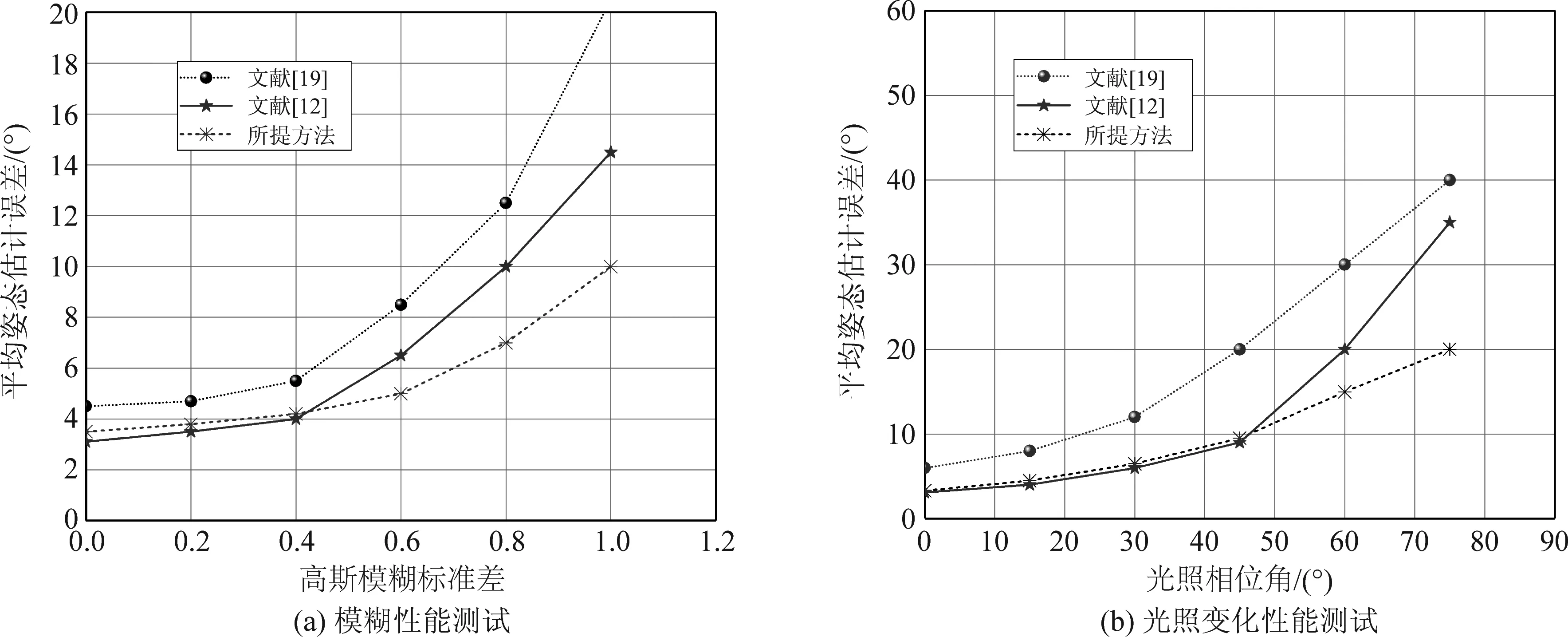

下面測試本文方法在這兩種典型的降質情況下的性能:對圖像模糊性能測試時,利用式(14)的二維高斯函數對觀測圖像進行高斯模糊處理,高斯核半徑設定為5像素,調節標準差σ從0.2到1,間隔為0.2;對光照變化性能測試時,調節光照相位角的范圍從0°到90°,當光照相位角大于90°時,目標將不可見。測試結果如圖12所示。

圖12 圖像降質性能測試結果圖Fig.12 Performance result under images quality deterioration

(14)

在模糊性能測試中,三種方法的姿態估計誤差隨著高斯模糊標準差的增大而增大,說明圖像模糊退化對所有方法均產生了影響;在沒有降質前,即高斯模糊標準差為0時,本文方法與文獻[12]姿態估計性能相當。但是,隨著模糊的增強,文獻[12]的平均姿態估計誤差開始陡增。當高斯模糊標準差大于0.6時,本文方法明顯優于文獻[12]和文獻[19](平均姿態估計誤差最大相差10°)。

在光照變化性能測試中,隨著光照相位角變大,姿態估計誤差也增加,且光照變化對姿態估計任務的影響更大,在光照變化性能測試中,隨著光照相位角變大,姿態估計誤差也增加,且光照變化對姿態估計任務的影響更大,處在不同光照相位角下的目標如圖13所示。需要指出的是,當光照相位角介于75°~90°之間時,目標主體大部分將不再清晰可見。在實際中,為了獲得較穩健的估計結果,通常選擇在穩定光照條件下(即保持目標主體基本可見)開展空間目標姿態估計任務。因此,本文的仿真實驗中側重對光照相位角在75°以內的情況進行分析。在理想光照條件下,本文方法與文獻[12]姿態估計性能相當,當光照相位角大于45°時,即目標部分“淹沒”在黑暗時,所有方法的估計誤差都開始急劇增加,在復雜多變的光照條件下,與文獻[12]和文獻[19]相比,本文方法在準確率上有明顯的優勢(平均姿態估計誤差最大相差20°)。

圖13 不同光照相位角下的目標Fig.13 Targets under different illumination phase angles

文獻[19]和文獻[12]方法受圖像降質影響較大,這是因為它們包含特征提取和匹配關聯兩個階段,而圖像降質會顯著降低圖像特征提取的可靠性,影響后續特征關聯匹配的正確率,并最終影響姿態估計結果的準確性。本文方法則端到端地提取包含語義信息的關鍵點,直接實現了光學圖像中二維特征點與目標三維實體結構的關聯映射,所以受降質影響較小。綜上所述,本文方法在降質條件下呈現出更好的魯棒性和準確性。

4 結論

本文提出了一種基于語義關鍵點的空間目標姿態估計方法,在目標結構已知的前提下估計單幅光學觀測圖像中空間目標的三維姿態。本文所提的方法旨在解決太空特殊觀測場景下特征提取性能受限而導致特征關聯誤差累積的問題,首先基于Hourglass網絡提取出能反映目標整體結構的語義關鍵點,然后用EPnP算法求解獲得目標姿態。實驗結果表明,與其他主流方法相比,本文所提方法能較好地兼顧準確率和效率,并且對因太空特殊觀測環境導致的圖像降質表現出更好的適應性。考慮更多降質因素,進一步提升網絡的泛化性能,是本文下一步工作的主要研究內容。