醫學CT影像超分辨率深度學習方法綜述

田苗苗,支力佳,張少敏,晁代福

北方民族大學 計算機科學與工程學院,銀川 750021

計算機斷層掃描(computed tomography,CT)是臨床診斷的重要輔助手段。CT影像的質量對病變診斷有非常重要的影響,高分辨率(high resolution,HR)CT 是肺結核[1]、特發性肺纖維化[2]和間質性肺炎[3]等疾病的關鍵診斷工具。并且HRCT 在鑒別肺結節良惡性方面優于常規胸部CT[4]。但由于成像設備的限制,難以獲得高分辨率醫學CT 影像,所以可以利用后處理技術獲取HRCT。

超分辨率(super resolution,SR)的概念最早由Gerchberg[5]提出用于提高超出衍射極限的光學系統的分辨率。隨著技術不斷發展,超分辨率被定義為從相應的低分辨率(low resolution,LR)圖像生成HR圖像的方法。經典圖像插值算法通過增加像素尺寸提高圖像分辨率,簡單且處理速度快,但是不能突破原有的信息量,而且由于不考慮結構信息,可能會產生偽影[6]。基于學習的SR 技術的基本思想是通過學習過程獲得先驗知識[7],該方法一般需要較少的LR圖像就能得到效果很好的超分辨率圖像,但是該算法不能隨意改變放大因子。近年來,深度學習在圖像處理的許多領域都取得了優秀的成果。深度學習用于SR問題的第一個模型SRCNN[8](super-resolution convolutional neural network)的出現,吸引了許多研究人員將神經網絡的各種變體應用到圖像超分辨率研究中。在醫學圖像超分辨率領域,Chaudhari等[9]使用SR方法從厚切片輸入圖像中生成膝蓋磁共振圖像的薄片。Dm等[10]提出使用漸進式生成對抗網絡來提高磁共振圖像質量。使用超分辨率輔助診斷已經成為近期的趨勢,例如研究人員使用基于深度學習的SR 方法來協助診斷孤立性肌張力障礙等運動障礙[11]。由于醫學成像的超分辨率技術之后通常是分割或診斷,因此增強感興趣的結構并且保存敏感信息是非常具有挑戰性的研究課題。此外,醫學圖像數據集相對較小且難以收集,尤其是臨床高分辨率和低分辨率圖像對。

一般地,圖像超分辨率重建模型可以分為三個功能模塊:輸入模塊、圖像特征提取模塊與特征圖放大重建模塊。隨著深度學習技術的發展,不斷有最新的網絡結構和學習策略被引入到醫學圖像超分辨率領域。相關研究往往通過改進網絡結構或者針對特定問題加入新的結構等手段提取更多深層高頻信息,提高輸出圖像質量。基于對現有醫學CT 影像超分辨率算法的研究,本文將從超分網絡的三個功能模塊入手,闡述基于深度學習的醫學CT影像超分網絡在結構和性能優化方面的創新與進展,通過提供結構上使用的SR 方法組件的細節來對比總結醫學CT影像超分辨率最新進展。如圖1所示為基于超分網絡結構改進的分割方法。

圖1 基于超分網絡結構改進的分割方法Fig.1 Improved segmentation method based on super-resolution network structure

本文的其余部分組織如下:本文第1、2章分別介紹了超分辨率基本理論和常用圖像質量評估準則。第3章重點論述了基于超分網絡結構改進的相關研究工作,并給出相關方法的整體總結與比較。第4 章分析了超分辨率網絡針對特定醫學領域的應用。第5 章討論了醫學CT 影像超分辨率重建方向上存在的困難和挑戰,并對未來的發展趨勢進行了總結與展望。

1 超分辨率基本理論

圖像超分辨率重建(SR)是計算機視覺領域中提高圖像分辨率的重要方法之一,能夠在不改變硬件設施的前提下,獲得高分辨率圖像。圖像分辨率技術在醫學成像、數字與場景識別、攝影以及目標跟蹤等多個領域都有廣泛應用。本章首先介紹SR 問題定義,然后依次介紹退化函數、網絡框架分類以及損失函數,為后續章節中介紹網絡結構改進提供理論基礎。

1.1 超分辨率問題定義

超分辨率是從輸入的LR 圖像中重建相應的HR 圖像。大多網絡在訓練和測試時使用的LR圖像為退化函數輸出,如公式(1)所示:

其中,t為退化函數,IHR為輸入HR 圖像,?為退化函數的輸入參數,通常是縮放因子、模糊類型和噪聲。SR問題則是退化函數的逆過程,如公式(2)所示:

其中,f為SR 函數,是輸入參數,為輸入ILR對應的估計高分辨率圖像。

最后,SR 要使損失函數最小,目標函數如公式(3)所示。為輸出HR圖像與真實HR圖像之間的損失函數,ψ(?)為正則化項。

1.2 退化函數

退化函數是指將圖像從理想超分辨率轉變為現實硬件設備生成的可能有瑕疵的圖像,常用到的退化函數如圖2所示。應用于醫學CT領域的超分辨率大多為有監督算法,一般需要利用大量LR-HR圖像對進行訓練,其中LR 圖像由HR 圖像經退化函數得到,大多數文獻會采用雙三次插值下采樣算法,但該方法在實際應用中效果不佳,因為現實世界的LR 圖像的降質過程更加復雜且未知,由于掃描時間、身體運動或者劑量限制等因素,CT圖像可能產生偽影,模糊等。

圖2 退化函數Fig.2 Degenerate function

醫學CT 超分辨率領域常用到的退化方式有四種:BI(bicubic-down)表示僅使用雙三次下采樣生成LR 圖像;BD(blur-down)為HR 圖像添加高斯模糊,然后進行下采樣;BN(bicubic-down and noise)表示雙三次插值下采樣和高斯白噪聲;DN(blur-down and noise)表示高斯模糊下采樣并在圖像中加入高斯白噪聲。

很多網絡采用雙三次下采樣結合模糊、噪聲等手段處理HR 圖像,但這并不是完美的解決方式,得到的LR圖像與現實硬件設備生成的圖像仍存在一定偏差,會影響網絡最終的訓練效果,本文在“3.1 節輸入模塊改進”中總結了一些網絡針對此類問題的思路與方法。

1.3 超分辨率網絡框架

根據上采樣模塊在模型中所處位置的不同,可以將超分網絡框架分為如圖3所示的四種框架。

圖3 四種SR框架模型圖Fig.3 Four SR framework model diagrams

1.3.1 預上采樣框架(pre-upsampling SR)

預上采樣SR框架[8]是指首先將LR圖像上采樣為所需的尺寸,再通過神經網絡重建高質量的細節,例如SRCNN[12]模型。該框架的優勢是學習難度低,并且可以將插值處理后的任意大小圖像作為輸入,效果與單尺度SR[13]模型相當。其缺點是經典的插值方法,例如雙三次插值[14]、三次樣條插值[15]等,會導致噪聲放大、圖像模糊,同時模型的計算在高維空間中進行,會顯著增加計算復雜度,時間和空間成本也隨之增加。

1.3.2 后上采樣框架(post-upsampling SR)

后上采樣[16]是指LR 圖像先被傳遞到神經網絡中,在較低維空間進行特征提取,上采樣在最后一層使用可學習層來執行。該框架在低維空間進行計算,計算成本低,降低了模型復雜度,在SR中得到了廣泛的應用。但是后上采樣無法滿足多尺度SR 的需要,并且當上采樣因子較大時,學習難度增加。

1.3.3 漸進上采樣框架(progressive-upsampling SR)

漸進上采樣是指將整個模型分為幾個階段,每個階段圖像被上采樣一次得到更高分辨率,逐步實現所需的縮放。該框架的優勢是漸進式操作降低了學習難度,獲得了更好的性能。缺點是仍然無法滿足多尺度問題,并且多階段模型設計的復雜性增加、訓練難度增加。應用漸進上采樣框架的模型有Lai 等[17]提出的LapSRN(Laplacian pyramid super-resolution network)和MSLapSRN(multi-scale Laplacian pyramid super-resolution network),Wang 等[18]提出的ProSR(progressive superresolution network)等。

1.3.4 迭代上采樣框架(iterative up-and-down sampling SR)

迭代上采樣將反向投影引入到SR中用來縮小LRHR之間的關系,迭代地進行上采樣下采樣操作,迭代使用反向投影精細化圖像,通過計算重建誤差來調整HR圖像。PBPN[19](progressive back-projection network)利用這一概念進行連續的上采樣和下采樣,利用中間生成的HR 圖像構建最終圖像。SRFBN[20](super-resolution feedback network)將迭代上采樣與密集連接層結合,能夠更好地挖掘LR-HR 圖像對之間的深層關系,從而提供更高質量的重建結果。反向投影機制剛剛被引入到該領域,具有很大的潛力,需要進一步探索。

1.4 損失函數

損失函數是網絡模型的重要組成部分,一般用于測量網絡重建誤差并指導模型優化。本節主要研究醫學CT超分辨率領域廣泛使用的損失函數。

1.4.1 像素損失(pixel loss)

像素損失是用來度量兩幅圖像之間的像素級差異,主要包括L1損失(即平均絕對誤差)和L2損失(即均方誤差):

其中,h、w和c分別是圖像通道的高度、寬度和數量。像素損失的目標是使生成的HR圖像I在像素值上足夠接近真實圖像I,L1損失計算的是實際值與目標值之間絕對差值的總和,L2 損失計算的是實際值與目標值之間絕對差值的平方總和。與L1 損失相比,L2 損失可以對大的損失進行懲罰,但更能容忍小的誤差,因此經常導致圖像過于平滑,所以在近期的網絡模型中使用L1損失更多。

在超分辨率領域,峰值信噪比是應用最廣泛的評價指標之一,最小化像素損失可以使峰值信噪比最大化,因此像素損失也得到普遍應用。然而,由于像素損失沒有考慮到圖像的感知質量、紋理細節等,因此結果通常缺乏高頻細節且紋理過于平滑。

1.4.2 感知損失(perceptual loss)

感知損失是使用預先訓練的特征提取器的特定層來最小化特征空間中的均方誤差,常用到的有VGG(visual geometry group)、ResNet(residual network)等,利用卷積層抽象高層特征,從更高維度感知圖像,能夠更準確地模擬人對圖像的感受,基于VGG 的感知損失公式如下:

其中,Cj、Hj、Wj為特征圖的通道數、長度和寬度,?是預先訓練的VGG模型,j表示?的特定層特征圖。

與像素損失不同的是,感知損失追求輸出圖像在視覺上與目標圖像相似,而不是迫使圖像精確匹配像素。感知損失可以獲得更好的視覺效果,被廣泛應用于超分辨率重建領域。

1.4.3 對抗損失(perceptual loss)

生成對抗網絡(generative adversarial network,GAN)具有強大的學習能力,在各種視覺任務中應用廣泛。GAN在訓練過程中,交替執行兩個步驟:固定生成器并訓練鑒別器更好地進行識別;固定鑒別器并訓練生成器得到與目標圖像更接近的圖像。基于交叉熵的對抗性損失公式如下:

其中,Lgan_ce_g和Lgan_ce_d分別表示生成器和鑒別器的對抗性損失,Is表示真實HR圖像中隨機采樣的圖像。

基于最小二乘誤差的對抗性損失可以實現更穩定的訓練過程和更高質量的結果[21],如下所示:

廣泛的MOS測試表明,使用對抗性損失訓練的SR模型與使用像素損失訓練的模型相比產生了較低的PSNR,但是在感知質量方面有顯著的提高[22]。為了得到更好的感知效果,許多模型采用多種損失函數,但組合型損失函數目前并無最優解,還需繼續探索研究。本文在“3.4 節損失函數改進”中討論了近期的醫學CT 超分辨率重建模型使用的各種組合型損失函數。

2 圖像質量評估準則(image quality assessment,IQA)

對SR模型性能進行評定,可以減少選擇的盲目性,而且對創新SR模型和算法具有科學的指導意義。圖像質量評估主要分為主觀評估和客觀評估,本章將介紹醫學CT超分辨率模型中常用到的評價指標。

2.1 主觀評價

主觀評價就是從人的主觀感知來評價圖像的質量,力求能夠真實地反映人的視覺感知。根據是否有真實HR 圖像作為標準參考圖像,可以將其分為相對主觀評價指標和絕對主觀評價指標。相對評估經典方法有平均意見得分(mean opinion score,MOS)[23]、絕對評估常用到的是平均意見排名(mean opinion rank,MOR)[24]。表1所示為兩種主觀評價指標的評價尺度。

表1 主觀評價指標的評價準則Table 1 Evaluation criterion of subjective evaluation indexs

雖然主觀評價能夠根據人眼的感知,直觀并較精確地評價圖片質量,但是費時費力,不能動態地調整參數,還會受到觀看距離、顯示設備、觀測者的視覺能力、情緒等各種因素的影響。因此,能夠自動精確地評價圖像質量的數學模型是有必要的。

2.2 客觀評價

客觀評價是使用某種特定的數學模型給出參考圖像和評估圖像之間的差異量化值,具有自動化及不受主觀因素影響的優點。使客觀評估算法與人的主觀質量判斷相一致,是圖像質量評估研究的重點。

(1)峰值信噪比(peak signal-to-noise ratio,PSNR)

峰值信噪比借助均方誤差(mean squared error,MSE)來計算圖像重建情況,MSE用于檢測重建后的圖像和真實圖像的相似度。一般PSNR 的范圍在20 到40之間,其值越大代表重建圖像與參考圖像越接近。

其中,y為真實圖像,x為模型重建圖像,N為圖像的像素個數,L為圖像的最大像素值,一般為255。

PSNR計算速度快,使用方便,是目前圖像處理領域應用最廣泛的評估指標之一。但其局限性也非常明顯,PSNR 是基于逐像素點的,即圖像中的每個像素點對圖像質量結果輸出的權重是相同的,這不合理;同時,人的視覺系統對于亮度信息的敏感度是強于色度信息的,以上因素導致PSNR給出的結果不夠接近人眼的直觀感覺。

(2)結構相似性(structural similarity index,SSIM)

結構相似性[25]通過比較參考圖像內的對比度、亮度和結構細節來衡量圖像之間的結構相似度,用圖像均值作為亮度的估計、標準差作為對比度的估計、協方差作為結構相似程度的度量。SSIM的范圍為0到1,當兩張圖像完全一樣時,SSIM的值等于1。

其中,μx是x的平均值,μy是y的平均值,是x的方差,是y的方差,σxy是x和y的協方差,C1和C2是用來維持穩定的常數,l是像素值動態范圍。

SSIM 基于人類對圖像中結構信息的感知,改進了PSNR的缺點。但是當圖像出現位移、縮放、旋轉等非結構性失真時,SSIM 無法有效運作。當參考圖像是方差或亮度較低的醫學圖像時,SSIM是不穩定的,可能會出現不一致的結果[26]。

(3)信息保真度準則(information fidelity criterion,IFC)與視覺信息保真度(visual information fidelity,VIF)

基于信息論中信息熵基礎,互信息被廣泛用于評價圖像質量。IFC[27]和VIF[28]都是通過計算待評圖像與參考圖像之間的互信息來衡量待評圖像的質量優劣的。這兩種方法擴展了圖像與人眼之間的聯系,但是對于圖像的結構信息沒有反應。

(4)其他評價指標

均方根誤差(root mean square error,RMSE)衡量的是預測值與真實值之間的偏差,并且對數據中的異常值較為敏感。距離得分(frechet inception distance score,FID)是計算真實圖像和生成圖像的特征向量之間距離的一種度量,從原始圖像的計算機視覺特征的統計方面的相似度來衡量兩組圖像的相似度。如果FID 值越小,則相似程度越高,最好情況即是FID=0,兩個圖像相同。

3 醫學CT影像超分辨率網絡

本章將從面向網絡結構的改進出發,系統介紹近期基于深度學習的醫學CT影像超分辨率網絡的相關研究工作,詳細闡述每個功能模塊的改進目的及其實現方法,將常規結構與改進結構進行對比總結,通過提供結構上使用的SR 方法組件的細節來對比總結醫學CT 影像超分辨率最新進展。如圖4 所示,根據LR 圖像生成SR 圖像的過程,按照輸入模塊改進、特征提取模塊改進、放大重建模塊改進、損失函數改進以及其他結構改進依次展開。

圖4 超分網絡模塊改進Fig.4 Improvement of super resolution network module

3.1 輸入模塊改進

超分辨率網絡一般需要利用大量LR-HR圖像對進行訓練,大多數文獻采用雙三次插值將高分辨率圖像處理為低分辨率圖像,但這種數據集處理方法在實際應用中效果不佳,因為現實世界的LR 圖像的降質過程更加復雜且未知。本節將從對輸入的LR圖像進行處理和添加額外信息這兩個方面介紹對輸入模塊的改進。

3.1.1 處理LR圖像

獲得清晰結果的一種廣泛使用的方法是使用固定的標準偏差添加高斯模糊。與其他方法不同,為了避免過擬合到一個固定的標準偏差,Georgescu 等[29]使用隨機標準差的高斯模糊平滑輸入,獲得更清晰的圖像。

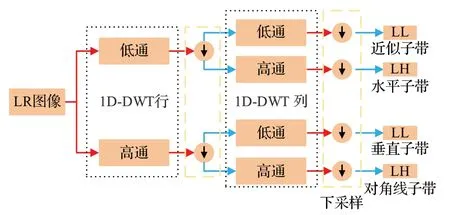

小波變換是指利用高頻子帶和低頻子帶中的全局結構信息高效地表示紋理。在SR 中使用小波變換,利用插值后的LR 小波子帶生成HR 子帶的殘差,而反小波變換則對HR 圖像進行重構。Amaranageswarao 等[30]利用小波變換捕捉LR圖像的不同方向高頻內容。小波變換在每個分解層產生對應不同頻率分量的四個子帶,分別是近似子帶和不同邊緣方向子帶(水平、垂直和對角線),捕獲圖像在不同方向上的結構信息,可以有效利用圖像的結構信息來推斷缺失的細節。一級小波分解的濾波器組運算框圖如圖5所示。

圖5 一級小波分解的濾波器組運算框圖Fig.5 Block diagram of filter bank analysis for level-1 2D-DWT decomposition

3.1.2 添加額外信息

Gu等[31]提出的MedSRGAN(medical images superresolution using generative adversarial networks),引入了一個均值為零、單位變化的隨機高斯噪聲作為額外的擾動通道,使網絡的特征映射具有一定隨機性,幫助網絡在同質區域更能自適應地生成更可行的模式。Kudo等[32]將包含身體部位信息的切片條件和參數尺度退化的虛擬薄圖像輸入鑒別器,使其可以對不同的身體部位進行調節。EDLF-CGAN[33](edge detection loss functionconditional generative adversarial networks)采用亮度和對比度作為輸入輔助條件,以解決紋理不合理的問題,提高圖像精度。

本小節介紹的方法均為基于退化模型的方法,雖然有助于模型獲得更清晰的圖像,但是真實的退化模型難以模擬,使用合成數據不能準確評估超分辨率模型在實際醫學應用中的性能。但是基于退化模型的方法并不是沒有意義的,Ji[34]等通過從真實世界的圖像對學習一組基本模糊核和相應的像素權重,開發了一個有效的退化框架,并贏得了NTIRE 2020真實世界圖像超分辨率挑戰[24]。基于退化模型的超分辨率的卓越性能表明,這種方法是解決真實世界SR的可行方案。

3.2 特征提取模塊改進

為了針對性地解決不同的問題,常常會采用多種網絡結構相結合的方式。特征提取模塊的改進一種是基于現有的殘差結構、密集連接以及注意力機制等進行改進或組合來達到更好的效果;另一種則是針對特定任務在模塊加入新的網絡設計如群卷積、信息蒸餾等。

3.2.1 基本塊變體

特征提取模塊由大量特征提取基本塊組成,最常使用的基本塊有殘差塊、密集連接塊以及嵌套殘差的密集連接塊,其中殘差塊在特征提取中具有較好的性能,所以許多超分辨率模型都會采用殘差塊作為網絡的一個基本單元。針對特征提取模塊中的殘差塊及殘差結構進行改進是醫學圖像超分辨率領域被廣泛采取的改進方法。

本小節主要針對特征利用不足的問題,對特征提取基本塊結構進行梳理總結,討論每個基本塊的創新與優勢。根據常見基本塊結構可將其分為五個小類進行闡述,分別是:殘差塊改進、嵌套殘差的密集連接塊改進、殘差結構與注意力機制結合、殘差結構與上投影下投影塊結合以及U-Net架構。

殘差結構有助于解決梯度消失和梯度爆炸問題,增強網絡學習能力,在訓練更深網絡的同時保證良好的信息。針對殘差塊進行改進的網絡有:You 等[35]在GANCIRCLE(GAN constrained by the identical,residual,and cycle learning ensemble)中將殘差塊的ReLU 替換為LeakyReLU進行非線性處理,以改善評價指標,并結合跳躍連接提取局部和全局的圖像特征。基于此模型,Jiang等[36]將16個相同的殘差塊采用跳躍連接迭代的學習上一層的輸出,并應用并行1×1卷積運算來降低每個隱藏層輸出的維數,使網絡訓練更加流暢。Jiang等[37]將SRGAN(super-resolution generative adversarial networks)殘差塊的普通卷積替換為空洞卷積,并去除了BN(batch normalization)層。在SR 任務中,BN 層會產生偽影,限制泛化能力。這樣既能充分利用圖像信息,又能最大限度地保留超分辨率后圖像的語義信息。

密集連接使特征和梯度的傳遞更加有效,能夠有效縮減模型大小,減輕梯度消失現象。針對嵌套殘差的密集連接塊改進的模型有:WCRDGCNN[30](wavelet based novel cross connected residual-in-dense grouped convolutional neural network)中使用交叉連接密集分組卷積塊作為基本模塊,該模塊包含14個交叉連接的分組卷積,上下分支層之間交叉連接,有助于學習不同的特征集,避免更深層次網絡中的特征冗余。Zhang 等[38]提出新的輕量化多重密集殘差塊結構,與RDN[39](residual dense network)不同的是,該結構在殘差塊外采用密集連接,盡可能地保持了重建圖像的全局信息,該結構不僅實現了CT 影像特征復用,保證了最大程度的信息傳輸,而且減少了僅使用DenseNet或ResNet的冗余。

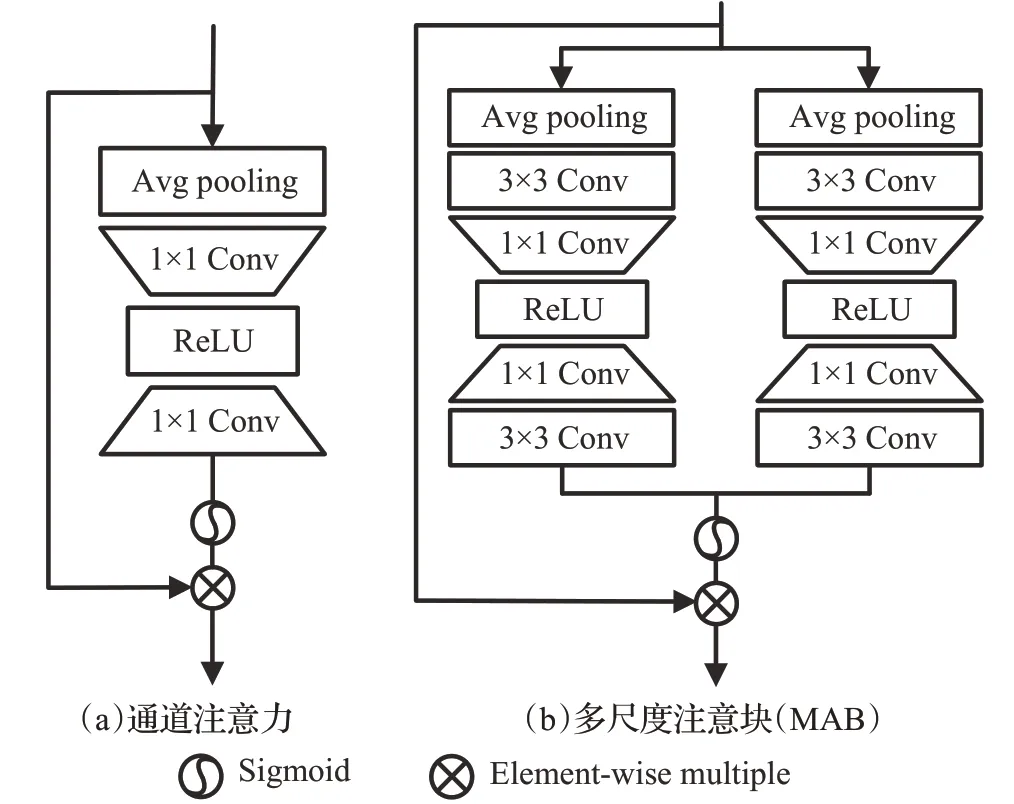

注意力機制[40]通過不斷調整權重,幫助網絡關注局部信息,權重越高表示對重要信息越關注。多尺度學習是在不同尺度上使用相同的特征提取過程,來處理單一網絡下的多尺度SR問題。信息蒸餾結構采用通道分裂操作逐步提取特征,將特征分為兩部分,一部分被保留,另一部分進行進一步的蒸餾操作,然后將兩個特征融合以獲得更多的信息,使模型可以在深度網絡中學習圖像特征,并提取特征信息。Zhao 等[41]提出的IDMAN(information distillation and multi-scale attention network)模型為了充分利用圖像的特征信息,將信息蒸餾與深度殘差網絡相結合,并且該模型使用如圖6所示的多分支多尺度注意塊(multi-scale attention block,MAB),與傳統的通道注意模塊圖6(a)相比,MAB 的多分支結構圖6(b)具有3×3和5×5分支,由于兩個分支的特征融合,可以更好地捕獲信息。通過這些改進,該模型有效地解決了特征利用不足、注意源單一的問題,提高了學習能力和表達能力,能夠重構出更高質量的醫學CT 圖像。Gu 等[31]基于RCAN[42](residual channel attention network)提出改進的殘差全圖注意網絡(residual whole map attention network,RWMAN),用于從不同的通道提取有用信息,同時更加關注有意義的區域。

圖6 傳統通道注意模塊和多尺度注意塊Fig.6 Traditional channel attention module and multi-scale attention block

Haris 等[43]提出的上投影塊和下投影塊是通過迭代糾錯反饋機制減少重構誤差,殘差結構與上投影下投影塊結合的算法有:Qiu等[44]提出的MWSR(multi-window back-projection residual networks)使用多窗口上投影下投影殘差模塊提取圖像特征,之后將幾個具有全局特征的相同連續殘差模塊進行合并,輸入到重構模塊中。MWUD結合三個窗口同時提取同一特征圖的關鍵信息,可以有效利用淺層網絡中各層的特征圖,提高高頻信息檢測的概率。Song 等[19]設計了殘差注意模塊(residual attention,RA)和上投影下投影殘差模塊(up-projection and down-projection residual,UD),如圖7的K所示。UD采用三次上采樣和三次殘差連接下采樣的方法,以最小的重構誤差提取淺層特征。RA 模塊由殘差注意塊組成,可以從LR 圖像中提取更多的深層高頻信息。在對LR 圖像特征進行多次上采樣的過程中,通過反投影和深度特征提取提高了SR重建的性能。U-Net[45]架構通過跳躍連接將高、低層次特征映射拼接,從而保留不同分辨率下的像素細節信息,使用U-Net架構的算法有:EDLF-CGAN[33]模型和Kudo等[32]提出的算法。漸進式U-Net殘差網絡PURN[46](progressive U-Net residual network)設計了雙U-Net 模塊,該模塊執行三次上采樣和三次下采樣,可以有效提取LR圖像特征,更好地學習HR和LR圖像之間的依賴關系。同時該模型在雙U-Net模塊中引入局部跳躍連接結構,在重構層中引入全局長跳躍連接結構,進一步豐富了重構HR圖像信息的流程。

圖7 特征提取模塊結構對比Fig.7 Comparison of feature extraction module structures

以上是對特征提取基本塊的分類總結,主要是為了解決特征利用不足問題,有效提取淺層深層的特征,充分利用圖像信息。殘差結構在SR特征提取中有普遍應用,使用最新的網絡結構和學習策略與殘差結構相結合提取特征是被廣泛采取的改進方法,如圖7所示為按照五個小類對特征提取模塊結構進行分類對比。

3.2.2 針對特定任務加入不同結構

本小節將介紹特征提取模塊中針對特定任務做出的創新與改進,主要分析特征增強和輕量化網絡這兩個方面的改進。

在醫學影像中,小的解剖標志和病理細節對準確的疾病分析至關重要,一般可以通過加入SE(squeeze-andexcitation)模塊[40]或者注意力模塊進行激勵,來增強目標特征、抑制無關特征。

SE 塊是通過顯式的模擬通道之間的相互依賴關系,自適應地重新校準通道特征響應。Bing等[47]改進了原始的SE 塊[40],如圖8 所示。改進SE 塊激活函數中的殘差同時利用三層網絡的輸入輸出,只需對權重進行微調,緩解訓練過程中的困難,并且有效改善了尺度小于1的多次乘法導致的特征弱化問題。

圖8 改進SE塊Fig.8 Improved SE block

IDMAN[41]模型使用多分支多尺度注意塊(MAB),MAB采用3×3和5×5兩個分支的特征融合,可以更好地捕獲信息,有效地解決注意源單一的問題。RWMAN[31]基于注意力機制,使用了1×1卷積和Sigmoid激活函數,有助于模型自適應地放大或降低每個像素的效果。Yu等[48]使用的TAB(through-plane attention block)利用體積數據的空間位置關系,達到了較好的性能。Kudo等[32]在鑒別器中增加了自注意力層,加速了對抗性訓練的收斂。

輕量化網絡(lightweight network,LN)[49]指的是通過設計緊湊的結構或者使用輕量化策略來減少網絡參數量,提升網絡速度,并保持或提升原有網絡性能的一種高效網絡,是對性能和效率的一種權衡。

VolumeNet[50]使用輕量級Queue 模塊,主要由可分離的二維跨通道卷積構成。分解的3D卷積最初通過1×1×1 卷積將通道從S減少到R,然后來自三個軸的1D卷積對所有通道的特征進行卷積,最后一層使用1×1卷積將通道從R增加到T。Queue 模塊通過減少參數數量來加快處理速度,并通過深化網絡提高精度。

Zhang 等[38]使用的輕量化多重密集殘差塊結構,減少殘差單元數量,建立密集連接,最大限度保證信息傳輸。Jiang等[37]和Qiu等[44]使用了空洞卷積,可以在沒有池化層(池化層會造成信息丟失)和等量參數的情況下提供更大的接受域,使每次卷積輸出包含更大范圍的信息,充分利用圖像信息,最大限度地保留超分辨率后的圖像語義信息。VolumeNet[50]和WCRDGCNN[30]都使用了群卷積來減少訓練參數,解決內存不足的問題。

3.3 特征圖放大重建模塊改進

特征圖放大重建模塊負責對特征圖進行上采樣并還原為超分辨率圖像,由上采樣和特征圖重建組成。

3.3.1 上采樣方式

不同上采樣方式對網絡模型性能有很大影響,上采樣方式可以分為基于線性插值的上采樣和基于深度學習的上采樣。下述為醫學CT超分辨率重建領域常用的上采樣方法。表2為這些上采樣方法的優缺點對比。

表2 常用上采樣方法對比Table 2 Comparison of commonly used upsampling methods

線性插值方法在超分領域應用廣泛,其中最常用的就是雙三次插值方法[14]。雙三次插值是利用待采樣點周圍16個點的灰度值作三次插值,不僅考慮到4個直接相鄰點的灰度影響,而且考慮到各鄰點間灰度值變化率的影響。與其他插值方法相比,雙三次插值可以得到更平滑的邊緣,效果更佳,但也導致了運算量急劇增加。基于插值的上采樣只能通過圖像本身內容提高圖像的分辨率,并沒有帶來更多信息,并且有噪聲放大、計算復雜度增加以及結果模糊等副作用。

端到端學習層被稱為亞像素層[51],通過對卷積產生的多個通道進行重新洗牌[51]操作實現上采樣,如圖9所示。該方法具有廣泛的感受野,提供了更多的上下文信息以幫助生成更多逼真的細節。然而,由于感受野的分布是不均勻的,并且塊狀區域共享相同的感受野,因此可能會導致不同塊的邊界附近出現一些偽影,并且獨立預測塊狀區域中的相鄰像素可能會導致輸出不平滑。

圖9 亞像素層Fig.9 Sub-pixel layer

反卷積也叫轉置卷積(transpose convolution)[52],通過插入零值,進行卷積來提高圖像分辨率。如圖10 所示為比例因子為2,卷積核為3×3 的反卷積層。由于反卷積在保持與卷積兼容的連接模式的同時以端到端的方式放大了圖像大小,因此它被廣泛用作SR 模型的上采樣層。然而,該層很容易在每個軸上引起“不均勻重疊”,并且兩個軸上的相乘結果進一步創建了大小變化的棋盤狀圖案,損害了SR性能。

圖10 反卷積層Fig.10 Deconvolution layer

元上采樣[53]以任意上采樣因子放大LR 圖像,具體來說,對于HR圖像上的每個目標位置,此模塊將其投影到LR 特征圖上的一個小塊,根據密集層的投影偏移和縮放因子預測卷積權重并執行卷積。該方法能以任意因子連續放大單個模型,性能可以超過使用固定因子的模型,并且預測權重的執行時間比特征提取所需總時間少100 倍[53]。但是,該方法基于與圖像內容無關的多個值來預測每個目標像素的卷積權重,因此當放大倍數較大時,預測結果可能不穩定且效率較低。MIASSR[54](medical image arbitrary-scale super-resolution)設計的meta-upscale 模塊由兩個全連接層和一個激活層組成。它根據輸入的比例因子預測一組權重,利用矩陣乘法實現特征圖放大。然后由放大后的特征圖生成超分辨率圖像,實現了醫學圖像的任意尺度超分辨率。

EDLF-CGAN[33]模型采用快速上卷積實現上采樣操作,在使用5×5 卷積核的卷積操作中,有很大一部分操作是在0 的數據上操作的,很浪費時間,因此把原來的5×5卷積核分為四個不同的小尺寸卷積核,在得到相同效果的同時用時很少,大大降低了網絡的棋盤效應。

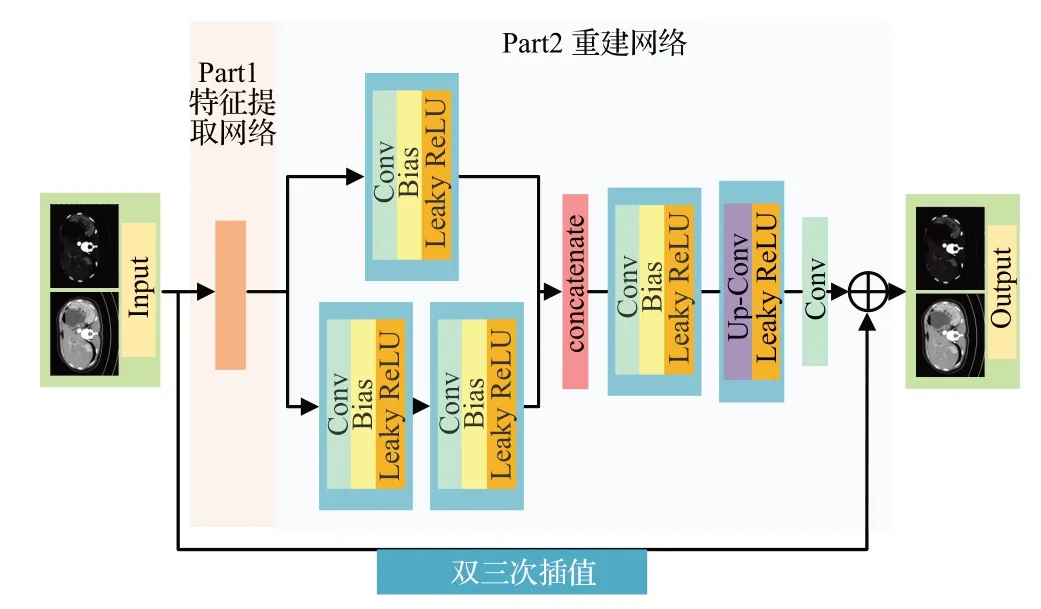

3.3.2 重建結構改進

GAN-CIRCLE[35]模型的重建部分如圖11所示,該模塊使用網中網結構,兩個重建分支A、B 合并為C,提高網絡非線性能力,使其可以學到更復雜的映射關系。de Farias 等[55]提出的CT SR 病灶聚焦框架也使用了網中網結構來增加非線性并降低濾波器空間維數,以實現更快的計算。

圖11 GAN-CIRCLE特征重建結構Fig.11 GAN-CIRCLE feature reconstruction structure

3.4 損失函數改進

損失函數是網絡模型的重要組成部分。相較于之前只使用一種損失函數的方法,多種損失函數的組合已表現出明顯優勢,能給圖像帶來更好的感知效果[56]。但組合型損失函數目前并無最優解,仍需繼續探索。本節介紹醫學CT超分辨率重建模型中設計的組合型損失函數及其優缺點。

Georgescu 等[29]在模型中除了計算最后一個卷積層之后的損失外,還在上采樣層之后計算了與真實高分辨率圖像的損失,中間損失迫使該網絡產生更好的輸出,更接近基本事實。

Jiang 等[37]在模型中使用平均結構相似度(mean structural similarity,MSSIM)損失代替均方誤差(MSE)損失,得到新的感知損失函數,在視覺感知方面獲得了更好的效果。MSSIM損失函數如下(N為訓練批次大小):

Bing等[47]將L1損失、對抗損失(LRG)[57]、感知損失(LVGG)[58]和均方誤差損失(LMSE)[8]組合成為一種新的融合損失,可以進一步加強對低層次特征的約束。新的融合損失如下(w1,wRG,wMSE為超參數,控制每個個體損失的權重):

MedSRGAN[31]訓練中采用了內容損失、對抗性損失和對抗性特征損失的加權總和,形成多任務損失函數。MIASSR[54]整個模型采用端到端的綜合損失函數進行訓練,包括L1 損失、對抗性損失和基于VGG 的感知損失。Jiang 等[36]將對抗損失、循環一致性損失、一致性損失和聯合稀疏變換損失結合起來形成新的損失函數,充分利用了沒有標準HR 圖像的大規模LR 訓練樣本,并以半監督的方式訓練模型。

EDLF-CGAN[33]模型采用的邊緣檢測損失函數(EDLF)可以抑制不合理紋理信息的產生,定義如下:

其中,W和H分別代表LR圖像的寬度和高度,r是下采樣因子,表示滿足條件y的原始HR圖像為HR圖像中(x,y)位置的像素值,表示滿足條件y的生成圖像,C為Canny邊緣檢測函數[59]。

3.5 其他結構改進

3.5.1 GAN模型鑒別器改進

對抗神經網絡(generative adversarial nets,GAN)[60]包含生成器和鑒別器,其優化過程是一個“二元極小極大博弈”問題。大多基于卷積神經網絡(convolutional neural network,CNN)的SR 網絡都更關注圖像質量指標而不是圖像視覺感知質量,而SRGAN 在圖像感知質量方面取得了巨大的提高。在超分辨率方面,采用對抗性學習只需將SR 模型視為生成器,并定義一個額外的鑒別器來判斷輸入圖像是否為生成圖像。GAN模型的生成器結構改進在上述章節中已經介紹,下面將介紹GAN模型鑒別器的改進。

MedSRGAN[31]模型使用圖像對(LR,HR/SR)作為鑒別器的輸入,如圖12所示,鑒別器通過將從LR和HR路徑中提取的特征映射進行拼接,學習HR/SR和LR圖像的成對信息,并輸出(LR,HR)對或(LR,SR)對作為真實數據的概率。

圖12 MedSRGAN鑒別器Fig.12 MedSRGAN discriminator

Kudo 等[32]在鑒別器網絡的第四層中增加了自注意力層,加速了對抗性訓練的收斂。De Farias等[55]提出的CT SR 病灶聚焦框架將空間金字塔池集成到GANCIRCLE[35]的鑒別器中,以處理不同的輸入CT 影像大小,用于病灶的斑塊聚焦訓練,提高了肺部CT數據集中最重要放射學特征的魯棒性。

3.5.2 Transformer結構

Transformer是一個完全基于注意的序列轉導模型,用多頭自注意取代了編碼器-解碼器架構中最常用的循環層。基于深度學習的超分辨率是提高分辨率可行的方法,其大多以在視覺任務方面表現出色的CNN 為核心,通過卷積操作提取局部特征,具有平移不變性,可以使用池化操作減少特征維度,防止過擬合。但是這類方法會受到卷積算子固有屬性的限制,使用相同的卷積核來恢復不同的區域可能忽略內容相關性,卷積算子的局部處理原理使得算法難以有效地模擬遠程依賴。與基于CNN 的算法相比,Transformer 可以對輸入域的遠程依賴進行建模,并對特征進行動態權值聚合,從而獲得特定于輸入的特征表示增強[61]。

醫學成像任務的數據集具有標注樣本少、圖像非自然的特點。在數據集稀缺的情況下,CNN和Transformer的性能都較差,標準的解決方案是使用遷移學習,模型在較大數據集(如ImageNet)上預訓練,然后在特定的數據集上進行微調,這類模型通常在最終性能和訓練時間方面都優于那些在醫學數據集上從頭開始訓練的CNN。在ImageNet 上預訓練的Transformer,在數據有限的情況下表現出與CNN 相當的性能,當自監督的預訓練之后是監督的微調時,Transformer 的表現比CNN 好[62]。這些發現表明,Transformer 在醫學圖像SR 領域有很好的前景。

Yu等[48]提出的基于自注意機制的Transformer體積超分辨率網絡(Transformer volumetric super-resolution network,TVSRN)使用非對稱編碼器-解碼器架構,為了更好地模擬可見區域和遮蔽區域之間的關系,解碼器使用了比編碼器更多的參數。并使用計算量較少的STL(swin Transformer layer)層[63]代替標準的Transformer層[64]作為基本組件,更適合于高分辨率圖像,同時使用TAB 利用體積數據的空間位置關系,達到了較好的性能。TVSRN模型結構如圖13所示。

圖13 TVSRN網絡結構Fig.13 TVSRN network structure

相關網絡從維度、亮點、數據集和評價參數這幾方面總結見表3。

表3 醫學CT影像的超分辨率面向結構優化總結Table 3 Summary of medical CT images with super resolution oriented structure optimization

4 超分網絡在醫學CT領域的應用

臨床實踐中對醫學圖像質量有很高的要求,高質量高分辨率的圖像能提高診斷決策正確性。基于深度學習的超分辨率重建算法在醫學領域有巨大的應用價值,將特定領域的醫學圖像先驗信息與深度網絡結構、損失函數以及訓練方式結合是有潛力的研究方向。本章介紹超分網絡在特定醫學CT領域的應用。

4.1 針對Covid-19的CT影像超分網絡

新型冠狀病毒肺炎(COVID-19)[70]在全球肆虐,肺部遭受病毒侵入后,常呈磨玻璃影,無明顯白色腫物改變[71]。CT 掃描是檢測COVID-19 肺炎和肺炎嚴重程度最有力、最有效的方法。Tan 等[72]提出基于SRGAN 和VGG16 的新型冠狀病毒病輔助診斷算法,有效提高了新冠病毒圖像分類精度,但模型存在較大參數量。MWSR[44]利用多窗口獲得更豐富的高低頻信息,與垂直深化網絡結構相比,這種水平擴展網絡結構可以更早地獲得完整的COVID-19 CT 圖像目標特征,但是,LR 特征空間與HR特征空間之間的特征映射關系有待優化。PBPN[19]使用殘差注意模塊和上投影下投影殘差模塊,能重構出包含更多細節和邊緣的高質量高分辨率COVIDCT 影像。PURN[46]使用雙U-Net 結構,從淺層加強特征監督,促進網絡收斂,有效提高圖像重建質量,但是該模型的任意尺度算法存在局限性。Nneji等[73]使用輕量級的孿生膠囊網絡,以VGG16預訓練網絡為骨干,共享參數和權重,用于COVID-19篩查,收斂速度快,有很好的分類效果,可以創建更合理和真實的圖像,但是模型訓練和測試數據集數量有限。Baccarelli 等[74]提出孿生殘差自編碼器的架構,利用特征向量和自編碼器恢復的SR 圖像進行遷移學習,通過有限的可訓練參數獲得更高的精度。Zhou 等[75]提出一種基于快速超分辨率卷積和修正粒子群優化的SR 算法,通過使用突變機制保證粒子的全局搜索能力和種群的多樣性。

重建的COVID-19 肺炎CT 圖像比原始CT 圖像更清晰,對比度更高,提高了AI 算法診斷COVID-19 的準確性,有效輔助COVID-19 的診斷和定量評估。目前,基于卷積神經網絡的SR 模型由于網絡結構較深,普遍存在高頻信息丟失、模型規模過大等問題。基于漸進上采樣的COVID-CT 超分辨率網絡會增加重建誤差。所以未來研究人員需要進一步優化網絡結構,設計出更好的SR重建網絡。

4.2 針對牙科CT影像的超分網絡

牙科診斷中常常會用到錐束CT來確定牙齒的三維結構,但是部分體積效應、噪聲和光束硬化[76]等會影響成像質量。Hatvani 等[77]分別利用亞像素網絡和U-Net網絡提高離體牙齒的二維錐束CT 切片的分辨率,相比基于重建的SR 方法可以更好地檢測醫學特征,但模型中使用的損失函數并不是度量感知指標的最佳選擇。在牙科中心定期進行根管治療,可以保存腐爛和感染的牙齒,其中根管長度、直徑和曲率都是規劃治療的重要因素。Hatvani等[78]提出基于張量分解的三維單圖像SR方法,使用較少的參數,具有計算優勢,可以很容易地通過視覺檢查重建結果并進行調整,但隨著迭代次數的增加,差異變得不那么結構化,一些牙齒形狀在隨機噪聲中丟失。Mohammad-Rahimi 等[79]將多個基于深度學習的SR模型應用于牙科全景X線片。SRCNN[8]可以提高放射圖像的視覺質量,但應用在根尖周X線片上對牙周骨丟失的檢測是無效的。SRGAN可以從下采樣圖像中恢復逼真的紋理,顯著提高圖像質量的MOS值,但客觀指標不一定得到改善。

應用SR模型來提高低劑量和低分辨率的牙科錐束CT 掃描的質量是有希望的。與基于重建的SR 方法相比,基于深度學習的SR 方法在質量指標和基于圖像分割的分析方面都顯示出更好的結果。但該類模型計算復雜性高且依賴于訓練集,在未來的工作中需要進一步提高網絡效率。

4.3 針對腫瘤CT影像的超分網絡

CT掃描是腫瘤診斷和治療的重要輔助手段。結直腸癌(colorectal cancer,CC)是臨床上最常見的惡性腫瘤之一,在全球惡性腫瘤發病率中排名第三,在惡性腫瘤死亡率中排名第四。Wang等[80]構建單軸超分辨率的特征增強殘差密集網絡模型用于非腹膜化結直腸癌診斷,取得了較好的效果,但是在該方法中樣本量相對較少,沒有大量樣本的前瞻性實驗。Liu 等[81]使用ResNet18 結合非局部注意機制實現膀胱腫瘤分級和分期雙重目標,有效提高了診斷準確率。Xu 等[82]提出一種用于肺癌CT 圖像重建的稀疏編碼方法,該方法解決了自相似約束導致重建圖像邊緣過于平滑和模糊的問題。Zhu等[83]提出基于雙注意機制的單幅圖像SR,該模型通過混合的空間注意力和通道注意力保留了圖像的高頻細節信息,但模型推理速度慢,不能很好地應用于工程任務。

深度學習醫學圖像超分辨率重建方法可以為腫瘤的早期診斷提供有力的技術支持。CNN的深度結構大大提高了對原始圖像的處理能力,與傳統方法相比,CNN 可以自動生成高度抽象的圖像特征,并且直接使用原始圖像獲得更準確的結果,提高了診斷效率。殘差網絡可以解決深度網絡訓練中的退化和梯度消失問題,因此通過建立相關學習模型,可以更高效、準確地捕捉相關特征,為臨床醫生選擇治療方案和指定隨訪策略提供依據。在未來的研究中要更加關注網絡輕量化,在不降低性能的情況下最大限度地提高模型的運行效率。

5 總結與展望

5.1 總結

基于深度學習的醫學CT 影像SR 重建對于醫學圖像分類、分割、融合以及特征提取等領域有重要意義。本文首先介紹了SR 基本理論和評價指標;然后重點介紹了超分網絡模型在結構和性能優化方面的創新與進展,并提煉出其優化常用到的網絡結構;最后討論了醫學CT 影像SR 重建存在的困難和挑戰,并對未來的發展趨勢進行了總結與展望。綜上,基于深度學習的SR 技術在醫學CT 領域仍有極大發展空間,仍有很多尚未完善的工作,需要更多的研究者開展富有創新性的工作。

5.2 展望

本文重點是基于深度學習的醫學CT影像超分辨率重建,有許多其他領域的超分模型對醫學CT 影像重建有參考價值。例如CT-SRCNN[84]采用級聯訓練,在逐步增加網絡層數的同時提高神經網絡精度,并且提出級聯剪裁來減小網絡規模。SAINT[85](spatially aware interpolation networks)用于提升肝臟、結腸等部位影像的層間分辨率,對于同樣層間切片數少的LR CT影像有借鑒意義。LSRGAN[86](Laplacian pyramid generation adversarial networks)使用殘差密集塊結合拉普拉斯金字塔結構實現了高縮放因子(16×)下心臟影像SR重建,抑制了重建后常出現的偽影。

基于深度學習的超分辨率重建技術在醫學圖像領域中具有廣泛的應用前景,并已經成為目前的研究熱點,但其未來發展仍面臨著許多問題和挑戰。

(1)多因素降質圖像的質量增強問題。在計算機輔助診斷系統(computer aided diagnosis,CADs)中,醫學圖像的退化通常表現為噪聲和低分辨率模糊。雖然有DCNN[87](dynamic convolutional neural networks)和雙通道聯合學習框架模型[6]提出去噪和超分辨率重構,但這方面的研究仍然很少。現有的醫學CT 影像SR 重建研究大多沒有關注去噪任務和超分辨率任務之間的相互作用,這類方法在解決實際問題時,往往效果欠佳。因此,借助深度神經網絡強大的學習能力,開展多種降質因素協同處理方法的研究,具有重要的理論意義和應用價值。

(2)基于無監督學習的超分辨率重建問題。從監督學習到無監督或半監督學習,成對數據的要求限制了監督算法的發展,而無監督或半監督學習只需要少量的匹配數據來訓練網絡,可節約獲取大量數據集的時間,直接使用現實圖像進行訓練和測試,不依靠外部數據集,更能提高模型泛化能力。因此,無監督學習有極大發展空間。

(3)網絡結構和學習策略。網絡結構設計在本質上決定了模型的整體性能。例如“上采樣方法”中所討論的四種方法各有其優缺點,需要進一步研究適用于SR模型的、適用于任何比例因子的上采樣方法。許多網絡應用注意力機制、多尺度學習、網中網結構和信息蒸餾等網絡結構提高輸出圖像質量。因此,創新網絡結構,研究開發計算成本低且能提供最佳性能的網絡架構是另一個有前途的研究方向。