面向白內障識別的臨床特征校準注意力網絡

章曉慶,肖尊杰,趙宇航,巫 曉,東田理沙,3,劉 江,4

1.南方科技大學 計算機科學與工程系,廣東 深圳 518055

2.南方科技大學 斯發基斯可信自主系統研究院,廣東 深圳 518055

3.Tomey公司,日本 名古屋4 510051

4.南方科技大學 廣東省類腦智能計算重點實驗室,廣東 深圳 518055

白內障是中國乃至全球排名首位的致盲性眼病[1],也是一種年齡相關性眼病。根據2018年屈光性白內障手術新進展國際會議報告數據顯示,中國白內障患者人數接近2億。隨著社會人口結構的老齡化進程加快,白內障患者人數將會顯著增長。在臨床上,白內障表現為眼睛的晶狀體區域出現混濁癥狀,從而導致視力受損甚至失明。根據混濁癥狀在眼睛晶狀體區域中出現的位置,白內障又可分為三種類型:核性白內障(nuclear cataract,NC)、皮質性白內障(cortical cataract,CC)、后囊性白內障(posterior subcapsular cataract,PSC)[2]。核性白內障是一種最常見的白內障類型,其臨床癥狀表現為晶狀體核性區域出現混濁。根據臨床診斷實際需求和晶狀體混濁分類系統(lens opacities classification system III,LOCS III)[3-5],核性白內障的發展可分為三個階段:正常(normal)、輕度(mild)和重度(severe)。在實際診斷過程中,眼科醫生通常基于自身經驗診斷患者的核性白內障嚴重程度,但這種診斷方式具有較強的主觀性且與醫生自身經驗、接受的臨床訓練以及領域知識有關,容易出現誤診。因此,有必要開發智能計算機輔助診斷技術提高眼科醫生診斷結果的精準性。

近年來,深度神經網絡模型已經被廣泛用于眼科疾病輔助診斷包括白內障疾病。國內學者李建強等基于眼底圖像提出了一個深度神經網絡模型用于白內障自動篩查[6]。Xu 等[7]在眼底圖像下構建了一個總體-局部集成卷積神經網絡模型用于白內障分類。劉振宇等[8]在裂隙燈圖像下提出了一個神經網絡用于核性白內障分級。然而,現有用于白內障篩查與分級的神經網絡模型設計主要出發點是提升白內障篩查與分級性能,鮮有研究工作關注神經網絡模型的可解釋性。

相較于其他常用于白內障臨床診斷的眼科影像模態如裂隙燈圖像和眼底圖像,眼前節光學相干斷層成像(anterior segment optical coherence tomography,ASOCT)是一種新型的眼科影像,其能清楚地獲取晶狀體核性區域。近年來,研究人員已經在AS-OCT影像下分析了核性白內障嚴重級別與臨床特征之間相關關系,比如像素均值和最大值,臨床統計結果表明它們與核性白內障嚴重級別之間存在強相關性[9]且相關性系數大小不同。這兩個臨床特征及其相關系數大小是眼科醫生診斷白內障嚴重級別的重要參考,可以當作一種臨床先驗知識。

注意力機制(attention mechanism)[10-12]已經在計算機視覺任務中證明其能提升卷積神經網絡(convolutional neural network,CNN)的性能。擠壓激勵注意力機制(squeeze-and-excitation attention mechanism,SE)[12]是一個具有代表性的注意力機制方法,它由擠壓和激勵操作符組成。在擠壓操作符中,SE 采用全局平均池化方法(global average pooling,GAP)從每個通道中提取特征圖(feature map)的全局均值特征表示信息,可以認為AS-OCT 影像下白內障的像素均值的另一種特征表示方式。類似的,其他特征圖的全局特征表示(最大值)也可以通過其他的池化方法(最大池化方法)提取[13]。

鑒于特征圖的全局特征表示和白內障的臨床特征如像素均值和最大值之間聯系,本文提出是否可以將這兩種臨床特征及其相關性系數轉化為特征圖的全局特征表示和特征表示權重,再將它們融入到注意力機制網絡模型設計中,以此來提升核性白內障分類結果和增強神經網絡模型決策過程的可解釋性。為此,本文基于AS-OCT 影像提出了一個基于臨床特征校準注意力網絡(clinical feature recalibration attention network,CFANet)模型自動地識別核性白內障嚴重級別,如圖1所示。在提出的CFANet 中,本文構造了一個臨床特征校準注意力模塊(clinical feature recalibration attention block,CFA),它對兩種特征圖的全局特征表示類型:均值和最大值進行動態地加權融合;隨后采用softmax函數作為門控操作符來突出了重要的通道,從而實現對每個特征圖的重要性校準。為了更好地了解CFANet的決策過程,本文采用可視化技術來分析臨床特征的權重分布和通道的權重分布。另外,本文還探索了其他影響CFANet 分類性能的因素,比如門控操作符種類和臨床特征表示的加權方式。本文的主要貢獻為以下三個方面:

圖1 基于CFANet的自動白內障分類框架Fig.1 Automatic cataract classification framework based on CFANet

(1)本文提出了一個臨床特征校準注意力網絡框架自動地識別核性白內障嚴重級別。在提出的CFANet中,本文引入了一個臨床特征校準注意力模塊對臨床特征表示:均值和最大值進行自適應地加權融合,并應用門控操作符來突出重要的通道和抑制不重要的通道,以此來提高核性白內障嚴重級別預測結果的準確性。

(2)在一個臨床AS-OCT數據集和公開OCT數據集上進行實驗,實驗結果表明CFANet 的性能明顯優于先進的注意力機制網絡和已發表的研究工作。

(3)本文不僅分析了CFA中臨床特征表示權重和通道權重的相對分布,同時還對比了CFA、SE、ECA、SRM的權重分布,以此來增強模型決策過程的可解釋性。同時也設計了有關消融實驗探索影響模型性能的因素。

1 相關工作

1.1 基于AS-OCT影像的眼科疾病診斷研究現狀

AS-OCT 是一種OCT 成像技術,它具有速度快、用戶友好、非侵入、高分辨率、定量化測量等特點。近年來,眼科醫生和研究人員已經基于AS-OCT影像對多種眼科疾病進行臨床診斷和科學研究如角膜疾病、青光眼和白內障。文獻[14-15]在AS-OCT 影像下利用深度分割神經網絡對角膜結構進行分割,并得到不錯的分割結果。Fu等[16-17]在AS-OCT影像下設計了一個多尺度神經網絡對開閉角青光眼進行自動篩查,并在一個臨床AS-OCT 數據集上取得了超過92%的準確率。在白內障診斷方面,AS-OCT影像與其他眼科影像相比例如裂隙燈影像,它能獲取完整的晶狀體結構信息,如囊性區域、皮質性區域和核性區域,這是診斷不同類型白內障的重要基礎,這也引起了研究人員的關注和興趣。Chen等[18]在LOCS III 分級系統上研究核性白內障級別與AS-OCT影像中均值特征的相關關系,臨床統計結果分析顯示兩者存在較強相關性。

文獻[19-21]在AS-OCT 影像下利用斯皮爾曼等級相關系數方法分析了像素均值和最大值與核性白內障嚴重程度之間相關性,統計分析結果顯示這兩種像素特征均與核性白內障級別存在較強相關性但它們的相關系數大小不同。以上基于AS-OCT 影像的核性白內障臨床研究工作為核性白內障的自動分類工作提供了臨床支持和依據。文獻[22]使用深度分割網絡模型對ASOCT影像的晶狀體結構進行自動分割,得到晶狀體的核性區域、皮質性區域和囊性區域,可用于輔助醫生基于AS-OCT 影像診斷不同類型白內障。Zhang 等[23]基于AS-OCT 影像提出了一個GraNet 網絡模型用于核性白內障自動分類,但準確率沒有達到60%。章曉慶等[24]設計了一個AS-OCT影像下的核性白內障自動分類框架,它包括三個階段:核性區域提取、像素特征提取、特征重要性分析和分類,取得了75.53%的準確率。Xiao等[25]提出了一個門控通道注意力網絡(gated channel attention network,GCANet)用于白內障的分類并取得了不錯的分類結果。

1.2 注意力機制

注意力機制已經證明其能作為卷積神經網絡重要組成部分且能有效地提升卷積神經網絡模型在各種學習任務中的性能[26-29]。擠壓激勵注意力(SE)是一個被廣泛應用的通道注意力機制方法,它通過壓縮和激勵操作符來重構不同通道之間關系并輸出通道權重值。Wang 等[30]提出了一個高效通道注意力方法(efficient channel attention,ECA)來構建通道之間的鄰近關系以此來提升卷積神經網絡性能。Lee等[31]構造了一個風格校準模塊(style-based recalibration module,SRM)通過融合風格遷移先驗知識來提高計算機視覺分類任務性能。卷積塊注意力組件(convolutional block attention module,CBAM)[26]和瓶頸注意力組件(bottleneck attention module,BAM)[32]將通道注意力和空域注意力結合進一步增強神經網絡的特征表示。

從現有有關研究工作調研可知,已有不少基于ASOCT 影像的核性白內障研究工作和注意力機制模塊設計研究工作。然而,缺乏相關研究工作將白內障的臨床特征及其相關系數作為臨床先驗知識融入到注意力機制方法模塊設計中。為此,本文提出了一個新穎的臨床特征校準注意力模塊,其中將核性白內障的臨床診斷特征及其相關系數作為臨床先驗知識注入到注意力機制模塊設計中,用以提升核性白內障嚴重級別的分類結果和改進神經網絡模型決策過程的可解釋性。

2 臨床特征校準注意力網絡框架

2.1 臨床特征校準注意力模塊

本文提出的臨床特征注意力模塊(clinical feature attention block,CFA)由Avg-Max 操作符和特征融合(feature fusion)操作符構成,如圖2(a)所示。在Avg-Max 操作符中,本文使用全局平均池化(global average pooling,GAP)和全局最大池化(global maximum pooling,GMP)兩種池化方法分去別提取每個通道的全局均值特征表示和全局最大值特征表示當作臨床特征表示。對于任一個卷積層輸出的特征圖張量表達X=[x1,x2,…,xc]∈RN×C×H×W(其中,N代表批量大小,C代表通道數量,H和W代表特征圖的高和寬),提取到的臨床特征表示T∈RN×C×2可通過以下公式得到:

其中,Rij、Avgc、Maxc,和tc∈R2分別表示特征圖的區域大小、第c個特征圖中提取得到的全局均值特征表示、全局最大特征表示以及兩個臨床特征表示的集合。

緊隨Avg-Max操作符之后是特征融合操作符,它由通道全連接(channel fully connected,CFC)操作符和門控操作符組成。CFC 操作符作用是將臨床特征表示進行自適應加權融合并轉化為臨床特征編碼表示。CFC操作符首先對兩個臨床特征表示的集合進行動態加權融合,得到融合的臨床特征表示;隨后構建通道之間的依懶性,以上兩個步驟可通過以下公式得到:

其中,wc∈RC×2表示每個通道的可學習的權重參數,可以認為是臨床特征的相關系數另一種表達;vc∈RC×1表示臨床特征編碼表示。

在門控操作符選擇方面,為了更好突出通道之間的差異性以此實現對特征圖的重要性校準。本文采用softmax函數作為門控單元來輸出每個通道的注意力權重,其定義為:

gc表示每個通道注意力權重。在消融實驗中,本文將會對比Softmax 作為門控單元與其他函數如Sigmoid 和Tanh作為門控單元對CFA性能的影響。

最后將每個原始特征圖與通道分配權重相乘,得到加權校準后的特征圖Y=[y1,y2,…,yc]∈RN×C×H×W可用以下公式表達:

其中,yc表示第c個加權特征圖,?表示矩陣相乘運算。

為了驗證批量歸一化層(batch normalization layer,BN)[33]是否能提升本文CFA 模塊的性能。在CFA 模塊中,本文加了一個BN 層在CFC 操作符后面并命名為CFA-Variant,如圖2(b)所示。

討論:CBAM[26]已經從每個通道中提取了全局均值和最大特征表示來構建通道注意力機制和采用共享多層感知機(shared multilayer perception,S-MLP)來構建不同通道之間的關系,但忽略了不同特征表示類型的相對重要程度。Lee 等[31]提出的SRM 模塊考慮了不同特征表示類型的相對重要程度,但沒有重構通道之間的相關性。不同于已發表的注意力機制模塊設計工作,本文提出的通道全連接操作符既考慮了兩個特征表示類型的相對重要程度,也重構了通道之間的相關關系。另外本文還采用Softmax函數作為門控單元突出重要通道和抑制不重要的通道。

2.2 網絡框架

本文主要目的是將白內障的臨床特征及其相關系數作為先驗知識注入到注意力機制模塊設計中,以此來提高核性白內障的分類結果和改善神經網絡模型的可解釋性。本文采用ResNet[34]作為網絡骨架(Backbone),因為現有很多注意力機制方法都采用它作為Backbone,可以全面地驗證本文提出的方法性能。本文將提出的CFA 模塊插入到殘差模塊中構成殘差臨床先驗特征注意力組件(Residual-CFA module),如圖1 下半部分所示。本文的網絡框架是由多個殘差臨床特征注意力組件堆疊而成并命名為CFANet,如圖1 上半部分所示。本文選擇Softmax 作為分類器,因為其已經被廣泛地應用在深度神經網絡模型作為分類器;另外本文還選擇經典的交叉熵損失函數(cross entropy loss function,CE)為損失函數。

3 數據集介紹

在實驗中,本文使用了兩個眼科圖像數據集來比較:一個核性白內障的臨床AS-OCT影像數據集和一個公開OCT影像數據集。

(1)臨床AS-OCT 影像數據集。AS-OCT 影像數據集來自一本地三甲醫院,數據采集眼科設備是日本Tomey公司的眼前節OCT 儀器CASIA2。所有受試者知情數據用途并對受試者個人信息進行脫敏處理。數據集包含543名受試者(左右眼的數量分別為422和440),平均年齡為61.30±18.65。每個受試者采集了24 張影像,在經驗豐富的眼科醫生幫助下剔除了4 487張受眼瞼干擾影像,本文最終得到16 201張可用的AS-OCT影像。由于沒有基于AS-OCT影像的白內障分類標準,所有受試者的AS-OCT 影像的核性白內障標簽是通過裂隙燈圖像映射得到的。即每一名受試者都拍攝了AS-OCT 影像和裂隙燈圖像,并由三名眼科醫生基于LOCS III 給出每個受試者的裂隙燈圖像下核性白內障嚴重程度,保證核性白內障嚴重級別標簽的質量和可靠性。

考慮到同一個受試者兩只眼的白內障嚴重程度相近,本文以受試者為基本單位將數據集拆分為訓練集(training dataset)、驗證集(validation dataset)和測試集(testing dataset)。表1 為訓練集、驗證集和測試集的三種嚴重程度的核性白內障的AS-OCT影像數量分布。

表1 三種核性白內障嚴重級別分布Table 1 Distribution of three NC severity levels

(2)公開OCT數據集[35]。公開OCT數據集也稱作加利福尼亞大學圣地亞哥分校數據集(University of California San Diego dataset,UCSD),它是由加利福尼亞大學圣地亞哥分校眼科中心采集并公開的。數據集包含5 319個病人,由訓練集和測試集組成。其中,訓練集包含4種不同標記的OCT圖像:11 348張糖尿病黃斑水腫疾病(diabetic macular edema,DME)影像、37 205張脈絡膜新生血管性疾病(choroidal neovascularization,CNV)影像、8 617 張黃斑玻璃疣疾病(drusen)影像,以及26 315 正常人影像。在測試集中,四種類別的OCT 圖像都為250 張,詳細數據集介紹見文獻[35]。在實驗中,本文采用與已發表的文獻中相同的數據預處理方法,保證實驗結果對比的公平性[35-36]。

4 評價標準與實驗設置

4.1 評價標準

參考文獻[37-38],本文選擇準確率(accuracy,ACC)、敏感度(sensitivity,Sen)、精確率(precision,PR)、F1 指標),以及kappa系數五種評價指標來評估方法的總體性能。準確率是用來衡量算法預測正確的樣本數目占總樣本數的比例,敏感度是算法預測正確的正例樣本的比例;精確率是算法預測為正例的樣本中實際為正例的比例;F1指標是精確率和召回率的調和均值。準確率、敏感度、精確率和F1 等評價指標可以通過公式(7)~(10)來表示:

其中,TP表示真陽性,TN為真陰性,FP為假陽性,FN為假陰性。

4.2 基準模型

本文通過以下對比實驗全面驗證提出模型的性能:

(1)先進的通道注意力機制方法。本文采用擠壓激勵注意力(SE)、高效通道注意力(ECA)、風格校準模塊(SRM)作為基準注意力模塊來驗證CFA 模塊的有效性,因為本文提出的方法和三種對比注意力機制方法都屬于通道注意力機制。

(2)基準方法。本文采用機器學習方法和卷積神經網絡模型驗證本文模型的優越性。機器學習方法:參考文獻[21],本文也從晶狀體核性區域提取17個像素特征并借助機器學習方法進行自動分類,如支持向量機(support vector machine,SVM)、決策樹(decision tree,DT)、隨機森林(random forest,RF)[24]、GradientBoost 和Adaboost。卷積神經網絡模型:ResNet、GraNet[23]、VGG[39]、ECANet、SRM、GCANet[25]、CBAM等先進的卷積神經網絡模型和注意力機制網絡模型被選擇作為對比方法。

4.3 實驗設置

本文使用Pytorch、Python、Pandas、scikit-learn 和OpenCV等軟件包來實現本文模型和基準模型。所有深度學習模型使用隨機梯度下降優化器(stochastic gradient descent,SGD)作為優化器,訓練周期(epoch)設置為150,批量大小(batch size)設置為32、初始化學習率(learning rate,lr)設置為0.035,每30 epochs 學習率減小5 倍。原始晶狀體核性區域的AS-OCT 影像高和寬分別864±50和386±30,本文將所有影像的高和寬都縮放為224×224,作為神經網絡模型的輸入。機器學習的提取特征來自原始晶狀體核性區域的AS-OCT 影像。實驗硬件環境配置為1 張Nvidia Titan GPU,DDR 12 GB 內存,操作系統為Ubuntu。

5 實驗結果與分析

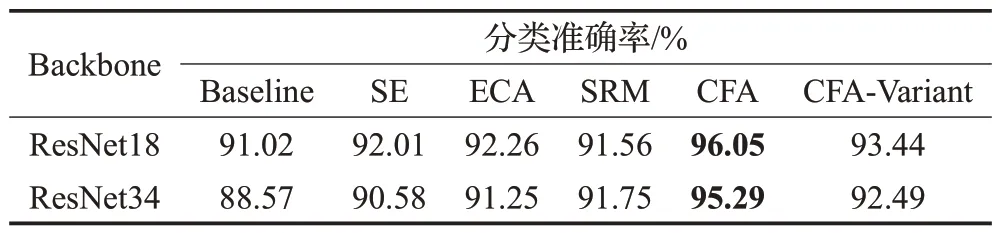

5.1 不同通道注意力機制方法結果對比

表2為本文的CFA與其他三種先進的通道注意力機制方法和基準模型(baseline是指ResNet18和ResNet34)在AS-OCT影像數據集上的分類準確率結果對比。從實驗結果對比分析可見,本文提出的CFA 和CFA-Variant優于其他三種注意力機制和基準模型。其中,CFA基于兩個網絡骨架都取得了最高的分類準確率,分別達到96.05%和95.29%,比其他三種通道注意力方法和基準模型至少提高了3.54個百分點。

表2 不同注意力機制方法在AS-OCT數據集上結果對比Table 2 Result comparison of different attention methods on AS-OCT dataset

相較于CFA-Variant,CFA的分類準確率提升了2.61個百分點以上,因為Softmax可以當作一種歸一化方法,其作用與BN 沖突,從而導致網絡模型的分類性能下降。除了SRM 以外,其他注意力機制方法ResNet18 的分類結果優于它們基于ResNet34 的分類結果。因此,在下文消融實驗中,選用ResNet18 作為CFA 和其他三種注意力機制方法的骨架網絡模型。

5.2 與基準方法結果對比

表3 為CFANet 與基準方法在AS-OCT 影像數據集上的核性白內障分類結果對比。可以看出,本文模型在五個評價指標都取得了最好性能,分別為96.05%、95.82%、95.97%、95.81%和92.64%。它比先進的卷積神經網絡模型(已發表的文獻中GraNet)和具有代表性的注意力機制方法(SENet)在五個評價指標上至少分別提升了3 和2 個百分點;與經典的機器學習方法的分類結果相比,本文模型提升了5個百分點以上。

表3 本文方法與基準方法AS-OCT數據集上結果對比Table 3 Result comparison of proposed method and baselines on AS-OCT dataset 單位:%

相比于CBAM和SRM,CFANet的核性白內障總體分類性能有著顯著提升,其中準確率至少提高了2.4 個百分點,這也驗證了本文模型考慮不同特征表示的相對重要作用和重構通道之間的依賴關系的有效性。深度神經網絡模型的總體核性白內障分類結果優于機器學習方法,說明了深度神經網絡模型能夠更有效地提取有用的特征表示信息。

表4 列出了CFANet、對比方法、已發表的工作在UCSD數據集上的實驗結果對比。實驗結果表明,CFANet在三個評價指標上都優于對比方法和已發表的工作并至少提升了1個百分點,證明了本文模型的泛化能力。

表4 本文方法與基準方法在UCSD數據集上結果對比Table 4 Result comparison of proposed method and baseline on UCSD dataset 單位:%

5.3 消融實驗

5.3.1 討論不同池化方式對分類結果的影響

為了驗證本文提出的Avg-Max池化方式對CFANet分類結果的影響,本文基于CFA模塊單獨采用全局平均池化(GAP)方式和全局最大池化(GMP)方式與Avg-Max 操作符進行比較,實驗結果如圖3 所示。可以看出,Avg-Max 操作符的分類結果優于GAP 和GMP 池化方法。由此說明,全局均值和最大值特征表示在CFA模塊中扮演不同角色,且兩者組合能提高核性白內障分類結果。在下文將會詳細地討論這兩種特征表示的權重分布來解釋它們的相對重要作用。

圖3 三種池化方法結果對比Fig.3 Result comparison of three pooling methods

5.3.2 討論不同臨床特征融合方式對分類結果的影響

為了驗證通道全連接(CFC)方法在本文的CFA 模塊中有效性,本文將已發表的文獻中多層感知機(multilayer perception,MLP)、共享多層感知機(shared multilayer perception,S-MLP)、通道獨立連接(independent channel connection,ICC)[26]與本文的CFC 方法做作對比,Backbone 是ResNet18。實驗結果如表5 所示,可以看出,CFC的分類結果優于MLP、S-MLP以及ICC,它的準確率、F1 和Kappa 分別達到了96.05%、95.81%和92.64%,比其他三種連接對比方法在三個評價指標上最小提升和最高提升分別為1.1 和8.09 個百分點。因為MLP 和S-MLP 僅重構了通道之間的依懶關系,但忽略了不同特征表示在同一個通道中具有不同的重要性。ICC 考慮了不同特征表示類型在單個通道中起著不同的作用,但沒有重構通道之間的依賴關系。本文的CFC方法不僅考慮到了通道依賴關系的構建,也考慮了在一個通道中不同特征表示類型的重要性不同,從而證明了CFC方法的有效性。

表5 不同特征表示融合方式的結果對比Table 5 Result comparison of different feature representation fusion methods 單位:%

5.3.3 討論不同門控操作符對分類結果的影響

為了探究門控操作符對本文的CFA 模塊性能的影響,本文對比了四種不同的門控操作符在CFA模塊上的分類結果:ReLU、Sigmoid、Tanh、和Softmax,Backbone是ResNet18。根據表6 的實驗結果分析可見,Softmax取得了最好的分類結果,在三個評價指標上都比其他三種門控操作符至少提高了1.36個百分點。Sigmoid、Tanh以及ReLU只考慮到單個通道的權重沒有其他通道的權重影響,而Softmax 不僅考慮到單個通道的權重還考慮了不同通道權重的相互影響。這也解釋了為什么采用Softmax作為門控操作符的CFA模塊的分類結果最好。

表6 不同門控操作符的結果對比Table 6 Result comparison of different gated operators 單位:%

5.4 可視化結果分析

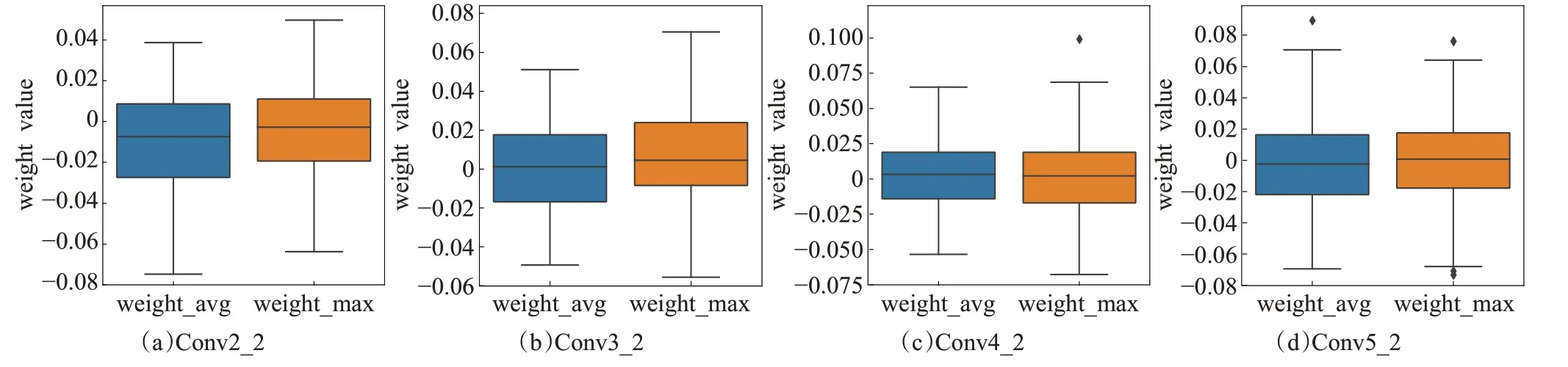

5.4.1 特征權重可視化

為了探索Avg 和Max 這兩個臨床特征表示在CFA模塊中的相對重要作用,本文分析了不同深度殘差CFA模塊中這兩個臨床特征表示的相對權重分布(可以當作是臨床特征相關系數的另一種表示),Backbone 是ResNet18。本文將神經網絡模型基于深度可分為三個階段:淺層、中間層以及深層。參考文獻[34],本文將Conv_2_2 當作淺層,Conv_3_2 和Conv_4_2 當作中間層、Conv_5_2當作深層。圖4為在AS-OCT影像數據集上不同階段的Avg 和Max 兩個特征表示的權重分布箱型圖。可以看出,在不同深度的卷積層,與Avg 相比,CFA 模塊傾向賦予Max 相對較大的權重值。這表明在核性白內障分類任務中Avg 和Max 這兩種特征表示類型的作用不同,對應這兩種臨床特征與白內障嚴重程度具有不同的相關系數。其中,Max主要突出特征圖的顯著特征表示;而Avg傾向于強調特征圖的全局均值特征表示。以上結果證明了本文提出的CFA 模塊能動態地調整這兩個特征表示類型的相對權重,以此來提高分類性能和增強模型的決策過程的可解釋性。

圖4 臨床特征表示在三個不同階段的權重可視化Fig.4 Clinical feature representation weight visualization in three stage levels

5.4.2 通道權重可視化

圖5 為本文的CFA 與其他三種通道注意力機制方法的通道權重分布圖,與其他注意力方法相比:SE、ECA、SRM 和CFA 的相對較大權重值主要集中在少數通道上。因為不同通道對應的特征圖代表著不同特征表示,但在同一個卷積層的不是所有特征圖的特征都起著相同的作用,只有一部分特征圖的特征表示信息有用。因此,圖5的通道權重分布結果說明CFA能較好地突出重要的通道和抑制不重要的通道,從而提高網絡模型的分類性能。

圖5 CFA與其他注意力機制方法的通道權重分布Fig.5 Channel weight distributions of CFA and other attention methods

5.4.3 基于類激活映射方法的可視化結果

本文采用類激活映射(class activation mapping,CAM)[41]方法對AS-OCT圖像的核性白內障分類結果進行可視化,它能突出神經網絡模型在推理過程中關注圖像哪些區域,以此來增強預測結果的可解釋性。圖6為本文的SENet、ECANet、SRM、CFANet 的具有代表性的三種核性白內障嚴重級別的類激活圖。其中,第一列是三種核性白內障嚴重級別的AS-OCT影像;第二列到第五列分別是SENet、ECANet、SRM 和本文的CFANet 的類激活圖。第一行是正常的AS-OCT 影像及各種方法的類激活圖;以此類推,第二行是輕度核性白內障的AS-OCT影像及各種方法的類激活圖;第三行是重度核性白內障的AS-OCT 影像及各種方法的類激活圖。可以看出,在正常的AS-OCT 影像上,三種對比注意力機制模型與CFANet 都關注整個核性區域,因為正常人的核性區域沒有出現混濁癥狀,像素分布十分均勻;對于輕度和重度核性白內障的AS-OCT影像,本文的模型更關注核性區域的中間與下半部分與對比注意力方法模型相比,臨床研究發現也指出這兩個部分混濁程度比上半部分更明顯[42],它們是臨床診斷核性白內障嚴重程度的重要參考,也解釋了本文模型的核性白內障性能優于其他對比模型的主要原因。

6 結束語

本文提出了一種基于臨床特征校準注意力網絡(CFANet)模型,實現AS-OCT 影像下核性白內障嚴重級別自動精準預測。在CFANet 中,本文設計了一個臨床特征校準注意力模塊通過引入白內障臨床先驗知識對不同特征表示進行動態加權融合并突出通道權重的差異性。消融實驗驗證了本文模型對基于AS-OCT 影像的核性白內障嚴重程度識別任務的有效性。模型的可視化結果分析表明,不同特征表示在本文模型具有不同重要的作用且本文模型采用softmax函數更能突出重要的通道;模型結果的可視化結果還顯示,與其他先進的注意力機制模型先比,本文模型更關注白內障的病理區域,與臨床研究發現保持一致性。

然而,如何從理論上來證明本文模型的可解釋性有待進一步研究;能否引入更多的臨床特征作為臨床先驗知識注入到神經網絡模型設計中來提高模型的分類結果,以及如何基于通道權重對模型進行剪枝來構建輕量級網絡并部署到眼科醫療設備中,是需要進一步探索和解決的問題。