基于BERT的高校圖書館微信信息服務的命名實體識別方法

李東升 鮑玉來 劉建華等

關鍵詞: 命名實體識別; 高校圖書館; 微信服務; BERT; 雙向長短記憶網絡; 條件隨機場

DOI:10.3969 / j.issn.1008-0821.2023.04.007

〔中圖分類號〕TP391.1 〔文獻標識碼〕A 〔文章編號〕1008-0821 (2023) 04-0064-13

隨著互聯網技術的不斷普及和發展, 網絡信息服務已成為高校圖書館重要的服務新模式[1] 。高校圖書館重視智慧服務的研究工作逐漸增強, 它是一種知識服務的新模式, 通過利用先進的信息技術和圖書館的資源, 以主動的搜尋、嵌入式的服務、有效的信息分析和創新為基礎實現圖書館的智能化服務, 促使高校圖書館開展更加豐富的實踐[2-4] 。命名實體識別(Name Entity Recognition, NER)作為文本信息識別的技術方法, 是正確理解文本的基礎,也是智慧化服務的知識引擎[5] 。NER 技術是將實體類型預先定義, 能夠實現在大量的半結構化和非結構數據中識別出不同的實體, 因而廣泛應用于知識圖譜、智能問答、機器翻譯、對話和信息檢索等復雜的自然語言處理任務[6-8] 。網絡信息資源為高校圖書館信息服務拓展提供了大量的圖情類文本信息, 借助NER 技術, 圖書館工作人員能夠從大量的相關文本信息中快速識別出領域內有價值的知識,在圖書館服務模式的推廣與應用中具有較大的參考價值。圖書館的服務能否及時和高效地利用網絡信息資源, 并借鑒新的服務發展模式, 有效滿足用戶新的信息需求, 將成為其保持對用戶吸引力和有效性的關鍵[9] 。高校圖書館微信移動信息服務是各大高校圖書館拓展服務的重要平臺, 為圖書館服務的開展提供了有效的方式, 是便捷的信息獲取和資源共享的可靠平臺。高校圖書館可以利用命名實體識別技術, 有針對性地從其豐富的知識、多樣的信息資源中挖掘知識, 形成知識服務產品, 為其服務拓展、優化和創新提供參考依據。

基于深度學習的命名實體識別技術, 在文本信息上特征提取的深度和模型的精確度的優異表現,已成為有序、有效地利用信息資源的重要方法[10] 。2013 年, Mikolov T 等[11] 提出模型Word2vec, 該模型采用skip-Gram 或CBOW 模型預測詞匯并通過神經網絡訓練相應的嵌入向量, 在命名實體識別方面取得良好的效果。在詞訓練方面, 如Glove、Fast?text 等模型在命名實體識別中有較多的嘗試應用,均有較大的研究進展[12] 。然而, Word2vec 等預訓練模型仍然存在無法表征一詞多義的問題, 因為它們主要關注的是詞或者字符之間的特征, 而忽略了詞的上下文語境, 導致其實體識別能力有限。在中文命名實體識別自然語言處理領域, 相比英文存在較多困難, 英文的詞語構造形式比中文在實體命名識別方面體現出更多的語義信息[13] 。Su T R 等[14]基于漢字字形學習特征, 在詞向量方面的研究對中文文本在訓練出現的語義特征所存在的困難和問題有較好的效果; Yu J 等[15] 研究提出一種組合學習語義特征的狀態和更加細粒度的Subcharacter 的方法, 并學習了中文在語言相似性和語言特征融合任務上詞向量任務。在實體命名識別領域中, BERT在詞向量訓練方面有效解決一詞多義的問題, 是一種基于序列到序列模式(Seq2Seq)結構上的創新。

2018年, Google團隊提出基于注意力機制的Trans?formers[16] 模型的BERT(Bidirectional Encoder Repre?sentations from Transformers), 不同于傳統的RNN和CNN(卷積神經網絡), 該模型使用了Transform?ers 作為算法的主要框架, 增強預訓練詞向量模型的泛化能力, 使得模型能夠更徹底地捕捉語句中的雙向關系, 更好地表征不同語境中的句法和語義信息。通過BERT訓練詞向量, 對前后文本的預測考慮了前后雙向的輸入信息, 體現出語境不同所含有相同詞的語法或字詞。因此, 在實體識別領域, 許多學者基于BERT 訓練模型學習詞向量的分布, 以提高實體識別的精度。黃梅根等[17] 基于BERT優化模型, 采用關系分類與元素抽取兩個任務模型進行命名實體識別, 取得了較好的效果。岳琪等[18]基于BERT改進與雙向RNN模型分析林業實體識別和實體關系的抽取, 并驗證了該領域內構建知識圖譜的可行性。在警情領域關鍵實體文本中, 王月等[19] 使用了BERT 預訓練詞向量, 模型在命名實體識別研究方法上設計了不同方案以提高準確率。

以上不同研究領域的命名實體識別方法為本文在高校圖書館微信信息服務進行命名實體識別提供了參考。目前, 在高校圖情領域命名實體識別的研究中, 由于缺乏對領域實體語料庫的研究, 提升實體識別效果存在較大的難度, 如文本中隱含的信息實體類別無法充分識別、數據量小、人工標注成本高等。為了解決高校圖情領域的命名實體識別問題, 針對高校圖情領域語料資源缺乏、人工標注難以滿足等對提升領域實體識別效果的情況下, 通過知識規則具體定義實體的邊界, 本文構建了高校圖書館微信服務推文文本的數據集ULICNER。由于BERT 具有較強的語義表達能力, 利用BERT學習大規模文本后生成具有語義特征的字符向量, 接著通過BiLSTM 層對BERT的輸入文本序列學習獲取上下文的文本特征, 最后通過連接CRF 層得到最佳的序列輸出。因此, 本文采用基于BERT-BiLSTMCRF模型構建高校圖書館微信信息服務文本中命名實體的方法, 完成高校圖書館微信服務領域的命名實體識別任務。

1文本數據集的采集與分析

1.1數據的來源

高校圖書館服務信息的文本不同于其他領域文本, 具有服務多樣性、規律性、客觀性, 這對其文本的語義識別技術使用產生了較大影響。為保證數據的可靠性和準確性, 本文參考了基于教育部的《普通高等學校圖書館規程》[20] 和圖書情報檢索領域內的《中國圖書館分類法》[21] 的語義分類方法和詞語用法。數據文本的采集通過清博指數平臺上的高校圖書館微信服務公眾號榜單[22] , 該榜單涵蓋了全國開通微信服務的946 所高校, 從中爬取了涵蓋高校圖書館對服務范圍、用戶需求、業務能力和文化推廣等方面的36 000多條文本, 約60萬字符。

1.2文本的實體特征分析

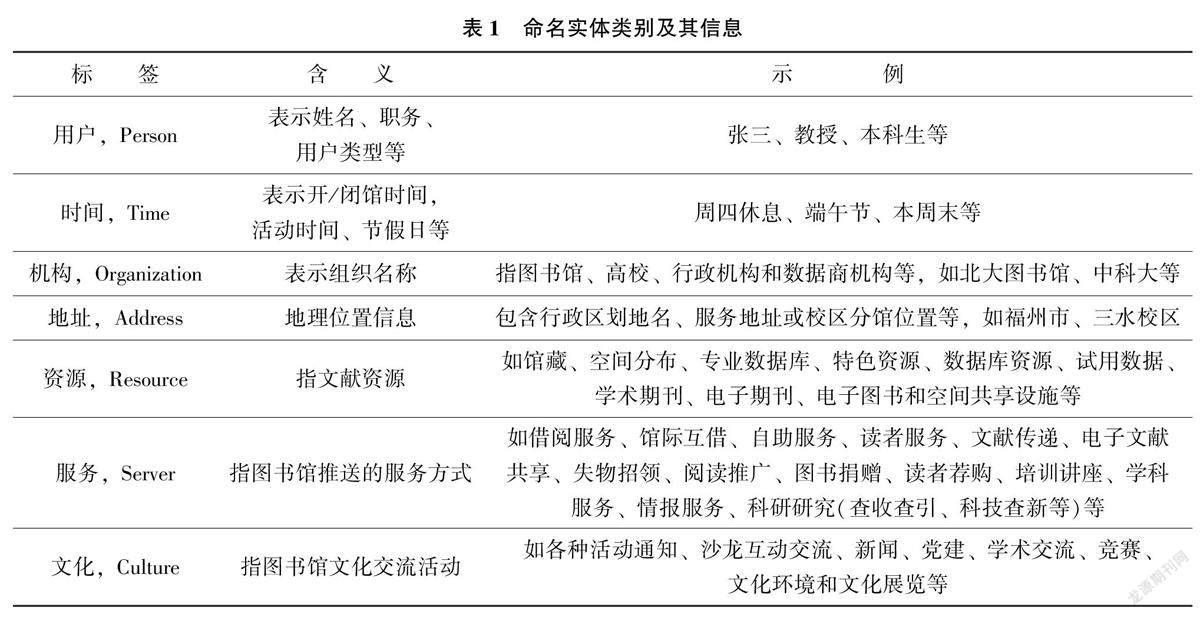

由于不同領域文本的實體有不同的特點, 高校圖書館服務領域語料與醫療、司法和輿情等其他領域存在不同的特征, 它們之間相互的詞匯重疊的相似度較低[23] 。因此, 詞分布不同的領域文本實體識別效果會在模型中體現出不同的特征, 進而需要設計不同的實體識別方法和分類。如實體類的“文化” 指圖書館文化交流活動, 是各種活動通知、沙龍互動交流、新聞、黨建、學術交流、競賽、文化活動、文化環境和文化展覽等, 其他各類實體的含義及示例如表1所示。

1.3數據文本的標注

本文基于BIO 法對高校圖書館微信服務推文文本的數據集ULICNER 進行標記。由于獲取的特定數據文本進行標注任務常采用純人工標注的方法, 在質量控制方面存在效率低和錯誤率高的問題[24] 。本文的標注人員由圖情方向的老師、專家和機器學習方向老師3 名成員組成, 領域內標記開始前需要經過前期軟件操作培訓和標注規則的熟悉。數據文本的標注工作持續了50 天, 平均每天完成700 多條文本句子。為確保標注質量和降低標注成本, 保證實體標注結果的一致性, 本文采用基于詞典規則與人工修正相結合的半自動標注方式,構建高校圖書館微信推文文本數據集。首先, 在標注語料庫前, 根據詞典與規則匹配方法, 預先采集了領域內的實體名稱和實體標簽, 此部分實體有600多個類目; 其次, 根據構建的匹配規則與所標注的數據本文進行自動實體標記; 最后, 還需對自動匹配結果中可能出現的錯誤標注、漏標注等問題以人工校驗的方式進一步作調整和改進, 且隨著文本被標注校驗正確后, 還會與預先定義的實體合并形成動態更新的領域知識庫, 進而在隨后的文本過程中自動匹配效率得到快速提升。具體實體標注過程如圖1 所示。

數據集基于BIO 規則對語言序列進行標注,其中, B-begin 代表實體的開頭; I-inside 代表實體的中間或結尾; O-outside 代表不屬于實體, 如以句子“圖書館寒假閉館通知” 為例, 其序列標注如圖2所示。

利用以上方法將高校圖情語料中的文本實體描述進行識別, 最終構建了ULICNER 語料集, 數據的標簽包含7 個粗粒度分類和16 個細粒度分類,如表2 所示。

另外, 本實驗使用數據集按照8∶1∶1的比例將數據集劃分為訓練集、驗證集和測試集。領域命名實體的數據集中每一行由兩列組成, 數據的兩列之間采用空格隔開, 其中第一列為文本內容, 第二列是BIO格式的標簽序列, 句子邊界用空行標識。數據集組成情況如表3 所示。

2BERT-BiLSTM-CRF語言模型

本文研究采用的BERT-BiLSTM-CRF 模型探索高校圖書館微信文本信息實體識別, 如圖3 所示。首先, 使用BERT 預訓練模型, 獲取每一個標識的向量表示特征, 即字向量表示層; 然后, 輸入BiL?STM 模型學習文本之間的關系, 即基于BiLSTM(考慮雙向的LSTM)建模以提取語義和結構特征;最后, 基于CRF 的解碼層輸出預測的標簽序列,獲取每個標識的分類結果。

為了便于理解本文BERT-BiLSTM-CRF 模型構建, 表4 具體解釋了模型流程, 包括輸入文本批量數, 維度轉換以及輸出的過程。

2.1 BERT 預訓練模型

由于BERT 在自然語言處理方面具有很強的語義表征優勢, 在文本輸入訓練層的Embedding 層采用BERT 進行預訓練, 產生詞向量, 獲取語境化的詞向量來提高實體識別的性能。BERT 采用了Transformer 的雙向編碼器表示, 在自然語言處理研究中取得很高的成就[25] 。BERT 通過所有Trans?former 層左右上下文共同調節, 來預訓練深度雙向表示, 不依賴于時間序列, 并在較長上下文本處理中具有較大優勢, 可以更好地提升語義表征水平。BERT 訓練通常分為兩步, 首先對模型進行預訓練(Pretraining BERT), 其次在預訓練的基礎上, 根據下游任務進行模型微調(Fine-tuning BERT)。

傳統語言模型訓練采用單向方式或者拼接的方式, 但這種模型從left-to-right, 或left-to-right+right-to-left 結合的方式提取特征的能力有限, 而Pre-training BERT 采用一個深度雙向表達模型(Deep Bidirectional Representation), 即采用MaskedLM(帶Mask 的語言模型訓練任務)和Next SentencePrediction(下一句話預測任務, NSP)兩種方法分別完成在BERT 訓練的構建, 具有較大的創新, 并且效果比較好。

本文在預訓練模型考慮多個句子區分級別的任務, 因此, 使用Masked LM 和NSP 進行模型預訓練。Masked LM 的任務機制在訓練時, 給定一個句子, 會隨機Mask(掩碼)15%的詞, 然后采用BERT來預測這些Mask 的詞。在這些被選中的Token 中,數據生成器并不是把它們全部變成[MASK]。通常存在3 種情況: 其一, 在80%的概率下, 用[MASK]標記替換該Token(圖書館暑假閉館>圖書館暑假[MASK] [MASK]); 其二, 在10%的概率下, 用一個隨機的單詞替換Token(如: 圖書館暑假閉館>圖書館暑假通知); 其三, 在10%的概率下, 保持該Token 不變(如: 圖書館暑假閉館>圖書館暑假閉館)。Masked LM 模型在訓練的過程中, 并不知道將要預測哪些單詞。正是在這樣一種高度不確定的情況下, 模型能快速學習該Token 的分布式上下文的語義, 最大化地學習原始語言語義表征。同時因為原始文本中只有15%的Token 參與MASK 操作, 并不影響學習原語言的表達能力和語言規則。

BERT 引入NSP(下一句話預測任務)任務, 采用的方式是輸入句子對(A, B), 模型來預測句子B是不是句子A 的真實的下一句話。為了更好地實現文本的實體命名識別, 需要模型能夠很好地理解兩個句子之間的關系, 故采用NSP 模型在對應的任務有良好的效果。NSP模型通過預訓練方法來捕捉兩個句子的聯系, 如有A和B兩個句子, B 有50%的可能性是A 的下一句, 訓練模型是為了預測B是不是A的下一句, 使模型增強對上下文聯系的能力。

另外, 在命名實體識別任務中, 模型微調通過Transformer中的Self-attention 機制提供的BERT 對其下游任務進行建模, 無論他們包含單個文本或多個文本, 只需要替換掉輸入和輸出。對于每個任務, 需將特定于任務的輸入和輸出插入到BERT中, 并對所有參數進行端到端微調。本文模型考慮多個句子區分級別的任務, 并分別給每個句子的字符進行標注標簽。句子起始的Token 均為特殊分類標記(Classification Token, [CLS]), 結束的Token均為特殊令牌(Special Token, [SEP])。句子的輸入過程包含將句子輸入到BERT 模型的原有靜態詞向量編碼(Token Embeddings, 表示字向量, 第一個單詞是[CLS]標志)和位置編碼(Position Embed?dings, 表示位置向量, 是通過學習得出), 另外還加入了語句分割編碼(Segment Embeddings, 句向量, 用來區別兩種句子), 整個模塊的輸出結果是3 種Embedding 編碼之和, 如圖4所示。

2.2 BiLSTM 模型

BiLSTM 模型是由兩個獨立的長短期記憶網絡(LSTM, Directional Long Short-term Memory) 模型組合而成, 一個正向去處理序列, 一個反向去處理序列, 處理完后, 兩個LSTM 的輸出拼接起來形成的詞向量作為該詞的最終特征表達。另外, BiL?STM 中的兩個LSTM 神經網絡參數是相互獨立的,它們只共享由BERT 預訓練層輸入的Word-embed?ding 詞向量信息。1997 年, 針對循環神經網絡(RNN, Recurrent Neural Networks)的梯度消失和梯度爆炸問題, Hochreiter S 等[26] 提出了該改進模型, 模型對文本特征提取效率和性能要優于單個LSTM 結構模型, 取得良好的效果, 其LSTM 原理結構如圖5 和圖6所示。

在自然語言處理的實際應用中,發現循環神經網絡存在如梯度消失、梯度爆炸以及長距離依賴信息能力差等問題, 因此引入了長短期記憶網絡(LSTM)。該模型是RNN 的一種改進, 內部結構擁有更長的記憶, 梯度消失問題得到優化。LSTM 在主體結構上與RNN 類似, 其主要的改進是在隱藏層h 中增加了3 個門控(Gates)結構, 分別是遺忘門(Forget Gate)、輸入門(Input Gate)、輸出門(OutputGate), 同時新增了一個隱藏狀態(Cell State)。LSTM 隱藏層結構原理如圖5 所示, f(t)表示t 時刻遺忘門, 可以選擇性地遺忘一些信息, 其值范圍是0~1; i(t)表示t 時刻輸入門, 可以添加新的信息,如假設輸入10 個元素信息和原來的4 個全連接層(假設是隱藏單元個數一致的128 個神經元, 輸出都是128 個元素的向量)進行拼接, 給C 中傳入更新的信息(138 個元素的一維向量); 輸出門o(t)依賴前一個狀態向量h(t-1)和更新的輸入信息x(t), 是長短期“記憶” 的更新變化; a(t)表示t 時刻對h(t-1)和x(t)的初步特征的提取, 會作為下一時刻(t+1)的輸入之一。具體的計算過程如下:

3.3實驗結果

本文采用的BERT-BiLSTM-CRF 有效地提升了高校圖書館微信推文文本數據集實體命名識別的效果。為驗證分析, 研究還設計了4 種不同模型性能比較, 分別是: ①CRF 模型, 該模型定義一個特征函數的集合, 用這個帶約束作用的特征函數集合來為一個標注序列打分, 并據此選出最佳的標注序列; ②BiLSTM 模型, 該模型為LSTM 的雙向考慮模型, 依靠神經網絡強大的非線性擬合能力, 可以將樣本的高維空間復雜非線性變換, 該模型將樣本標注進行學習并預測; ③BiLSTM-CRF 模型, 經典的實體命名提取模型, 該模型通過加入CRF 層優化了LSTM 層在序列標注學習任務過程, 學習隱含狀態序列的特征; ④BERT-CRF 模型, 該模型與BiLSTM-CRF 模型較為相似, 其本質上還是一個CRF 模型, 只是采用BERT 模型來訓練CRF 模型中的發射矩陣。實驗結果如表5 所示。

由表5 可知, BiLSTM-CRF 模型結合了BiL?STM 模型和CRF 模型的優點, 準確率為94.17%,高于后兩種模型91.26% 和93.18% 的準確率;BERT-CRF 模型通過BERT 預訓練模型, 在學習到狀態序列(輸出的標注)之間的關系效果好于BiL?STM 模型, 其準確率提高到了97.85%; BERT -BiLSTM-CRF 模型能夠并行獲取并優化全局信息,其準確率、召回率和F1 值都是最高的, 分別為98.59%、98.91%和98.75%。另外, 相比BERTCRF模型沒有對BERT 預訓練輸出結果進行上下文關系的匹配, 本文模型在準確率、召回率和F1 值上分別提升了0.74%、0.99%和0.76%。因此, 采用BERT-BiLSTM-CRF 模型的實驗結果可以看出,通過BERT模型對輸入的詞向量進行訓練后的結果導入到BiLSTM-CRF 模型, 得出的結果更準確。

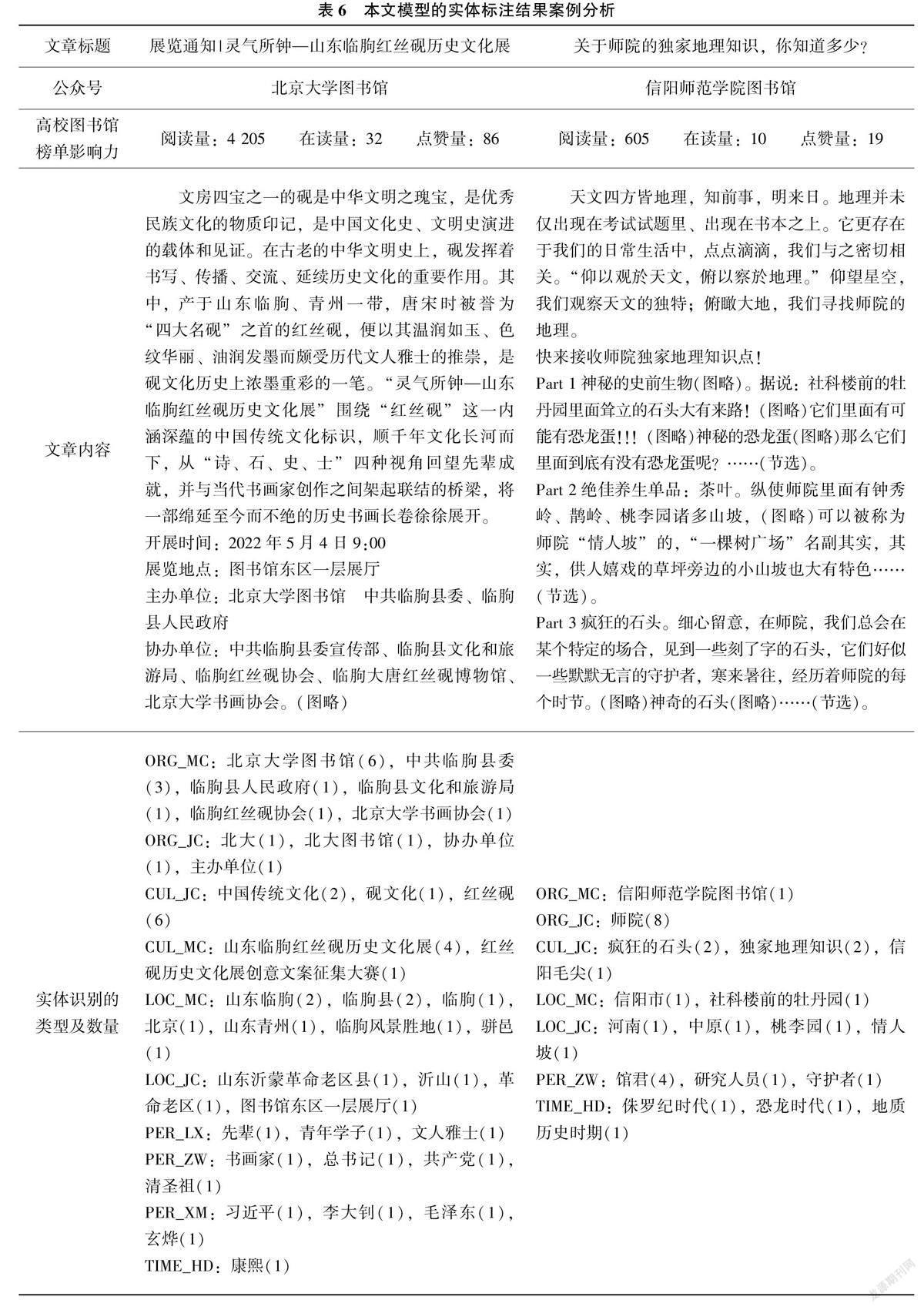

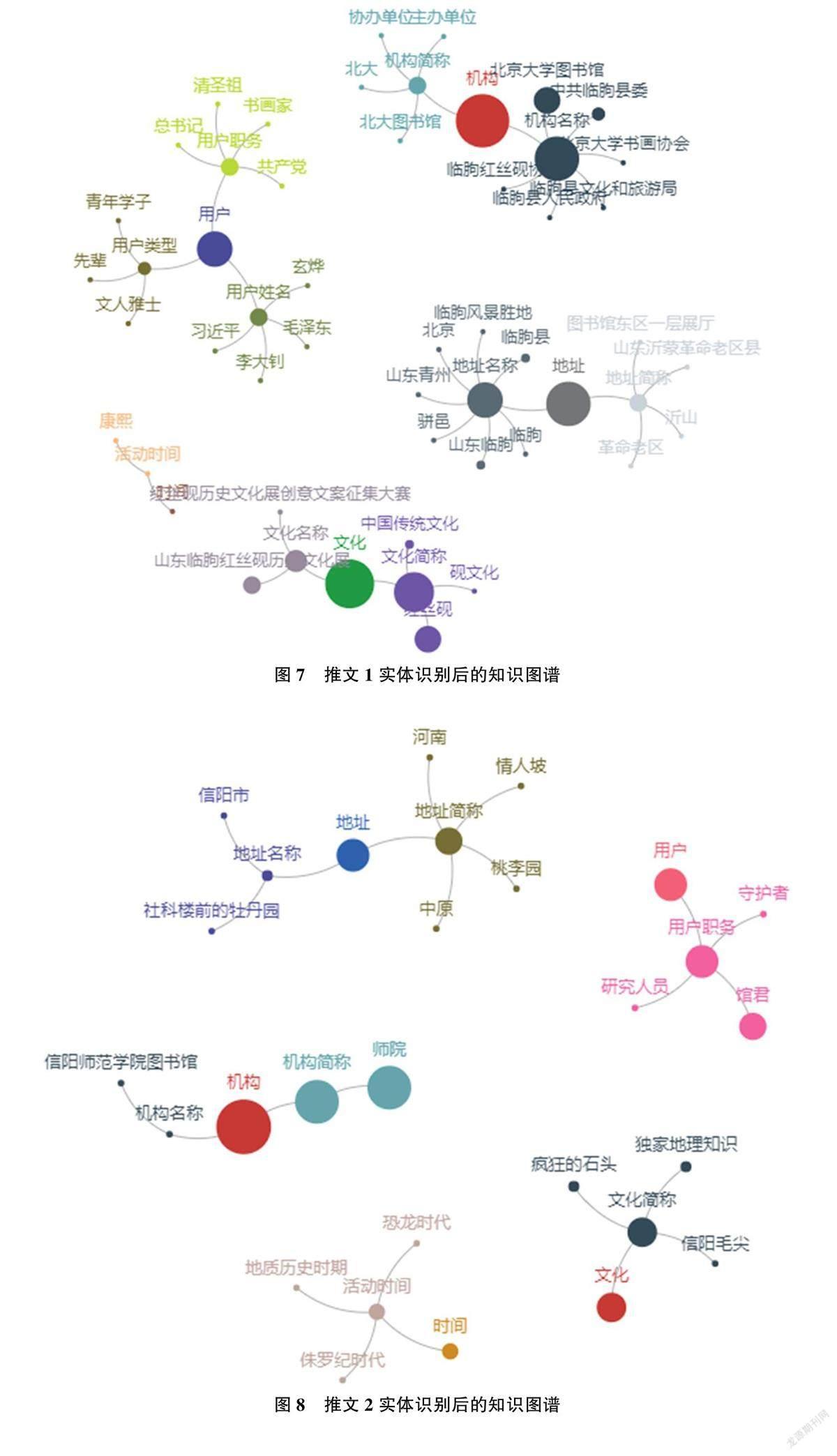

為有效分析本文模型在測試集上的實體識別效果, 通過實例分析命名實體標記結果的具體表現進行呈現。為突顯高校圖書館微信信息服務的特色和影響力, 隨機選出兩篇高校圖書館在榜單中影響力排名靠前的微信推文, 具體結果如表6 所示。

由表6 可見, 本文通過命名實體識別技術應用, 分別實例分析了兩類不同辦學層次高校圖書館微信推文的實體識別效果, 并以此較為全面地提取了高校圖書館服務平臺上的領域內容介紹中的各類專業名詞術語, 極大地豐富了圖書館知識服務。其中, 北京大學圖書館發布的“靈氣所鐘—山東臨朐紅絲硯歷史文化展” 微信推文取得良好的社會影響, 閱讀量和點贊量非常高, 有效地實現文化傳播在高校圖書館的推廣和應用, 其微信推文的實體識別效果如圖7 所示。同時, 該文的知識發現可以推薦作為高校圖書館微信信息服務與地方特色歷史文化相結合, 為讀者提供了便捷的信息分享條件,提升讀者的關注, 實現資源共享和服務推廣等。另外, 信陽師范學院圖書館發布的“關于師院的獨家地理知識, 你知道多少?” 微信推文的影響力較佳, 在閱讀量不高的情況下取得較高的點贊量, 深受讀者的歡迎, 該文介紹了校內特色人文地理環境, 借鑒圖書館微信平臺宣傳吸引當地讀者的注意, 能夠引起讀者的共鳴, 塑造良好的校園環境,也是高校圖書館信息服務過程和信息服務創新模式的有效策略, 該文的實體識別效果如圖8所示。因此, 通過分析高校圖書館微信平臺具有影響力的推文, 采集具有特色和影響力的推文實體, 可以實現高校圖書館服務內容的結構化呈現, 為圖書館特色服務和發展模式的拓展提供了可借鑒的資源獲取和利用平臺。采用命名實體識別技術, 通過進一步挖掘信息資源的各類實體關系, 如構建高校圖書館知識圖譜, 實現信息資源的實體之間更深層次和更大范圍的關聯, 優化領域內的內容推薦、檢索等服務質量, 提升圖書館知識服務的發現能力。

3.4各類實體識別結果

為明確本文的不同模型對不同類別實體的識別效果, 本文通過準確率、召回率和F1 值3 個指標對不同類別實體識別進行了對比分析, 結果如表7所示。本文模型在用戶、時間、機構和地址等實體識別的準確率、召回率和F1 值都較高, 而只是對實體數較少的服務簡稱(SER_JC)的實體識別評價指標的數值偏低, 可能與該實體數量偏少有關, 存在降低實體分類能力, 該實體識別的準確率、召回率和F1 值分別為80.00%、100.00%和88.89%。可見, 本文采用的BERT-BiLSTM-CRF 模型對高校圖書館微信服務的推文文本信息中各類不同實體的識別效率效果良好。

4結語

針對高校圖書館服務領域內實體名稱多樣、特征信息提取不明確的問題, 將高校圖情領域的數據集預先定義為7 個粗粒度分類和16 個細粒度分類,并進行了實體識別標注, 數據集涵蓋領域內的服務內容, 用戶需求、業務能力和文化推廣等方面。

高校圖書館如何有效地整合服務推廣平臺信息, 使服務模式的重要信息聯系起來, 是高校圖書館移動信息服務提高的關鍵。因此, 本文以BERTBiLSTM-CRF 模型作為高校圖書館微信推文文本實體識別方法。首先, 采用BERT 預訓練模型, 獲取每一個標識的向量表示特征; 然后, 基于BiLSTM層以提取更加準確的語義和結構特征; 最后, 使用CRF 層輸出預測的標簽序列, 獲取高校圖情微信服務領域的實體識別中存在的特征關系進行約束,進一步提高了實體識別的提取效率。另外, 本文模型提升了高校圖書館信息服務領域命名實體識別效果, 并實例分析了高校圖書館微信推文在知識服務過程中的發現能力。本文下一步的研究內容主要有兩個方面: 一是如何解決數據集實體中數量不平衡問題; 二是提高模型的實體識別效率, 同時提高標注的準確率, 如訓練耗時長、參數冗余和資源成本高等方面進行模型改進, 為自然語言處理技術在高校圖書館服務領域中的應用提供方案。