基于雙重注意力機制的遙感圖像場景分類特征表示方法

徐從安 呂亞飛 張筱晗 劉 瑜 崔晨浩 顧祥岐

①(海軍航空大學信息融合研究所 煙臺 264000)

②(清華大學電子工程系 北京 100084)

③(91977部隊 北京 100089)

④(61646部隊 北京 100089)

⑤(32144部隊 渭南 714000)

1 引言

隨著衛星與無人機等遙感觀測技術的飛速發展,高分辨率遙感圖像的數據總量和數據類型都不斷增加,遙感信息處理正在進入“遙感大數據時代”[1]。高分辨率遙感圖像相比于中低分辨率遙感圖像包含著更豐富的紋理、細節和地物特征,在為遙感圖像的自動解譯工作提供了豐富信息的同時,也提出了更多的挑戰和要求。

作為遙感圖像解譯工作中的重要組成部分,遙感圖像場景分類(Remote Sensing Image Scene Classification, RSISC)是根據圖像中包含的高層語義信息,將遙感圖像映射到預定的類別標簽中,實現對圖像場景內容的自動判別。根據特征表示方法的不同,現有的研究方法主要可以分為基于手工特征的方法[2,3]和基于學習特征的方法[4,5]。尤其自AlexNet[6]的提出,以卷積神經網絡(Convolutional Neural Networks, CNNs)為代表的基于學習特征的方法憑借較好的高層語義特征提取能力較大提高了算法的性能表現,逐漸取代了基于手工特征的相關方法。

基于CNNs的網絡結構在計算機視覺領域不斷提高著分類、識別等任務的性能表現,但在RSISC中,由于自然場景圖像與遙感圖像在成像內容和成像特點上的差異,用于自然場景圖像的深度網絡結構難以直接適用于RSISC問題。這主要是由遙感圖像俯視成像帶來的成像范圍更廣、尺度變化大和語義內容更復雜等問題導致的[7]。成像目標的繁雜性和語義內容的復雜性導致遙感圖像場景分類面臨著類內差異性大、類間相似性高的難點。為了解決該問題,已有較多研究方法提出,文獻[8]提出了鑒別性卷積神經網絡 (Discriminative-Convolutional Neural Networks, D-CNN)的網絡結構,將度量學習和CNNs相結合,以拉近同類場景、推遠異類場景圖像特征表示間的距離,較好地提高了特征表示的鑒別性能力(discriminative ability),但該方法忽略了對遙感圖像局部特征的關注;文獻[9]提出了基于區域的深度特征提取網絡,通過先檢測后特征表示的方式,對圖像中顯著的局部區域進行特征提取,雖然關注了局部區域特征,但丟失了全局特征;文獻[10]提出了多尺度CNN結構,利用兩個不同尺度的網絡結構分別提取圖像的特征表示,以學習遙感圖像中的尺度不變性特征;文獻[11]通過先聚類再重排的方式挑選遙感圖像中重要的局部區域進行特征表示,方法無法端到端訓練,算法復雜度高;文獻[12]利用注意力機制通過長短時記憶網絡生成了高層特征圖的重要性權重,對高層特征中每一個元素的重要性進行修正,雖然該方法可以端到端訓練,但對每一個元素的修正沒有實現對局部區域重要性的修正。文獻[13]中針對遙感圖像成像范圍廣、語義復雜的特點提出了適用于遙感圖像特征表示的注意力模塊,在高層特征的基礎上,分別從通道維和空間維兩個維度對圖像的特征表示進行修正,以使得圖像中顯著區域和顯著性特征更被關注,提高特征表示的鑒別性能力,該方法在遙感圖像檢索問題上得到了有效性驗證。不同于文獻[13]中注意力模塊學習的無先驗知識,文獻[14]提出了一種局部和全局特征融合的特征表示方法,利用循環神經網絡分別讀取和捕獲不同區域特征表示間的上下文關系,以生成不同區域的重要性權重,實現對局部重要區域的重點關注,整個方法可端到端地實現局部和全局特征的提取與融合訓練,在多個公開數據集上達到了最佳實現(State-Of-The-Art, SOTA),但該方法只是在空間維對不同區域的重要性進行了修正,忽略了通道維重要性的作用。

基于以上討論,針對遙感圖像成像范圍廣、語義信息復雜的特點,而現有的特征表示方法又難以同時對遙感圖像中的局部顯著區域和顯著性特征進行關注并有效地表達,本文提出了一種雙重注意力機制的遙感圖像場景分類特征表示方法,以CNNs提取的高層特征為先驗信息,利用循環神經網絡對上下文信息的提取能力,分別設計了一個通道維和空間維相結合的雙重注意力模塊,通過生成不同通道和不同區域的重要性權重,對原有高層特征表示中顯著性特征和顯著性區域兩個維度的特征表示進行增強,減弱對非重要區域(背景區域)和非顯著性特征的關注,提高特征表示的鑒別性能力。

2 本文方法

2.1 方法整體框架

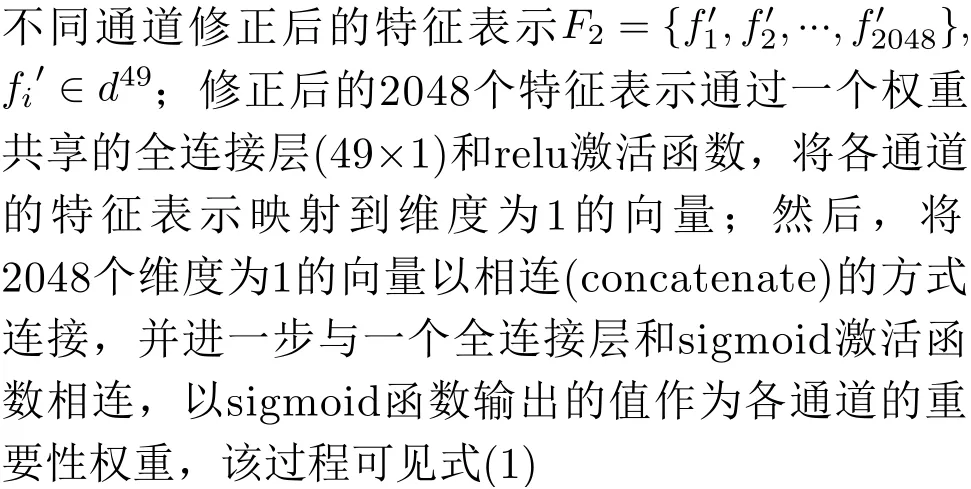

卷積神經網絡的強特征表示主要歸因于其對高層語義特征的提取能力,如圖1所示ResNet50所提取的高層特征(7×7×2048),其3維的特征結構可以分解為空間維(7×7)和特征維(2048)兩個維度。一方面,空間維(7×7)與輸入圖像(一般為224×224)的空間位置存在著對應關系,即高層特征空間維中每一個像素(1×1)對應著輸入圖像中大小為32×32的圖像塊,因此,空間維(7×7)中每一個像素就可以看作輸入圖像中不同區域的特征代表;另一方面,卷積神經網絡中不同的卷積層代表著不同的特征,每一層卷積層可能關注著不同類型的特征,因此,通道維的物理意義可以看作2048中不同類型的特征,對不同類別的遙感圖像來說,決定其身份信息的特征也必定不相同。因此綜上分析,為了進一步提高CNNs特征表示的鑒別性能力,需要從空間維和通道維兩個維度進一步對高層特征進行修正,對重要區域和特征進行增加,非重要區域和特征進行減弱。

以CNNs提取的高層特征為基礎,所提的雙重注意力模塊在通道維和空間維進一步對高層特征進行再權重化,方法的框架圖如圖1所示。以Res-Net50為例,以其最后一個大小為7×7×2048的卷積層為高層特征,依次連接通道維注意力模塊和空間維注意力模塊;通道維注意力模塊以高層特征中各通道展開后得到的49維向量為輸入,共2048個49維的通道向量依次輸入到以門限循環單元(Gated Recurrent Units, GRU)[15]為基本單元的循環神經網絡中,以提取各通道間的上下文關系,生成各通道的重要性權重,對高層特征的通道重要性進行加權修正;經通道注意力模塊修正后的高層特征進一步輸入到空間維注意力模塊中,以高層特征中不同區域的特征表示為先驗以此輸入到以GRU為基本單元的循環神經網絡中,輸出得到不同區域的重要性權重,以此實現對顯著性區域的增強、背景區域的抑制。最后,將經過通道注意力和空間注意力修正后的高層特征以全局平均池化的方式得到維度為2048維的特征向量,并與兩個節點為2048的全連接層連接后,通過softmax函數預測輸入圖像的類別。

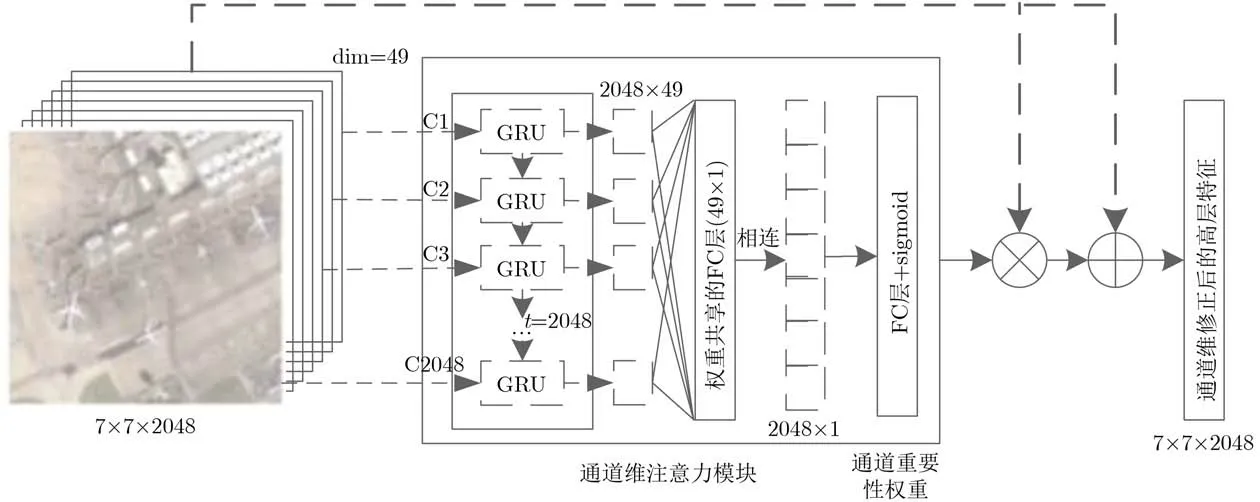

2.2 通道維注意力模塊

經CNNs提取獲得的特征圖中,不同的通道代表著不同種類的特征,以ResNet50為例,高層特征圖中包含2048個通道,可以看作2048種視覺特征。不同特征對遙感圖像語義內容的表達起著不同的作用,通道維注意力模塊的目的就是在CNNs提取的特征圖基礎上,根據不同通道的重要性程度,進一步生成各通道的重要性權重,實現對顯著性特征的加強,對非顯著特征的忽略。通道維注意力模塊的具體網絡結構如圖2所示。

將得到的高層特征F(7×7×2048)按照空間維展開得到2048個維度為49的通道特征表示:F1={f1,f2,···,f2048},fi∈d49。文獻[13]對通道注意力模塊的生成是以隨機初始化的方式,學習生成各通道的重要性,雖然起到了對不同通道重要性修正的目的,但對各通道間的相互關系和通道自身先驗信息的利用不足。而循環神經網絡作為處理序列信息的重要手段,能有效提取序列信息中的上下文關系,對進一步確定不同通道間的相互關系和重要性權重提供了解決方法。因此,為了準確生成不同通道間的重要性權重,本文以各通道的特征表示為先驗信息,依次輸入到以GRU為基本單元的循環神經網絡中,GRU是一種包含參數更少,但在很多序列關系提取任務中都有較好性能表現的一種循環神經網絡。通過對不同通道間的上下文關系的提取,生成

圖1 本文算法框架圖

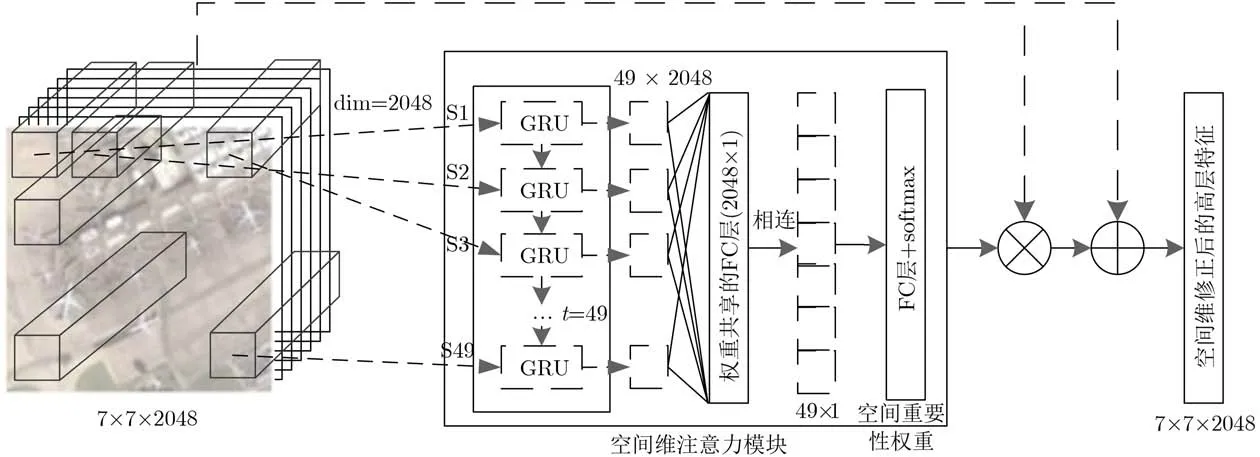

2.3 空間維注意力模塊

遙感圖像廣闊的成像范圍導致遙感圖像成像內容繁雜、目標眾多,如何更好地關注顯著性區域,忽略背景區域對于準確地實現遙感圖像特征表示起著關鍵作用。空間注意力模塊的目的就是在CNNs提取的高層特征基礎上,進一步捕獲不同區域特征的上下文聯系,以生成各區域的重要性權重,實現對顯著區域的重點關注,對背景區域的忽略。與通道維注意力模塊的網絡結構相似,空間維注意力模塊的網絡結構圖如圖3所示。

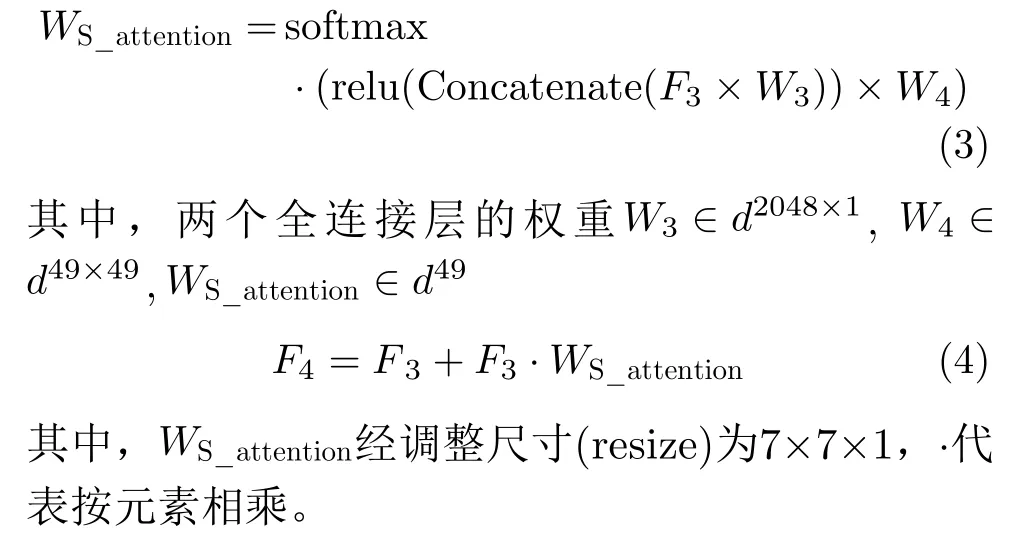

將經通道維注意力模塊修正后的高層特征F3(7×7×2048)輸入到空間維注意力模塊中。由文獻[14]可知,高層特征F3空間維中每個元素的特征表示(1×1×2048)可以看作原圖像中局部區域的特征表示,因此,可以得到圖像中49(7×7)個區域的高層特征表示F4={v1,v2,···,v49},vi∈d2048。與通道維注意力模塊的結構類似,為了充分探索不同圖像區域間的相互關系和重要性權重,利用循環神經網絡作為不同區域序列信息的上下文關系提取器。將49個不同區域的特征表示依次輸入到由GRU構成的循環神經網絡中,并與共享全連接層和最后的分類全連接層相連,通過softmax函數輸出不同區域的重要性權重 WS_attention;與通道維注意力模塊相同,將空間維注意力模塊的重要性權重與輸入的高層特征按元素相乘,并與原輸入的高層特征相加,得到最終的經通道維和空間維雙重注意力模塊修正后的高層特征F4。整個過程的計算如式(3)和式(4)所示

圖2 通道維注意力模塊網絡結構圖

圖3 空間維注意力模塊網絡結構圖

3 實驗驗證與結果分析

3.1 數據集

為驗證所提雙重注意力模塊的有效性,選取兩個代表性數據集AID (Aerial Image Dataset)[16]和NWPU-RESISC45 dataset (NWPU45)[17]進行實驗驗證。數據集AID和NWPU45是遙感圖像場景分類領域數據量最大、使用最廣泛的兩個數據集之一。AID中的數據來自谷歌地球,共包含10000張大小為600×600像素的航空場景圖像,空間分辨率為1~8 m,數據集共被劃分為30個類別,每個類別包含220~420張圖像不等。數據集NWPU45也是收集自谷歌地球,覆蓋率100多個國家的遙感圖像,共包含31500張圖像和45個場景類別,每類各包含700張大小為256像素×256像素的圖像,分辨率為0.2~30 m。

為便于與相關方法進行比較,與相關文獻[11–14,16,17]中的數據集設置保持一致,隨機從兩個數據集中挑選部分數據進行訓練和測試,數據集AID分別挑選20%和50%進行訓練,剩余的作為測試集;數據集NWPU45中隨機挑選10%和20%的數據作為訓練集,剩余的90%和80%作為測試集。

3.2 實驗設置

在實驗中,整個網絡采用隨機梯度下降(Stochastic Gradient Descent, SGD)優化器進行訓練,數據批次大小(batch size)為64,數據集訓練迭代30個循環(epochs),學習率設置為1e-6。

對于高層特征的獲取,本實驗主要采用VGG16和ResNet50作為基準網絡,與所提的雙重注意力模塊相結合;在測試階段,以整個網絡結構倒數第2個全連接層作為遙感圖像最終的特征表示;根據相關文獻[11,14]中的驗證,利用支持向量機作為測試階段分類器的性能要優于訓練階段使用softmax的分類性能,因此,采用線性支持向量機作為測試階段的分類器。

此外,算法的評價指標采用總體分類準確率(Overall Accuracy, OA)和混淆矩陣(Confusion Matrix, CM)兩個綜合性指標。OA的定義為測試集中分類正確的樣本數占總測試集的百分比,計算方法見式(5)

其中,T為測試集中分類正確的樣本數,N為測試集的樣本總數。本實驗中對每次測試結果重復10次,以10次的平均準確率和標準差作為最終的實驗結果。

CM是分類任務中能更直觀地表現算法性能表現的表達方式,其對角線元素表示各類別的分類準確率,其余元素 amn代表第m類被誤分為第n類所占的比例,通過CM能更好地看出相近、混淆類別間的分類情況。

3.3 實驗結果與分析

3.3.1 模型簡化測試

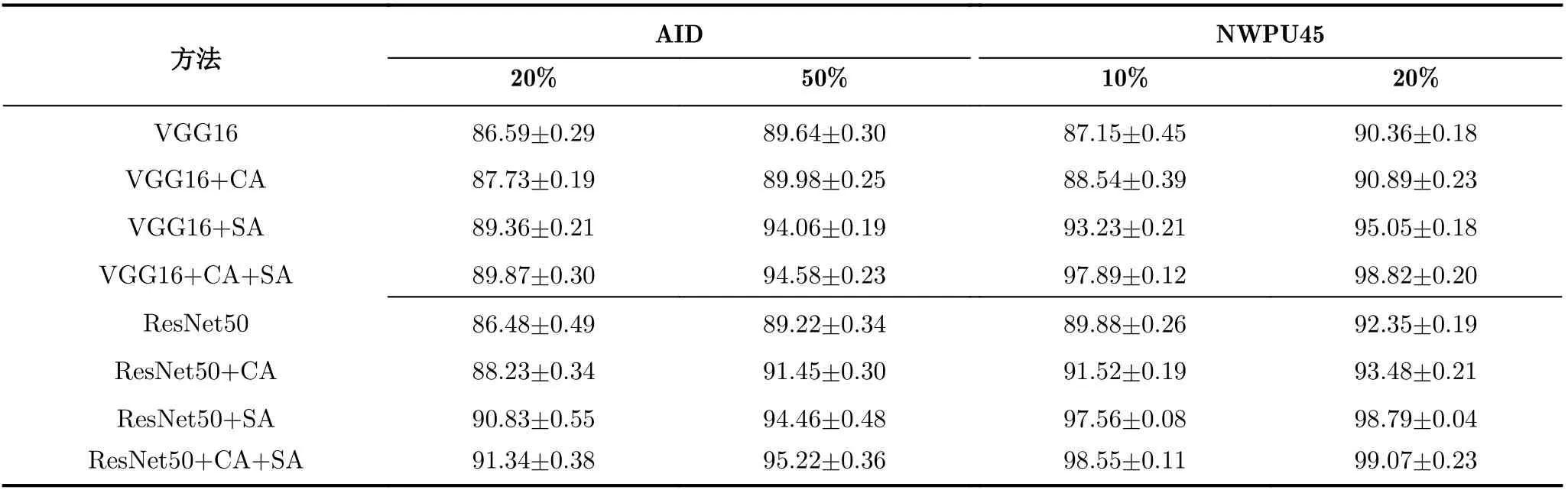

為了驗證雙重注意力模塊中各組成部分的作用,通過模型簡化測試的方法對兩種注意力模塊的有效性進行實驗驗證,分別用C A(C h a n n e l Attention module)和SA(Spatial Attention module)代表通道注意力模塊和空間注意力模塊,將兩類注意力模塊分別與基準網絡VGG16[18]和Res-Net50相連,在兩個數據集上的實驗結果對比如表1所示。

從實驗結果中可以看到兩個注意力模塊的有效性,具體分析如下:首先,在兩個基準網絡VGG16和ResNet50上,兩種注意力模塊都能提升深度卷積網絡所提取特征的表征能力,在兩個數據集上的整體分類準確率都取得了較明顯的提升,但空間注意力模塊的性能提升要更優于通道注意力模塊,本文認為這主要是由于受遙感圖像在成像范圍上廣闊性的影響,通過空間注意力模塊對局部顯著區域進行重點的關注更能提高對遙感圖像語義內容的理解;然后,通過表1可以發現兩種注意力模塊的結合能更進一步提高特征表示的鑒別性能力,使得基準網絡的分類準確率大幅提升,尤其在數據量更大、更具挑戰性的NWPU45數據集上,所提方法將原基準網絡的準確率提升到了99%,證實了兩種注意力模塊針對的側重點不同,可以相互補充、相互促進;最后,可以發現,兩個基準網絡的性能表現還存在著明顯差距,ResNet50的特征表征能力明顯超出VGG16,但所提的兩個注意力模塊都能較好適用于兩個基準網絡,證明了所提注意力模塊的適用性是可以與任意卷積神經網絡相結合。

3.3.2 與其他方法的對比及分析

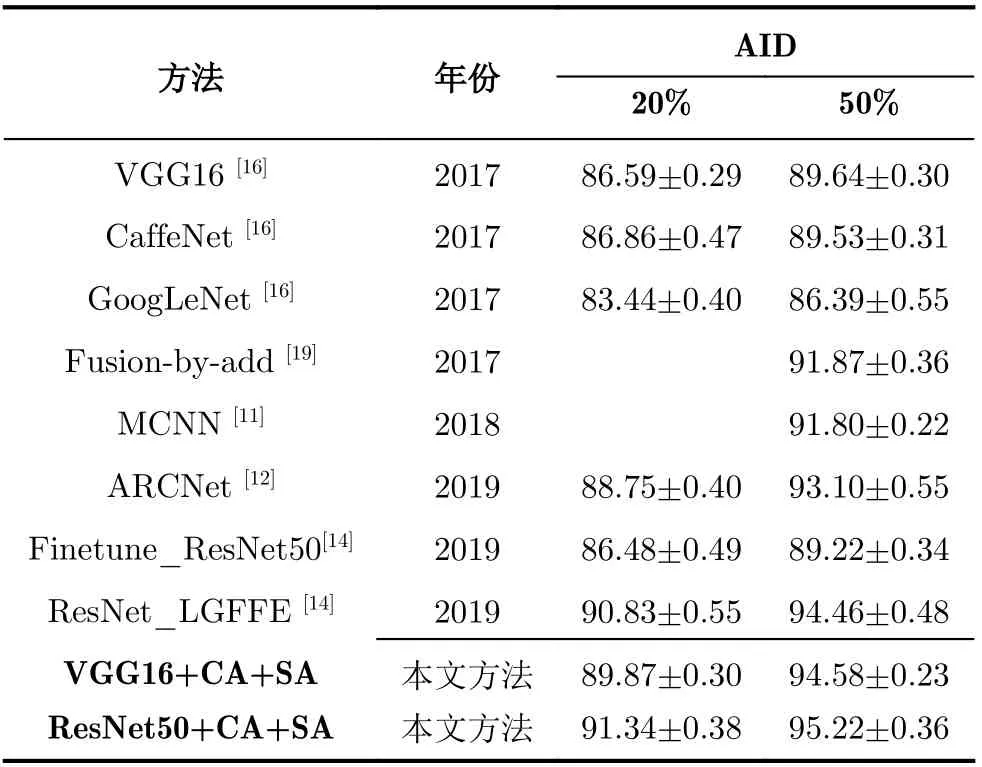

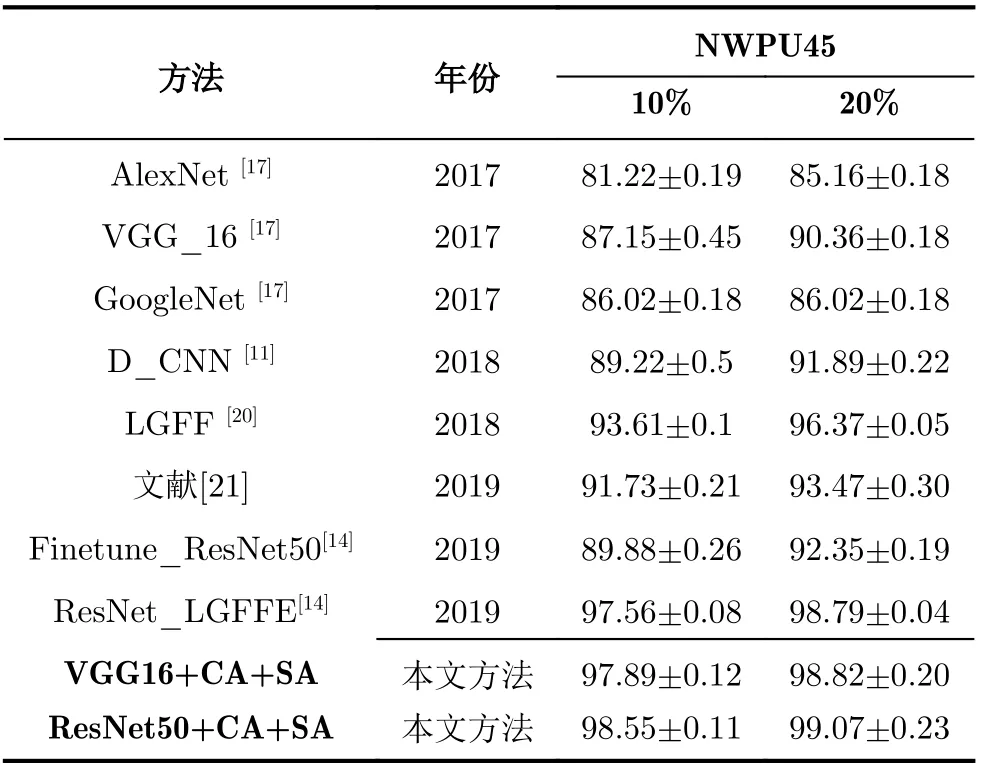

為了進一步驗證所提方法的有效性,在數據集AID和NWPU45上與近幾年的相關基準方法進行比較,實驗對比結果如表2和表3所示。

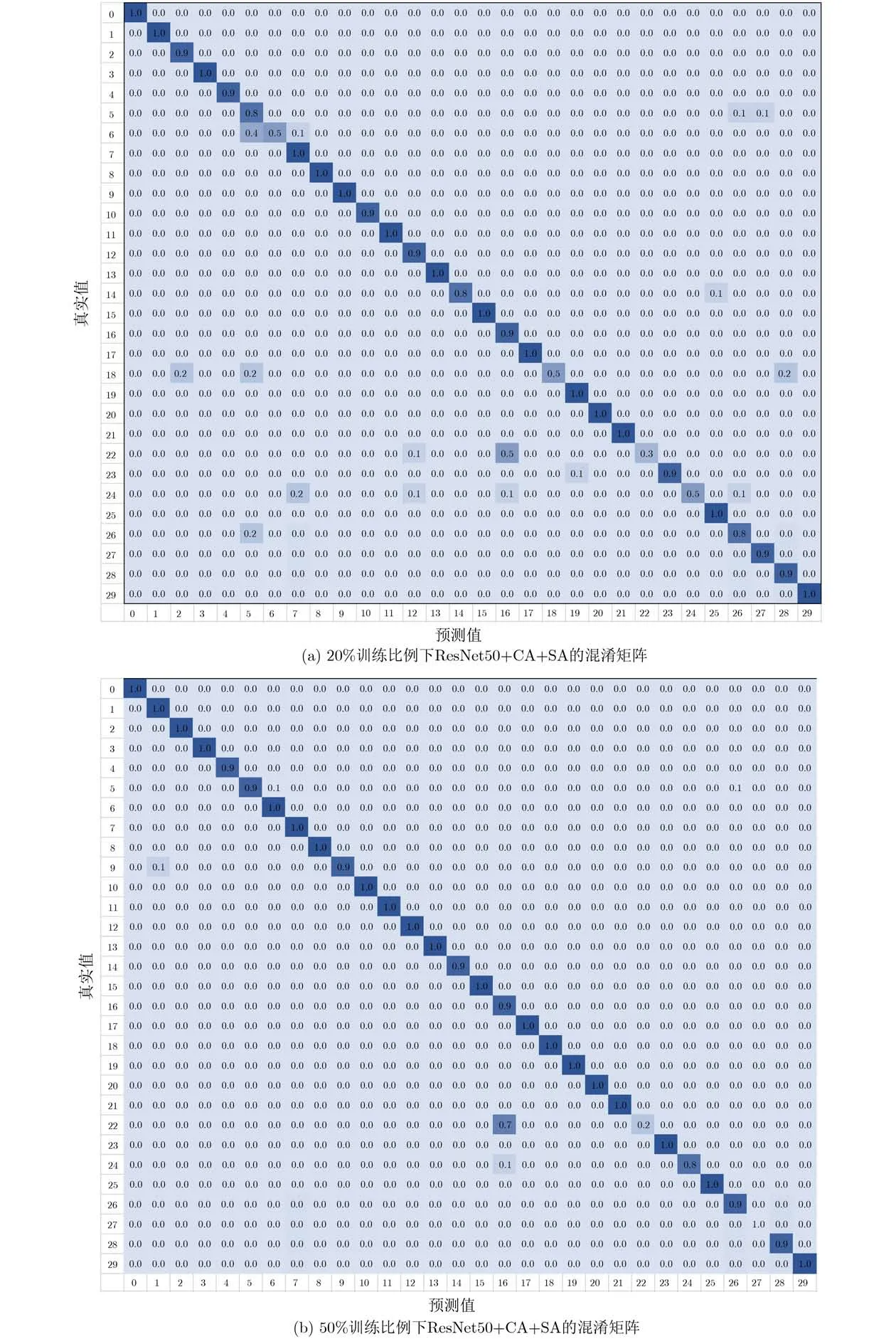

數據集AID下的對比結果如表2所示,本文所提方法在20%和50%兩種訓練比例下都實現了最佳性能表現,準確率超過了現有基準方法,分別達到了91%和95%左右的整體分類準確率。其中,2019年提出的方法ResNet_LGFFE將兩種訓練比例下原有最佳分類表現分別提高了2%和1.3%左右,在此基礎上,本文方法又將整體準確率分別提高了0.5%和0.8%,達到了最佳實現(SOTA)。數據集NWPU45下的實驗對比結果如表3所示,本文所提方法在兩種訓練比例下的準確率達到了98.55%和99.07%,接近于100%,較大提高了該數據集下的最佳實現。由此,在以上兩個數據集下的表現可以看出所提方法的有效性。此外,將所提的雙注意力模塊與ResNet50相結合在數據集AID下所取得的最佳混淆矩陣展示如圖4所示。

本文所提方法雖然能較明顯地提升特征表示的鑒別性能力,在兩個具有挑戰性的數據集上取得了較好的總體分類準確率,但是對局部特征和局部區域的過分關注也反而導致對相似類別圖像的混淆。如圖4的混淆矩陣所示,所提方法對各個類別的分類準確率都比較高,尤其在50%的訓練比例下,各個類別的準確率都接近1,但錯誤最明顯的是將真值為類別22(度假村,resort)的圖像大量誤判為類別16(公園,park)。以圖5中兩個類別的代表性圖像為例,可以發現兩類圖像在部分局部特征上存在較高的相似性,如游泳池、樹木和建筑等。而所提方法是在原有特征表示的基礎上對局部區域和局部特征的進一步關注,這就導致了所提方法在該數據集下訓練學習后,對度假村和公園的局部相似特征過分關注,導致了對兩個類別信息的混淆。

4 結束語

針對遙感圖像場景分類存在的類內差異性大、類間相似性高導致的分類準確率不高的問題,本文提出了一種雙重注意力模塊的特征表示方法,在CNNs提取的高層特征基礎上,分別從通道維和空間維各設計了一個注意力模塊,利用循環神經網絡的上下文信息提取能力,捕捉不同特征和不同區域間的重要性程度,以實現對重點區域和顯著特征的重點關注,對背景區域和非顯著特征進行忽略,以此提高特征表示的鑒別性能力。在兩個公開數據集上,本文方法均超過了現有基準方法,驗證了所提方法的有效性。但是,雙注意力模塊的引入不可避免地增加了一定的訓練時間,對訓練數據量有一定的要求,且通過實驗結果可以發現對局部特征相似的部分類別容易出現混淆的現象,下一步重點從自監督學習的角度出發,減少模型對訓練數據量的依賴。

表1 數據集AID和NWPU45下的模型簡化測試OA(%)結果對比表

表2 數據集AID下所提方法與其他基準方法的OA(%)結果對比表

表3 數據集NWPU45下所提方法與其他基準方法的OA(%)結果對比表

圖4 數據集AID下所提方法的混淆矩陣圖

圖5 數據集AID在所提方法中的誤判實例