采用輪廓特征匹配的紅外-可見光視頻自動配準

孫興龍,韓廣良,郭立紅,劉培勛,許廷發

(1.中國科學院 長春光學精密機械與物理研究所,吉林 長春 130033; 2.中國科學院大學, 北京 100049; 3. 北京理工大學 光電學院,北京 100081)

1 引 言

作為計算機視覺領域的重要組成部分,圖像融合技術[1]在近年來得到了深入的研究,尤其是多源圖像融合技術[2-4]。其中,紅外圖像和可見光圖像可以為觀測場景提供互補性的光譜信息,融合兩者[2,4]可以顯著地提升場景表述能力,因此在人臉識別、安防監控、軍事偵察、目標跟蹤等領域得到了廣泛應用[5-6]。作為圖像融合的關鍵預處理技術之一,圖像配準技術[7]致力于確定兩幅或多幅圖像之間的時空變換關系,進而在時間和空間上對齊待融合圖像。精確的圖像配準可以保證圖像融合的有效性和可靠性,具有重要的研究意義。

圖像配準的核心工作是在待配準圖像間尋找一致性信息,但這對于紅外-可見光圖像而言是一個十分具有挑戰性的問題。紅外傳感器的成像原理是記錄場景的熱分布,而可見光傳感器是記錄場景的反射光分布。成像原理的不同導致兩類圖像存在強烈的強度差異和紋理差異。例如,紅外圖像往往遺漏物體的細節信息,但這在可見光圖像中卻清晰可見。在此情況下,如何有效地為圖像配準提取一致性信息是一個值得探究的問題,諸多學者已經對此展開了深入的研究和分析。

目前已經存在的紅外-可見光圖像配準算法主要基于以下三類信息:區域信息、特征信息及運動信息。區域信息配準算法[8-10]的基本思想是直接或間接地利用圖像強度信息計算一種相似性度量函數,通過最優化度量函數確定配準參數。其主要包括相關類算法和互信息法。相關類算法[9]主要通過最大化各個候選圖像子窗之間的互相關函數確定匹配窗口對,進而得到一致性信息。互信息方法[8,10]采用聯合信息熵(互信息函數)作為損失函數,通過最優化損失函數確定配準參數。總體而言,區域信息配準算法嚴重依賴于圖像強度信息,難以克服異源圖像之間強度差異的影響。

基于特征信息的配準算法首先需要從圖像中提取特征,然后通過匹配特征計算兩幅圖像間的變換關系。經常采用的特征包括點、邊緣等。作為最常見的特征,點特征已經被普遍地應用于配準領域,如角點[11],SIFT特征點[12]及SURF[13]特征點。但由于紅外-可見光圖像之間的強度差異和紋理差異,利用這些點特征進行配準并不可靠。紅外-可見光傳感器可以同時捕獲場景中的邊緣信息,因此采用邊緣信息配準是一種可行的方案。Klimaszewski等人[14]通過衡量相位相關度匹配紅外-可見光邊緣,而Ma等人[6]采用復雜的高斯區域準則匹配邊緣映射信息。此外,Ming等人[15]通過在邊緣上提取CSS(Curvature Scale Space)角點進行圖像配準。但是,邊緣分布在紅外-可見光圖像中并不完全一致,且非常容易受到噪聲的影響,直接采用邊緣信息難以保證配準精度。

由于靜態特征的配準精度受限,近年來逐漸出現了基于運動信息的配準方法。此類方法首先采用運動目標檢測技術[16-17]提取目標前景,然后根據前景特征完成配準工作。其中,王洪慶等人[18-19]通過采用跟蹤目標頂點的方式確定目標運動軌跡,并通過軌跡匹配計算配準矩陣。然而精確地檢測目標頂點的難度較大,得到的特征數量也有限。另一類方法[20-22]是提取目標前景的輪廓曲線,在進行配準時對輪廓曲線或曲線上的特征點進行匹配。此類方法可以達到較高的配準精度,是目前配準效果比較突出的一類配準算法。

然而,基于輪廓特征的配準方法仍然存在著一些缺陷。首先,在特征匹配之前并沒有對特征進行充分的描述,導致匹配的精確度不足;此外,在近平面場景中物體的深度位置并不完全固定,而這些方法僅僅根據當前時刻的配準效果確定全局配準矩陣,往往導致矩陣陷入局部最優解,無法精確地配準整個視頻序列。

為了解決上述問題,本文提出了一種新的配準方法,其根據輪廓曲線的空間分布對特征進行描述,提升了特征匹配的可靠性;在估計全局配準矩陣時,綜合考慮了配準參數在多個時刻的配準效果,防止其陷入局部最優解。實驗結果表明,本文算法在近平面場景中可以實現高精度的紅外-可見光視頻配準,其精度優于當前先進的其它配準算法。

2 輪廓特征配準方法的基本原理

基于輪廓特征的配準算法[20-22]通過利用目標的運動信息克服了紅外-可見光圖像間強度差異與紋理差異的影響,在紅外-可見光圖配準領域具有重要的參考價值。這類算法主要包含特征提取、特征匹配及配準參數計算三個步驟。

2.1 輪廓特征提取

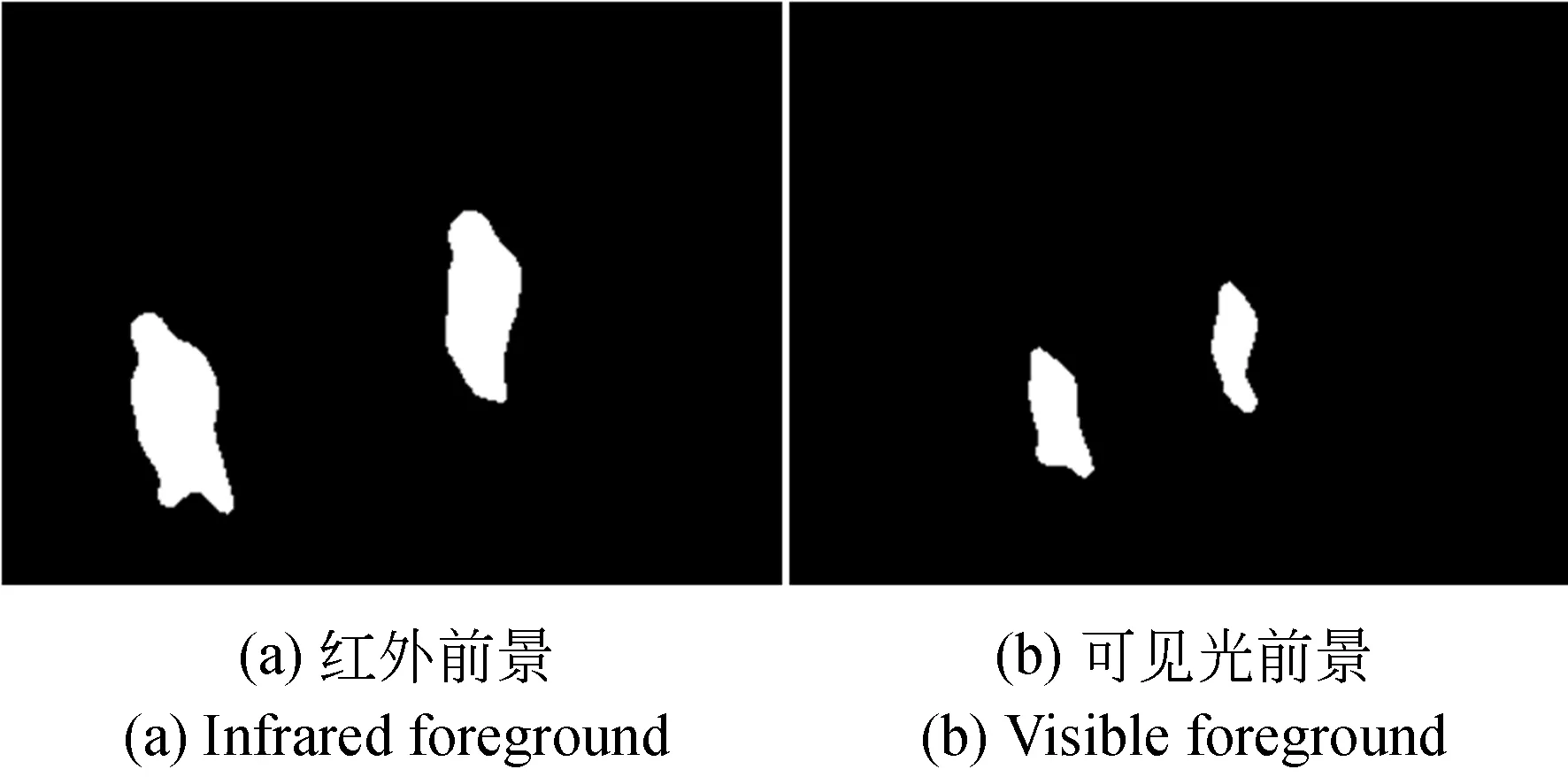

為了捕獲運動目標的輪廓特征,首先需要采用運動目標檢測技術檢測目標前景。目前在配準領域被經常使用的運動目標檢測算法是St-Charles等人提出的PAWCS算法[17]。該算法根據顏色特征信息和二值化特征信息對背景進行統計建模,并對統計模型進行負反饋更新,最后通過背景減除的方式提取運動目標。為了抑制噪聲和光線變化等因素的干擾,濾波、腐蝕和膨脹等操作在這一過程也經常被使用。圖1給出了利用PAWCS(Pixd-based Adaptive Word Consensus Segmenter)算法提取到的紅外-可見光前景圖像。

圖1 運動目標檢測的結果Fig.1 Results of motional target detection

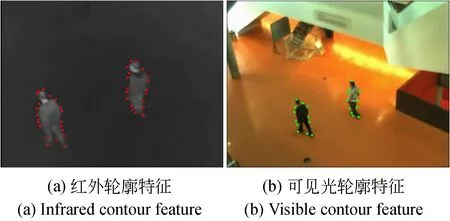

在提取了運動目標以后,利用簡單的邊緣檢測技術即可獲得目標輪廓曲線。目前的配準算法通過多種手段從曲線上提取特征。其中,Sonn等人[20]采用曲線演化理論獲取特征點,而Charles等人[21]直接將所有輪廓點作為特征。另一種方式是利用CSS角點檢測算法[15,22]提取特征,主要包含以下步驟:(1)在大尺度空間下計算所有輪廓點的曲率值,選取鄰域極大值點作為候選角點;(2)在低尺度空間下精確定位候選角點,將其與T型角點進行比較剔除,得到最終的檢測結果。該方法具有定位準確、計算量小等優勢,且提取的特征具有尺度不變性和旋轉不變性。本文采用該算法提取配準特征點,提取到的紅外-可見光輪廓特征如圖2所示。

圖2 CSS角點檢測的結果Fig.2 Results of CSS corner detection

2.2 輪廓特征匹配

特征匹配是圖像配準的核心任務,精確有效的特征匹配是實現高質量圖像配準的前提。目前已經出現了多種輪廓特征匹配策略,各種類型的特征描述子也已被采用。Sonn等人[20]在曲線演化理論的基礎上引入了距離描述子和方向描述子,通過計算描述子之間的距離匹配紅外-可見光特征點。Sun等人[22]采用歸一化位置和邊緣方向直方圖描述特征點,并以歸一化距離作為匹配度量函數。盡管這些描述子在輪廓特征匹配的過程中起到了一定作用,但描述方法過于簡單,無法保證匹配質量。因此本文建立新的特征描述機制,以完成精確地特征匹配。

2.3 配準參數計算

在完成特征點匹配后,可利用匹配點對計算配準參數。目前常用的是隨機一致性(RANSAC)算法[23]。其首先隨機選取若干點對計算配準參數,并根據該參數計算各匹配點對之間的距離,方式如式(1)所示:

(1)

其中: (xi,yi)和(xj,yj)分別表示點對中紅外和可見光特征點的位置,Z表示插值變換,M表示配準參數。當點對之間的距離小于T(一般T=5)時,認為其是矩陣的內點,否則視為外點。多次循環以上步驟,選取內點數量最多的配準參數作為最終結果。

在視頻序列配準問題上,僅根據當前時刻的配準參數難以實現精確配準。因此,許多算法[20-22]采用迭代更新的策略確定一個全局配準矩陣。采用初次得到的配準矩陣初始化全局配準矩陣,并計算當前時刻配準矩陣和全局配準矩陣在當前紅外-可見光前景上的重疊率誤差,計算方式如式(2)所示:

(2)

其中:SI表示紅外前景圖像,SV表示可見光前景圖像,M表示配準矩陣,Z表示插值變換。此后,可以根據兩個矩陣的重疊率誤差判斷如何根據當前配準矩陣更新全局配準矩陣,實現最終地配準。

3 改進的輪廓特征匹配式紅外-可見光視頻配準

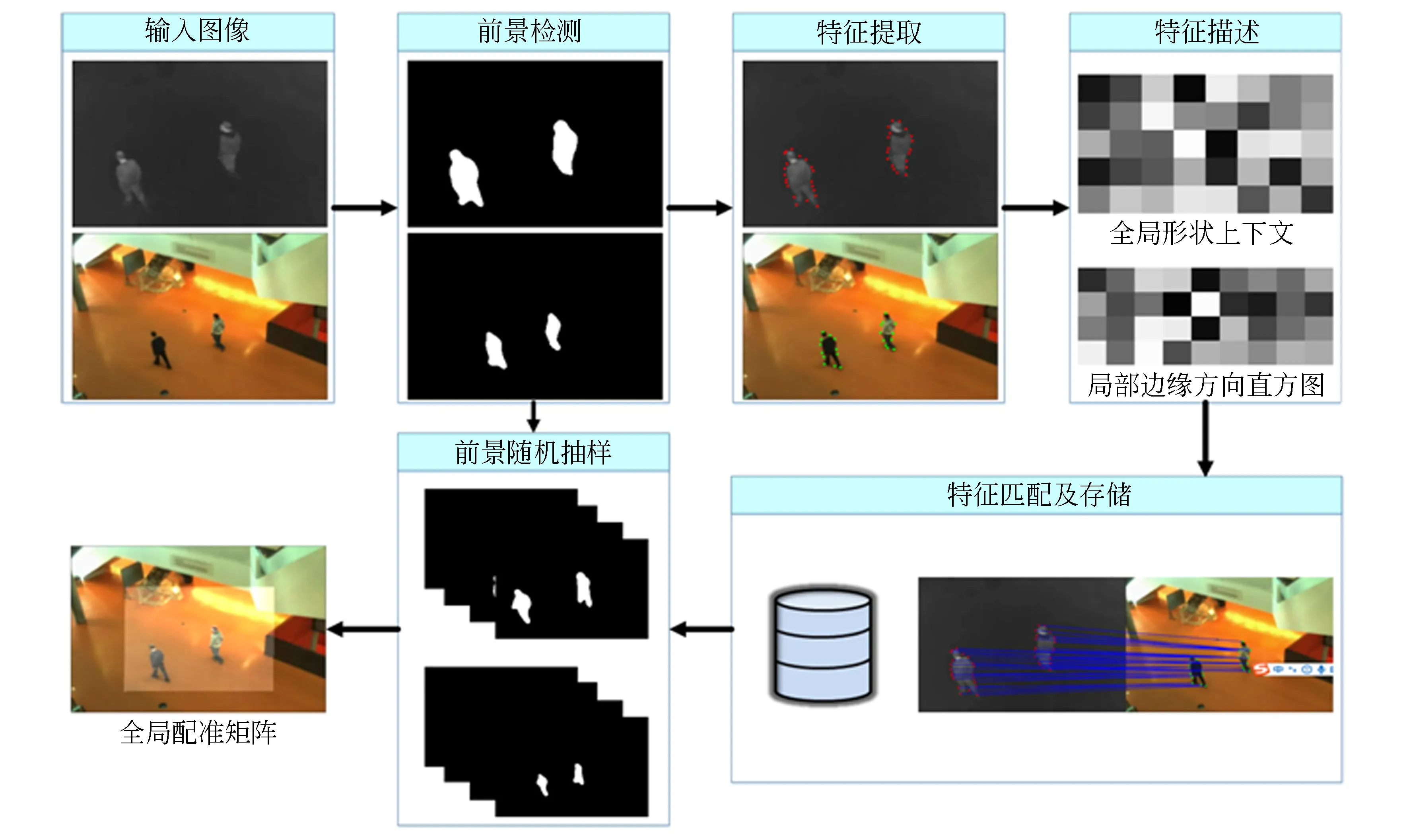

3.1 原理框架

圖3呈現了本文紅外-可見光視頻配準方法的基本流程。對于輸入的紅外-可見光視頻序列,首先由PAWCS目標檢測算法提取目標前景,并采用CSS角點檢測算法在前景輪廓上提取配準特征點。此后,為每個特征點建立兩個描述子:根據全局輪廓形狀信息建立形狀上下文描述子;根據局部輪廓方向信息建立邊緣方向直方圖描述子。接著,根據描述子之間的相似程度匹配紅外-可見光特征點,并用一個基于高斯距離準則的特征匹配庫保存不同時刻的特征點對。最后,采用RANSAC(Random Sample Consensus)算法計算

圖3 本文配準算法框架示意圖Fig.3 Framework of proposed registration method

當前時刻的配準矩陣。對不同時刻的前景樣本進行隨機抽樣選取,根據在抽取樣本上的前景重疊率誤差判斷是否更新全局配準矩陣,完成對紅外-可見光視頻序列的配準。在后續的章節中,會對方法進行詳細介紹。

3.2 特征描述

論文首先利用PAWCS算法檢測目標前景,并從前景輪廓上提取CSS特征點。此后,為了保證特征匹配質量,需要進行特征描述。但輪廓特征點來源于二值化前景圖像,一般的描述方法并不可靠。為此,論文建立兩種新的特征描述子。

3.2.1 全局形狀上下文描述子

當紅外-可見光相機的拍攝視角差異不是十分明顯時,在兩種圖像中目標的輪廓形狀具有相似性。論文采用形狀上下文算法統計目標輪廓形狀的空間分布,建立全局形狀上下文描述子。對于第k個CSS特征點,首先計算所有輪廓點與該點之間的距離值和角度值,計算公式如下:

(3)

在統計了所有輪廓點的空間分布后,需要進行歸一化編碼處理來保證描述子的尺度不變性和旋轉不變性。選取距離當前特征點最遠的輪廓點作為歸一化編碼的參考點,距離歸一化編碼的公式如式(4)所示:

(4)

(5)

(6)

在量化編碼后,歸一化角度編碼值只能取1,2,…,8等8個整數值。最后,對所有輪廓點的距離編碼和角度編碼進行直方圖統計,為當前特征點建立一個40維的形狀上下文描述子,表示如下:

Hi=P(i),i=1,2,...,40,

(7)

3.2.2 局部邊緣方向直方圖描述子

運動目標檢測的結果存在著一定的誤差,導致僅利用輪廓形狀的全局空間分布可能會誤匹配鄰近特征點。因此,論文同時根據特征點鄰域的輪廓方向分布描述特征,建立局部邊緣方向直方圖描述子。為剔除尺度縮放和旋轉變換的影響,首先對紅外特征的鄰域輪廓點(x,y)進行重新定位,方式如下:

(8)

Ei=P(i),i=1,2,...,32,

(9)

其中:i表示方向索引值,P(i)表示方向索引值i出現的概率。

3.3 特征匹配及存儲

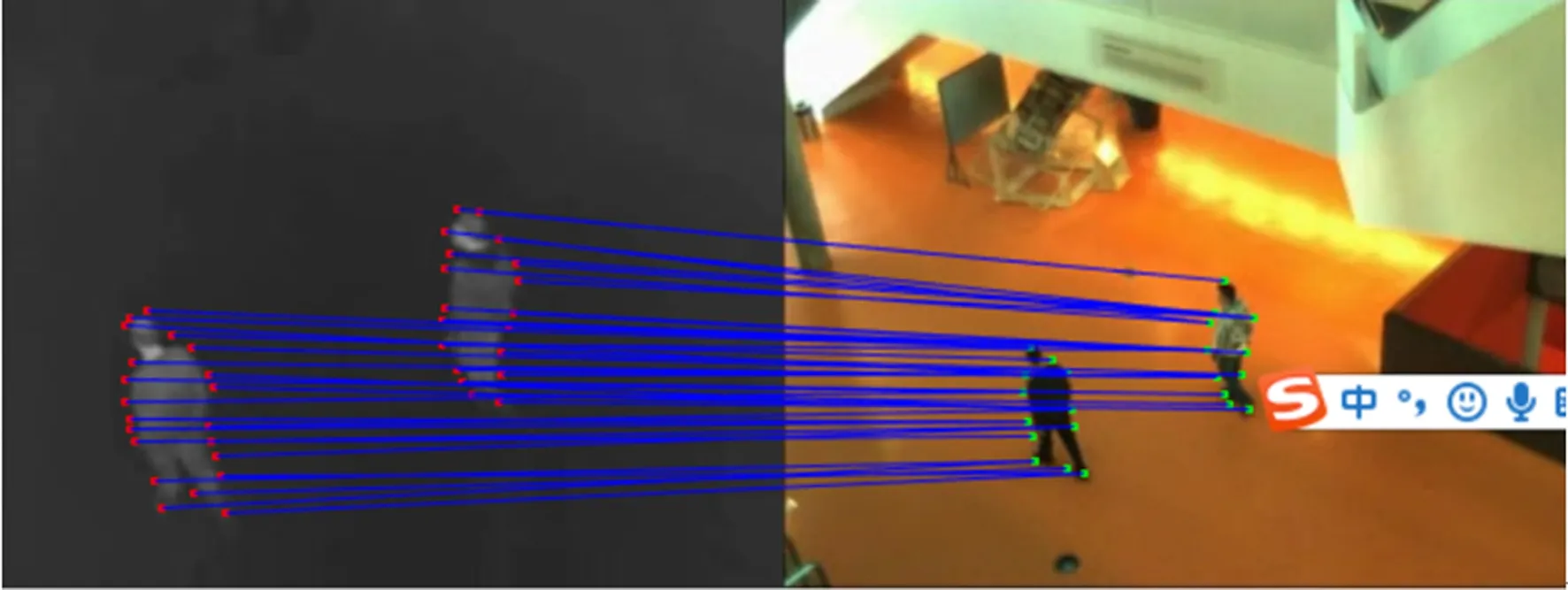

3.3.1 特征匹配

論文根據已經建立的特征描述子匹配紅外-可見光輪廓特征點。首先對兩種描述子進行拼接,為每個特征點建立一個72維的綜合描述子,表示如式(10)所示:

Gi=G(i),i=1,2,...,72.

(10)

該描述子的前40維表示全局形狀上下文描述子,后32維表示局部邊緣方向直方圖描述子。此后,采用χ2統計函數計算兩個特征點的匹配程度,公式如式(11)所示:

(11)

其中GI(k)和GV(k)分別表示紅外和可見光特征點的綜合描述子。χ2統計函數值越低,兩個特征點的匹配程度越高。在匹配過程中,論文采用雙向匹配策略。對于每個紅外特征點,選取匹配程度最高的可見光特征點作為候選匹配點。同時,根據相同的方式為每個可見光特征點確定紅外候選匹配點。若一對紅外-可見光特征點互為候選匹配,則將它們視為最終的匹配點對。雙向匹配策略可以有效地降低誤匹配的概率,特征匹配的結果如圖4所示。

圖4 特征匹配的結果Fig.4 Results of feature matching

3.3.2 特征存儲

在視頻序列的配準問題上,僅采用當前時刻的匹配點對難以實現高精度配準。目前,多種特征匹配庫[20-22]已經被用于保存來自不同時刻的特征點對,如先入先出(First in, First out)的匹配庫[20]。為了更有效地剔除外點,保留可靠的匹配點對,論文采用一種基于高斯距離準則的特征匹配庫。首先計算每對匹配點之間的高斯距離,公式如式(12)所示:

λ·C(GI(i),GV(i))),

(12)

其中:xI(i)和xv(i)分別表示匹配點對中紅外和可見光特征點的位置,Z表示已經得到的全局配準矩陣(見章節3.4),d表示歐氏距離函數。C(GI(i),GV(i))表示該點對的匹配程度,計算方式如式(11)。σ表示高斯權重因子,一般取值為100。λ表示特征點距離和匹配度之間的平衡因子,一般取值為0.3。利用高斯距離準則可以綜合衡量匹配點對的匹配度以及其對當前配準參數的適應性,有利于提升匹配點對的質量。此后,當匹配庫中的點對數量超過上限容量時(一般設置為500),將高斯距離最小的1/3視為外點點對。當獲取新的匹配點對后,利用其隨機替代外點點對,完成匹配庫更新。

3.4 計算全局配準矩陣

根據不同時刻的特征點對,采用RANSAC算法即可計算當前時刻的配準參數。此后,可以基于當前時刻的前景重疊率誤差更新全局配準矩陣,使全局配準矩陣時刻趨向于配準當前時刻目標。但在近平面場景中,運動目標在不同時刻可能存在深度差異,配準了當前時刻的目標并不意味著精確配準了整個視頻序列,全局配準矩陣可能陷入了局部最優解。

為解決該問題,論文提出了前景樣本隨機抽樣策略,核心思想是結合多個時刻的目標前景估計全局配準矩陣,避免其陷入局部最優。該策略首先建立一個前景樣本庫,保存不同時刻的紅外-可見光前景樣本對。當庫中樣本對的數量達到上限時(一般設置為50),根據前一時刻的全局配準矩陣對所有紅外前景樣本進行插值變換。在變換后,計算紅外-可見光前景樣本對的重疊率誤差,將誤差值最大的1/3視為外點樣本對。在得到新的前景樣本對后,利用其隨機替換庫中的外點樣本對,完成對前景樣本庫的更新。

在配準矩陣的迭代更新過程,首先從樣本庫中隨機抽取部分前景樣本計算當前時刻配準矩陣和全局配準矩陣的重疊率誤差,公式如下:

(13)

Mp=(1-β)·Mp+β·Mc,

(14)

其中:Mp,Mc分別表示全局配準矩陣和當前時刻配準矩陣。β表示更新步長,一般取值為0.25。通過引入前景樣本隨機抽樣策略,全局配準矩陣可以更準確地配準整個視頻序列。

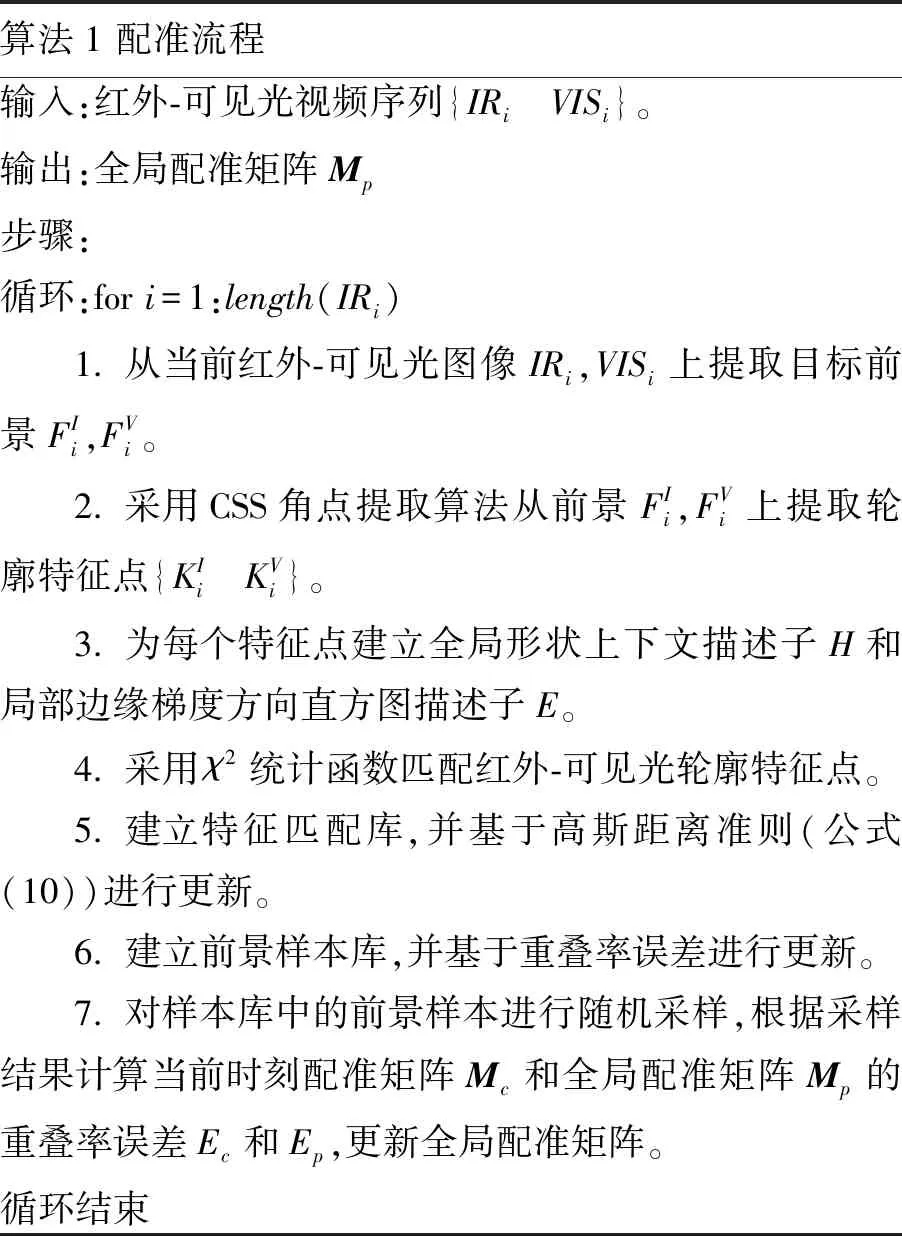

為了清晰地呈現本文方法的主要思想,算法1給出了本文方法的基本流程。

算法1 本文算法的整體配準流程

Algorithm. 1 Integral registration flow of our method

算法1 配準流程輸入:紅外-可見光視頻序列{IRi VISi}。輸出:全局配準矩陣Mp步驟:循環:for i=1:length(IRi)1. 從當前紅外-可見光圖像IRi,VISi上提取目標前景FIi,FVi。2. 采用CSS角點提取算法從前景FIi,FVi上提取輪廓特征點{KIi KVi}。3. 為每個特征點建立全局形狀上下文描述子H和局部邊緣梯度方向直方圖描述子E。 4. 采用χ2統計函數匹配紅外-可見光輪廓特征點。5. 建立特征匹配庫,并基于高斯距離準則(公式(10))進行更新。6. 建立前景樣本庫,并基于重疊率誤差進行更新。7. 對樣本庫中的前景樣本進行隨機采樣,根據采樣結果計算當前時刻配準矩陣Mc和全局配準矩陣Mp的重疊率誤差Ec和Ep,更新全局配準矩陣。循環結束

4 實驗測試與結果分析

4.1 實驗設置

4.1.1 數據集

為了驗證本文方法的精確度和魯棒性,實驗在公開通用的LITIV視頻配準數據集上進行。該數據集由Torabi等人提供[19],包含9組紅外-可見光視頻序列。視頻分辨率為240×320,視頻長度在300~1 300 frame之間。由于成像傳感器與被拍攝場景之間的距離較遠,所有的圖像均滿足近平面假設條件。此外,數據集為每組視頻序列提供了手動標定的Ground-Truth配準矩陣。在衡量本文方法的配準表現時,可以將該矩陣視為基準參考,從而體現出方法的精確性。

4.1.2 對比算法

實驗將本文算法與其他兩種先進的配準算法進行比較,進而突出本文算法的優勢。第一種算法是Charles等人提出的基于輪廓特征的配準算法[21]。該算法將所有目標輪廓點作為配準特征,并利用目標形狀信息對特征進行描述。第二種算法是王洪慶等人提出的基于目標運動軌跡匹配的配準算法[18]。該算法通過采用多目標跟蹤技術確定每個目標的運動軌跡,并為每條軌跡建立歸一化運動距離描述子和歸一化運動方向描述子。對比算法皆采用RANSAC算法確定當前時刻的配準參數,并根據當前時刻前景上的重疊率誤差更新全局配準矩陣。

4.1.3 評價指標

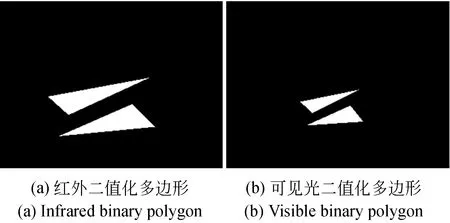

為了量化本文算法和對比算法的配準能力,實驗采用多邊形重疊率誤差作為配準精度的評價指標。首先需要為每對紅外-可見光視頻序列構建二值化多邊形圖像對,方法如Torabi等人[19]所述:從紅外和可見光圖像中人工地選取一些易于識別的關鍵點并進行手動匹配,按照相同的順序分別依次連接這些關鍵點,得到二值化多邊形圖像。實際上,Charles等人[21]已經為每組視頻序列建立了二值化多邊形圖像,第一組視頻序列的多邊形圖像如圖5所示。實驗直接采用這些多邊形圖像計算配準誤差。對于二值化多邊形圖像的重疊率誤差,計算公式同前景圖像的重疊率誤差,如公式(2)所示。區別是采用二值化多邊形圖像代替了前景圖像,避免了前景檢測誤差的影響。

圖5 LITIV-1序列上的二值化多邊形Fig.5 Binary polygons on LITIV-1 sequence

4.2 結果分析

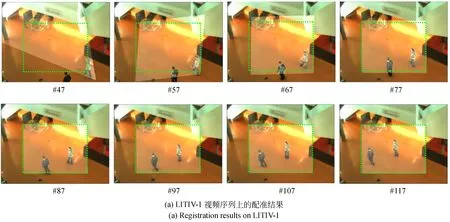

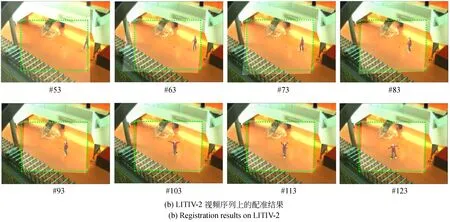

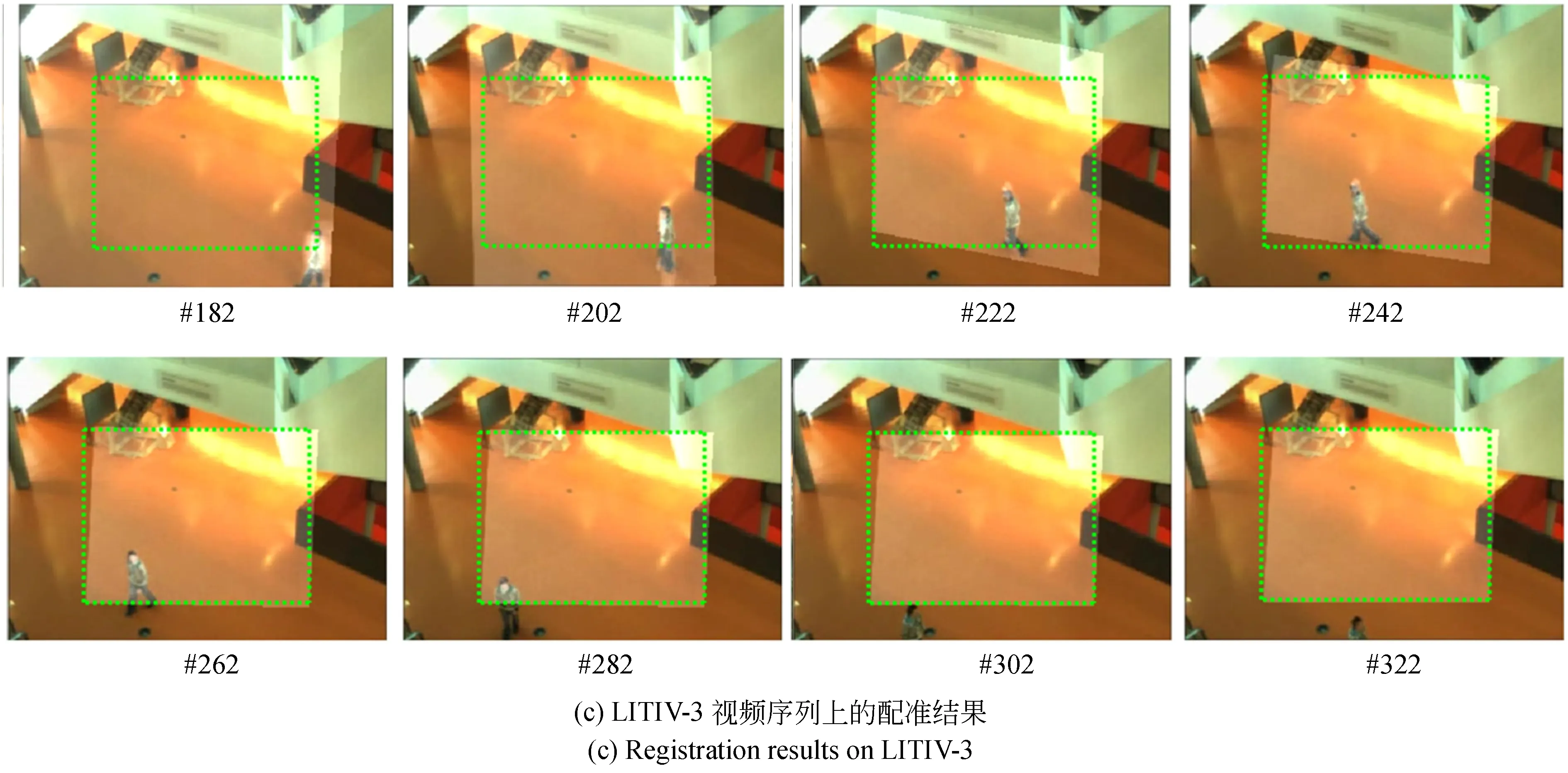

論文方法對LITIV數據庫中前3個視頻序列的配準結果如圖6所示。實驗采用全局配準矩陣對紅外圖像進行插值變換,并將其疊加在可見光圖像上,表示最終的配準結果。此外,根據Ground-Truth矩陣對紅外圖像的邊界進行重定位,并以綠色矩形框的形式疊加在可見光圖像上,表示Ground-Truth矩陣的配準結果。

在每個序列的結果圖像中,第一幅圖像給出了目標初次同時進入紅外-可見光視場時的配準結果。可以看出,本文方法并不能立刻精確地配準兩幅圖像。這是因為此時匹配點對的數量較少,且紅外-可見光目標前景存在較大的空間差異。但隨著算法的運行,匹配點對的數量會急劇增多,目標的空間分布也會逐漸趨于一致。此時,論文方法輸出的配準參數能夠迅速收斂,配準結果十分接近于Ground-Truth矩陣。這說明本文方法可以快速有效地配準紅外-可見光視頻序列。

同時,可以看出本文方法在不同序列上的收斂速度有所差異。對于前兩個視頻序列,本文提出的方法在目標進入視場后的40幀內即可獲得準確的全局配準矩陣。但對于第3個視頻序列,在目標進入視場后需要80幀左右的時間才能夠計算出可靠的配準參數。引起這一差異的主要原因是目標運動的速度差異和區域差異。在第三個視頻序列中,目標的運動速度較慢,且運動區域始終局限在一個較小的空間范圍內,導致得到的匹配點對不具有全局代表性。

圖6 LITIV數據集上的配準結果(前3個視頻對)Fig.6 Registration results on LITIV dataset (for the first three video pairs)

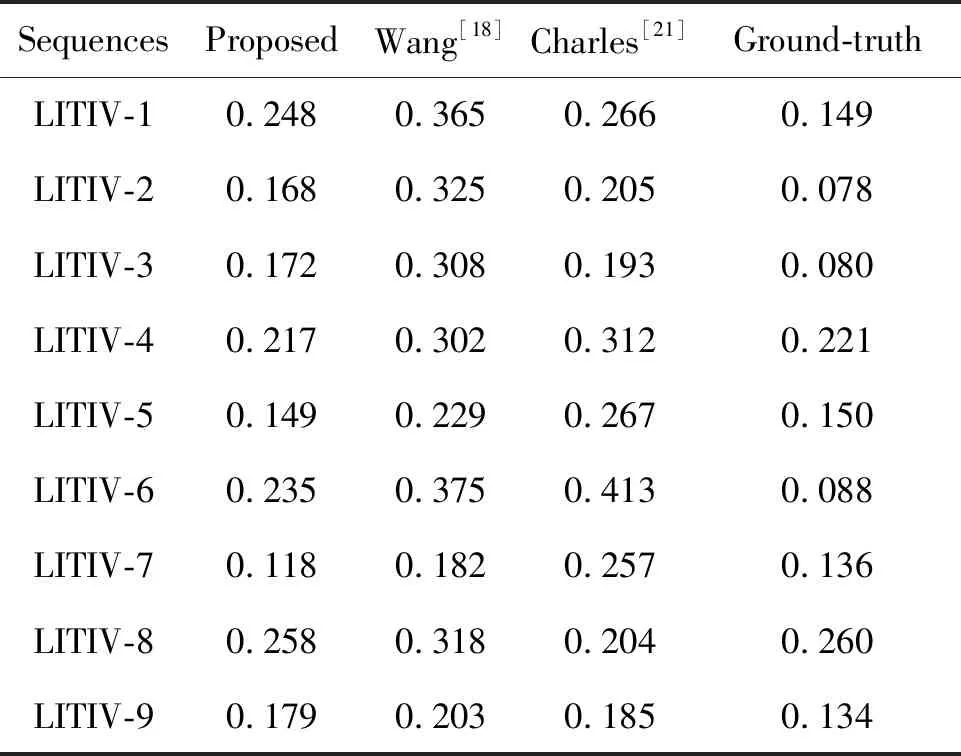

為了定量地評價本文方法在各個視頻序列上的整體表現,表1給出了本文方法和其他對比方法的平均重疊率誤差。分析得知,本文方法在9個視頻序列上的平均重疊率誤差僅為0.194,與對比方法相比下降了18.5%,充分表明了本文方法的精度優勢。

表1 平均重疊率誤差Tab.1 Average overlap error

下面詳細介紹本文方法在各個序列上的配準表現。對于序列LITIV-4,LITIV-5,LITIV-6和LITIV-7,本文方法顯著降低了配準誤差,下降比例分別為 28.1%,34.9%,37.4%和35.2%。對于序列LITIV-1,LITIV-2,LITIV-3和LITIV-9,本文方法也較為明顯地提升了配準精度,提升比例分別為6.8%,18.0%,10.9%和3.2%。這充分證明了本文方法的有效性:通過建立全局形狀上下文描述子和局部邊緣方向直方圖描述子,有效地提升了特征匹配質量;通過在計算全局配準矩陣的過程中引入前景樣本隨機抽樣策略,有效地避免了全局配準參數陷入局部最優解。與其他視頻序列相比,本文方法在序列LITIV-4,LITIV-5,LITIV-6和LITIV-7上對配準精度的提升更為顯著。這主要是因為在這些序列上運動目標的深度變化更為明顯,而本文方法在計算配準參數時能夠充分降低深度變化帶來的影響。

對于序列LITIV-8,本文方法的配準精度不如Charles等人提出的對比方法[21]。導致此情況的主要原因是該序列的前景檢測結果質量較差,嚴重影響了本文方法在特征提取和匹配時的可靠性。Charles等人的算法由于直接將所有目標輪廓點視為配準特征,同時僅利用目標形狀信息對特征進行描述,所以能夠達到更高的配準精度。

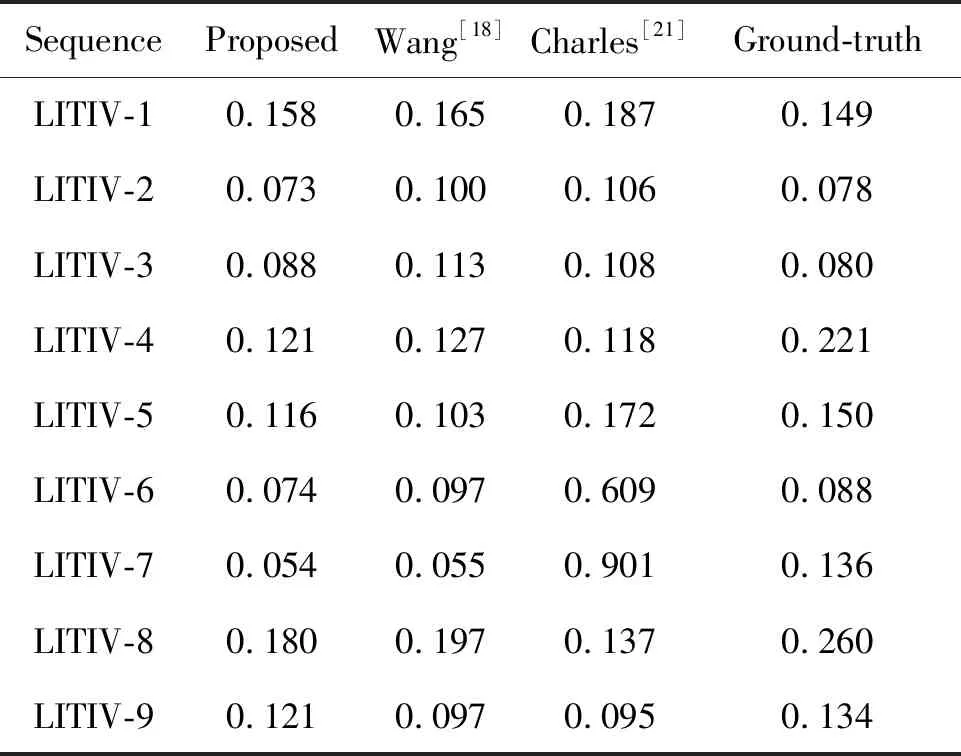

本文方法和對比方法在各個視頻序列上能夠達到的最小重疊率誤差如表2所示。實際上,實驗采用的兩種對比算法都是根據當前時刻的前景重疊率誤差估計全局配準矩陣,而計算配準誤差所用的二值化多邊形同樣是建立在某一時刻的前景上。因此在理論上,對比算法應該可以達到更低的最小重疊率誤差。但從實驗結果可以看出,本文算法在多數視頻序列上取得了更低的最小重疊率誤差。這一現象充分證明了本文方法的特征匹配質量更高,保證了配準參數的精確性。

表2 最小重疊率誤差Tab.2 Minimum overlap error

根據表1和表2給出的配準誤差,可以發現論文方法在某些序列上的精度超過了Ground-Truth矩陣。這主要是因為Ground-Truth矩陣是通過手動挑選紅外-可見光關鍵點構建的,其存在著不可避免的人為誤差。此外,Ground-Truth矩陣只能夠完美地配準平面場景圖像,無法克服近平面場景中目標深度變化的影響。以上因素也導致Ground-Truth矩陣在各個序列上的配準誤差并不為0。同時,由于本文方法和對比方法都是根據前景重疊率誤差迭代更新全局配準參數,往往能夠更好地適應目標的深度變化,從而比Ground-Truth矩陣取得更高的配準精度。

5 結 論

為了提高近平面場景下紅外-可見光視頻序列配準的精確度與魯棒性,本文提出了一種基于輪廓特征匹配的自動配準方法。該方法在特征描述匹配和全局配準矩陣計算兩個方面對傳統輪廓特征配準算法進行了改進,提升了配準精度。在特征匹配階段,本文方法為每個輪廓特征點建立了全局形狀上下文描述子和局部邊緣方向直方圖描述子,利用全局輪廓形狀信息和局部輪廓方向信息提升特征匹配質量。此后,在計算全局配準矩陣的過程中建立了前景樣本隨機采樣策略,結合多個時刻的紅外-可見光前景樣本克服目標深度變化的影響,避免全局配準矩陣陷入局部最優解。實驗結果顯示,本文方法在9個測試視頻上的平均重疊率誤差僅為0.194,與其他兩種先進的配準方法相比下降了18.5%。論文提出的方法基本滿足近平面場景下紅外-可見光視頻序列自動配準的精度要求,且具有較高的魯棒性。