一種基于SVM的核相關跟蹤算法

袁 康, 魏大鵬, 趙從梅, 傅 順

(1.重慶郵電大學 計算機科學與技術學院,重慶 400065; 2.中國科學院 重慶綠色智能技術研究院,重慶 400714)

0 引 言

視覺跟蹤在計算機視覺領域是一個具有挑戰性的問題。在許多應用中扮演著重要角色,尤其是人機交互、智能監控、機器人等多個領域[1,2]。所謂的跟蹤任務是僅給出其初始位置,估計圖像序列中目標的軌跡。雖然過去幾十年,視覺跟蹤取得了很大的成功[3~6],但是由于光照變化、幾何變形、遮擋和背景干擾等因素的存在,使得設計穩健高效的目標跟蹤器依然存在諸多問題。

最近,相關濾波器被引入到視覺跟蹤應用中,并取得了很好的跟蹤效果。相關濾波器的本質思想是相關性可以在傅立葉域中快速計算以避免耗時的卷積運算。Bolme D S等人[7]提出了最小化輸出平方誤差和輸出(minimizing the output sum of squared error,MOSSE)的自適應相關濾波器對目標外觀進行建模跟蹤,相關濾波器中使用卷積理論來加速跟蹤。Henriques J等人[8]提出了采用循環結構的核跟蹤器(circulant structure with kernels tracker,CSK),利用圖像中鄰近子窗口的循環結構,對目標特征區域進行密集采樣快速訓練核化正則最小方差分類器。Henriques J等人又對CSK進行了擴展,在相關跟蹤中使用多通道特征的核化脊回歸模型,提出了核相關濾波器(kernelized correlation filter,KCF)[9]。Danelljan M等人[10]引入了顏色名稱(color names,CN)顏色信息來提高在彩色圖像中的跟蹤性能,隨后又提出了利用一個獨立的尺度濾波器來進行精確尺度評估的判別式尺度空間跟蹤(discriminative scale space tracker,DSST)跟蹤器[11]。張開華[12]等人利用時空上下文信息結合貝葉斯框架來進行相關跟蹤。上述跟蹤方法雖然取得了很好的跟蹤效果,但是不能有效地進行遮擋處理,很大程度上限制了跟蹤性能。

本文在傳統的CSK跟蹤方法基礎上,提出了一種基于支持向量機(support vector machine,SVM)的重檢測機制,在目標發生遮擋時,能夠有效解決遮擋問題,并通過在核矩陣中引入尺度因子來提高尺度濾波器的性能。

1 CSK跟蹤算法

CSK跟蹤算法的主要思想是利用循環矩陣構造訓練樣本,通過對一個單獨的圖像塊學習目標的正則化最小二乘法(regularized least squares,RLS)分類器[9,10],通過核函數計算候選區域與跟蹤目標的相似程度,選取相似度最大的候選區域為新的跟蹤目標,同時利用離散傅里葉變換降低分類器訓練和檢測過程中的運算量。該算法可大致分為分類器訓練、快速檢測和外觀模型更新。

分類器訓練過程的數學公式描述如公式(1)所示

(1)

式中yi為樣本xi的期望輸出;λ為一個固定的正則化參數。使用高斯核函數κ,將樣本映射到高維特征空間,將尋找最優w問題轉化為尋找最優α問題

(2)

(3)

在計算響應得到新的目標區域x′后,更新下一幀中用于分類器檢測過程中用到的模型參數α和目標模型X。

2 改進的CSK視覺目標跟蹤算法

傳統的CSK跟蹤算法采取固定大小的訓練樣本來訓練分類器模型,無法處理尺度變化問題,最終導致分類器模型累積誤差,跟蹤目標產生漂移。為此,本文使用相關濾波器方法對CSK算法進行多尺度跟蹤上的改進,并提出了一種基于重檢測的遮擋處理機制,對遮擋情況下的模型更新進行改進。

2.1 尺度估計

(4)

式中x為圖像樣本塊;φ(·)為圖像特征,Φ(·)為傅立葉域中的特征映射函數;K(·,·)為計算核相關的核矩陣。得到h后便可估計下一幀中目標區域z的尺度,對z提取相應的方向梯度直方圖(histogram of oriented gradient,HOG)特征,記為g,然后取F-1(F(g)⊙H*)最大值所對應的尺度si為跟蹤目標的尺度,最后更新目標模型參數αs和目標模型Xs。

2.2 在線檢測

假定訓練數據包括了N組數據對,(xi,yi),i=1,2,…,n,xi=(xi1,xi2,…,xin),yi∈(-1,1)代表點xi的類,所述SVM分類器為wx+b=0,調整w和b使min|wxi+b|≥1,邊緣d定義如下

(5)

確定最佳分類平面,使兩個分界面之間的距離達到最大,此時對應的參數w達到最小,于是將線性分類問題轉化為最優解問題,使用拉格朗日函數求解最優問題[13],最后計算得到最佳的權重向量w*,并使用支持向量得到最佳的偏移b=1-w*·xi。計算候選目標的置信度

score=w*·f+b

(6)

最高置信度所對應位置即為輸出。

當目標被遮擋時,不適當的更新會導致目標模型漂移。為了解決這個問題,引入了一個簡單的判斷機制來評估目標是否遮擋,同時自適應調整學習率。如果目標發生遮擋,停止目標更新;否則,保持學習率不變。判斷機制是每一幀的輸出響應與閾值的比較,按如下方式調整學習率β

(7)

式中βinit為學習率β的初始值;T=0.15。

整個跟蹤算法步驟如下:

初始化:根據第一幀視頻選取要跟蹤的目標,確定相關參數;

輸入:第i(i≥2)幀視頻vi;上一幀的目標位置pi-1及尺度si-1,位置檢測中的αi-1,Xi-1及尺度檢測中的ast-1,Xst-1,閾值T;

輸出:檢測出當前幀目標的位置pi和尺度si。

位置檢測:

a.根據pi-1及si-1從vi幀中截取搜索窗口,并提取特征x;

尺度檢測:

d.根據Pi及si-1從vi幀目標窗口區域中提取特征xs;

目標重檢測:

更新:

i.更新位置檢測中的αi,Xi;

j.更新尺度檢測中的αsi,Xsi。

3 實驗結果與分析

3.1 實驗環境與參數

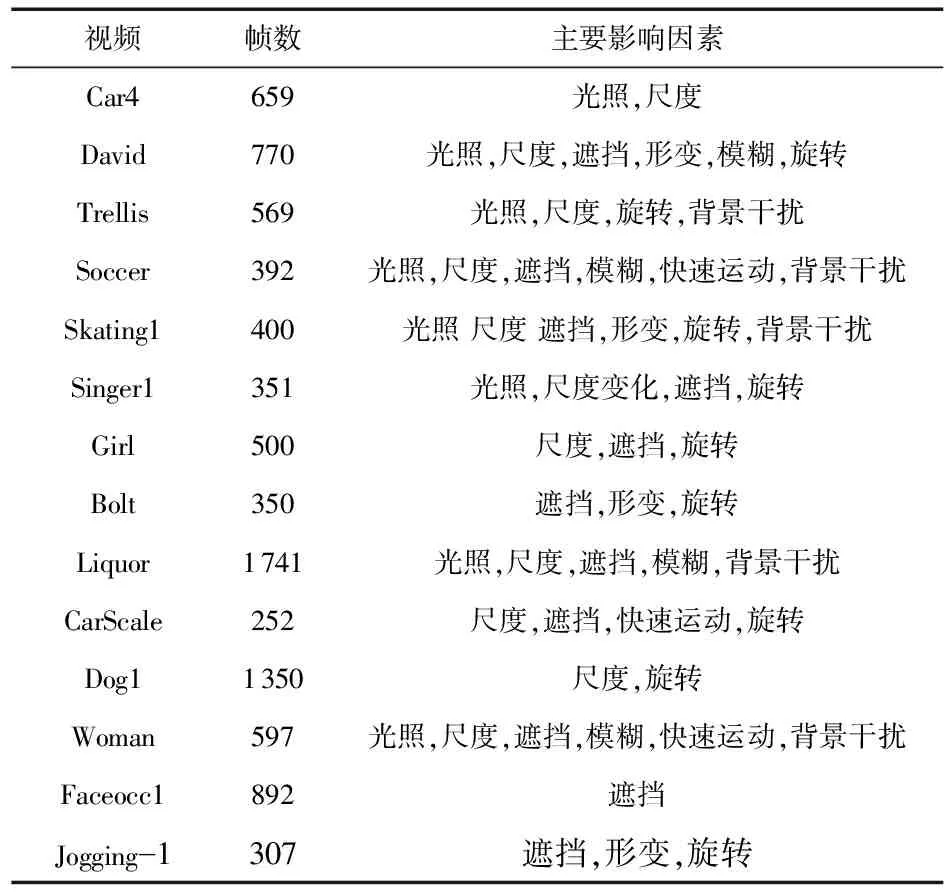

從Visual Benchmark[14]選取了14組復雜場景下的視頻序列,如表1所示,進行測試并與其他5種經典的跟蹤算法進行對比。

3.2 性能評估

表1 實驗中的測試視頻

全部實驗中,使用中心位置誤差(center location error,CLE)、距離精度(distance precision,DP)、成功率(success rate,SR)作為綜合評價指標。CLE表示跟蹤結果中心與Groundtruth標注中心的歐氏距離,DP表示CLE小于某個固定閾值(實驗中均取20像素)的視頻幀數與總測試視頻幀數的比值。SR的定義如下

(8)

(9)

式中score為重疊率;Rt為實驗獲得的目標矩形窗口;Rgt為手動標記獲得的目標矩形窗口;area()為區域面積;Sn為跟蹤成功次數,如果score>0.5,則Sn增加一次。

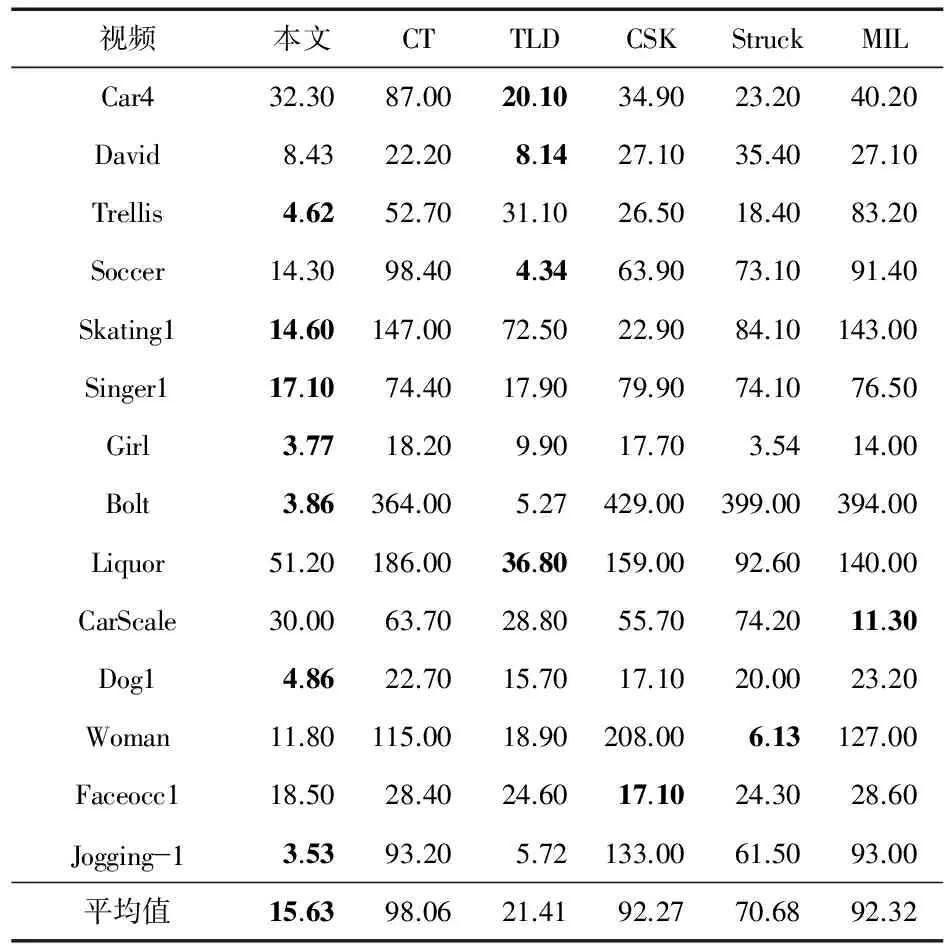

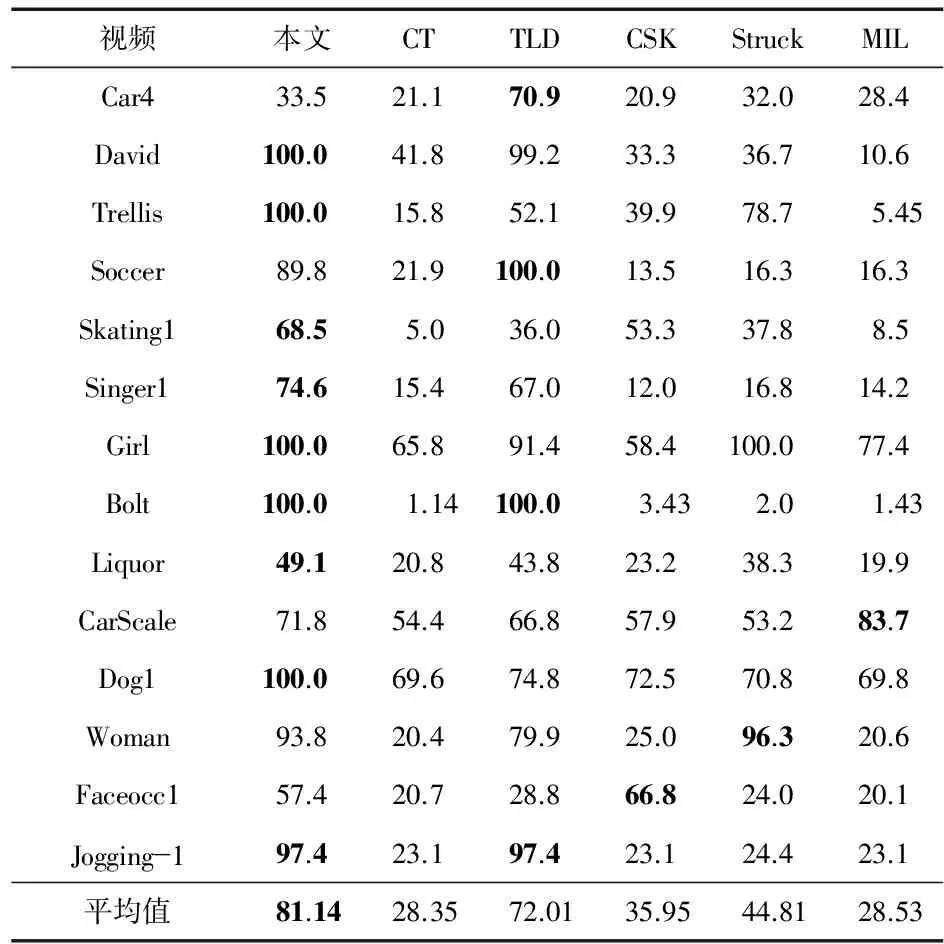

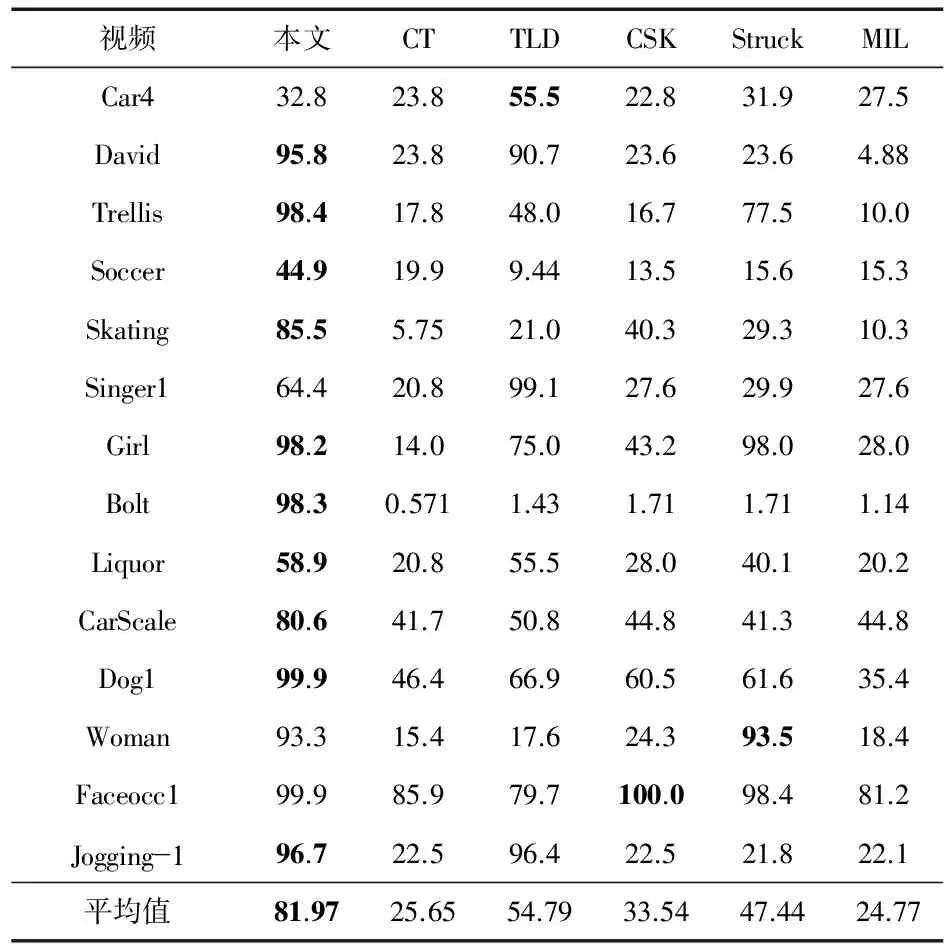

6種跟蹤方法對14組視頻進行測試獲得的平均CLE,SR及DP,分別如表2~表4所示,其中加粗表示最優值。

表2 平均中心位置誤差 像素

從表2~表4中可以看到:本文方法和原始CSK算法相比平均中心位置誤差的均值由原來的92.27像素減少到了15.63像素,距離精度的均值由原來的35.95 %提高到了81.14 %,成功率均值由原來的33.54 %提高到了81.97 %,本文算法和其他5種算法相比,3種評測值亦最優,證明本文方法的跟蹤性能有明顯提高。

表3 距離精度 %

表4 成功率 %

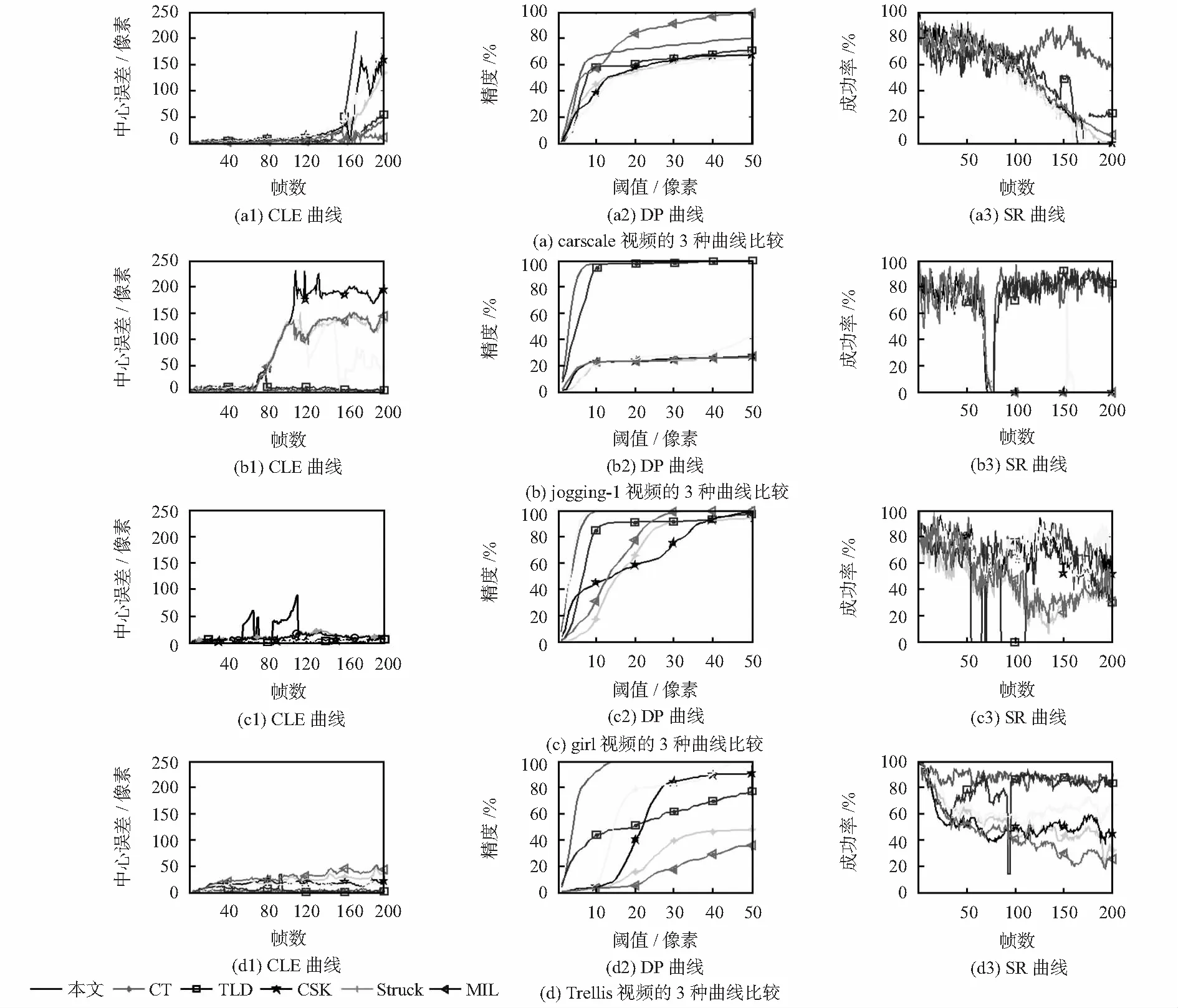

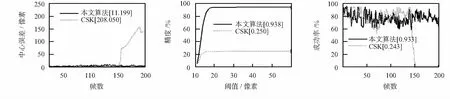

實驗中繪制了6種算法對14組視頻的3種評測標準曲線,但是由于篇幅限制,本文僅給出了4組視頻的評測曲線,如圖1所示。

圖1 部分實驗評價標準曲線

3.3 與CSK跟蹤器的比較實驗

通過3個評價標準的定量分析,可以證明本文方法的跟蹤性能優于CSK跟蹤方法。為了更直觀地說明對比結果,以Woman視頻的測試結果為例進行實驗,圖2、圖3分別給出了2種方法的部分跟蹤結果及3個評價標準的曲線。Woman視頻中的目標分別發生了尺度變換、遮擋及背景干擾等情況,從圖2可以看到:第125#幀目標發生了部分遮擋和背景干擾時,CSK跟蹤開始出現尺度上的細微偏差。

由于CSK的跟蹤誤差逐漸積累,目標運動到第149#幀時,CSK的跟蹤結果已經出現明顯的偏移,到161#幀以后已經無法跟蹤到目標,而本文算法從發生遮擋到遮擋消失后一直能較準確地跟蹤目標。從圖3中可以看出本文算法的3種評價標準曲線均優于CSK。綜上可知本文方法較好。

圖2 跟蹤結果(55#,77#,125#,149#,161#,176#)

圖3 曲線

3.4 本文算法與其他跟蹤算法比較

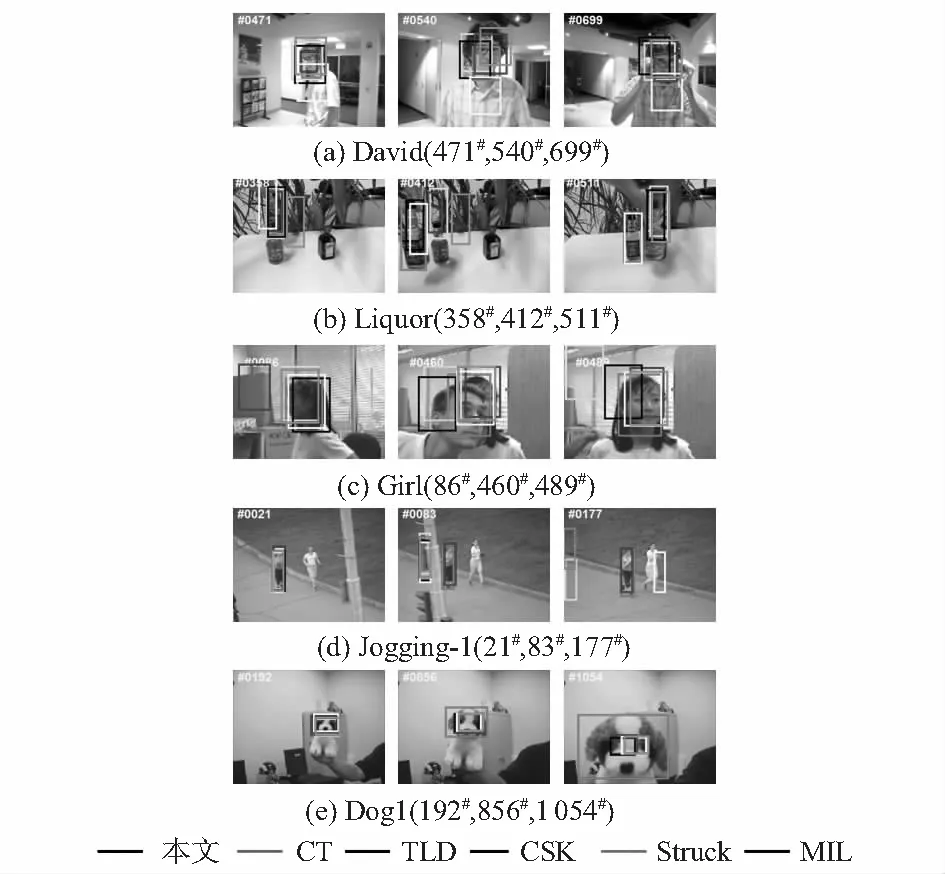

為了更直觀地說明實驗對比結果,本文給出了部分視頻序列在6種算法上的實驗結果對比,如圖4。

圖4 部分實驗對比

視頻序列David中,存在光照尺度及姿態變化等問題,從圖4(a)可以看出:第471#幀目標發生旋轉時,部分算法已經將目標跟丟,在光照和姿態變化影響下,僅 CT及本文方法能夠正確跟蹤大部分視頻序列。視頻序列Liquor中,目標發生了光照、尺度變化、遮擋、模糊和背景干擾,從圖4(b)可以看出:從第358#幀開始,目標發生快速運動、旋轉及被復雜的背景干擾,其他算法均開始出現了較大的偏差,初始階段可以準確跟蹤的CSK算法在第511#幀時也跟丟了目標,而本文算法一直能準確跟蹤目標。視頻序列Girl中的目標分別發生了尺度變化、旋轉、姿態變化和遮擋等情況,從圖4(c)可以看出:第86#幀目標發生旋轉時,和第460#幀發生遮擋時,其他幾種算法跟蹤均出現了偏差,而本文方法從發生旋轉到遮擋消失后一直能較準確地跟蹤目標。視頻序列Jogging中,目標發生了遮擋、形變、旋轉變化,從圖4(d)可以看出從第83#幀開始,由于發生遮擋,只有跟蹤學習檢測(tracking learning detection,TLD)算法和本文算法仍然可以準確的跟蹤目標。視頻序列Dog1中目標主要發生了尺度變化,從圖4(e)中可以看出:第192#幀當目標沒有發生尺度變化的時候,幾種算法均跟蹤比較準確,在第856#幀和第1 054#幀,目標發生尺度變化,本文算法表現出了明顯優勢。

綜合以上實驗結果分析可知:本文方法在目標發生尺度、光照、姿態變化、旋轉、遮擋以及快速運動等情況下均具有較強的適應性,跟蹤性能良好。

4 結束語

提出了一種結合SVM的多尺度相關濾波器跟蹤算法,首先通過CSK跟蹤算法計算當前目標是否受到遮擋,在未受到遮擋的情況下,對當前目標建立尺度金字塔,然后通過相關濾波器求取尺度金字塔的最大響應得到當前目標尺度信息;最后使用新目標圖像為訓練樣本更新目標的外觀模型和尺度模型;如果受到遮擋,則觸發重檢測機制,在目標丟失后重新獲取目標。實驗結果證明該方法跟蹤性能和原始CSK算法相比有所提高,也明顯高于其它5種經典算法,適用于具有光照變化、尺度變化和遮擋的復雜場景下的運動目標跟蹤。

參考文獻:

[1] Fang J,Wang Q,Yuan Y.Part-based online tracking with geometry constraint and attention selection[J].IEEE Transactions on Circuits & Systems for Video Technology,2014,24(5):854-864.

[2] Chen Z,Hong Z,Tao D.An experimental survey on correlation filter-based tracking[J].Computer Science,2015,53(6025):68-83.

[3] Babenko B,Yang M H,Belongi E S.Robust object tracking with online multiple instance learning[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33(8):1619-1632.

[4] Zhang K,Zhang L,Yang M H.Real-time compressive tra-cking[C]∥European Conference on Computer Vision,Springer-Verlag,2012:864-877.

[5] Kalal Z,Mikolajczyk K,Matas J.Tracking-learning-detection[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2012,34(7):1409-1422.

[6] Hare S,Golodetz S,Saffari A,et al.Struck:Structured output tracking with kernels[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2015,23(5):263-270.

[7] Bolme D S,Beveridge J R,Draper B A,et al.Visual object tra-cking using adaptive adaptive correlation filters[C]∥IEEE Conference on Computer Vision & Pattern Recognition,IEEE,2010:2544-2550.

[8] Henriques J F,Rui C,Martins P,et al.Exploiting the circulant structure of tracking-by-detection with kernels[C]∥ECCV 2012,Springer:Berlin Heidelberg,2012:702-715.

[9] Henriques J F,Rui C,Martins P,et al.High-speed tracking with kernelized correlation filters[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2015,37(3):583-596.

[10] Danelljan M,Khan F S,Felsberg M,et al.Adaptive color attri-butes for real-time visual tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition,IEEE,2014:1090-1097.

[11] Danelljan M,H?ger G,Khan F S,et al.Accurate scale estimation for robust visual tracking[C]∥British Machine Vision Confe-rence,2014:65.1-65.11.

[12] Zhang K,Zhang L,Liu Q,et al.Fast visual tracking via dense spatio-temporal context learning[C]∥2014 European Conference on Computer Vision(ECCV),2014:127-141.

[13] Chapelle O.Training a support vector machine in the primal[J].Neural Computation,2007,19(5):1155-1178.

[14] Wu Y,Lim J,Yang M H.Online object tracking:A Bench-mark[C]∥IEEE Conference on Computer Vision & Pattern Recognition,2013:2411-241.