基于改進 ResNet 網絡和遷移學習的服裝圖像風格識別研究

夏明桂 田入君 姜會鈺 董敏

摘 要:傳統的服裝圖像風格識別方法主要依賴于成功提取有效特征,這些方法在處理圖像時不僅會消耗大 量的時間和精力,識別精度也較低。為了提高服裝圖像風格識別的性能,提出了一種基于改進的ResNet152 網絡和遷移學習的服裝圖像風格識別方法。首先將ResNet152網絡首層結構中的7×7卷積核替換成3個3 ×3卷積核組合層,其次把原始殘差單元中的“卷積層(Conv)+批歸一化層(BN)+非線性激活函數層(Relu)”的組合方式換成“批歸一化層(BN)+非線性激活函數層(Relu)+卷積層(Conv)”的組合方式。這兩個改進方 法有效地提升了網絡性能,使其能夠更好地捕捉不同尺度的服裝風格特征。然后把在ImageNet數據集上訓 練好的ResNet152網絡模型參數遷移到改進的網絡中,在此基礎上,將女童服裝數據集輸入到網絡中進行訓 練驗證以及微調網絡參數。結果表明,所提出的方法風格識別準確率達到了94.2%,訓練效果好,識別精度、收斂速度等均優于其他風格識別網絡,可以更好的完成女童服裝風格識別任務。

關鍵詞:ResNet網絡;遷移學習;服裝圖像;服裝風格識別;識別準確率

中圖分類號:TS195.644? 文獻標志碼:A? 文章編號:2097-2911-(2024)01-0012-09

Research on Clothing image Style Recognition Based on Improved ResNet Network and Transfer Learning

XIA Minggui a, TIAN Rujun a, JIANG Huiyu a, DONG Min b*

(a.College of Chemistry and Chemical Engineering; b.College of Mathematical Sciences, Wuhan Textile University,Wuhan 430200,China)

Abstract:Traditional clothing image style recognition methods mainly rely on the successful extraction of ef- fective features, and these methods not only consume a lot of time and energy when processing images, but also have low recognition accuracy. In order to improve the performance of clothing imagestyle recognition, this pa- per proposes a clothing image style recognition method based on the improved ResNet152 network and transfer learning. Firstly, the 7×7 convolutional kernel in the first layer structure of ResNet152 network is replaced by three 3×3 convolutional kernel combination layers, and secondly, the combination of "convolutional layer (Conv)+ batch normalization layer (BN)+ nonlinear activation function layer (Relu)" in the original residual unit is replaced by "batch normalization layer (BN)+ nonlinear activation function layer (Relu)+ convolutional layer (Conv)". These two improved methods effectively enhance the network performance and enable it to better capture clothing style features at different scales. The parameters of the ResNet152 network model trained on the ImageNet dataset are then migrated to the improved network, based on which the girl's clothing dataset is in- put to the network for training and validation as well as fine-tuning the network parameters. The results show that the proposed method in this paper has good training effect, and the recognition accuracy and convergence speed are better than other type recognition networks, which can better accomplish the task of girls' clothing style recognition.

Keywords:resNet network;transfer learning;clothing images;clothing style recognition;recognition accuracy

隨著互聯網技術的不斷發展和服裝類電子商務的日趨成熟,通過網絡在各大電商平臺購買服裝的用戶越來越多,人們對服裝圖像識別技術的進步寄予了更高的期望。然而,服裝圖像風格識別技術面臨著多種挑戰,其中包括服裝圖像的細粒度識別分類復雜性[1]、服裝個性化的風格評判標準以及迅速演化的時尚風格特征[2]等,這些因素共同使得服裝圖像風格識別問題愈發復雜化。因此,如何高效地實現服裝圖像風格識別成為當前服裝數字化研究的熱點。

傳統的服裝圖像風格識別方法主要依賴于有效特征的提取,如 CHAO等[3]將服裝圖像的風格使用方向梯度直方圖和局部二值模式等特征來描述,然后通過測量這些特征之間的相似性來實現服裝風格的推薦。莊立鋒等[4]提出采用改進后的Canny算法來進行服裝款式結構特征的識別和分類,能夠很好地識別服裝結構款式。高妍等[5]使用改進框架HSR-FCN將R-FCN中的區域建議網絡和HyperNet網絡相融合,改變圖片特征學習方式,在模型中引入空間轉換網絡,對輸入圖像和特征圖進行空間變換及對齊,加強了對多角度服裝和形變服裝的特征學習,能夠有效地解決形變服裝圖像的識別問題。然而,這些傳統服裝圖像風格識別方法在準確性和處理效率方面都存在不足,而且對于小樣本數據集來說并不適用。

近年來,許多學者開始利用深度神經網絡進行圖像識別[6]。深度神經網絡能夠自動學習和提取圖像中的特征,并且無需手動設計特征描述子,這使其成為許多圖像識別任務的首選方法。KO- ZIARSKI等[7]提出了用深度神經網絡來解釋各種類型噪聲的存在對圖像識別任務的影響,在網絡中引入噪聲的類型以及嚴重程度這兩種方法都比不考慮噪聲的情況下圖像識別性能好。SHU- BATHRA等[8]提出了用MLP、CNN、ELM這三種方法通過提取多種特征來識別服裝圖像,相對于其他兩種方法,ELM方法識別的性能最優,服裝圖像識別時間短且準確率高。在此基礎上,結合深度神經網絡和遷移學習在圖像識別領域的應用也取得了較好的效果。王軍敏等[9]提出一種基于深度卷積神經網絡和遷移學習的紋理圖像識別方法,使用全局平均池化層替代深度卷積神經網絡模型頂部的部分全連接層,用逐級微調的方法來處理遷移學習模型,確定最佳的凍結層以及可調整層的組合,以達到最佳的紋理服裝圖像識別精度。ELLEUCH等[10]使用Inception-v3網絡在大型數據集進行預訓練,把得到的預訓練模型參數遷移到所設計的網絡中,用創建的13種風格類別的80000張圖像數據集在所設計的網絡上進行訓練驗證,其訓練速度加快且圖像識別準確率進一步提高,證明了此方法對服裝圖像識別的有效性。

現有的研究主要集中在從服裝圖像中提取基礎特征,這些特征用于對服裝進行粗略的識別分類,但識別服裝風格的細微差異需要更加具體和詳細的特征,提取的基礎特征達不到風格識別的要求。LIN等[11]提出了雙線性CNN模型,此模型使用兩個并行的網絡通路來提取圖像特征,然后采用雙線性池化方法來計算這兩個并行特征之間的相關性,這個過程用于篩選細粒度子類的特征,使其充分挖掘細粒度特征。但雙線性 CNN模型采用了兩個并行的網絡路徑來提取特征,導致了參數量和計算量的成倍增加,訓練時間和計算資源的消耗相應增加。

基于上述存在的問題,本文提出了一種基于改進的ResNet152網絡和遷移學習的服裝圖像風格識別方法。對在ImageNet數據集上進行預訓練的 ResNet 152網絡,采用共享模型參數的遷移學習方法,把預訓練模型參數遷移到所改進的ResNet152網絡中,在此基礎上,將收集的女童服裝數據集輸入到網絡中進行訓練和驗證,得到新的網絡模型,達到提升女童服裝圖像風格識別準確率的目的。

1 改進 ResNet152網絡的服裝風格識別模型

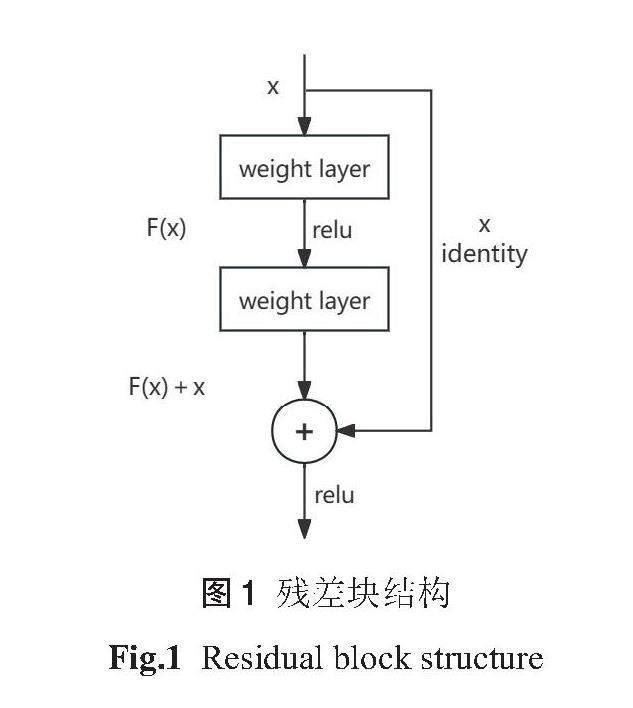

1.1 ResNet152網絡

服裝圖像風格識別不僅需要考慮服裝本身的顏色、紋理等基礎特征信息,還需要考慮服裝款式等細粒度特征信息。豐富的服裝風格特征信息可以顯著的提高識別準確率。為了獲得豐富的特征信息,可以通過加深網絡來解決。相比于 AlexNet、VGG、GoogleNet 等網絡,ResNet 網絡由于引入了殘差塊,允許網絡學習殘差,使其可以更有效地學習到特征信息,同時殘差塊結構通過跳躍連接將輸入直接添加到層輸出上,梯度可以輕松地傳播回較淺層,減輕了梯度消失問題,也有助于防止網絡的退化。因此ResNet可以更輕松地訓練非常深的神經網絡,而不會出現梯度消失、退化等問題。殘差塊結構如圖1所示。

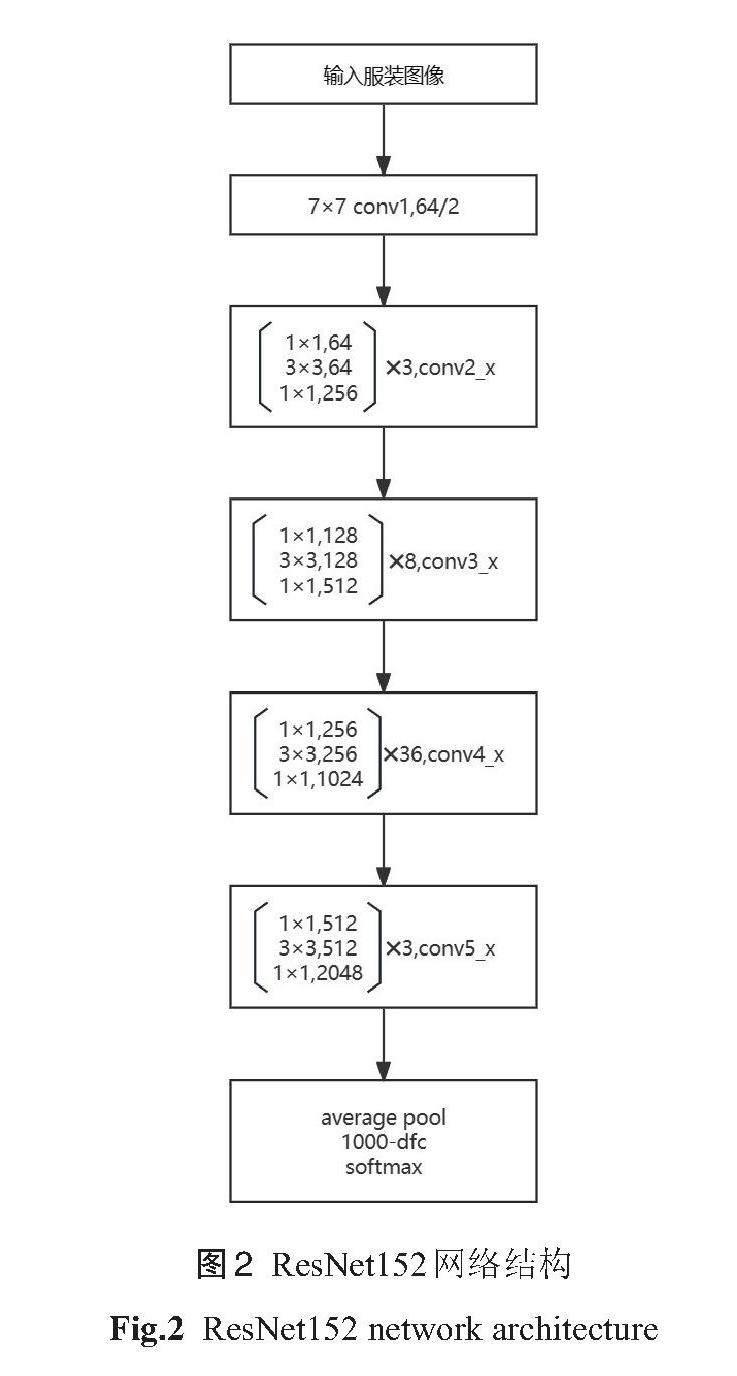

由于網絡層數的不同,ResNet 網絡包括 ResNet18、 ResNet34、 ResNet50、 ResNet101、ResNet152等,ResNet18和 ResNet34采用了 Ba-sicBlock 結構,ResNet50、ResNet101 以及 ResNet152采用了Bottleneck結構。為了處理復雜的服裝圖像風格識別任務,提取到更深層次的風格特征,本文選用ResNet152網絡搭建模型,其結構如圖2所示,總層數是152層,包括1個7×7的卷積層、階段1至階段4的Bottleneck結構、具有平均池化和softmax函數的全連接層。其中階段1至階段4中的階段1有3個殘差塊,階段2有8個殘差塊,階段3有36個殘差塊,階段4有3個殘差塊,每個殘差塊包含3個卷積層。

1.2 改進的ResNet152網絡

1.2.1 改進網絡首層結構

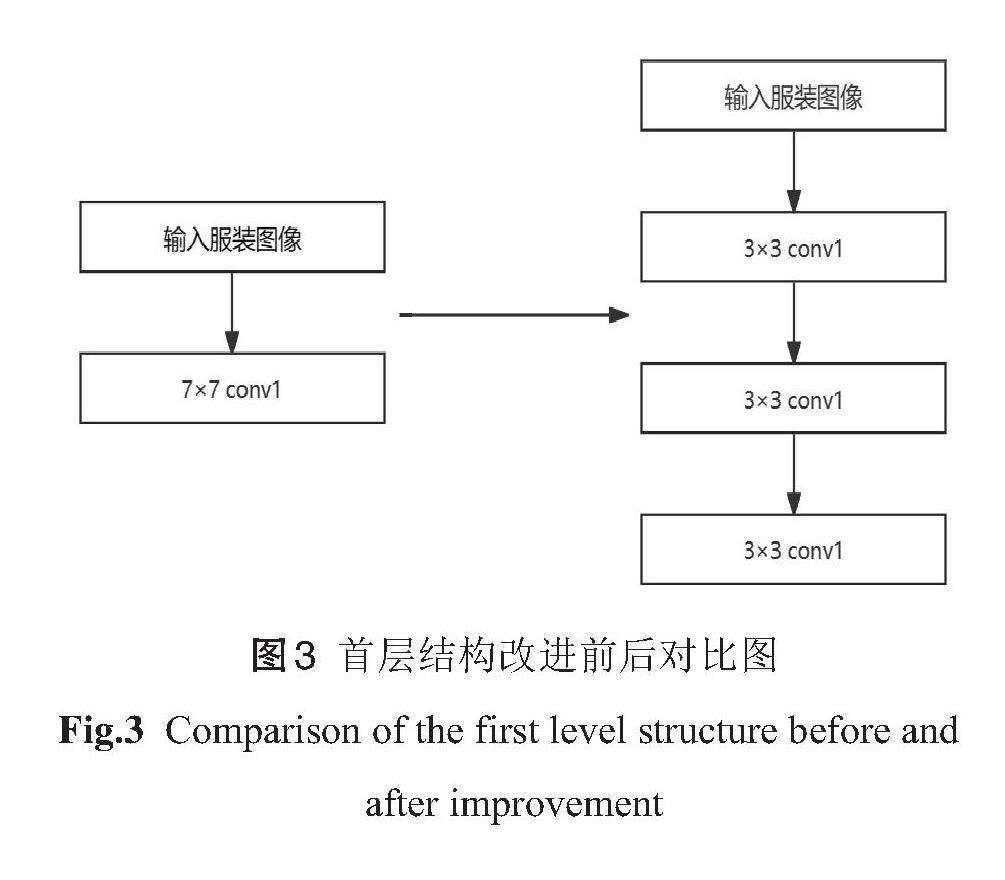

提高服裝圖像風格識別準確率,需要網絡提取出更加細粒度的風格特征。為了實現這一目標,本文提出了一種將網絡首層結構進行改進的方法。即在輸入服裝圖像上提取風格特征的7×7卷積核用3個3×3的卷積核組合層來替代,保持卷積操作中的步幅(stride)和填充(padding)設置相同。網絡首層結構改進前后如圖3所示。

使用3個3×3的卷積核組合層來替代1個7×7卷積核可以保持網絡中感受野和輸出特征圖大小不變。感受野是神經網絡中某一層輸出的特征圖上的一個單元對輸入的影響區域。其計算公式如(1)所示:

F(i)=(F(i +1)-1)× Stride + Ksize (1)

式中,F(i +1)表示第 i +1層的感受野,F(i)表示第 i 層的感受野,Stride 表示步長,Ksize 表示卷積核的大小。實驗中設置 F(i +1)初始值為2,Stride 初始值為1。網絡的第1層經過7×7卷積核,根據公式(1)可知: F(1)=(2-1)×1+7=8;

網絡的第1層經過3個3×3的卷積核組合層,根據公式(1)可知:

F(1)=(2-1)×1+3=4

F(2)=(4-1)×1+3=6

F(3)=(6-1)×1+3=8

因此可知,使用3個3×3的卷積核組合層來替代1個7×7卷積核可以保持感受野大小不變,并且3個3×3卷積核的層次結構可以增加網絡的深度,捕捉到多種尺度的風格特征,引入更多的非線性,減少過擬合,提升了網絡的性能。

1.2.2 改進殘差單元

ResNet殘差網絡由多個殘差學習單元疊加而成。當輸入的服裝圖像數據進入ResNet殘差網絡時,需要經過一系列處理。首先卷積層(Conv)對輸入服裝圖像進行特征提取,接著通過非線性激活函數層(Relu)增強網絡的非線性擬合能力,并經過批歸一化層(BN)對數據進行歸一化處理。然后,處理的結果被送入多個殘差單元,這些單元通過批歸一化層(BN)和多個全連接層進一步處理數據,最后得到輸出的服裝圖像。

在深層網絡中,原始殘差單元可能會遇到梯度消失或梯度爆炸的問題。為了解決潛在的問題,本文提出了將殘差單元的組合方式進行變化的方法。即“卷積層(Conv)+批歸一化層(BN)+非線性激活函數層(Relu)”的組合方式換成“批歸一化層(BN)+非線性激活函數層(Relu)+卷積層(Conv)”的組合方式。組合方式的變化引入了預激活(pre-activation)結構,它通過將BN層放在非線性支路的開始,有助于規范化激活值,使它們在合理范圍內減少了梯度消失問題,使網絡更容易訓練。殘差單元改進前后如圖4所示。

1.2.3 不同網絡改進方法的服裝風格識別效果對比

為了證明ResNet152不同網絡改進方法對服裝風格識別效果的影響,把在ImageNet數據集上訓練好的ResNet152網絡模型參數遷移至改進的網絡中,將本文收集的女童服裝數據集分別輸入到不同的改進網絡中進行訓練,得到不同網絡改進方法的風格識別準確率如表1所示。

從表1可知,將改進網絡首層結構方法和改進殘差單元方法相結合,這時網絡對女童服裝數據集的風格識別準確率達到最高,為94.2%。因此,本文采用兩種改進方法相結合的網絡進行服裝風格識別。

2 實驗

2.1 實驗前處理

2.1.1 遷移學習

遷移學習是指將模型在某些任務或領域中學習到的知識通過源域學習的遷移運用到目標任務或目標領域中[12-16],它可以有效地解決由于數據集稀缺而導致模型出現過擬合的問題。遷移學習方法可以分為多種類型,包括基于共享模型參數的遷移、基于特征的遷移、基于樣本數據的遷移等。這些遷移學習方法允許在不同任務之間有效地利用已有的知識和技能,提高網絡的性能和泛化能力。其中,基于共享模型參數的遷移學習方法的工作原理是結合遷移學習和深度學習,在 ImageNet 數據集上進行預訓練的 ResNet 網絡,采用共享模型參數的遷移學習方法,把預訓練模型參數遷移到所改進的網絡中,進一步優化網絡參數。在此基礎上,使用女童服裝數據集在網絡中進行訓練,完成女童服裝圖像風格識別的任務。因此,本文選用基于共享模型參數的遷移學習方法。

2.1.2 數據集

本文所使用的女童服裝圖像數據集來自各大電商平臺,由于女童服裝風格的多樣性,通過專家建議和查詢相關資料,本文選用4個最具代表性的女童服裝風格類型,分別為可愛風格、運動風格、學院風格、民族風格,每種風格包含300張圖片,共1200張女童服裝圖片。其中80%圖片作為訓練集,用于訓練網絡模型和調整模型參數;20%圖片作為驗證集,用于驗證網絡模型的訓練效果以及微調模型參數。在數據集標注的過程中,只需要將女童服裝圖像放到相應風格分類的文件夾里,不需要進行額外標注。數據集部分圖像如圖5所示,數據集中呈現了女童服裝風格的多樣化。同時,由于數據集中服裝的拍攝角度、光照、褶皺、背景等因素的干擾,在一定程度上增加了女童服裝圖像風格識別的難度。

2.1.3 數據預處理與增強

數據集中服裝拍攝角度、光照等方面的變化會引入噪聲和差異,從而增加了網絡對女童服裝圖像風格識別任務的復雜度。為了應對這一挑戰,可以采用數據預處理與增強技術來規范數據集,以降低這一因素的影響。

數據預處理[17-18]是指對原始數據進行一系列的操作和轉換,以確保數據適用于模型的訓練、驗證。本文所使用的數據預處理方法是標準化(Normalize)和 ToTensor 。其中標準化是將數據調整為均值為0,標準差為1的分布,從而使數據在訓練過程中更具穩定性。ToTensor 是將服裝圖像JPG格式轉換為張量(tensor)格式的操作,以供后續的網絡模型訓練使用。

數據增強[19-20]是指在深度學習中使用一系列技術手段來增加數據集的大小和多樣性,以改善模型的泛化能力。本文所使用的數據增強方法是隨機縮放裁剪(RandomResizedCrop)和隨機水平翻轉(RandomHorizontalFlip)。其中隨機縮放裁剪是在原始圖像中隨機選擇區域,將該區域裁剪成指定的大小,將裁剪后的圖像縮放到模型的輸入尺寸。隨機水平翻轉是將圖像以一定的概率水平翻轉,從而生成新的訓練樣本。這兩種操作增加了數據的多樣性,提高了模型的泛化能力。

2.2 實驗和方法

2.2.1 實驗環境

本文采用的實驗環境為Windows 11操作系統,AMD R76800H 處理器,16GB 內存,512GB 固態硬盤,采用Pytorch深度學習框架進行訓練,訓練后得到的識別準確率和損失函數,通過采用 Python的Matplotlib庫可視化得到。

2.2.2 實驗設置

本文設置一個對比實驗,使用女童服裝訓練集分別對未使用遷移學習的ResNet152網絡、未使用遷移學習的改進ResNet152網絡、使用遷移學習的 ResNet152網絡、使用遷移學習的改進ResNet152網絡進行訓練。訓練完成后,為了驗證遷移學習方法和改進網絡對女童服裝圖像風格識別的影響,每迭代5次記錄一次使用遷移學習和未使用遷移學習的 ResNet152和改進ResNet152識別準確率(val)和損失函數(loss)。設置網絡模型學習率(lr)為0.0001、批大小(batch_size)為16,迭代總次數(epoch)為80次,預訓練模型版本為resnet152-394f9c45.pth。

2.2.3 基于改進網絡和遷移學習的服裝圖像風格識別

本文提出了一種基于改進ResNet152網絡和遷移學習的服裝圖像風格識別方法,把ImageNet 圖像數據集上輸入至初始ResNet152網絡模型進行訓練,得到預訓練模型。在此基礎上,采用共享模型參數的遷移方法,把預訓練模型參數遷移到本文所改進的ResNet152網絡模型中,進一步優化網絡參數。在女童服裝圖像數據集輸入網絡之前,由于數據集中服裝拍攝角度、光照等因素的干擾,本文采用了數據預處理與增強技術來規范數據集,最后把數據集輸入網絡進行訓練以及驗證,完成女童服裝圖像風格識別的任務。上述過程如圖6所示。

3 結果與分析

女童服裝圖像訓練集分別輸入至未使用遷移學習的ResNet152網絡、未使用遷移學習的改進 ResNet152網絡、使用遷移學習的 ResNet152網絡以及本文所提出的使用遷移學習的改進 ResNet152網絡中進行訓練,得到相應的損失函數(loss)。訓練完成后,將其驗證集分別輸入至上述四種網絡中進行風格識別,得到相應的風格識別準確率(val)。

圖7(a)、(b)、(c)、(d)分別展示了四種網絡在同一女童服裝數據集上得到的風格識別準確率(val)和損失函數(loss)。

圖7(a)展示了未使用遷移學習的ResNet152網絡在女童服裝數據集上訓練得到的損失函數和識別準確率,從曲線圖看出此網絡在小樣本數據集上訓練時,服裝風格識別準確率低和損失函數高,網絡模型共迭代80次,其中迭代至第68次時準確率最高,只達到65.0%,相應的損失函數為0.927。在此基礎上可知初始ResNet152網絡訓練效果差,損失函數和識別準確率波動較大,模型可能發生了過擬合。

圖7(b)展示了未使用遷移學習的改進 ResNet152網絡在女童服裝數據集上訓練得到的損失函數和識別準確率,從曲線圖看出此網絡在小樣本數據集上訓練時,迭代至第40次時準確率最高,達到了85.9%,相應的損失函數為0.258。對比未使用遷移學習的 ResNet152網絡,識別準確率提升了20.9%。通過改進網絡首層的卷積核大小和調整殘差單元中“卷積層(Conv)+批歸一化層(BN)+非線性激活函數層(Relu)”排列順序來改進網絡,使得其風格識別準確率大幅度提高,網絡性能得到了提升。

圖7(c)展示了使用遷移學習的ResNet152網絡在女童服裝數據集上訓練得到的損失函數和識別準確率,從曲線圖看出此網絡在小樣本數據集上訓練時,迭代至第68次時準確率最高,達到了92.9%,相應的損失函數為0.134。對比未使用遷移學習的ResNet152網絡,識別準確率提升了27.9%。將在 ImageNet圖像數據集訓練好的模型,通過遷移其模型參數至ResNet152網絡中,使得網絡減少了計算資源的消耗,還大幅提高了風格識別準確率。

圖7(d)展示了使用遷移學習的改進 ResNet152網絡在女童服裝數據集上訓練得到的損失函數和識別準確率,從曲線圖看出此網絡在小樣本數據集上訓練時,迭代至第66次時準確率最高,達到了94.2%,相應的損失函數為0.093。與未使用遷移學習的 ResNet152網絡、未使用遷移學習的改進 ResNet152網絡以及使用遷移學習的 ResNet152網絡識別準確率相比,使用遷移學習的改進 ResNet152網絡在女童服裝數據集中風格識別效果最好,識別準確率分別提高了29.2%,8.3%,1.3%。這表明本文所提出的方法在女童服裝風格識別任務中的高效性。

4 結論

本文提出了一種基于改進的ResNet152網絡和遷移學習的服裝圖像風格識別方法。對網絡結構進行了改進,首先用3個3×3的卷積核組合層來代替首層結構的7×7卷積核,在此基礎上,把網絡殘差單元中的卷積層、批歸一化層、非線性激活函數層的排列順序進行改變。這兩種改進方法能捕捉到多種尺度的風格特征。然后用共享參數的遷移方法把在ImageNet圖像數據集上訓練的 ResNet152網絡模型參數遷移至改進的網絡中。女童服裝數據集在進行網絡訓練前,采用數據預處理與增強技術來規范數據集,之后把數據集輸入至網絡進行訓練驗證以及微調網絡。實驗結果表明,與未使用遷移學習及未改進ResNet152網絡方法相比,本文基于改進的ResNet152網絡和遷移學習的服裝圖像風格識別方法收斂速度快,泛化能力和魯棒性強,識別準確率高。因此,本文提出的女童服裝圖像風格識別方法對當前服裝數字化研究具有一定的參考意義。

雖然本文提出的方法在收集的女童服裝數據集取得良好的風格識別效果,但是仍存在著一些不足之處,例如:選擇的女童服裝風格類型較少、女童服裝數據集樣本較少等。在今后的工作中,增加女童服裝風格類型以及相應的樣本數量,把女童服裝數據集輸入至網絡進行訓練以及驗證,完成女童服裝圖像風格識別的任務。

參考文獻:

[1]趙浩如,張永,劉國柱.基于RPN與B-CNN的細粒度圖像分類算法研究[J].計算機應用與軟件, 2019, 36(3):210-213.

ZHAO Haoru, ZHANG Yong, LIU Guozhu. Re- search on fine-grained image classification algo- rithm based on RPN and B-CNN[J]. Computer Applications and Software, 2019, 36(3):210-213.

[2]鐘曉東.基于認知特征的服裝風格自主分類的研究與實現[D].上海:東華大學, 2012.

ZHONG Xiaodong. Research and implementa- tion of autonomous classification of clothing styles based on cognitive features[D].Shanghai: Donghua University,2012.

[3]CHAO X, HUISKES M J, GRITTI T, et al. A framework for robust feature selection for real- time fashion style recommendation[C]//Proceed- ings of the 1st International Workshop on Inter- active Multimedia for Consumer Electronics.2009:35-42.

[4]莊立鋒, 林俊文.基于改進 Canny 算法的服裝款式結構特征識別與分類[J].實驗室研究與探索, 2020,39(5):264-268.

ZHUANG Lifeng, LIN Junwen. Recognition and classification of structural features of cloth- ing styles based on improved Canny algorithm [J]. Laboratory Research and Exploration, 2020,39(5):264-268.

[5]高妍,王寶珠,郭志濤,等.改進HSR-FCN的服裝圖像識別分類算法研究[J].計算機工程與應用,2019,55(16):144-149.

GAO Yan, WANG Baozhu, GUO Zhitao, et al. Research on the classification algorithm for ap- parel image recognition with improved HSR- FCN[J]. Computer Engineering and Applica- tions, 2019,55(16):144-149.

[6]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Visionand Pattern Recognition.2016:770-778.

[7]KOZIARSK M, CYGANEK B. Image recogni- tion with deep neural networks in presence of noise-dealing with and taking advantage of dis- tortions[J]. Integrated Computer- Aided Engi- neering, 2017, 24(4):337-349.

[8]SHUBATHRA S, KALAIVAANI P C D, SAN- THOSHKUMAR S. Clothing image recogni- tion based on multiple features using deep neu- ral networks[C]//2020 International Conference on Electronics and Sustainable CommunicationSystems (ICESC). IEEE, 2020:166-172.

[9]王軍敏,樊養余,李祖賀.基于深度卷積神經網絡和遷移學習的紋理圖像識別[J].計算機輔助設計與圖形學學報,2022,34(5):701-710.

WANG Junmin, FAN Yangyu, LI Zuhe. Texture image recognition based on deep convolutional neural networks and migration learning[J]. Jour- nal of Computer- Aided Design and Graphics, 2022,34(5):701-710.

[10]ELLEUCH M, MEZGHANI A, KHEMAK- HEM M, et al. Clothing classification using deep CNN architecture based on transfer learn- ing[C]//Hybrid Intelligent Systems:19th Inter- national Conference on Hybrid Intelligent Sys- tems (HIS 2019) held in Bhopal, India, Decem- ber 10-12, 2019 19. Springer InternationalPublishing, 2021:240-248.

[11]LIN T Y, ROYCHOWDHURY A, MAJI S. Bi- linear CNN models for fine-grained visual rec-ognition[C]//Proceedings of the IEEE Interna- tional Conference on Computer vision, 2015:1449-1457.

[12]HAND, LIU Q, FAN W. A new imageclassifi- cation method using CNN transfer learning and web data augmentation[J]. Expert Systemswith Applications, 2018, 95:43-56.

[13]WEISS K, KHOSHGOFTAAR T M, WANGD D. A survey of transfer learning[J]. Journal of Big data, 2016, 3(1):1-40.

[14]PAN S J, YANG Q. A survey on transfer learn- ing[J]. IEEE Transactions on Knowledge and Data Engineering, 2009, 22(10):1345-1359.

[15]BENGIO Y. Deep learning of representations for unsupervised and transfer learning[C]//Pro- ceedings of ICML Workshop on Unsupervised and Transfer learning. JMLR Workshop andConference Proceedings, 2012:17-36.

[16]TAN C, SUN F, KONG T, et al. A survey on deep transfer learning[C]//Artificial Neural Networks and Machine Learning – ICANN 2018:27th International Conference on Artifi-cial Neural Networks, Rhodes: Springer Inter-national Publishing, 2018:270-279.

[17]BHATTACHARYYA S. A brief survey of col-or image preprocessing and segmentation tech- niques[J]. Journal of Pattern Recognition Re- search, 2011, 1(1):120-129.

[18]MISHRA P, BIANCOLILLO A, ROGER J M, et al. New data preprocessing trends based on ensemble of multiple preprocessing techniques [J]. Trends in Analytical Chemistry, 2020, 132:116045.

[19]SHORTEN C, KHOSHGOFTAAR T M. A sur- vey on image data augmentation for deep learning[J]. Journal of Big Data, 2019, 6(1):1-48.

[20]SCHLETT T, RATHGEB C, BUSCH C. Deep learning- based single image face depth data enhancement[J]. Computer Vision and Image Understanding, 2021, 210(3):103247.

(責任編輯:周莉)