基于深度強化學習的主動配電網高恢復力決策方法

羅欣兒,杜進橋,田杰,劉安迪,王標,李妍,王少榮

(1. 深圳供電局有限公司,廣東 深圳518001;2. 華中科技大學強電磁工程與新技術國家重點實驗室,武漢430074)

0 引言

隨著全球災害威脅的增加,電力系統在極端自然災害下恢復力的研究得到越來越多的關注[1 - 2]。美國、歐盟、日本等國家和地區已將電網恢復力建設作為未來電網發展的重要方向。主動配電網(active distribution network, AND)是智能配電網技術發展到高級階段的產物,可以通過拓撲結構、分布式發電(distributed generation, DG)和可中斷負荷(interruptible load, IL)等進行主動優化控制,在故障恢復過程中減少用戶停電損失[3 - 5]。文獻[6]針對含微網的配電系統,在極端災害下的網架重構階段,根據故障位置的不同提出差異化供電恢復方案;文獻[7]提出通過動態拓撲分析、孤島配置、含DG主網絡連通性恢復和網絡優化解決故障快速恢復問題;文獻[8]將多源協同的配電網故障恢復問題建模為混合整數二階錐規劃模型,并利用商業優化軟件MOSEK進行求解。針對配電網在極端災害下的故障恢復過程,建立適應具有復雜動態約束的混合整數非線性規劃模型,運行狀態隨機性會導致場景組合激增[9],求解的復雜度隨求解時段數成指數增長,在極端災害條件下或者在實際故障恢復過程中,以上優化模型會消耗大量的計算資源也可能找不到最優解[10]。

數據驅動的機器學習算法已成為求解隨機優化決策領域的研究熱點[11 - 12],其中AlphaGo是成功的應用案例[13],其核心技術是自學習方法[14 - 16]。隨著智能電網技術發展,高級量測體系、各種監控系統的大規模部署將產生和積累大量數據,基于數據驅動的自學習方法在能源與電力系統優化調度和控制決策等方面已引起廣泛關注[17 - 20]。配電網的故障恢復決策是隨機優化決策的問題,強化學習是一種無模型的方法,不需要先驗知識,采用歷史狀態數據訓練神經網絡進而得出復雜決策,本文將其引入到問題求解中去,為解決極端災害下故障恢復決策提供一條新的思路。本文首先構建基于深度強化學習的高恢復力決策模型,考慮減少負荷停電的經濟損失,同時兼顧故障恢復時電網運行經濟成本,采用觀測狀態數據,基于深度強化學習算法對競爭深度Q網絡(dueling deep Q network, DDQN)進行訓練,迭代更新參數,完成歷史觀測狀態的深度強化學習(deep reinforcement learning, DRL),實現觀測狀態到主動配電網故障恢復策略的非線性映射。本文最后基于蒙特卡羅法隨機生成易損線路的故障狀態,得到易損線路故障集合,仿真研究IEEE33節點配電網算例的隨機故障場景,將DG孤島、網絡重構和可中斷負荷等作為故障恢復的動作手段,對DDQN結構的神經網絡進行訓練,分析了3種決策策略下的負荷損失功率,說明本文所提方法可有效提高主動配電網極端災害下供電恢復力。

1 基于深度強化學習的高恢復力決策模型

本文基于數據驅動的深度強化學習方法開展極端災害條件下的故障恢復決策,將極端災害下配電網運行狀態和線路故障狀態作為觀測狀態集合,自學習智能體Agent在當前環境觀測狀態下尋求可行的決策策略進行動作,通過回報函數進行動作評價以開展自學習,如圖1所示。

圖1 基于深度強化學習的故障恢復決策機制

t時刻觀測狀態St包括極端災害下的線路故障狀態和主動配電網運行狀態,其中,運行狀態包括DG以及負荷的功率,線路故障狀態定義為極端災害期間主動配電網易損線路的受損狀態。

在主動配電網極端災害后故障恢復階段,本文提出可行的3種決策策略at并給出對應約束條件,通過決策策略的約束建模可體現故障恢復能力。

策略一:“DG”控制,以實現故障后孤島內負荷的供電恢復;DG出力的功率存在上下限表明其恢復能力的大小,如式(1)所示。

(1)

策略二:“DG +網絡重構”,靈活使用聯絡開關轉供電,形成孤島聯絡,充分利用DG的容量;網絡重構需要考慮配電網的潮流運行方式約束,主要為功率平衡約束、相鄰節點電壓關系約束、線路容量約束以及電壓大小上下限約束等。以線路容量約束為例說明,如(2)所示。

(2)

策略三:“源-網-荷”控制,通過可中斷負荷控制進一步提高供電恢復能力;可中斷負荷的功率變化大小與自身屬性有關,如(3)所示。

(3)

(4)

故障恢復階段DG提供備用功率支撐,需要考慮其出力成本;此外,對可中斷負荷進行控制時,需要考慮可中斷負荷的中斷補償成本。因此,本文考慮的故障恢復時電網運行經濟成本包括DG出力成本以及可中斷負荷的中斷補償成本,電網運行的經濟損失回報rc如式(5)所示。

(5)

綜合以上建立基于深度強化學習的故障恢復決策自學習Agent的即時回報函數rt+1, 見式(6)。

(6)

智能體Agent通過試錯學習方式選擇動作進行即時回報評價,基于評價激勵可實現經驗積累與決策動作優化。

2 基于DDQN結構的DRL自學習訓練

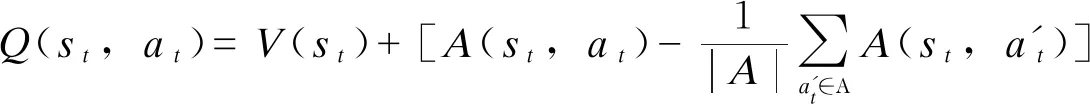

本節基于DDQN網絡開展DRL訓練,自學習智能體Agent的試錯經驗在估值函數Q矩陣中存儲,以實現狀態到主動配電網實時故障恢復策略的非線性映射。基于DDQN結構構造Q函數,對狀態和動作進行分層學習,DDQN用兩個不同的神經網絡分別擬合觀測狀態的狀態估值函數V(st)和當前狀態每個動作的優勢估值函數[23],并得到實現狀態和動作解耦的Q(st,at)值。DDQN的Q函數如式(7)所示。

(7)

式中:A為所有可執行動作集合,執行動作包括DG出力ADG、 聯絡開關動作AS以及IL控制AIL; |A|表示可執行動作的總數。由于每個觀測狀態只對應一個控制動作,因此獲取的一個Q函數值無法拆解成唯一狀態估值函數V值和動作優勢函數A值,故為了去除多余的自由度,提高算法穩定性,將動作優勢函數設置為單獨動作優勢函數減去當前狀態下所有動作優勢函數的平均值。

引入ε-greedy策略進行動作選取體現自學習對環境的探索機制見式(8)。

(8)

式中:ε為ε-greedy策略中的固定常數;T為總訓練次數;k為當前訓練次數;γ(0<γ≤ε)為計算機生成的隨機數;Q′(st,at)為狀態st下動作at的預測估值。

DDQN執行正向計算可得到所有控制動作的Q值,將目標Q值和神經網絡輸出的預測Q值之間的均方差定義為損失函數,見式(9)。

(9)

式中:Qπ*(st,at)為目標Q值;Qπ′(st,at,w)為神經網絡輸出的預測Q值;ω為神經網絡的結構參數;n為小批量訓練的樣本數。

為了消除短期內樣本間的時序相關性,采用記憶回放來存儲狀態動作傳輸對樣本(st,at,rt+1,st+1)。建立容量為N的經驗池,在每個訓練周期內,將主動配電網觀測樣本存入其中,當樣本數超過回放開始容量M, 則從經驗池中隨機抽取小批量的觀測樣本,開展神經網絡訓練,通過隨機抽取觀測樣本訓練神經網絡,避免過擬合等現象的出現。若樣本數超過經驗池的最大容量,則剔除掉最早的觀測樣本再存入新樣本,保證神經網絡學習最新的觀測狀態。

基于DDQN結構的DRL自學習訓練過程:首先設置合適的超參數λ、α、ε、n、N、M, 初始化神經網絡與經驗池,設定訓練終止時刻T并令當前訓練時刻t=0; 其次觀察當前狀態st, 結合ε-greedy策略選取下步動作at, 記錄下一狀態st+1并計算即時回報rt+1, 不斷積累樣本數據;然后判斷經驗池是否存滿,若存滿則剔除掉早期樣本,并存入當前時刻觀測樣本;當樣本數超過回放開始容量,從經驗池中隨機抽取n個小批量歷史樣本作為DDQN網絡的訓練數據開展DRL自學習訓練。具體來說,首先通過DDQN的正向計算得到所有控制動作的預測Q值,根據式(8)結合目標Q值計算損失函數,使用小批量梯度下降法完成DDQN網絡的參數更新;令t=t+1, 進行循環迭代,在經過足夠多的訓練周期后,DDQN神經網絡的結構參數會收斂于穩定值,完成估值函數的近似,最后判斷t是否達到終止時刻T, 若達到終止時刻則結束自學習的訓練過程。

采用觀測狀態數據完成基于DDQN的DRL訓練后,可實現觀測狀態到主動配電網故障恢復策略的非線性映射。后面基于算例仿真進行有效性分析。

3 算例分析

3.1 典型配電網隨機故障場景

選取IEEE 33節點典型配電系統作為算例,如圖1紅色虛線框內所示,詳細的算例模型參數見文獻[22];考慮臺風極端天氣下算例系統的故障恢復過程。在節點6,13,23,29設置可控型DG1、DG2、DG3、DG4,容量限額分別為300 kVA、300 kVA、400 kVA、600 kVA,可控型DG的單位電量出力成本為0.4元/kWh,節點6,13,23,29負荷在停電時單位電量的停電損失為5.6元/kWh;在節點21、32設置風電WT21、WT32,節點17、24設置光伏PV17、PV24;5條聯絡開關支路33、34、35、36、37作為改變拓撲結構的動作手段;在節點4、8、15、30設置可中斷負荷IL4、IL8、IL15、IL30,其單位電量的中斷補償成本分別為1.2、0.84、0.96、1.4元/kWh,在停電時其單位電量的停電損失成本為0.4元/kWh;其余節點負荷停電時單位電量停電損失成本為2元/kWh。

臺風災害下電力系統設備的故障率主要與臺風風速有關,根據現有的文獻,線路故障概率與臺風風速vtyp滿足威布爾累積分布[9],如式(10)所示。算例中臺風風速模擬按照下述假設:臺風風速vtyp服從正態分布,本算例中vtyp~N(22,62)。

(10)

式中α>0,β>0, 分別為尺度參數和形狀參數,結合配電網歷史故障數據。算例系統中支路5、9、15、20、22、28共6條線路為臺風登陸時的易受損線路。線性擬合獲取α和β參數的估計值,本算例中α=32,β=6。

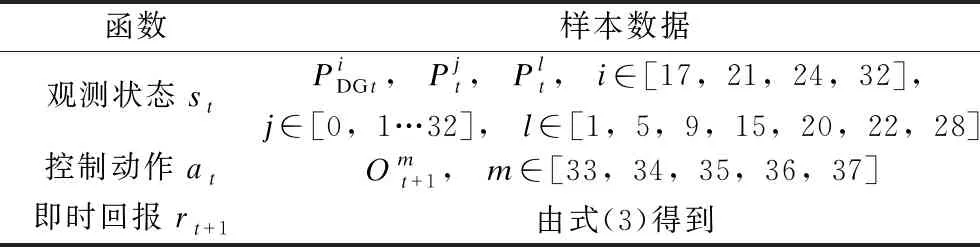

3.2 DDQN訓練的樣本數據

基于DDQN結構的深度強化學習算法開展易受損線路故障下隨機決策過程的優化,DDQN訓練的樣本數據(st、at、rt+1、st+1)對應的變量設置如表1所示。

表1 DDQN訓練樣本數據

(11)

3.3 基于DDQN的DRL自學習算法的超參數

將仿真中的DDQN網絡結構設置為:狀態估值網絡V(st)和動作優勢網絡A(st,at)的輸入層均含44個神經元(和狀態變量個數相同),隱含層分別含20個和25個神經元,均以線性整流單元(Relu)作為激活函數,V(st)和A(st,at)的輸出層分別有1個和32個神經元(代表聯絡開關的動作組合數),所有層之間采用全連接方式。DRL算法中超參數的設置見表2。

表2 DRL算法中超參數的設置

在迭代訓練期間,DDQN的損失函數下降情況如圖2所示。由圖2可知,DDQN的損失函數迅速下降并趨于穩定,說明該算法收斂性較好。

圖2 訓練期間DDQN的損失函數

3.4 基于DRL的決策結果

本文采用每隔15 min的運行狀態數據,基于蒙特卡羅仿真方法隨機生成線路故障集合,仿真配電網故障運行方式。把配電網觀測狀態(如表1所示)輸入到訓練后的DDQN神經網絡中,按照第1節3種不同的決策策略進行動作決策分析。

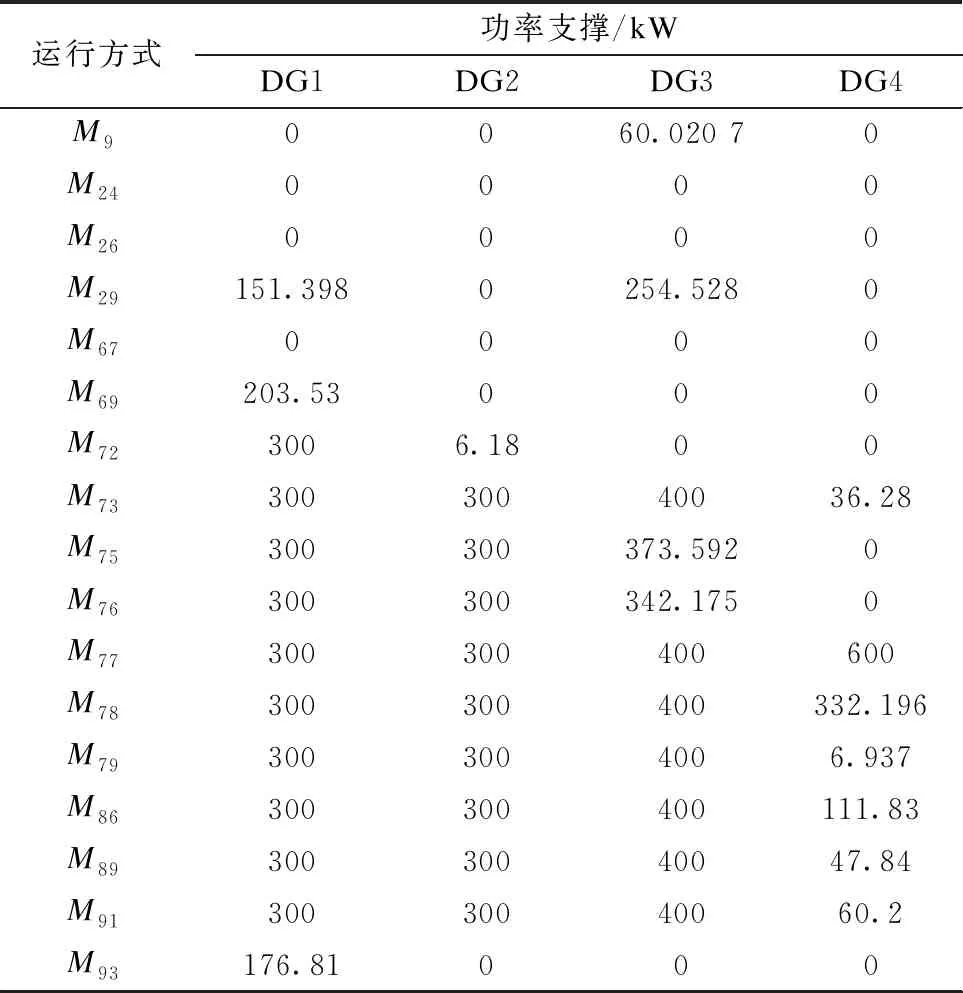

1)可控DG出力決策

可控DG出力在不同隨機運行方式下的決策結果如表3所示。

表3 可控DG出力的決策結果

2)聯絡開關動作

聯絡開關在隨機運行方式下的決策結果動作情況如表4所示,其中1表示動作,0表示未動作。

表4 聯絡開關決策結果

3)IL的中斷控制

針對隨機運行方式M29、M73、M75、M76、M77、M78和M79的IL決策結果中斷負荷量數據見表5。

表5 可中斷負荷決策結果

IL的需求響應曲線見圖3,其中藍色虛線代表IL的原始負荷需求,紅色實線代表優化控制后的實際負荷曲線。

基于3種不同決策策略,隨機故障運行方式下基于DRL的動作決策結果說明:本文基于DRL的高恢復力決策方法適應多種隨機運行方式。

3.5 不同決策策略的有效性

選取僅在DG支撐下無法完全恢復所有負荷供電的隨機運行方式,其余運行方式下由DG進行孤島供電,均可完全恢復。不同隨機運行方式下負荷

損失功率數據見表6。負荷損失功率是指該配電網算例中正常運行條件下所有負荷的總功率P1與極端災害導致的故障情況下所有負荷的總功率P2的差值,即負荷損失功率等于(P1-P2)。在隨機運行方式M9、M24、M26、M67、M69、M72、M86、M89、M91和M93下,采用策略二能夠將負荷損失功率減小到零,進一步發揮了DG的恢復能力;最后策略三采用“源-網-荷”控制,隨機運行方式M73、M75、M76和M79的負荷損失功率可減小到零。

表6 不同決策策略的負荷損失功率數據

綜上,針對配電網極端災害條件下故障過程的隨機性,將DG、聯絡開關以及IL作為減少停電損失的動作手段,通過基于DDQN的深度強化學習算法形成隨機優化動作決策,可有效提升配電網在極端災害條件下的恢復力。

5 結論

為提高極端災害下主動配電網供電恢復力,本文提出了一種基于深度強化學習的主動配電網高恢復力決策方法,通過典型算例研究了深度強化學習算法的隨機優化決策能力。

1)在極端災害導致的隨機故障場景下,本文構建基于深度強化學習的高恢復力決策模型,定義自學習Agent恢復力回報函數,采用觀測狀態數據訓練DDQN神經網絡,實現了觀測狀態到主動配電網故障恢復策略的非線性映射。

2)本文基于DDQN結構構造Q函數,對狀態和動作進行分層學習,開展基于DDQN的DRL自學習訓練過程,損失函數迅速下降并趨于穩定,說明該算法收斂性較好。

3)算例仿真研究表明,基于DDQN的深度強化學習算法適應多種隨機運行方式,不同動作決策均可實現有效提升故障恢復力。