動態視頻多幀連續圖像形變特征重構方法研究

韓 麗,王華東

(1. 鄭州輕工業大學計算機與通信工程學院,河南 鄭州 450000;2. 鄭州輕工業大學信息化管理中心,河南 鄭州 450000)

1 引言

隨著時代的發展,數據的形式發生了滄海桑田般的變化,傳統的圖像已滿足不了人們的日常需求[1,2]。與此同時,隨著視頻的興盛,視頻圖像中含有的運動信息和畫面信息等復雜特征,在圖像發生形變后使圖像的識別更加困難,因此需要結合圖像的時間和空間等相關顯著目標才能更好的重構視頻的連續圖像[3,4]。

近年來,動態視頻成為計算機視覺領域研究的熱點問題之一,引起廣大研究者的關注。文獻[5]將圖像中冗余的信息剔除,對圖像進行預處理,同時對連續形變的圖像采取參照原本圖像信息與灰度相融合的方式實現圖像變光背景的更新,通過對圖像特征矩陣的計算,完成矩陣相似信息的自適應識別,該方法對連續形變圖像信息的識別率較高,適應性較好。文獻[6]通過分數階微分函數增加圖像的高頻分量,使圖像細節增強,采用高斯平滑濾波算子對拉格朗日梯度算子進行更新,去除影響圖像重構的高斯白噪聲增量,該方法使圖像重構的質量有了明顯地提高,并增加了圖像的紋理細節。文獻[7]利用BRISK特征檢測方法對視頻中的特征點進行提取,確定圖像跟蹤的目標模板和特征集合,利用FLANN方法對特征點子集進行匹配,確定視頻圖像中的可靠特征點子集,若有三幀連續的目標發生形變,對目標模板和特征點集進行更新,該方法對形變嚴重的視頻圖像具有較好的跟蹤效果,跟蹤精度較高。

基于以上研究,本文提出動態視頻多幀連續圖像形變特征重構方法。使用卷積網絡對視頻圖像的特征進行提取,有利于實現圖像的重構效果,利用改進的殘差結構進行時間-空間特征融合,重構出細節更加豐富的視頻圖像。

2 動態視頻幀的計算

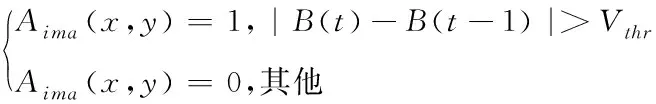

對于動態視頻流中特征的處理主要有幀間差分和光流兩種方法。光流法主要是通過目標速度與背景的不同將兩者區分開,但算法較為復雜,計算效率低。而幀差法執行速度相對更快,因此這里對視頻信息的處理采用改進的幀差法。視頻是由若干幀組成的視頻序列,具有連續性。如果視頻中沒有運動目標,那么連續幀變化不明顯;如果視頻中存在運動目標,那么連續幀變化明顯。因此目標的運動使圖像幀的位置不同,各個像素點間存在像素差。幀差法對連續幀進行差分運算,將RGB圖像轉化為灰度圖像后對灰度差的絕對值進行判斷。若絕對值比閾值低,則判定該點為背景點;若絕對值比閾值高,則判定該點為運動目標,公式可表示為

(1)

其中,Aima(x,y)=1表示前景;Aima(x,y)=0表示背景;B(t)表示t時刻的圖像;B(t-1)表示t-1時刻的圖像;Vthr表示差分圖像的閾值。由于運動目標的內部灰度值較為接近,使檢測的運動目標存在“空洞”現象,因此只能提取運動目標的輪廓信息,使圖片信息不完整。基于此對幀差法進行改進,將圖像的當前幀和后一幀作為輸入,分別對當前幀圖像的RGB三個通道做差分運算,并進行加權求和處理,公式可表示為

(2)

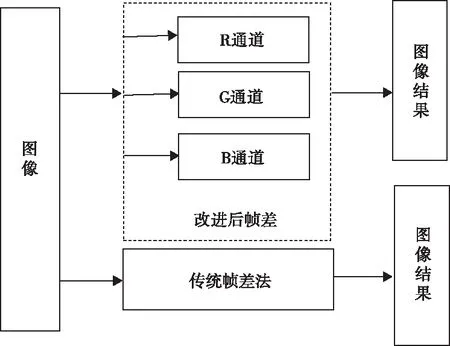

其中,BR(t)、BG(t)和BB(t)分別表示t時刻R、G和B三個通道的圖像;BR(t+1)、BG(t+1)和BB(t+1)分別表示t+1時刻R、G和B三個通道的圖像。改進后的幀差法不僅改善了圖像的“空洞”現象,還明顯增強了目標的運行痕跡。圖1 為改進后幀差法與傳統幀差法的計算對比結果。

圖1 改進幀差法與傳統幀差法的對比圖

對視頻的顯著性進行檢測,不僅要考慮時間上的運動特征,還要對當前視頻幀的空間特征進行分析,本文采用卷積神經網絡對視頻的顯著性進行檢測。采用卷積對輸入的視頻圖像進行特征提取,然后對提取的多特征進行時間與空間特征的融合處理,公式表示為

(3)

特征提取主要是對輸入視頻的初步特征進行提取,由于固定大小的卷積核只能提取一種尺度的特征,而不同大小的卷積核可以提取不同尺度的特征信息,因此采用大小不同的卷積核對圖像特征進行提取,獲得更加豐富的圖像信息,有利于圖像特征的重構。在特征提取模塊中分別使用大小為3和5的卷積核對圖像的兩種尺度進行特征提取,同時為了減少網絡中的參數,將各個卷積層輸入到一個卷積核大小為1的卷積層中,并將輸出合并到一起,公式表示為

Dout_img=E1([E3(X),E5(X)])

(4)

其中,Dout_img表示圖像的輸出特征;E表示進行的卷積操作;X表示圖像的輸入信息。進行特征提取后,需要對圖像的特征進行時間-空間的融合處理,采用卷積殘差塊的方法進行特征融合。其中包含3個卷積層,前2個卷積層使用卷積核的大小為3;同時將第1個卷積層的輸出分成Dout_img1和Dout_img2兩部分,第2個卷積層只對Dout_img2作處理,最后使用卷積核大小為1的卷積層將兩部分特征融合起來,公式表示為

(5)

其中,F表示分離操作;Dout_img_in表示殘差塊的輸入;Dout_img表示圖像的特征輸出。通過殘差塊對時間-空間的融合可以對視頻幀間的運動進行較好的補償,不僅可以降低網路的復雜度,還可以使圖像的重構結果更加準確。

3 特征重構方法模型

當動態視頻連續多幀變化時,會使視頻中目標姿態發生劇烈的改變,如果不對形變的圖像進行重構,會導致對提取的特征點出現誤判,因此需要對圖像特征進行重構。重構方法模型可表示為

(6)

(7)

其中,δ表示正常數;x表示輔助變量;l表示拉格朗日常數。為了進一步解決低秩矩陣極小化問題,對式(6)進行迭代求解,公式表示為

(8)

其中,t表示迭代次數。綜上所述圖像的重構問題可轉換成對Li、g和x求解的問題。

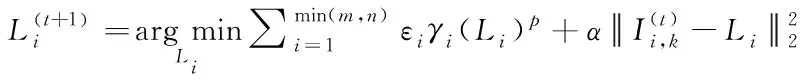

3.1 低秩矩陣Li求解

首先假定g和x為固定值,Li優化后通過加權范數處理,用公式可表示為

(9)

(10)

(11)

(12)

其中,μ為利普希茨常量,于是Li的求解問題可轉換為求解加權核范數的最小化問題,通過迭代權重加權核就可以方便的計算出其數值。

3.2 特征信號g求解

假定Li和x為固定值,原始圖像的特征信號g的優化處理公式可表示為

(13)

由上式可知,g優化處理后是一個凸二次優化問題,將其進行封閉求解,公式可表示為

(14)

其中,I表示單位矩陣。因圖像中含有大量信息,采用共軛梯度法進行求解,可以大大提高運算的速率。

3.3 輔助變量x求解

假定Li和g為固定值,輔助變量x的優化處理公式可表示為

(15)

由上式可知,x優化處理后也是一個凸二次函數的極小化問題,為了得到x的封閉解,對其進行求導,得

(16)

4 實驗結果與分析

為了驗證動態視頻多幀連續圖像形變特征重構方法的有效性和適用性,本文選擇VideoSal數據集,其中包含不同場景的視頻序列7萬個,每個視頻序列由7幀連續的視頻幀組成,較為全面的覆蓋了目標的高速運動和角度變化等場景,能夠對視頻顯著性進行有效地驗證。本文通過平均絕對誤差(MEA)和精確率與召回率的加權平均(F-Measure)兩個指標對實驗結果進行評價。

MEA表示原始圖像與其在像素層的真值之間的絕對誤差平均值,公式表示為

(17)

其中,U表示原始圖像;V表示原始圖像在像素層的真值;Wima表示圖像的寬度;Hima表示圖像的高度;(x,y)表示像素點與中心像素點的坐標。

F-Measure表示精度與召回率加權后的平均值,用公式可表示為

(18)

其中,ζ表示權重,J表示精確率;Z表示召回率。

4.1 特征融合的驗證

為了驗證特征融合對視頻的作用,使用普通的殘差塊與本文提出改進的殘差塊對網絡進行訓練,分別用方法1和方法2表示,并在VideoSal數據集上測試。對比結果如表1所示。

表1 兩種方法的性能評價指標

從表中可以看出,采用普通殘差塊方法對視頻融合時,MEA和F-Measure這兩種性能評價指標明顯沒有本文改進后的方法好,而且網絡參數量比本文方法略高。為了驗證視頻融合過程的有效性,將本文方法與文獻[5]、文獻[6]和文獻[7]的方法進行對比,同時對圖像進行2倍和4倍的放大處理,不同方法在VideoSal數據集上的評價指標如表2所示。

表2 不同放大倍數下性能評價指標

從表中可以看出,本文提出的方法與其它方法相比,評價指標均有一定的提升,證明了本文方法的有效性。在進行圖像的2倍放大時,與效果較好的文獻[6]和文獻[7]方法相比,本文方法在MEA指標上分別提高了0.025和0.021;在F-Measure指標上分別提高了0.207和0.146。在進行圖像的4倍放大時,本文方法較文獻[6]和文獻[7]方法在MEA指標上分別提高了0.03和0.026;在F-Measure指標上分別提高了0.209和0.147。雖然在網絡參數量上本文方法比文獻[7]方法略高,但獲得的重建性能較好。

4.2 重構性能評估

為了對視頻中某幀圖像的檢測效果進行驗證,隨機選擇3張VideoSal數據集中的某幀圖像作為目標圖像,并將本文方法與文獻[5]、文獻[6]和文獻[7]的方法進行對比。各個重構算法的圖像對比圖如圖2所示。

圖2 不同方法重構圖像對比結果

從圖中可以看出,采用文獻[5]和文獻[6]的方法重構出的圖像邊緣等細節較為模糊,重構的效果比較差;利用文獻[7]的方法,當采樣率較低時,重構圖像相對有改善,但邊緣等細節仍不能取得較好的效果;而本文的重構方法,充分利用了函數求解和圖像本身的特性,即使在低秩矩陣中,圖像的重構效果也較好,與原始圖像最為接近,視覺效果比其它方法相對較好,通過圖像的局部放大可以看出本文方法對圖像的細節保護性能更佳。

5 結束語

本文提出動態視頻多幀連續圖像形變重構方法,利用改進后的幀間差分法對視頻幀的RGB三通道上的差分值進行計算,提取圖像在時間上的運動特性,再通過卷積神經網絡對視頻的每幀圖像進行空間特征的提取,并采用改進的殘差塊對RGB通道分離出的圖像特征進行融合,對形變的圖像通過改進后的方法進行重構。在VideoSal數據集上將本文方法與其它文獻方法進行對比,并選擇MEA和F-Measure這兩個值作為性能評價指標。實驗結果表明,本文方法與采用普通殘差塊方法對視頻融合時,MEA和F-Measure性能評價指標較好,且網絡參數量較少,圖像的重構效果與原始圖像最為接近,對圖像的細節保護性能更佳。