融合尺度空間的智能機器人自適應跟隨仿真

韓 菊,曹 峰

(1.太原學院計算機科學與技術系,山西 太原 030012;2.山西大學計算機與信息技術學院,山西 太原 030001)

1 引言

由于目標跟隨技術能夠完成特殊場景中的自主動作,被大量應用于制導、安防和機器人等領域[1]。依托各類傳感器對環境和目標的感知,利用特征提取分析等技術完成目標檢測。隨著視頻圖像軟硬件技術的發展,大部分目標采用視頻跟隨方式[2]。但是,跟隨過程存在動靜態混合過程,會引起視頻圖像的清晰度、光照度和尺度變換。另外,長期的目標遮擋也會給目標識別帶來誤差干擾。為了能夠找到一種兼具精度、速度,以及抗擾性的跟隨算法,研究人員已經做了很多工作,也取得了一些成果。早期較為著名的跟隨方法包括MeanShift、SVM、TLD和KCF等[3]。它們推動了目標跟隨在實際中的應用,同時也推動了各種改進方法的出現。文獻[4]針對跟隨過程中發生的部分遮擋情況,采用計算K均值的方法來分辨目標與背景。文獻[5]在TLD基礎上引入了尺度變換處理,并采用置信度評價學習粒子。文獻[6]在KCF基礎上,通過對目標采取HOG與LBP特征提取,改善跟隨過程中的遮擋問題。文獻[7]依據超像素處理來實現位置與尺度兩個方面的特征跟隨。文獻[8]根據卷積計算來確定KCF響應和尺度信息。這些改進方法都在傳統方法的基礎上做了某些性能提升,考慮到機器人目標跟隨應用場景,以及跟隨算法的適應性,結合現有研究成果,本文提出了融合尺度空間的自適應目標跟隨方法。

本文方法融合尺度空間,構建包含位置估計與尺度空間估計目標模型,利用位置估計實現快速檢測,利用尺度估計適應尺度變換,同時對位置和尺度參數的計算進行優化。由于位置與尺度模型無法有效處理長時間的目標丟失,所以又針對非規則模糊圖像和遮擋情況分別設計了目標與背景分類器,從而提高跟隨算法的環境自適應性。

2 融合尺度空間的機器人跟隨模型

2.1 目標位置確定

考慮到目標位置估算的速度問題,采取高斯核對空間特征進行映射。通過低維向高維的轉換實現特征可分性。利用目標附近的a×b圖像區域,確定學習粒子xi及其標簽yi,這里i∈{0,…,a-1}×{0,…,b-1}。目標位置映射對應的代價約束描述為

(1)

引入學習粒子的核矩陣,可以得到分類器表達式為

ε=(H+αI)-1Y

(2)

其中,I代表單位矩陣;H代表學習粒子的核矩陣,hij=h(xi,xj)=〈m(xi),m(xj)〉;Y代表由yi構成的矩陣。求解出的結果代入線性組合公式,確定正則后的濾波響應如下

f(k)=F-1{F(ε)F[mT(x),m(k)]}

(3)

其中,k代表備用學習粒子;F-1代表傅里葉反變換;m(x)代表學習粒子特征向量;m(k)代表備用學習粒子特征向量。通過求解f(k)的最大值,能夠得到當前幀的目標位置。

在計算學習粒子線性組合的時候,需要收集不同時間段內的學習粒子。假定將不同時間段內學習粒子的平均誤差標記為Δxi,…,Δxt,利用最小二乘便可以計算出所需濾波器數量。考慮到位置確定應該具有較好的魯棒性,同時為了簡化處理過程,本文采取DFT變換求解濾波器參數

(4)

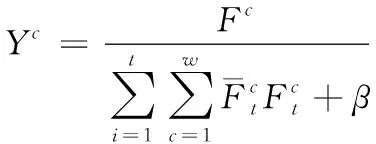

(5)

其中,Yc代表DFT處理后的標簽變量;β代表加權因子,用于防止濾波器出現擬合過度的情況。

2.2 目標尺度確定

采用高斯函數與卷積計算對學習粒子進行特征尺度映射,相應的尺度映射代價約束描述為

(6)

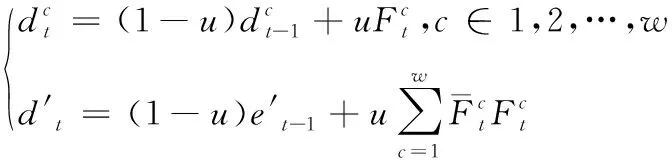

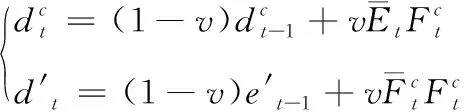

其中,fi代表尺度濾波器;xi代表時間序列的學習粒子;ei代表xi的期望高斯輸出;*代表卷積計算。基于復頻域,利用Parseval定理對代價約束進行處理,求解出尺度濾波器參數如下

(7)

(8)

基于尺度濾波器,備用學習粒子k的響應可以表示為

(9)

3 自適應跟隨檢測

融合尺度空間的跟隨方法可以根據學習粒子完成目標的快速跟隨。同時由于約束條件的邊界性,能夠很好的保證目標跟隨的魯棒性。盡管融合尺度空間優化了基于位置跟隨的魯棒性,可是其過程中仍然會形成過多的學習矩形區域,從而影響算法處理性能。為增強目標與背景的識別精度,本文首先采用尺度掃描來獲得矩形區域,目標粒子尺度選擇方式描述如下

(10)

其中,μ代表尺度系數;m代表尺度掃描的區域數量;M代表尺度層數。通過尺度選擇,能夠得到m數量的矩形區域,再將區域內的目標特征進行分類。分類器公式描述如下

(11)

fi代表矩形區域i;二值參數x∈{0,1}用于描述正負粒子的標簽。考慮到目標的非規則性,為了消除矩形邊緣與內部的相互影響,將矩形區域采取g×g均分,并為每個子區域賦予權重

(12)

(o0,x,o0,y)和(oi,x,oi,y)分別代表矩形區域和子區域i對應中心位置。引入權重后的分類器表達式更新為

(13)

G代表g×g均分后子區域數量;fji代表子區域j中的i特征值。此時,由于權重的不同,邊緣特征將會獲得相對小的分數,進而降低目標邊緣受背景的影響,更加準確的分辨出目標和背景。

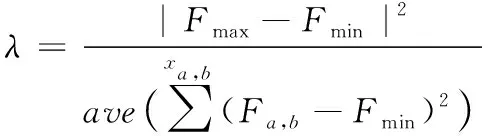

機器人對目標進行跟隨的過程中,可能會出現目標被遮擋的情況。如果目標被完全遮擋,則目標消失很容易導致跟隨失敗。如果目標被部分遮擋,隨著時間流逝很容易使跟隨誤差增加,進而導致跟隨失敗。因此,要完成機器人的自適應跟隨,就需要對目標遮擋采取有效的處理。根據遮擋造成的影響程度,這里將其劃分成輕重兩級。對于隸屬輕級別的情況,維持跟隨狀態與模型的更新。對于隸屬重級別的情況,需要立即采取重檢,且無需進行模型更新。在輕重級別劃分時,直接依據模型的最大響應來確定劃分閾值可能會導致誤差不可控。當出現累計誤差時,跟隨模型可能已經發生偏移,此時得到的閾值將失去有效性。于是,這里綜合響應峰值與響應波動進行衡量,描述如下

(14)

其中,Fmax為模型最大響應;Fmin為模型最小響應;ave(·)為均值求解。通過λ值的計算,有利于體現圖像區域內各點響應相對峰值的情況。在目標存在遮擋或者消失的時候,將引起較大的波動效果,λ受到影響而顯著降低。所以利用λ便可以有效判斷出目標是否受到遮擋。當出現遮擋,為了能夠維持較好的跟隨性能,這里通過對目標和背景的分布狀態進行區分。此過程可以看做是學習粒子的特征至分類的映射。基于屬性描述的學習粒子為Xn=(fn,sn),n∈[1,a×b],f為粒子特征集合;s為粒子分類集合;映射過程描述為f→s。利用SNB對學習粒子進行分類處理。通過隨機方式選取f內的i組子集,其間需要滿足子集大小一致的限定條件,任意子集可以描述如下

fi={fi,1,fi,2,…,fi,j}

(15)

其中,j表示子集內的特征數量。如果所有子集內的屬性均滿足相互獨立,則f的似然估計可以描述如下

(16)

其中,nf、ns依次表示特征總數量和分類總數量。根據似然估計,推導得出分類器如下

(17)

通過分類器處理,便可以更好的完成遮擋情況下的目標和背景分類。

4 實驗與結果分析

4.1 實驗環境

實驗基于OTB視頻集來模擬機器人對目標的跟隨效果,OTB中包含11類變換屬性,能夠模擬較為復雜的應用場景。實驗平臺選擇Intel(R)Core(TM)i5-8250U,頻率1.8GHz,內存8GB。采用MatlabR2014仿真軟件驗證跟隨算法的性能。實驗過程中,設置正則系數α=0.01,學習率u=v=0.075,尺度系數μ=1.13,尺度層數M=28。

4.2 評估指標

為了對跟隨性能進行定量分析,通過距離精度來衡量跟隨精確度。該指標能夠反映目標位置的誤差,其公式描述如下

(18)

其中,N代表測試視頻包含的總幀數;Nframe代表跟隨誤差符合約束條件的幀數。對于每一幀視頻,采用距離來判定位置誤差,其計算公式描述如下

(19)

其中,(x',y')代表跟隨估計的目標位置;(x,y)代表標記的目標位置。

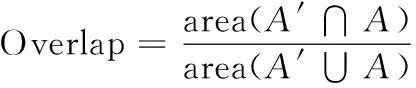

通過成功率指標進一步衡量跟隨效果,該指標能夠反映目標的重疊率,其公式描述如下

(20)

其中,N代表測試視頻包含的總幀數;Noverlap代表跟隨過程中重疊率符合約束條件的幀數。關于重疊率,公式描述如下

(21)

其中,A′代表跟隨估計的目標區域;A代表標記的目標區域。

基于評估指標,選擇文獻[7]和文獻[8]的跟隨方法作為實驗對比,進而驗證所提方法的性能優勢。

4.3 定量結果分析

從OTB數據集中隨機選取10個視頻序列,通過調節誤差門限,得到各跟隨方法的距離精度變化情況,結果如圖1所示。由曲線可知,誤差門限的合理設定,將直接影響測試的距離精度。如果門限設置過小,會導致一些正常跟隨被誤判;如果門限設置過大,又會導致一些非正常跟隨被覆蓋。門限的不合理設置,均會對精度產生影響。另外,經過曲線對比能夠發現,在距離精度達到穩定后,本文方法具有明顯優勢。

針對選取的10個視頻序列,通過調節重疊門限,得到各跟隨方法的成功率變化情況,結果如圖2所示。由曲線可知,重疊門限的合理選取直接影響成功率大小,同時也能夠得到在任意重疊門限情況下,本文方法的成功率都高于其它方法。

圖2 成功率隨重疊門限的變化

從OTB數據集中隨機選取10個視頻序列,根據距離精度結果設置誤差門限為15,測試得到各跟隨方法的距離精度,結果如表1所示。由測試數據可知,文獻[7]方法的平均距離精度為73.17%,文獻[8]方法的平均距離精度為77.46%,本文所提方法的平均距離精度為86.51%。在測試選取的10個視頻序列中,本文方法的距離精度均高于其它方法,且平均精度分別高于文獻[7]和文獻[8]方法13.34%、9.05%。

表1 距離精度

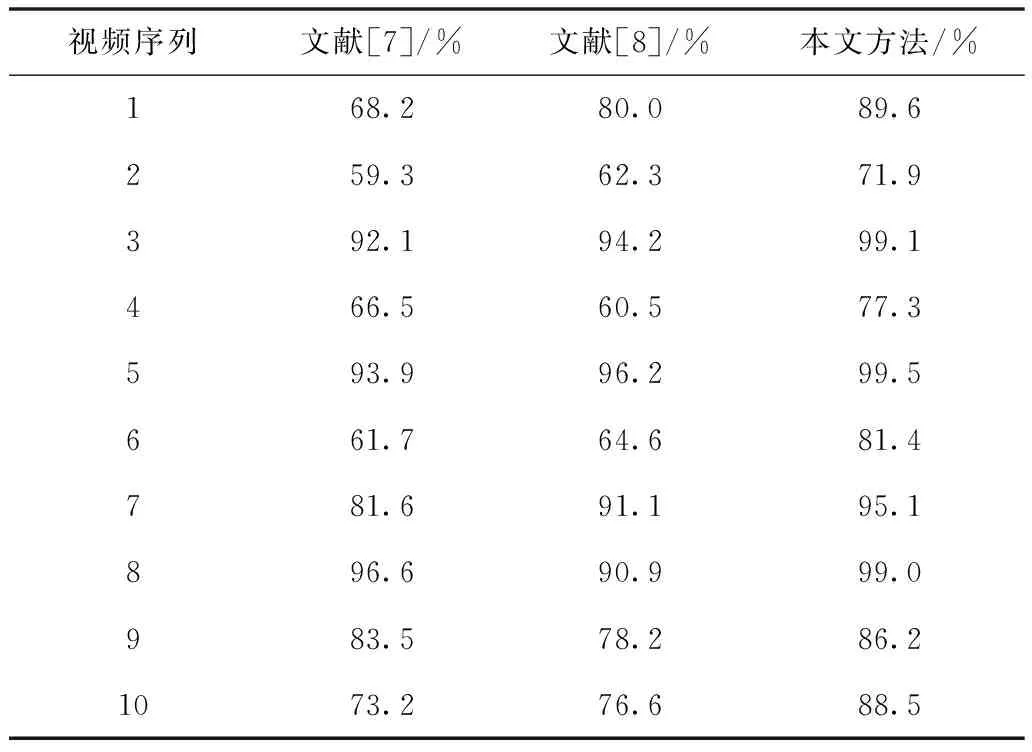

針對選取的10個視頻序列,根據成功率結果設置誤差門限為0.45,測試得到各跟隨方法的成功率,結果如表2所示。由測試數據可知,文獻[7]方法的平均成功率為77.66%,文獻[8]方法的平均成功率為79.46%,本文所提方法的平均成功率為88.76%,本文方法的平均成功率分別高于文獻[7]和文獻[8]方法的11.10%、9.30%。

表2 成功率

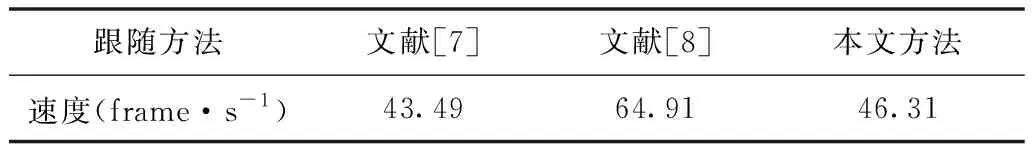

通過10個視頻序列測試得到各方法的平均運行速度,結果如表3所示。比較發現,雖然本文方法的運行速度較文獻[7]方法慢了一點,但是仍然滿足目標跟隨的實時性要求,具有良好的跟隨速度。

表3 運行速度

5 結束語

為了提高智能機器人跟隨效果,本文采用目標位置融合尺度空間的方法構建跟隨模型,針對目標和背景的區分設計了目標區域特征分類與權重分類器,針對目標遮擋設計了基于波動的似然估計分類器。通過OTB數據集對機器人跟隨效果進行模擬仿真,得到所提方法的平均距離精度為86.51%,平均成功率為88.76%。表明融合尺度空間自適應跟隨方法魯棒性好,顯著提升了尺度變換與遮擋等復雜場景下的精度與速度。