基于多智能體強化學習的多園區綜合能源系統協同優化運行研究

楊 照,黃少偉,陳 穎,2

(1.清華大學電機工程與應用電子技術系,北京 100084;2.青海大學新能源光伏產業研究中心,青海 西寧 810016)

1 引言

綜合能源系統能夠提高能源利用效率,促進可再生能源消納[1]。作為用能終端側的多能耦合系統,多能園區將園區中多種能源進行轉換、分配與有機協調,給終端用能側帶來了更大的靈活性[2]。相比于各個園區單獨運行,多個園區間的協同運行構成了多園區綜合能源系統。多園區綜合能源系統內的能量互濟可進一步釋放分布式資源的潛力,提高各個園區運行方式的靈活性,降低各個園區運行成本[3]。因此研究多園區綜合能源系統協同優化運行方法對于提高系統經濟性,促進可再生能源消納具有重要意義[4]。

目前對多園區綜合能源系統協同優化運行方法的研究有集中優化和分布式優化兩種方法[5]。集中優化方面,文獻[6]提出了一種基于可再生能源配額制的多園區綜合能源系統優化調度模型,并采用集中優化進行求解,有效地提高了系統可再生能源消納能力,并保證了系統的經濟性;集中優化需要一個集中決策者,大量信息的傳遞會對通信造成較大負擔,同時詳細信息的傳遞也不利于保護園區的隱私[7]。分布式優化方面,文獻[3]提出了一個基于能源交易的能源共享策略,以協調區域綜合能源系統中互聯的多能微網,并采用交替方向乘子法算法(Alternating Direction Method of Multipliers,ADMM)實現了能量分配的分布式優化;文獻[8]研究了同一能源配送網絡下多能源樞紐的協同優化運行問題,采用基于ADMM的分布式優化算法進行求解,保護了各能源樞紐的隱私,保證了調度的相對獨立性。在多園區綜合能源系統中,各個園區往往分屬不同的管理者,根據最小化自身運行成本的目標進行自主調度決策,因此系統呈現出多利益主體特性。然而上述研究均以全局最優為目標,沒有對各個園區之間的能量傳遞進行結算,忽略了多園區綜合能源系統中的多利益主體特性,同時也缺乏對新能源出力以及多能負荷的多重不確定性的考慮。

基于數據驅動的強化學習算法(Reinforcement Learning,RL)無需對不確定量進行精準預測,目前已有較多的研究將強化學習應用于電力系統和綜合能源系統的決策控制中[9,10],文獻[9]介紹了基于RL的模型和解決方案在頻率調節、電壓控制、能源管理方面的關鍵應用;文獻[10]介紹了RL的最新進展以及在電力系統中應用的前景和挑戰;文獻[11]將深度強化學習算法(Deep Deterministic Policy Gradient,DDPG)應用于綜合能源服務商的定價和調度決策中;文獻[12]提出了一種基于無模型深度強化學習的多能園區實時自治能量管理策略,并驗證了該方法在降低用戶用能成本的同時處理不確定性的優越性能;文獻[13]將RL和傳統優化方法相結合,提出了一種雙層強化學習模型,以實現綜合能源系統的實時經濟調度。但上述研究多將強化學習應用于將綜合能源系統建模為單一主體的場景中,目前尚缺乏對強化學習應用于綜合能源系統多主體場景中的研究。

因此,本文針對含多重不確定性的多園區綜合能源系統多利益主體協同優化運行問題進行研究,采用強化學習算法進行求解。本文首先針對多園區綜合能源系統建立基于內部市場和內部能量交易的整體模型;然后建立單個園區數學模型和內部市場出清機制;接著建立面向多智能體系統的馬爾可夫博弈模型來描述多智能體強化學習任務,并建立基于多智能體深度確定性策略梯度算法(Muli-Agent Deep Deterministic Policy Gradient,MADDPG)的求解架構和訓練方法;最后通過仿真驗證本文所提方法在確定性場景中和不確定性場景中的表現。

2 多園區綜合能源系統建模

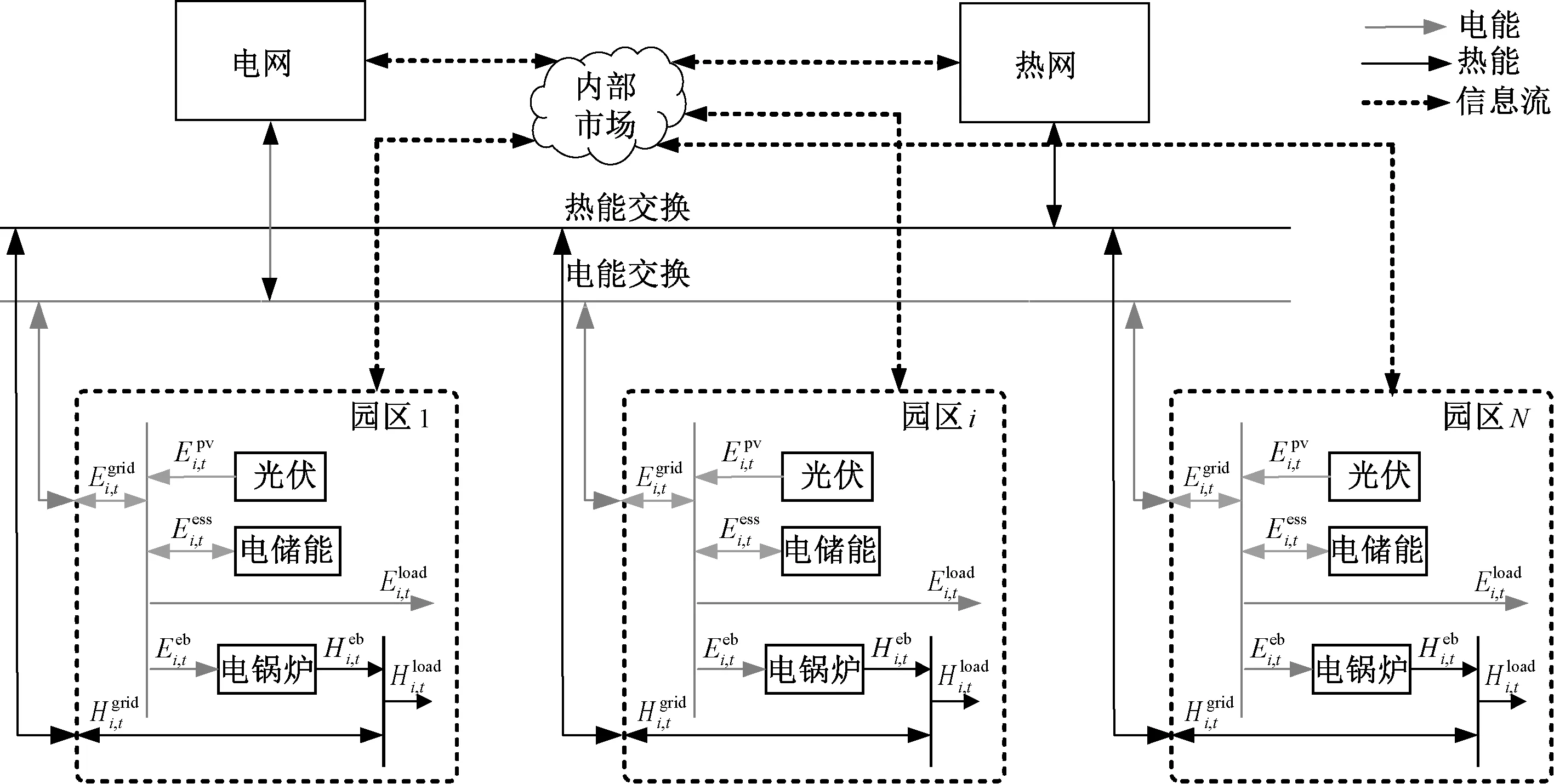

2.1 多園區綜合能源系統結構

本文研究的多園區綜合能源系統的整體結構如圖1所示。園區之間可以通過能量母線進行能量的雙向傳遞,并通過內部市場進行結算。基于內部市場,能量富余的園區可以將多余的能量賣給其他園區,而不是低價賣給外部能源網絡;能量不足的園區可通過內部市場購買能量,從而避免以較高的價格向外部能源網絡買入能量。因此相比于各個園區單獨運行,基于內部市場的多園區協同運行可充分發揮園區的靈活性和能量互補特性,降低各個園區的運行成本。

圖1 多園區綜合能源系統整體結構Fig.1 Structure of multi-park integrated energy system

在多園區綜合能源系統中,各個園區優化自身調度策略,并將計劃買入或售出的能量信息提交給內部市場,由市場管理者進行出清,多余或缺乏的能量再向外部能源網絡賣出或買入。接下來介紹單個園區優化模型和內部市場出清機制。

2.2 單個園區模型

單個多能園區由新能源、儲能、能量轉換設備(如電鍋爐、CHP等)和多能用戶等構成。對于每個園區,園區管理者制定園區內部設備的運行計劃從而實現園區的經濟運行。園區管理者從外部能源網絡或其他園區購入電、熱等能源,經過能量存儲和轉換輸出至內部多能用戶,也可將多余的能量賣給其他園區或外部能源網絡,其調度目標為最小化自身運行成本為:

minCi(xi)

(1)

(2)

每個園區在運行時需要滿足如下約束條件:

(1)能量平衡約束。

(3)

(4)

(2)儲能動作約束。

(5)

(6)

(7)

SOCmin≤SOCt≤SOCmax

(8)

(9)

(4)傳輸線功率約束。

0≤Ei,t,b≤Ei,b,max

(10)

0≤Ei,t,s≤Ei,s,max

(11)

0≤Hi,t,b≤Hi,b,max

(12)

0≤Hi,t,s≤Hi,s,max

(13)

式中,Ei,b,max、Ei,s,max、Hi,b,max、Hi,s,max分別為電、熱傳輸線路(管道)最大功率。

2.3 市場出清機制設計

本文采用內部市場實現園區間能量交易的結算,每個園區只需向內部市場提供自己的總售能量和購能量數據,無需提供詳細的運行數據。

本文參考文獻[14]微電網內部電力市場結算方案建立多園區內部電、熱市場出清方法,電能市場價格出清如式(14)、式(15)所示,熱能市場類似。

(14)

(15)

3 求解方法

本節首先將第2節中建立的多園區綜合能源系統模型轉換為馬爾可夫博弈模型。在此基礎上,本節建立了一種面向多園區綜合能源系統的MADDPG算法,該算法采用“集中訓練,分散執行”的方法求解此馬爾可夫博弈問題。在虛擬環境中,智能體基于系統狀態進行訓練,在實際環境中,訓練好的智能體可僅基于自己的局部觀測給出最優動作,從而避免了通信負擔過大和隱私泄露的問題,同時多智能體算法保證了多利益主體各自收益的最大化。

3.1 馬爾可夫博弈模型

為簡化問題,本文對各園區設計了相同的結構,同時對各個智能體設計了形式相似的觀測空間、動作空間和獎勵函數。

(16)

(17)

(18)

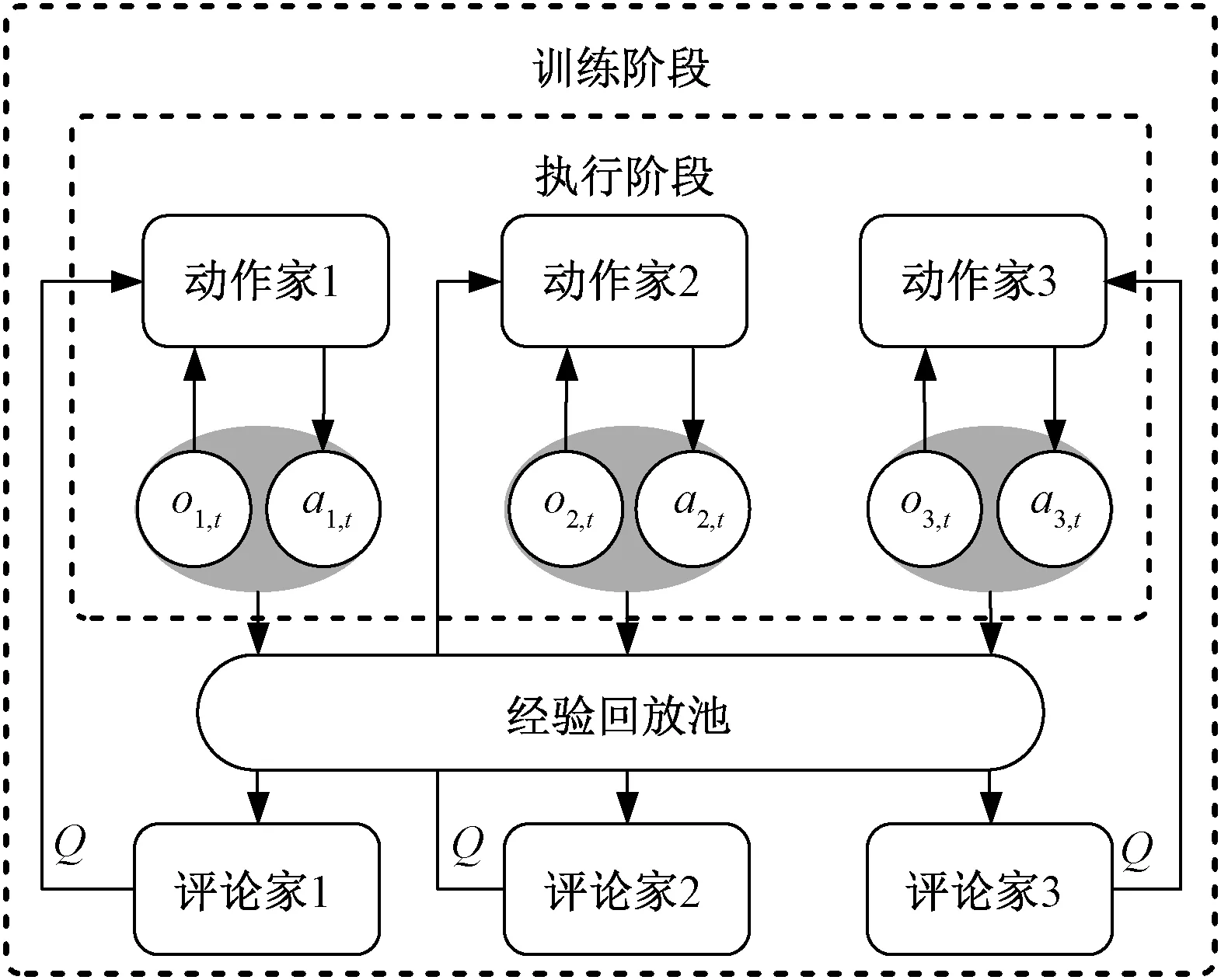

3.2 面向多園區綜合能源系統的MADDPG算法

盡管已有較多研究應用深度強化學習算法求解電力系統和綜合能源系統優化調度問題,但是對于多主體系統,直接使用多個強化學習智能體進行獨立訓練和決策往往達不到理想的效果。由于每個智能體的獎勵依賴于所有智能體的動作,然而每個智能體的策略分布在訓練過程中且都在不斷變化,因此從單個智能體的角度看,其面對的環境是不穩定的。這種不穩定打破了強化學習算法所遵循的馬爾可夫假設[15],因此難以通過獨立訓練多個強化學習智能體得到穩定的策略分布。為了解決這個問題,本文采用具有“集中訓練,分散執行”特點的MADDPG算法求解多園區綜合能源系統協同優化問題。

MADDPG算法是DDPG算法[16]的多智能體版本,其模型結構如圖2所示。每個智能體由需要全局信息的評論家網絡(Critic)和只需要局部觀測的動作家網絡(Actor)組成[17]。MADDPG算法處理環境不穩定的關鍵是集中訓練的評論家網絡,在訓練階段,評論家網絡輸入系統狀態,因此每個智能體都能捕捉到環境的動態變化,這使得MADDPG的訓練過程更加穩定。MADDPG算法中,動作家網絡和評論家網絡均為多層全連接網絡。由于評論家網絡輸入系統狀態,因此其網絡寬度大于只輸入局部觀測的動作家網絡。本文建立的動作家和評論家網絡的結構如圖3所示。

圖2 MADDPG算法結構Fig.2 Structure of MADDPG algorithm

圖3 動作家網絡和評論家網絡結構Fig.3 Structures of actor network and critic network

(19)

(20)

(1)評論家估計網絡參數更新

評論家估計網絡通過最小化損失函數LθQ來更新參數,損失函數的定義為:

(21)

(22)

根據損失函數的梯度更新評論家估計網絡的參數為:

(23)

式中,αQ為評論家估計網絡的學習率。

(2)動作家估計網絡參數更新

在訓練過程中,動作家網絡朝聯合狀態動作價值Q增大的方向更新參數以獲得更大的價值,動作家網絡參數更新的梯度為:

(24)

動作家估計網絡的更新公式為:

(25)

式中,απ為動作家估計網絡的學習率。

(3)目標網絡參數更新

評論家和動作家目標網絡參數由相應估計網絡參數進行滯后更新,采用如式(26)、式(27)所示的軟更新方式用以提高訓練的穩定性和收斂性[18]。

θiπ′←τθiπ+(1-τ)θiπ′

(26)

θiQ′←τθiQ+(1-τ)θiQ′

(27)

式中,τ為軟更新系數,且τ?1。

在訓練過程中,由于智能體與環境順序交互產生的樣本有關聯,并不滿足獨立同分布的假設,因此不能直接用于訓練。MADDPG算法采用同DDPG相同的經驗回放機制,在與環境的交互中存儲智能體與環境交互產生的經驗序列e=(o1,t,oi,t,on,t,a1,t,ai,t,an,t,r1,t,ri,t,rn,t,o1,t+1,oi,t+1,on,t+1),在樣本池中隨機抽樣一個小批量樣本用于訓練,從而降低樣本間的相關性。

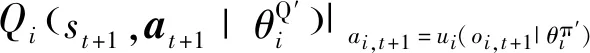

3.3 基于MADDPG算法的多園區綜合能源系統協同優化求解架構

在多園區綜合能源系統的協同優化問題中,本文使用歷史數據在虛擬空間進行離線訓練,訓練好的智能體在真實物理空間進行分散決策,既降低了執行階段的通信負擔,又保護了各個園區的隱私,多園區綜合能源系統協同優化問題的求解架構如圖4所示。

圖4 多園區綜合能源系統協同優化求解架構Fig.4 Solution framework for collaborative optimization of multi-park integrated energy system

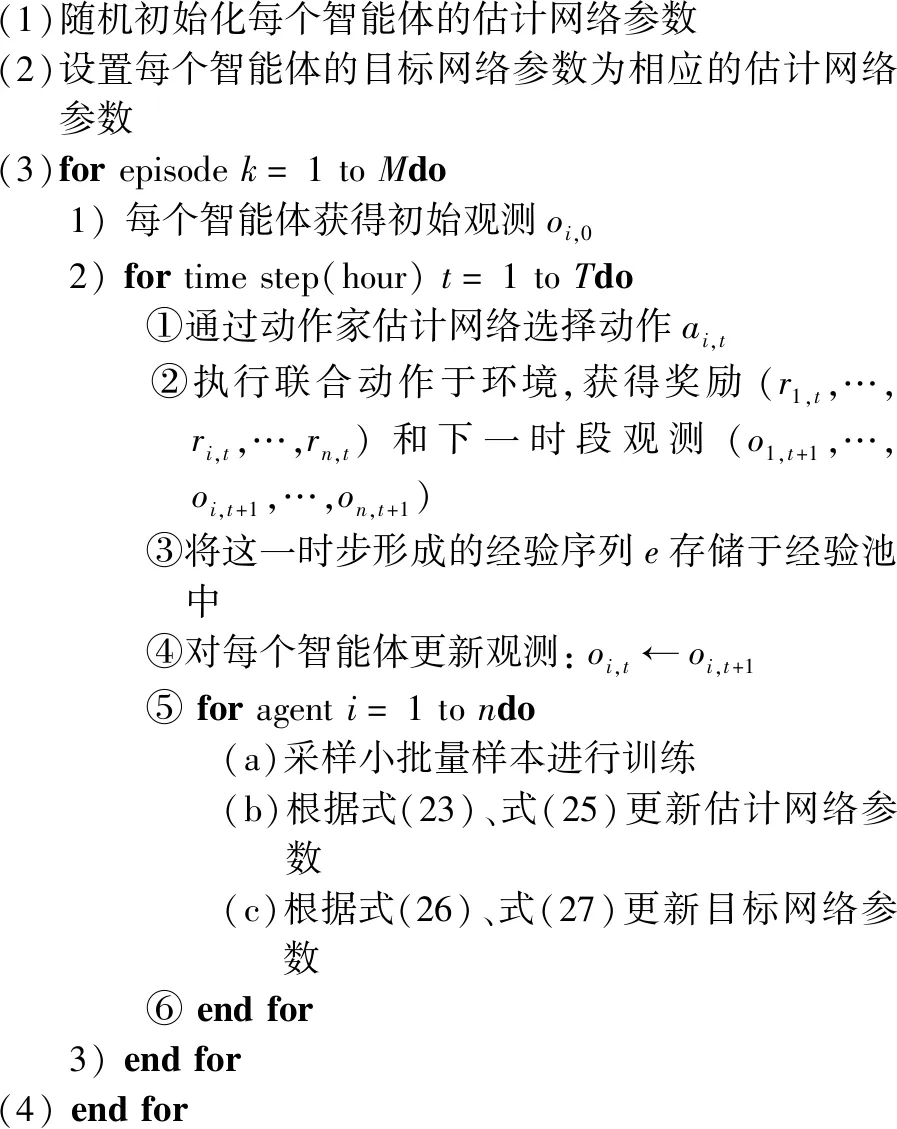

其中MADDPG算法的訓練過程如下:

(1)隨機初始化每個智能體的估計網絡參數(2)設置每個智能體的目標網絡參數為相應的估計網絡參數(3)forepisodek=1toMdo 1)每個智能體獲得初始觀測oi,0 2)fortimestep(hour)t=1toTdo ①通過動作家估計網絡選擇動作ai,t ②執行聯合動作于環境,獲得獎勵(r1,t,…,ri,t,…,rn,t)和下一時段觀測(o1,t+1,…,oi,t+1,…,on,t+1) ③將這一時步形成的經驗序列e存儲于經驗池中 ④對每個智能體更新觀測:oi,t←oi,t+1 ⑤foragenti=1tondo (a)采樣小批量樣本進行訓練(b)根據式(23)、式(25)更新估計網絡參數(c)根據式(26)、式(27)更新目標網絡參數 ⑥endfor 3)endfor(4)endfor

4 算例分析

4.1 算例參數

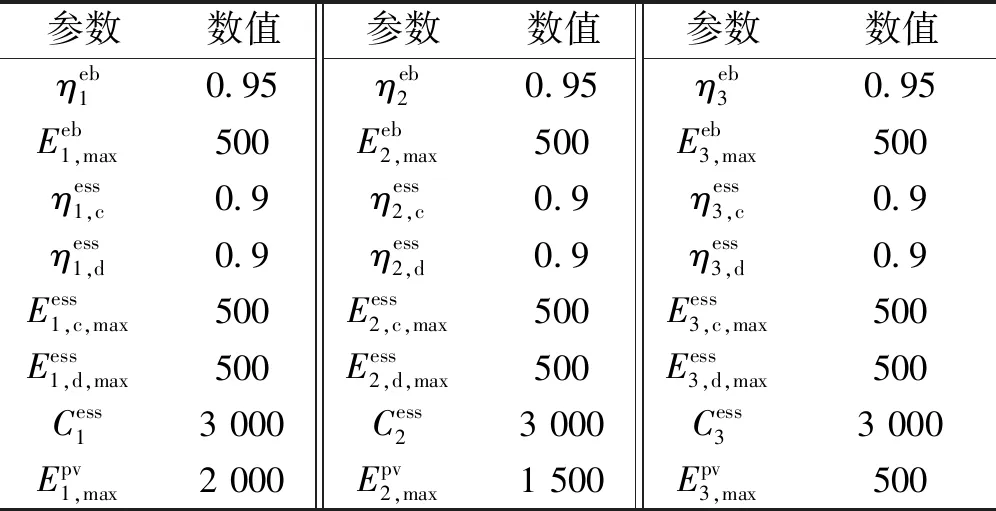

表1 設備參數Tab.1 Parameters of devices

表2 電網電價Tab.2 Electricity price of power grid

本文設定各個園區智能體的網絡結構相同,設置動作家網絡的學習率為1e-4,評論家網絡的學習率為1e-3,獎勵衰減因子γ=1,表征決策目標為整個調度周期運行成本最小。

4.2 確定場景仿真結果分析

假設各園區的負荷和新能源出力可準確預測,基于預測值,可進行多園區協同優化,分別采取以下兩種方案作為對比:①集中優化方法(Centralized Optimization,CO),假設多園區綜合能源系統有一個共同的管理者,根據各個園區的數據和參數進行集中統一調度,所得結果作為第一個參考;②單獨優化方法(Individual Optimization,IO),假設園區之間不能進行能量交換,各園區只能與外部網絡進行能量交換,各園區單獨優化的結果可作為第二個參考。理論上集中優化的結果是最優的,但也忽略了系統的多利益主體特性,而單獨優化的結果運行成本最高。

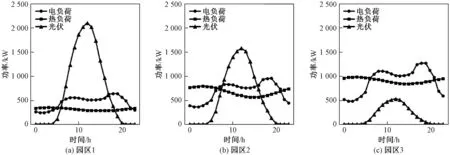

一個典型的場景如圖5所示,假設各個園區位置接近,各個園區新能源出力具有一定時空相關性,因此各個園區新能源出力曲線形狀相似,但幅值不同。又由于各個園區用能曲線不同,因此各個園區有不同的能量特征,例如園區1新能源發電量較高,但是電熱負荷水平比較低,園區3則相反。

圖5 典型場景下三個園區的新能源出力和電熱負荷曲線Fig.5 Renewable energy outputs and multi energy loads curves of three parks in typical scenario

MADDPG算法得到的三個園區獎勵總和的收斂曲線如圖6所示。分析收斂曲線可得,隨著訓練回合的增加,各園區之間的動作逐漸協調,經過10 000次訓練,三個園區獎勵總和逼近集中調度的最優值。三種方法在典型場景下得到的運行成本見表3。由結果可得,進行集中優化時,多園區系統總運行成本為26 418.3元,園區2的運行成本為8 488.0元;而在本文所提方法下多園區系統總運行成本為26 796.5元,園區2用能成本為8 293.9元。由此可見,集中優化雖然使得整個多園區系統的總運行成本更低,但其因為集中決策調度的特性而損傷了園區2的利益,而本文所提的求解方法可以實現各個園區的獨立自治,保護各個園區的利益。相比于各園區單獨優化,本文所提算法下各個園區的用能成本均有下降,其中園區1和園區3的用能成本下降比例較大,且園區1開始盈利,這是由于園區1新能源出力較高,在內部市場扮演售能者(能量提供者)的角色。園區3新能源出力較低,在內部市場扮演購能者(能量接收者)的角色,基于MADDPG的多園區協同優化運行既提高了售能者的收益,也降低了購能者的成本。

圖6 園區智能體獎勵總和的收斂曲線Fig.6 Convergence curve of total rewards of three parks

表3 典型場景下各園區運行成本統計Tab.3 Operation cost in typical scenario

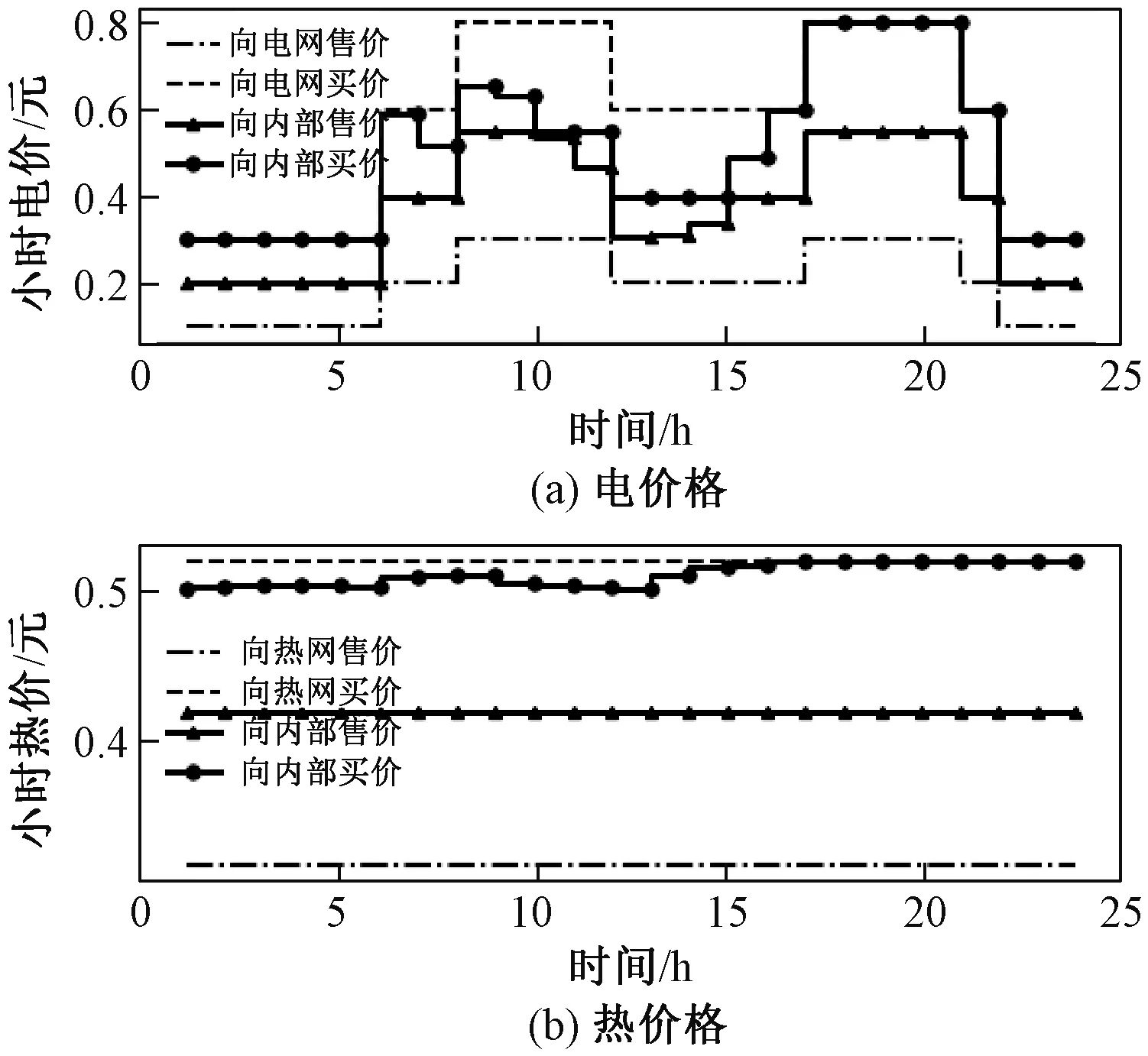

內部市場的價格出清結果如圖7所示,從出清曲線可得,內部熱能市場全天處于供不應求的狀態,內部電能市場在新能源高發時刻會出現短暫的供過于求狀態,其余時刻也處于供不應求狀態。

圖7 典型場景下內部市場價格出清曲線Fig.7 Clearing price curve of the internal market

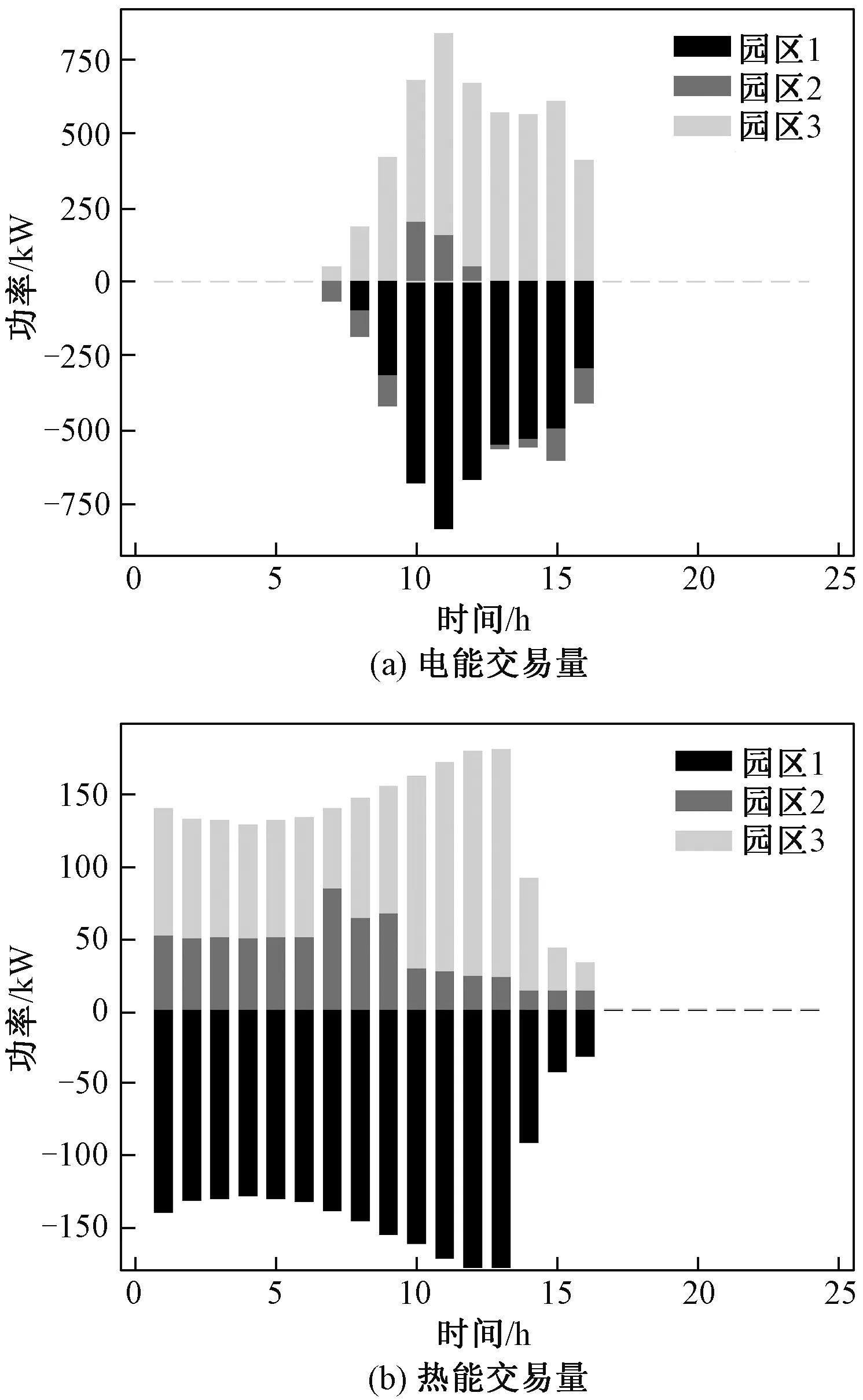

典型場景下各園區的能量交易量如圖8所示,由于園區1新能源發電量較多,因此其向內部市場售電量較多,且其熱負荷水平較低,因此園區1會在光伏高發時刻向其他園區出售多余的熱能,而園區3由于新能源發電量最少,其在內部市場主要是一個購能者。

圖8 典型場景下各園區能源交易量Fig.8 Energy trading of each park in typical scenario

4.3 不確定場景仿真結果分析

假設新能源出力、電熱負荷等不確定變量不能準確預測,本文建立的求解方法是否能夠實現多園區協同優化運行是本節研究的內容。為了刻畫新能源出力和負荷的不確定性,本文基于采樣的方式生成多種場景供模型訓練,并生成100個隨機測試場景測試模型的訓練效果。假設新能源和負荷的基準曲線為4.2節建立的典型場景,并以基準曲線為均值、以0.1倍的基準值為標準差采樣形成多種可能的場景。按照此方法生成園區1的100個測試場景如圖9所示,園區2和園區3按照相同的方法進行場景生成。

圖9 園區1的100個測試場景Fig.9 100 test scenarios of the first park

在不確定性場景測試中,本文建立了兩種對比算法:①基于新能源出力和負荷預測的集中優化(CO);②無預測信息下園區獨立運行的單時段最優算法(Short-Sight Individual Optimization,SSIO),即當新能源出力和負荷預測值未知時,單獨運行的園區只根據當前時段的實時信息做出單時段的最優調度,而不考慮整個調度周期最優。理論上三種優化方法得到的園區總運行成本關系為:基于新能源出力和負荷預測的集中優化<本文方法<園區獨立運行的單時段最優算法。

系統智能體獎勵總和的收斂曲線如圖10所示,隨著訓練次數的增加,各園區的動作逐漸協調,智能體獎勵總和逐漸收斂。100個測試場景的平均運行成本結果見表4,分析結果可得,在新能源出力和負荷信息未知的不確定性場景中,相比于各園區獨立運行,基于MADDPG算法的多園區協同運行可降低各個園區的運行成本,系統總成本降低比例為15.44%。需說明的是,基于新能源出力和負荷預測的集中優化需要對多重不確定量進行準確預測,而基于MADDPG的協同優化在不需要預測值的情況下可接近集中優化的結果,同時本文所提方法保證了多利益主體通過內部市場進行合理的收益分配。

圖10 不確定性場景下智能體獎勵總和的收斂曲線Fig.10 Total rewards convergence curves in uncertain scenarios

表4 100個測試場景下各園區平均運行成本統計Tab.4 Average operating cost under 100 test scenarios

5 結論

針對多園區綜合能源系統協同優化運行中面臨的缺乏多主體利益分配機制、隱私保護不足以及存在多重不確定量等問題,本文基于具有“集中訓練、分散執行”特點的MADDPG算法建立了求解架構進行求解。確定性和不確定性場景下的仿真結果均表明,該算法可保證多利益主體合理的收益分配,在保護園區隱私的前提下降低各園區的運行成本,同時該算法不依賴于對多重不確定量的預測,可應用于實時調度中。

本文針對不確定量的建模還存在一定不足,后續研究計劃則是研究如何基于真實歷史數據訓練模型;另外本文基于仿真空間進行離線訓練,相比于離線訓練,在線訓練不需要建立鏡像空間,但其常面臨安全性低、效率低以及通信負擔重等問題,因此后續工作將研究如何高效安全地實現在線訓練。