基于改進Mask R-CNN的鐵路扣件狀態檢測方法研究

白堂博 高嘉琳 楊建偉 許貴陽

1.北京建筑大學機電與車輛工程學院,北京100044;2.北京建筑大學城市軌道交通車輛服役性能保障北京市重點實驗室,北京100044

扣件是城市軌道中不可忽視的基礎部件,扣件狀態的準確智能化檢測對于保證軌道列車安全運行具有重要意義[1]。在列車運行過程中扣件容易出現移位、斷裂、丟失等問題。這些問題所產生的振動及噪聲十分微小,基于振動、噪聲信號分析的檢測方法處理難度大,檢測效果差[2]。

目前基于圖像采集與處理的扣件狀態檢測方法有流行排序方法[3]、十字交叉與特征測度方法[4]、引導濾波與積分投影方法[5]、垂向定位與灰度投影方法[6]、置信圖方法[7]等。這些方法優點是計算效率較高,但需要分別進行扣件的定位及扣件圖像特征的提取,并須根據特定的檢測對象進行算法修正,難以適應多變的現場情況。

近年來隨著目標檢測技術的發展,深度學習被應用于扣件狀態檢測。Guo等[8]提出基于YOLOv4(You Only Look Once v4)算法的扣件狀態檢測方法;龍炎[9]提出了基于Faster R-CNN(Faster Region-based Convolutional Neural Networks)算法的扣件狀態檢測方法;李兆洋等[10]建立了基于改進SSD(Single Shot Multibox Detector,SSD)算法的扣件定位方法。該類方法不用經過目標定位及圖像特征提取,可直接對圖像中的扣件區域進行檢測,但是該類方法重點在于檢出目標,對扣件斷裂及缺失檢測效果好,對扣件偏移的檢測效果較差。

針對這種情況,本文提出一種基于改進Mask R-CNN的鐵路扣件狀態檢測方法,首先利用Mask R-CNN方法實現扣件的位置檢測與扣件圖像分割,然后利用最小外接矩形法改進Mask R-CNN的輸出層,計算獲得扣件圖像角度信息,進而識別偏移扣件。

1 Mask R-CNN算法簡介

區域卷積神經網絡(R-CNN)是在經典深度學習算法卷積神經網絡(CNN)基礎上發展起來的,在圖像處理中具有較好的性能,被廣泛應用到目標檢測領域。R-CNN算法先通過搜索或者邊框檢測生成候選圖像區域,再將每個圖像區域視為一張待分類圖像輸入CNN進行網絡訓練和目標檢測。為了實現目標檢測,R-CNN算法須首先選定大量的候選圖像區域進行訓練,計算量太大,影響檢測效率。為解決這一問題,Fast R-CNN和Faster R-CNN相繼被提出,通過改變卷積次序和引入區域候選網絡減少了計算量,提高了計算效率。

掩膜區域卷積神經網絡(Mask R-CNN)[11]是在Faster R-CNN的基礎上改進而來的,增加了感興趣區域(Region of Interest,ROI)排列步驟和全卷積網絡,以實現圖像分割和目標提取。

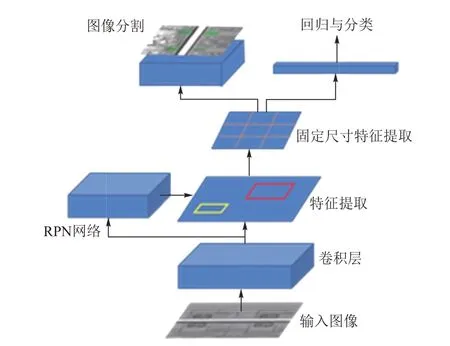

Mask R-CNN(圖1)主要分為特征提取、區域候選和結果輸出三大部分,輸出結果包括目標物體分類、目標檢測框回歸及目標圖像分割。在進行目標檢測時,系統會通過卷積網絡生成候選圖像區域并實現目標檢測。Mask R-CNN將原來的ROI池化改進為ROI排列,通過這一操作,特征圖被劃分為一定規格的二值掩膜圖,保證了像素輸入和輸出的對應關系,從而實現了Faster R-CNN所不具備的圖像分割功能。

圖1 Mask R-CNN結構

2 基于改進Mask R-CNN的鐵路扣件狀態檢測方法

2.1 設計思路及具體步驟

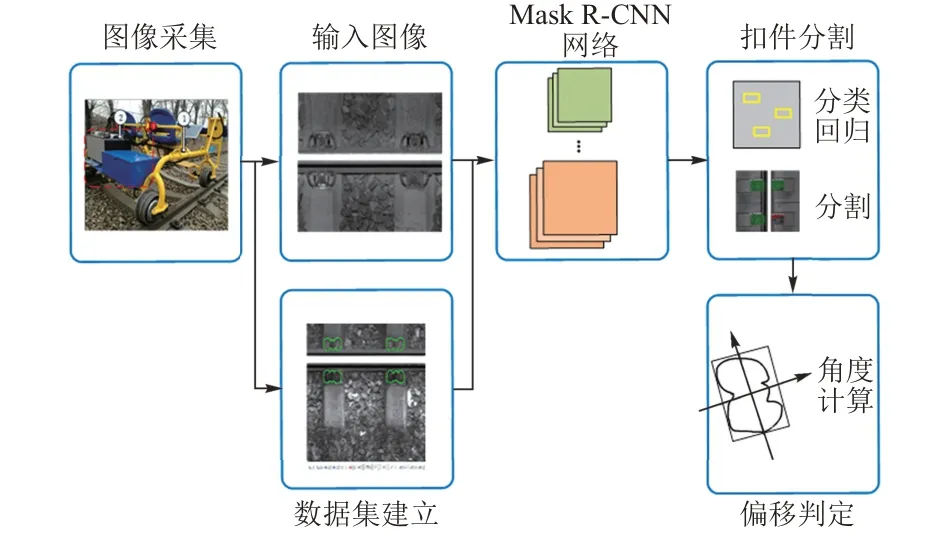

利用Mask R-CNN算法進行扣件狀態檢測時可將完整扣件與斷裂、丟失狀態的扣件分開,但正常扣件與偏移扣件同屬于完整扣件,分類時難以有效區分。本文根據Mask R-CNN具備目標物體圖像分割的特點,利用最小外接矩形法改進Mask R-CNN的輸出層,以實現偏移扣件的角度計算及狀態檢測。設計思路如圖2所示。具體步驟:首先進行現場試驗,完成圖像采集并建立數據集;然后利用Mask R-CNN將扣件中完整扣件和斷裂、丟失狀態的扣件進行初步分類;最后利用最小外接矩形法對Mask R-CNN的輸出層中完整扣件的分割圖像進行角度計算,以判斷其是否為偏移扣件。

圖2 本文方法的設計思路

2.2 基于最小外接矩形法的Mask R-CNN輸出層改進

最小外接矩形法[12]是一種獲取圖像中特定目標物體角度的方法。計算時將圖像中目標物體區域分割出來,并使目標物體區域在90°范圍內等角度旋轉,每次旋轉后,用一個水平外接矩形擬合其邊界。通過計算這一過程中得到的最小外接矩形特征參數即可得到物體角度等信息。

最小外接矩形法采用頂點鏈碼方法[12]對目標的最小外接矩形的幾何形狀特征參數進行計算,以得到目標偏轉角度。

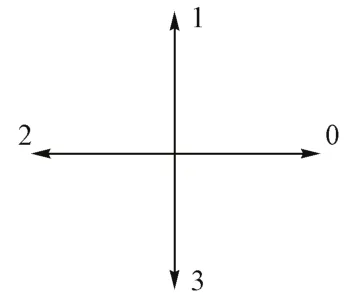

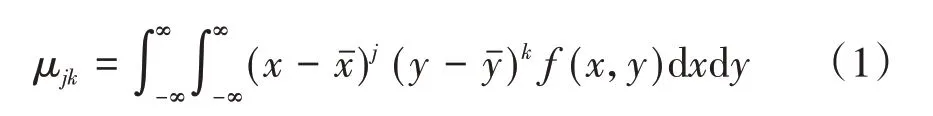

根據四方向頂點鏈碼方法,目標圖像頂點在旋轉過程中在4個步進方向0、1、2、3進行遍歷(圖3),得到圖像中目標物體邊界[12]f(x,y),然后利用該邊界求中心矩μjk,最終求得目標物體主軸與x軸的夾角α。μjk的計算公式為

圖3 四方向頂點鏈碼方法步進方向示意

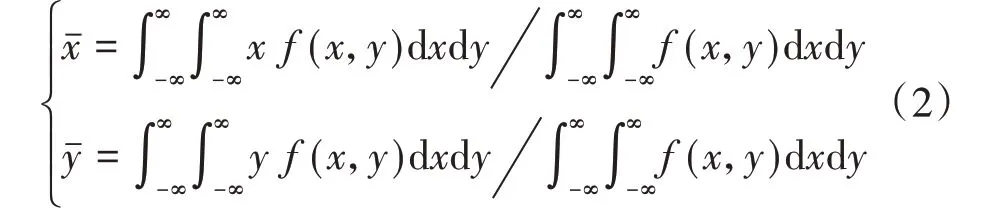

式中:j,k分別為目標物體邊界f(x,y)橫縱坐標的階次,j,k=0,1,2;xˉ和yˉ為目標物體質心橫縱坐標,其計算公式為

目標物體主軸與x軸的夾角α為

式中:μ11,μ20,μ02分別為目標圖像主軸方向、x軸方向和y軸方向上的二階中心矩,由式(1)計算得到。

利用最小外接矩形法改進Mask R-CNN的輸出層,可以在得到扣件分割圖像后直接輸出扣件角度信息。在該方法中,目標扣件邊界f(x,y)不需采用頂點鏈碼方法求取,只需通過Mask R-CNN算法中的ROI排列,直接獲取目標扣件分割區域并得出扣件邊界坐標,簡化了計算,提高了效率。

3 工程現場驗證

3.1 檢測設備

選取京滬高速鐵路上長15 km的軌道區間(其中無砟軌道約10.2 km,有砟軌道4.8 km)作為試驗段,對基于改進Mask R-CNN的扣件狀態檢測方法應用效果進行驗證。試驗采用的智能軌道巡檢車(圖4)由北京鷹路科技有限公司研發,該車分為電動巡檢車和軌道狀態巡檢系統兩部分。電動巡檢車由車體、軌道輪和座椅組成;軌道狀態巡檢系統由主機和高清線陣圖像掃描模塊組成。采集軌道圖像時巡檢車運行速度為20 km/h,圖像分辨率為2 048×2 048。

圖4 智能軌道巡檢車

3.2 圖像采集與處理

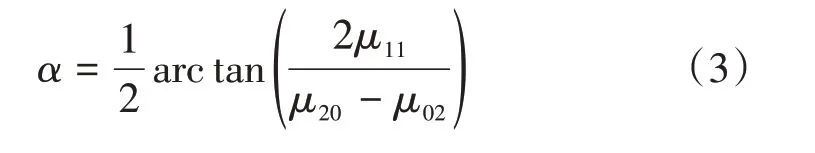

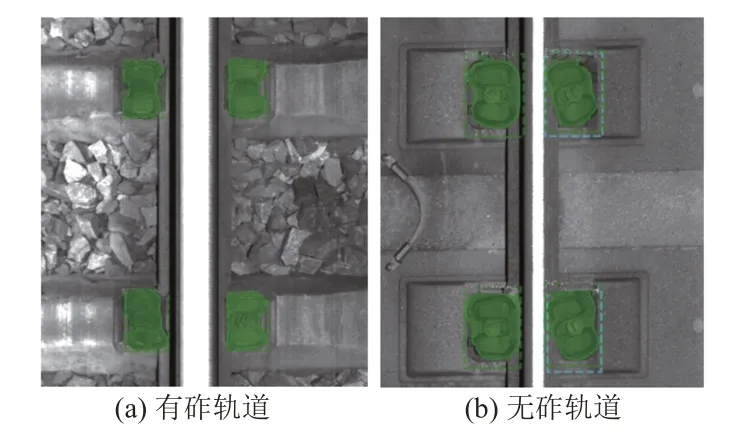

本次檢測中獲得的軌道圖像分有砟軌道和無砟軌道兩種,見圖5。扣件狀態檢測算法運行所采用的關鍵硬件中GPU為NVIDIA RTX2080,CPU為Intel i7 9700,內存為16 GB。算法運行平臺為Windows 10,算法運行所需軟件包括Tensorflow 1.6,Python 3.6.5,CUDA 10.0,CUDNN 10.0。

圖5 軌道圖像

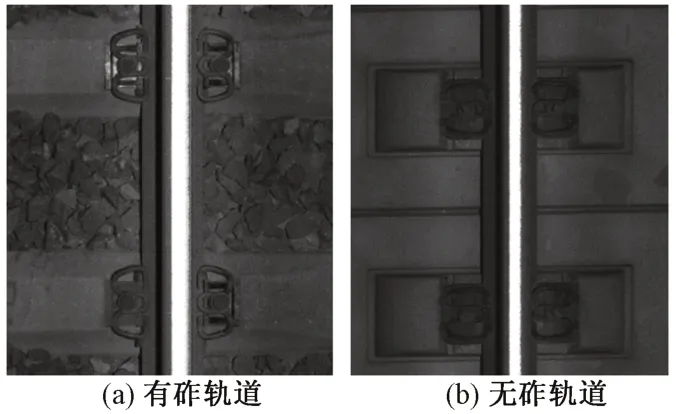

選用現場采集的1 000張軌道圖像(其中無砟軌道600張,有砟軌道400張)進行扣件狀態檢測分析,隨機選取500張作為訓練集,其余500張作為測試集。測試前需要進行圖像標注以建立訓練集特征信息庫。采用LABELME軟件進行訓練集圖像標注(圖6),將圖像中的扣件區域作為目標檢測區域。

圖6 圖像標注

根據訓練集圖像標注生成的扣件邊界坐標數據集進行算法訓練。

3.3 檢測結果與分析

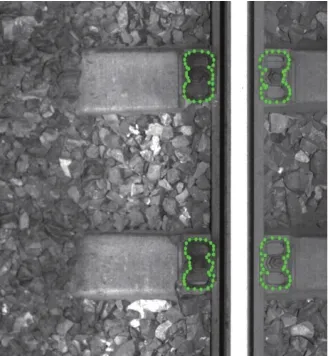

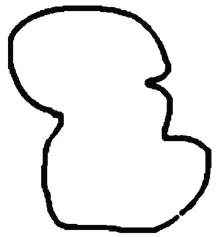

將測試集圖像輸入到改進的Mask R-CNN,得到扣件區域的分割結果,見圖7。可見,改進的Mask R-CNN能夠檢測出圖像中扣件位置并進行分割,對所分割的扣件區域進行預處理,包括去除邊界外部信息、去除噪聲、濾波、二值化,最終提取出扣件邊界,見圖8。

圖7 扣件位置檢測及分割結果

圖8 扣件邊界提取

根據提取出的扣件邊界數據,構造扣件邊界函數f(x,y),將該邊界函數代入式(1)—式(3),即可得到扣件偏移角度。以圖8中扣件為例,經計算得到該扣件主軸與軌道方向的偏移角度(即夾角α)為-15.28°。根據工程經驗,夾角超過±10°即可判定為扣件偏移,因此該扣件被判定處于偏移狀態。

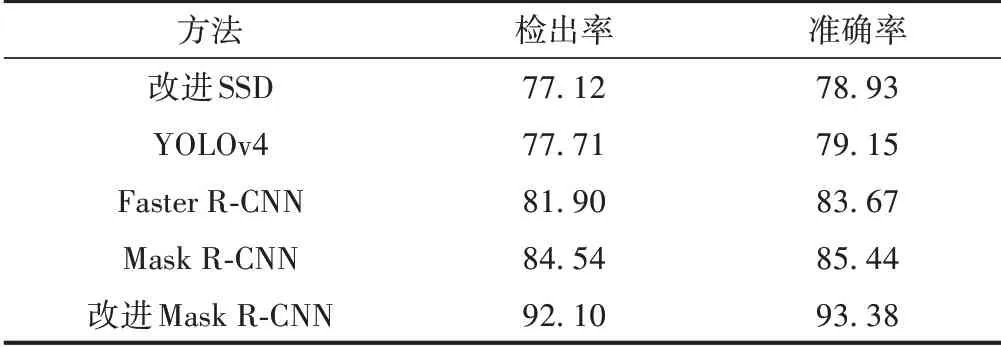

基于改進Mask R-CNN的扣件狀態檢測方法與其他基于深度學習的扣件狀態檢測方法對偏移扣件的檢測結果對比見表1。其中,檢出率為正確檢出扣件占所有待檢測扣件的百分比,準確率為正確檢出扣件占所有檢出扣件的百分比。可見,本文提出的改進Mask R-CNN扣件狀態檢測方法的檢出率和準確率均高于其他方法。該方法對扣件角度進行計算,可有效判定扣件偏移狀態,提高偏移扣件的檢出率和準確率。

表1 偏移扣件檢測結果對比 %

4 結論

針對軌道扣件狀態檢測中偏移扣件檢測難的問題,提出了基于改進Mask R-CNN的扣件狀態檢測方法。該檢測方法可以有效檢測出圖像中扣件的位置并進行分割,分割后的扣件圖像經預處理和計算后可直接獲得扣件偏移角度,進而實現對扣件偏移狀態的判定。經在京滬高速鐵路試驗段現場測試,該檢測方法能夠對偏移扣件進行有效檢測,并且檢出率和準確率均較高。