基于多頭注意力循環(huán)卷積神經(jīng)網(wǎng)絡(luò)的電力設(shè)備缺陷文本分類(lèi)方法

陸世豪,祝云,周振茂

(1.廣西電力系統(tǒng)最優(yōu)化與節(jié)能技術(shù)重點(diǎn)實(shí)驗(yàn)室 (廣西大學(xué)),廣西 南寧 530004;2.廣西電網(wǎng)有限責(zé)任公司來(lái)賓供電局,廣西 來(lái)賓 546100)

電力設(shè)備巡檢是保障電力系統(tǒng)安全運(yùn)行的重要舉措。巡檢發(fā)現(xiàn)的設(shè)備缺陷將被記錄到缺陷管理系統(tǒng),包括缺陷發(fā)現(xiàn)時(shí)間、缺陷描述、缺陷等級(jí)等。判斷設(shè)備缺陷等級(jí)是消缺的前提,根據(jù)電網(wǎng)公司設(shè)備缺陷分類(lèi)標(biāo)準(zhǔn)[1],將設(shè)備缺陷按嚴(yán)重程度分為緊急缺陷、重大缺陷和一般缺陷,不同等級(jí)的缺陷消除時(shí)限也不同,目前缺陷分類(lèi)工作主要由人工完成。隨著電力系統(tǒng)的規(guī)模越來(lái)越龐大,設(shè)備的數(shù)量成倍增長(zhǎng),極大地增加了巡檢工作量。同時(shí)隨著設(shè)備運(yùn)行時(shí)間推移和操作頻次增加,加大了設(shè)備缺陷的出現(xiàn)幾率。如果巡檢人員的知識(shí)和經(jīng)驗(yàn)不足,很容易對(duì)設(shè)備缺陷等級(jí)產(chǎn)生誤判,影響消缺的時(shí)間和效果。因此,快速、準(zhǔn)確地將設(shè)備缺陷進(jìn)行分類(lèi)對(duì)電網(wǎng)安全運(yùn)行具有重要意義。

電網(wǎng)缺陷管理系統(tǒng)中存在大量已經(jīng)消缺的歷史缺陷記錄,其中的缺陷描述包含缺陷的具體信息,若使用歷史缺陷描述將新缺陷自動(dòng)分類(lèi),不僅能提高電力系統(tǒng)信息資源利用率,還可降低人工分類(lèi)的工作量。

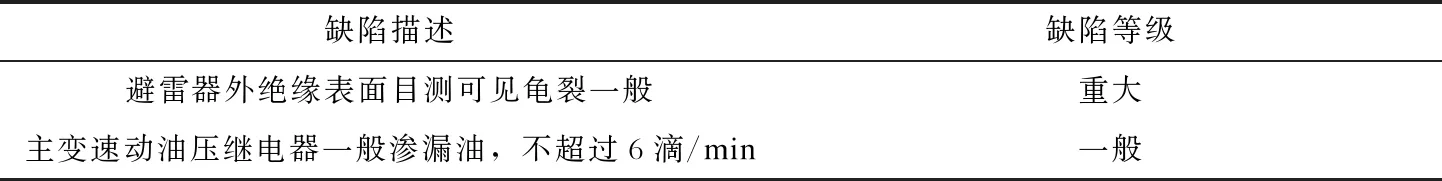

電力設(shè)備缺陷描述文本涉及電力專(zhuān)業(yè)領(lǐng)域,與許多日常的中文文本存在不同。首先,每個(gè)人的用語(yǔ)習(xí)慣不同,描述上存在差異,對(duì)同一裝置或者缺陷會(huì)出現(xiàn)不同表達(dá);其次,存在相同詞在不同缺陷描述中表達(dá)嚴(yán)重程度不同的情況,例如表1中的加粗詞語(yǔ)在不同缺陷情況描述中所表達(dá)的程度不同;最后,缺陷描述一般會(huì)記錄缺陷現(xiàn)象、數(shù)據(jù)、故障推斷等。這類(lèi)描述的內(nèi)容較多,語(yǔ)義較為復(fù)雜,需要結(jié)合上下文理解語(yǔ)義,關(guān)注文中重要信息才能正確判斷。

表1 缺陷描述例句Tab.1 Example sentences of defect descriptions

隨著自然語(yǔ)言處理技術(shù)的高速發(fā)展,文本挖掘技術(shù)從早期的貝葉斯、支持向量機(jī)等淺層學(xué)習(xí)算法轉(zhuǎn)向卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural network,CNN)、記憶網(wǎng)絡(luò)等深度學(xué)習(xí)算法。文獻(xiàn)[2]對(duì)大量的設(shè)備缺陷文本進(jìn)行分析,通過(guò)機(jī)器學(xué)習(xí)實(shí)現(xiàn)電力設(shè)備故障預(yù)測(cè)以及系統(tǒng)風(fēng)險(xiǎn)評(píng)估。由于中文沒(méi)有空格分詞,也沒(méi)有固定的句法結(jié)構(gòu),因此中文的理解難度遠(yuǎn)大于英文,這也加大了在工業(yè)應(yīng)用的難度。目前,國(guó)內(nèi)電力自然語(yǔ)言處理還屬于探索階段。文獻(xiàn)[3]利用文本挖掘模型輔助電力操作票校驗(yàn),提升操作票校驗(yàn)的效率和準(zhǔn)確性。文獻(xiàn)[4]采用CNN對(duì)電力設(shè)備缺陷描述短句文本分類(lèi),相比起傳統(tǒng)機(jī)器學(xué)習(xí)分類(lèi)方法能有效降低分類(lèi)錯(cuò)誤率,但是CNN是通過(guò)增強(qiáng)局部感知來(lái)獲取文本特征,并不能學(xué)習(xí)上下文語(yǔ)義,從而影響分類(lèi)準(zhǔn)確度。文獻(xiàn)[5]使用雙向長(zhǎng)短期記憶網(wǎng)絡(luò)(bidirectional long short-term memory,Bi-LSTM)模型根據(jù)因果關(guān)系對(duì)電力設(shè)備缺陷句子進(jìn)行分類(lèi),為故障文本下一步挖掘提供條件。文獻(xiàn)[6]將循環(huán)卷積神經(jīng)網(wǎng)絡(luò)(recurrent convolutional neural networks,RCNN)分類(lèi)模型用于電力變壓器缺陷文本分類(lèi)中。RCNN網(wǎng)絡(luò)由RNN和CNN兩種網(wǎng)絡(luò)結(jié)合而成,RNN網(wǎng)絡(luò)用于處理順序敏感的序列問(wèn)題,但存在選擇性遺忘信息的不足,隨著時(shí)間步長(zhǎng)的更新會(huì)造成重要信息丟失,并且通過(guò)最大池化層提取特征的方法不具備選擇關(guān)注重要單詞的能力。

注意力機(jī)制(attention mechanism)最早起源于視覺(jué)領(lǐng)域研究。注意力機(jī)制按人類(lèi)視覺(jué)機(jī)制理解就是,人類(lèi)的視覺(jué)系統(tǒng)一般會(huì)傾向于關(guān)注圖像的重要部分,并且忽略無(wú)關(guān)信息[7]。同樣,人們?cè)陂喿x一段文字時(shí),也會(huì)根據(jù)經(jīng)驗(yàn)捕捉重要信息。2017年Google將注意力機(jī)制應(yīng)用到機(jī)器翻譯當(dāng)中,并將注意力機(jī)制進(jìn)行完善,提出基于多頭注意力(multi-head attention,MAT)機(jī)制的翻譯模型Transformer[8],Transformer打破了傳統(tǒng)翻譯模型基于RNN端到端的框架,在編碼過(guò)程和解碼過(guò)程完全使用多頭注意力機(jī)制,通過(guò)在不同子空間下進(jìn)行自注意力(self-attention)計(jì)算挖掘詞與詞內(nèi)部聯(lián)系,使得機(jī)器能夠?qū)W習(xí)到長(zhǎng)距離依賴關(guān)系,并選擇性的關(guān)注重要信息。

為探索深度學(xué)習(xí)文本分類(lèi)模型在電力文本識(shí)別中應(yīng)用,對(duì)電力設(shè)備缺陷描述文本進(jìn)行研究。根據(jù)缺陷描述文本的特點(diǎn),將多頭注意力機(jī)制與RCNN結(jié)合,構(gòu)建基于多頭注意力循環(huán)卷積神經(jīng)網(wǎng)絡(luò)(MAT-RCNN)的電力設(shè)備缺陷描述文本分類(lèi)模型,并通過(guò)實(shí)例顯示本文所提模型較傳統(tǒng)的淺層分類(lèi)模型、深度學(xué)習(xí)分類(lèi)模型在電力設(shè)備缺陷描述文本分類(lèi)性能上表現(xiàn)更佳。

1 預(yù)訓(xùn)練語(yǔ)言模型

1.1 文本預(yù)處理

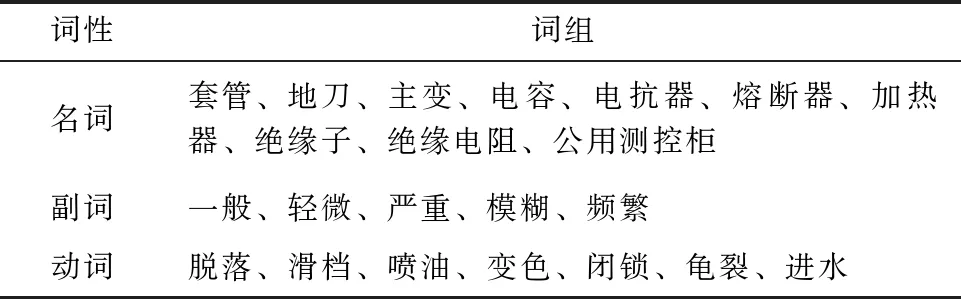

a)中文分詞。中文文本和英文文本的不同在于中文每個(gè)詞之間沒(méi)有空格分隔,所以需要對(duì)文本分詞處理。缺陷描述文本中有許多電氣領(lǐng)域?qū)S忻~,為了提升分詞的準(zhǔn)確性,根據(jù)缺陷設(shè)備定級(jí)標(biāo)準(zhǔn)手冊(cè)與缺陷描述文本實(shí)際,自行建立電力缺陷描述詞典,見(jiàn)表2。

表2 電氣缺陷描述部分詞匯Tab.2 Vocabularies of electrical defect descriptions

采用基于漢字成詞能力的隱馬爾可夫模型(hidden Markov model,HMM)并結(jié)合Viterbi算法[9]動(dòng)態(tài)求解最佳的分詞序列,通過(guò)建立詞典保證電力專(zhuān)有名詞切分的正確性。

b)去停用詞。為了避免將無(wú)用詞作為特征,影響文本處理效率。對(duì)于無(wú)法體現(xiàn)設(shè)備缺陷嚴(yán)重程度的詞,如人名、變電站名稱(chēng)、地名等,通過(guò)建立停用詞表,在分詞后利用二叉搜索樹(shù)將缺陷描述中的停用詞剔除。

1.2 分布式文本表示

預(yù)處理后的文本并不能直接被任何分類(lèi)器所識(shí)別,必須將其轉(zhuǎn)換成為一個(gè)簡(jiǎn)潔的、統(tǒng)一的、能夠被學(xué)習(xí)算法和分類(lèi)器所識(shí)別的形式,才能進(jìn)一步分析和處理。傳統(tǒng)分類(lèi)模型采用句向量[10]表示文本,通過(guò)詞頻、布爾值等計(jì)算方法獲得權(quán)重。但是這種基于詞頻計(jì)算的表達(dá)方式并不能很好地表達(dá)句子語(yǔ)義,例如“電機(jī)表面溫度>120 ℃”和“120 ℃>電機(jī)表面溫度”在句義上完全不同,但是傳統(tǒng)表示方法會(huì)將其表示為相同的句向量。并且傳統(tǒng)方法將每個(gè)單詞獨(dú)立化,這就無(wú)法體現(xiàn)詞語(yǔ)的相關(guān)性,例如 “視窗鏡 破裂”與“視窗鏡 破損”等,會(huì)被表示為不同詞組。

Word2vec[11-12]是Google提出來(lái)的一種文本分布式表示方法,通過(guò)運(yùn)用層次Softmax[13]和負(fù)采樣2種方式,可以無(wú)監(jiān)督地深度學(xué)習(xí)語(yǔ)義信息,并生成表征語(yǔ)義的低維度稠密詞向量。這種方法在近義詞描述、語(yǔ)義表達(dá)以及詞之間關(guān)聯(lián)度方面要優(yōu)于傳統(tǒng)方法。

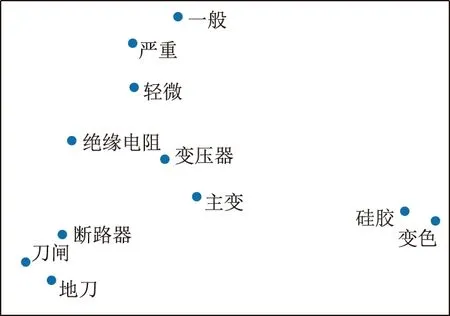

本文采用Word2vec中連續(xù)詞袋(continuous bag-of-words,CBOW)模型,CBOW模型是通過(guò)上下文的詞語(yǔ)預(yù)測(cè)中間的詞,從而得到中間詞的向量。以預(yù)處理后的電力缺陷描述作為語(yǔ)料,訓(xùn)練出每個(gè)詞的向量表示,選取部分詞向量通過(guò)t分布隨機(jī)鄰域嵌入(t-distributed stochastic neighbor embedding,T-SNE)降至二維空間展示,如圖1所示。

圖1每個(gè)點(diǎn)代表每個(gè)詞所對(duì)應(yīng)的詞向量,語(yǔ)義相近的單詞如“地刀”和“刀閘”、“主變”和“變壓器”在二維空間圖上距離較近。語(yǔ)義相差較大的單詞如“硅膠”與“斷路器”二者距離相差較遠(yuǎn)。由此可見(jiàn),訓(xùn)練的詞向量能在一定程度上刻畫(huà)出詞之間的語(yǔ)義距離。根據(jù)電力設(shè)備用語(yǔ)規(guī)范[14]將同義詞向量進(jìn)行合并,語(yǔ)義存在差別的近義詞向量不合并。

圖1 二維空間的詞向量Fig.1 Word vector in two-dimensional space

2 MAT-RCNN網(wǎng)絡(luò)分類(lèi)模型

2.1 多頭注意力機(jī)制

注意力機(jī)制本質(zhì)上是一個(gè)查詢(query)到一系列鍵-值對(duì)

(1)

與傳統(tǒng)注意力機(jī)制不同,多頭注意力機(jī)制進(jìn)行了多次注意力計(jì)算,從而能在不同子空間表示中多維度學(xué)習(xí)序列的關(guān)鍵信息,其結(jié)構(gòu)如圖2所示。

h—多頭注意力頭數(shù)即注意力運(yùn)算次數(shù);X—輸入文本矩陣。圖2 多頭注意力結(jié)構(gòu)Fig.2 Multi-head attention structure

首先,對(duì)輸入矩陣X進(jìn)行線性變換;然后,輸入到縮放點(diǎn)積注意力函數(shù)中,重復(fù)h次;最后將所有的注意力值進(jìn)行拼接處理,并進(jìn)行線性變換。

ti=fA(XWiQ,XWiK,XWiV),

(2)

T=[t1…th]WO.

(3)

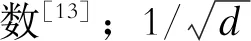

2.2 GRU結(jié)構(gòu)

門(mén)控循環(huán)單元(gated recurrent unit,GRU)是LSTM的一種變體,適用于分析時(shí)間序列數(shù)據(jù)[15-16],其結(jié)構(gòu)如圖3所示。GRU將LSTM中的輸入門(mén)和遺忘門(mén)合并成更新門(mén),相比LSTM的三門(mén)結(jié)構(gòu),GRU的兩門(mén)結(jié)構(gòu)參數(shù)更少;因此,在保證效果的同時(shí)簡(jiǎn)化內(nèi)部結(jié)構(gòu),縮短訓(xùn)練時(shí)長(zhǎng)。

圖3 GRU結(jié)構(gòu)Fig.3 GRU structure

rt=σ(Wr·[ht-1,xt]),

(4)

zt=σ(Wz·[ht-1,xt]),

(5)

(6)

(7)

式(4)—(7)中:Wz、Wr、W為權(quán)重矩陣;E為單位向量;[…,…]表示2個(gè)向量的拼接;“·”表示矩陣相乘。

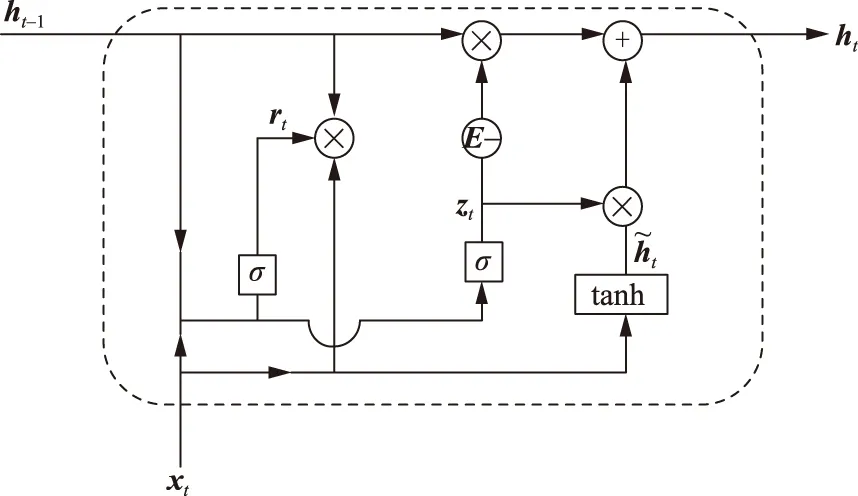

2.3 MAT-RCNN網(wǎng)絡(luò)模型

本文根據(jù)多頭注意力機(jī)制和RCNN的特點(diǎn),提出一種MAT-RCNN分類(lèi)模型,模型由輸入層、注意力層、RCNN層、輸出層組成,模型架構(gòu)如圖4所示。

圖4 MAT-RCNN模型架構(gòu)Fig.4 MAT-RCNN model structure

a)輸入層。將預(yù)訓(xùn)練的Word2vec詞向量輸送到文本詞嵌入層,可將句子變換成可以被神經(jīng)網(wǎng)絡(luò)處理的文本矩陣。

以最長(zhǎng)文本長(zhǎng)度L作為模型輸入大小,文本長(zhǎng)度不足的使用零填充。句子中第i個(gè)詞向量表示為ci(1≤i≤L),得到L×d的文本矩陣

(8)

b)注意力層。按照2.1節(jié)計(jì)算出多頭注意力T,將輸入矩陣D與T進(jìn)行殘差連接,歸一化后輸出文本矩陣:

D′1=fRC(D,T),

(9)

D1=fLN(D′1).

(10)

式(9)、(10)中:輸出矩陣D1∈RL×d;fRC為殘差連接操作[8];fLN為層歸一化操作[8]。

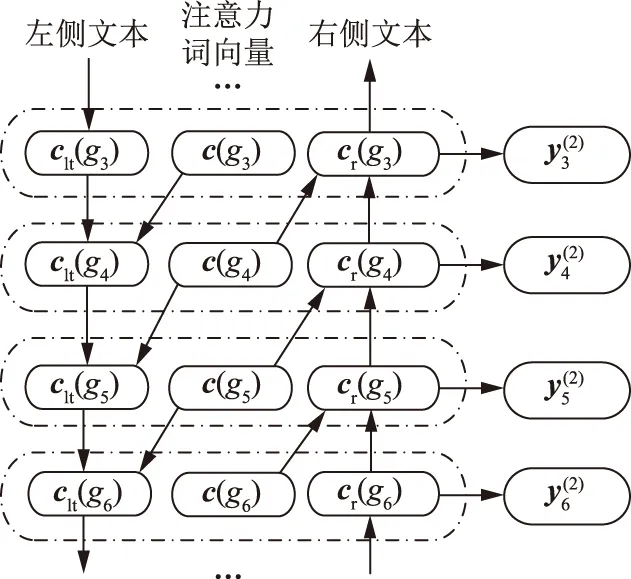

c)RCNN層。注意力層輸出的文本矩陣需要RCNN進(jìn)一步提取特征。單向GRU網(wǎng)絡(luò)對(duì)全文信息學(xué)習(xí)能力較弱,因此采用雙向GRU網(wǎng)絡(luò)(Bi-GRU)對(duì)文本序列學(xué)習(xí),進(jìn)一步提取特征,如圖5所示。

圖5 Bi-GRU示意圖Fig.5 Bi-GRU structure

Bi-GRU網(wǎng)絡(luò)由2層GRU網(wǎng)絡(luò)和注意力層輸出組成,左右使用GRU網(wǎng)絡(luò)分別學(xué)習(xí)當(dāng)前詞gi的左上下文表示clt(gi)和右上下文表示cr(gi),再與當(dāng)前詞的注意力詞向量c(gi)∈D1連接,構(gòu)成后續(xù)卷積層的輸入xi:

(11)

(12)

xi=[clt(gi),c(gi),cr(gi)].

(13)

卷積部分使用列數(shù)與xi相同,行數(shù)為1的卷積核W(2)∈R1×3d,步長(zhǎng)為1,激活函數(shù)為tanh,將Bi-GRU網(wǎng)絡(luò)的輸出通過(guò)卷積層進(jìn)行卷積運(yùn)算得到卷積結(jié)果

(14)

與文獻(xiàn)[6]采用的池化層不同,本模型的池化層采用全局平均池化 (global average pooling,GAP)[17],卷積結(jié)果送入池化層進(jìn)行特征采樣。通過(guò)GAP采樣得到特征信息y(3)∈R3d。

d)輸出層。將最終提取的特征向量y(3)傳遞到輸出層。采用Softmax函數(shù)計(jì)算每類(lèi)概率Pi,根據(jù)概率最大值確定文本所屬類(lèi)別。訓(xùn)練時(shí)采用隨機(jī)失活率(dropout)機(jī)制與L2正則化提高模型泛化能力[18]。

優(yōu)化算法采用自適應(yīng)矩估計(jì)法(adaptive moment estimation,ADAM)對(duì)隨機(jī)目標(biāo)函數(shù)執(zhí)行一階梯度優(yōu)化。模型的目標(biāo)函數(shù)為交叉熵?fù)p失函數(shù)

(15)

式中:N為類(lèi)別個(gè)數(shù);Pi為預(yù)測(cè)類(lèi)別的概率分布;yi為樣本類(lèi)別真實(shí)分布。

3 算例分析

3.1 樣本情況與分類(lèi)評(píng)價(jià)指標(biāo)

為研究本文模型對(duì)電力設(shè)備缺陷文本的分類(lèi)效果,選取廣西電網(wǎng)缺陷管理系統(tǒng)2016至2019年的2 150條一次設(shè)備缺陷描述文本進(jìn)行研究,文本均已全部標(biāo)注缺陷等級(jí),并逐條核對(duì)。隨機(jī)選取215條數(shù)據(jù)作為測(cè)試集,其余數(shù)據(jù)平均分為5份,每份387條數(shù)據(jù),4份為訓(xùn)練數(shù)據(jù),1份為驗(yàn)證數(shù)據(jù),進(jìn)行5次交叉驗(yàn)證,以測(cè)試集結(jié)果作為模型的最終評(píng)價(jià)。

在二分類(lèi)問(wèn)題中常采用評(píng)價(jià)指標(biāo)為

(16)

式中:準(zhǔn)確率為P=Tp/(Tp+Fp);TP為正例中預(yù)測(cè)正確的部分,F(xiàn)P為負(fù)例中預(yù)測(cè)正確的部分;召回率為R=Tp/(Tp+FN),F(xiàn)N為正例中預(yù)測(cè)錯(cuò)誤的部分。

由于電力缺陷文本分類(lèi)可分為3個(gè)缺陷等級(jí),因此屬于多分類(lèi)問(wèn)題,為了綜合評(píng)價(jià)模型對(duì)每類(lèi)的分類(lèi)情況,采用宏平均綜合指標(biāo)[5-6]

(17)

式中宏準(zhǔn)確率MP、宏召回率MR定義如下:

(18)

式中n為分類(lèi)類(lèi)別個(gè)數(shù)。

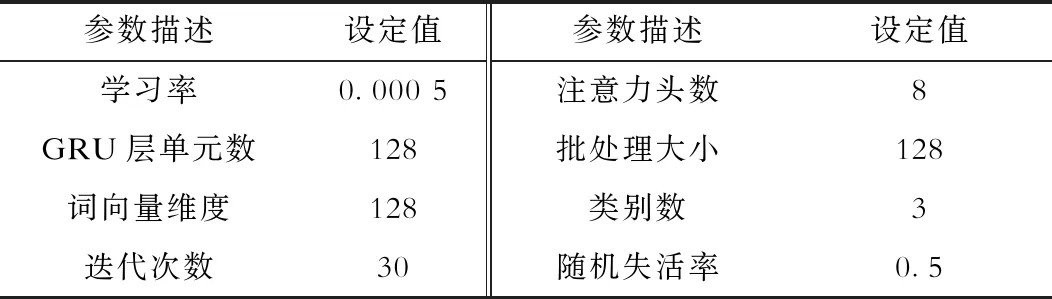

3.2 實(shí)驗(yàn)條件及參數(shù)設(shè)置

本文的實(shí)驗(yàn)環(huán)境:CPU為 Intel Core i7-8550U,具有4個(gè)處理核心;主頻1.8 GHz;編程語(yǔ)言為Python;模型開(kāi)發(fā)架構(gòu)為T(mén)ensorflow。模型經(jīng)過(guò)調(diào)參后,具體參數(shù)見(jiàn)表3。

表3 模型參數(shù)設(shè)置Tab.3 Model parameter setting

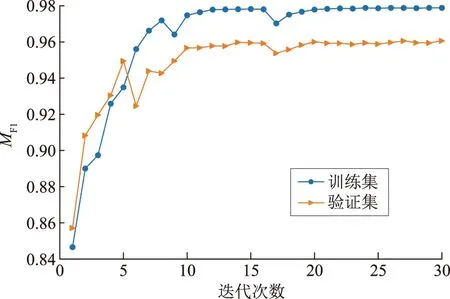

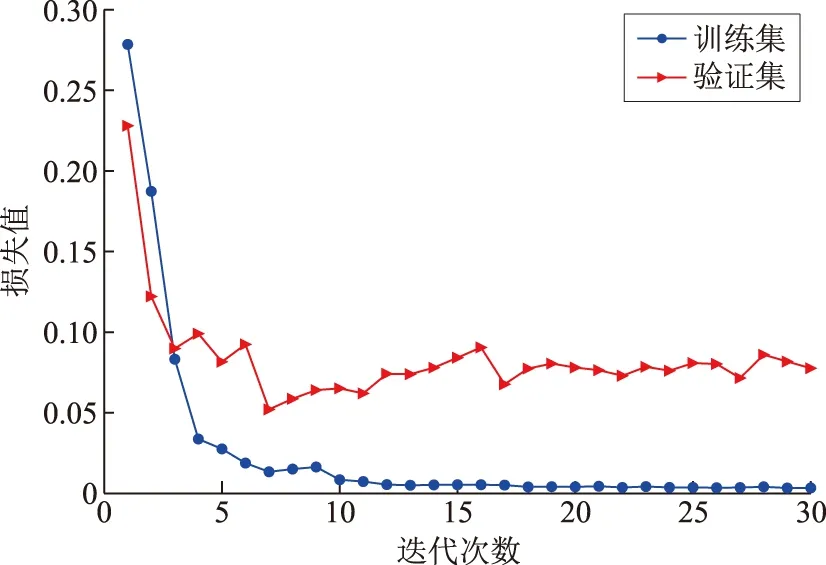

模型評(píng)價(jià)指標(biāo)(MF1)如圖6所示,損失值(fLoss)曲線如圖7所示。由圖6、圖7可見(jiàn),隨著迭代次數(shù)增加,訓(xùn)練過(guò)程趨于平穩(wěn),模型的評(píng)價(jià)指標(biāo)與損失值均趨于收斂。當(dāng)?shù)螖?shù)達(dá)到30時(shí),訓(xùn)練集MF1=97.88%,驗(yàn)證集MF1=95.91%。

圖6 訓(xùn)練評(píng)價(jià)指標(biāo)曲線Fig.7 Training evaluation index curves

圖7 訓(xùn)練損失值曲線Fig.7 Training loss value curves

3.3 實(shí)驗(yàn)結(jié)果及分析

3.3.1 多頭注意力超參數(shù)取值研究

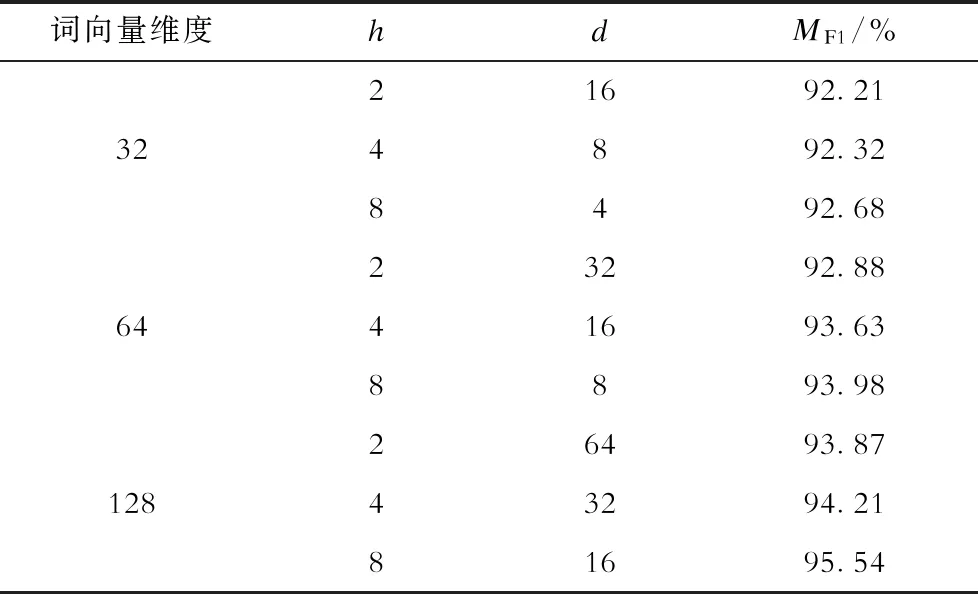

表4 不同參數(shù)實(shí)驗(yàn)結(jié)果Tab.4 Experimental results of different parameters

可見(jiàn),當(dāng)維度相同時(shí),隨著頭數(shù)h增加,模型的分類(lèi)效果越好,這也說(shuō)明了多頭注意力的優(yōu)點(diǎn),通過(guò)增加頭數(shù)h數(shù)量,模型可從多個(gè)方面考慮文本序列內(nèi)部信息,深度學(xué)習(xí)文本語(yǔ)義特征,從而提升模型性能。

3.3.2 注意力可視化

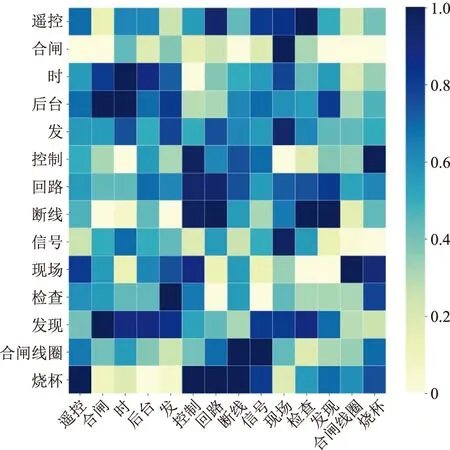

多頭注意力機(jī)制可通過(guò)學(xué)習(xí)缺陷文本內(nèi)所有詞之間聯(lián)系,以分配不同詞語(yǔ)相應(yīng)權(quán)重的方式自動(dòng)捕獲重要信息,將這些權(quán)重進(jìn)行可視化操作來(lái)體現(xiàn)注意力機(jī)制的有效性[19-20]。以“遙控合閘時(shí)后臺(tái)發(fā)控制回路斷線信號(hào)現(xiàn)場(chǎng)檢查發(fā)現(xiàn)合閘線圈燒壞”為例,輸出某一子空間的注意力矩陣,其注意力分布如圖8所示。

圖8 注意力可視化結(jié)果Fig.8 Visualization result of attention mechanism

圖8中縱坐標(biāo)為方面詞,橫坐標(biāo)為文本單詞,色塊的深淺代表兩詞之間的關(guān)聯(lián)程度,關(guān)聯(lián)性越強(qiáng)獲得的權(quán)重也越大,同時(shí)注意力對(duì)這類(lèi)信息的關(guān)注程度越高。

對(duì)缺陷分析可知,由于合閘線圈燒壞導(dǎo)致合閘回路斷線,后臺(tái)才發(fā)出控制回路斷線信號(hào)。因此,合閘線圈燒壞與控制回路斷線信號(hào)之間存在內(nèi)在聯(lián)系。圖8中方面詞“合閘線圈”向量中,“回路 斷線 信號(hào)”以及“燒壞”所對(duì)應(yīng)色塊很深,說(shuō)明注意力關(guān)注到了“回路 斷線 信號(hào)”,并且捕捉到與“燒壞”這個(gè)狀態(tài)詞;同樣,方面詞“燒壞”向量中,“遙控”以及“控制 回路 斷線 信號(hào)”對(duì)應(yīng)的色塊很深,說(shuō)明這些信息和方面詞之間有很強(qiáng)的關(guān)聯(lián)度。在2個(gè)方面詞中都同時(shí)關(guān)注到了“控制 回路 斷線 信號(hào)”這個(gè)關(guān)聯(lián)信息,但對(duì)應(yīng)的其余部分顏色相對(duì)較淺,說(shuō)明注意力對(duì)其余部分并未過(guò)多關(guān)注。

3.3.3 與傳統(tǒng)模型分類(lèi)效果對(duì)比實(shí)驗(yàn)

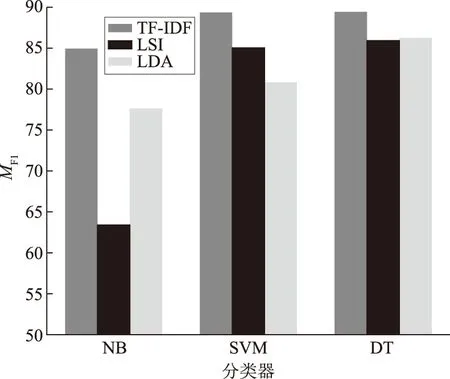

為對(duì)比本文模型與傳統(tǒng)文本分類(lèi)模型分類(lèi)效果,分別選取詞頻與逆文檔頻率 (term frequency-inverse document frequency,TF-IDF)、潛在語(yǔ)義索引(latent semantic indexing,LSI)、隱含狄利克雷分布主題模型(latent Dirichlet allocation,LDA)3種特征提取方法。分類(lèi)器選擇樸素貝葉斯(naive Bayesian,NB)、支持向量機(jī)(support vector machine,SVM)、決策樹(shù)(decision tree,DT)。實(shí)驗(yàn)結(jié)果如圖9所示。

圖9 傳統(tǒng)文本分類(lèi)模型實(shí)驗(yàn)結(jié)果Fig.9 Experimental results of traditional text classification models

從表4和圖9分析可知本文模型在分類(lèi)效果上優(yōu)于傳統(tǒng)分類(lèi)模型。因?yàn)閭鹘y(tǒng)分類(lèi)模型的特征提取方法假設(shè)每個(gè)詞之間是相互獨(dú)立,因此無(wú)法學(xué)習(xí)詞之間的關(guān)聯(lián)信息,所采用的分類(lèi)器僅能淺層分析文本語(yǔ)義。而深度學(xué)習(xí)模型可以無(wú)監(jiān)督地學(xué)習(xí)詞之間的相關(guān)度,利用神經(jīng)網(wǎng)絡(luò)進(jìn)一步提取語(yǔ)義信息,所以分類(lèi)效果更佳。

3.3.4 與CNN、RNN、RCNN模型對(duì)比實(shí)驗(yàn)

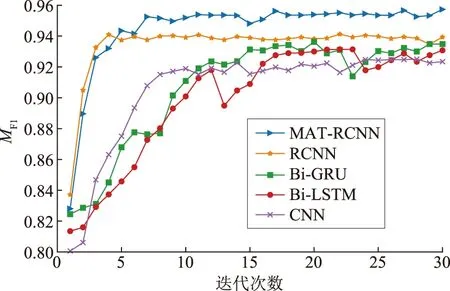

對(duì)比提出的MAT-RCNN模型與CNN、RNN、RCNN在分類(lèi)性能上的優(yōu)劣,采用相同方法進(jìn)行實(shí)驗(yàn),其中CNN模型為文獻(xiàn)[4]的模型,RNN模型分別采用Bi-GRU和Bi-LSTM[5],RCNN模型選用文獻(xiàn)[6]中的模型。實(shí)驗(yàn)結(jié)果均在每個(gè)模型最優(yōu)參數(shù)下獲得,實(shí)驗(yàn)結(jié)果如圖10所示。

圖10 與CNN、RNN、RCNN模型對(duì)比結(jié)果Fig.10 Comparison results of CNN,RNN and RCNN models

如圖10所示,本文所提出的模型在分類(lèi)效果上要優(yōu)于其他對(duì)比模型。CNN模型的MF1最低,這是由于CNN是通過(guò)卷積核逐塊掃描的方法提取特征,因此無(wú)法關(guān)注到上下文的語(yǔ)義聯(lián)系。Bi-GRU與Bi-LSTM分類(lèi)效果相差不大,但Bi-GRU的分類(lèi)效果要稍好于Bi-LSTM,這種雙向的RNN循環(huán)結(jié)構(gòu)在一定程度上能獲取上下文信息。RCNN在雙向循環(huán)結(jié)構(gòu)的基礎(chǔ)上加入最大池化層,在獲取上下文信息的同時(shí)較大程度保留關(guān)鍵語(yǔ)義,在分類(lèi)效果上優(yōu)于雙向RNN模型。本文所提出的模型利用多次注意力計(jì)算獲取文本內(nèi)部聯(lián)系,從而突出文本重要特征,并通過(guò)RCNN進(jìn)一步提取語(yǔ)義信息,因此在語(yǔ)義理解方面要優(yōu)于對(duì)比模型。

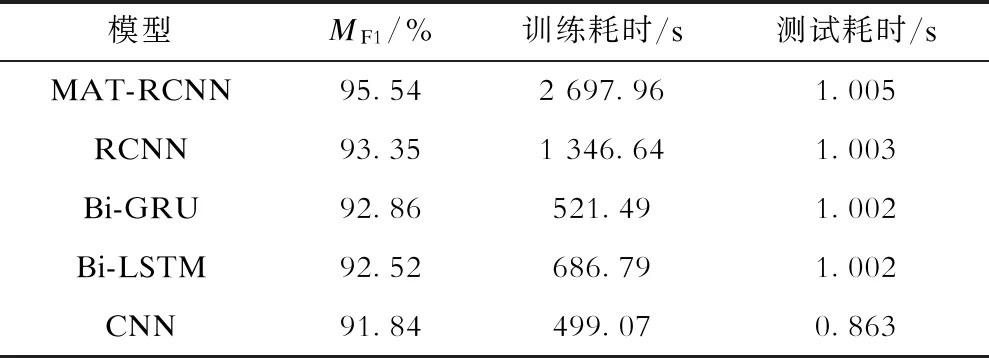

對(duì)各個(gè)模型訓(xùn)練耗時(shí)與測(cè)試耗時(shí)進(jìn)行研究,由于詞向量維度大小會(huì)對(duì)耗時(shí)產(chǎn)生影響,詞向量越大耗時(shí)越長(zhǎng),詞向量維度在50~150之間變化時(shí),模型的綜合指標(biāo)MF1變化幅度不超過(guò)0.6%。因此,為了客觀地對(duì)每個(gè)模型訓(xùn)練耗時(shí)與測(cè)試耗時(shí)進(jìn)行測(cè)試,將輸入詞向量維度設(shè)置為128,迭代次數(shù)為30次,分別對(duì)每個(gè)模型進(jìn)行實(shí)驗(yàn),結(jié)果見(jiàn)表5。

由表5可知,隨著模型的復(fù)雜程度增加,模型的耗時(shí)也會(huì)增加。由于CNN模型采用不同卷積核并行運(yùn)算,因此耗時(shí)最少。Bi-GRU模型訓(xùn)練耗時(shí)少于Bi-LSTM模型,因?yàn)镚RU模型的兩門(mén)設(shè)計(jì)相比起LSTM的三門(mén)設(shè)計(jì),結(jié)構(gòu)簡(jiǎn)單,訓(xùn)練耗時(shí)少,這也是本文模型的RCNN網(wǎng)絡(luò)層采用Bi-GRU網(wǎng)絡(luò)的原因。本文模型由于模型結(jié)構(gòu)相比于對(duì)比模型復(fù)雜,因此訓(xùn)練耗時(shí)較長(zhǎng),但是測(cè)試耗時(shí)相對(duì)于對(duì)比模型相差不大,在實(shí)際應(yīng)用中僅需加載訓(xùn)練好的模型對(duì)測(cè)試數(shù)據(jù)進(jìn)行計(jì)算,所以實(shí)際中僅用考慮測(cè)試耗時(shí),模型測(cè)試耗時(shí)為1.005 s,遠(yuǎn)低于人工分類(lèi)耗時(shí)。

表5 深度學(xué)習(xí)模型分類(lèi)性能對(duì)比Tab.5 Performance comparisons of deep learning models

4 結(jié)束語(yǔ)

采用多頭注意力機(jī)制與RCNN對(duì)電力設(shè)備缺陷描述文本實(shí)現(xiàn)自動(dòng)分類(lèi),通過(guò)實(shí)驗(yàn)證明多頭注意力機(jī)制結(jié)合RCNN在語(yǔ)義學(xué)習(xí)和缺陷描述文本分類(lèi)效果上優(yōu)于CNN、RNN、RCNN等模型。所提方法可以通過(guò)語(yǔ)義學(xué)習(xí)有效地識(shí)別缺陷的嚴(yán)重程度,提升了巡檢效率。