基于DeeplabV3+的無(wú)人機(jī)遙感影像識(shí)別

賴(lài)麗琦

(浙江農(nóng)林大學(xué) 信息工程學(xué)院,浙江 杭州 311300)

近些年來(lái),隨著無(wú)人機(jī)航拍技術(shù)日漸成熟,無(wú)人機(jī)航拍影像正在被越來(lái)越廣泛地應(yīng)用于各個(gè)領(lǐng)域。作為高空衛(wèi)星遙感影像的補(bǔ)充,無(wú)人機(jī)航拍影像以其獲取方便,成像分辨率高,受大氣因素干擾小的優(yōu)點(diǎn)[1],在小區(qū)域遙感應(yīng)用方面擁有較大的前景[2-4],基于無(wú)人機(jī)的林業(yè)資源信息獲取已成為一種研究熱點(diǎn)。林志瑋等[5]利用DenseNet,F(xiàn)C-DenseNet對(duì)無(wú)人機(jī)遙感影像中的不同樹(shù)種進(jìn)行細(xì)分,其分類(lèi)精度均達(dá)80%以上,最高精度為87.54%;楊建宇等[6]使用SegNet對(duì)遙感影像中農(nóng)村建筑物進(jìn)行分割,得到了優(yōu)于傳統(tǒng)機(jī)器學(xué)習(xí)方法的結(jié)果;劉文萍等[7]提出一種改進(jìn)的DeeplabV3+模型,編碼器中將主干網(wǎng)絡(luò)替換為ResNet+,增加聯(lián)合上采樣模塊,調(diào)整 ASPP 模塊,解碼器中融合更多淺層特征。該模型對(duì)無(wú)人機(jī)影像的不同土地類(lèi)型進(jìn)行了較好地細(xì)分,得到效果更好的分類(lèi)與分割結(jié)果;宋建輝等[8]利用基于遷移學(xué)習(xí)的DeeplabV3+模型進(jìn)行無(wú)人機(jī)地物場(chǎng)景語(yǔ)義分割,平均交并比達(dá)75.45%;戴鵬欽等[9]使用Resnet-Unet對(duì)結(jié)合了植被因子的遙感影像進(jìn)行識(shí)別,結(jié)合最優(yōu)尺度的面向?qū)ο蠓指罱Y(jié)果可以對(duì)其結(jié)果進(jìn)行修正,有效去除了“椒鹽噪聲”,提高了樹(shù)種分類(lèi)精度;滕文秀等[10]采用超像素法結(jié)合語(yǔ)義分割模型對(duì)無(wú)人機(jī)影像進(jìn)行識(shí)別,該方法較單一模型收斂更快,精度更高。

傳統(tǒng)機(jī)器學(xué)習(xí)方法通常沿用了衛(wèi)星遙感圖像的處理思路,需要人為選取特征變量,工程量大,而且特征變量的選取對(duì)精度的影響較大[11,12],深度學(xué)習(xí)領(lǐng)域中的語(yǔ)義分割方法具有較好的魯棒性和分類(lèi)分割效果,能較好地避免特征選擇對(duì)精度的影響,為無(wú)人機(jī)影像分割與分類(lèi)提供了新思路[13]。

本文以無(wú)人機(jī)獲取的植被覆蓋影像為研究對(duì)象,使用傳統(tǒng)圖像分割模型隨機(jī)森林(Random Forest)和語(yǔ)義分割模型SegNet,U-Net,DeeplabV3+對(duì)影像進(jìn)行識(shí)別分割,并對(duì)DeeplabV3+模型進(jìn)行改進(jìn),探討不同模型的指標(biāo)優(yōu)劣,以期得到最佳分割模型,為無(wú)人機(jī)植被影像精準(zhǔn)識(shí)別提供參考。

1 材料與方法

1.1 數(shù)據(jù)采集

使用六旋翼無(wú)人機(jī)DJI Matrice 600 Pro,最大載重5.5 kg,最大飛行高度500 m。搭載相機(jī)型號(hào)為Zenmuse X5,有效像素1 600萬(wàn),分辨率4608×3 456,鏡頭焦距15 mm,等效焦距30 mm。

影像拍攝地點(diǎn)位于臨安區(qū)榧子山附近的青山湖綠道,拍攝時(shí)天氣良好,受天氣影響較小,相機(jī)鏡頭保持垂直向下。

1.2 數(shù)據(jù)集的建立

根據(jù)拍攝地點(diǎn)無(wú)人機(jī)影像,結(jié)合青山湖地區(qū)植被分布情況,根據(jù)《中國(guó)植被》所提出的植被生活型劃分為4種植被類(lèi)型,即喬木、草本、灌木、禾本類(lèi)草本,將道路,水體等其他物體統(tǒng)一歸為背景。為提升模型的收斂速度,減少運(yùn)算量,將圖像裁剪為512像素×512像素,使用labelme進(jìn)行圖像像素級(jí)別標(biāo)注并生成標(biāo)簽圖。通過(guò)旋轉(zhuǎn),翻轉(zhuǎn),傾斜,彈性變換,透視,裁剪,縮放等不同操作對(duì)數(shù)據(jù)進(jìn)行增廣,共獲得 4 500 張圖像,按照7∶3的比例劃分為訓(xùn)練集和驗(yàn)證集。圖1(a)為其中一幅樣本圖及其數(shù)據(jù)增廣圖,圖1(b)為對(duì)應(yīng)的標(biāo)簽圖。

圖1 數(shù)據(jù)增廣與標(biāo)簽圖Fig.1 Data augmentation and label map

1.3 分割方法

1.3.1隨機(jī)森林

隨機(jī)森林(Random Forest)由Breiman[14]于2001年提出,是指利用多棵決策樹(shù)對(duì)樣本進(jìn)行訓(xùn)練并預(yù)測(cè)的一種算法,屬于監(jiān)督分類(lèi)方法。其通常包含多個(gè)決策樹(shù),輸出的類(lèi)別是由個(gè)別決策樹(shù)輸出的類(lèi)別的眾樹(shù)來(lái)決定的。隨機(jī)森林方法實(shí)現(xiàn)簡(jiǎn)單,精度高,具有較好的抗過(guò)擬合能力。

1.3.2SegNet

SegNet是一個(gè)由Encoder和Decoder組成的對(duì)稱(chēng)網(wǎng)絡(luò)[15,16]。其中Encoder使用的是微調(diào)過(guò)的VGG16中的前13層卷積網(wǎng)絡(luò)結(jié)構(gòu)。SegNet的創(chuàng)新就在于其Encoder的每一個(gè)Max-pooling過(guò)程中保存其池化索引(最大值的Index),在Decoder層使用這些得到的索引來(lái)做非線性上采樣,對(duì)經(jīng)過(guò)上采樣的特征圖進(jìn)行卷積操作產(chǎn)生密集特征圖(Feature maps),送入softmax分類(lèi)器中進(jìn)行分類(lèi)。SegNet改善了邊界劃分,減少了端到端訓(xùn)練的參數(shù)量,模型較小,對(duì)內(nèi)存要求較低。

1.3.3U-net

U-net[17]包括兩部分,分別為特征提取和上采樣部分。由于網(wǎng)絡(luò)結(jié)構(gòu)像U型,所以叫U-net網(wǎng)絡(luò)。與傳統(tǒng)FCN網(wǎng)絡(luò)不同,U-net采用了完全不同的特征融合方式:拼接(Concatenate),U-net網(wǎng)絡(luò)的每個(gè)卷積層得到的特征圖都會(huì)拼接到對(duì)應(yīng)的上采樣層,從而實(shí)現(xiàn)對(duì)每層特征圖均有效使用到后續(xù)計(jì)算中。這樣做的好處是結(jié)合了低級(jí)特征圖中的特征,從而可以使得最終所得到的特征圖中既包含了高維度的特征,也包含很多低維度的特征,實(shí)現(xiàn)了不同尺度下特征的融合,能有效提高模型的結(jié)果精確度,在小樣本集上也能獲得較為出色的表現(xiàn),常用于醫(yī)療影像分割。

1.3.4DeeplabV3+

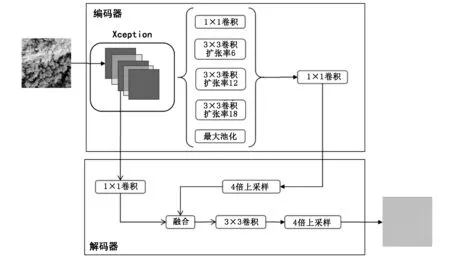

DeeplabV3+是Deeplab[18]系列網(wǎng)絡(luò)的第四代產(chǎn)品。DeeplabV3+為了融合多尺度信息,其引入了語(yǔ)義分割常用的encoder-decoder形式。在Encoder-Decoder 架構(gòu)中,引入可任意控制編碼器提取特征的分辨率,通過(guò)空洞卷積平衡精度和耗時(shí)。DeeplabV3+與SegNet、U-net相比,其最大的改進(jìn)之處就是引入了空洞卷積,空洞卷積加大了感受野,而且并不會(huì)造成信息損失,使得每個(gè)卷積輸出均包含了更大范圍的信息,并且DeeplabV3+將深度可分離卷積應(yīng)用于ASPP和解碼器,以替換所有的最大池化(Max-pooling)操作,有效減少了參數(shù)數(shù)量,提升模型訓(xùn)練速度。DeeplabV3+模型結(jié)構(gòu)見(jiàn)圖2。

圖2 DeeplabV3+模型結(jié)構(gòu)Fig.2 Structure of DeeplabV3+ model

1.3.5改進(jìn)的DeeplabV3+

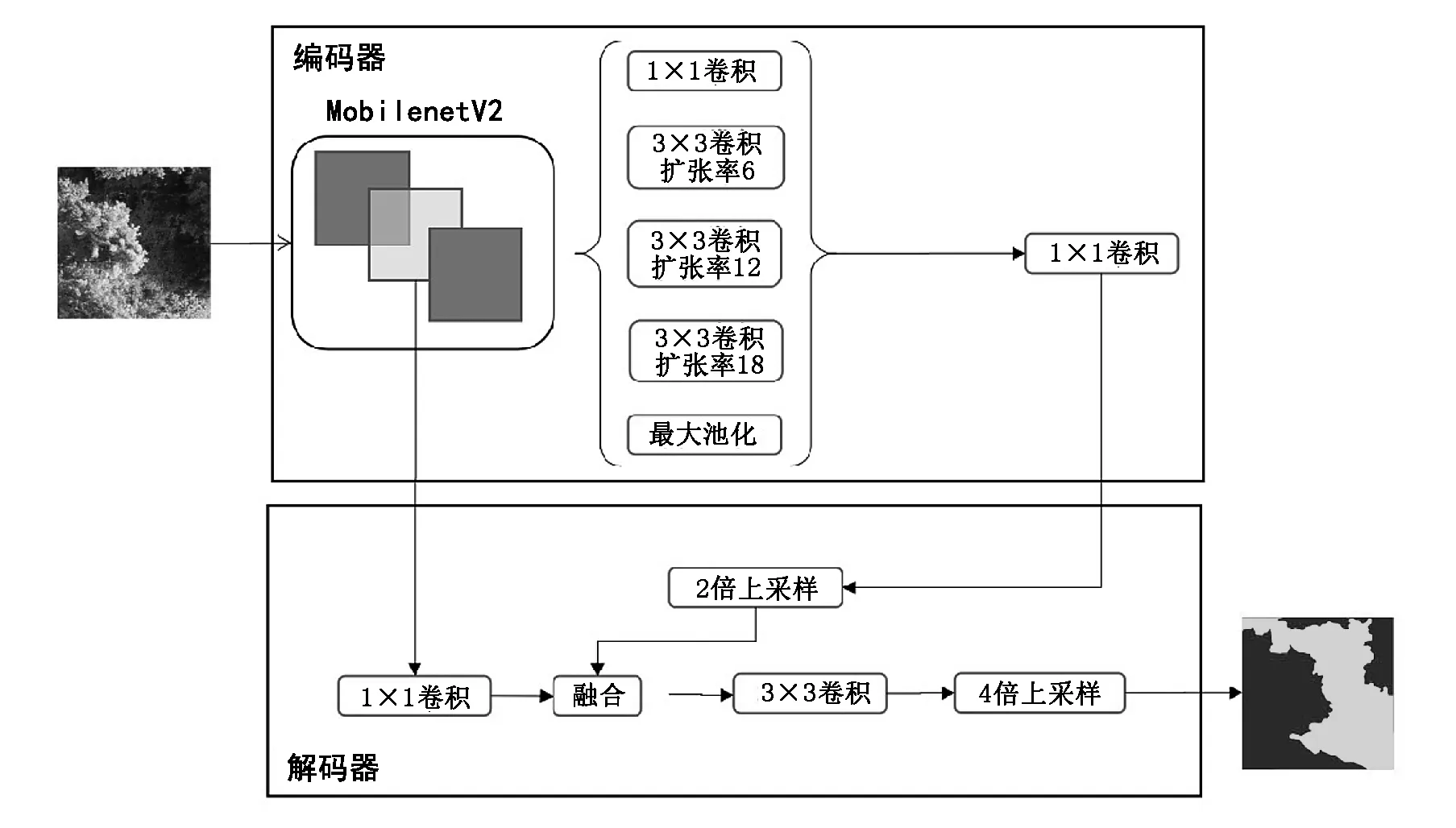

本文提出的分割方法基于DeeplabV3+語(yǔ)義分割模型,并對(duì)主干網(wǎng)絡(luò)進(jìn)行了替換,采用加入擴(kuò)張卷積的MobilenetV2作為主干網(wǎng)絡(luò),進(jìn)一步減少模型參數(shù)量,使模型更加輕量化。

相比原始DeeplabV3+使用的Xception+網(wǎng)絡(luò),MobileNetV2網(wǎng)絡(luò)可以大幅度縮減參數(shù)量,并且可以用較少的運(yùn)算量得到較高的精度。在相同顯存大小的情況下,可以使用更大的batch size來(lái)訓(xùn)練模型。同時(shí),輕量化的網(wǎng)絡(luò)結(jié)構(gòu)顯著降低了模型權(quán)重文件大小和模型預(yù)測(cè)速度。改進(jìn)的DeeplabV3+模型結(jié)構(gòu)見(jiàn)圖3。

圖3 改進(jìn)的DeeplabV3+模型結(jié)構(gòu)Fig.3 Structure of improved DeeplabV3+ model

2 實(shí)驗(yàn)結(jié)果與分析

2.1 實(shí)驗(yàn)環(huán)境與模型訓(xùn)練

使用Keras構(gòu)建深度學(xué)習(xí)模型,處理器為i7-8750H,顯卡為GTX1080TI。按照7:3的比例隨機(jī)劃分訓(xùn)練集與驗(yàn)證集。模型以3幅圖像為一個(gè)批次進(jìn)行完整迭代。以交叉熵作為損失函數(shù);以驗(yàn)證集損失函數(shù)值Val_loss為監(jiān)控對(duì)象,當(dāng)Val_loss經(jīng)過(guò)7個(gè)epoch不下降時(shí),自動(dòng)降低1/2學(xué)習(xí)率;當(dāng)Val_loss經(jīng)過(guò)40個(gè)eopch不下降時(shí),認(rèn)為模型已經(jīng)收斂,提前結(jié)束訓(xùn)練。

除圖像原始特征外,還使用32組不同參數(shù)組合的Gabor濾波器獲取圖像紋理特征,使用Roberts,Sobel等算子獲取邊緣特征,最后加入高斯、中值濾波器等,共獲取42個(gè)特征進(jìn)行隨機(jī)森林模型訓(xùn)練。

2.2 評(píng)價(jià)指標(biāo)

基于混淆矩陣基礎(chǔ)評(píng)估模型精度。采用的評(píng)價(jià)指標(biāo)有PA(Pixel Accuracy),MIOU(Mean Intersection Over Union),Precision(精確率)以及Recall(召回率)。具體計(jì)算公式為:

(1)

(2)

(3)

(4)

其中,假定數(shù)據(jù)集中有n+1類(lèi)(0~n),0通常表示背景。真正(TP)和真負(fù)(TN)表示原本為i類(lèi)同時(shí)預(yù)測(cè)為i類(lèi),假正(FP)和假負(fù)(FN)表示原本為i類(lèi)被預(yù)測(cè)為j類(lèi)。如果第i類(lèi)為正類(lèi),當(dāng)i!=j時(shí),使用Pii表示原本為i類(lèi)同時(shí)預(yù)測(cè)為i類(lèi),Pij表示原本為i類(lèi)被預(yù)測(cè)為j類(lèi),則Pii表示TP,Pjj表示TN,Pij表示FP,Pji表示FN。

2.3 實(shí)驗(yàn)結(jié)果

2.3.1未改進(jìn)模型實(shí)驗(yàn)結(jié)果對(duì)比

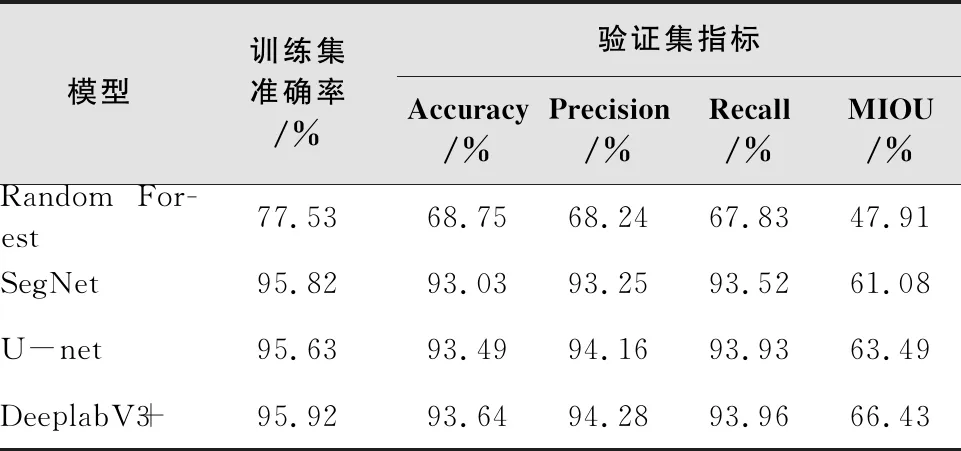

不同模型在數(shù)據(jù)集上的表現(xiàn)如表1所示。

表1 不同模型指標(biāo)對(duì)比

從表1中可以看到,傳統(tǒng)機(jī)器學(xué)習(xí)模型Random Forest表現(xiàn)較差,在訓(xùn)練集和驗(yàn)證集上的表現(xiàn)較深度學(xué)習(xí)模型有所差距。U-net表現(xiàn)略好于SegNet,在驗(yàn)證集上的MIOU比SegNet高出2.41%;DeeplabV3+的平均交并比MIOU達(dá)到66.43%,比U-net高出2.94%,其他指標(biāo)也都優(yōu)于SegNet和U-Net的表現(xiàn)。可以得出結(jié)論:DeeplabV3+模型在本次實(shí)驗(yàn)中表現(xiàn)最好,空洞卷積的引入使得模型的感受野加大,能夠獲取更多上下文信息,使得模型的MIOU較其他模型有很大提升。

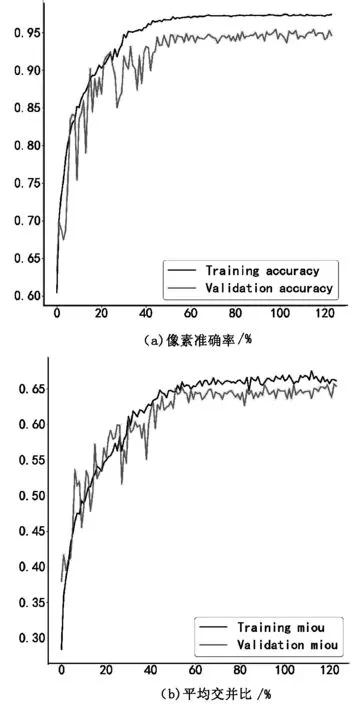

DeeplabV3+模型的部分指標(biāo)如圖4所示。

從圖4可以看到,模型的指標(biāo)曲線均在80個(gè)epoch左右趨于平緩,到120個(gè)epoch時(shí)模型已達(dá)到收斂。

圖4 Indicators of DeeplabV3+ model Fig.4

2.3.2改進(jìn)模型實(shí)驗(yàn)結(jié)果

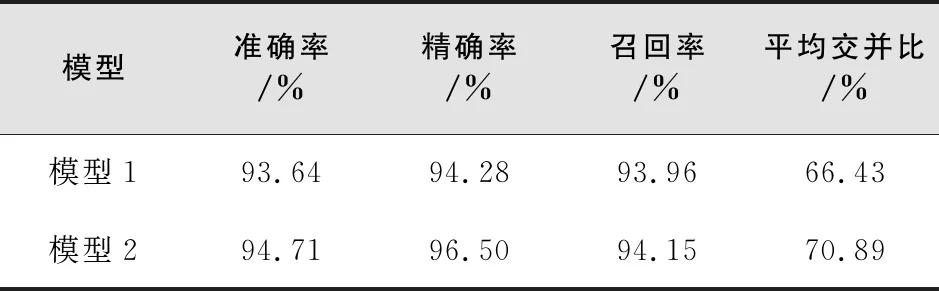

本文提出的改進(jìn)的DeeplabV3+模型與原始DeeplabV3+模型對(duì)比效果見(jiàn)表2,以驗(yàn)證集指標(biāo)作為評(píng)估指標(biāo)。模型1為原始DeeplabV3+模型,模型2為本文提出的改進(jìn)模型。

從表2中可以看出,模型2各項(xiàng)指標(biāo)較模型1均有所提升。模型2在模型1基礎(chǔ)上,Accuracy提升1.07%,Precision提升2.22%,Recall提升0.19%,MIOU提升4.46%。實(shí)驗(yàn)結(jié)果表明,改進(jìn)模型能夠獲得更好的分類(lèi)與分割效果。與原模型相比,改進(jìn)模型在各項(xiàng)性能指標(biāo)上均有所改善,且MIOU有明顯提升。

表2 模型指標(biāo)對(duì)比

模型各項(xiàng)參數(shù)指標(biāo)如表3所示。

從表3可知。與模型1相比,使用MobilenetV2作為主干網(wǎng)絡(luò)后,模型2的參數(shù)個(gè)數(shù)從41,254,101降到2,766,933,僅為模型1的6.71%,更少的參數(shù)使模型訓(xùn)練更快,更加輕量化;單epoch訓(xùn)練時(shí)長(zhǎng)從485s降到363s,總訓(xùn)練Epoch次數(shù)從158次降到125次,訓(xùn)練時(shí)長(zhǎng)也有明顯縮短。

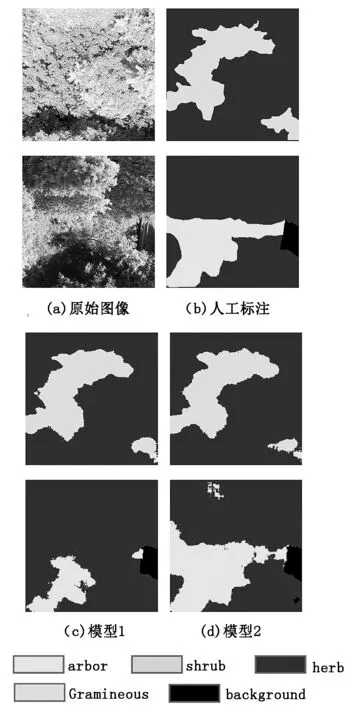

兩個(gè)模型部分預(yù)測(cè)結(jié)果如圖5所示。

圖5 兩種模型分割效果對(duì)比Fig.5 Comparison of the segmentation results of two models

由圖5可以看出,模型1誤分割情況較多,在邊界分割上效果并不理想。模型2誤分割情況有所改善,在植被覆蓋圖像上的分割分類(lèi)精度較高,能夠?qū)吔邕M(jìn)行更好地劃分,具有更好的魯棒性和實(shí)用性。但仍存在一定“椒鹽噪聲”,存在進(jìn)一步優(yōu)化的可能。

3 結(jié)論與討論

針對(duì)現(xiàn)有林地覆蓋數(shù)據(jù)獲取方法耗時(shí)慢、成本高、工程量大等問(wèn)題,基于深度學(xué)習(xí)方法,提出一種面向無(wú)人機(jī)航拍影像的語(yǔ)義分割方法。結(jié)果表明,基于深度學(xué)習(xí)的語(yǔ)義分割方法能夠在植被識(shí)別任務(wù)上取得一定成果。

1)使用語(yǔ)義分割模型以及傳統(tǒng)圖像分割模型分別對(duì)研究區(qū)無(wú)人機(jī)影像進(jìn)行識(shí)別分割,表明語(yǔ)義分割模型在圖像分割上的表現(xiàn)要優(yōu)于傳統(tǒng)圖像分割模型,可應(yīng)用于無(wú)人機(jī)航拍影像識(shí)別;在語(yǔ)義分割模型中,DeeplabV3+表現(xiàn)最好,在驗(yàn)證集上的像素準(zhǔn)確率為93.64%,精確率為94.28%,召回率為93.96%,平均交并比為66.43%。

2)本文提出的改進(jìn)DeeplabV3+模型在驗(yàn)證集上的像素準(zhǔn)確率為94.71%,查準(zhǔn)率為96.50%,召回率為94.15%,平均交并比為70.89%,相比原始DeeplabV3+模型像素準(zhǔn)確率提高了1.07%,精確率提高了2.22%,召回率提高了0.19%,平均交并比MIOU提高了4.46%,得到了更高的分割與分類(lèi)效果。訓(xùn)練時(shí)長(zhǎng)為原模型的78.76%,參數(shù)量?jī)H為原模型的6.74%,具有一定的適用性和實(shí)用價(jià)值。

3)本實(shí)驗(yàn)無(wú)人機(jī)航拍高度固定為20 m,后續(xù)可使用不同航拍高度圖像進(jìn)行對(duì)比實(shí)驗(yàn),分析不同航拍高度對(duì)分割精度的影響[19]。