多標簽分類的傳統民族服飾紋樣圖像語義理解

趙海英,周 偉,侯小剛,齊光磊

(1.北京郵電大學 計算機學院,北京 100876;2.北京郵電大學 數字媒體與設計藝術學院,北京 100876;3.北京郵電大學 網絡技術研究院,北京100876;4.北京郵電大學 世紀學院,北京 102101)

1 引 言

傳統民族服飾紋樣記載著一個民族從建立到發展過程的歷史文化演變,在對服飾紋樣進行解讀時,不僅需要明確紋樣的類別(本體),更需要詮釋各紋樣所具有的深層文化語義信息(隱義)。例如,傳統民族服飾中紋樣本體“龍”是古代皇帝的象征,隱義是“權勢、高貴”;紋樣本體“牡丹”被譽為花王,隱義是“富貴、美滿”;紋樣本體“桃”具有圖騰、生殖崇拜的原始信仰,隱義是“長壽、健康”。因此,在對傳統民族服飾紋樣進行多標簽分類時,從“本體”和“隱義”兩個層面分類,可以更全面地闡述傳統民族服飾紋樣所蘊含的文化語義信息。

近年來,基于深度學習的方法在圖像分割[1]、識別[2]和檢索[3]等一系列計算機視覺任務中取得了巨大的成功。與此同時,基于深度學習的圖像多標簽分類方法越來越受歡迎。一方面,由于卷積神經網絡(Convolutional Neural Networks,CNN)在單標簽分類任務的成功,很多研究者直接將CNN應用到多標簽分類任務上[4-8]。例如WEI等[4]以任意數量的對象片段假設作為輸入,將共享的CNN與每個假設相連,最后將不同假設的CNN輸出結果用最大池化進行聚合,得到最終的多標簽預測。Yu等[6]將圖像的全局先驗信息和局部實例信息相結合構建了一個新的雙流網絡,可以自動定位觸發標簽的關鍵圖像模式。另一方面,由于循環神經網絡(Recurrent Neural Network,RNN)在機器翻譯、圖像描述以及視覺問題回答等任務的成功應用,一些學者將圖像多分類看作是序列生成問題,同時利用RNN建立標簽之間的依賴關系[9-12]。例如,JIN等[9]將圖像標注任務作為一個序列生成問題,提出RIA模型能夠根據圖像內容對標簽的長度進行原生預測,并考慮訓練標注序列輸入到LSTM順序的影響。WANG等[10]構建一個端到端的CNN-RNN框架,學習圖像標簽嵌入的方法來表征隱義標簽依賴關系和圖像標簽相關性。

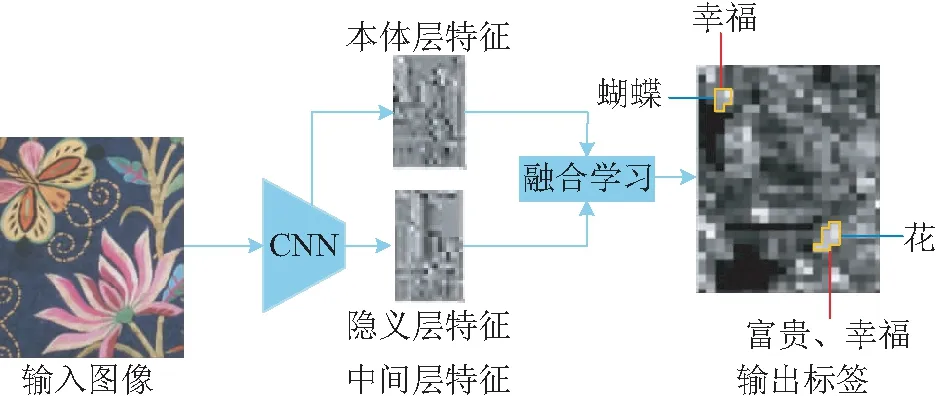

然而,上述方法只能對圖像中多個物體類別(本體)進行分類,而不能對同一張圖像中各類別所蘊含的深層次語義信息(隱義)進行分類。為解決上述問題,本文提出了一個“本體-隱義”融合學習的圖像多標簽分類模型,該模型首先利用CNN中間層學習圖像的本體信息,利用CNN較高層學習圖像的隱義信息,然后利用本體信息和隱義信息之間的依賴關系設計融合學習模型,實現對圖像中多類別以及各類別蘊含的深層語義信息分類。此外,在傳統民族服飾紋樣圖像數據集和Scene數據集上進行對比實驗,實驗結果證明了本文方法在圖像多標簽分類任務上的有效性和優越性。

2 “本體-隱義”融合學習的多標簽分類模型

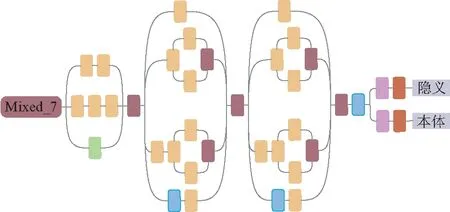

圖1 構建模型縱覽圖Fig.1 Overview of the present model

從“本體”和“隱義”兩個層面對傳統民族服飾紋樣進行分類,如表1所示,可以更全面地闡述傳統民族服飾紋樣所蘊含的文化語義信息。

2.1 模型結構

CNNs可以學習豐富的圖像層次特征,例如AlexNet模型前兩層學習的是顏色、邊緣等低層特征,第3層學習的是較復雜的紋理特征,第4層學習的是特定類別的局部特征,第5層學習的是具有辨別性的完整特征[13],即網絡的低層特征包含更多的圖像結構信息,中間層因卷積核感受野小且個數多,更容易學習圖像的區域或局部特征,而高層特征更關注圖像的語義信息。

表1 圖像的本體標簽和隱義標簽多分類

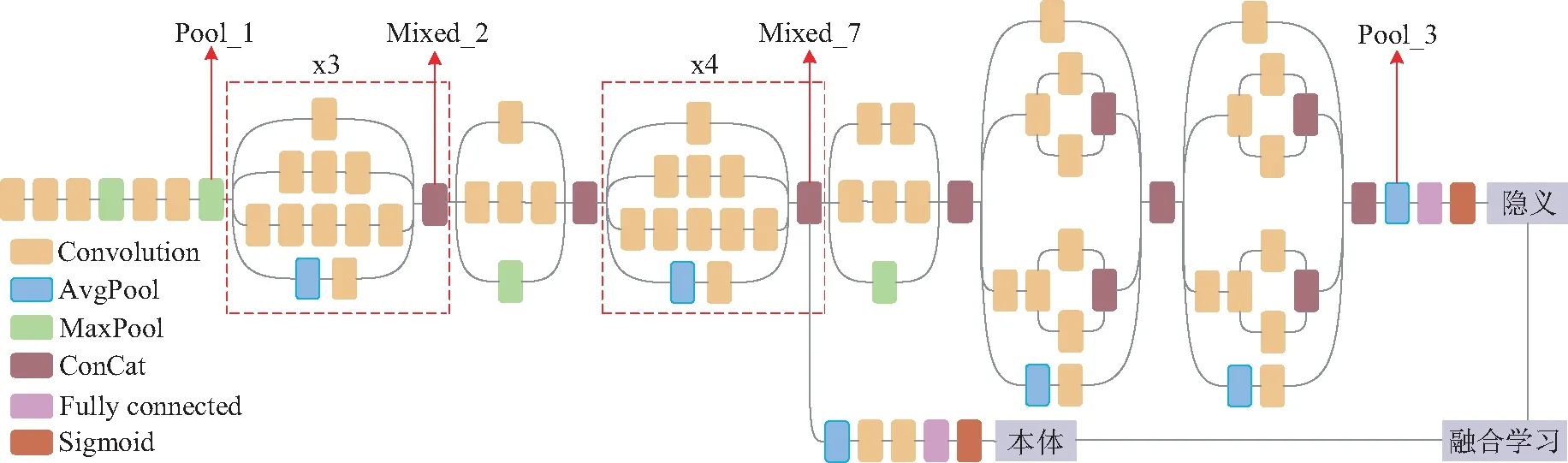

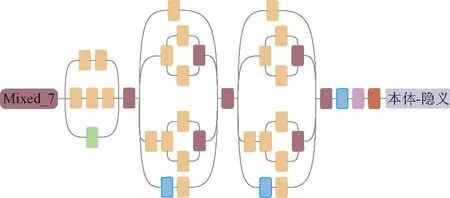

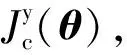

在本文中,本體信息描述圖像中存在的物體類別,而隱義信息詮釋圖像所蘊含的深層次文化語義,與本體信息相比較,隱義信息需要考慮圖像中存在的物體類別、組合規則等信息,從而需要更高層的特征進行表征。因此,在同一個網絡中,可以利用網絡的中間層學習圖像的本體信息,高層學習圖像的隱義信息。然后,將本體信息和隱義信息分別利用損失函數進行訓練后,采用融合學習的方式更新網絡參數,可以捕獲圖像的本體信息與隱義信息之間的關聯性,從而實現了對同一張圖像的本體標簽分類和隱義標簽分類。本文選取Inception-V3[14]作為基準模型,構建了一種“本體-隱義”融合學習的圖像多標簽分類模型,如圖2所示(彩圖見期刊電子版)。為簡單直觀地表述,圖中紅色虛線模塊為重復模塊,“x3”表示此模塊按先后順序重復3次,“x4”同理。(注:為便于下文表述,圖中紅色箭頭為對應節點名稱,其中mixed_2和mixed_7分別是最后一個重復模塊的節點名稱)

圖2 “本體-隱義”融合學習的多標簽分類模型Fig.2 Multi-label classification model based on “ontology-implicit” fusion learning

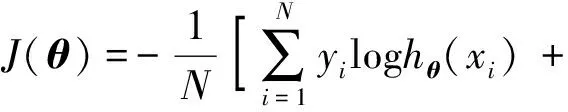

由于Inception-V3模型網絡層次較深,通常需要在非常大的數據集上經過數百萬次訓練才能達到較好的效果。因此,本文利用ImageNet上預訓練的Inception-V3在多標簽分類任務上微調。本文采用的多標簽損失函數為交叉熵損失。其中,采用Sigmoid作為激活函數得到輸出hθ(x):

(1)

預測值和真實值概率之間的交叉熵如下:

(2)

其中yi∈{0,1}。記本體標簽的損失函數為Jy(θ),隱義標簽的損失函數為Js(θ),將兩者加權求和進行融合學習,得到模型總損失函數為Jsum(θ),最后進行反向傳播降低誤差,以獲得更好的分類效果:

Jsum(θ)=λJy(θ)+Js(θ),

(3)

其中λ為本體標簽的損失函數Jy(θ)的權重。

2.2 模型不同中間層特征影響研究

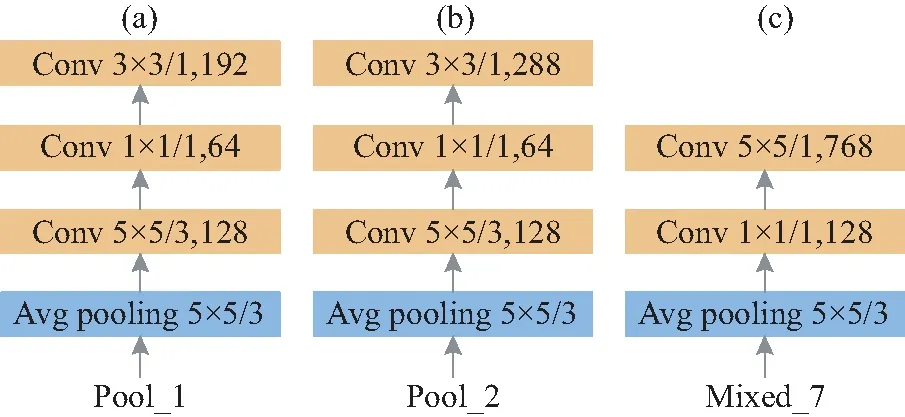

Inception-V3網絡模型深度較深,模型中包含許多卷積操作和池化操作。為了研究Inception-V3模型不同位置獲取的中間層圖像特征對本體標簽多分類結果的影響,如圖3所示,本文對Inception-V3模型的3個不同位置做出以下探討。

圖3 卷積和池化操作Fig.3 Convolution and pooling operations

在圖3(a)中,獲取Inception-V3網絡模型的非Inception Module的第2個池化層(即Pool_1)輸出特征,在其后面接1個平均池化層和3個卷積層,然后再接全連接層。在圖3(b)中,在Inception-V3模型中的第1個Inception模塊組的輸出(即Mixed_2)后面,連接1個平均池化層和3個卷積層,然后再接全連接層。章節2.1中間層如圖3(c)所示,即在Inception-V3模型中的第2個Inception模塊組的輸出(即Mixed_7)后面,連接一個平均池化層和兩個卷積層,然后再接全連接層。下文將對不同中間層特征進行實驗,對比效果差異。

3 模型不同結構對比研究

在2.1節中介紹的“本體-隱義”融合學習的圖像多標簽分類CNN模型基礎上,對模型結構進行修改,提出另外3種“本體-隱義”圖像多標簽分類模型,下面對3個對比模型進行詳細闡述。

3.1 單流網絡

圖4 單流網絡Fig.4 Single stream network

3.2 分流網絡

圖5 分流網絡Fig.5 Shunt network

3.3 中間層分流網絡

圖6 中間層分流網絡Fig.6 Intermediate shunt network

4 實驗結果與分析

4.1 實驗數據與評價指標

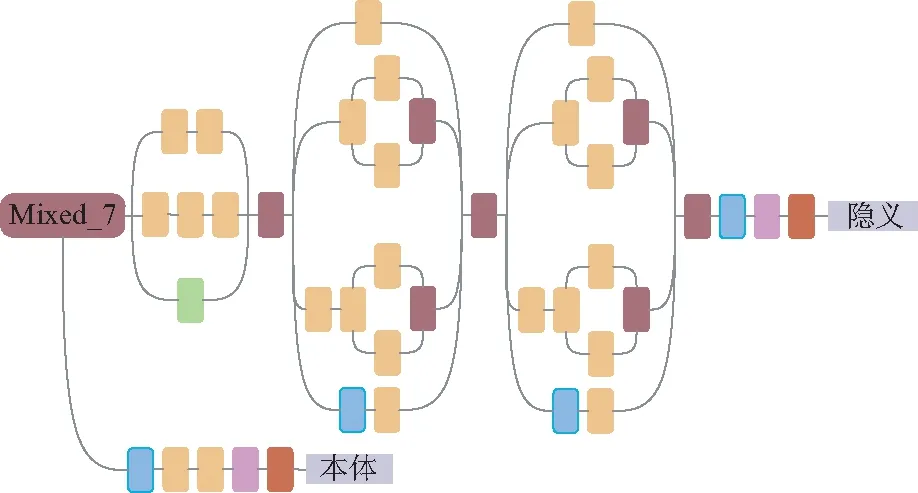

本文在傳統民族服飾紋樣圖像數據集和Scene數據集上進行多標簽分類的對比實驗。傳統民族服飾紋樣圖像數據集由本實驗室構建,共有3 000張圖像,每張圖像均含有本體和隱義兩層標簽。本體標簽包含8個不同類別,即花、桃、鳥、龍、蝴蝶、蝙蝠、祥云以及人物;隱義標簽包含有7個不同類別,即富貴、喜慶、權勢、幸福、典故、吉祥以及長壽。另外,Scene數據集[15]共有2 000張圖像,包含沙漠、山脈、海洋、日落和樹木類等5類自然場景。另外,將兩個數據集分別按6∶2∶2的比例劃分為訓練集、驗證集和測試集。兩個數據集的統計信息如表2所示,其中“>1 標簽”表示同時含有多個標簽的圖像在數據集中所占比例大小。

表2 數據集統計信息

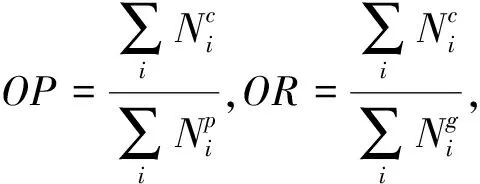

在傳統民族服飾紋樣圖像數據集上,使用和文獻[9]同樣的評價指標,利用公式(4)計算總體的精確率、召回率和F1值(O-P、O-R、O-F1),以及每個類別的精確率、召回率和F1值(C-P、C-R、C-F1)。同時參考文獻[5],本文對每個類別也采用平均精度(Average Precision,AP),對于總體也采用平均精度均值(mAP)。

(4)

在實驗中,本文使用TensorFlow深度學習框架,利用在ImageNet2012分類挑戰數據集上預訓練的Inception-v3作為基礎模型。模型訓練的初始學習率為0.001,共訓練15 000步,在第10 000步時學習率降低為之前的1/10,動量率為0.9,權重衰減率為0.000 5,使用隨機梯度下降法(Stochastic Gradient Descent,SGD)進行優化,batch_size設置為100,同時將原始圖像大小調整為299×299作為模型的輸入。

為標記簡潔,將單流網絡、分流網絡、中間層分流網絡以及2.1章節中提出的模型依次記為M1,M2,M3以及M4,同時考慮Inception-v3中間層的影響,將Pool_1,Mixed_2和Mixed_7輸出依次記為A,B和C,并將Pool_3的輸出記為D。在Scene數據集上進行對比實驗時,遵循NGRM-1方法實驗設置,即使用標準5-折交叉驗證進行評估,報告5次實驗的平均性能,此外對比方法還有MLR[16],MIMLfast[17],KISAR[18]和MIMLcaus[19]。

4.2 實驗結果

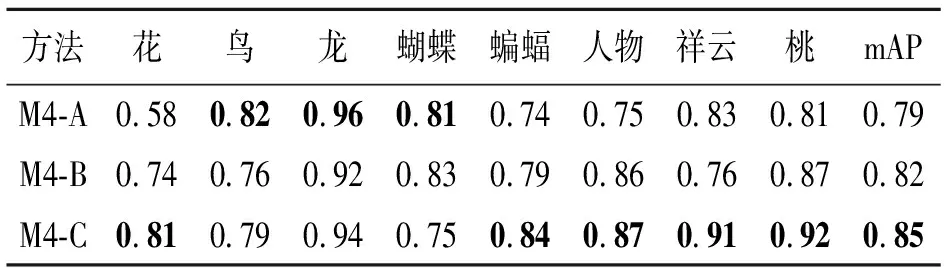

4.2.1 模型不同中間層特征對比結果

通過對“本體-隱義”融合學習的圖像多標簽分類模型(M4)的不同中間層特征進行研究,在傳統民族服飾紋樣圖像數據集上的實驗結果如表3所示,同時M4-A、M4-B和M4-C的參數量(單位:×105)分別是26.32,26.68和28.15。從表中可以看出,在AP的大多數指標上,M4-C的結果優于M4-A和M4-B,并且在mAP指標上獲得了最好的結果,盡管M4-C模型參數量相較于M4-A和M4-B有所增加,但性能的提升是可觀的。因此,在本文的后續實驗中,將采用Mixed_7作為中間層輸出。

表3 模型M4不同中間層特征的AP和mAP對比結果

注:黑色加粗為單列指標最好結果。

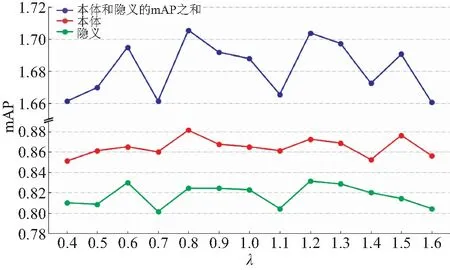

4.2.2 模型融合學習參數選擇

由公式(3)可知,λ為模型M4中本體標簽損失函數的權重值。將模型M4在傳統民族服飾紋樣圖像數據集進行實驗,并且λ在[0.4,1.6]內取值,實驗結果如圖7所示(彩圖見期刊電子版)。從圖中可以看出,在λ的取值范圍內本體標簽分類的mAP值(紅線)顯著高于隱義標簽分類的mAP值(綠線),另外當λ取0.8或1.2時,本體和隱義的mAP值之和取得最大值(藍線)。考慮到隱義標簽分類的mAP值較小,在誤差反向傳播時應賦予較大的權重,因此λ取值為0.8。

圖7 不同λ對應的本體標簽和隱義標簽分類的mAPFig.7 mAP of ontology label and implicit label classification corresponding to different λ

4.2.3 模型不同結構對比結果

本文比較了提出的4種模型結構,在傳統民族服飾紋樣圖像數據集上的實驗結果如表4所示(由于M1是將本體標簽和隱義標簽看作一個整體進行訓練,得到的是整體C-P,C-R,C-F1,O-P,O-R,O-F1以及mAP值,為方便直觀與其它網絡結果進行比較,將其看作是本體標簽分類和隱義標簽分類的結果)。從表中可以看出,無論是本體標簽分類結果還是隱義標簽分類結果,M4在大多數指標上獲得了最好的結果,并且在mAP指標上明顯優于其它方法。另外,比較4個模型的參數量(單位:×105),模型M4的參數量相較于模型M1和模型M2有所增加,但模型性能的提高是巨大的,如在本體標簽分類的指標mAP上分別提高10%和5%,同時比較模型M4和M3的參數量,可以發現參數量幾乎相等(數據只保留兩位小數),但采用融合學習使得在隱義標簽分類的指標mAP上提高1%。因此,將本體信息和隱義信息進行融合學習,可以很好地捕獲兩種之間的關聯性,更好地提高模型分類的性能。

表4 4種模型結構對比結果

注:黑色加粗為單列指標最好結果。

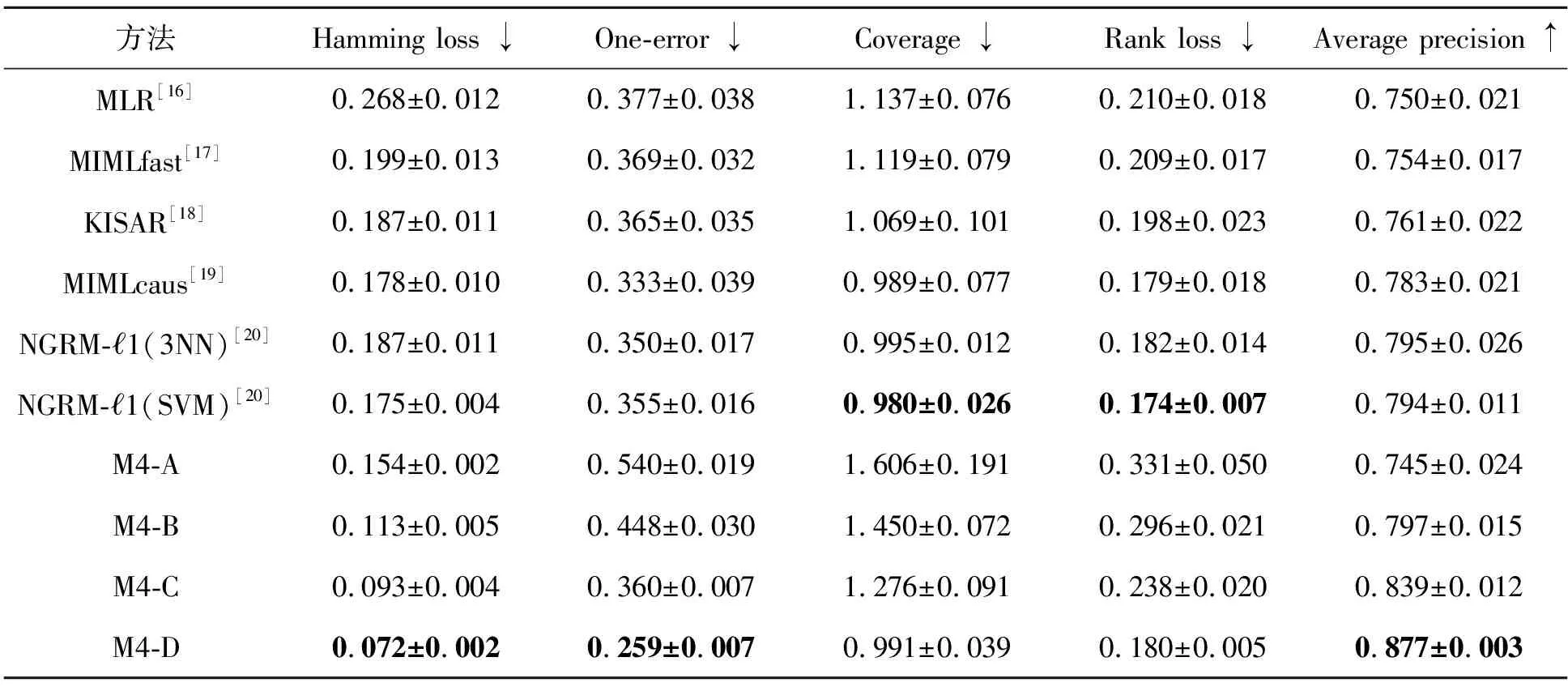

4.2.4 Scene數據集實驗對比結果

為驗證本文提出模型的圖像多標簽分類效果,在公開的Scene數據集上與其他方法進行性能比較。實驗對比結果如表5所示,其中“↓”表示“越小越好”,“↑”表示“越大越好”。可以看出,本文方法M4-D在Hamming loss、One-error和Average precision指標上分別優于其他最好方法0.103,0.096和0.083。在Coverage和Rank loss指標上與NGRM-1(SVM)方法性能接近,可以表明本文方法的優越性。同時,本文M4-C方法在Hamming loss和Average precision指標上優于NGRM-1(3NN)方法,驗證了CNN中間層的有效性,即CNN中間層能夠有效學習圖像特征。

表5 圖像多標簽分類方法的性能比(mean±std)

注:黑色加粗為單列指標最好結果。

5 結 論

本文提出了“本體-隱義”融合學習的圖像多標簽分類模型。該模型能夠模仿人類的方式觀察圖像,既能對圖像中物體類別信息(本體)進行分類,又能識別各個物體類別所蘊含的深層次語義信息(隱義)。該模型首先利用CNN中間層和較高層分別學習圖像的本體信息和隱義信息,然后利用本體信息與隱義信息之間的依賴關系設計融合學習模型,從而實現對圖像中多類別以及各類別蘊含的深層語義信息分類。在傳統民族服飾紋樣圖像數據集進行實驗,結果表明模型的中間層特征能夠有效表示圖像的本體信息,利用融合學習可進一步提高分類的準確性;在Scene數據集上進行實驗,結果表明本文方法在指標Hamming loss、One-error和Average precision上大幅度優于其他方法。在后續的工作中,將嘗試利用兩個CNN網絡分別學習本體信息和隱義信息再進行融合學習。