生成對抗網絡理論框架、衍生模型與應用最新進展

趙增順,高寒旭,孫 騫,滕升華,常發亮,Dapeng Oliver Wu

1(山東科技大學 電子通信與物理學院,山東 青島 266590)2(山東大學 控制科學與工程學院,濟南 250061)3(佛羅里達大學 電子與計算機工程系,美國 佛羅里達州 蓋恩斯維爾 32611)

1 引 言

近年來,深度學習技術在計算機視覺[1,2]、自然語言處理[3,4]和語音識別[5]等領域得到了廣泛應用.深度網絡使用大規模數據集進行訓練,在圖像語義理解和內容生成方面明顯優于先前的方法.但深度網絡模型多為有監督訓練,模型依賴于大量的標注數據和長時間的訓練.以此為背景,Goodfellow等人提出的生成對抗網絡(Generative Adversarial Networks,GAN)[6]不需要假設分布便可以從潛在空間中推斷出真實樣本,Yann Lecun將其稱為“過去十年機器學習界最酷的想法”.GAN作為一種學習生成模型的新方法,在各種具有挑戰性的任務中表現優異,如逼真圖像生成[7,8]、視頻幀生成[9,10]、藝術風格遷移[11,12]等.

本文主要介紹基于生成對抗網絡的圖像領域的應用.首先對生成對抗網絡的基本模型及其衍生模型作了簡要介紹;簡要介紹了其訓練方法;重點介紹了生成對抗網絡的具體應用.

2 生成對抗網絡模型

2.1 基本模型理論

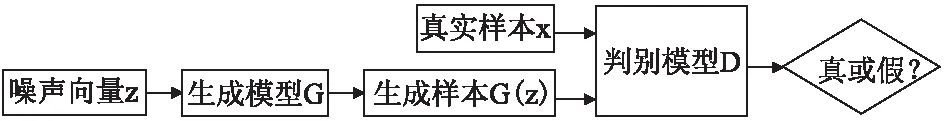

GANs由Goodfellow等人[6]在2014年提出,其來源于博弈論中的二人零和博弈,包含一個生成模型和一個判別模型.給定隨機噪聲變量z服從先驗分布pz(z)(如高斯分布),生成模型G通過這個噪聲生成樣本,記作G(z).將真實樣本x和生成樣本G(z)分別輸入判別模型D,判別模型輸出表示置信度的概率值,用于判斷真假使用,概率值大于0.5則判斷為真,概率值小于0.5則判斷為假.當D最后無法區別出真實數據x和生成數據G(z)時則停止訓練,此時達到生成器與判別器之間判定誤差的平衡.

GAN的目標函數如下所示,整個優化過程可以視為一個最大-最小化問題.

其中,pdata(x)是真實數據,pz(x)是生成數據.當訓練判別器D時,希望真實數據的判別值越大越好;同時希望對生成數據的判別值logD(x)越小越好,所以log(1-D(G(z)))也是越大越好.訓練中使用梯度上升,使價值函數的值越來越高.同理,當訓練生成器G時,希望價值函數的值越小越好,即使用梯度下降來訓練生成器的參數.其結構如圖1所示.

圖1 GANs的結構[13]Fig.1 Structure of GANs[13]

2.2 GAN模型變體

與其他生成式模型[14,15]相比較,生成對抗網絡可以比其他模型產生更好的樣本(圖像更銳利、清晰).與PixelRNN[14]相比,GAN生成一個樣本的運行時間更短.與VAE(Variational AutoEncoders)[15]相比,GAN在理論上可以漸進地逼近任意概率分布,克服了VAE最終模擬的結果必然存在偏置的問題.但是GAN依然存在不收斂、模型過于自由不可控和崩潰問題.鑒于此,對GAN提出了一些改進[16-25].

2.2.1 cGANs

區別于其他生成式模型,GAN的生成器使用一種分布直接進行采樣而無需預先建模,從而真正實現理論上完全擬合真實數據分布,這是GAN最大的優點.然而簡單GAN的方法對尺寸較大的圖像無法進行有效控制,為了穩定GAN,自然想到給GAN增加條件約束,于是便產生了Conditional Generative Adversarial Nets(CGAN)[16].cGANs的結構如圖2所示.在生成模型(G)和判別模型(D)的建模中均引入條件變量y,使用額外信息y對模型增加條件,可以指導數據生成過程.這些條件變量y可以基于多種信息,例如類別標簽,用于圖像修復的部分數據,來自不同模態的數據.如果條件變量y是類別標簽,可以視為CGAN將無監督的GAN變成有監督模型的一種改進.經過證明,這個改進是十分有效的,并在后續的相關工作[17,25,31]中得到了廣泛的應用.Mehdi Mirz等[16]的工作是在MNIST數據集上以類別標簽為條件變量,生成指定類別的圖像.

圖2 cGANs的結構[13]Fig.2 Structure of cGANs[13]

2.2.2 卷積GANs

卷積神經網絡在有監督學習的各項任務中大放異彩,但在無監督學習領域應用卻較少.LAPGAN(Laplacian Generative Adversarial Networks)[17]是建立在GAN和cGAN基礎上的成功嘗試,由具有K層的拉普拉斯金字塔框架的卷積GAN級聯構成.拉普拉斯金字塔頂端用來訓練普通的GAN,生成器輸入只有噪聲.而后像素更高的圖像用來訓練cGAN,輸入不僅有噪聲,還有同級高斯金字塔的圖像經過上采樣后得到的圖像.正是由這種粗糙到精細的方式,使得LAPGAN能夠產生更高分辨率的圖像.

另外,Radford等人[18]將有監督學習中的CNN與無監督學習中的GAN結合到了一起,提出了一種稱為DCGAN(Deep convolutional GAN)的網絡結構.該網絡由四個卷積層作為鑒別器,其實質就是一個沒有pooling的全卷積網絡.DCGAN能有效地學習物體的特征,且在訓練過程中表現更加穩定.

2.2.3 WGAN

與DCGAN[18]不同,WGAN[19]從損失函數的角度對GAN做出了改進,損失函數改進置換即使在全連接層上也能得到很好的結果.WGAN理論上給出了GAN訓練不穩定的原因,即交叉熵(Jensen-Shannon divergence)不適合衡量不相交部分的分布的距離,轉而使用Wassertein距離去衡量生成數據分布和真實數據分布的距離,解決了訓練不穩定和模式崩潰的問題.實際上,WGAN沒能完全解決GAN訓練穩定性問題, WGAN中采用Lipschitz限制的方法需要把判別器參數絕對值截斷到不超過固定常數c.對此Gulrajani提出了WGAN-GP[20],更換了梯度懲罰,判別器能學到合理的參數取值,解決了WGAN收斂緩慢的問題.

2.2.4 其他模型

Chen等[21]將信息理論與GAN相結合提出了InfoGAN模型.該模型將噪聲z的具體維數與數據的語義特征相關聯推導出可解釋的特征,實現了對噪聲z的高效利用.Improved GAN[22]提出了對于GANs新的結構和訓練過程:特征匹配;最小批量判斷;歷史平均;單邊標簽平滑;虛擬批量歸一化.Yu等[23]將GAN與RNN(Recurrent Neural Network)結合提出了SeqGAN,解決了GAN的輸出為連續實數分布而無法產生離散空間的分布的問題.Mao等[24]提出了LSGAN(Least Squares Generative Adversarial Networks),其使用最小二乘損失函數代替GAN的損失函數,緩解了GAN訓練不穩定和生成圖像質量差及多樣性不足的問題.ACGAN[25]和Improved GAN[22]利用標簽信息,可生成更高質量的圖片,穩定性良好.更進一步地,Zhou等[26]以ACGAN和Imporved GAN為基準提出了AMGAN( Activation Maximization Generative Adversarial Network),AMGAN可看做是Improved GAN和輔助分類器的組合.作者提出的AM評分可用于樣本質量度量,并證明Inception Score可用于多樣性度量.AMGAN優于其他模型[20,23,25],并在Cifar-10獲得了最高的評分(8.91).訓練模型時利用標簽信息,表1給出了各種模型的從屬類別.

表1 各網絡模型類別Table 1 Category of each network model

3 訓練方法

3.1 隨機梯度下降

考慮到進行優化的函數:

其中,參數w用于估計Q(w)的最小值,Qi為數據集的第i個觀測值.

與標準的梯度下降算法在整個訓練集上更新目標函數的參數不同,隨機梯度下降(Stochastic gradient descent,SGD)僅使用單樣本來更新和計算參數的梯度,因此我們可以頻繁地更新權重,使其快速收斂.

w:=w-η▽Qi(w)

其中η是學習率,▽Qi(wt)是Qi相對于w的梯度.SGD通常用于小批量,一般包含少量數據點.在實踐中通常采用動量法,以加速SGD收斂.SGD算法的其他擴展如Adagrad,Adadelta和Adam都可以很好地訓練深度網絡.

3.2 反向傳播

4 應 用

4.1 圖像合成

生成對抗網絡在圖像處理方面最廣泛的應用之一就是圖像合成:Reed等[7]首次提出利用GAN實現文字描述合成圖像,它以DCGAN[18]作為基礎模型,實現了輸入“粉色花瓣的花”,輸出包含這些要素的圖像;Behnza[8]的研究能夠學習語義上有意義的面部表征,并在二元交互中生成適當的面部表情.

4.1.1 圖像補全

圖像補全旨在合成圖像總缺失或損壞的部分.Pathak等[27]首次提出將GAN應用于圖像補全,提出深度GANs模型(Context Encoder).該模型結合Encoder-Decoder網絡和GAN,以完全無監督的方式進行訓練,Encoder-Decoder部分用于學習圖像特征和生成圖像待修補區域對應的預測圖,GAN部分用于判斷生成圖像來自訓練集或預測集的可能性,當生成的預測圖與ground truth在圖像內容上達到一致,并且GAN的判別器無法判斷預測圖是否來自訓練集或預測集時,則模型參數達到最佳值.但是此模型存在的弊端是其全連接層不能保存精確的空間信息.對此,Li等[28]提出上下文感知語義修補方法CASI,將圖像上下文輸入全卷積生成網絡,圖像缺失區域使用掩碼操作進行填充,然后通過合成操作將其放置在圖像上下文中.

與文獻[27]方法類似,Yeh[29]使用DCGAN[18]實現圖像補全,并使用Adam進行優化,能成功預測缺失區域的信息,還原度較高.Yang[30]提出了一種基于圖像內容和紋理約束的圖像合成方法,可以通過建模全局內容約束和卷積神經網絡的局部紋理約束來合成缺失的圖像區域.缺點是迭代速度慢.

4.1.2 圖像風格轉換

人眼能夠很有效地的辨別出不同畫家不同流派繪畫風格這種很抽象的東西,而多層網絡的實質其實就是找出更復雜、更內在的特性.圖像風格轉換同樣分為有監督和無監督的方式.

想要將草圖生成理想圖像,需要添加細節信息(顏色、紋理等).Isola等[31]對cGAN作出了改進:在目標函數中加入了L1約束項(用于約束生成圖片和原始圖片偏差不至于太大);生成器中用U-net結構代替ecoder-decoder;鑒別器使用PatchGAN[32]的判別方式(在圖像的每個N×N塊上去判斷是否為真).但是,基于cGAN[16]提出的模型必須要求成對數據(paired data),Zhu等[33]提出了一個不成對(unparied data)的圖像到圖像轉換模型—CycleGAN,解決了模型需要成對數據進行訓練的難題.該模型架構基于[34],由兩個生成器和兩個判別器構成,其中生成器包括編碼器、轉換器和解碼器,鑒別器屬于卷積網絡,需要從圖像中提取特征.在具體實現時,采用生成質量更高的LSGAN[24]替換原始GAN使訓練過程更加穩定,對Dx,Dy進行滯后更新避免模式震蕩.然而,CycleGAN對非成對圖片集的成功轉換集中在色彩和貼圖轉換上,諸如幾何形態上的上的轉換(如貓→狗)大多沒有成功.Perera等[12]將無監督圖像到圖像的轉換問題擴展到多個輸入設置,將來自多個模態的配對圖像作為輸入并轉換到指定域.Xian等[11]提出可以由草圖生成理想圖像的TextureGAN,用戶將示例紋理“拖”到場景中的草圖,系統即可自動填充該目標區域的紋理.TextureGAN使用的是文獻[35]的網絡架構,但其重新定義了特征損失和對抗損失,并引入新的損失(風格損失、像素損失、顏色損失)來改善紋理細節.

4.1.3 3D圖像生成

生成對抗網絡可用于3D圖像的生成,受文獻[18]的啟發,Wu等[36]結合對抗網絡和傳統的體積卷積網絡提出了3D-GAN模型.3D-GAN在3D數據上進行訓練,其生成器包含5個體積全卷積層,它從概率潛在空間隨機采樣生成對象,鑒別器判斷輸入對象的真偽.Gadelha等[37]提出的投影生成對抗網絡(PrGANs)可以從2D圖形集合中學習3D形狀的概率分布,此模型包括3D形狀生成器,視點生成器,投影模塊和鑒別器.其中,判別器僅顯示2D圖像,投影模塊捕獲3D表示,并在傳遞給判別器之前將其轉換為2D圖像.不斷迭代訓練周期,生成器通過改進生成的3D體素形狀完善投影效果.

4.2 圖像分類

早期GAN模型主要應用于無監督學習,而將GAN應用到分類問題時,需要對網絡做改動,Improved GANs[22]屬于半監督分類方法.Luc等[38]訓練了一個CNN語義分割網絡(用于對單幅圖像進行基于像素的分類)和一個對抗網絡(用于區分標簽圖和預測出來的概率圖)實現對圖像內容的分類,具體操作是先將分割網絡的兩種訓練圖片輸入對抗網絡中,再用sigmoid函數進行二分類,文中提出的混合損失函數,就是將交叉熵損失和GAN的損失結合起來.文獻[38]屬于有監督分類方法.

4.3 圖像超分辨率

超分辨率是從觀測到的低分辨率圖像重建出相應的高分辨率圖像,訓練后的模型可以生成照片般逼真的細節.但生成對抗網絡生成的圖片質量不是很好,Ledig等[39]針對這一問題作出優化,用參數化的殘差網絡表示生成器,用VGG分類網絡作為判別器.此外,作者提出了一個全新的損失函數,該損失函數包括兩部分:對抗損失(adversarial loss)與內容損失(content loss).其中,內容損失可被看作為重建的高分辨率圖像和原始高分辨率圖像之間特征圖(feature map)的歐式距離(Euclidean distance)損失.由于這一全新損失函數使用,生成對抗網絡能夠恢復降采樣后的圖像的生動紋理和小顆粒細節,使超分效果更接近人的視覺感受.然而,VGG網絡無法捕捉超分辨率任務中所需的高頻細節,對此,Wu等[40]提出一個新的框架—SRPGAN.首先使用雙三次插值對低分辨率圖像進行縮放,經過生成器的編碼與解碼后,生成高分辨率圖像.將真實圖像和生成圖像分別輸入鑒別器并提取特征,得到對抗損失和感知損失,最后將兩種損失函數與內容損失結合,從而得出D和G的總目標函數.從實驗結果可以看出,SRPGAN[40]在細節恢復方面超越了SRGAN[39].

4.4 其他應用

4.4.1 醫學圖像

Dong Nie等[41]首次將GAN框架應用于合成醫學圖像領域,提出通過三維全卷積神經網絡(3D FCN)學習從MR(magnetic resonance)圖像到CT(Computed Tomography)圖像的非線性映射,并將3D FCN作為GAN中的生成器.為生成更加逼真的CT圖像,除傳統的重建誤差損失之外又增加了一個對抗性損失項.此外,作者采用Auto-Context Model(ACM),為使ACM具有上下文感知能力,其每個階段都使用GAN架構進行訓練.結果表明,3D GAN模型顯著優于當前三種先進的模型(Atlas,SR,SRF+),不僅如此,此模型還可以應用于諸如超分辨率、圖像去噪等涉及醫學圖像分析生成的其他任務中.

GANCS[42]是一種新型的CS(compressed sensing)框架,它采用LSGAN[24]學習紋理細節,并使用l1逐像素損失來控制高頻噪聲.GANCS結合了生成對抗網絡的優勢,用于MRI(Magnetic Resonance Imaging)重建有良好的效果.SegAN[43]是一種新型端到端對抗神經網絡,旨在分割醫學圖像.SegAN使用全卷積神經網絡作為分割器來生成預測的分割圖像,并提出具有多尺度L1損失函數的對抗批評網絡,對抗批評網絡最大限度地挖掘生成的分割圖像和ground truth之間的特征差異,使分割器能夠準確地學習ground truth分割對抗的特征.

4.4.2 圖像安全

圖像隱寫術可以保證圖像的安全,Denis等[44]提出將DCGAN[18]模型應用于圖像隱寫問題.此文考慮的是從文本到圖像的嵌入,并引入了隱寫生成對抗網絡模型SGAN.SGAN包含三部分:生成器網絡G、鑒別器網絡D和隱寫分析網絡S(steganalyser,確定圖像是否包隱藏的秘密消息),但它僅適于使用相同的密鑰嵌入.與現有采用DCGAN的工作不同,Shi等人基于WGAN[19]提出了SSGAN[45],它解決了文獻[44]存在的問題,更適合隨機密鑰嵌入.另外,此模型生成的圖像更加高質.

傳統的隱寫術會使原圖像發生改變,為克服這一弊端,Liu等[46]提出了基于ACGAN[25]無覆蓋信息隱藏方法.首先構建代碼字典進行文本信息K到類別標簽C的映射,然后生成加密圖像以實現信息的隱藏,最后由鑒別器提取加密信息.實驗表明此方法能夠有效抵抗現有隱寫分析算法的檢測,并且其隱藏通信具有良好的可靠性和安全性.但由此產生的圖像不夠清晰,仍需進一步的改進,下一步可以考慮使用更復雜的Wasserstein GAN[19]構建更逼真的圖像.

4.4.3 視頻預測

視頻預測是指對于給出的靜態圖片或者一段連續視頻幀Z1,Z2,…,Zn,可以預測隨后的視頻幀Zn+1,Zn+2,…,Zn+t(t為需要預測的幀的數量).Mathieu等[47]將生成對抗網絡擴展到視頻處理領域,采用對抗網絡進行視頻幀預測,擬解決使用l1或l2損失函數造成的圖像模糊問題,使預測的圖像更加銳利.此外,文中將生成器的損失函數定義為對抗損失、l2損失與圖像梯度差分損失的加權和.Vondrick和Torralba[10]提出了一個通過變換現有幀中像素來生成未來幀的模型.文獻[9]在DCGAN的基礎上提出“two streams”架構[48]視頻預測模型,雙流指的是靜止的背景流和移動的前景流,它們之間相互獨立,其中,單流架構由時空卷積和反卷積組成,雙流架構可以對靜態背景和動態前景建模.該模型中生成網絡輸入的是低維的潛在編碼向量,輸出高維視頻,判別網絡的任務是判別生成場景和真實場景,同時識別視頻幀間的運動.作者從Flickr下載超過200萬條視頻進行模型的訓練,激活函數采用ReLU,模型訓練完成后,可以從單副圖像上直接預測32幀(64×64分辨率)圖像,經測試,其中有20%的人認為這些生成的視頻是真實的.

5 結束語

GANs作為無監督生成模型一個強大的算法框架,已經在計算機視覺領域得到了廣泛應用.相比于傳統的生成式網絡模型,GANs可以從潛在空間和數據之間的映射和逆映射中學習高度非線性的映射,克服了需要依賴真實數據的缺點,由此生成模型能夠生成合理的圖像.憑借深度神經網絡的強大功能,改進GAN并將GAN應用于各種領域仍有巨大的機會.