一種用于卷積神經網絡壓縮的混合剪枝方法

靳麗蕾,楊文柱,王思樂,崔振超,陳向陽,陳麗萍

(河北大學 網絡空間安全與計算機學院,河北 保定 071002)

1 引 言

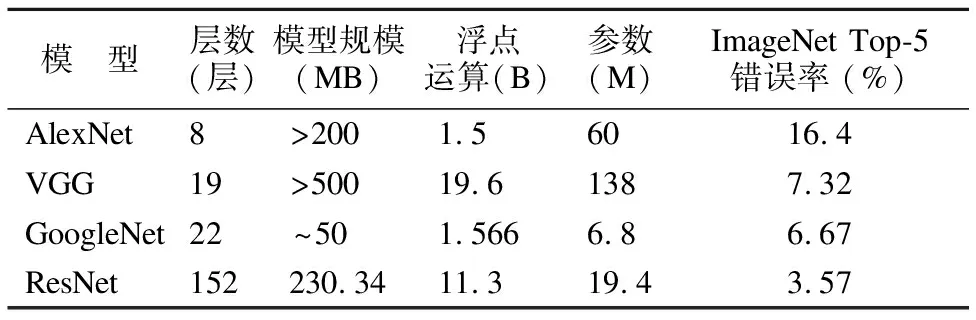

近幾年,卷積神經網絡(Convolutional Neural Network,CNN)作為深度學習中的經典模型,在圖像分類、目標檢測和語義分割等諸多領域取得了一系列的研究成果.自2012年深度學習算法在識別精度方面表現出巨大優(yōu)勢后,各種深度學習模型便相繼涌現.但是這些模型在不斷逼近計算機視覺任務精度極限的同時,其模型深度和參數也在成倍增長,使得這些模型很難應用于資源受限的設備.由表1[1-4]可以看出,CNN的層數越來越多,使得其計算復雜度越來越高,而過高的計算復雜度要使用GPU或者更高性能的CPU實現神經網絡運算.由于手機等移動設備、車載嵌入式設備等存在計算能力、存儲容量等諸多方面的約束,現有的深度神經網絡無法在這些資源受限設備上進行很好的部署使用.目前模型壓縮的關鍵就是如何在保持現有神經網絡性能基本不變的情況下,通過減小網絡的計算量和網絡模型存儲,使其能在資源受限的設備上高效運行.因此,模型壓縮與加速受到學術界和工業(yè)界的極大關注,其中合理有效地修剪冗余參數最具挑戰(zhàn)性.

自AlexNet[1]在2012 ILSVRC上取得突破性成果后,越來越多的研究人員開始研究CNN模型.最具代表性的CNN模型,如VGG[2],GoogLeNet[3],ResNet[4]和DenseNet[5],大大提高了模型精度.其中,VGG網絡的卷積層占據了大約 90-95% 的計算時間和參數規(guī)模;全連接(FC)層占據了大約 5-10% 的計算時間和95% 的參數量,這為研究深度模型的壓縮提供了統(tǒng)計依據.深度神經網絡在各種計算機視覺任務中(比如遙感圖像的分類[6])都非常有效,但由于參數過多難以部署在手機等資源受限的設備上.

表1 幾種經典卷積神經網絡模型的對比Table 1 Comparison between some CNN models

剪枝是用于降低網絡復雜度、加速網絡模型的有效方法,可以在幾乎不損失模型精度的前提下移除網絡中的冗余參數,達到模型壓縮的目的.20世紀90年代,LeCun等人[7]便提出了Optimal Brain Damage方法對模型進行剪枝,有效降低了網絡復雜性并緩解了過擬合問題.神經網絡中包含很多參數,但有些參數對最終輸出的貢獻很小,可以認為這些參數是冗余的.因此,需要找到有效的評估方法,對不重要的參數進行剪枝以減少模型參數冗余.Han等人[8]提出了一種簡單的剪枝方法,不會損失準確性;其主要思想是移除權重低于指定閾值的所有連接.雖然這個方法稀疏度很高,但在實際加速中其效果有限.卷積核剪枝可以解決該方法的局限性,有效實現模型壓縮與加速.但在模型壓縮時,單獨使用權重剪枝或卷積核剪枝得到的網絡仍然存在參數冗余.本文提出了一種結合權重剪枝和卷積核剪枝的混合剪枝方法,以實現最大限度的模型壓縮.

2 相關工作

為了提升網絡的性能,深度卷積神經網絡在增加深度的同時,極大增加了參數量.Denil等人[9]證明了卷積神經網絡可以用它原始參數的一個子集進行有效的重建,表明網絡中存在參數冗余問題.目前有很多不同的模型壓縮與加速方法,大致可以分為五類:新型網絡模塊設計、知識蒸餾、低秩分解、量化、剪枝.

關于新型網絡模塊設計的研究有很多,比如SqueezeNet[10],MobileNet[11]和ShuffleNet[12].基于更細致更高效的原則設計新型網絡模型有效減小模型尺寸且有良好的性能,但設計新的網絡結構對技巧和經驗要求較高.Lei等人[13]基于知識遷移[14]提出了知識蒸餾(Knowledge Distillation,KD)方法,該方法在保持一定性能的前提下將深層網絡壓縮成較淺的網絡,有效降低了計算量;但它只能用于具有SoftMax 損失函數的分類任務,且模型假設有時過于嚴格,導致在性能方面無法與其它方法競爭.權重矩陣分解利用網絡中計算單元的矩陣來實現信息重組,達到網絡壓縮的目的.網絡模型中,每層的權重都可以通過該層的權重子集進行精確預測,可使用奇異值分解(SVD)[15]來對每一層進行低秩近似.然而,低秩分解技術已經很成熟,并且現在越來越多網絡中采用諸如1×1、3×3這樣的小卷積核,而對這些小卷積核用矩陣分解的方法很難實現網絡加速和壓縮;另外,目前的分解方法都是逐層執(zhí)行低秩近似,無法執(zhí)行全局參數壓縮.嵌入式處理器由于位寬和性能的限制,導致常規(guī)的計算需求在該環(huán)境下難以得到滿足.面對這種情況,在保證網絡模型精度的同時對網絡中的權重數據使用量化方法已成為一種趨勢,但由于實現難度大、準確性不穩(wěn)定等問題導致量化方法使用門檻較高.

剪枝方法被廣泛應用于壓縮CNN模型.Srinivas等人[16]研究了神經元之間的冗余問題,并提出了一種無數據剪枝方法.Chen等人[17]提出了一個HashedNets模型,使用低成本的散列函數將權重分組為哈希表進行參數共享.Han等人[18]提出了“Deep Compression”方法,主要包括參數剪枝、量化和霍夫曼編碼.Ullrich等人[19]提出了一種基于軟權重共享的簡單正則化方法.韓等人[20]提出了網絡刪減、參數共享相結合的壓縮方案.對于已經訓練好的模型,可以找到一種有效的評估方法,對不重要的卷積核進行剪枝以減少模型冗余,這是目前模型壓縮中使用最多的方法.Li等人[21]基于權重的大小提出了一種簡單的剪枝方法來衡量每個卷積核的重要性,對每個卷積核中所有權重的絕對值求和作為該卷積核的評價指標.Hu等人[22]定義零的平均百分比APoZ(Average Percentage of Zeros)來衡量每一個卷積核中激活函數值為零的數量,作為評價卷積核重要與否的標準.這兩個標準簡單明了,但與最終損失沒有直接關系.因此,Molchanov等人[23]采用泰勒展開式來近似的計算移除每個卷積核對損失函數的影響程度.Luo等人[24]認為難以通過權重大小判定每個卷積核的重要性,提出了基于熵的剪枝方法.Luo等人[25]在基于熵的剪枝方法基礎上進行改進,設計出了效果更優(yōu)的 ThiNet框架.該框架利用下一層的統(tǒng)計信息指導當前層的剪枝,在不改變原網絡結構的前提下實現模型的加速與壓縮.

基于模型剪枝的方法很多,其主要思想都是挑選出模型中不重要的權重或卷積核將其移除.移除不重要的權重或卷積核后,通過再訓練來恢復模型的性能,這樣就可以在保證模型性能的前提下,最大程度的壓縮模型參數,實現模型加速.該類方法中,如何找到一個有效衡量權重或卷積核重要性的標準是關鍵問題.

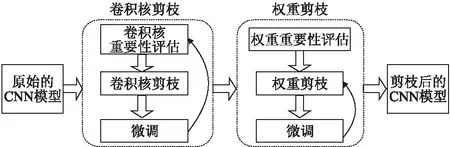

3 CNN混合剪枝方法

對CNN進行剪枝能夠有效降低它的參數量和運行需要的計算開銷,解決CNN模型難以應用于資源受限設備的問題.對于權重剪枝,去掉低于閾值的權重連接,通過再訓練恢復模型精度,最后可以得到一個稀疏模型.卷積核剪枝可以保持原始的網絡模型不被改變,也不需要額外的深度學習庫支持.為了得到更好的壓縮效果,綜合考慮卷積核剪枝與權重剪枝兩種方法,提出了混合剪枝方法.

3.1 CNN混合剪枝的框架

給定一個原始網絡,首先刪除重要性低的卷積核來進行卷積核剪枝;然后,使用權重剪枝實現進一步壓縮.與原始CNN相比,剪枝后的CNN具有更少的卷積核和權重.混合剪枝的框架如圖1所示.

圖1 網絡混合剪枝的框架圖Fig.1 Framework of mixed network pruning

3.2 卷積核剪枝

卷積核剪枝包括以下四個步驟:

1)評估卷積核的重要性.主要思想是使用i+1層的統(tǒng)計信息來指導i層的剪枝,使用i+1層輸入的子集近似i+1層的輸出.

2)剪除不重要的通道及其相對應的卷積核.i+1層輸入中的通道由i層中的卷積核產生,因此可把i+1層不重要的通道和相應i層的卷積核安全地移除.

3)剪枝后會損壞模型的泛化能力,將整個網絡微調一遍或兩遍恢復其性能.

4)最后,判斷剪枝是否結束.如果剪枝停止,可微調多次獲得更準確的模型.否則,重復步驟(1)-(3)繼續(xù)對下一層進行剪枝.

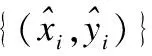

針對網絡模型的第i+1層進行壓縮,使用第i+1層的輸入,即第i層的輸出來模擬其輸出的線性過程.如果通過優(yōu)化的方法可以找到對于第i+1層的輸入中線性組合等于零的部分,并將相應的第i層輸出的卷積核舍棄掉,就可以利用較少的輸入得到相似的輸出,即在盡量不影響模型效果的前提下實現壓縮模型.尋找線性組合的值接近于零的具體過程包括收集訓練樣本、用于通道選擇的貪心算法、最小化重構誤差等優(yōu)化方法.

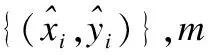

3.2.1 收集訓練集

收集訓練集以評估通道的重要性,確定通道是否可以安全地移除.由y表示的元素從i+2層中隨機采樣.i+1層中的相應卷積核和滑動窗口也可以根據其位置來確定.

卷積運算如下式:

(1)

進一步定義如下公式:

(2)

然后,公式(1)卷積操作可以簡化為:

(3)

(4)

3.2.2 通道選擇

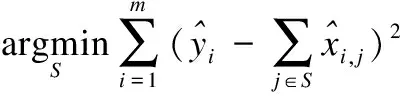

卷積核剪枝的關鍵是衡量卷積核的重要性,常用的方法包括:通過卷積結果的稀疏程度、卷積核對損失函數的影響、卷積結果對下一層結果的影響等.訓練之后,移除一些不重要的卷積核,然后每一層剪枝后微調一遍或兩遍,以便恢復模型精度.

(5)

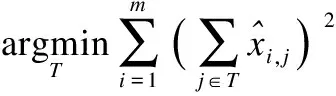

其中,|S|是子集S中元素的數量,r是預定義的壓縮率.等價的,T表示被移除通道的子集,即S∪T={1,2,…,C} andS∩T=φ,就可以最小化下面的公式6來替代公式5:

(6)

公式(6)等價于公式(5),但|T|的個數通常是小于|S|的,因此公式(6)比公式(5)更快更簡單.解決公式(6)仍然是NP難題,可以使用如算法1所示的貪心算法來解決.假設T表示已移除通道的子集,其初始值為空集.U是所有通道的集合,對于每個i∈U,通過公式6計算值,每次選擇添加一個通道使得通過當前樣本得到的誤差最小,最后獲得移除通道的子集.這種方法是局部最優(yōu)的,可通過微調來彌補這種方法造成的影響.

算法1. 貪心算法

輸出:移除通道的子集T

1.T←φ;U←{1,2,…,C};

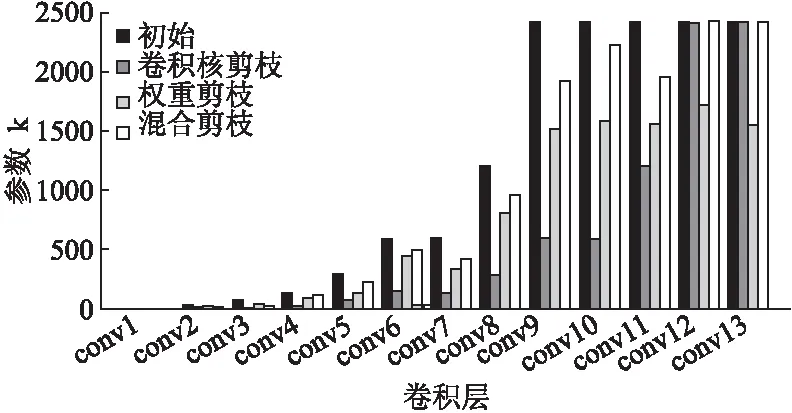

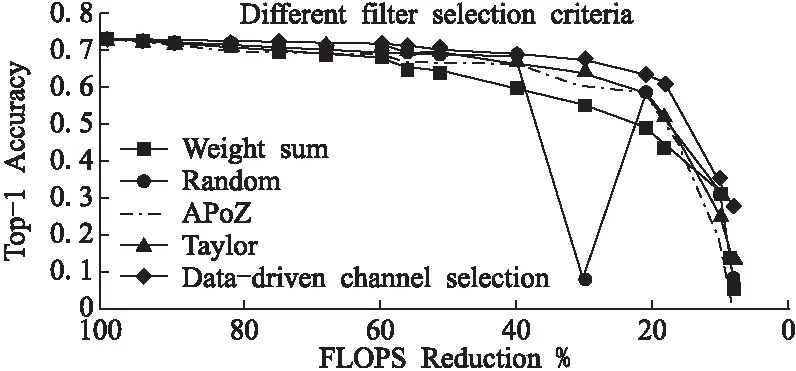

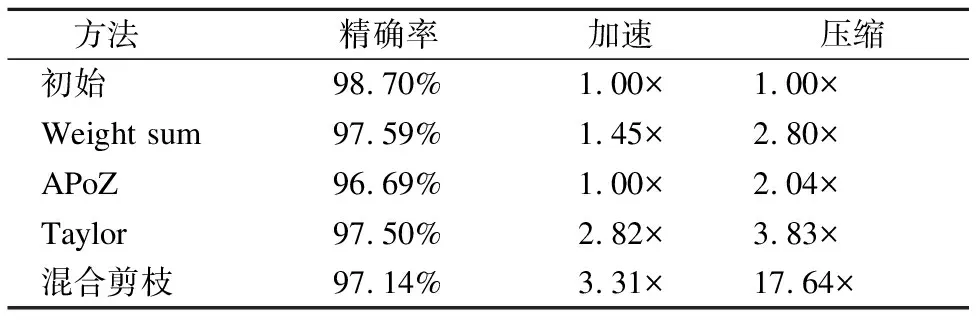

2.while |T| 3.min_value←+∞; 4. for each itemi∈Udo 5.tmpT←T∪{i}; 6. computevaluefrom Eq.(6)usingtmpT; 7. ifvalue 8.min_value←value;min_i←i; 9. end if 10. end for 11. movemin_ifromIintoT; 12.end while 3.2.3 最小化重構誤差 在確定要保留哪些卷積核之后,通過通道的加權來進一步減少重構誤差: (7) 權重剪枝包括3個步驟: 1)評估權重的重要性.正常訓練得出的權重被視為相對重要和不重要的權重. 2)設置一個閾值,將小于閾值的權重設置為零,此時網絡變?yōu)橄∈柽B接的網絡. 3)重新訓練這個稀疏網絡以獲得最終結果. 因數據量有限、訓練參數多并且訓練過度,卷積神經網絡面臨過擬合的問題,目前正則化和dropout是防止過擬合常用的兩種方法.正常訓練網絡后,得到相對重要和不重要的權重;在權重剪枝時,L1/L2正則化方法、卷積層和全連接層會具有不同的敏感度. 3.3.1 正則化 通過增加深度,網絡可以更好地近似損失函數,增加非線性,獲得更好的特征表示.然而增加深度,網絡的復雜性也會增加,使得網絡難以優(yōu)化并且更易過擬合.使用L1 / L2正則化和dropout等生成稀疏權重的方法來訓練大而密的網絡,然后刪除網絡中貢獻較小的權重,即刪掉一些冗余連接.另外,防止過擬合的最直接方法是增加使用的數據集和縮小使用的網絡結構.但是,擴大數據集并不簡單.減少網絡結構固然可以有效減少參數數量,但一般網絡越深,表達能力越強.因此,正則化和dropout的使用旨在解決過擬合的問題. L2 正則化是最常用的正則化方法,可表示為: (8) 其中C是正則化后的損失函數,C0是原始的損失函數.λ表示正則化因子.所以常用的交叉熵損失函數可以表示為: (9) 其中x代表樣本,n代表樣本總數,y是實際值,a是輸出值.由上面的公式,正則化是通過在損失函數中加入權重懲罰因子來增加損失值以減小權重.使用正則化因子調整正則化:λ越大,越傾向于減小權重;λ越小,越傾向于減小原始的損失函數.在剪枝過程的第一次訓練中,確定權重的重要與否.正則化程度將影響權重的大小,從而影響網絡中的哪些連接需要進行剪枝. 與L2正則化不同,dropout通過改變網絡結構解決過擬合的問題.在訓練期間,dropout以一定概率將某些權重隨機置為零,通過設置隨機剪枝的概率,以增加網絡稀疏性加速收斂,可按公式(10)(11)計算: Ci=NiNi-1 (10) (11) 其中Ci表示第i層的連接數,Ni表示第i層的神經元數目,Cio表示原來的連接數,Cir表示再訓練時的連接數,Do表示原始的 dropout. 3.3.2 敏感度 不同的正則化方法和不同類型的層在剪枝時具有的敏感度不同,因此它們的剪枝閾值對精確度也會有不同的影響.逐層對神經網絡進行靈敏度分析,將權重置為零后對神經網絡精度影響很小的部分.然后對權重進行排序并設置一個閾值,將低于閾值的權重重置為零,保持這些權重不變,繼續(xù)訓練直到模型精度恢復,最后重復上述過程,通過增加閾值來增加模型中零的比例. 實驗采用兩種數據集,MNIST[26]手寫數字識別和用于物體識別的CIFAR-10[27].CNN架構使用經典的LeNet-5和VGG-16.MNIST數據集有60,000個訓練集和10,000個測試集.CIFAR-10由10類60,000個32×32彩色圖像組成,每個類別有6000個圖像.有50,000個訓練圖像和10,000個測試圖像.分別與原始網絡,權重剪枝和卷積核剪枝結果進行對比,驗證混合剪枝方法的有效性.然后,將混合剪枝結果與現有方法(如APoZ,Weight sum和Taylor)進行比較.本實驗在PyTorch[28]環(huán)境下進行. 實驗中使用LeNet-5網絡,它有兩個卷積層,兩個下采樣層,兩個FC層和一個分類層,在MNIST數據集上的錯誤率為0.8%.在MNIST數據集上進行剪枝和訓練CNN.混合網絡剪枝與三個基準比較: 1)原始模型:正常訓練一個小的CNN不進行剪枝. 2)權重剪枝:移除權重低于閾值的所有連接. 3)卷積核剪枝:移除重要性低的卷積核. 使用LeNet-5網絡在MNIST數據集上評估權重剪枝方法的性能.對于網絡中低于閾值的所有權重進行剪枝獲得壓縮模型.如圖2所示,將LeNet-5上的存儲開銷與不同的壓縮比進行比較.在90%的壓縮率下最大的降低存儲代價,精度僅下降0.18%. 使用LeNet-5網絡在MNIST數據集上評估卷積核剪枝方法的性能.從收集用于通道選擇的訓練集開始,從訓練集中的每個類別中隨機選擇10個圖像構成評估集.并且對于每個輸入圖像,用不同的通道和不同的空間位置隨機采樣10個實例.因此,總共有1000個訓練樣本用于通過貪心算法找到最佳通道子集.實驗證明了這種選擇的有效性(每個類10個圖像,每個圖像10個位置),足以進行神經元重要性評估.每層剪枝后微調一遍.當所有層都被修剪完,微調10遍以獲得更高的準確度. 圖2 不同壓縮率下存儲代價的比較Fig.2 Storage overhead comparison of different compression rate圖3 LeNet-5在MNIST上參數減少的統(tǒng)計數據Fig.3 Parameters reduction statistics for LeNet-5 on MNIST 使用LeNet-5網絡在MNIST數據集上評估混合剪枝方法的性能.卷積核剪枝的主要優(yōu)點是該方法能直接影響網絡結構的大小,刪除對最后結果貢獻不大的卷積核得到的網絡可實現一定程度的壓縮.對剪枝后的模型,再進行權重剪枝實現進一步壓縮.如圖3所示,LeNet-5在MNIST上通過不同剪枝方法得到每層參數數量的對比.FC層可用全局平均池化層(global average pooling,GAP)替換,但MNIST數據集和LeNet-5網絡比較簡單,因此本實驗中保留了FC層.針對LeNet-5網絡剪枝,主要對conv2和FC1中的權重和卷積核進行剪枝操作.實驗結果表明,與僅進行權重剪枝或卷積核剪枝相比,所提出的混合網絡剪枝方法可以顯著減少參數的數量. 表2 剪枝前后LeNet-5模型的性能變化Table 2 Performance changes of the LeNet-5 model before/after pruning 如表2所示,剪枝前后的LeNet-5模型的性能變化.對于LeNet-5模型,使用權重剪枝雖然可以實現較好的壓縮效果,但是沒有加速效果.使用卷積核剪枝,可以實現壓縮與加速,但是壓縮效果與權重剪枝相比效果略差.而使用所提出的混合剪枝方法可以實現13.01×壓縮和3.23×加速. VGG-16是一個16層的CNN,有13個卷積層和3個FC層,在CIFAR-10數據集上進行剪枝和訓練CNN.與4.1節(jié)類似,提出的混合剪枝方法與三種基準在cifar10數據集上進行對比實驗. 使用VGG-16網絡在cifar10數據集上評估權重剪枝的性能.創(chuàng)建和VGG-16相同的架構,但將掩碼和閾值變量添加到需要進行剪枝的層.變量掩碼與網絡層的權重張量具有相同的形狀,確定哪些權重參與圖的正向執(zhí)行.然后,將操作添加到訓練圖中,該圖監(jiān)視層中權重大小的分布并確定層閾值,掩蓋低于該閾值的所有權重,達到當前訓練步驟所需的稀疏度水平. 表3 剪枝前后VGG-16模型的性能變化Table 3 Performance changes of the VGG-16 model before/after pruning 使用VGG-16網絡在CIFAR-10數據集上評估卷積核剪枝方法的性能.CIFAR-10數據集包含從10個類別中抽取的50,000個訓練圖像.收集用于通道選擇的訓練集,然后從訓練集中的每個類別中隨機選擇10個圖像以構成我們的評估集.總共有1000個訓練集用于通過貪婪算法找到最優(yōu)通道子集.微調期間,網絡每修剪一層后微調一遍.當所有層都被剪枝后,微調15遍以恢復準確性. 圖4 VGG-16在Cifar10上每層參數減少統(tǒng)計Fig.4 Parameters reduction statistics for VGG-16 on Cifar10 使用VGG-16網絡在cifar10數據集上評估混合剪枝方法的性能.首先移除不重要的卷積核,再對剪枝后的模型進行權重剪枝實現進一步的壓縮.如圖4所示,VGG-16在Cifar10數據集上通過不同剪枝方法得到每層參數剪枝數量的對比.結果表明,與僅使用權重剪枝或卷積核剪枝相比,所提出的混合剪枝方法顯著減少了參數的數量.VGG-16網絡的卷積層占有約90%的浮點運算,而FC層有89.36%的參數.出于模型加速的考慮,使用GAP層替換FC層會更簡單有效.剪枝前后的VGG-16模型的性能變化如表3所示.與其它基準相比,混合剪枝方法可以實現更好的壓縮與加速.對于VGG-16模型,使用所提出的混合剪枝方法可以實現19.20×壓縮和3.31×加速. 針對不同的卷積核選擇方法,在Dogs vs.Cats Kaggle數據集上對其性能進行實驗評估,該數據集包含25000張狗和貓的圖像.出于加速的考慮,使用GAP層替換FC層.因此,VGG-16中的所有FC層都將被刪除并在新數據集上進行微調.然后,在獲得該微調模型之后,以不同的壓縮率逐層對網絡剪枝.每一層剪枝之后微調一遍,最后一層剪枝完微調15遍以提高準確性,使用不同的卷積核選擇策略重復該過程若干次.除了卷積核選擇標準外,其它所有設置均保持不變.在Dogs vs.Cats Kaggle數據集上針對不同卷積核選擇標準的剪枝結果,如圖5所示. 圖5 不同卷積核選擇標準的性能比較Fig.5 Performance comparison of different filter selection criteria 與其他選擇方法相比,Data-driven通道的選擇標準幾乎在整個剪枝比的范圍內性能最優(yōu).與Data-driven的通道選擇標準相比,泰勒標準性能稍差.Random選擇標準表現出相當好的性能.但是,這個標準魯棒性不好,并且在壓縮所有層之后精度非常低,在實踐中并不適用.Weight sum標準由于它只考慮權重的大小,具有相當差的精度.實際上,去除大量小的卷積核也會對精度產生很大影響. 表4 在VGG-16上與現有方法的比較Table 4 Comparison with existing methods on VGG-16 將所提出的方法與幾種現有剪枝方法進行比較,結果如表4所示.APoZ旨在減少參數數量,但其性能有限.相反,Taylor旨在模型加速,并且只對卷積層進行剪枝.但計算過程可能非常耗時,因此他們使用Taylor展開來近似剪枝的優(yōu)化問題.我們在Data-driven的通道選擇方法基礎上進行權重剪枝,最后得到的結果優(yōu)于其他方法. 在模型壓縮中,單獨使用權重剪枝或卷積核剪枝,壓縮后的卷積神經網絡仍然存在參數冗余問題,因此提出了一種結合卷積核剪枝和權重剪枝的混合剪枝方法.通過刪除不太重要的卷積核,達到壓縮網絡的初步目的;對剪枝過的模型再進行權重剪枝實現進一步的模型壓縮;剪枝過程中通過重新訓練來恢復模型精度.實驗結果表明,提出的混合剪枝方法可以有效減少CNN中存在的參數冗余,實現了網絡加速.進一步的工作將在更深的神經網絡上進行實驗以觀察模型壓縮的綜合性能.

3.3 權重剪枝

4 實驗結果及分析

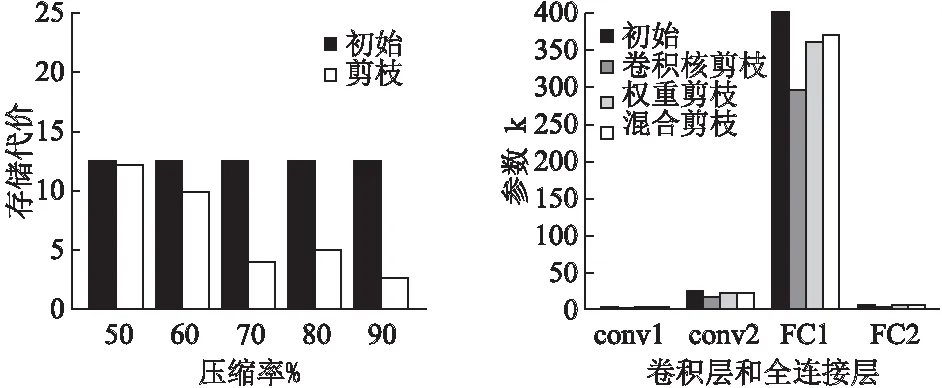

4.1 LeNet-5剪枝結果與分析

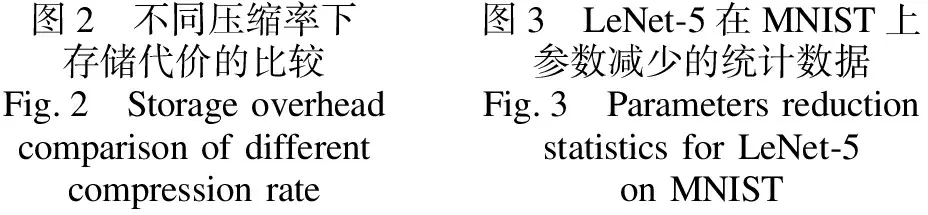

4.2 VGG-16剪枝結果與分析

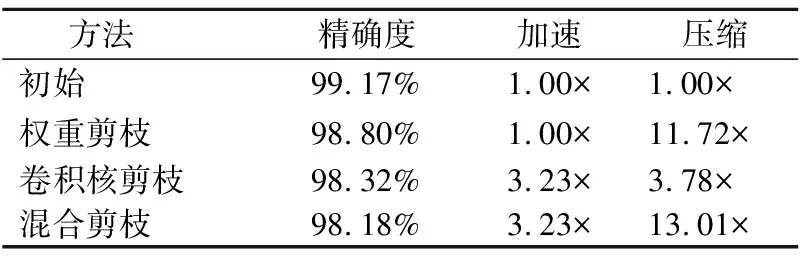

4.3 對比現有方法

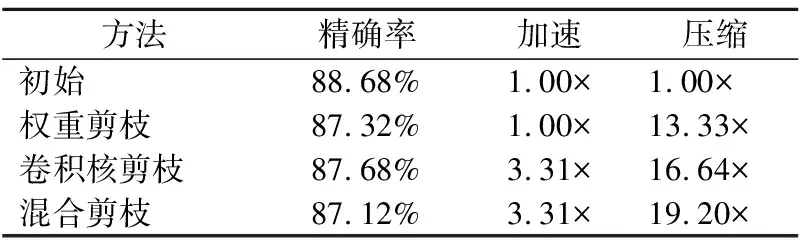

5 結 論