聯(lián)合字典魯棒稀疏表示的多聚焦圖像融合

楊 勇,吳嘉驊,黃淑英,闕 越

1(江西財經(jīng)大學 信息管理學院,南昌 330032) 2(江西財經(jīng)大學 軟件與通信工程學院,南昌 330032) E-mail:greatyangy@126.com

1 引 言

由于CCD設(shè)備中的光學透鏡的景深有限,光學成像系統(tǒng)通常無法獲得場景中所有目標都聚焦的圖像.這一問題可以通過圖像融合技術(shù),更精確地來說是多聚焦圖像融合技術(shù)來解決,該技術(shù)能將具有不同焦點的多幅圖像融合成一幅所有對象均完全聚焦的圖像[1].融合結(jié)果可以更準確、全面地描述圖像的場景,有效地提高了多聚焦圖像的利用率.

近十年來,多聚焦融合技術(shù)發(fā)展迅速,現(xiàn)有的融合技術(shù)通常分為空間域的方法和變換域的方法.空間域的方法擁有直接融合源圖像聚焦區(qū)域的優(yōu)點,但是高度依賴于清晰度測量標準的選擇,比如圖像的梯度能量、標準差或空間頻率等[2,3].由于結(jié)構(gòu)信息不能由單個像素來表示,基于區(qū)域的融合方法可以有效地從源圖像中提取聚焦區(qū)域.Li利用摳圖技術(shù),來獲得每個源圖像的聚焦區(qū)域[4].然而,由于摳圖技術(shù)的性能不穩(wěn)定,該方法所得到的聚焦區(qū)域的邊界并非完全可靠.考慮到相鄰像素的灰度相似度與幾何相似度,Kumar使用了交叉雙邊濾波器對多聚焦圖像進行融合[5].然而,這種技術(shù)的普適性不能令人滿意,因為該方法的濾波窗口的大小不能自適應地調(diào)整.近幾年來,許多基于梯度信息的空間域融合方法被提出[6-8].這些方法克服了融合圖像的塊效應,但是融合的結(jié)果不穩(wěn)定,邊緣的過渡也不自然.

基于變換域的融合方法通常將源圖像轉(zhuǎn)換到另一個頻率域進行處理,這使得源圖像可以被有效地融合[9].這類融合方法的關(guān)鍵在于圖像多尺度分解工具的選取和融合規(guī)則的制定[10].然而,現(xiàn)有的方法并不能表征圖像的所有幾何特征.舉例來說,雖然小波變換[11]、輪廓波變換[12]、曲波變換[13]和剪切波變換[14]可以很好地表示各自的結(jié)構(gòu)信息,但也只能提取有限的方向信息,不能精確地提取完整的輪廓.這將導致偽吉布斯現(xiàn)象等影響圖像融合效果的副作用產(chǎn)生.雖然非下采樣輪廓波變換(NSCT)具有良好的平移不變性,避免了偽吉布斯現(xiàn)象[15],但這種融合方法的計算復雜度非常高,占用內(nèi)存較多,運行時間過長,限制了該方法的實際應用[16].此外,在圖像逆變換的過程中可能導致一些有用的源圖像信息丟失,對最終的圖像融合效果有一定的影響.

卷積神經(jīng)網(wǎng)絡(Convolutional Neural Networks,CNNs)是近年來十分熱門的一種深度學習模型,也是第一個在圖像領(lǐng)域各個方面真正獲得成功的深度架構(gòu)[17].文獻[18]首次將卷積神經(jīng)網(wǎng)絡應用于多聚焦圖像融合,該方法利用清晰圖像以及模糊圖像訓練卷積神經(jīng)網(wǎng)絡,并通過該網(wǎng)絡得到融合決策圖.但由于該方法是對圖像塊進行標記訓練,可能導致聚焦與非聚焦區(qū)域之間的邊界不準確.與卷積神經(jīng)網(wǎng)絡類似,由于在圖像去噪、圖像分類、人臉識別等方向上的成功應用,稀疏表示(SR)成為近年來計算機視覺領(lǐng)域的研究熱點之一[19].在圖像融合領(lǐng)域,SR也得到了充分的應用.文獻[20-23]提出了多種基于稀疏表示的圖像融合方法,通過建立特征與稀疏系數(shù)之間的關(guān)系來表示圖像的顯著信息.然而基于SR的傳統(tǒng)融合方法存在3個主要缺點:1)對細節(jié)的保存能力有限;2)對圖像未配準有很高的敏感性;3)稀疏系數(shù)無法準確判別聚焦區(qū)域[24].而這3個問題在多聚焦圖像融合中是非常重要的.文獻[25]提出了一種魯棒稀疏表示模型(RSR)和多任務魯棒稀疏表示模型(MRSR).不同于傳統(tǒng)SR模型,RSR通過分解得到的重構(gòu)誤差作為圖像聚焦區(qū)域的判別依據(jù),得到的聚焦區(qū)域更加準確.MRSR方法對RSR進行了改進,該方法中每個圖像塊以及其相鄰區(qū)域的信息被協(xié)同地用于確定多聚焦圖像中的聚焦和非聚焦區(qū)域,這使得融合方法的魯棒性大大提高.然而上述兩種方法均使用單個源圖像構(gòu)建字典,容易導致字典的完備性不足.并且這兩種方法拋棄了RSR分解得到的稀疏系數(shù),僅使用重構(gòu)誤差作為判別依據(jù),這將使稀疏系數(shù)中包含的聚焦區(qū)域信息被忽略,容易將非聚焦區(qū)域誤判為聚焦區(qū)域.同時,MRSR方法的計算復雜度高,對聚焦區(qū)域的邊界也未作進一步處理[25].為解決以上問題,本文提出了一種基于RSR和形態(tài)學濾波相結(jié)合的多聚焦圖像融合新方法.與文獻[25]中的RSR融合方法不同,源圖像通過基于聯(lián)合字典的RSR模型得到稀疏系數(shù)和重構(gòu)誤差,并通過兩者共同判別圖像的聚焦區(qū)域,以此獲得初始的融合決策圖.接著使用形態(tài)學濾波與高斯濾波優(yōu)化初始決策圖,從而獲得最終的融合決策圖.通過此步驟,可以使聚焦區(qū)域的判別更為精確,同時使聚焦區(qū)域的邊緣過渡自然,有效地抑制融合圖像中塊效應和偽影現(xiàn)象的產(chǎn)生.將本文方法與現(xiàn)有的多種融合方法進行主觀與客觀實驗對比,結(jié)果證明了本文方法的有效性.

2 魯棒稀疏表示模型

魯棒稀疏表示(RSR)可視為對SR模型的一種改進,該模型可以提高對非高斯噪聲的魯棒性.令Y=[y1,y2,…,yN]是一個大小為d×N的數(shù)據(jù)矩陣(即多聚焦圖像),該數(shù)據(jù)矩陣的每一列yi∈Rd相當于一個數(shù)據(jù)向量(即一個圖像塊).假設(shè)該圖像部分地被誤差或噪聲E∈Rd×N所污染,再給出一個擁有M個原子的字典D∈Rd×M,RSR模型可以由如下公式所定義:

(1)

其中,矩陣X∈RM×N代表所求的稀疏系數(shù)矩陣,‖X‖0代表矩陣X的l0范數(shù),‖E‖2,0代表誤差矩陣E的l2,0范數(shù),D代表過完備字典,參數(shù)λ用來平衡上述兩個分量在等式(1)中的影響.由文獻[26]的研究可知,等式(1)所定義的RSR模型可以由如下優(yōu)化問題來代替:

(2)

J=‖X‖1+λ‖E‖2,1+[L,Y-DX-E]+

(3)

其中,L是拉格朗日函數(shù),用來消除公式(2)中的條件約束,μ>0是最后一項的懲罰參數(shù),運算符[A,B]表示矩陣A和矩陣B的歐幾里得內(nèi)積.顯然公式(3)現(xiàn)在是不受約束的,并且可以利用如下公式,通過固定X和E中的一項來求另一項的方法迭代循環(huán)計算該函數(shù)的最小值,直至收斂.計算公式如下:

(4)

(5)

(6)

3 本文融合方法

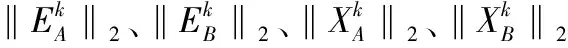

本文基于RSR模型的融合框架可以分為如下四個步驟:

1)利用滑動窗口取塊的方法,將源圖像A和B分別分解成圖像塊序列.通過聯(lián)合字典對圖像塊序列進行魯棒稀疏表示,得到稀疏系數(shù)矩陣X和編碼殘差矩陣E;

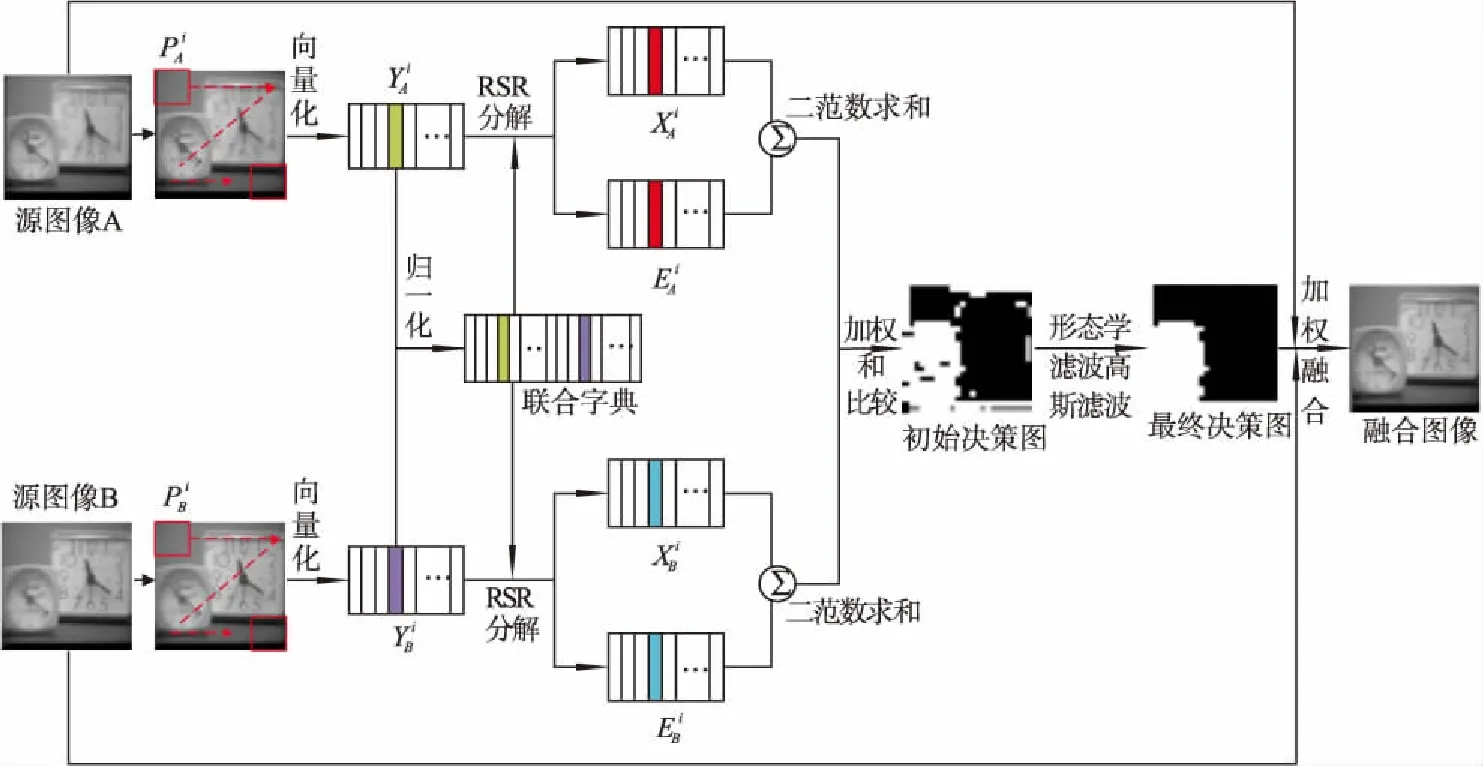

2)分別對源圖像A、B中相同位置處圖像塊序列的稀疏系數(shù)矩陣X和編碼殘差矩陣E的二范數(shù)加權(quán)求和,通過比較兩者間的大小來得到初始的決策圖;

3)通過對初始決策圖進行形態(tài)學濾波和高斯濾波優(yōu)化,得到融合使用的最終決策圖;

4)根據(jù)得到的最終決策圖對源圖像A、B進行加權(quán)融合,得到最終的融合圖像.上述融合步驟如圖2所示.

3.1 聯(lián)合字典的構(gòu)建

(7)

(8)

在多聚焦圖像融合中,不同源圖像的聚焦區(qū)域雖然不一致,但還是具有一定的相關(guān)性.僅使用單幅圖像所構(gòu)建出來的字典并不能得到最稀疏的系數(shù),但是將不同源圖像生成的字典聯(lián)合成一個字典,就能使字典中的信息更加完備.因此,用聯(lián)合后的字典再對源圖像進行魯棒稀疏表示,可以得到稀疏程度更高的稀疏系數(shù).為此,本文構(gòu)造了一種聯(lián)合字典,將源圖像IA和IB生成的兩個字典聯(lián)合成一個字典DAB,其中DAB=[DA,DB].再將DAB代回RSR模型中求解.

3.2 初始決策圖的獲得

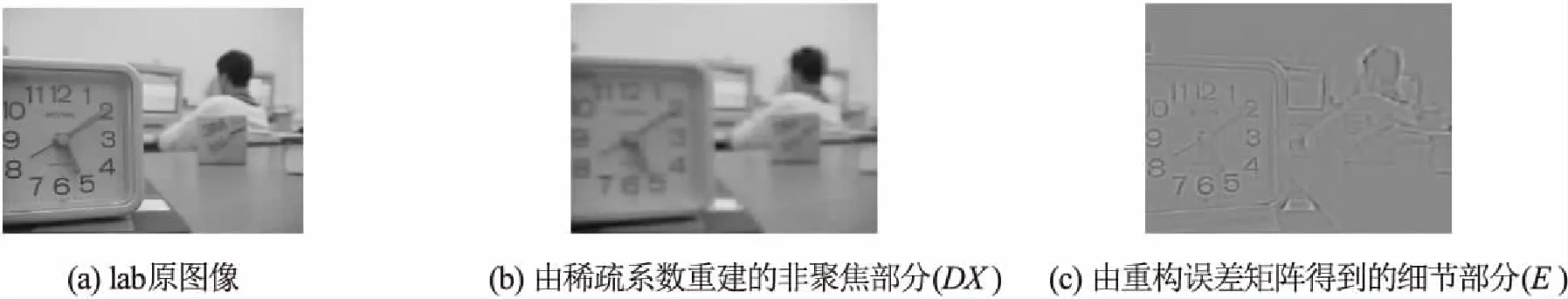

傳統(tǒng)的稀疏表示模型利用稀疏系數(shù)矩陣X作為判別聚焦區(qū)域的依據(jù).而在RSR模型中,多聚焦圖像被分解為一個非聚焦(或模糊)的部分,又稱作重構(gòu)后的矩陣DX,加上一個包含細節(jié)的部分,又稱作重構(gòu)誤差矩陣E,如圖1所示.換句話說,在RSR模型中,重構(gòu)誤差矩陣E包含了多聚焦圖像中的高頻細節(jié)信息.因此,傳統(tǒng)的RSR方法以重構(gòu)誤差E來代替稀疏系數(shù)X對聚焦區(qū)域進行判別.

圖1 lab圖像的RSR分解示意圖Fig.1 Illustration of RSR decomposition on lab

雖然DX代表著非聚焦部分,但事實上兩幅聚焦區(qū)域不同的圖像的DX并非完全相同,這說明DX中仍然包含著少許聚焦區(qū)域的信息.為此,本文將傳統(tǒng)SR和RSR的方法相結(jié)合,在判別聚焦區(qū)域時,將DX也加入考慮,可以獲得更加精確的聚焦區(qū)域.在本文中,取DX與E的加權(quán)二范數(shù)和作為比較的依據(jù).詳細的步驟如下:

1)利用聯(lián)合字典DAB,通過如下算法1求解下列優(yōu)化問題,以此得到數(shù)據(jù)矩陣YA、YB的魯棒稀疏表示:

s.t.YA=DABXA+EA,diag(XA)=0

(9)

s.t.YB=DABXB+EB,diag(XB)=0

(10)

其中,XA、XB分別是源圖像A、B的稀疏系數(shù)矩陣,EA、EB分別是源圖像A、B的重構(gòu)誤差矩陣.約束條件diag(XA)=0與diag(XB)=0是為了避免EA、EB成為零矩陣[28].算法1如下:

算法1.通過LADMAP得到魯棒稀疏表示模型算法

輸入:數(shù)據(jù)矩陣Y,字典D,參數(shù)λ

輸出:稀疏系數(shù)X,重構(gòu)誤差E

初始化:X0=0,E0=L0=0,ρ=1.1,ε=0.05,μ=10-6,μmax=1010

WHILE 結(jié)果未收斂 DO

1.固定X并利用公式(4)更新E;

2.固定E并利用公式(5)更新X;

3.利用如下公式更新拉格朗日函數(shù)L

Lj+1=Lj+μj(Y-DXj+1-Ej+1)

4.利用如下公式更新μ

μj+1=min(μjρ,μmax)

5.檢查迭代條件是否成立

‖Y-DXj+1-Ej+1‖F(xiàn)/‖Y‖F(xiàn)<ε,

‖Xj+1-Xj‖∞<ε,‖Ej+1-Ej‖∞<ε

其中,‖.‖∞代表l∞范數(shù),其含義為矩陣里每一行元素絕對值之和的最大值.

END WHILE

(11)

3.3 基于形態(tài)學濾波和高斯濾波的決策圖優(yōu)化

在獲得初始決策圖時,只是比較了單個圖像塊中的信息,而沒有將鄰近圖像塊內(nèi)的信息加入考慮.這使得初始決策圖中存在許多孤立的小塊(或者稱作“空穴”).這些“空穴”的存在說明部分聚焦區(qū)域未被正確地識別,或者部分非聚焦區(qū)域被誤判成聚焦區(qū)域.在文獻[25]中,通過引入了MRSR模型來解決該問題,但MRSR模型的計算復雜度比RSR模型高了許多,并且得到的融合決策圖中仍存在許多“空穴”.為了減少“空穴”對圖像融合的影響,同時降低計算的復雜度,本文通過兩個步驟對初始決策圖進行優(yōu)化.首先,將決策圖中孤立的小區(qū)域進行填充,填充過程如下:

M2=bwareaopen(M1,t)

(12)

式中,bwareaopen代表形態(tài)學濾波中的填充操作,代表濾波的閾值,M1為初始決策圖.該填充操作可以將二值圖像中少于t個像素的聯(lián)通區(qū)域移除,得到一個沒有“空穴”的新二值圖像.形態(tài)學濾波的優(yōu)化很好的消除了部分被誤判的區(qū)域,有效抑制了融合圖像中偽影的產(chǎn)生.在本文方法中,t值取10000可以得到最好的效果.

在使用二值圖像作為多聚焦融合權(quán)重圖時,由于聚焦與非聚焦區(qū)域的過渡不平滑,常常導致圖像塊效應在融合結(jié)果中出現(xiàn).因此本文使用高斯濾波對形態(tài)學濾波填充過的決策圖進行進一步優(yōu)化,得到最終的融合權(quán)重圖,即:

圖2 本文的融合框架Fig.2 Schematic diagram of the proposed fusion frame

MF=M2*Gsr,σ

(13)

式(13)中,*代表卷積操作,Gsr,σ代表高斯濾波函數(shù),r和σ分別為高斯濾波的參數(shù),本文取r=7,σ=1.2.

3.4 融合源圖像

獲得最終的融合權(quán)重圖后,對源圖像進行加權(quán)得到最終的融合圖像,即:

IF=MFIA+(1-MF)IB

(14)

式(14)中,IF為最終的融合圖像.

4 實驗結(jié)果及分析

為了驗證本文所提出方法的有效性,本文選擇了6組廣泛應用于研究的多聚焦圖像進行對比實驗,包括lab、book、clock、flower、disk、paper.其中,lab、flower和disk大小均為320×240,book大小為400×300,clock大小為256×256,paper大小為322×234.如圖3所示,除book外,其余圖像均是未精確配準的,圖3中第一排是聚焦于左側(cè)的圖像,第二排是對應的聚焦于右側(cè)的圖像.本文方法與七種當前主流的多聚焦圖像融合方法進行了比較,包括圖像摳圖(IMF)[4]、引導濾波(GFF)[6]、多尺度權(quán)重梯度(MWGF)[7]、交叉雙邊濾波(CBF)[5]、自相似與深度信息(SSDI)[8]、NSCT結(jié)合稀疏表示(NSCT-SR)[21]和卷積神經(jīng)網(wǎng)絡(CNN)[18].本文對比實驗中,七種方法的代碼均是作者在其主頁公布的,它們的參數(shù)選擇均與各文獻中保持一致,所有的實驗均是在Matlab2014a上實現(xiàn)的,實驗配置是3.20GHz的CPU和8GB的內(nèi)存.

圖3 六組多聚焦源圖像Fig.3 Six groups of multi-focus source images

4.1 融合圖像質(zhì)量評價

融合圖像的質(zhì)量評價主要包括主觀評價和客觀評價兩部分.由于融合技術(shù)地不斷提升,主觀評價的標準已經(jīng)很難體現(xiàn)不同融合方法得到的效果的差異.在本文中,將同時考慮融合圖像的主觀視覺效果和客觀定量評價,其中客觀定量評價通過互信息(MI)[29]、邊緣信息保持度(QAB/F)[30]和結(jié)構(gòu)相似度(SSIM)[31]三種常用的圖像融合質(zhì)量評價標準來衡量.

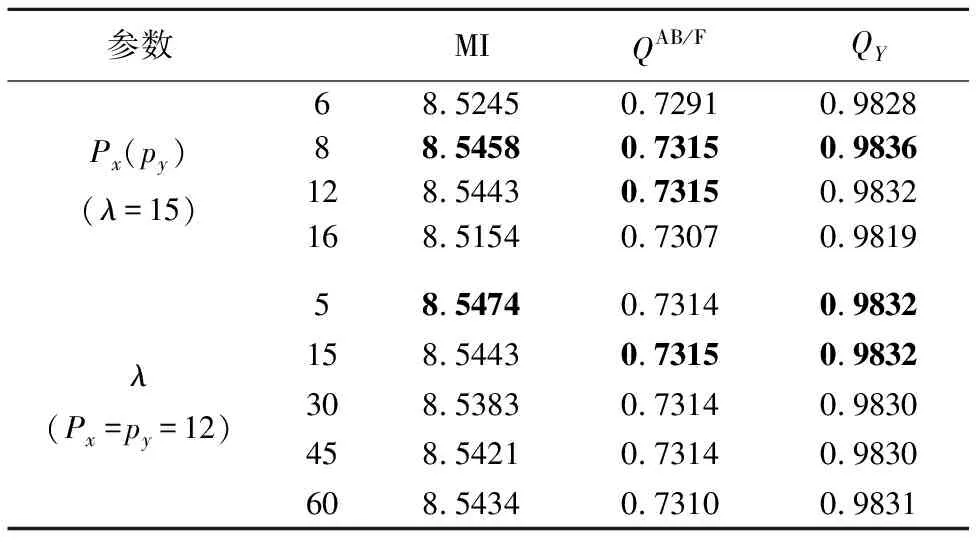

4.2 融合的參數(shù)選擇

由于公式(1)中提到的參數(shù)λ以及滑動取塊時窗口大小px×py對融合結(jié)果有著重要的影響,我們需要找到可以使融合結(jié)果達到最優(yōu)的參數(shù).在本小節(jié)中,我們使用六幅圖像的平均結(jié)果來測試不同參數(shù)對本文方法的影響.采用上一小節(jié)提到的三個質(zhì)量評價指標來衡量不同參數(shù)得到的融合結(jié)果.

表1 不同參數(shù)下本文方法得到的融合結(jié)果Table 1 Fusion results obtained by different parameters

表1給出了不同參數(shù)下的融合結(jié)果.我們注意到,窗口尺寸px和py取8和12時,得到的結(jié)果相近,但是當px取12時計算復雜度大大降低,由表3可知,消耗時間只有px=8時的九分之一左右.因此綜合考慮各個因素,本文窗口尺寸px和py取12.從表1中還可以看到,當λ取15時,可以得到最優(yōu)的結(jié)果.因此在以下的實驗中,取px=py=12,λ=15.

4.3 圖像融合實驗

4.3.1 主觀視覺效果

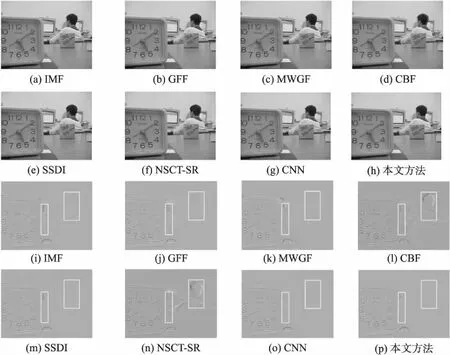

圖4給出了不同方法的lab融合結(jié)果.值得注意的是,由于拍攝時差,lab圖中實驗人員的頭部相互具有明顯的位移(如圖3(a)),這說明兩張源圖像未完全配準.為了體現(xiàn)本文方法對未精確配準圖像的魯棒性,本文給出了融合圖像與右聚焦源圖像的歸一化殘差圖.在殘差圖中,對應源圖像聚焦區(qū)域的殘差特征越少,則代表源圖像聚焦區(qū)域所轉(zhuǎn)移到融合圖像中的信息越完整.相反,對于非聚焦區(qū)域則是應該具有更豐富的細節(jié)信息.為了得到更清晰的對比,本文對殘差圖進行了歸一化處理:

(13)

圖4 不同方法的lab融合圖像和對應殘差圖Fig.4 Fused images and their relevant residues of different fusion methods on lab

4.3.2 客觀定量評價

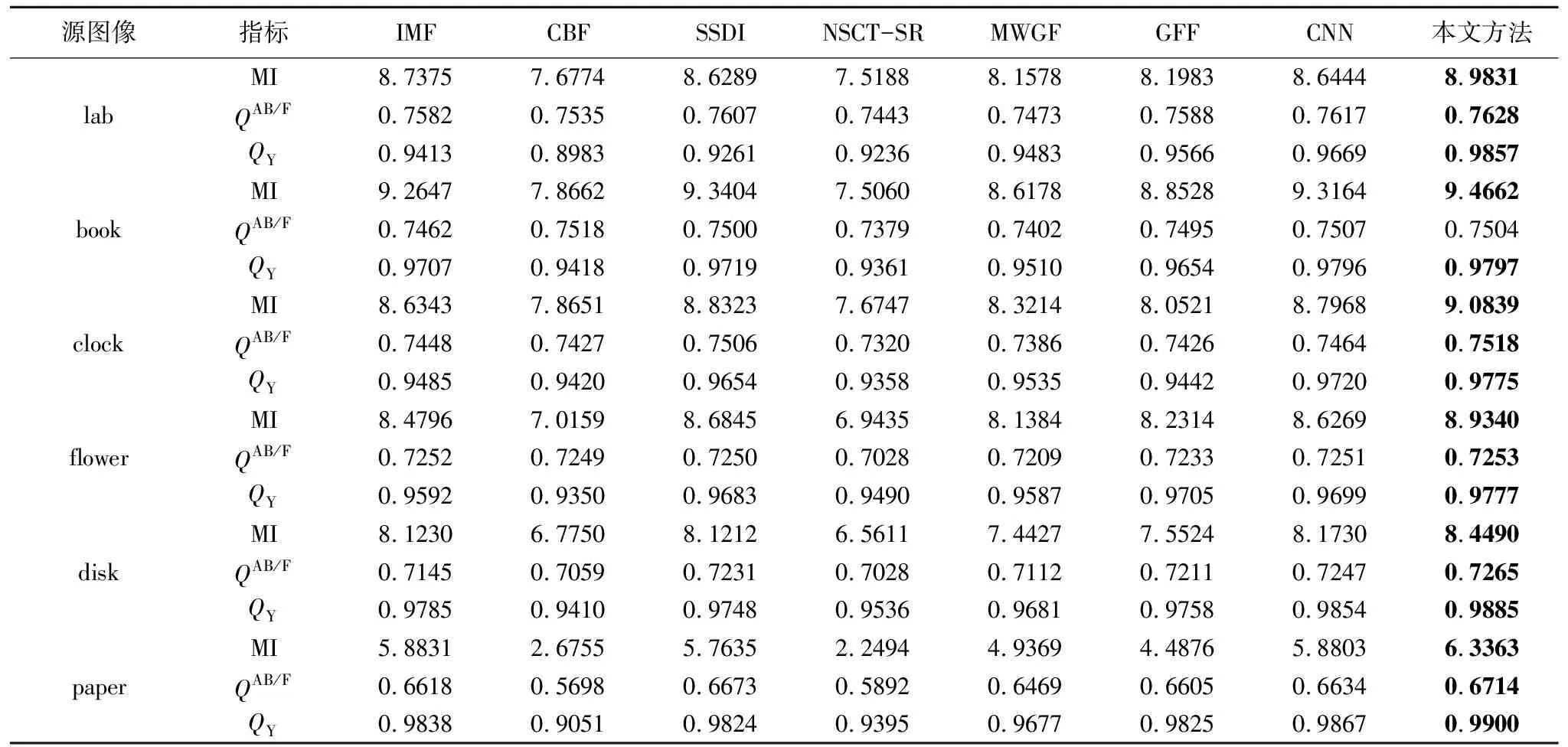

為了進一步驗證本文方法的性能,本文對七種方法的結(jié)果進行了客觀質(zhì)量評價.利用MI、QAB/F和QY對融合結(jié)果進行定量分析,評價結(jié)果如表2所示,其中粗體為所有方法中的最大值.從表2中可以直觀地看出,本文方法的MI和QY的值均是最大,除了book之外QAB/F的值也均為最大,并且book的QAB/F值也與最大值相近.MI的值均為最大值,說明本文方法所獲得的融合圖像轉(zhuǎn)移了更多來自源圖像的原始信息.QY的值均為最大值,說明本文方法可以很好的保留源圖像的結(jié)構(gòu)信息.QAB/F的對比也說明本文方法總體上可以很好的保留源圖像的邊緣信息.因此,綜合三個評價指標的表現(xiàn)來看,本文方法在有效信息提取上明顯優(yōu)于其他七種主流方法.

表2 不同融合方法得到的客觀指標對比Table 2 Objective comparison of different multi-focus image fusion methods

4.3.3 關(guān)于聯(lián)合字典與形態(tài)學濾波的對比試驗

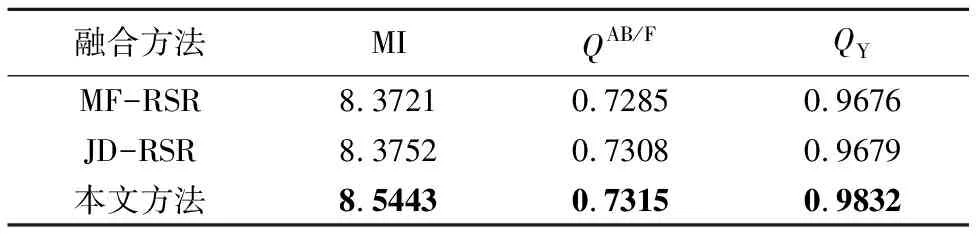

為了驗證聯(lián)合字典與形態(tài)學濾波在本文方法中的有效性,本節(jié)將未使用聯(lián)合字典的魯棒稀疏表示融合方法和未使用形態(tài)學濾波處理的魯棒稀疏表示融合方法與本文方法進行了對比.對上述6組圖進行融合的平均評價指標如表3所示.

表3 是否使用聯(lián)合字典與形態(tài)學濾波的對比Table 3 Comparison of using the joint dictionary or morphological filtering

其中 MF-RSR代表使用形態(tài)學濾波處理但不使用聯(lián)合字典的魯棒稀疏表示融合方法,JD-RSR代表使用聯(lián)合字典但不使用形態(tài)學濾波處理的魯棒稀疏表示融合方法.由表3可以看出,MF-RSR與JD-RSR兩種方法的MI、QAB/F與QY的值均低于本文方法.因此綜合三個評價指標的表現(xiàn)來看,使用聯(lián)合字典對圖像進行魯棒稀疏分解以及使用形態(tài)學濾波對決策圖進行后處理可以有效提升融合圖像的質(zhì)量.

4.3.4 算法效率分析

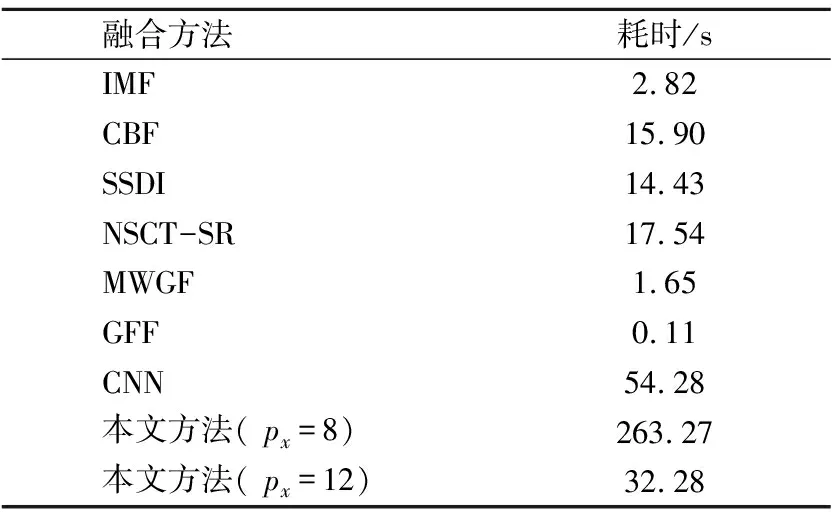

表4給出了不同多聚焦圖像融合方法在六組融合實驗中的平均耗時.從表4中可以看出,GFF是目前效率最高的方法,可以做到實時性.IMF與MWGF是效率較高的兩種方法,分別只需要2.82秒和1.65秒.CBF、SSDI與NSCT-SR的耗時均超過了10秒,效率相對較低.CNN是最耗時的方法,這是由于CNN使用了卷積神經(jīng)網(wǎng)絡,計算復雜度較高.但是CNN的融合效果與SSDI相近,并且優(yōu)于其余方法.本文方法由于使用了RSR模型,計算復雜度略高于傳統(tǒng)SR模型[25].但是本文方法在犧牲部分計算效率的基礎(chǔ)上,得到的融合效果明顯優(yōu)于上述方法,并且計算耗時少于CNN.相信通過優(yōu)化RSR模型的算法,可以進一步地提升計算效率,滿足各種實際應用的要求.

表4 不同融合方法的耗時對比Table 4 Comparison of time consuming in different fusion methods

5 結(jié) 論

本文提出一種基于魯棒稀疏表示和形態(tài)學濾波的多聚焦圖像融合方法.利用魯棒稀疏表示模型對源圖像進行處理,得到稀疏系數(shù)和重構(gòu)誤差,再求解兩者的加權(quán)二范數(shù)和判別圖像的聚焦區(qū)域,以此來獲得初始的融合決策圖.為了減少融合圖像中偽影現(xiàn)象和塊效應現(xiàn)象的產(chǎn)生,接著采用形態(tài)學濾波與高斯濾波對初始決策圖進行優(yōu)化,從而獲得最終的融合決策圖.最后,本文方法與七種主流的融合方法進行了對比實驗,實驗結(jié)果表明本文方法在視覺效果和定量指標上均優(yōu)于其他方法.由于本文方法的計算效率并非最高,因此在下一步的工作中,將研究降低本文方法計算復雜度的優(yōu)化算法.同時,還將考慮將本文方法應用在其他圖像類型的融合技術(shù)上,如多模態(tài)醫(yī)學圖像融合和紅外與可見光圖像融合等.