多融合協同表示的人臉識別方法

黃 偉,王曉輝

(韓山師范學院計算機與信息工程學院,廣東潮州 521041)

多融合協同表示的人臉識別方法

黃偉,王曉輝

(韓山師范學院計算機與信息工程學院,廣東潮州521041)

將虛擬樣本和逆表示融入到協同表示中,通過約束協同系數矩陣和逆表示系數矩陣的范數同時最小化的方式充分體現協同表達與逆表達之間的關聯信息,不僅在同一個目標函數體現了協同表示和逆表示,而且也能充分利用虛擬樣本的有效信息.在Yale和FERET人臉數據庫中的實驗表明:提出的多融合協同表示方法在不同的訓練樣本數下均比SRC、TSPTC和CRC的正確率有大幅的提高,證明了提出方法的有效性和魯棒性.

協同表示;逆表示;稀疏表示;虛擬樣本;人臉識別

人臉識別由于廣泛的應用前景及其問題的復雜性,一直是模式識別和機器視覺領域的研究重點.目前,基于重構的方法是人臉識別研究中的一個熱點.基于重構的方法將訓練集對測試樣本的重構能力作為分類的準則.稀疏表示(Sparse Representation Classification,SRC)[1]通過l1范數的約束在訓練集中找到合適的樣本對測試樣本進行重構.實驗表明SRC不僅有優越的性能,而且對遮擋等有很強的魯棒性.在此基礎上兩步方法(Two-phase Test Sample Sparse Representation,TSPTC)[2]的提出進一步提高了識別率.盡管l1范數的約束增加了計算的復雜度,但卻被視為SRC性能良好表現的主要原因. Zhang經過深入分析后認為協同表示才是SRC性能優越的根本原因[3].同時用l2范數代替l1范數的約束提出了協同表示分類器(Collaborative Representation Classification,CRC).Xu首次提出了逆表示(Inverse Representation,IR)[4]并將其引入到人臉識別中.逆表達最大的特點在于利用測試樣本對訓練樣本的“表達能力”來計算測試樣本與各類別的訓練樣本間的距離.IR的提出不僅進一步提高了人臉識別的性能,而且為我們提供了解決問題的另一種思路.

盡管各種理論和方法不斷被提出[5],但人臉識別依然是一個挑戰.由于光照、人臉的姿態和表情等的變化復雜,訓練集中不可能包括所有變化,因此大大降低了識別率[6].構造虛擬樣本是解決這個問題的有效方法.Xu[7]等人提出的鏡像虛擬樣本在一定程度上擴大了訓練集中對人臉姿態變化的范圍,大大提高了算法的魯棒性.本文將在協同表示的基礎上,結合測試樣本的鏡像虛擬樣本和逆表示的思想,提出多融合的協同表示人臉識別方法,進一步提高了CRC的性能和魯棒性.

1 相關工作簡介

假設人臉庫中有c類,第i類有ni個樣本,其中i=1,2,…,c.N=∑ic=1ni表示訓練樣本總數.將每個訓練樣本拉伸成為一個向量,并將訓練集記為X=[X1,X2,…,Xi…,Xc],其中Xi表示第i類訓練樣本的集合,y表示測試樣本拉成的向量.

1.1稀疏表示分類器(SRC)

稀疏表示可以看成是最近鄰子空間的一種擴展.SRC假設是同一類的訓練樣本分布在同一個子空間.基于這樣的假設測試樣本可以被第t類內的訓練樣本重構

由于測試樣本y的類別未知,假如用所有類的所有訓練樣本來重構測試樣本,式(1)可以改寫為

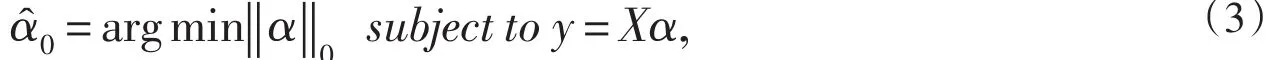

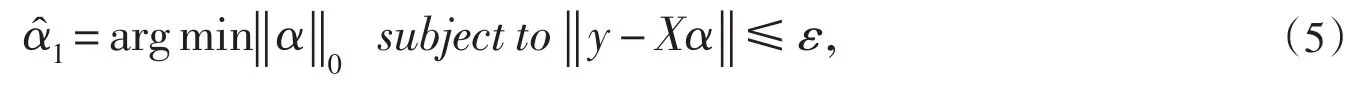

‖?‖0表示l0范數,指的是矢量中非零的個數.式(3)是一個NP問題,當α足夠稀疏的話l0范數等價于l1范數

考慮到誤差的普遍存在,式(4)應該改寫為

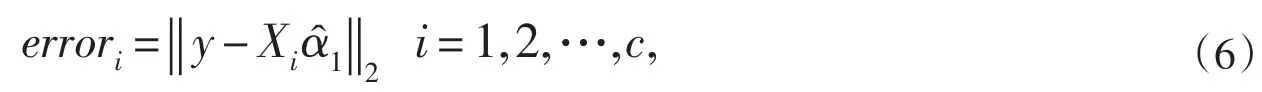

其中ε>0是一個給定的誤差.當得到稀疏α1就能計算每一類的訓練樣本重構測試樣本的重構誤差

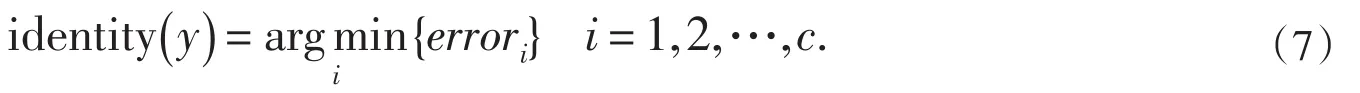

最后,用以下的分類準則將測試樣本分類

1.2協同表示分類器(CRC)

相對于人臉變化的復雜,訓練樣本的缺乏一直是人臉識別性能提高的障礙.考慮到不同類人臉的相似性,Zhang等人在分析了SRC后,指出了協同表示才是SRC性能提高的關鍵,并由此提出了CRC算法. CRC在訓練過程中將所用類所用的訓練樣本全部拿來重構測試樣本,同時求出重構系數,然后再根據不同類的訓練樣本和相應的重構系數計算該類對測試樣本的線性重構,最后將測試樣本歸類于重構誤差最小的那一類中去.對于測試樣本y和訓練樣本集X,利用線性回歸的方法求得重構系數φ

對于第i類的重構誤差為

1.3鏡像虛擬樣本

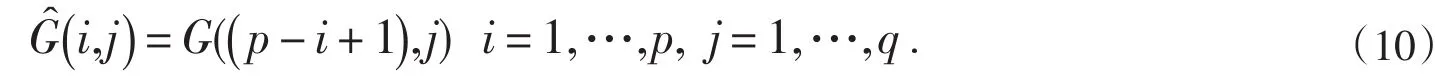

利用已有訓練樣本生成虛擬樣本是增加訓練樣本數量的有效方法.考慮到人臉的對稱性以及在采集人臉圖像過程中人臉姿態變化的特點,將訓練樣本的鏡像圖像作為虛擬樣本對訓練集進行擴充,能夠有效提高算法對姿態變化的魯棒性.假設為一張p×q像素的人臉圖像,其鏡像虛擬樣本G定義為

從式(10)可以看出,相對于原始樣本,鏡像虛擬樣本只對行方向上的像素進行置換,置換規則是將每一行的左右對應像素值進行對調.人臉姿態的變化主要集中在左右姿態變化,鏡像虛擬樣本能夠使訓練集容納更多左右姿態的變化,提高對測試樣本的重構能力.

2 多融合協同表示的人臉識別方法

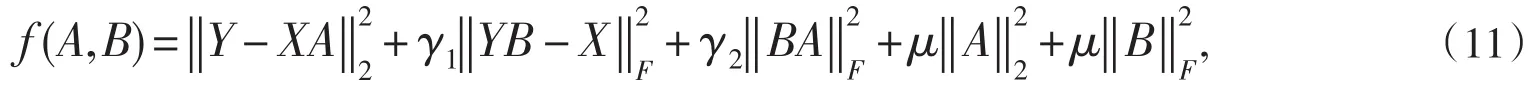

為了進一步提高CRC的識別率和魯棒性,將逆表示和鏡像虛擬樣本引入到CRC中.假設y為測試樣本的鏡像虛擬樣本,記Y=[y,y].設計的目標函數如下其中A=[A,…,Ai,…,Ac]T∈Rc×2和B=[B1,…,Bi,…,Bc]∈R2×c為矩陣,γ1,γ2和μ為大于0的權重參數.目標函數中第一項為協同表示,利用訓練集中所有的訓練樣本來重構測試樣本,第二項為逆表示,利用測試樣本及測試樣本的鏡像虛擬樣本來重構訓練樣本其余三項為范數約束項.因此只需求解一個目標函數就可同時得出協同表達與逆表達,而且通過約束兩個解向量的范數同時最小化的方式很好地利用了協同表達與逆表達之間的關聯.

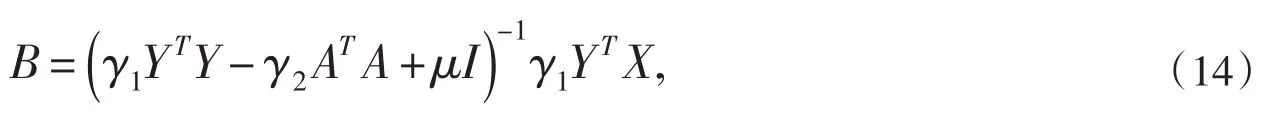

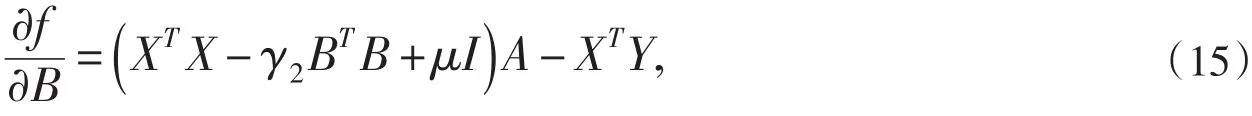

通過最小化目標函數來求得合適的協同表示系數矩陣A和逆表示系數矩陣B.由于目標函數同時存在兩個未知量,因此無法同時直接求出它們的表達式.下面通過迭代的算法分別求出協同表示系數A和逆表示矩陣B.

先根據原始協同表示求出A

求出目標函數對α的偏導數

類似地,得出B后再求目標函數對α的偏導數

以此類推,經過若干次迭代后就得到穩定的協同系數矩陣和逆表示系數矩陣.

在分類過程中,先計算融合了測試樣本在不同類的訓練集中的協同表示和逆表示的重構誤差

最后利用式(7)完成對測試樣本y的分類.

3 實驗結果與分析

在通用的人臉數據庫Yale和FERET中對提出算法進行實驗,對比的算法包括目前較前沿的基于重構的兩種算法:CRC和SRC,以及CRC的改進算法TSPTC.在實驗中,前t(t=1,2,…)個樣本作為訓練樣本,其余的樣本作為測試樣本.參數設置如下:γ1和γ2取值0.4,μ取值0.3,迭代次數取值為5.

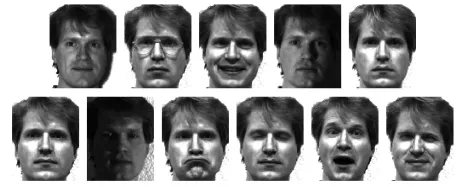

Yale人臉數據庫包括15個類,每類11個樣本,一共165個樣本.主要的變化有光照變化,表情變化和戴/不戴眼鏡等.圖1給出了數據庫中某一類的所用樣本.

圖1 Yale人臉數據庫中某一類的所用樣本

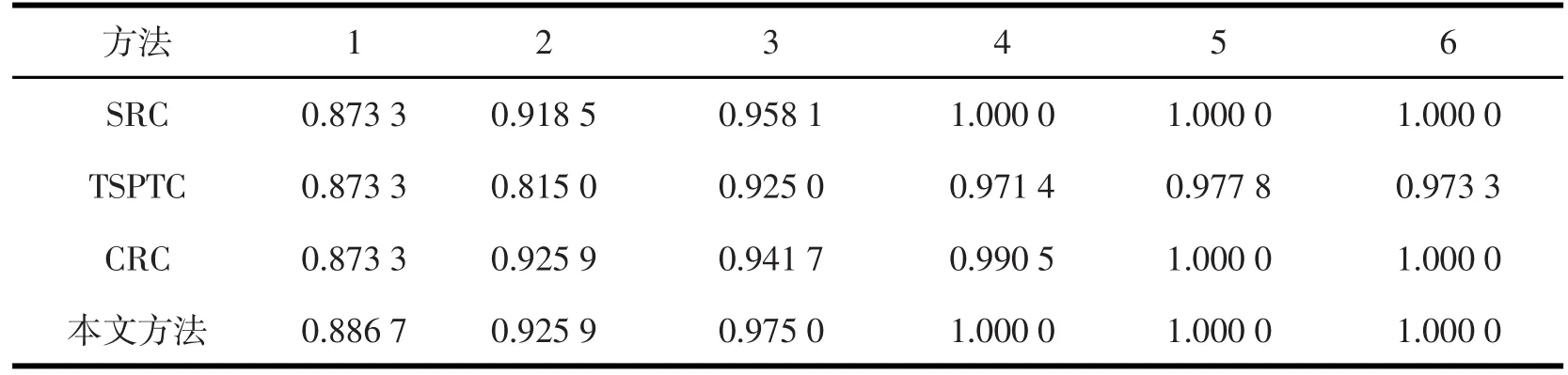

在實驗過程中,取每一類的前t(t=1,2,…,6)個樣本構成訓練集,其余的樣本作為測試.實驗結果如表1所示.

表1 Yale人臉數據庫識別率對比表

從表1可以看出所有的算法在Yale人臉數據庫中都取得比較高的正確識別率,多融合協同表示算法在不同的訓練樣本中的識別率是最高的.在t=1,其它算法的識別率均相等時,本文提出的算法仍然有超過1%的提高,并且隨著訓練樣本的增加,很快達到100%的識別率,體現了提出算法的有效性.

FERET人臉數據庫包括200個類,每類7個樣本,一共1 400個樣本.是目前通用的檢測姿態變化的人臉數據庫.圖2是FERET庫中某一類的所用樣本.

圖2 FERET人臉數據庫中某一類的所用樣本

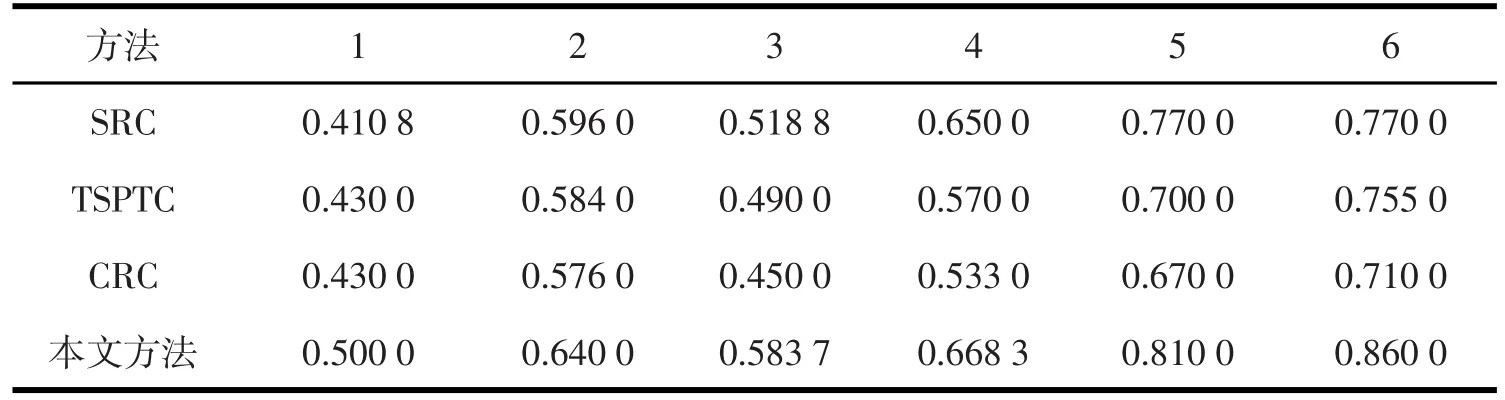

在實驗過程中,取每一類的前t(t=1,2,…,6)個樣本構成訓練集,其余的樣本作為測試.實驗結果如表1所示.

表2 FERET人臉數據庫識別率對比表

從表2可以看出,本文提出的多融合協同表示在識別率上有大幅提高.與原始CRC相比,當訓練樣數t≥3時,識別率提高超過10個百分點,尤其當t=3時,識別率提高了29.71%.另一方面,從表2也可以看出在姿態變化方面,SRC整體比CRC的識別率高.針對SRC的改進算法TSPTC在姿態變化方面的性能反而不如傳統SRC.相比于SRC和TSPTC,本文提出的方法在不同訓練樣本下均表現出更高的正確識別率,證明了多融合協同表示不僅能夠充分利用協同和逆表示的有效信息,而且能夠有效融合鏡像的虛擬樣本,提高識別率.

4 結束語

人臉圖像在光照、姿態和表情方面的復雜變化以及相對于人臉數據的維數而言,訓練樣本數量的不足是制約著人臉識別性能提高的重要因素.盡管近幾十年來對人臉識別的研究不斷,但訓練樣本的不足依然是一個巨大的挑戰.本文將協同表示、逆表示和虛擬樣本融合起來,不僅在一個目標函數中體現協同表示和逆表示,而且通過約束協同系數矩陣和逆表示系數矩陣的范數同時較小的方式充分體現協同表達與逆表達之間的關聯信息,大幅提高了人臉識別的正確率.在未來的工作中將討論不同虛擬樣本和協同表示、逆表示的關系以及進一步改進融合的方法,進一步提高在缺乏訓練樣本以及復雜的光照、姿態和表情等變化的環境下的識別率和魯棒性.

[1]WRIGHT J,YANG Y,SASTRY S S,et al.Robust face recognition via sparse representation[J].IEEE Transactions on.Pattern Analysis and Machine Intelligence,2009,32(2):210-227.

[2]ZHANG L,YANG M,FENG X.Sparse Representation or Collaborative Representation:Which Helps Face Recognition[C]// Computer Vision(ICCV),2011 IEEE International Conference on,2011:471-478.

[3]XU Y,ZHANG D,YANG J,et al.A two-phase test sample sparse representation method for use with face recognition[J]. IEEE Transactions on Circuits and Systems for Video Technology,2011,21(9):1255-1262.

[4]XU Y,LI X,YANG J,et al.Integrating conventional and inverse representation for face recognition[J].IEEE Transactions on Cybernetics,2014,44(10):1738-1746.

[5]吳巾一,周德龍.人臉識別方法綜述[J].計算機應用研究,2009,26(9):3205-3209.

[6]SANDFORD A,BURTON A M.Tolerance for distorted faces:Challenges to a configural processing account of familiar face recognition[J].Cognition,2014,132(3):262-268.

[7]XU Y,ZHU ZL,LIU G,et al.Using the original and‘symmetrical face’training samples to perform representation based two-step face recognition[J].Pattern Recognition,2013,46(4):1151-1158.

Multi-Fusion Collaborative Representation Method for Face Recognition

HUANG Wei,WANG Xiao-hui

(School of Computer and Information Engineering,Hanshan Normal University,Chaozhou,Guangdong,521041)

In this paper,the virtual samples and inverse representation are integrated into collaborative representation to improve the face recognition accuracy.The relation between collaborative representation and inverse representation is gotten by minimizing the norms of collaborative representation coefficients matrix and inverse representation coefficients matrix simultaneously.So the objective function not only includes the collaborative representation and inverse representation but also uses the available information of virtual samples. The experiment results on Yale and FERET face databases demonstrate the effective and feasibility of the proposed method comparing to SRC,TSPTC and CRC.

collaborative representation;inverse representation;sparse representation;virtual sample;face recognition

TP 391

A

1007-6883(2016)03-0041-05

責任編輯朱本華

2015-12-26

廣東省高等學校學科與專業建設項目(項目編號:2013LY0055);韓山師范學院2013年自然科學項目(項目編號:LY201301);2012潮州市科技引導項目(項目編號:2012S13).

黃偉(1978-),男,廣東潮州人,韓山師范學院計算機與信息工程學院高級實驗師.