基于互信息相對熵差異的顯著區域提取算法

郭禮華

(華南理工大學電子與信息學院,廣州510641)

生物學家對人眼的視覺模型進行了研究(A.P.Michael 1999),結果發現,當人觀察一幅圖像時,往往會首先關注圖像的主要內容,即最顯著的區域,而忽略圖像的背景信息。最顯著的區域,它含有大量的信息。若能從圖像中將這些區域提取出來作為圖像處理和分析的目標,不僅可消除圖像中次要信息對圖像處理結果的影響,而且更符合人眼的視覺需求。圖像的顯著目標提取是用部分概括整體,突出了圖像的最主要部分,從而消除了一些次要部分對觀察者帶來的干擾。目前,顯著目標的提取技術已經在許多領域得到了廣泛的應用,如圖像檢索、自適應圖像壓縮和編碼、視頻壓縮、敏感圖像識別、醫學圖像分析等。

近些年來,圖像的研究者們對圖像顯著區域的提取方法進行了一系列的研究,按其基本原理來看,常見的顯著區域提取方法可為分以下幾種:基于人機交互的方法,基于變換的方法和基于生物視覺注意機制的方法。最早,Itti首先提出顯著圖的概念,其采用的機制就是生物視覺注意機制,他們構成的顯著圖是一副和圖像大小相同的亮度分布圖,以亮度大小表示圖像中對應位置的顯著性程度,通過檢測圖像中顏色和方向的對比反映圖像對人眼視覺的刺激[1-3],隨后 Walther擴充了顯著模型,并成功應用于目標識別[4],他們還建立了顯著性檢測網站,提供顯著性工具箱下載[5]。后來陸續出現了基于信息理論的視覺注意模型,譬如AIM[6]、GBVS[7]、DISC[8]算法。AIM用一個特定的Gaussian函數估計中心-周邊概率,然后計算自信息;GBVS用 Markov鏈計算中心-周邊的互相影響;DISC用樣本方差和峰度估計假設的GGD概率密度函數,然后計算中心-周邊的互信息。這些基于信息理論的算法結構上還是按照 Itti的特征提取、中心-周邊對抗及重組的3個階段。這些算法都是非常復雜的,計算時速度比較緩慢。自從基于信息理論的視覺注意算法的出現,視覺注意開始偏離了生物性,顯著性分析算法也開始采用各種不同的算法。2008年 Achanta等[9]提出一種顯著性分析算法(AC算法),該算法的顯著值是指輸入圖像的一個局部區域和它的周邊區域的一個對比,即是這個局部區域的平均特征向量和周邊區域的平均特征向量的差。因為這里的特征只考慮顏色和亮度,所以該算法在計算時速度非常快。而基于頻域的算法也同樣在計算速度上很有優勢,2007年 Hou等[10]提出的剩余譜方法(SR算法)和2009年 Achanta等[11]提出的IG算法都是基于頻域的算法。筆者從顯著區域突出的特點,比較中心區域和周邊區域之間的顏色和梯度等屬性的差別,建立一套結合低維視覺特征的顯著區域提取算法。

1 中心周邊分布特征的提取

Itti模型是目前世界上被最廣泛采用并最有影響力的顯著圖提取模型,它是對一幅輸入的圖像提取多方面的特征,包括顏色、亮度、方向等特征,然后形成各個特征上的多尺度關注圖(Conspicuity Map),對其進行分析、融合得到顯著圖(Saliency Map),并從顯著圖中得到顯著區域和目標。Itti模型主要有3個處理步驟: 1)對圖像進行高斯金字塔分解,在圖像的多個尺度上提取顏色、亮度、方向等早期視覺特征; 2)通過局部的迭代合并策略,利用早期視覺特征分別得到3個特征顯著圖;3)將3個特征顯著圖線性合并為綜合顯著圖[1]。其中每一特征的計算采用了與生物感受野類似的線性中央周邊操作。中央周邊操作是指視覺神經元對位于其中央的小區域最敏感,而其中央區周圍的更廣、更弱區域內的刺激將抑制該神經元的響應。顯然,這樣的對局部空間不連續性的敏感結構特別適用于檢測相對于其局部周圍突出的區域,這也是視網膜、外膝體及視皮層內采用的一般計算原則。模型中的中央周邊操作是通過計算小尺度和大尺度的差來實現的。

Itti方法在實際應用中取得了良好的效果,但也存在一些問題。

1)Itti方法中使用Gabor濾波提取方向信息,但Gabor濾波器比較復雜,計算量大,效率較差;

2)Itti方法對提取得到的關注圖沒有進行進一步處理,直接進行組合;

3)Itti方法也沒有對提取的顯著區進行區分,可能會產生過度提取的情況。

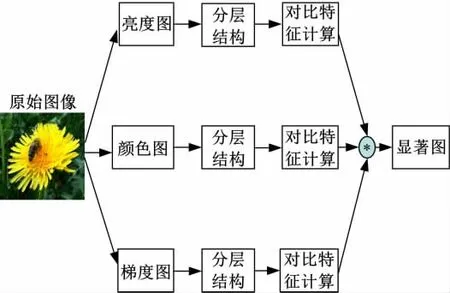

筆者按Itti模型的中央周邊操作的指導思想下建立顯著區域提取算法,但又有別于Itti模型。其系統結構圖如圖1所示。

圖1 顯著區域提取算法框圖Fig.1 Significant regin extraction algoritm diagram

和Itti顯著區域提取模型一樣,此方法也將圖像分成3部分,分別是亮度圖像、顏色圖像和梯度圖像,但是該算法的亮度、顏色和梯度圖的提取方法不同于Itti中的圖像方法,省去了Itti算法中的運算復雜度高的Gabor濾波器提取過程。首先,將彩色圖像中的RGB圖像層轉換成HSL圖像層,其中H表示色調圖像層,S表明飽和度圖像層,L表示亮度圖像層。色調和飽和度兩個圖像層在顏色表示時,是一對極坐標空間,為此在顏色圖像層中,將H和S兩個圖像層轉換成直角坐標系,分別得到2個圖像層Hue_x和Hue_y。梯度圖像采用在一特定尺度空間下,區域內像素偏微分的平均值。

計算亮度圖像,顏色圖像和梯度圖像后,需要對其進行分層處理。分層的最大好處就在于可利用不同的層次來檢測不同大小的顯著區域。為此將圖像進行分層處理,各層之間的大小關系是0.5倍,圖像共分成4個層次。接下來是計算對比特征,生物視覺研究關于視覺顯著性的觀察認為,視覺系統對視覺信號的對比度是很敏感的。首先根據文獻[12]計算像素的顯著值,具體來說,一個像素的顯著性值可以用它和圖像中其它像素的對比度來定義。圖像P中像素Pk的顯著性值定義為

其中H(Pk,Pi)為像素Pk和Pi像素在圖像空間的距離度量,在該系統中,其分別是亮度空間,顏色空間和梯度空間的距離度量。用公(1)計算圖像每個像素的顯著性值的方法,其時間復雜度為O(N2)。對于圖像來說,其計算復雜度已經非常高了。

文獻[12]利用亮度值減少顏色的數量n。這種方法雖然減低了復雜度,但是在這種定義下具有相同顏色值的像素具有相同的顯著性值,所以這種方法的缺陷是沒有考慮顏色信息的顯著性,同時也忽略了空間關系。

文獻[13]利用量化顏色,然后保留高頻出現的顏色,而替代低頻出現的顏色,減少復雜度,其實現效果對顯著性區域提取有很大改善,但是并未建模區域局部與周邊區域的關系。

在此基礎上,利用局部直方圖對比的方式,將顯著性值植入局部直方圖對比中,從而最終實現顯著區域提取。具體操作如下,首先在亮度圖像層、顏色圖像層和梯度圖像層中,分別將其像素值量化成12份,然后將在亮度圖像層、顏色圖像層和梯度圖像層分別計算各個像素的顯著性信號值,在局部區域內,統計中心區域內顯著性信號的直方圖與周邊區域內顯著信息信號直方圖的差異。

在求解直方圖差異的時候,本算法借鑒信息理論中信息熵的思想統計其直方圖的差異。信息理論是用來分析信號及其在信道傳輸時的統計理論方法。在這些理論中,信息熵是一個重要的概念,它表明信號的不確定性。以圖2為例,圖2右下方區域內的區域和其周圍在顏色上存在極大差別,如果統計其直方圖分布的話,其在直方圖分布存在極大差異。而圖左上方的中心區域內,其和周邊的直方圖分布就存在一致性。

圖2 中心區域與周邊區域內差異特征Fig.2 Differences in characteristics of the center area and the surrounding area

在信息熵中,相對熵(Relative Entropy)是兩個信號之間的不確定性,借鑒其概念,將相對熵引入到中心區域和周邊直方圖分布的差異分析,在該系統中,相對熵的度量采用Kullback-Leibler距離,它衡量的是相同事件空間里的兩個概率分布的差異情況。假設中心區域和周圍區域的直方圖分布分別是Hcem(x)和Hsur(x),計算公式如下:

經過計算各種圖像層的對比度距離特征后,將各個層進行最終的融合,得到最終的顯著區域。

3 計算結果與比較

首先觀察一下亮度信息提取顯著區域的效果,亮度信息提取顯著區域也采用的本算法框架結構,選用了一個花卉圖片作為測試圖片,如圖3 (a)所示,其亮度圖像如圖3(b)所示。分層結構后的顯著區域如圖3(c)所示,最終融合各種分層結構的結果如圖3(d)所示。所得到的結果可以看出,如果只是利用亮度信息對圖像的顯著性區域進行提取的話,雖然可以取得一定的效果,但在背景圖像較為復雜的情況下,其顯著圖的效果不是非常理想,背景中的一部分信息的顯著性也比較大,準確性不夠高。

圖3 花卉圖像的顯著性區域提取實驗Fig.3 Flower image of the significant region extraction experiment

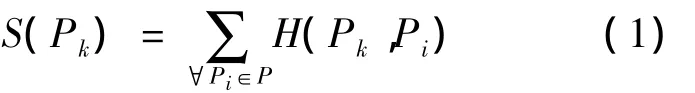

圖4 人體圖像的顯著性區域提取實驗Fig.4 A significant area of the human body image extraction experiment

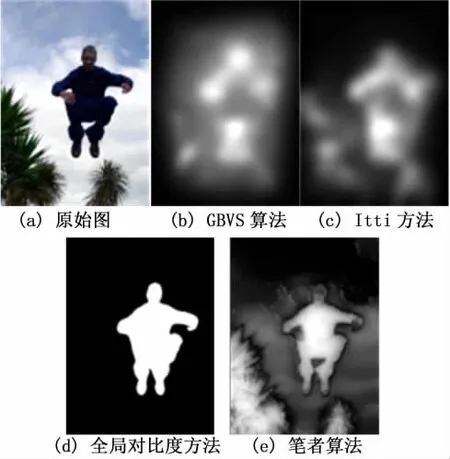

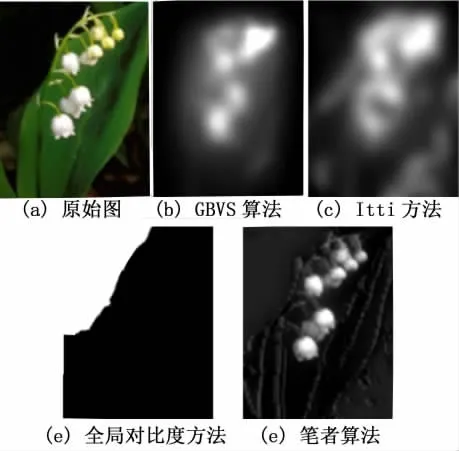

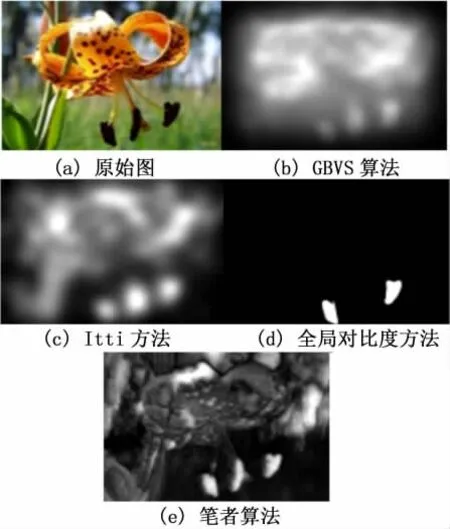

筆者采用顯著性值和局部直方圖信息提取顯著區域的效果,選用幾幅圖像對其算法進行相應的測試,圖像有人像和花卉。比較的算法有GBVS[1],Itti方法[5],和全局對比度方法[13]。從圖4可看出,由于全局對比度方法需要對圖像進行分割,此時分割比較正確,所以其顯著性區域的檢測比較符合人體視覺。GBVS方法和Itti方法雖然也關注場景中的人物,但是結果不夠清晰。在圖5和圖6的花卉圖像中,由于全局對比度方法在圖像分割過程中,圖像的主題并沒有完整的被分割出來,使得圖5中左上角的黑色區域被誤認了最顯著區域。圖6中的百合花蕾被視為單個對象進行了分割,并沒有和百合花整體分割,所以顯著區域檢測過程中,百合花蕾的顯著性更強,其最終成了最突出的顯著區域。而筆者算法顯著區域比較符合人體的視覺主觀特性。

圖5 花卉圖像1的顯著性區域提取實驗Fig.5 Flower image 1 significant area extracting

圖6 花卉圖像2的顯著性區域提取實驗Fig.6 Flower image 2 significant area extracting

4 結論

筆者提出一種基于互信息相對熵差異的顯著區域提取算法。算法首先在亮度圖像層、顏色圖像層和梯度圖像層中,分別將其像素值進行量化,然后將在亮度圖像層、顏色圖像層和梯度圖像層分別計算各個像素的顯著性信號值,并將顯著性值植入局部直方圖對比中,然后在局部區域內,統計中心區域內顯著性信號的直方圖與周邊區域內顯著信息信號直方圖的差異。在求解直方圖差異的時候,本算法借鑒信息理論中信息熵的思想來統計其直方圖的差異。在算法設計中,不僅僅考慮亮度信息,而且還融入色調和梯度信息,并采用分層結構,設計由粗到細的顯著區域提取。實驗結果比較好地驗證了,筆者算法所提取的顯著區域比較符合人體視覺的主觀感覺。

[1]Itti l,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Tran.on Pattern Analysis and Machine Intelligence,1998,20 (11):1254-1259.

[2]Itti l,Koch C.A saliency-based searchmechanism for overt and covert shifts of visual attention[J].Vision Research,2000,40(10):1489-1506.

[3]Itti l,Koch C,Niebur E.Computationmodeling of visual attention[J].Nature Reviews Neuroscience,2001,2 (11):194-203.

[4]Walther D,Itti l,RiesenhubeR M,et al,Attentional selection for object recognitiona gentle way[J].Lecture Notes in Computer Science,2002,25(1):472-479.

[5]Walther D,Itti l,Koch C.Saliency toolbox[OL].[2012-05-04].http://www.saliencytoolbox.net,2008.11.

[6]Bruce N,Tsotsos J.Salencey based on informationmaximization[C]//Advances in Neural Information Processing Systems.Vancouver,Canada,2006:155-162.

[7]Harel J,Koch C,Perona P.Graph-based visual saliency[C]//Advances in Neural Information Processing Systems.Vancouver,Canada,2007:545-552.

[8]Gao D,Mahadevan V,Vasconcelos N.The discriminant center-surround hypothesis for bottom-up saliency[C]//Advances in Neural Information Processing Systems.Vancouver,Canada,2007:497-504.

[9]Achanta R,Estrada F,Wils P,et al.Salient region detection and segmentation[C]//Proceedings of International Conference on Computer Vision Systems.Santorini,Greece,2008:66-75.

[10]Hou X,Zhang L.Saliency detection:a spectral residual approach[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Minnesota,USA,2007:1-8.

[11]Achanta R,Hemami S,Estrada F,et al.Frequencytuned salient region detection[C]//Proceedings of IEEE International Conference on Computer Vision and Pattern Recognition.Florida,USA,2009:1597-1604.

[12]Zhai Y Shah M.Visual attention detection in video sequences using spatiotemporal cues.[C]//Proceedings of ACM Multimedia.Santa Barbara,USA,2006:815-824.

[13]Cheng Ming-ming,Zhang Guo-xin,Niloy JMitra,et al. Global Contrast based Salient Region Detection.[C]// Proceedings of IEEE CVPR.Colorado Springs,USA,2011:409-416.