基于融合注意力Bi-LSTM的V2X通信阻塞預測方法

摘 要:為了解決Vehicle to Everything (V2X) 毫米波通信系統延時高、鏈路易阻塞等問題,基于車輛和用戶終端周圍環境狀態信息的感知,提出一種視覺輔助的能效最大阻塞預測方法。利用視覺感知模型實現系統對目標用戶以及周圍障礙物的精準感知,結合深度強化學習設計了一種融合特征和時間注意力的DA-DBLSTM 網絡預測未來鏈路阻塞到達時間,與傳統注意力相比,該融合注意力不僅可以關注每個時間單元中的不同特征,而且關注不同時間單元的時序信息,使檢測效果更優。仿真和分析結果表明,提出的DA-DBLSTM 網絡預測鏈路阻塞效果明顯,在均方誤差(Mean Square Error,MSE)、均方根誤差(Root Mean Square Error,RMSE)、平均絕對誤差(Mean Absolute Error,MAE) 和平均絕對百分比誤差(MeanAbsolute Percentage Error,MAPE) 方面均優于現有方法。

關鍵詞:V2X 通信;機器視覺;雙向LSTM;注意力機制;阻塞預測

中圖分類號:TN92 文獻標志碼:A 開放科學(資源服務)標識碼(OSID):

文章編號:1003-3106(2024)05-1277-09

0 引言

毫米波通信是當前和未來無線通信的關鍵支柱網絡[1],高頻段的帶寬可以滿足自動駕駛、智能交互等新興應用對網絡速率的要求。毫米波主要依靠視距(Line of Sight,LoS )鏈路來實現高速率的信息傳輸,與非視距(Non Line of Sight,NLoS)鏈路相比,LoS 鏈路接收信號的功率更大,從而可以實現更好的通信功能[2]。當環境中用戶與基站之間的LoS 鏈路被遮擋時,用戶接收功率嚴重衰減,信噪比(Signal to Noise Ratio,SNR)將嚴重降低,這些對毫米波通信的可靠性提出了挑戰。在以往的通信范式當中,高質量LoS 鏈路的重建往往是被動重建,而對于高頻通信而言,系統能夠主動保持LoS 鏈路非常重要,這需要系統具備感知環境的能力,因此,如何對環境中的物體進行感知并提取利用相關信息成為了阻塞預測的關鍵難點。

近年來,隨著環境中不固定變量的增多,傳統的數學建模方式遠不足以支撐環境中多樣化的信息感知和預測,為了獲取多樣化的環境信息,集成傳感和通信(Integrated Sensing and Communication,ISAC)應運而生[3]。ISAC 利用智能終端上配備的傳感器,如相機、雷達輔助通信,從而感知環境中的各種信息,并通過深度神經網絡與傳感器輔助相結合來有效減小系統選擇最優波束所造成的開銷[4-5],這些工作往往從無線傳感數據中學習一些統計規律來預測未來鏈路阻塞的發生。文獻[6]開發了一種基于機器學習的有效方案預測未來的阻塞,通過遞歸神經網絡來處理波束序列進而預測阻塞。文獻[7]開發了基于深度學習的毫米波雷達輔助波束預測方法,利用雷達信號處理的領域知識來提取并學習模型的相關特征。文獻[8]提出了一種利用無線信號和道路監控系統驅動的新機制,基于多元回歸技術預測用戶到達阻塞區域的時間,從而確定最佳切換決策。文獻[9]提出了視覺輔助毫米波無線通信的波束預測方案,通過多層感知機估計用戶與攝像機之間的角度從而為用戶選擇最佳波束索引。文獻[10]提出了一種新的深度學習架構,通過利用光束和RGB 圖像序列來預測全動態環境中的鏈路阻塞。文獻[11]開發了2 種基于深度神經網絡的兩階段和端到端算法,用于預測傳入服務及其請求時間。

研究人員早期曾采用傳統的機器學習方法對感知信息進行分類和預測[12-13],如使用分類器或者回歸方法,然而研究發現這些以傳統機器學習方法為基礎的環境感知和預測結果很不理想,其性能太過依賴特征,具有較高的錯誤率。為解決這些問題,基于Vehicle to Everything(V2X)的智能感知通信(In-telligent Perception Communication,IPC)這一概念被提出,相較于傳統機器學習,IPC 擺脫了太過依賴特征的缺點,可以直接捕獲原始數據之間的關系并將其擴展到新場景中,具有較強的自主學習和泛化能力。此外,IPC 具備獲取交通信息、實現波束跟蹤、遮擋判斷、參數獲取和資源配置等多種功能[14],對于多類其他通信場景例如智能反射面等也有良好的支撐,具有大規模部署和應用的前景。

為了更好地解決V2X 毫米波通信穿透性差、鏈路易阻塞的問題,本文在考慮實際視覺和通信模型的情況下提出了一種基于視覺感知的新型V2X 通信阻塞預測方法,其本質是將通信由“被動接收”轉化為“主動感知”,屬于主動感知輔助的通信新范式,是感知通信一體化新體系中的重要技術,此方法可以預測阻塞的到達時間,使系統提前改變通信方案(如將信號從另一個基站傳遞給用戶),從而實現通信的穩定性。此外本文開發了一種融合注意力的機器學習方法,利用提取的散射體/ 環境相關特征有效預測未來阻塞到達時間。具體而言,首先,采用目標檢測與定位算法分析視覺傳感器中的RGB 圖像,檢測用戶和障礙物并確定其位置,視覺輔助V2X 通信僅以RGB 圖像形式,不需要其他通道,可以顯著降低開銷。然后使用多種方法訓練不同類型的神經網絡,以預測未來阻塞到達的時間。最后,通過多項指標對不同阻塞模型進行評價對比分析。

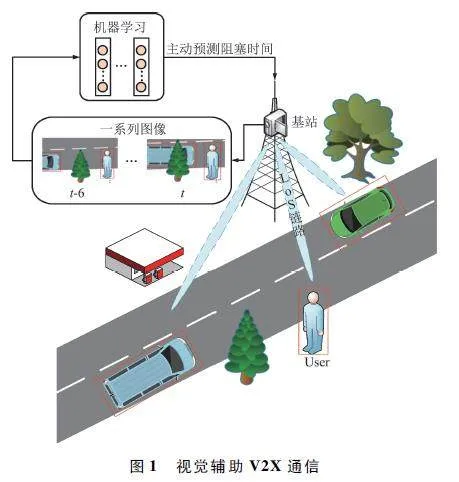

1 系統模型

V2X 通信在提高交通效率方面發揮著重要作用,低延時的通信取決于系統的處理速度和預測的準確度,因此V2X 是本文的研究場景。本文考慮了一種室外通信場景,如圖1 所示,道路上有一些車輛和行人,道路邊有一個毫米波基站為處于繁忙道路上的靜止用戶提供服務,每個基站配備了具有M 個元素的均勻平面陣列(Uniform Planar Array,UPA),為了捕捉到實時的RGB 圖像,系統在毫米波基站上方配備RGB 攝像頭用來感知并監控周圍環境,并獲取相關信息,該信息可以潛在地用于主動預測由移動物體引起的未來鏈路阻塞時間。通信系統采用正交分頻復用技術,采用預定義的波束形成碼本F= {fm} Qm = 1 ,fm ∈CM×1 和Q 是碼本中波束形成向量的總數,其中維度M 表示基站的天線個數。對于無線環境中的任何毫米波用戶,其接收到的下行信號為:

yk = hTkfm x + nk , (1)

式中:yk ∈C為用戶在第k 個子載波處接收的信號,hk ∈CM×1 為基站和用戶在第k 個子載波處之間的信道,x∈C\"為傳輸數據符號,nk 為從復高斯分布NC(0,σ2 )中提取的噪聲樣本。

1. 1 信道模型

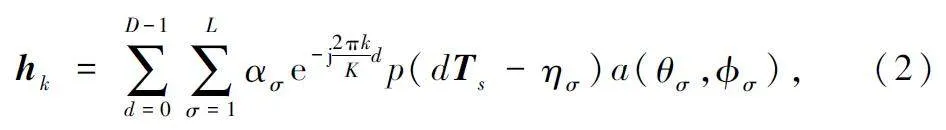

本文假設了一個幾何信道模型,其中用戶在第k 個子載波上的信道向量為:

式中:L 為信道路徑數,ασ 、ησ 、θσ 、Φσ 分別表示第σ 個信道的路徑增益(包括路徑損失)、時延、到達方位角和到達仰角,Ts 為采樣時間,D 為循環前綴長度。

1. 2 阻塞預測模型

本文工作主要是觀察在基站捕獲的一系列圖像樣本,并利用感測數據來預測靜止用戶未來多久將被環境中的障礙物阻擋在窗口內,令時刻t 在基站捕獲單個RGB 圖像為Z[t]∈RW×H×C ,W、H、C 分別是圖像的寬度、高度和顏色通道數。在任一時刻τ∈Z ,定義基站使用的RGB 圖像序列S[τ]為:

S[τ] = {S[t]}τt= τ -r +1 , (3)

式中:r∈Z 為預測未來鏈路阻塞到達時間的輸入序列或觀察窗口的長度。根據輸入的圖像序列S[τ]預測下一時刻阻塞距離到達靜止用戶所需具體時間Td,需要注意的是,本項工作不關注確切的未來實例窗口狀態,而是考慮表示未來阻塞到來的具體時間。采用機器學習模型去學習S[τ]到Td 的映射任務,定義一個函數fθ,該函數將觀察到的圖像序列S[τ]映射到未來堵塞到達的時間Td 中去,函數fθ可以表示為

fθ :S[τ]→ Td , (4)

式中:θ 表示機器學習模型的參數,從標記序列的數據集中學習。

2 視覺輔助阻塞預測方法

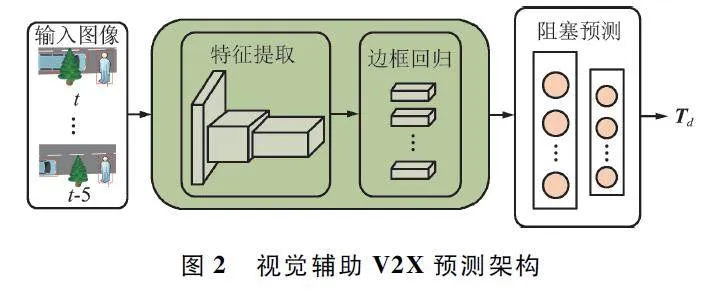

在V2X 通信網絡中,LoS 鏈路阻塞通常是由環境中可移動物體造成的,例如汽車、公交車等,考慮真實場景中移動對象的動態特性,未來阻塞任務的預測將更加具有挑戰性。為此,將阻塞預測分為對象檢測和時序預測2 個子任務。如圖2 所示,第一個子任務涉及檢測環境中感興趣的相關對象,考慮到當前計算機視覺和深度學習領域的最新進展,這項任務可以利用基于卷積神經網絡(ConvolutionalNeural Network,CNN)的物體檢測執行,例如YOLO(You Only Look Once)模型,其主要是從圖像中提取相關特征,并在圖像中繪制邊界框來鎖定感興趣的具體特征。第二個子任務是以第一個子任務提取的相關特征作為輸入,通過機器學習模型從提取的特征中學習潛在的關鍵指標,進而預測未來時刻窗口用戶被阻塞的剩余時間。

2. 1 目標檢測與定位

為了準確快速地識別環境中感興趣的對象并提取其邊界框坐標,本文采用了YOLOv7 版本的目標檢測模型[15],YOLOv7 是一種單階段目標檢測算法,與雙階段檢測方法相比具有更快的速度和更高的準確度,主要通過處理視覺數據從中獲取感興趣對象的信息。在本文工作中未重新采集圖片、對圖片進行標注,而是直接利用官方開源的COCO 預訓練權重,其包含行人、汽車和公交車等80 種類別,完全能夠滿足環境中存在大多數相關對象的檢測。

通過目標檢測可以提取感興趣對象的邊界框坐標,因其是歸一化后的坐標,處理后得到邊框左上角和右下角像素點坐標(x1 ,y1 )、(x2 ,y2 )。由于邊界框可以由左上角和右下角這2 組坐標表示,因此可以將x1 、y1 、x2 、y2 四元組作為邊界框的特征表示。

通過以上步驟可以獲得物體像素尺度的位置信息,物體真實速度的獲取前提是如何將像素尺度坐標轉換成真實場景下的物理坐標。實驗中將相機固定在某一位置以保證拍攝圖像具有相同范圍大小的視野,視野范圍的恒定意味著實際物理距離也不會發生變化,具體計算公式如下:

式中:W* 為圖像在真實場景中所占據的寬度,單位m;W 為圖像中的像素寬度,xt2 和xt1 分別表示目標在t2 和t1 時刻的像素點中心點位置,FPS 為一幀的時間。

而后將坐標與速度連接形成向量β∈RY×1 ,Y 為檢測到的物體數目,因每個數據樣本中檢測到的物體數目未必相同,這將導致提取的特征長度不固定。為了保證向量β 長度一致,用Z-Y 個零值去填充以獲得長度一致的向量β^ ∈RZ×1 。經過以上處理,物體坐標和速度連接形成的固定長度向量β^ 就可以被提取出來。

2. 2 阻塞預測方法

此方法無需再用圖像序列,只需從圖像中提取目標的邊框坐標和速度,這將大大減少計算量,有效節省運算時間。由于提取信息為時序序列信息,故只考慮采用不同類型的時序神經網絡,如長短期記憶(Long Short Term Memory,LSTM)神經網絡、門控循環網絡(Gated Recurrent Unit,GRU)等。為了預測用戶下一時刻的阻塞剩余時間,本文以時間序列{β^ [τ-r+1],…,β^ [τ]}作為輸入,進而完成預測任務并對比分析其效果。

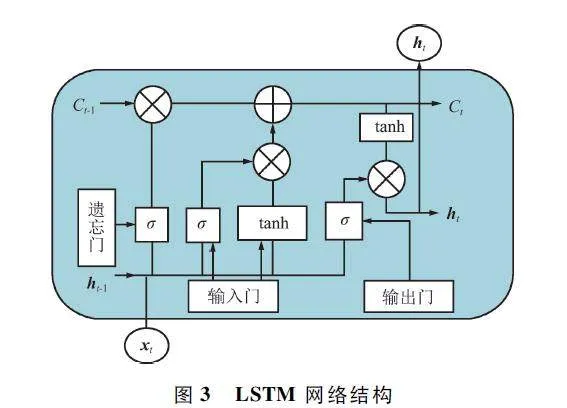

2. 2. 1 LSTM 網絡

LSTM 是一種特殊的時序網絡[16],通過遺忘、記憶和更新3 個門控單元控制信息的保留和傳遞。如圖3 所示,遺忘門決定了上一時刻單元狀態Ct-1 中哪些信息需要被遺忘。記憶門與遺忘門相反,它由Sigmoid 和tanh 兩個神經網絡層組成。Sigmoid 網絡層接收xt 和ht-1 作為輸入,輸出it 決定哪些信息需要被更新;tanh 網絡層通過整合輸入的xt 和ht-1 來創建一個新的-1 ~ 1 的狀態候選量C~t,并對其更新得到新狀態Ct。輸出門用來控制Ct 中的內容輸出到LSTM 網絡當前的輸出值ht 中。

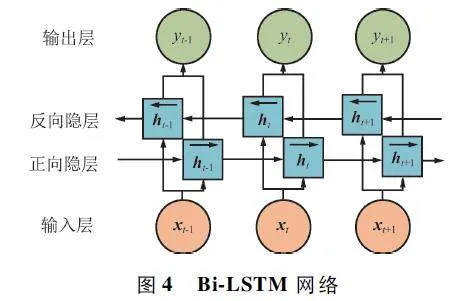

2. 2. 2 Bi-LSTM 網絡

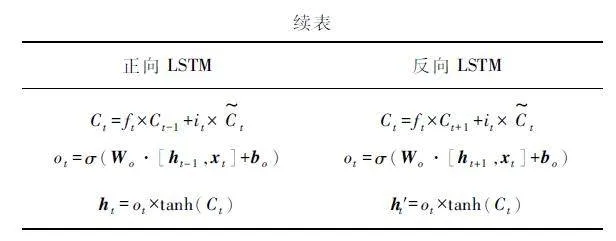

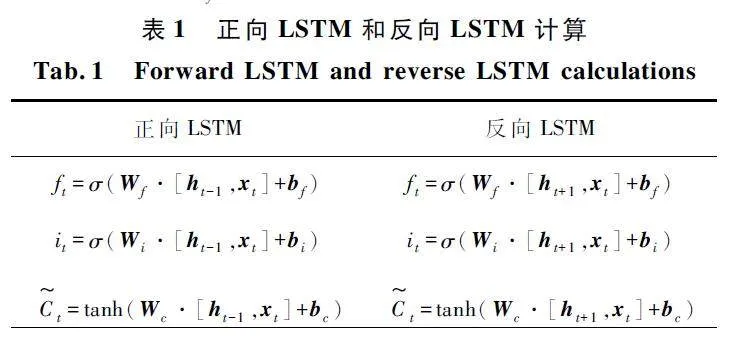

Bi-LSTM 簡稱雙向LSTM,是LSTM 的一種變體[17]。如圖4 所示,它由輸入層、正向LSTM、反向LSTM 以及輸出層組成,正向LSTM 提取輸入特征序列的正向特征,而反向LSTM 與之相反,提取特征序列從后往前的反向特征,輸出層負責對二者的輸出數據進行整合。

正向LSTM 和反向LSTM 的計算如表1 所示,其中xt 為t 時刻的輸入序列,Ct 為t 時刻的細胞狀態,ht-1 為隱層狀態,Wf、Wi、Wc、Wo 分別為記憶細胞狀態、遺忘門、輸入門、輸出門的權重矩陣,bf、bi、bc、bo 分別表示其對應偏置。由此可以求出在t 時刻的輸出yt 為

yt = Wy h + W*y h′ + by , (6)

式中:Wy 和W*y 分別為正向輸入和反向輸入到隱層權重矩陣,by 為其偏置。

由于其使用過去時刻和未來時刻的信息,因此對于遠距離時間序列預測,Bi-LSTM 可以獲得比LSTM 更好的性能。

2. 2. 3 DADBLSTM 網絡

通過在神經網絡輸出端引入注意力的方法雖然已經很普遍[18-20],但是同時引入2 種不同注意力在V2X 通信領域還未得到廣泛應用,本文分別在雙層Bi-LSTM 的每個隱層輸出端引入特征注意力(Feature Attention,FeaAttn)和時間注意力(Time At-tention,TimeAttn)。FeaAttn 可以獲取特征空間的不同位置特征之間的信息,關注每個時間點上不同特征的性能,使得單位時間序列可以自適應地選擇最相關的屬性。TimeAttn 可以捕獲時間序列之間的信息,關注不同時間序列的屬性,從而使系統更全面的利用序列數據。圖5 展示了DA-DBLSTM 模型的網絡結構,第一層為Bi-LSTM 網絡,負責從輸入數據中挖掘出每個單元序列中的隱藏信息,對于輸入時間序列X = (X1 ,X2 ,…,XT),Xt ∈RN ,N 表示序列數據中的特征數量,Bi-LSTM 網絡主要學習從Xt 到ht的映射任務:

ht = f1(Xt,ht-1 ), (7)

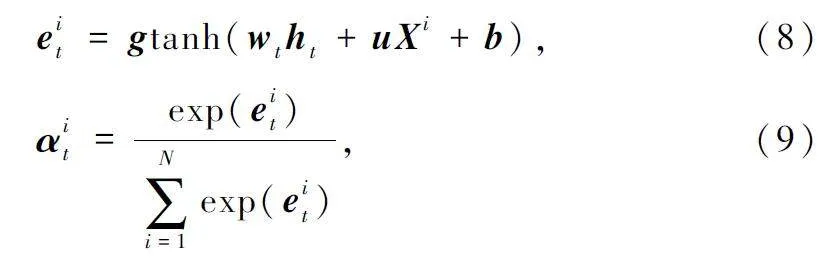

式中:ht 表示t 時刻的隱藏層向量,f1 表示時序神經網絡,Xt = (x1t,x2t,…,xNt)表示單位時間序列中的N 個特征向量。第二層是FeaAttn 層,它可以選擇性地將關注點聚焦于特定的特征上,由于考慮了每個特征對ht 的作用,因此能夠獲得更好的效果。通過利用從第一層中捕獲的單位時間序列的每組特征,可以得到關于特征的注意機制,計算如下:

式中:g∈!T、wt ∈RT×hidden_size和u∈RT×T為需要學習的權重矩陣,Xi = (xi1,xi2,…,xiT )∈RT為序列長度為T 的第i 個特征序列數據,αit為第i 個特征在時間t分配的關注權重值。將αit在時間t 分配給輸入向量X ~t:

X~t = (α1tx1t,α2tx2t,…,αNtxNt)。(10)

在時間t 自適應地選擇不同的特征之后,獲得新的輸入向量X ~t。與Xt 相比,X ~t 可以選擇性地關注不同的特征,而不是將相同的權重分配給每個特征。而后將從FeaAttn 層輸出的序列X ~ = (X ~1 ,X ~2 ,…,X ~T)作為輸入送入第三層網絡。第三層網絡同第一層類似,用來學習第二層輸出序列X ~t 到h~t 的映射函數:

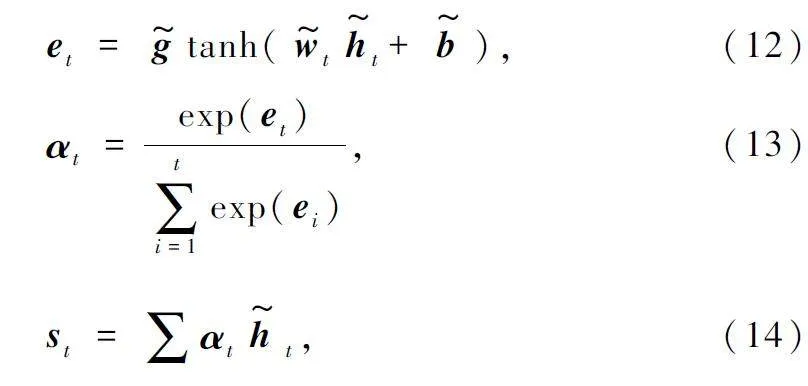

t = f2(X~t,h ~t-1 ), (11)

式中:h~t 是t 時刻的第三層網絡的隱藏層向量,h~t-1 是隱藏層的前一個單元的輸出,f2 是時序神經網絡。然后TimeAttn 層以從第三層網絡的隱藏層狀態H ~t = (h~1 ,h~2 ,…,h~T)作為輸入,對其進行加權求和,處理過程如式(12)~ 式(14)所示:

式中:g~ 和w~t 為權重矩陣,αt 為時間序列分配所得的關注權重值,st 為隱層狀態與注意力權重加權后的值,最后將其通過全連接層得到預測結果。

本文提出的DADBLSTM 模型內容總結如下:首先,第一層網絡提取每個序列單元的隱藏層信息,學習相應的映射任務;然后,通過第二層的FeaAttn機制在不同時間自適應地選擇特征;其次,將隱藏層信息和不同時間的不同特征組合成新的輸入序列數據,送入第三層網絡學習映射任務;最后,第三層的輸出經過TimeAttn 層,對時間序列分配注意力并通過全連接層輸出預測值。

3 仿真分析

3. 1 實驗環境、參數配置和評估指標

實驗所用計算機硬件配置為:處理器Intel Xeon Platinum8255C,CPU 頻率為2. 5 GHz,GPU加速顯卡為NVIDIA GeForce RTX 2080Ti,操作系統為Ubuntu 18. 04,使用python3. 7 編程。實驗采用RGB 相機自行拍攝所在街道場景,采樣頻率每秒約10 個樣本,共2 000 個樣本,將其按照7 ∶ 2 ∶ 1 的比例劃分為訓練集、驗證集和測試集,通過目標檢測模型及相關處理提取生成的特征序列,對其進行最大最小歸一化處理,該方法能夠消除變異量綱和變異范圍的影響,確保數據是在同一量綱下進行比較,處理后進而將其送入深度學習模型以評估未來阻塞發生的可能性。所提出的Bi-LSTM 模型中有3 個主要參數,分別是隱藏層大小、時間窗長度和批次大小。由于深度學習模型具有參數化特性,模型的訓練和測試受參數的影響較大。實驗采用隨機梯度下降算法更新參數直到模型收斂,并采取控制變量方式,反復對驗證集進行驗證以得到使模型學習效果最佳的參數配置,從而避免出現精度波動的問題。為了在處理大規模數據和復雜模型時更具優勢,采用Adam 優化器,訓練過程損失函數為mean_squared_error,學習率為0. 001,批次大小為10,訓練次數為50。

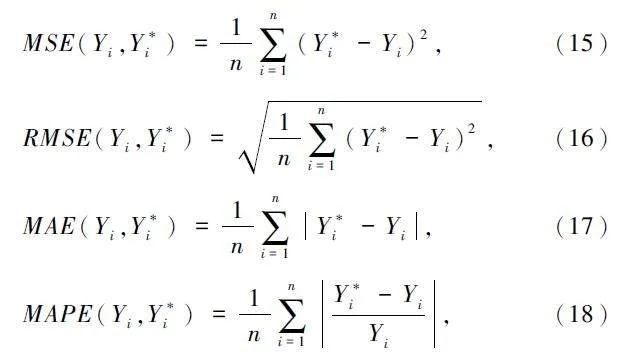

本文使用滑動窗口的方式處理數據,以多張圖片生成的特征序列為一組,作為輸入以預測未來一個窗口內用戶距離阻塞來臨的剩余時間Td。使用均方根誤差(Root Mean Square Error,RMSE)、均方誤差(Mean Square Error,MSE)、平均絕對誤差(MeanAbsolute Error,MAE )以及平均絕對百分比誤差(Mean Absolute Percentage Error,MAPE)來評估DA-DBLSTM 模型的預測性能。評估指標的計算如下:

式中:Yi 為實際值,Y*i 為預測值。

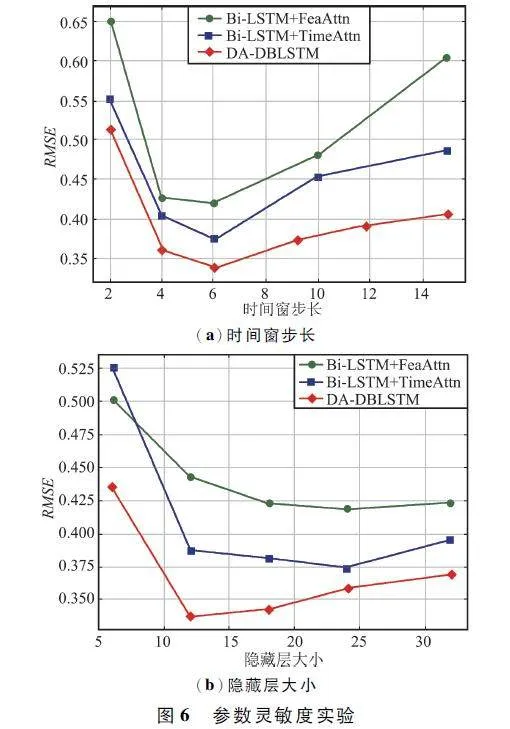

3. 2 參數靈敏度實驗

為探究最佳時間窗長度和隱藏層大小及其對DA-DBLSTM 模型的影響,實驗選取DA-DBLSTM、BiLSTM-FeaAttn 和BiLSTM-TimeAttn 進行實驗并繪制其RMSE,如圖6 所示。

從圖6(a)可以看出,在保持其他參數大小不變的情況下改變時間窗長度,設置時間窗步長分別為2、4、6、10、15,當時間窗步長為6 時,3 種網絡的RMSE 均低于其他時間窗步長,當時間窗步長的長度太短或太長時,3 種網絡的性能會變差,但相較于Bi-LSTM-FeaAttn 和Bi-LSTM-TimeAttn,DA-DBLSTM具有更好的魯棒性。此外,從圖中很容易觀察到當時間窗步長較大時,DADBLSTM 顯著優于另外2 種網絡,這也表明TimeAttn 機制可以通過在所有時間步長中選擇相關的編碼器隱藏狀態來捕獲長期依賴關系。

通過設置時間步長為6,實驗進一步研究隱藏層大小與RMSE 之間的關系,分別設置隱藏層大小為6、12、18、24、32,并將其關系通過圖6(b)進行繪制,注意到當隱藏層大小為12,DA-DBLSTM 可以實現最佳性能,盡管另外2 種網絡在隱藏層大小為24達到最優,但RMSE 仍遠遠高于DA-DBLSTM,這表明DADBLSTM 對參數具有更強的魯棒性。還可以觀測到僅添加FeaAttn 的網絡相較于僅添加TimeAttn 的網絡,受隱藏層大小變化的影響較小,網絡更穩定,這也驗證了FeaAttn 對元素間狀態關系的捕獲具有一定的增強作用。

3. 3 阻塞時間預測實驗

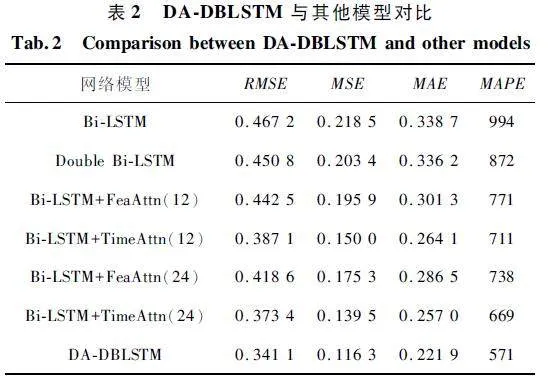

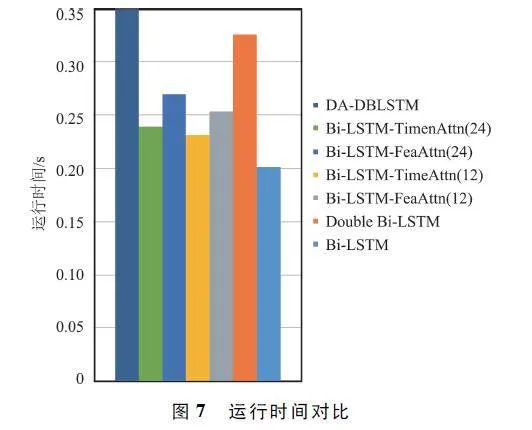

為驗證DA-DBLSTM 模型的性能,實驗采取Bi-LSTM、Double Bi-LSTM、Bi-LSTM-FeaAttn 和Bi-LSTM-TimeAttn 四種模型與之對比。公平起見,除注意力外,其他網絡與之對比的4 種模型均與其采用相同的參數。當輸入數據組數一定時,實驗探究了幾種模型從輸入到輸出的運行時間,并將其以柱狀圖的形狀繪制,如圖7 所示。從圖中可以看出,Bi-LSTM和Bi-LSTM-FeaAttn、Bi-LSTM-TimeAttn 兩種網絡的運行時間接近,DA-DBLSTM 網絡的運行時間略微高于Double Bi-LSTM 網絡,但卻遠大于Bi-LSTM 網絡,這是因為DA-DBLSTM 相較于Bi-LSTM 擁有更深的網絡結構,因此在處理本文復雜數據時具備更強大的特征抽取和處理能力,能夠更有效地捕捉數據之間的關聯性,這也意味著需要更多的計算資源和時間來完成工作。

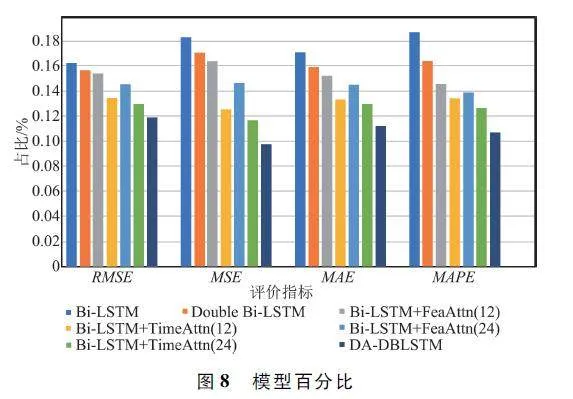

表2 為DA-DBLSTM 與其他模型對比。可以看出,采用的DA-DBLSTM 模型在評估指標RMSE、MSE、MAE 以及MAPE 方面的值比其他模型小很多。以MSE 為例,Bi-LSTM、Double Bi-LSTM、Bi-LSTM-FeaAttn、Bi-LSTM-TimeAttn 和Double-LSTM的MSE 分別為0. 218 5、0. 230 4、0. 175 3、0. 139 5,DA-DBLSTM 模型將MSE 降低至0. 116 3,比BiLSTM 模型低了將近一倍。對于RMSE、MAE 和MAPE,DA-DBLSTM 模型也遠遠低于其余4 種模型。為了更清晰地展示表2 中的結果,將表2 中的數據按照百分比進行縮放并在圖8 中繪制,也可以看出DA-DBLSTM 性能指標明顯低于其他模型。

基于此,實驗還對每個模型進行20 次試驗得出不同模型4 種指標的變化區間并繪制,圖9 分別展示了4 種模型的RMSE、MSE、MAE 和MAPE 的方箱圖,從圖中不難看出,DA-DBLSTM 模型呈現出來的性能明顯優于其他模型,該模型的中線以及最小值均在其他模型之下,平均值也遠遠小于其他模型,變化區間也保持在一定范圍,相對來說比較穩定。由此可得出結論,DA-DBLSTM 模型不僅可以顯著提高預測精度,對改善系統穩定性也有很大幫助。

4 結束語

本文對視覺輔助V2X 通信網絡進行研究,針對未來阻塞到達時間預測,提出了一種融合注意力機制的DA-DBLSTM 網絡。在雙層雙向LSTM 網絡中引入FeaAttn 和TimeAttn 層,從而可以自適應地分配特征和時間權重,使系統性能最優。并與多種先進的時序神經網絡進行對比,驗證其網絡性能。仿真結果表明,本文提出的DA-DBLSTM 網絡在精度和穩定性方面優于其他先進方法,不僅具有較高的預測精度,而且對注意機制的使用和神經網絡結構的設計提供了一種新的毫米波通信應用思路。未來計劃將該思路拓展到其他信息感知模式,并融合多模態感知數據準確、高效地提取靜態和動態環境信息,綜合利用新的多個維度來輔助系統的設計與優化。

參考文獻

[1] HONG W,JIANG Z H,YU C,et al. The Role ofMillimeterwave Technologies in 5G / 6G Wireless Communications[J]. IEEE Journal of Microwaves,2021,1 (1):101-122.

[2] CHARAN G,ALRABEIAH M,ALKHATEEB A. Visionaided 6G Wireless Communications:Blockage Predictionand Proactive Handoff [J ]. IEEE Transactions onVehicular Technology,2021,70(10):10193-10208.

[3] TIAN Y,PAN G F,ALOUINI MS. Applying Deeplearningbased Computer Vision to Wireless Communications:Methodologies,Opportunities,and Challenges [J].IEEE Open Journal of the Communications Society,2020,2:132-143.

[4] TOLSTIKHIN I,HOULSBY N,KOLESNIKOV A,et al.MLPMixer:An AllMLP Architecture for Vision [EB /OL]. (2021-06-11)[2023-6-20]. https:∥arxiv. org /abs / 2105. 01601v4.

[5] ROY K,ISHMAM A,TAHER K. Demand Forecasting inSmart Grid Using Long Shortterm Memory[C]∥2021 International Conference on Automation,Control and Mechatronics for Industry 4. 0 (ACMI). Rajshahi,IEEE,2021:1-5.

[6] CHARAN G,ALKHATEEB A. Computer Vision AidedBlockage Prediction in Realworld Millimeter Wave Deployments[C]∥ 2022 IEEE Globecom Workshops (GCWkshps). Rio de Janeiro:IEEE,2022:1711-1716.

[7] DEMIRHAN U,ALKHATEEB A. Radar Aided 6G BeamPrediction:Deep Learning Algorithms and RealworldDemonstration[C]∥2022 IEEE Wireless Communicationsand Networking Conference (WCNC). Austin:IEEE,2022:2655-2660.

[8] ALQURAAN M,KHAN A,MOHJAZ I,et al. IntelligentBlockage Prediction and Proactive Handover for SeamlessConnectivity in Visionaided 5G / 6G UDNs [EB / OL ].(2022-02-21)[2023-06-20]. https:∥arxiv. org / abs /2203. 16419v1.

[9] YING Z Q,YANG H J,GAO J,et al. A New VisionaidedBeam Prediction Scheme for mmWave Wireless Communications[C]∥2020 IEEE 6th International Conference onComputer and Communications (ICCC). Chengdu:IEEE,2020:232-237.

[10] CHARAN G,ALRABEIAH M,ALKHATEEB A. Visionaided Dynamic Blockage Prediction for 6G Wireless Communication Networks[C]∥2021 IEEE International Conference on Communications Workshops (ICC Workshops).Montreal:IEEE,2021:1-6.

[11] ALRABEIAH M,DEMIRHAN U,HREDZAK A,et al. Vision Aided URLL Communications:Proactive ServiceIdentification and Coexistence[C]∥2020 54th AsilomarConference on Signals,Systems,and Computers. PacificGrove:IEEE,2020:174-178.

[12] REDMON J,FARHADI A. YOLOv3:An Incremental Improvement[EB / OL]. (2018 - 04 - 08)[2023 - 06 - 20].https:∥arxiv. org / abs / 1804. 02767.

[13] LI S,LI W Q,ZHU C,et al. Independently RecurrentNeural Network (IndRNN ):Building a Longer andDeeper RNN[C]∥2018 IEEE / CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City:IEEE,2018:5457-5466.

[14] ALRABEIAH M,HREDZAK A,ALKHATEEB A. MillimeterWave Base Stations with Cameras:Visionaided Beam andBlockage Prediction [C ]∥ 2020 IEEE 91st VehicularTechnology Conference (VTC2020Spring). Antwerp:IEEE,2020:1-5.

[15] SONG X Y,GU W. Multiobjective Realtime Vehicle Detection Method Based on YOLOv5[C]∥2021 InternationalSymposium on Artificial Intelligence and Its Applicationon Media (ISAIAM). Xi’an:IEEE,2021:142-145.

[16] KARIM F,MAJUMDAR S,DARABI H,et al. LSTM FullyConvolutional Networks for Time Series Classification[J].IEEE Access,2018,6:1662-1669.

[17] ZHANG H,NAN Z X,YANG T,et al. A Driving BehaviorRecognition Model with BiLSTM and Multiscale CNN[C]∥2020 IEEE Intelligent Vehicles Symposium (IV).Las Vegas:IEEE,2020:284-289.

[18] PRADHAN T,KUMAR P,PAL S. CLAVER:AnIntegrated Framework of Convolutional Layer,BidirectionalLSTM with Attention Mechanism Based Scholarly VenueRecommendation [J]. Information Sciences,2020,559:212-235.

[19] HE Y L,CHEN L,GAO Y L,et al. Novel DoublelayerBidirectional LSTM Network with Improved AttentionMechanism for Predicting Energy Consumption [J]. ISATransactions,2021,127:350-360.

[20] GUO M H,XU T X,LIU J J,et al. Attention Mechanismsin Computer Vision:A Survey[J]. Computational VisualMedia,2022,8(3):331-368.

作者簡介

邵 霞 女,(1970—),碩士,副教授。主要研究方向:通信與信息安全。

段臣續 男,(1999—),碩士研究生。主要研究方向:視覺感知輔助無線通信。

羅文宇 男,(1982—),博士,副教授。主要研究方向:智能無線環境、可重構智能表面技術。

許 麗 女,(1978—),博士,教授。主要研究方向:計算機視覺、模式識別、機器學習等。

鐘云開 男,(1999—),碩士研究生。主要研究方向:智能無線環境、深度學習。

馬怡樂 男,(1998—),碩士研究生。主要研究方向:可重構智能表面技術。

基金項目:國家自然科學基金(U1804148);河南省科技攻關項目(232102210141)