跨媒體語義關聯增強的網絡視頻熱點話題檢測

張承德 劉雨宣 肖 霞 梅 凱

1(中南財經政法大學信息與安全工程學院 武漢 430073)

2(華中農業大學公共管理學院 武漢 430070)

(chengdezhang@zuel.edu.cn)

社交網絡和智能手機的普及使得網絡視頻數量爆炸式增長,并逐漸取代文本成為普通用戶信息交流的主要載體[1].據中國互聯網絡信息中心(CNNIC)發布的最新報告[2],截至2021 年6 月,國內網絡視頻用戶規模達9.44 億,較2020 年增長1 707 萬.同時,國外最大的視頻分享平臺YouTube,月活躍用戶人數已超過20 億,每分鐘上傳的視頻總時長超過300 h,人們每天在YouTube 上花費超過1010h 尋找和觀看視頻[3].當熱點話題發生時,用戶需要觀看數量龐大的網絡視頻,并花費大量時間和精力梳理和總結其前因后果,才能初步了解熱點話題的基本情況.而當遇到完全陌生的話題時,則進一步增加了這一難度.因此,網絡視頻熱點話題檢測變得十分必要.

傳統網絡視頻熱點話題檢測方法,主要通過計算標題、標簽間的語義相似度,將視頻劃分到不同的話題[4].通常,網絡視頻只有十多個詞描述,且文本信息少、噪聲多,這很容易引起文本語義特征空間稀疏[5],導致文本間語義關聯少且關聯強度弱.另外,由于不同的人表達習慣不同,以及多義詞、多語言等問題,將進一步降低文本間語義特征的關聯強度,難以建立視頻間聯系.現有方法主要通過引入視頻彈幕、評論等外部信息豐富文本語義空間[6-8].但是,這類方法存在2 方面問題:一方面,部分媒體平臺不支持發送彈幕和評論,導致部分視頻缺乏外部信息;另一方面,彈幕、評論有效信息少,內容冗雜,導致文本間語義關聯減少.因此,上述方法嚴重依賴于引入信息與話題的相關度,導致話題檢測性能不穩定.由于視頻內容豐富、客觀,且視頻內容與話題往往高度相關.因此,嘗試智能理解視頻內容,生成大量準確、客觀的語義信息,豐富文本語義特征空間,提升熱點話題檢測效果.

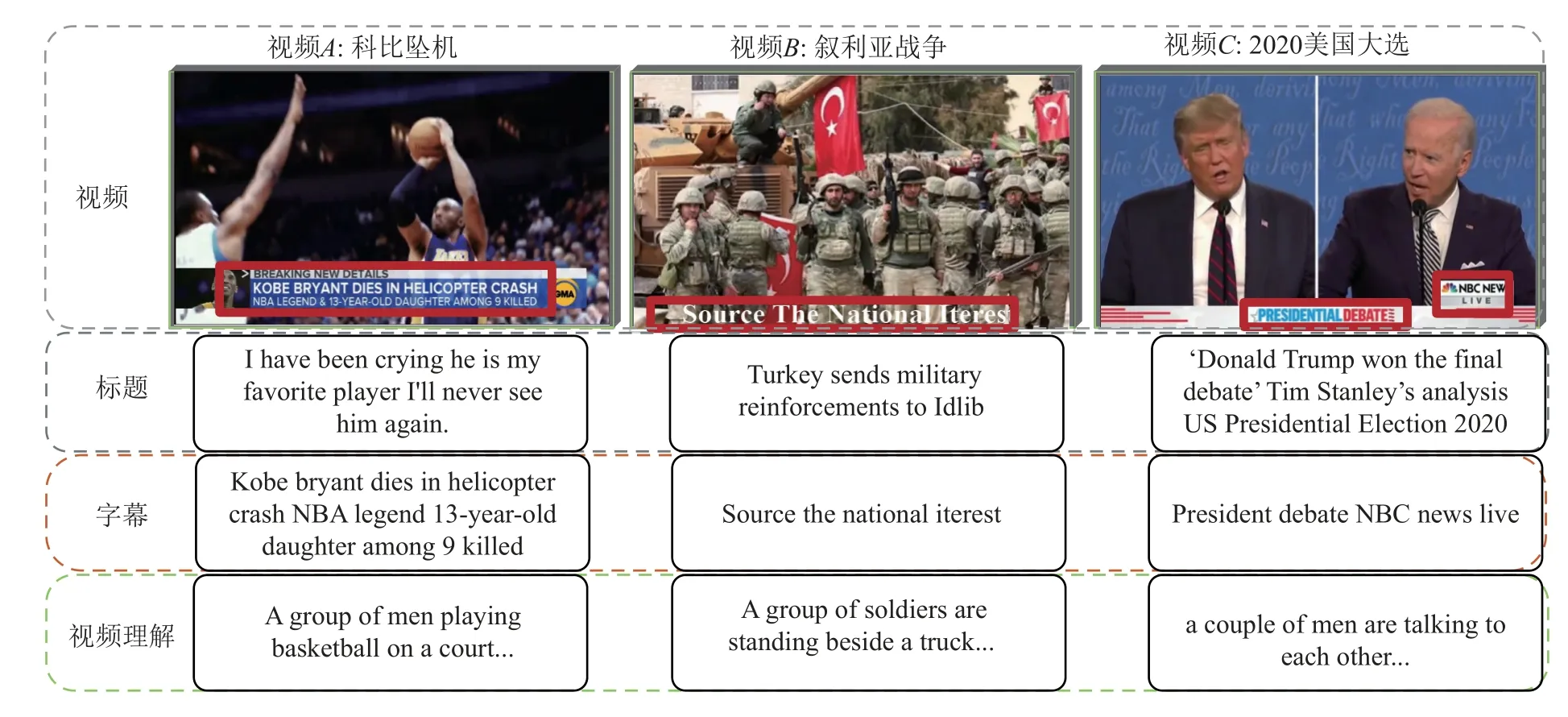

然而,由于視頻內容側重于對視覺具體信息的客觀描述,文本信息側重于對話題內容的抽象表達,帶有一定的主觀情感,導致同一話題下視覺語義與文本語義特征差異性較大.如圖1 所示,視頻A的標題表達了一種主觀情感,并未提及任何與話題相關的信息,字幕則直接表達科比墜機這一話題;在視頻B中,字幕僅表達視頻來源,與視頻所屬話題無關,視頻理解則清晰地展示了“士兵、坦克”等與戰爭主題高度相關的詞匯;在視頻C中,字幕以及視頻理解表達的語義都不準確,只有標題清晰地表達2020 美國大選這一主題.傳統的融合方法無法調和文本與視覺間的語義鴻溝,反而降低了同一話題下文本間的關聯強度.因此,如何克服文本語義與視覺語義間的差異,增強跨媒體語義的關聯,成為一個巨大的挑戰.

Fig.1 Three semantic differences圖1 3 種語義差異

為應對上述挑戰,提出一種新的跨媒體語義關聯增強方法.通過融合視頻理解、字幕、標題3 種語義特征,增強文本與視覺語義間的關聯強度,實現跨媒體信息的互補,解決話題檢測中的文本稀疏問題.該方法共分為4 步:第1 步,通過雙層注意力機制,挖掘文本語義特征.第2 步,通過視頻智能理解以及場景文字識別,生成一系列與視頻內容高度相關的文本信息,豐富文本語義空間.第3 步,跨媒體語義融合.首先,分別通過文本語義相關度和視覺語義相關度,構建文本語義圖和視覺語義圖;然后,構造時間衰減函數,通過視頻上傳的時間差,度量跨媒體數據間的話題相似性;最后,通過時間衰減系數量化文本語義圖和視覺語義圖間的連接強度,并將其加權疊加形成混合語義圖,增強跨媒體語義關聯.第4 步,話題檢測.通過圖移位(graph shifts,GS)算法[9]在混合語義圖中挖掘出密集子圖,并通過TextRank 算法[10]檢測出熱點話題.

本文的主要創新點和貢獻總結為3 個方面:

1)提出一種新的文本信息豐富方法.通過理解視覺內容,生成大量與話題高度相關的文本描述信息,避免外部數據引入而帶來的過多噪聲問題,實現網絡視頻的文本語義特征空間豐富.

2)構建了一種新途徑建立視覺與文本信息間的語義關聯.引入時間特征建立跨媒體語義關聯,主要通過時間衰減函數,量化視頻上傳時間差對跨媒體數據話題相似性的影響,以此增強跨媒體語義關聯強度,同時避免語義融合所帶來的噪聲干擾.

3)提出一種新的跨媒體語義關聯增強方法.通過構建文本語義圖,找到網絡視頻中缺失的話題關聯,并通過融合文本語義圖與視覺語義圖,重建文本與視覺語義間的連接,實現跨媒體語義互補增強.同時賦予模型良好的可擴展性,能輕松地將其他模態信息融合到語義圖中.

1 相關工作

1.1 熱點話題檢測與跟蹤

熱點話題檢測與跟蹤(topic detection and tracking,TDT)任務源于美國國防高級研究計劃局贊助的研究計劃[11],核心任務是從數據流中發現新話題,并收集后續的相關報導[12].早期的話題檢測主要是面向新聞、博客等長文本,隨著社交媒體的快速發展,使得信息的傳播不再局限于文本這一種形式,網絡圖片和視頻在信息交流中占據主導地位,話題檢測也由面向純文本擴展為基于文本、圖像、視頻等多模態融合的話題檢測[13].

對于文本信息,早期的話題檢測方法大多基于LDA(latent Dirichlet allocation)主題模型[14]或其改進模型[15].受LDA 固有的局限性,這些方法對長文本效果較好、對短文本效果較差.文獻[16]通過搜索引入相關文本以擴展短文本,但此方式過于依賴于輔助文本的質量,當引入文本質量不高或者相關文本不充足時,話題檢測效果較差.文獻[17]提出了一種BTM(biterm topic model)主題模型,這是對LDA 模型的一種改進,利用詞共現關系豐富詞組,從而緩解短文本的稀疏性問題,此模型對短文本主題檢測效果有一定的提升.但是,當文本特征過于稀疏或者存在噪聲、一詞多義時模型的檢測效果較差.所以這種基于主題模型的話題檢測方法對視頻標題并不適用.

對于圖像和視頻,現有方法主要利用豐富的視覺信息進行話題挖掘.文獻[18]通過注意力提取視頻局部顯著語義特征和全局語義特征,并進行分類表示以區分不同話題.文獻[19]提出了一種圖像主導的主題模型,將視覺特征作為信息線索進行話題檢測.這種檢測方法雖然較好地利用了視覺信息,但由于網絡視頻大多由用戶隨意拍攝和剪輯,再加上拍光照、運動、拍攝角度等多種因素的變化,導致視覺語義特征獲取并不準確、檢測效果不佳.

對多模態數據,現有方法主要通過多種模態數據中的互補信息來檢測熱點話題.文獻[20]對視覺信息和文本信息之間的相關性進行研究,探索不同模態數據間的語義關聯.文獻[21]利用圖片理解技術,挖掘圖片表達的語義信息;通過融合文本與圖像信息,實現了短文本語義空間豐富.受此工作的啟發,我們通過視頻理解技術,深度挖掘網絡視頻中的語義信息,并與稀疏的文本語義融合,豐富文本語義.

1.2 視頻理解

視頻理解旨在理解視覺內容,實現視覺特征向自然語言的轉化[22].文獻[23]提出了一種按固定的語法和模板生成句子的方法,但是這種基于模板的方法生成的句子單一,束縛了模型的表達能力.隨著深度學習取得突破性進展,基于深度學習的視頻理解方法被廣泛應用.文獻[24]提出了一種S2VT(sequence to sequence video to text)模型,引入編碼解碼器架構,實現特征的編碼和解碼.同一時期,文獻[25]在模型中引入注意力機制,對視頻幀的卷積特征進行加權求和,實現更精準的特征選擇,但是生成的句子表達依舊不夠準確,難以滿足實際生活的需要.近年來,許多研究都聚焦于改進視頻特征提取的方法或改進編碼的循環神經網絡的結構.文獻[26]提出了一種基于雙向時序圖的對象感知聚合模型,通過構建雙向時序圖實現了對視頻特征更為精細的捕捉.文獻[27]提出了一種視覺特征編碼技術,通過傅里葉變換嵌入時間動態,并改用循環門控單元生成豐富的語義.

此外,網絡視頻中包含豐富的場景文字信息,往往與視頻主題高度相關.已有部分工作結合場景文字與視覺特征,增強圖像和視頻內容理解.如文獻[28]將圖像中的場景文字信息與圖像卷積特征相結合,增強視覺特征表達.文獻[29]利用圖片中的場景文字,增強短文本與視覺間的交互關系,并在上述工作的啟發下,試圖將視頻中的字幕信息與視頻理解相結合,挖掘視覺語義,豐富文本語義空間.

1.3 跨媒體融合

跨媒體數據具有分散異構、語義關聯和多模態的特點,相同語義可以借由不同跨媒體數據表達.而不同跨媒體數據低層特征表示不一致,導致無法直接通過特征計算數據間的相關性[30].早期主要是利用人工標注跨媒體數據,然后通過標簽信息實現跨媒體數據間的關聯和檢索,但是人工標注成本高、速度慢且具有一定的主觀性,對海量的跨媒體數據并不適用.隨著深度學習的成功,針對圖像和視頻的分析技術迅速發展.通過分析和理解跨媒體數據的內容,結合標題、場景文字等信息,形成語義標簽以輔助跨媒體融合成為了主流方法.文獻[31]提出一種混合注意力模塊,同時利用多模態數據內部的聯系以及文本詞和圖像位置之間的關系進行融合,實現了多模態數據的關聯和互補.文獻[32]捕捉多模態數據的整體特征,并映射到同一空間實現多模態數據的融合.這種融合方式在一定程度上實現了跨媒體數據的對齊,但是它們都過于復雜,而且要求文本和視覺信息具有嚴格的對應關系,這對網絡視頻并不適用.

然而,報道同一熱點話題的跨媒體數據具有相似的語義內容,而且通常在相似的時間上傳,因此,同一話題下的跨媒體數據具有很強的語義相似性和時間相似性.文獻[33]通過時間窗口改進聚類模型實現新聞文本主題的精準捕捉.但其主要是基于文本的分析,尤其是針對新聞文章,這對稀疏的視頻文本并不適用.所以為了解決上述問題,構建了一種簡單且有效的融合方法.通過文本語義相似性和視覺語義相似性,分別構建文本語義圖和視覺語義圖,通過圖的融合實現跨媒體數據的融合.此外通過時間衰減函數,將時間特征嵌入混合語義圖,增強文本和視覺語義關聯強度,形成更為平滑的密集子圖.

2 網絡視頻熱點話題檢測方法

本文提出的話題檢測框架如圖2 所示,框架包括4 個步驟,分別為文本語義特征提取、視覺語義特征提取、跨媒體語義融合以及話題檢測.

Fig.2 Topic detection framework圖2 話題檢測框架

2.1 文本語義特征提取

受文獻[34]的啟發,我們構造了一個雙層注意力模型,分別通過單詞級注意力和句子級注意力挖掘文本核心語義特征.假定數據集中共有J篇文本,每篇文本有L個句子,每個句子包含T個單詞.其中j∈[1,J]表示第j篇文本,i∈[1,L]表示文本中第i個句子,t∈[1,T]表示句子中第t個單詞.

2.1.1 單詞級注意力

對給定的第i個句子中的第t個單詞wi,t,由詞向量模型[35]將單詞編碼為詞向量xi,t,接著將詞向量輸入到雙向長短期記憶網絡(bi-directional long short-term memory,BiLSTM)[36]單元,分別獲取前向隱藏層狀態和后向隱藏層狀態.式(1)和式(2)展示了LSTM(long short-term memory)細胞單元,將隱藏層狀態傳遞到下一個細胞單元,并獲取雙向時序信息的過程.

其中xi,t表示LSTM單元的輸入,表示前一時刻的隱藏層狀態分別表示LSTM單元的前向和后向隱藏層狀態.然后連接前向和后向的隱藏層狀態,得到給定單詞wi,t的特征向量表示.式(3)展示了整合前向和后向隱藏層狀態的過程.

其中 ⊕表示元素求和,hi,t表示雙向LSTM 輸出的隱藏層狀態.

在單詞級別,通過單詞級注意力區分不同單詞的重要性,并將其聚合為句子向量表示.首先,將單詞隱藏層向量hi,t輸入帶有激活函數 tanh的非線性神經元層,將hi,t投影到同一個注意力空間(見式(4));然后,利用uwod作為衡量指標,wod為單詞級標記,計算ui,t的重要性,并將結果歸一化后得到不同單詞的權重(見式(5));最后,通過加權求和的方式計算句子向量Si(見式(6)).單詞上下文向量uwod在訓練過程中被隨機初始化并聯合學習.

其中ui,t表示隱藏層狀態hi,t的投影向量,T 表示轉置,Wwod和bwod表示網絡的權重矩陣和偏置值,ai,t表示句子內部每個單詞的權重,Si表示文本中第i個句子的特征向量.

2.1.2 句子級注意力

在句子級別,通過句子級注意力區分不同句子的重要性,并將其聚合為文本向量表示.首先,通過BiLSTM 對文本中的句子進行編碼表示,為了簡單起見,我們將BiLSTM 單元的操作表示為hi=fBiLSTM(Si),即以句子Si為中心,整合句子上下文信息的隱藏層向量表示;其次,將隱藏層狀態hi投影到同一個注意力空間(見式(7)),并隨機初始化一個句子級別的上下文向量usen,用于衡量不同句子的重要性;然后,將計算出的句子重要性,歸一化后得到每個句子的權重(見式(8));最后,對句子向量進行加權求和,并經過一個全連接層映射得到文本語義特征表示(見式(9)).

式(8)和(9)中,ui表示句子隱藏層狀態的投影向量,T 表示轉置.ai表示文本中第i個句子的權重,usen表示句子上下文向量,在訓練過程中被隨機初始化并聯合學習,sen 為句子級標記.式(9)中,表示蘊含第j篇文檔結構知識的文本語義特征表示,tex表示文本標記.Wsen,Wtex和bsen,btex分別表示訓練得到的權重和偏置值.

2.2 視覺語義特征提取

2.2.1 視頻理解

由于傳統模型在復雜的真實場景中表現不佳,因此通過視頻理解結合光學字符識別(optical character recognition,OCR),實現對視覺語義的精準捕捉.如圖3 所示視頻理解模型包括4 個階段:

Fig.3 Video caption model圖3 視頻理解模型

1)特征提取階段.利用基于注意力的C3D 網絡[37]提取視頻顯著性區域的運動特征,通過VGG16[38]提取視頻的全局卷積特征,并通過全連接層連接這2類特征,作為視頻的特征輸入.

2)特征編碼階段.特征的編碼主要由2 層LSTM和視覺注意力實現.在每個時間步長下,2 層LSTM將可變長度的輸入編碼為固定維度的向量,視覺注意力則用于捕捉視覺特征中的顯著性區域.即對于輸入特征X=(x1,x2,…,xn)經過2層LSTM的編碼得到其隱藏層狀態序列此序列經過注意力加權得到當前時刻的特征編碼(式(10)).

其中ct表示編碼后的特征輸出,at,i表示編碼器隱藏層向量hemb的權重(式(11)),et,i由LSTM 隱藏層狀態經過激活函數后得到.ba均表示可學習的參數.

3)特征解碼階段.輸入序列經過解碼器解碼為輸出序列Y=(y1,y2,…,yn)上的分布(見式(13)),再通過Y查詢詞匯表得到對應的單詞.此外,當前時刻生成的單詞會作為特征序列與輸入特征連接后傳入到解碼器,為下一時刻單詞的生成提供支持.

其中ct表示編碼器輸出,hdec表示解碼器隱藏層輸出,yt-1表示前一時刻解碼器輸出的序列,p(y1,y2,…,ym|x1,x2,…,xn) 表示對于特定輸入X獲得的輸出分布.

4)訓練階段.模型以MSVD 數據集[39]作為知識庫,采用端到端方式訓練.訓練目標是:使得預測句子的對數釋然估計值最大.即通過最大化對數釋然估計值,不斷更新參數 θ讓模型找到最優解碼序列Y=(y1,y2,…,ym),見式(14).

2.2.2 視覺語義嵌入

視覺語義嵌入分為2 步:第1 步,將生成的字幕和視頻描述編碼為詞向量,并將該詞向量輸入到BiLSTM 模型中,得到蘊含上下文語義信息的隱藏層特征向量;第2 步,通過自注意力對隱藏層狀態進行加權(見式(15)和式(16)),并將加權融合后的特征經向量全連接層得到視覺語義特征表示(見式(17)).

其中ei表示隱藏層狀態經過全連接層后的輸出,u表示經過訓練后得到的權重參數矩陣,ai表示注意力權重,表示第j個視頻的視覺語義特征表示,L表示文本長度.W,Wvid,b,bvid分別表示訓練權重和偏置值,vid表示視頻標記.

2.3 跨媒體語義融合

2.3.1 文本語義圖

2.3.2 視覺語義圖

2.3.3 混合語義圖

通過視頻上傳時間差,構造時間衰減函數,以衡量時間對跨媒體數據間話題相似性的影響,從時間維度增強話題結點間的關聯.時間衰減函數為:

其中 β是控制衰減速率的正標度參數,L用于控制衰減周期,ti和tj表示視頻i和視頻j的時間戳,表示向下取整.從式(22)中可以看出時間衰減函數pi,j隨時間間隔的增加而降低,這表明視頻i和j屬于同一話題的可能性較小.不同數據的主題相似度隨它們的時間間隔呈指數下降.

如式(23)所示,通過時間衰減函數pi,j賦予文本語義圖和視覺語義圖不同的連接權重,并將其加權疊加形成混合語義圖G=({ni},{wi,j}).融合過程中,將Gvid和Gtex的結點合并,得到混合語義圖的結點集.這樣,缺失的結點信息在融合過程中得到豐富和補充,從而建立起更豐富的語義關聯.結點間的連接權重通過時間衰減函數加權求和并歸一化后得到融合后的連接權重wi,j.

其中G表示構造的混合語義圖,{ni}表示結點集,{wi,j}表示邊的權重集.時間信息的嵌入增強文本語義與視覺語義間的連接強度,若混合語義圖中的文本語義、視覺語義以及上傳時間都相似,那么所對應結點的連接較強(即邊權重大),會在圖中形成一個稠密的子圖.這種融合方式使模型具有較強的可擴展性,能輕松地將其他模態的信息(如地理位置、情感傾向等)也融合到語義圖中.而且基于圖的方式可以在話題個數未知的情況下進行話題聚類,使得模型更加魯棒.

2.4 話題檢測

通過GS 算法在混合語義圖中由聚類分析找出密集子圖(即話題簇).GS 算法的輸入是混合語義圖G的鄰接矩陣M,矩陣M中的每一個元素都由混合語義圖的連接權值wi,j決定.混合語義圖的子圖由概率簇x∈Δm表示.其中Δm={x|x∈Rm,xi≥0,|x|1=1},m表示圖中的結點總數,x表示一個映射向量,x=(xi)實現了圖中的結點集到單一標準形 Rm的映射,每一個x∈Δm表示了各結點的組合概率,稱為概率簇.其中xi表示x的第i個分量包含結點ni的概率,xi=0表示該概率簇不包含頂點ni.如式(24)所示,GS 算法通過衡量子圖x中的平均連接強度,找到g(x)所有的局部極大值 {x*}.每一個局部極大值x*代表了混合語義圖的一個密集子圖,也就是我們所探尋的熱點話題.

其中M表示存儲混合語義圖的鄰接矩陣,x表示混合語義圖中結點到話題簇的映射,g(x)表示子圖的平均連接強度,x*表示g(x)的局部極大值.挖掘出密集子圖后,利用TextRank 算法[10]在密集子圖中抽取出K個關鍵詞表示熱點話題.

3 實驗結果與分析

3.1 數據集

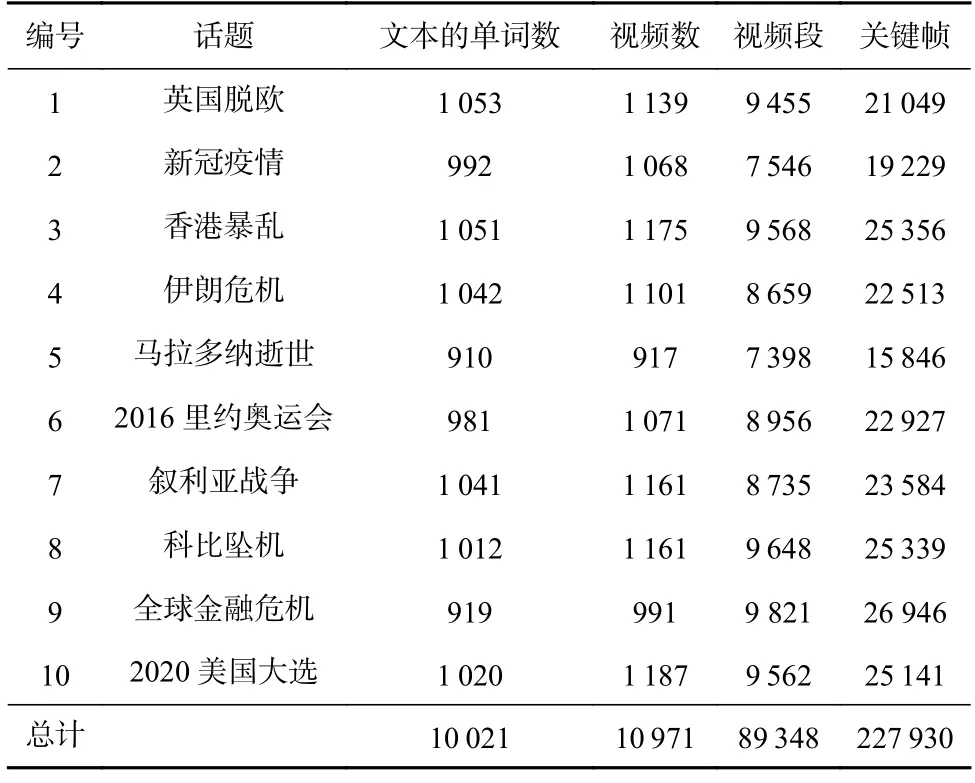

以國內新華網、新浪網,國外視頻分享網站YouTube、美國有線電視新聞網CNN 等主流媒體上最熱門的話題為依據,爬取了10 個熱點話題.實驗數據集詳細信息如表1 所示,包括10 021 條文本、10 971個視頻,利用基于顏色直方圖的方法[40]切分視頻得到89 348 個視頻段,提取227 930 個關鍵幀.實驗所用數據集涵蓋多個角度、覆蓋不同的時間跨度,范圍從1 個月到3 年不等,涉及經濟、政治、體育、生活等多個領域.因此,實驗數據具有足夠的代表性,充分驗證了實驗的有效性.

Table 1 Experimental Dataset表1 實驗數據集

3.2 評價指標

實驗采用標準的精確率(Precision)、召回率(Recall)和F1 值評價所提出方法的有效性.

其中A表示檢測到的話題數據集,B表示與A最匹配的真實話題數據集,B+表示正確檢測的話題數據集.Precision表示所有檢測出的信息中,正確樣本數目的占比;Recall表示正確檢測出的樣本在所有樣本中的占比.由于F1 值兼顧了精確率和召回率的優點,因此F1 值被作為評價實驗結果的主要方式.

3.3 參數設置及其分析

實驗中,我們在數據集上無監督地訓練一個word-2vec 模型[35],得到128 維的詞嵌入向量.在視覺特征提取方面,我們在ImageNet 數據集上預訓練一個VGG16模型[38],并將其第1 個全連接層的輸出作為視覺特征,維度大小為4 096.對于文本特征,2 層LSTM 維度相同,設置為64 維.上下文向量uwod和usen設置為128 維,并且隨機初始化.

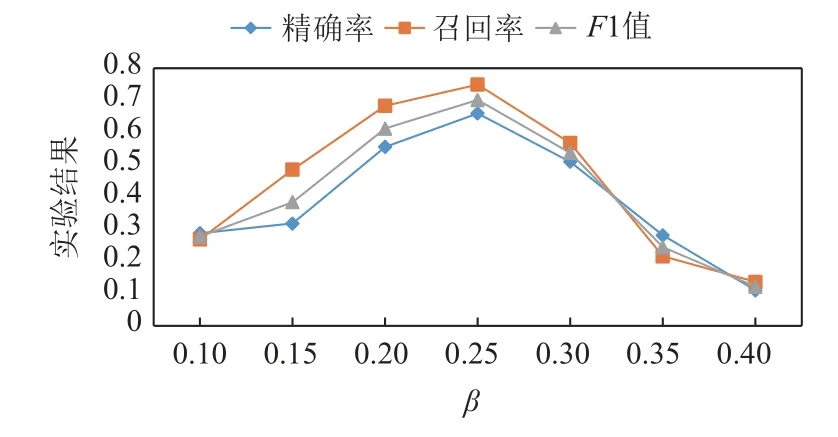

此外,時間衰減函數(見式(22))中設置了2 個參數,固定的時間單位因子L和正標度參數 β.L控制時間函數的衰減周期,對實驗結果影響較小,在我們的模型中設置L=10;標度參數 β控制函數的衰減速率,即控制檢測話題的感興趣粒度(熱點話題的持續時間),較小的 β使得結點之間的連接權重更大,加強數據之間的聯系,使得大粒度的話題更容易形成密集子圖.例如話題6(2016 里約奧運會)的粒度大于話題5(馬拉多納逝世),所以在話題檢測時相似性較弱的數據結點更容易被劃分到話題6,從而帶來一些噪聲.相反,較大的 β值,削弱了結點之間的聯系,有利于小粒度的話題,但可能會丟失一些大粒度話題的正確結點.我們設置不同的 β值,以探究 β對實驗結果的影響.如圖4 所示,話題檢測的F1 值隨著 β的增長,先增大后減小.這是因為我們選取的話題粒度不一,β較小時,大粒度的話題F1 值較高,小粒度的話題F1 值較低,而當 β較大時,則小粒度話題的F1 值高,大粒度話題的F1 值低.所以在我們的數據集中選取 β=0.25時能獲得最佳的實驗效果.

Fig.4 Effect of β on topic detection圖4 β 對話題檢測的影響

3.4 實驗結果對比分析

3.4.1 基線方法

為了全面評估本文所提出的模型,我們將本文模型與8 種基線方法進行對比,以驗證模型的有效性.

1)LDA(latent Dirichlet allocation)[14].該方法利用視頻文本進行主題挖掘,通過推測文檔的主題分布,得到視頻的主題分布.實驗中,我們將文本輸入到LDA,并設置挖掘的主題數量,得到文本-主題分布向量,最后通過聚類方法得到主題.

2)BTM(biterm topic model)[17].該方法與LDA 主題模型類似,BTM 模型對多個詞組建模更適用于短文本.實驗中,我們將文本輸入到BTM,并設置挖掘的主題數量,得到文本-主題分布向量,最后通過聚類方法得到視頻主題.

3)Doc2vec(document to vector)[41].該方法屬于一種無監督算法,通過預訓練的Doc2vec 模型,從變長的文本中學習得到固定長度的特征表示.在實驗中,我們將變長的文本信息編碼為128 維的特征向量,再通過對文檔向量的聚類得到視頻主題.

4)BiLSTM_Attn(attention-based bidirectional LSTM)[42].該方法通過雙向長短期記憶網絡挖掘文本上下文語義,并利用注意力對句子加權求和得到文本特征表示,再經過分類得到不同主題.

5)VSD_Attn(attention for video saliency detection)[43].該方法通過視覺顯著性的注意力模型,提取視頻局部顯著語義特征和全局語義特征,并進行分類表示以區分不同話題.

6)CSG(capsule semantic graph)[44].該方法利用文本中詞共現關系構建關鍵字子圖,并通過相似度連接形成膠囊語義圖,最后在語義圖上進行聚類得到不同的話題.

7)TopicBERT(topic detection using BERT)[45].該方法通過多模態命名實體識別和Bert 挖掘單詞間的語義關聯,并通過結構規則和實體類別增強話題信息.

8)SMMTM(unsupervised multimodal topic model)[46].該方法通過圖像信息豐富文本語義,解決文本稀疏問題,并利用無監督的多模態主題模型對文本和圖像信息進行建模和分類.

3.4.2 實驗結果分析

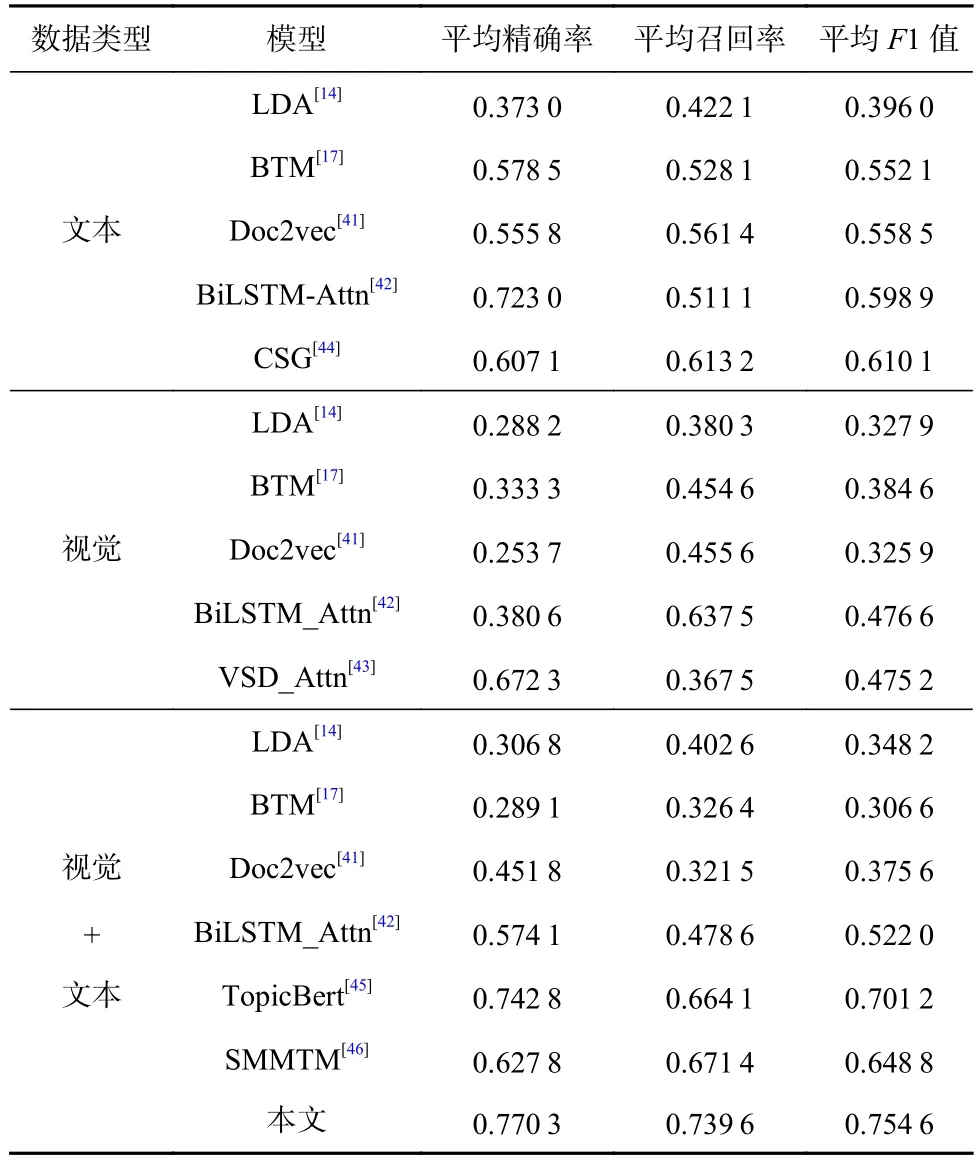

表2 展示了僅利用文本信息(標題+標簽)、僅利用視覺信息(視頻理解+字幕)以及文本與視覺信息聯合的實驗結果.通過前10 個主題的平均精確率、平均召回率和平均F1 值評估話題檢測方法的總體性能.實驗結果表明,提出的模型比其他話題檢測方法表現更優,與基線模型相比提升20%~30%(平均F1 值).

Table 2 Average Experimental Results Under 10 Topics In Multiple models表2 各模型中在10 個話題下的平均實驗結果

如表2 所示,LDA 模型在3 組數據中的表現都不好.因為LDA 是基于概率的主題模型,具有主題模型固有的局限性,導致LDA 對長文本較為敏感,對短文本的檢測效果較差.而數據集中的文本由視頻標題組成,通常只含有10 多個單詞,長度短、詞共現頻率低,導致LDA 檢測的效果較差.此外,視覺信息由視頻理解和字幕信息組成,是對視頻底層細節的客觀描述,包含較多的噪聲以及與主題無關的信息,導致LDA 檢測效果較差.另一方面,直接合并文本和視覺信息雖然豐富了文本,但引入了大量的噪聲,導致LDA 模型的檢測效果降低.

BTM 模型也是一種基于概率的主題模型,通過共現詞對預測文檔主題,比LDA 模型更適用于短文本.實驗結果表明,BTM 模型對文本的檢測效果相比LDA 有一定的提升,但是在視覺信息上實驗效果仍然較差,因為BTM 模型以詞袋模型編碼單詞作為輸入,忽視了詞匯間的語義關聯,再加上視覺信息中所含的噪聲較多,因此實驗效果不佳.

Doc2ve 是一種無監督文本向量模型,相比LDA在3 個評價指標上都有較大的提升,相比BTM 模型在平均召回率上有一定的提升.這是因為Doc2vec 方法克服了詞袋模型的缺點,考慮到詞匯間的語義關聯.但Doc2vec 在視覺信息上的實驗效果也較差,因為其僅僅是文本中多個詞向量的平均,沒有區分不同單詞的重要性,并且模型忽視了單詞間的時序信息,導致模型的平均精確率不高.

BiLSTM_Attn 模型基于循環神經網絡,對于文本信息,獲得了較高的平均精確率.因為模型利用長短期記憶網絡捕捉時序信息,此外注意力機制區分單詞的重要性,獲得精確的語義表達,故得到較高的平均精確率.但受限于文本信息較少、文本間語義關聯較少,導致模型的平均召回率較低、平均F1 值也較低.對于視覺信息,注意力機制的加入使得模型的平均召回率有一定程度的提高,但受噪聲影響,平均精確率提升并不明顯,這導致模型平均F1 值不高.

VSD_Attn 方法獲得較高的平均精確率,這表明若視頻包含了相同的顯著性區域,則這些視頻通常屬于同一話題.但是,此方法的平均召回率和平均F1 值較低,因為與文本信息相比視覺內容的噪聲更少,平均精準率更高,但是更容易受到視頻編輯、光照、拍攝角度變化的影響.導致顯著性區域相似性檢測不準確,因此當只有視覺信息時,平均召回率非常低.事實上,同一個話題可以被分割成多個視覺場景,而基于顯著性區域檢測的方法只能將視覺特征相似的場景組合到一起,導致同一話題下的視頻缺失.

CSG 方法通過詞共現關系構建膠囊語義圖,從而挖掘話題信息,相比傳統的主題模型獲得更高的平均召回率和平均F1 值.但由于稀疏文本中詞共現頻率低,再加上個人語言表達習慣問題,相同的視頻可能由不同的詞描述,導致相同的語義無法關聯,在社區檢測中相關結點無法被準確地劃分到同一個子圖中,導致準確率較低.

TopicBert 方法通過Bert 和多模態命名實體識別增強文本間的語義關聯,獲得較高的平均精確率,但平均召回率提高并不明顯.事實上,一個話題包含多種類別的視頻,可能由完全不同或部分不同的場景組成,通過嵌入實體類別劃分視頻只能將內容相似的場景組合在一起,更多不同場景的視頻將會丟失.另外基于規則的主題優化方法,也很難將所有的視頻都挖掘形成話題.

SMMTM 方法結合短文本與圖像信息,通過視覺相似性,增強文本間的語義關聯,但是對視覺特征的簡單處理,并沒有解決視覺相似性檢測不精確問題,因此模型的平均精確率不高.這說明SMMTM 雖然可以增強文本間的語義關聯,但是不可避免地引入噪聲.

此外,通過分析數據我們得出2 個結論:

1)文本比視覺信息在多個模型中表現得更好,這說明文本特征比視覺特征更重要.通過文本與視覺信息在LDA,BTM,Doc2vec,BiLSTM_Attn 中的結果可以發現,將視覺特征轉化為文本信息后,在一定程度上提升了平均召回率,但平均精確率受到了較大影響,導致平均F1 值降低.因為視頻理解將視覺信息翻譯成自然語言的過程中丟失了視覺特征的特異性.例如:在科比墜機的話題下,會出現科比打籃球的場景,在里約奧運會這個話題下同樣會出現打籃球的場景.但通過視頻理解它們會被翻譯為相同的描述:a group of men playing basketball,相似但不相關視覺信息被翻譯成相同的語言描述,且在后續的處理中它們被認為是完全相同的特征,導致純視覺信息檢測的平均精確率較低.相反,視覺信息檢測的平均召回率高于文本檢測,一方面是因為文本較為稀疏,所含的有效信息少、噪聲多,使得文本檢測的平均召回率低,另一方面OCR 從視頻中獲取的字幕信息與視頻內容高度相關,很容易與視頻理解得到的語義信息產生聯系,從而將更多相關的數據聚集到一起,使得視覺信息檢測的平均召回率高于文本檢測.

2)視覺特征與文本特征的直接合并效果比單一文本更差,這表明實現視覺信息與文本信息的互補,需要找到適合的融合方法.以BiLSTM_Attn 模型為例,文本與視覺信息的直接合并相比于純文本,平均精確率下降15%,平均召回率下降4%,平均F1 值下降8%.這是因為視頻特征經由視頻理解會引入部分的無意義詞匯,簡單地合并造成了文本信息的泛化、文本間的語義關聯強度降低,導致模型檢測效果較差.提出的方法在3 種評價指標上都獲得了最優的實驗性能,相比于單一文本或視覺的最優值,本文方法的平均精確率提升約5%,平均召回率提升約10%,平均F1 值提升約15%.因為通過雙層注意力,區分了不同單詞和句子的重要性,極大地降低噪聲的干擾.此外,將文本和視覺語義融合到同一個混合語義圖中,保證文本和視覺語義優勢互補,避免相互干擾,使得模型的平均精確率和平均召回率都有較大的提高.

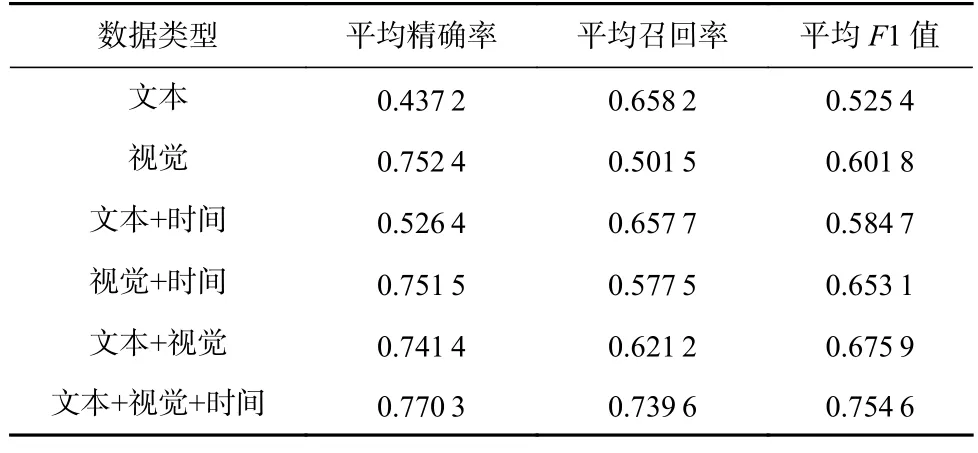

此外,通過消融實驗驗證本文所提出方法的有效性.如表3 所示,文本、視覺分別表示僅利用文本、視覺數據構建語義圖,文本+視覺表示文本與視覺信息融合構建語義圖,文本+視覺+時間表示嵌入時間的文本和視覺語義圖融合.

Table 3 Ablation Experiment表3 消融實驗

通過對比實驗數據可以得出 2 個結論:

相比單一文本或視覺,跨媒體融合的方式在話題檢測效果上有較大的提升.雖然文本+視覺相比于單一視覺信息,平均精確率略有降低(降低1%),但平均召回率有較大的提高(提高12%),平均F1 值提高7%.這是由于視覺特征會受到光照、編輯、拍攝角度等的影響,導致同一場景下的視覺特征可能完全不同,因此單一視覺信息具有精確率高、召回率低的特點.融合文本信息后,文本語義相似的視頻也會被納入同一話題,這個過程中帶入部分噪聲數據,導致平均精確率略有降低,但同時平均召回率有較大的提升.所以我們在混合語義圖中嵌入時間特征,通過時間相似性,從時間維度給文本和視覺語義關聯增加權重,使得語義上難以區分的數據可以通過時間特征被輕松區分,很好地解決了這一問題.

嵌入時間特征后,本文模型的平均精確率提升3%,平均召回率提升11%,平均F1 值提升8%,表明在混合語義圖中嵌入時間特征能增強混合語義圖的區分能力.這是因為熱點話題的爆發都具有很強的時間聚集性,所以時間特征對于不同的熱點話題具有很強的區分能力.通過時間衰減函數將時間分布特征嵌入到混合語義圖中,增強相同時間跨度內文本與視覺語義間的連接強度,從而避免具有相似文本和視覺特征的噪聲干擾.因此在本文模型下,文本和視覺難以區分的數據可通過時間分布特征輕松區分.此外,這種時間系數的軟量化在一定程度上保證話題在時間上的連續性,防止由于時間線硬分割而導致的同一話題被錯誤分割.

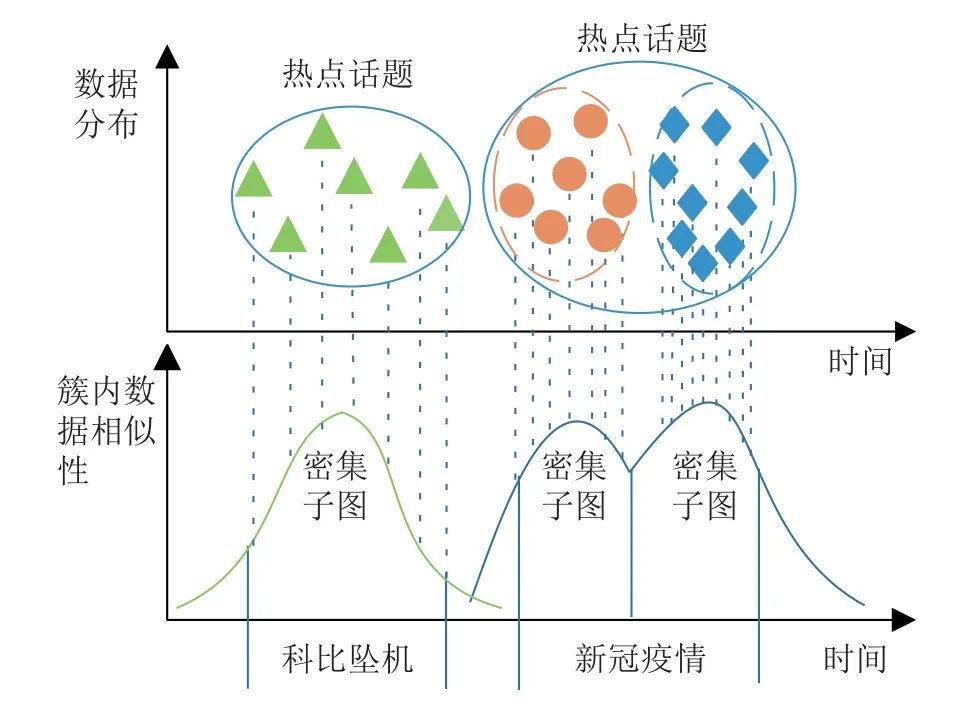

為了進一步證明時間特征可以有效增強話題檢測效果,我們統計了短期爆發和周期型爆發話題的數據分布情況.如圖5 所示,對于“科比墜機”這一話題,網絡視頻在短期內集中爆發,文本和視覺特征具有很強的時間相似性.通過時間戳的嵌入,可以在時間維度建立跨媒體數據間的語義關聯,增強密集子圖中結點的連接強度,所以模型對于短期爆發的熱點話題具有很強的檢測能力.對于“新冠疫情”這一話題,在不同時段內形成多個密集子圖,導致熱點話題被分割成多個密集子圖.但是,同一話題下密集子圖的語義相似性遠高于不同話題下的密集子圖.因此,通過計算密集子圖間的平均歐氏距離(Euclidean distance)能有效實現密集子圖的合并,得到完整的熱點話題.

Fig.5 Time distribution characteristics of topics圖5 話題的時間分布特征

表4 展示了從10 個話題中挖掘出的高頻話題詞.以話題8 為例,我們不僅挖掘出了Kobe,death,NBA等文本中出現的高頻詞,還挖掘出playing,running,basketball 等低頻詞.視覺特征向文本信息轉換的過程中生成了大量新詞,增加了playing,running,basketball這類低頻詞的出現頻率,豐富了文本語義空間.此外,視頻理解生成的basketball,player 與標題和字幕中的NBA,playing 高度相關,增強了跨媒體數據間的語義關聯強度,使得熱點話題更容易形成密集子圖,從而被準確地檢測.

表5 展示了3 個具體的例子,以表明本文提出方法的有效性.例1 標題中并沒有出現與“科比墜機”相關的單詞,導致語義關聯缺失,基線方法僅通過標題無法準確劃分.而通過視頻理解和字幕,從視覺語義中挖掘出Kobe,bryant,crash,accident 等詞,建立起該視頻結點與“科比墜機”話題的聯系,這有效提高模型的召回率;例2 標題中出現“2020 presidential victory”和“Brexit”,極易被錯分為“2020 美國大選”.而通過融合視覺語義以及時間特征,增強了視覺語義London 與Brexit 的語義關聯,這使得該結點在聚類過程中被正確劃分.同樣地,例3 中語義融合時,受文本噪聲financial markets 的影響,該結點極易與話題“全球金融危機”混淆,而融合方法從時間維度對該結點進行相似度加權,因為此視頻上傳時間處于新冠疫情大爆發期間,并且視覺語義masks 與新冠疫情密切相關,這增強了該視頻結點與新冠疫情的語義關聯強度,從而使得該視頻被正確劃分,因此模型具有較高的精確率.

4 總結

本文提出一個新的跨媒體語義關聯增強方法,解決文本特征稀疏導致的同一話題下文本語義特征差異大且關聯強度弱的問題.首先,構造一個雙層注意力模型,通過單詞級注意力和句子級注意力捕捉文本核心語義特征;然后,通過視頻理解和場景文字識別,生成與視頻內容高度相關的文本描述信息,豐富文本語義空間;最后,將文本語義和視覺語義通過時間衰減函數,加權融合形成混合語義圖,增強跨媒體語義關聯,使得話題的分割更為準確.實驗結果表明,本文提出的方法能有效提高網絡視頻熱點話題檢測效果.

作者貢獻聲明:張承德提出論文思路,并指導論文撰寫和修改;劉雨宣負責方法設計,完成實驗并撰寫論文;肖霞對實驗設計和論文撰寫提出指導意見;梅凱為實驗數據提供支持,并對數據進行處理.