基于傅里葉描述子的吸煙行為檢測方法*

趙鑒福,梁金幸,史寶軍,3

(1.河北工業大學 省部共建電工裝備可靠性與智能化國家重點實驗室,天津 300401;2.河北工業大學 機械工程學院 河北省機器人感知與人機融合重點實驗室,天津 300401;3.國家技術創新方法與實施工具工程技術研究中心,天津 300401)

0 引 言

石化廠區內的吸煙行為是引發火災、爆炸事故的重要原因之一,因此吸煙行為檢測作為一種安全監測方法越來越受到重視。與火災事故發生產生的滾滾濃煙不同的是,吸煙產生的煙霧表現為一種半透明的煙霧。傳統煙霧傳感器[1]只有煙霧接觸到傳感器且煙霧濃度到達設定閾值時會發出警報,傳感器普遍布置于屋頂或傾斜墻壁,對吸煙產生的煙霧不敏感。隨著計算機視覺的發展,基于視頻圖像的煙霧檢測成為可能。煙霧的擴散運動規律可以有效區分煙霧和非煙物體,姚太偉等人[2]通過分析煙霧的運動規律,采用分塊和背景自適應的方法建立煙霧的顏色模型。Chen T H等人[3]分析煙霧的三原色(RGB)三通道圖形信息,發現煙霧在三通道的對應像素之間像素值差幾乎可以忽略,利用RGB 顏色模型可以區分部分煙霧。Tian H 等人[4]利用混合圖像模型區分煙霧與背景,提出一種優化算法求解煙霧的不透明度。Yuan F N等人[5]提出了一種基于積分圖像的累積運動模型,該模型能有效減少人工燈光和非煙物體的干擾。在此基礎上,進一步研究了噪聲和非煙物體雜亂運動干擾的消除技術[6]。張潔等人[7]提出了一種結合煙霧紋理特征與輪廓光流失量的煙霧識別方法,對可疑區域進行分析,提高檢測效率。但是,不同的光照、氣象條件對獲取的煙霧視頻質量產生了較大的影響,進而影響了吸煙檢測的精確率。

針對上述情況,以煙支為檢測對象的目標檢測技術被應用于吸煙行為檢測中,相比煙霧特征,煙支是一種相對穩定的吸煙行為特征。由卷煙機生產的煙支分為不加過濾嘴與加過濾嘴的兩種,中國市面上的大多數過濾嘴煙支的規格為長度84 mm,直徑7.8 mm,它包括19 mm 的過濾嘴、65 mm的煙支長度,不加過濾嘴卷煙煙支的長度70 mm。Wu W C等人[8]提出了一種基于人臉分析的吸煙行為檢測方法,在YCbCr顏色模型中確定人嘴所在區域,在HSV 顏色模型分割煙支并判斷是否為吸煙行為。程淑紅等人[9]提出了一種基于人臉分析的公共場所吸煙行為檢測方法,構建了基于多任務級聯卷積神經網絡(multi-task cascaded convolutional neural network,MTCNN)和MobileNet-V1 的吸煙行為檢測模型,在自建數據集中有較好的準確率。韓貴金等人[10]提出了一種基于深度學習的煙支檢測技術,改進特征提取方案,將淺層局部特征與深層全局特征進行融合,有效降低了煙支目標檢測的漏檢率,提升了檢測效率。但是,在吸煙行為中,煙支通常與人體手部的運動關聯,且深度學習的應用對硬件要求較高。

針對上述問題,本文提出了一種基于傅里葉描述子的吸煙行為檢測方法。首先,基于Azure Kinect傳感器獲取的人體關鍵點信息,動態調整手部目標區域。獲取手部區域后,在YCbCr顏色模型上進行煙支的分割,分析并提取煙支的傅里葉描述子形狀特征,然后利用支持向量機(SVM)對提取的特征進行分類。最后,自建行為檢測數據集驗證方法的可行性。

1 手部目標區域的獲取

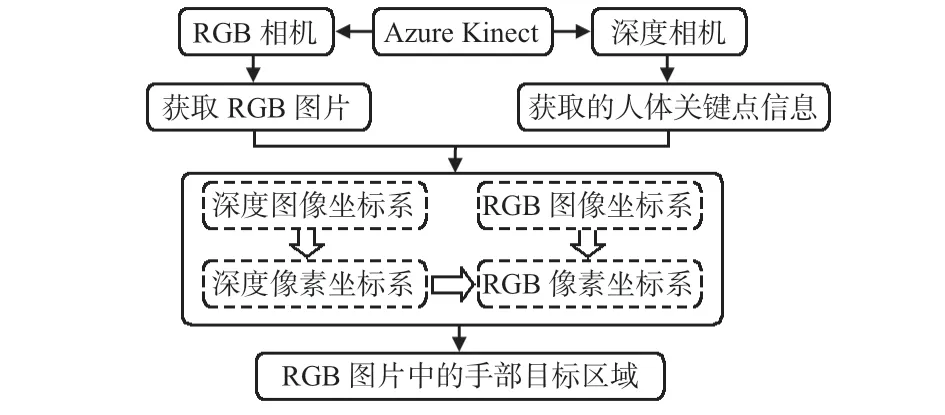

圖1為獲取手部目標區域的流程,首先,由RGB[11]相機和深度相機分別獲取RGB圖片和人體關鍵點信息,并制定手部目標區域獲取規則;然后,通過像素與坐標的轉換將深度圖像坐標系與RGB 圖像坐標系對齊;最后,分割RGB圖片獲取手部目標區域。

圖1 獲取手部目標區域流程

1.1 手部目標區域獲取規則

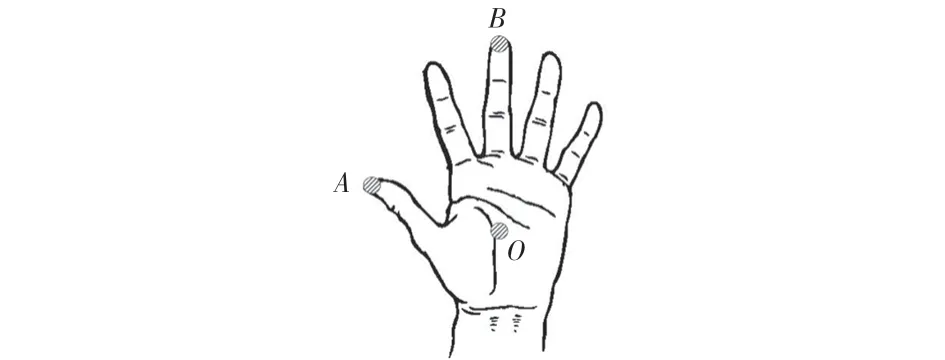

圖2為Azure Kinect傳感器檢測手部目標區域結果的示意,獲取的人體手部區域關鍵點分別為圖示點A,B,O。以O為中心,2OB +60 mm的經驗值為邊長的矩形為待檢測的手部目標區域。

圖2 檢測手部目標區域結果示意

1.2 坐標系變換

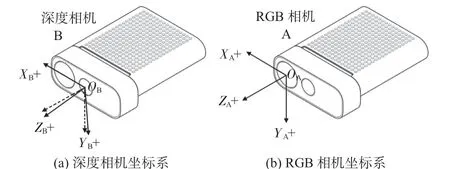

由Azure Kinect Body Tracking SDK 獲取人在深度圖像坐標系下關鍵點位置坐標信息,在深度圖像坐標系中,點以[X,Y,Z]坐標三元組的形式表示,單位為mm。圖3 給出了RGB相機坐標系{A}與深度相機坐標系{B}之間的關系。

圖3 深度相機與RGB相機坐標系間關系

由張氏標定法獲取Azure Kinect傳感器RGB相機的內參為MRGB,TOF 深度相機的內參為MD,深度相機相對于RGB相機的旋轉矩陣為R,平移矩陣為T,內參矩陣分別為

式中 fx,fy為相機的焦距,u0,v0為相機光軸相對于像素坐標系的偏移坐標。

在深度圖中的一點PD,其在深度圖像坐標系中的坐標為(uD,vD,DepD),則PD在RGB圖像坐標系中的映射點為

棋盤格相對于RGB 相機和深度相機的旋轉矩陣和平移矩陣分別為

與式(1)對應系數相同得到旋轉矩陣R 和平移矩陣T為

RGB像素坐標中對應點Pf的坐標為(uf,vf),則RGB相機圖像坐標系與像素坐標系的轉換方程為

得到(uD,vD)與(uf,vf)的關系,完成深度圖中像素點到RGB像素點的轉換。

1.3 目標區域的獲取

得到RGB相機坐標系下的目標區域后,分割獲取的RGB圖片,圖4為圖片分割得到的RGB圖像的手部目標區域,采用Visual Studio 2019 配置Azure Kinect SDK 所需環境,OpenCV環境為3.4.1,編程實現手部目標區域的獲取。

圖4 獲取目標區域示例

2 預處理與煙支形狀特征提取

2.1 待檢測目標的分割

YCbCr是在視頻標準研制過程中被提出的,其中,Y 為亮度,Cb,Cr為顏色。YCbCr 顏色模型壓縮了數據量,在計算機系統中應用較多。文獻[12]提出了YCbCr 顏色模型,結合本文數據集修改煙支分割閾值:CbY =Cb-128,CrY =Cr-128,|CbY-CrY |>25,y -|CbY |-|CrY |≥95。其中,CbY與CrY為計算中間值。

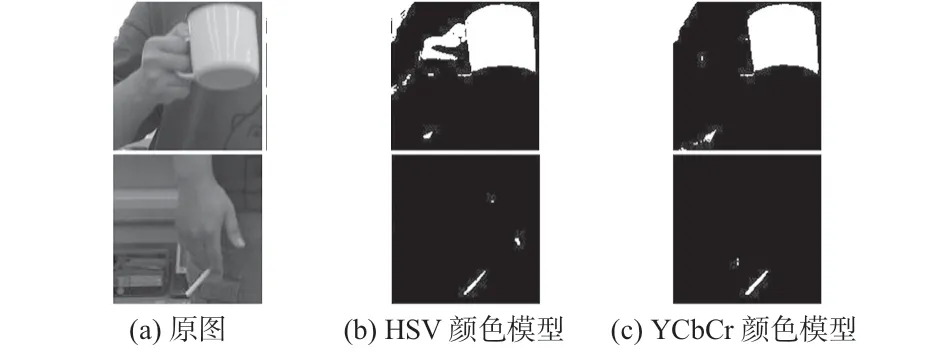

圖5給出了使用修改后上述閾值的不同顏色模型的分割結果。可以看出,HSV顏色模型分割的結果引入較多的干擾,YCbCr顏色模型分割的結果最大程度地保留了待檢測目標的形狀特征,所以本文選擇YCbCr 顏色模型分割手部目標區域。

圖5 不同顏色模型的分割效果

2.2 分割圖像后處理

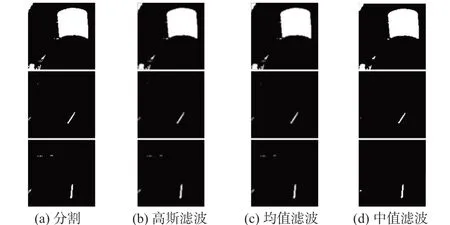

圖6分別給出了YCbCr顏色模型分割、高斯濾波、均值濾波和中值濾波的結果。由圖可以看出,高斯濾波和均值濾波不能有效去除原圖中的噪點,并且使圖片中的形狀特征模糊,但中值濾波可有效去除原圖中的噪點,并保留圖片中的形狀特征,所以本文選擇中值濾波。

圖6 不同濾波方法的結果比較

2.3 形狀特征與SVM分類器的訓練

2.3.1 目標區域的傅里葉描述

首先,采用Canny算子[13,14]對目標區域進行邊緣檢測;然后,將輪廓上的K 個像素點的二維坐標s(k)=[x(k),y(k)],k =0,1,2,…,K -1,轉換為復數表示,即s(k)=x(k)+jy(k),j為虛數單位。這種表示方法將二維輪廓信息轉換為一維信息,降低了輪廓特征維度,式(7)給出了s(k)的離散傅里葉變換(DFT)

式中 u =0,1,2,…,K -1,a(u)稱為輪廓的傅里葉描述子[15]。

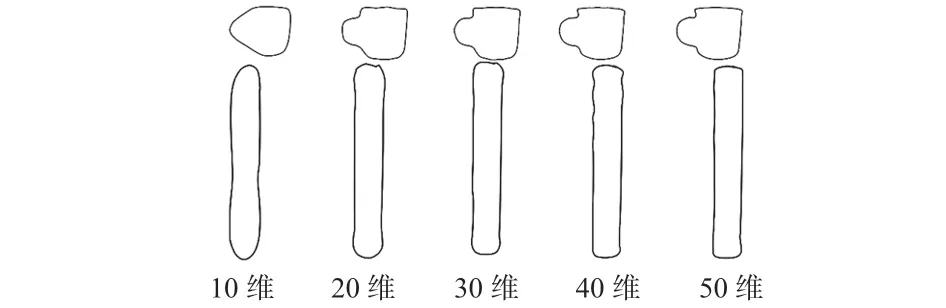

由于圖片輪廓像素點數量多且各不相同,造成提取特征維數多和特征維數不同的問題,選用不同長度的傅里葉描述子重構圖像,用最少的傅里葉描述子完整描述形狀特征。圖7給出了不同維數的傅里葉描述子重構輪廓的示例,自左向右依次為10,20,30,40,50 維傅里葉描述子的重構示例。

圖7 不同維數傅里葉描述子重構輪廓示例

由圖7可以看出,傅里葉描述子的維數越低,特征表達輪廓的形狀越粗略;維數越高,特征表達輪廓的形狀細節越豐富。所以,選取可以表征輪廓且維數較少的30 維特征描述子作為分類器的輸入。

2.3.2 基于SVM的煙支分類器構建

SVM[16~18]是一類有監督的機器學習分類器,其本質是將特征向量映射為空間中的點,求解超平面實現間隔最大的劃分不同類別的點。劃分的超平面應具有抗干擾強、泛化性優、魯棒性好的特點。本文采用LibSVM[19]工具箱,對目標區域提取的傅里葉描述子進行二分類,并采用交叉驗證的方式,選擇最優的參數訓練。

3 實驗與結果分析

3.1 實驗平臺與自建數據集

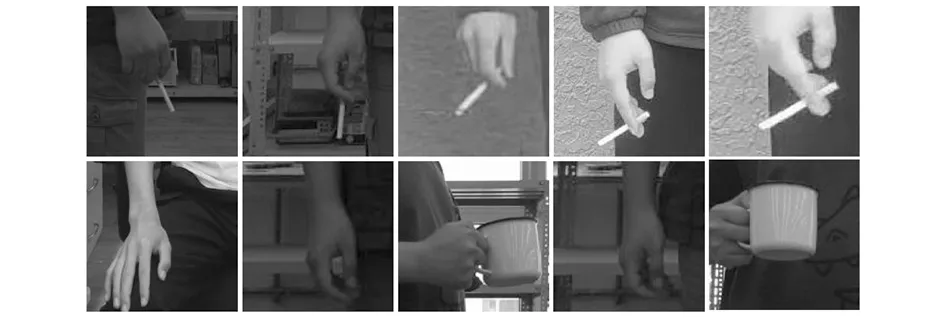

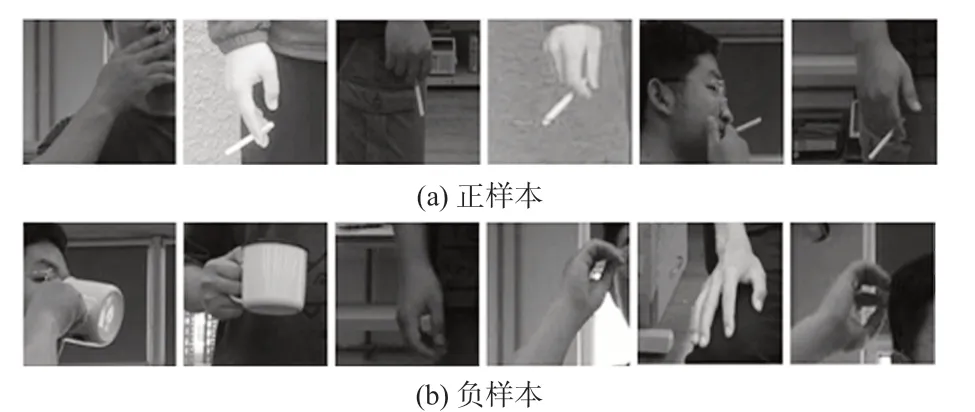

本文實驗采用英特爾酷睿i9—10900KF CPU、NVIDIA GeForce RTX 2080 Ti顯卡、1TB +2TB雙硬盤、32 GB運行內存、Windows10操作系統的計算機作為處理設備。目前,沒有公開的吸煙行為數據集,本文使用Azure Kinect傳感器錄制吸煙行為與其他行為的待檢測視頻并分幀處理,另外在網絡中搜集相關的吸煙行為圖片。自建數據集共500 張圖片,其中,訓練集355 張、驗證集145 張。圖8 所示為數據集中的部分正負樣本圖片。

圖8 數據集中部分正、負樣本

3.2 方法流程

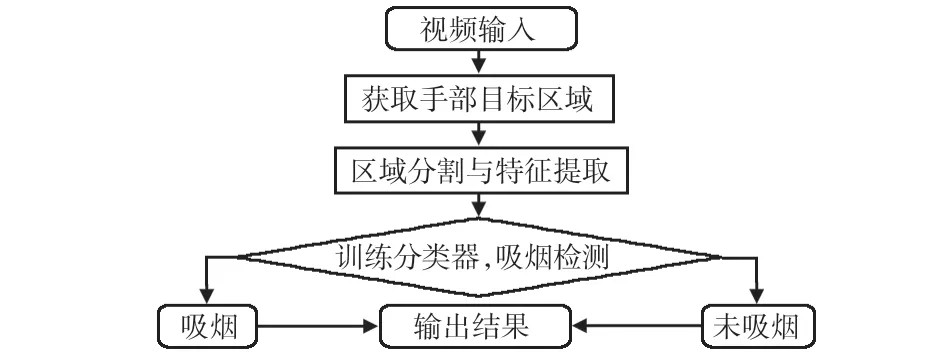

圖9給出了吸煙檢測流程。

圖9 吸煙檢測流程

3.3 實驗結果

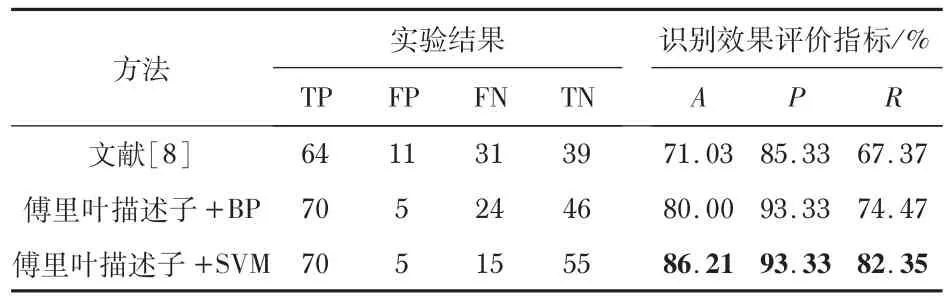

實驗結果評價指標[20,21]使用準確率A(accuracy)、精確率P(precision)和召回率R(recall),定義分別為

式中 TP為吸煙視頻幀正確分類的幀數,TN 為非吸煙視頻幀正確分類的幀數,FN 為吸煙視頻幀錯誤分類的幀數,FP為非吸煙視頻幀錯誤分類的幀數。

分別對數據集中的圖片使用文獻[8]中的煙支分割顏色模型和本文提出的分割模型進行煙支顏色分割處理。然后提取傅里葉描述子形狀特征特征并分別使用反向傳播(back propagation,BP)神經網絡、SVM 作為分類器,在自建數據集上進行吸煙檢測實驗。實驗結果與識別效果評價指標如表1所示。

表1 實驗結果與識別效果評價指標

文獻[8]中首先檢測人嘴區域,在本文數據集中煙支與人手一起移動,所以只采用文獻[8]中的顏色模型來分割相同數據集,并與其他方法比較結果。實驗結果表明,提取手部目標區域的傅里葉描述子和SVM 分類器的方法表現最優,評價指標均達80%以上,其中,A為86.21%,P為93.33%,R為82.35%。

4 結 論

針對目前煙霧傳感器與視頻煙霧智能識別受外界環境影響較大的問題,本文提出了一種以煙支為檢測對象的吸煙行為檢測方法。首先,提出了一種基于Azure Kinect傳感器的手部目標區域獲取方法;然后,在YCbCr顏色模型下修改顏色閾值,并提取基于傅里葉描述子的形狀特征;最后,利用SVM分類器實現吸煙行為的分類判斷。為驗證方法的有效性,建立行為檢測數據集,本文提出的方法在數據集上表現良好。由于數據集圖片的數量與質量對最終的檢測結果有較大的影響。