RCAR-UNet:基于粗糙通道注意力機制的視網膜血管分割網絡

孫 穎 丁衛平 黃嘉爽 鞠恒榮 李 銘 耿 宇

(南通大學信息科學技術學院 江蘇南通 226019)

(17805056265@163.com)

眼健康作為國民健康中的重要組成部分,涉及到公共衛生和社會領域的民生福祉,引起了國家健康委的高度重視[1].視網膜血管中蘊含豐富的形態特征,如血管直徑、旁支角度、尺寸和彎曲度等[2].各種眼科疾病以及心腦血管疾病都會導致視網膜血管出現形態結構變化、出血等不同程度的病變,從而導致視力受損[3],所以在臨床上醫生廣泛使用眼底圖像來分析視網膜血管的形態變化并輔助診斷各種眼科及心腦血管等疾病具有重要意義[4]. 然而眼底圖像中視網膜血管分布密集而無規律,存在大量易與背景混淆、對比度較低的細小血管,血管邊界模糊不清,同時易受采集設備和光照以及病變組織的影響[5]. 這些問題使得臨床上手動分割視網膜血管不僅工作量巨大而且對醫療人員的經驗和技能要求頗高. 此外,不同專家對同一張圖像的血管提取也存在主觀上的差異,手動分割已不能滿足臨床的需要.

隨著計算機技術的不斷發展,實現眼底視網膜血管的智能分割并對眼科疾病進行輔助診斷和決策,成為國內外學者關注的研究熱點. 深度學習憑借其在識別應用中超高的預測準確率,在圖像處理領域獲得了極大關注[6-9]. 與傳統方法相比,深度學習模型能夠以端到端的方式自動提取特征.全卷積神經網絡[10-11](fully convolutional network,FCN)是首個應用于圖像語義分割任務的神經網絡,在此基礎上形成目前分割任務中最流行的編解碼結構[12-13]. 而U-Net模型不僅具有編解碼結構,同時在U 型對稱層之間添加跳躍連接,實現低層特征和高層特征的拼接和融合,在圖像分割領域有顯著的優勢,在醫學圖像分割領域獲得較好的效果. 何慧等人[14]利用改進預測編碼器U-Net 模型實現PET 腫瘤的自動分割,實現了更準確、快速、穩定的腫瘤分割,分割結果可以達到金標準的88.5%;Rundo 等人[15]為了解決前列腺區域分割任務,將Squeeze-and-Excitation 塊合并到U-Net中,提出了一種新的卷積神經網絡,稱為USE-Net;Jin 等人[16]將可變形卷積集成到U-Net 模型中,提出DUNet 網絡模型,根據血管的大小和形狀自適應地調節感受野來捕獲各種形狀和大小的視網膜血管等.

Attention 機制是模仿人類注意力而提出的一種解決問題的方法,是一種能讓模型對與任務相關的重要信息重點關注的技術,能夠作用于任何序列模型,其應用領域包括文本、圖片等. Basiri 等人[17]將Attention 機制和長短期記憶模型相融合,提出一種基于注意力的雙向CNN-RNN(convolutional neural networkrecurrent neural network)深度模型用于情感分析;Haut等人[18]將Attention 機制和殘差網絡模型相結合用于分析遙感高光譜圖像,得到更為準確的分類準確率.

進一步地,將符合人類視覺機制的Attention 機制與能夠實現低層特征和高層特征融合的U-Net 模型相結合,實現對顯著性區域的關注,在醫學圖像分割中廣泛應用. Guo 等人[19]開發了一個3D 深度注意力U-Net,從冠狀動脈計算機斷層掃描血管造影中分割左心室心肌輪廓;Cui 等人[20]將注意力機制和UNet 模型相結合,在短軸磁共振成像圖像中進行心臟分割. 基于注意力機制的U-Net 模型在眼底視網膜血管分割中也取得不錯效果[21-24],Guo 等人[21]提出了一種空間注意力U-Net 的輕量級網絡實現對視網膜血管的精確分割;Tang 等人[22]提出多尺度的通道注意力模塊和空間信息定位模塊來提高血管末端的分割準確率.

上述模型與方法將Attention 機制融合U-Net 網絡用于眼底視網膜血管分割中仍然存在一定的不足,視網膜血管分布密集、雜亂且形狀不規則,血管粗細不一,存在大量細小血管,血管邊界不清晰,且易受采集設備和光照以及病變組織等噪聲的影響,上述模型無法解決血管邊界的不確定性和細小血管的分割. 為彌補該不足之處,本文引入能有效分析不精確、不一致、不完整等各種不完備信息的粗糙集理論中上下近似概念設計粗糙神經元,對特征通道依賴關系進行合理粗糙化.

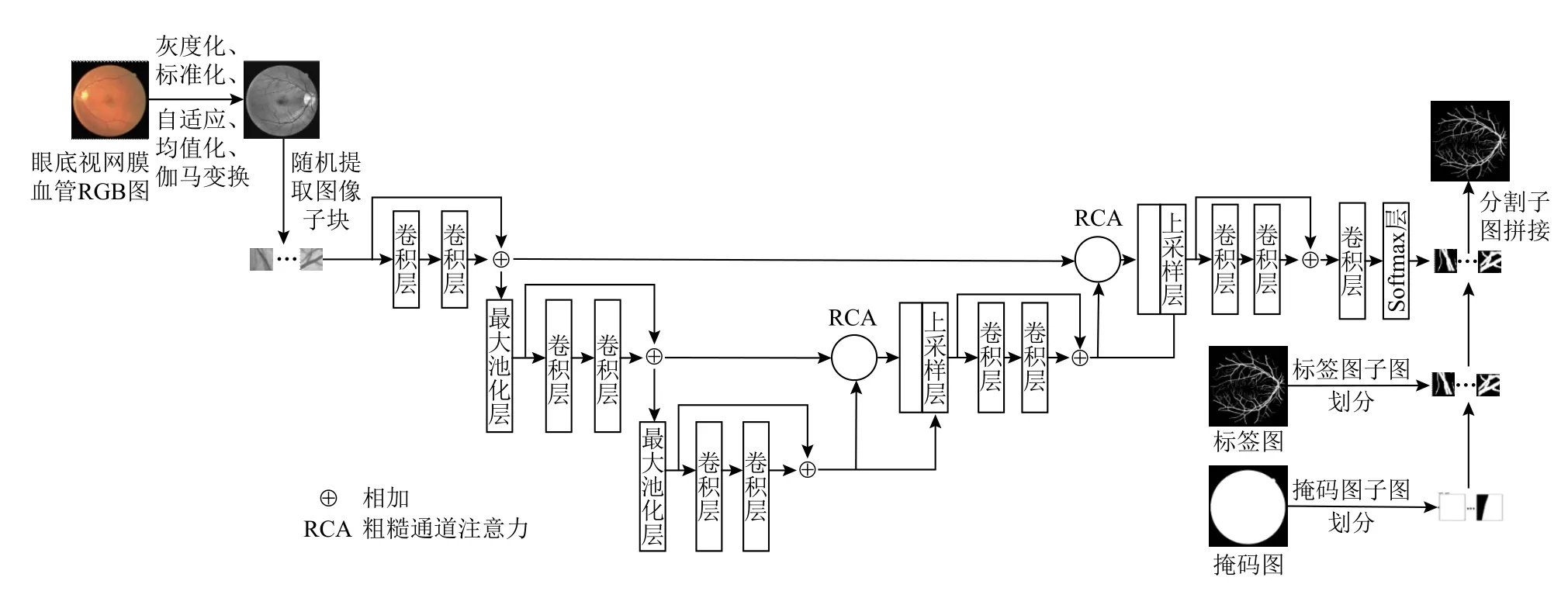

本文針對視網膜血管分布密集而雜亂,存在大量對比度低的細小血管,血管邊界模糊,且易受采集設備和光照以及病變區域等噪聲影響的特點,提出一種粗糙通道注意力殘差U 型網絡(RCAR-UNet),有效提高對細微血管的分割精度. 該網絡以U-Net 模型為主干,首先引入粗糙集上下近似概念設計粗糙神經元. 然后利用粗糙神經元對每一層下采樣視網膜血管特征圖建立通道之間的依賴關系,構建粗糙通道注意力機制,將全局最大池化和全局平均池化分別作為通道重要性權重的上下近似神經元,將全局平均池化作為通道重要性權重的下近似神經元,對每個通道重要性權重設置上下限,并對上下限賦予自適應權重系數,進行神經元間加權求和,得到更加合理的Attention 系數;對下采樣的視網膜血管特征圖進行特征的重標定,并與U-Net 模型對稱層的上采樣視網膜血管特征圖進行高低層特征之間的拼接融合. 最后為解決經典U-Net 網絡的退化問題,在該模型中添加殘差連接,實現將低層視網膜特征直接傳遞給高層,可有效提取更加準確的視網膜血管特征.

1 相關工作

1.1 粗糙集理論

粗糙集于1982 年由波蘭數學家Pawlak[25]提出,是一種可以定量分析處理不精確、不一致、不完整信息與知識的數學工具.粗糙集理論基于不可分辨關系[26]對數據進行劃分,利用上下近似集對目標進行描述,形成正域、負域和邊界域3 個互不重疊的區域[27].

假設決策信息系統表示為S=(U,AT,f,V),其中,U={x1,x2,…,xn}表示非空有限對象集合,n表示系統中對象的個數;AT表示信息系統的屬性集合,它由條件屬性集合C和決策屬性集合D共同組成;表 示所有屬性的值域;f:U×AT→V表示信息函數,?a∈AT, x∈U ,f(x,a)∈Va.

粗糙集可以通過上、下近似集對目標概念X進行逼近. 粗糙集在屬性集合R?A對論域U的任意對象子集X中的對象進行上、下近似集的劃分,那么X基于屬性集合R的上近似集R(X)和下近似集R(X)定義為

目標概念X基于屬性集合R的正域POSR(X)、負域NEGR(X)和邊界域BNDR(X)定義為

正域POSR(X)表示論域U中基于不可分辨關系R一定屬于目標概念X的對象集合;負域NEGR(X)表示論域U中基于不可分辨關系R一定不屬于目標概念X的對象集合;邊界域BNDR(X)表示論域U中基于不可分辨關系R可能屬于目標概念X,也可能不屬于目標概念X的對象集合. 邊界域BNDR(X)描述了X的粗糙度,若BNDR(X)=?,說明其是精確的集合;若BNDR(X)≠?,說明其是粗糙集.

1.2 Attention U-Net 模型

Attention U-Net 模型以U-Net 編解碼的U 形網絡結構為主干,其中U-Net 網絡結構包括:

1) 收縮路徑(編碼器)包括卷積層、激活層和池化層. 卷積層具有局部感知、參數共享等特性,用于圖像局部特征的自動提取;激活層的輸出都是對上一層輸入的線性映射,常用激活函數ReLu 和激活函數Sigmoid;池化層則是對所提取的特征進行數據的降維和壓縮操作,常用平均池化和最大池化.

2) 擴展路徑(解碼器)包括反卷積層和卷積層,經過下采樣特征圖尺寸會越來越小,所以上采樣主要用于恢復特征圖的細節和尺寸.

3) 在上采樣和下采樣的同層結構中添加跳躍連接,將高層圖像特征信息與低層圖像特征信息相聯合,實現上下特征信息的融合.

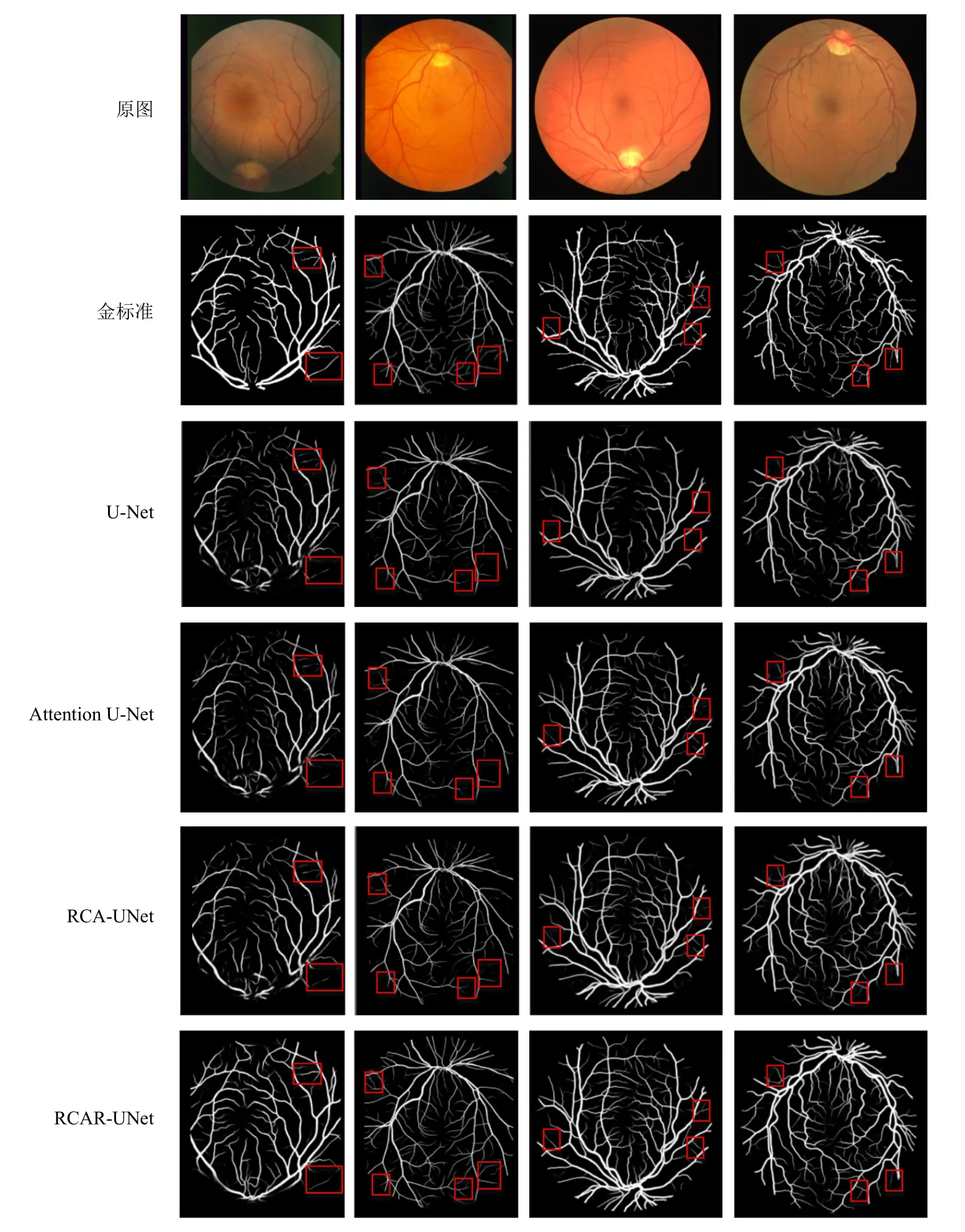

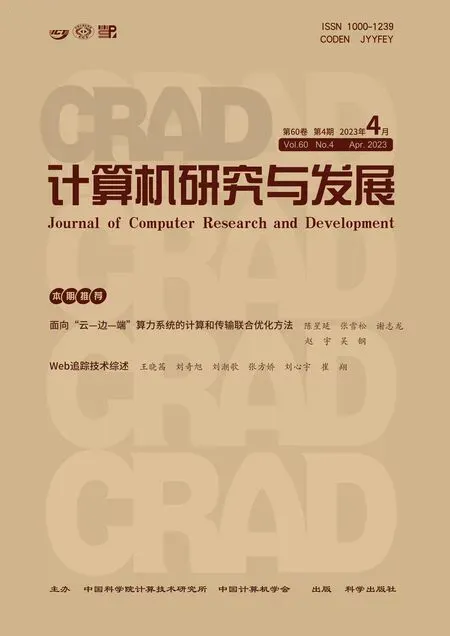

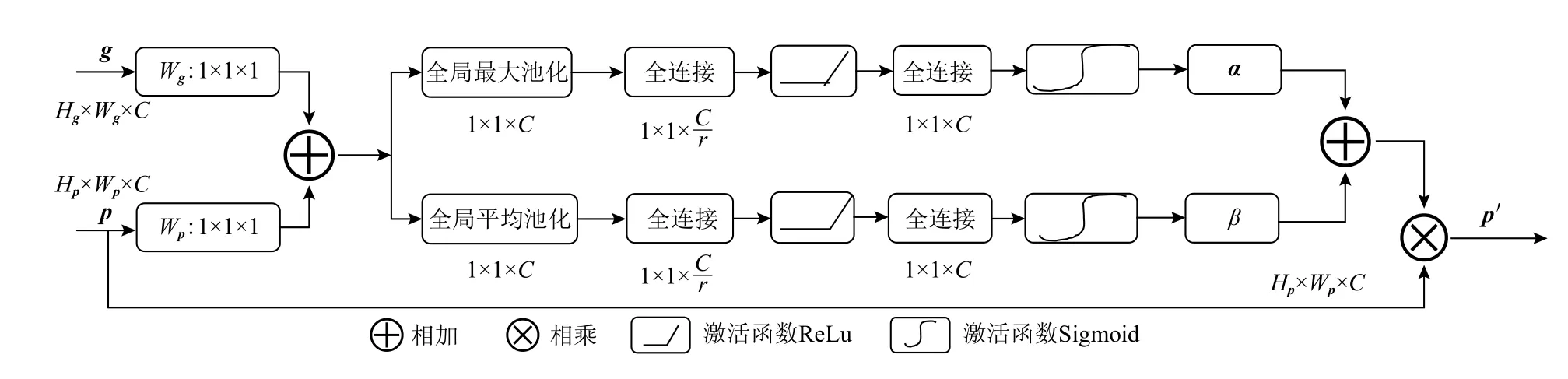

U-Net 模型最主要的思想是在收縮路徑上捕獲全局特征,在擴展路徑上實現精確定位. 為解決擴展路徑的上采樣過程中重建的空間信息不精確問題,使用跳躍連接將下采樣的空間信息與上采樣的空間信息相結合,然而跳躍連接也帶來了許多冗余的底層特征,造成大量的無效計算,浪費大量的計算資源.對此,Oktay 等人[28]將注意力門作用于U-Net 模型的跳躍連接中,提出Attention U-Net 模型,該模型能夠有效地抑制不相關區域中的激活,從而減少冗余特征的數量,并且不會引入大量的參數和計算量,得到更加符合人類視覺機制的網絡模型,其結構如圖1所示. 同一張圖像的不同區域關注度不同,對此,通過注意力門系數控制關注區域,得到更加具有語義的特征圖. 注意力門具體結構如圖2 所示. 將收縮路徑得到的特征圖g∈與擴展路徑中同層通道數相同的特征圖p∈相加,經過一系列的線性變換,得到注意力系數A∈將其與特征圖p相乘,實現對特征圖p的不同區域特征值的重新標定,得到新的特征圖p′.

Fig.1 Attention U-Net network architecture圖1 Attention U-Net 網絡結構

Fig.2 Attention gate architecture圖2 注意力門結構

2 粗糙神經網絡

圖像信息復雜多樣,其內容蘊含著諸如隨機性、模糊性等不確定性信息,例如眼底視網膜血管分布雜亂,形狀不規則并且邊緣模糊不清,且易受采集設備和光照以及病變影響,這些眼底視網膜血管圖像中蘊含的不確定信息使得深度神經網絡效果不佳. 1996年,Lingras[29]使用上下界的一般概念引入了粗糙神經網絡. 深度神經網絡在學習復雜特征方面的成功以及粗糙神經網絡處理不確定性的能力,促進了將粗糙神經網絡與深度架構相結合[30-31].

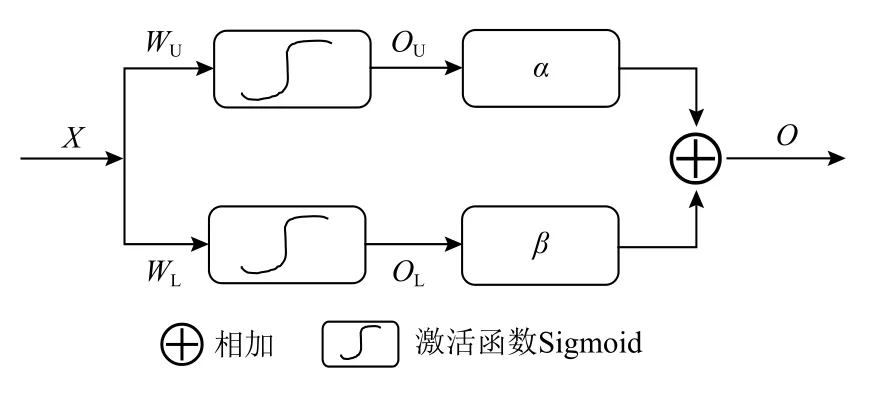

2.1 粗糙神經元

上下限的概念已在人工智能的各種應用中使用,特別是粗糙集理論中上下近似集證明了上下限在規則生成中的有效性,粗糙集理論利用上下近似集對目標概念進行逼近,本文引入粗糙集的上下近似集的思想,構建上下近似神經元對注意力模塊所得的注意力系數進行合理粗糙化,粗糙神經元[32-35]結構如圖3 所示.

上近似神經元的參數θU={WU,bU,α},下近似神經元的參數θL={WL,bL,β},其中WU,bU表示上近似神經元的權重和偏差,WL,bL表示下近似神經元的權重和偏差. 圖3 中OU,OL表示上下近似神經元的輸出.與常規神經元的單個輸出值不同的是,粗糙神經元的輸出是一對上下限,其計算公式為:

Fig.3 Rough neuron architecture圖3 粗糙神經元結構

最終給定上下邊界神經元一定的權重 α 和 β,加權求和得到最終粗糙神經元的輸出O,表示為

粗糙神經元是對輸入的數值映射為一個粗糙的范圍,最后的輸出取決于上下神經元的輸出,對于不同的輸出賦予一定的權重值,以區分不同神經元對最終輸出的貢獻. 該方法能夠對輸入的確定數值粗糙化,對確定性的數值進行重標定,得到更合理、準確的輸出值.

2.2 通道注意力機制

特征圖的通道數取決于卷積操作中卷積核的個數,以往認為得到的多通道特征圖中每個通道所蘊含的信息重要程度相同,即不對特征通道的重要性加以區分. 然而同一張圖像的不同區域關注度不同,同樣,每個特征通道的關注度也有所差異. 例如1 張眼底視網膜血管圖像有2 個通道,分割目標是血管,那么會更加關注與分割任務相關的血管通道,也就是需要賦予每個特征通道一個表征通道蘊含信息重要度的權重,以此對不同特征通道信息加以區分. 將表征每個特征通道信息重要性的權重與原特征圖對應的每個通道相乘得到的對應值就是真實的特征圖值.

為了建立特征通道之間的關系,引用一個新的維度信息來表征特征通道重要度,進行特征通道之間的融合,即通過訓練網絡參數的方式計算每個特征通道信息的重要性權重,依照所得到的特征通道重要性權重提升與當前分割任務相關的特征并抑制對當前分割任務無關的特征. 通道注意力機制[36-38]主要包括激勵部分,其結構如圖4 所示.

Fig.4 Channel attention mechanism圖4 通道注意力機制

首先是壓縮操作,對特征通道維度進行特征圖的壓縮,通過全局池化,將維度為Hp×Wp×C的特征圖的每個通道的2 維數據轉化為一個實數 R;然后是激勵操作,包括2 層全連接:第1 個全連接層是把C個通道壓縮成C/r個通道來減少模型所需的參數和計算時間,第2 個全連接層將特征圖恢復為C個通道,使模型更加非線性,更好地適應通道之間的復雜關系,激活函數ReLu 降低了梯度消失的概率,激活函數Sigmoid 使C中每個通道的特征權值在0~1 之間;最后是特征重標定,重新計算特征通道值,通過權值乘法運算完成特征通道內對原始各個特征通道重要程度的重新標定,并作為下一級的輸入數據.

2.3 基于粗糙通道注意力機制U-Net 模型

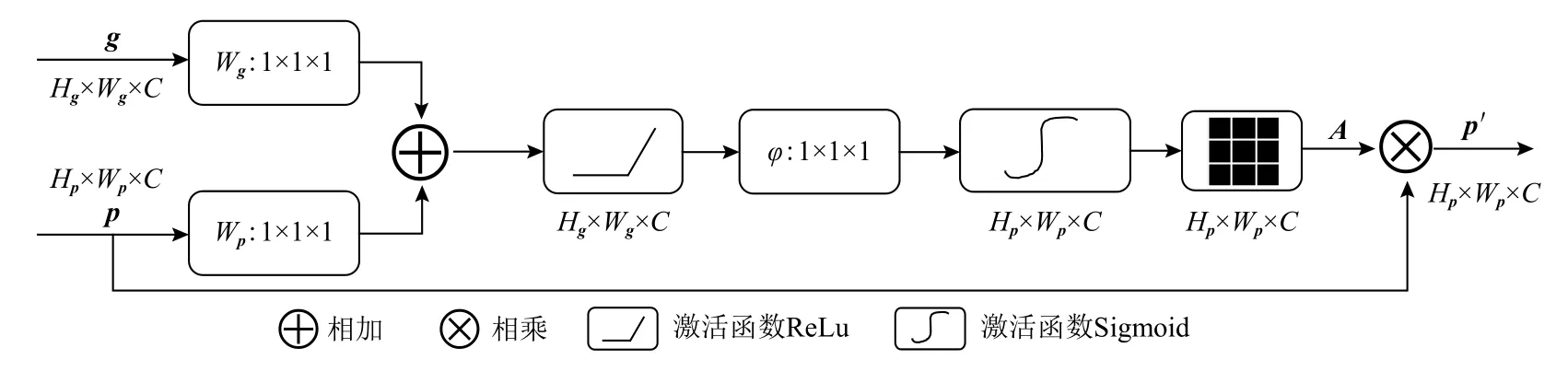

基于粗糙神經元和通道注意力機制,提出粗糙通道注意力機制模塊,并將其嵌入到U-Net 模型的跳躍連接中. RCAR-UNet 模型結構分別如圖5 和表1 所示.

在U-Net 模型的特征編碼部分,構建一個簡單的特征提取模塊包括:殘差連接的2 個3×3的卷積層和1 個2×2的最大池化層. 加入殘差連接是因為殘差連接能夠實現將低層特征直接傳播到高層,在一定程度上解決了網絡退化的問題,以此提高模型性能.

Fig.5 Architecture of RCAR-UNet圖5 RCAR-UNet 模型結構

Table 1 U-Net Model Architecture Based on Rough Channel Attention表1 基于粗糙通道注意力U-Net 模型結構

在特征解碼部分,使用粗糙通道注意力機制來融合特征圖的上下語義信息,以便生成更具代表性的特征圖.粗糙通道注意力機制融合了粗糙神經元處理不確定信息的能力和通道注意力機制能夠區分不同特征通道重要性的優點. 通道注意力機制可以實現對特征圖不同特征通道重要度的區分,一般選用全局平均池化對特征圖進行壓縮,建立特征通道之間的關系,其值在一定程度上具有全局感受野. 然而視網膜血管粗細不一,存在大量對比度較低的細微血管,其結構細長,只有一個或者幾個像素的寬度,局部圖像細節信息也不容忽視,因此加以利用全局最大池化對特征圖進行壓縮,使得其值在一定程度上具有局部感受野. 對此,本文在構建粗糙神經元時,使用全局最大池化和全局平均池化作為上下近似神經元對特征通道重要性進行上下限描述,使得Attention系數值兼具全局信息和局部細節信息.在此基礎上進行特征重標定,得到新的視網膜血管特征圖. 設計粗糙通道注意力機制結構如圖6 所示.

Fig.6 Rough channel attention mechanism圖6 粗糙通道注意力機制

對高低特征圖進行相加操作,得到融合特征圖.表示為

利用全局最大池化層建立通道間的依賴關系,并保留全局信息,表示為

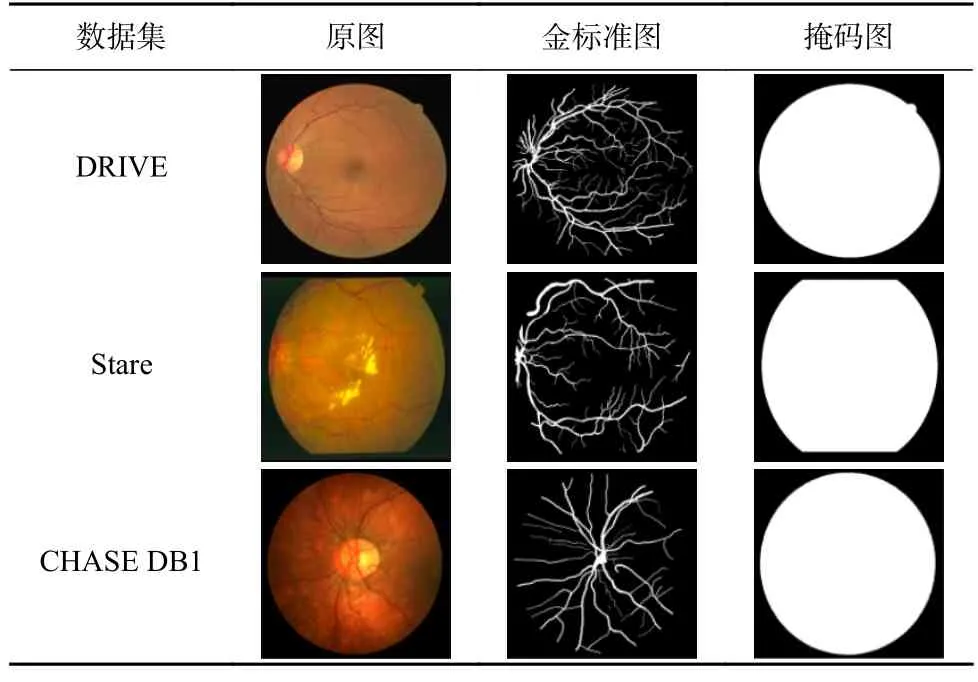

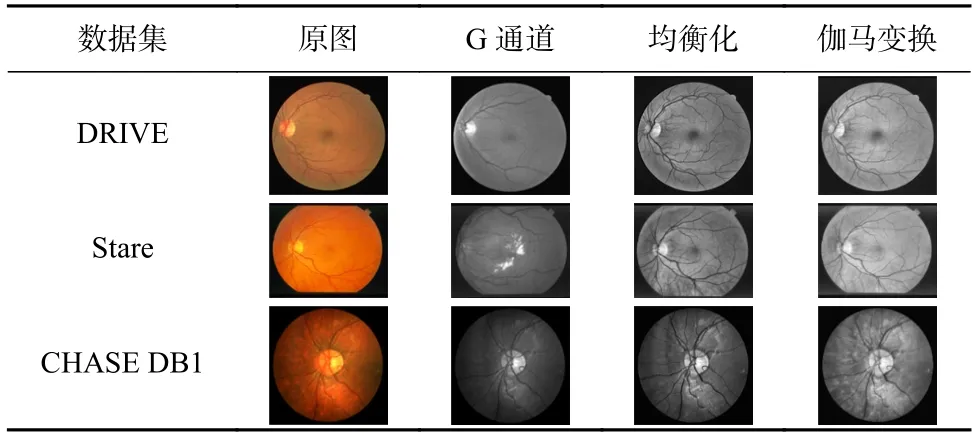

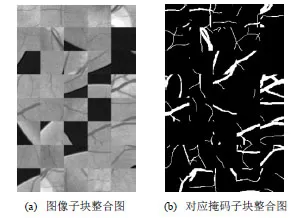

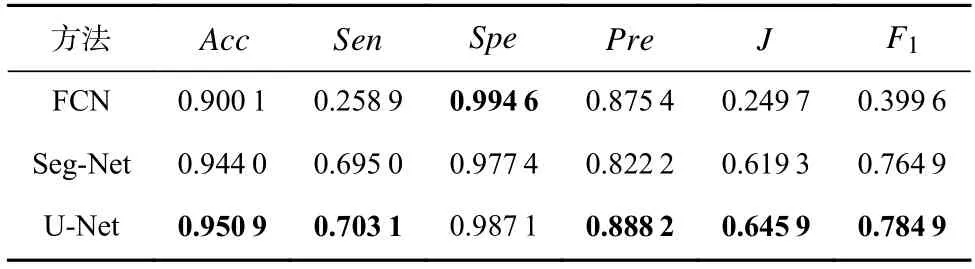

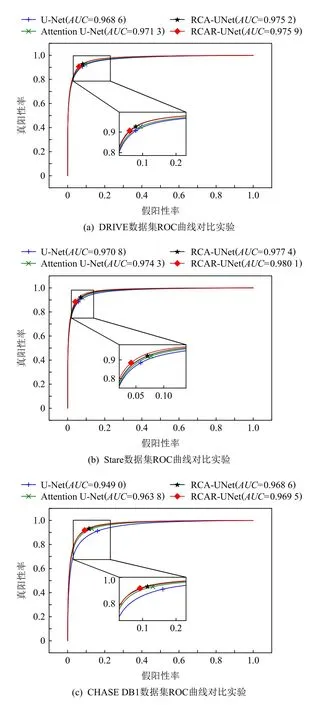

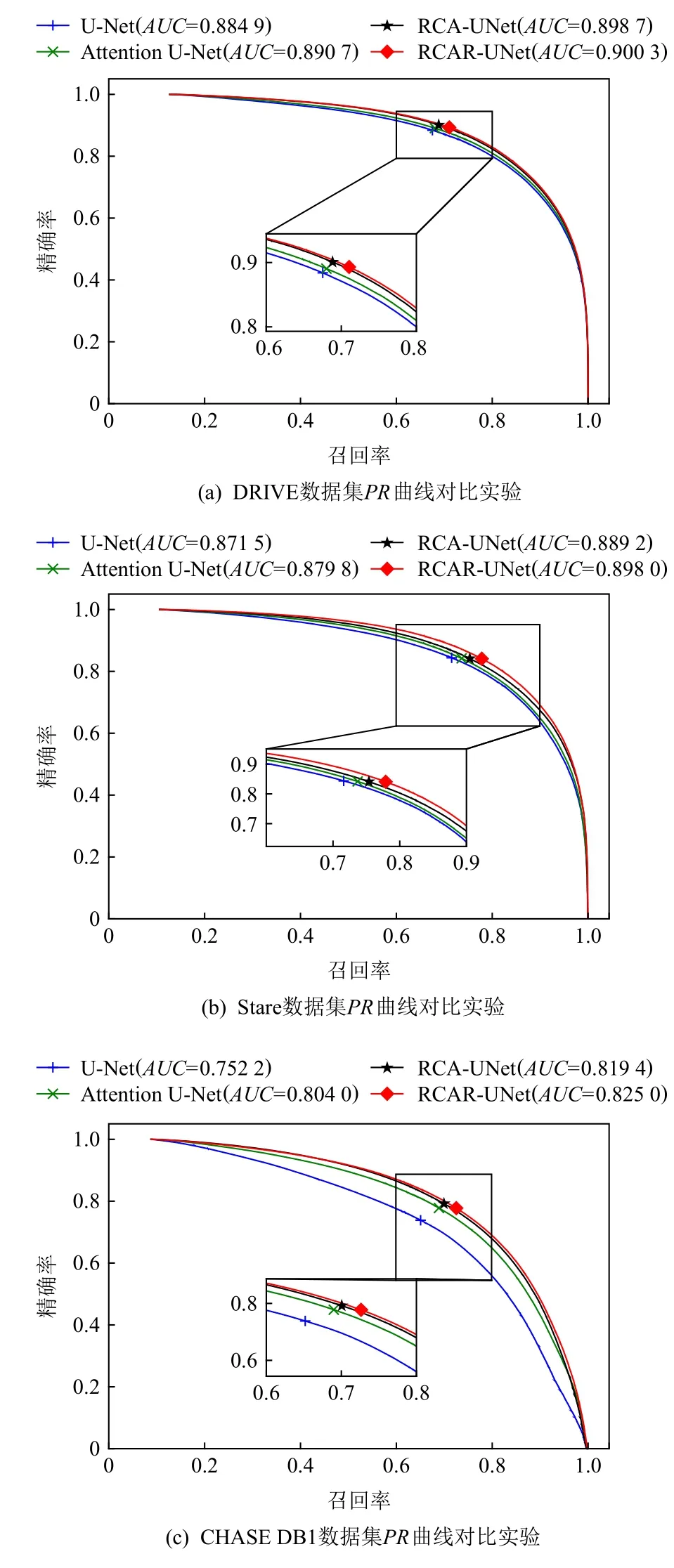

其中0 利用全局平均池化層建立通道之間的依賴關系,并保留局部信息,表示為 其中0 分別對全局平均池化和全局最大池化的2 個1×1×C的張量進行激勵操作:第1 個全連接層是把C個通道壓縮成C/r個通道來減少模型所需的參數和計算時間;第2 個全連接層將特征圖恢復為C個通道,使模型更加非線性,更好地適應通道之間的復雜關系,r是指壓縮的比例,本文設置r=16.激活函數ReLu 降低了梯度消失的概率,激活函數Sigmoid使C中每個通道的特征權值在0~1 之間,得到Attention 系數的上下限值,分別表示為 為了使得通道之間的依賴關系既包含全局信息,又包含局部細節信息.對所得到的通道重要性值的上下限進行加權操作,得到新的通道之間的依賴關系: 其中α,β分別表示上下神經元的權重信息. 利用輸出的通道之間的依賴關系對特征圖進行重新標定,得到新的特征圖表示: 在U-Net 模型的特征解碼部分,首先構建一個簡單的恢復特征模塊包括:一個2×2上采樣層和殘差連接的2 個3×3的卷積層;然后因為該任務包含血管類和非血管類2 類,所以在恢復特征尺寸后使用2 個1×1的卷積核進行卷積操作得到一個通道數為2 的特征圖,一個通道表示血管類,另一個通道表示非血管類;最后使用Softmax層輸出每個像素屬于血管類的概率. 眼底圖像分割的過程如算法1 所示. 算法1.RCA-UNet 模型的視網膜血管分割算法. 輸入:彩色眼底視網膜血管圖像input∈RH×W×3、掩碼圖mask∈RH×W×1; 輸出:視網膜血管分割圖out put∈RH×W×2. 1)對視網膜血管原圖input∈RH×W×3進行灰度化、自適應均衡化等預處理,得到視網膜血管預處理圖input′∈RH×W×1; 2)以步長patch_stride從視網膜血管預處理圖input′∈RH×W×1中進行視網膜血管圖像子塊patch_image∈的劃分,保證視網膜血管圖像子塊覆蓋視網膜血管圖; 3)將視網膜血管圖像子塊patch_image∈輸入到訓練好的RCAR-UNet 模型中,得到視網膜血管子塊圖patch_out put∈,其具體步驟為: ①利用卷積操作和殘差連接提取眼底視網膜血管特征. ②利用最大池化對眼底視網膜血管特征進行降維. ③利用粗糙通道注意力機制求得較為合理的Attention 系數對收縮路徑提取的視網膜血管特征進行準確重標定. ④利用上采樣操作恢復視網膜血管特征圖的尺寸,直到網絡輸入的視網膜血管圖尺寸保持一致為止.1×1 ⑤采用2 個的卷積核進行操作得到通道為2 的視網膜血管特征圖; ⑥利用Softmax 層得到視網膜血管特征圖中的每個像素點屬于血管類別和非血管類別的概率; ⑦設置閾值θ=0.5,如果視網膜血管特征圖中的像素點屬于血管類的概率值大于θ,則屬于血管類;反之,屬于非血管類. 4)將視網膜血管圖像子塊patch_out put∈按照提取順序進行圖像拼接,得到完整的視網膜血管分割圖out put′∈ 5)對視網膜血管掩碼mask∈RH×W×1進行通道的修改,使其通道數與視網膜血管網絡分割圖out put′∈保持一致,得到視網膜血管掩碼圖mask′∈ 6)利用視網膜血管掩碼從視網膜血管網絡輸出圖中摳出眼球部分,得到最終視網膜血管分割圖out put∈RH×W×2. RCA-UNet 模型的時間復雜度可以表示為 時間復雜度與每一層的輸出特征圖尺寸Fi、每一個卷積核的尺寸Ki、上一層輸出特征圖的通道數Ci?1以及當前層輸出特征圖的通道數Ci有關,與此同時每一層特征圖的輸出尺寸F與輸入尺寸X、卷積核的步長stride、填充的數量padding以及卷積核的尺寸K等相關,可表示為 3.1.1 數據集 DRIVE 數據集[39-41]發布于2004 年,包含40 張格式為tif. 尺寸為565×584 的彩色眼底圖像,每張圖像包含2 位專家手工標注的金標準圖,并且自帶視網膜血管的掩膜圖. Stare 數據集[39-41]是1975 年Michael Goldbaum 發起的項目,用來進行視網膜血管分割的彩色眼底圖數據庫,包括20 張格式為ppm、尺寸為605×700 的彩色眼底圖像,同樣每張圖像對應2 位專家手工標注的金標準圖,相對應的掩膜需要自己通過代碼進行掩膜的設置. CHASE DB1 數據集[39-41]包括從14 名學童的雙眼中拍攝的28 張格式為jpg、尺寸為999×960 的視網膜圖像. 每張圖像具有2 位專家的手工分割標簽,相對應的掩膜需要自己通過代碼進行掩膜的設置. 一般情況下將前20 張圖像用于訓練,其余8 張圖像用于測試. 3 個眼底視網膜血管圖像數據集信息如表2 所示. Table 2 Information of Retinal Vessels Image Datasets表2 眼底視網膜血管圖像數據集信息 3.1.2 預處理 由于眼底圖像照明不均勻以及血管與背景之間的對比度較低等因素,為了捕獲細小血管的更多特征并提高血管分割的準確性,需要將輸入網絡的眼底圖像進行預處理. 首先對RGB 圖像進行通道分離,發現G 通道的血管與背景之間的對比度最高,選取RGB 圖像的G 通道完成圖像的灰度變換,對視網膜血管灰度圖像進行歸一化;然后采用對比度受限的自適應直方圖均衡化,在不放大眼底視網膜圖像噪聲的情況下增強視網膜血管與背景之間的對比度,以使眼底圖像中血管的結構和特征更容易受到關注;最后使用Gamma 變換進行圖像增強,對過白或者過暗的圖像區域進行校正. 表3 分別表示原圖和預處理之后的圖像. Table 3 Information of Original Images and Preprocessed Images表3 原圖與預處理圖信息 3.1.3 數據集擴充 由于深度卷積神經網絡的復雜性,訓練一個深度卷積神經網絡進行圖像分割,通常需要大量標簽圖像,然而,只有幾十張視網膜血管圖像具有像素級的標簽,因此,設計用于視網膜血管分割的深度學習模型容易出現過擬合現象. 對此,本文采用對原圖進行分塊的方式進行數據擴充,將訓練圖像以及相應的掩碼圖劃分為大小為48×48 的圖像子塊,從中隨機選取一定數量的圖像子塊數,圖7 中展示了整合部分的圖像子塊以及相對應的掩碼子塊圖. Fig.7 Sub-image and corresponding mask sub-image圖7 圖像子塊以及相對應的掩碼子塊圖 本研究使用基于Windows10 系統的工作站,運行在Intel?Core?i7-10750H CPU @2.60GHz 上,擁 有16GB 內存和NVidia GeForce RTX 2 060 6.0GB GPU,使用TensorFlow 和Keras 等框架構建文中所用的網絡模型.在模型的訓練過程中,采用交叉熵損失函數作為訓練的損失函數,批大小batch_size設置為32,模型迭代的次數N_epochs設置為50,模型初始學習率設為0.01,選擇SGD 隨機梯度下降法作為優化器對模型的參數進行更新. 視網膜血管分割任務的實質是像素級的分類,判斷像素點是血管類還是非血管類.血管是需要檢測分割的目標,稱作正類;非血管類的部位,稱作負類.分割算法的結果與真實值比較可以得到混淆矩陣中的真陽性NTP、假陽性NFP、假陰性NTN、真陰性NFN,如表4 所示.其中NTP是將血管類正確分類為血管類的像素點數,NFP是將非血管類錯分為血管類的像素點數,NTN是將非血管類分類為非血管類的像素點數,NFN是將血管類錯分為非血管類的像素點數. Table 4 Confusion Matrix表4 混淆矩陣 為了評價視網膜血管分割算法的好壞,選用準確率Acc、靈敏度Sen、特異性Spe、精確率Pre等評價指標,其中Acc表示將血管類和背景類分類正確的概率,Sen表示將血管類分類正確的概率,Spe表示將背景類分類正確的概率,Pre表示預測為血管類的樣本中真正為血管類所占的比例.為了進一步地評估分割模型的性能,利用Jaccard 相似度描述金標準圖truth與分割圖result之間的相似性和差異性,Jaccard 值越大說明相似度越高.各評價指標公式表示為: 本文所提模型是以U-Net 網絡為基礎網絡,并針對視網膜血管的獨特特性,將U-Net 網路和本文所提的粗糙通道注意力機制相融合.首先,為了驗證基礎網絡U-Net 的有效性,選取目前較常使用的分割網絡FCN 和Seg-Net[42]在眼底圖像視網膜血管DRIVE,Stare,CHASE DB1 數據集上進行對比實驗,從準確率Acc、靈敏度Sen、特異性Spe、精確率Pre、Jaccard 相似度J等評價指標對實驗結果進行比較. FCN,Seg-Net,U-Net 模型在視網膜血管的3 個數據集上的對比結果分別如表5~7 所示,從表5~7 中可以發現,U-Net 模型具有更好的表現,總體表現優于其他2 個模型.更具體地說,U-Net 具有更高的分割準確率,對血管像素具有更好的識別能力,所得分割圖和金標準圖具有更高的相似度,對背景像素的識別能力也是具有競爭力的,綜合考慮分割精度和敏感度,取得更高的F1值. Table 5 Comparison Results on DRIVE Dataset表5 DRIVE 數據集對比結果 Table 6 Comparison Results on Stare Dataset表6 Stare 數據集對比結果 Table 7 Comparison Results on CHASE DB1 Dataset表7 CHASE DB1 數據集對比結果 上述結果表明Seg-Net 和U-Net 這類基于編解碼結構的網絡在醫學圖像分割上具有更好的競爭力,而增加了跳躍連接結構的U-Net 在上采樣過程中將對稱層的特征圖進行通道上的拼接,實現低層特征和高級特征的信息融合使得網絡能夠提取和保留更多視網膜血管局部細節信息,從而提高了圖像分割精度.基于此,選用U-Net 作為基礎網絡具有一定的有效性. 為了進一步驗證本文所提粗糙通道注意力機制的有效性,選取U-Net,Attention U-Net,RCA-UNet 在3 個眼底視網膜血管數據集中進行對比,從準確率Acc、靈敏度Sen、特異性Spe、精確率Pre、Jaccard 相似度J等評價指標對實驗結果進行比較,實驗結果分別如表8~10 所示.實驗結果表明:在3 個數據集中RCA-UNet 模型都具有相對較好的性能.具體而言,RCA-UNet 模型具有較高的靈敏度Sen,對血管類具有更好的識別能力,在3 個數據集上相對于U-Net 模型提高了2.97%,2.9%,10.33%,相對于Attention UNet 模型提高了1.35%,1.23%,0.54%.在考慮模型性能的時候,單純地追求精度Pre或者靈敏度Sen的提升并沒有太大作用,在實際分割任務中,需要結合正負樣本比進行綜合評價,對此從精度Pre與靈敏度Sen的調和平均值F1可以看出RCA-UNet 模型具有較好的性能,提高0.19%~1.43%,0.88%~2.03%,1.24%~4.71%.另外,RCAR-UNet 所得的分割圖與金標準的Jaccard相似度更高,相較于其他模型相似度提高了0.26%~1.96%,1.12%~2.57%和1.57%~5.78%. 上述實驗結果清楚地表明利用全局最大池化和全局平均池化構建上下近似神經元的粗糙通道注意力機制的有效性.分析其原因在于考慮了特征通道之間的依賴關系,借助粗糙集的上下近似原理,利用全局最大池化和全局平均池化分別構建上下近似神經元,并賦予一定的自適應權重,得到較為合理的Attention 系數,并對特征圖進行相應的重標定操作,使得在上采樣的過程中,得到更加細致的特征信息. Table 8 Comparison Results on DRIVE Dataset表8 DRIVE 數據集對比結果 為了在說明粗糙通道注意力機制的有效性的同時,進一步驗證殘差連接的有效性,本文將RCAUNet 和RCAR-UNet 在3 個數據集上進行對比實驗,實驗結果分別如表8~10 所示. 實驗結果表明,本文所提模型RCAR-UNet 能夠得到更好的視網膜血管分割效果.從3 個表中可以發現,在3 個視網膜血管數據集中各個評價指標都有所提升. 從表8 中可以很直觀地看出在DRIVE 數據集上,RCAR-UNet 相對于RCAUNet 模型,Acc提高了0.06%,Sen提高了1.59%,相似度J提高了0.77%,F1提高了0.55%;從表9 中可以看出,RCAR-UNet 在Acc,Sen,J,F1指標上都有明顯的提升,分別提升了0.41%,5.65%,4.22%,3.2%;從表10中可以看出,RCAR-UNet 在CHASE DB1 數據集上相對于RCA-UNet 模型的提升不是很大,但是都有所改善,Acc提高了0.1%,Sen提高了0.33%,Pre提高了2.11%,Jaccard 相似度提高0.26%,F1指標提高了0.04%. 上述實驗結果充分說明模型中添加殘差連接實現特征映射的有效性,將低層特征直接傳遞給高層特征的短跳躍連接方式,不僅豐富網絡特征提取,并且有助于訓練模型時梯度的反向傳播,可有效解決網絡退化問題. Table 9 Comparison Results on Stare Dataset表9 Stare 數據集對比結果 Table 10 Comparison Results on CHASE DB1 Dataset表10 CHASE DB1 數據集對比結果 最后,本文還采用ROC 曲線和PR 曲線進行模型的評價. ROC 曲線是對假陽性率和真陽性率的安全考慮,橫坐標表示假陽性率,縱坐標表示真陽性率;PR 曲線是對召回率和精確率的綜合考慮,其橫坐標表示召回率Recall(和靈敏度Sen一樣),縱坐標表示精確率Pre.曲線與坐標系圍成的面積表示AUC面積,AUC值越大,表明模型具有更好的性能. 4 個網絡模型在不同數據集上的ROC 曲線和PR 曲線對比實驗結果分別如圖8 和圖9所示. Fig.8 Comparison of ROC curves of different models on different datasets圖8 不同模型在不同數據集上的ROC 曲線對比 Fig.9 Comparison of PR curves of different models on different datasets圖9 不同模型在不同數據集上的PR 曲線對比 從圖8 中可以看出,本文所提模型RCAR-UNet 在3 個數據集上的ROC 曲線的AUC值為0.975 9,0.980 1,0.969 5,相對于經典U-Net 模型,提高了0.73%,0.93%,2.05%. ROC 曲線的縱坐標為真陽性率,表示實際正樣本中被預測成正樣本的占比,也就是實際正樣本的預測正確率,所以是越大越好;而其橫坐標為假陽性率,表示實際負樣本中被預測成正樣本的占比,也就是實際正樣本的預測錯誤率,所以是越小越好. 最為理想的點是(0,1),綜上所述,ROC 曲線的AUC值越大,性能越好,所以RCAR-UNet 在3 個眼底視網膜血管數據集上具有較好的性能. PR 曲線描述的是精準率與召回率的關系,在分割過程中,期望精確率和召回率值均相對較高,達到較好的平衡點,同樣利用曲線與坐標系圍成的AUC面積對模型進行評估,圖9結果表明RCAR-UNet 具有較好的性能. RCAR-UNet在3 個數據集上的AUC值為0.900 3,0.898 0,0.825 0,相對于其他模型都有所提高. 綜上所述,RCAR-UNet 相對于經典U-Net,Attention U-Net 等模型能夠得到更好的眼底視網膜血管分割精度,分析其主要原因在于:RCAR-UNet 在編碼-解碼的U-Net 模型主干上,利用粗糙集中上下近似理論構建粗糙上下近似神經元,對眼底視網膜血管特征通道重要性進行區分,對視網膜血管特征進行準確重標定,并融合殘差連接,進行特征的映射. 為了進一步直觀地說明RCAR-UNet 對于視網膜血管分割具有較好的分割效果,將之與U-Net,Attention U-Net 等模型的分割圖進行比較,各模型分割效果圖如圖10 所示. 從視網膜血管分割效果圖可以直觀看出,本文所提RCAR-UNet 模型的分割結果和專家分割標準圖基本一致,特別是在矩形框區域內細微血管的分割上有更好的效果. 針對視網膜血管結構復雜、血管較細、易受光照影響等,本文考慮了特征通道之間的關系,引入一種新的通道注意力機制來增加網絡的鑒別能力. 具體而言:首先在編碼-解碼結構的U-Net 模型上利用粗糙集的上下近似概念構建粗糙注意力模塊,對注意力系數設置上下限,利用全局最大池化構造上神經元作為注意力系數的上限,利用全局平均池化構造下神經元作為注意力系數的下限,通過賦予上下限一定的權重系數并求和得到較具語義的注意力系數,該注意力系數不僅包含全局信息也具有了一定的局部信息;然后引入殘差連接,實現將低層特征直接傳播到高層,在一定程度上解決了網絡退化的問題,以此提高模型性能;最后在3 個眼底視網膜血管數據集進行網絡模型性能驗證,實驗結果表明本文所提網絡RCAR-UNet 模型能夠分割出視網膜血管末端的細小分支,得到較好的視網膜血管分割精度. 我們會進一步研究將粗糙集理論融合到深度神經網絡模型的卷積和池化層中,處理圖像特征中不確定性、不精確性信息. Fig.10 Segmentation effect diagram of retinal blood vessels of each model圖10 各模型視網膜血管分割效果圖 作者貢獻聲明:孫穎提出了算法的核心思想,設計了實驗方案,完成實驗并撰寫論文初稿;丁衛平提出了整個算法的框架并對整個算法思想進行完善,修改了論文;黃嘉爽、鞠恒榮完善了算法的思路,指導了論文寫作并修改論文;李銘、耿宇協助實驗數據的處理并修改論文.3 實 驗

3.1 數據集和預處理

3.2 實驗參數設置

3.3 評價指標

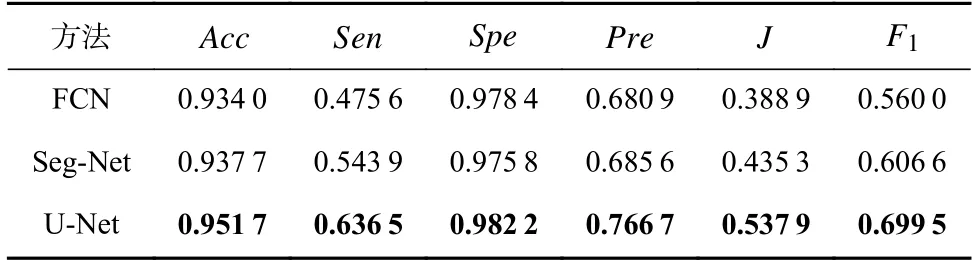

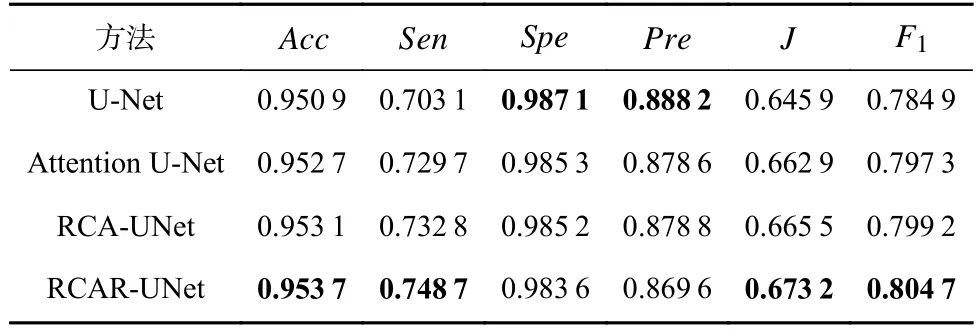

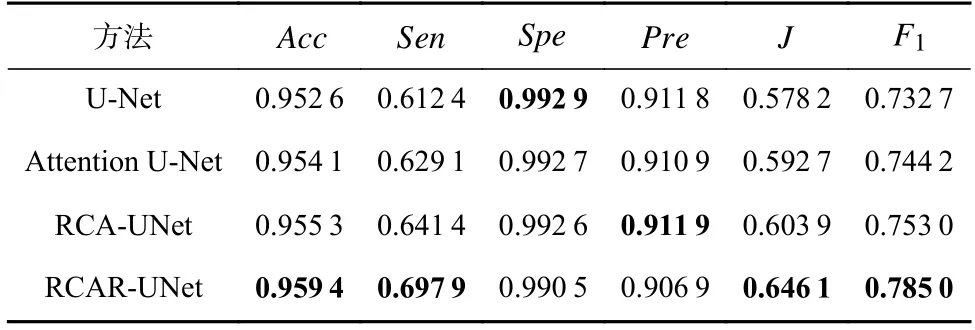

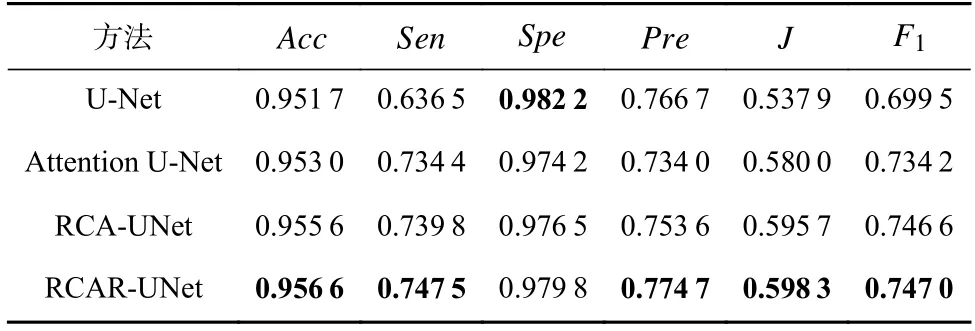

3.4 實驗結果分析

4 總結