融合濾波增強和反轉(zhuǎn)注意力網(wǎng)絡(luò)用于息肉分割

林薦壯,楊文忠*,譚思翔,周樂鑫,陳丹妮

(1.新疆大學 信息科學與工程學院,烏魯木齊 830046;2.新疆大學 軟件學院,烏魯木齊 830091)

0 引言

息肉是由局部粘膜表面突出的異常生長的組織,可以在結(jié)腸、直腸、胃甚至喉嚨中發(fā)現(xiàn)。在大多數(shù)情況下,息肉是良性的;然而,息肉具有潛在癌變的可能,所以需要進行長期的診斷,包括息肉的增長情況、位置以及是否變成惡性。

當結(jié)直腸息肉持續(xù)惡化,就有可能會慢慢演化成結(jié)直腸癌。結(jié)直腸癌是世界上六種最常見的癌癥之一,也是消化道最常見的惡性腫瘤之一,在所有癌癥中,死亡率排在前10位[1]。自20 世紀90 年代初以來,結(jié)腸鏡檢查的引入使得結(jié)直腸癌總體發(fā)病率降低,是結(jié)直腸癌篩查的主要方式,可以在結(jié)腸息肉發(fā)展為癌癥之前檢測和清除結(jié)腸息肉[2]。結(jié)直腸息肉的檢測和分割是醫(yī)生診斷結(jié)直腸癌的重要依據(jù);因此,準確分割結(jié)直腸息肉對于降低結(jié)直腸癌的發(fā)病率具有重要意義。

傳統(tǒng)的息肉分割算法主要通過研究人員手動設(shè)計息肉特征來實現(xiàn)分割任務(wù),根據(jù)息肉和背景的不同,從灰度值、對比度信息和紋理信息三個方面進行設(shè)計。傳統(tǒng)的分割算法包括基于閾值的分割算法[3]、基于邊界的分割算法[4]和基于區(qū)域生長的分割算法[5]。由于同一類型的息肉的外觀可能不同(如大小、紋理和顏色),在結(jié)腸鏡檢查圖像中,息肉與周圍粘膜的邊界通常非常模糊,無法達到傳統(tǒng)分割算法所要求的對比度。使用傳統(tǒng)的分割算法分割息肉需要耗費大量的人力,效率低,且分割不完整。

隨著計算機技術(shù)和人工智能的飛速發(fā)展,出現(xiàn)了許多深度神經(jīng)網(wǎng)絡(luò),如全卷積網(wǎng)絡(luò)(Fully Convolutional Network,F(xiàn)CN)[6]、U-Net[7]、SegNet(Segmentation Network)[8]、DenseNet(Dense convolutional Network)[9]等,能夠幫助處理大容量的結(jié)腸鏡檢查圖片和視頻數(shù)據(jù),協(xié)助臨床醫(yī)生對結(jié)腸鏡檢測結(jié)腸息肉是否存在和息肉分類作出決定[10]。由于深度學習的通用性和高效性,其分割效果優(yōu)于傳統(tǒng)的分割算法,已被應(yīng)用于醫(yī)學圖像分割等多個領(lǐng)域。隨著對神經(jīng)網(wǎng)絡(luò)研究的不斷深入,注意力機制也逐漸得到廣泛的應(yīng)用,通過計算注意力權(quán)重和對特征進行加權(quán)可強化有效特征,抑制無效特征[11]。分析結(jié)腸鏡檢查獲得的圖像可以發(fā)現(xiàn),大部分圖像中息肉區(qū)域與周圍粘膜的邊界通常非常模糊,缺乏對比度。由于前景和背景之間的對比度較低,在下采樣過程中容易造成病灶區(qū)域結(jié)構(gòu)信息丟失以及現(xiàn)有方法過度分割和欠分割問題。為了解決以上問題,本文提出了融合濾波增強和反轉(zhuǎn)注意力分割網(wǎng)絡(luò)(Fusing Filter enhancement and Reverse attention segmentation Network,F(xiàn)FRNet)。

1 相關(guān)工作

隨著基于卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)的發(fā)展,涌現(xiàn)了許多優(yōu)秀的方法,它們在醫(yī)學圖像領(lǐng)域取得了不錯的效果。典型的工作有:

1)嵌套式U 型網(wǎng)絡(luò)(nested U-Net,UNet++)[12]。Zhou等[12]在U-Net[7]的基礎(chǔ)上提出了UNet++。該網(wǎng)絡(luò)中,編碼器和解碼器通過一系列嵌套的密集跳過路徑連接,縮小了編碼器和解碼器的特征映射之間的語義差距;網(wǎng)絡(luò)中增加了深度監(jiān)督,實現(xiàn)更準確的分割,特別是對于出現(xiàn)在多個尺度上的病變,如結(jié)腸鏡檢查視頻中的息肉,深度監(jiān)督能提高網(wǎng)絡(luò)對于息肉分割的能力。

2)選擇性特征聚合(Selective Feature Aggregation,SFA)網(wǎng)絡(luò)[13]。Fang 等[13]提出一種具有面積和邊界約束的選擇性特征聚合網(wǎng)絡(luò)用于息肉分割。具體地,上聯(lián)和選擇性核模塊(Selective Kernel Module,SKM)被用來選擇息肉圖像的多尺度和多接受場表示;并且提出了一種新的損失,該損失考慮了區(qū)域和邊界分支之間的相關(guān)性,使兩個分支之間可以相互影響,從而實現(xiàn)更準確的預(yù)測。

3)并行反轉(zhuǎn)注意力網(wǎng)絡(luò)(Parallel reverse attention Network,PraNet)[14]。Fan 等[14]提出使用并行的部分解碼器(Partial Decoder,PD)[15]組件獲取全局特征圖和遞歸反向注意模塊。首先,使用并行連接聚合高級特征;然后,使用PD計算全局特征映射;最后,通過全局地圖和反向注意機制建立區(qū)域與邊界的關(guān)系,能實現(xiàn)對息肉區(qū)域的準確分割。

4)不確定性增強上下文注意力網(wǎng)絡(luò)(Uncertainty Augmented Context Attention Network,UACANet)[16]。Kim等[16]提出通過獲取未識別的區(qū)域信息來增強上下文信息。具體地,通過計算具有模糊顯著性區(qū)域的分數(shù),結(jié)合前景和背景區(qū)域用于上下文注意模塊,并且提出了用于主干特征編碼器和初始顯著圖解碼器的平行軸注意力。該網(wǎng)絡(luò)在未可見數(shù)據(jù)集上取得了較好的效果。

5)基于多尺度感知和語義適配的醫(yī)學圖像分割算法[17]。王雪等[17]提出多尺度上下文感知模塊和多層語義適配模塊,通過多尺度上下文感知模塊,采用不同感受野獲取豐富的特征信息,并根據(jù)目標區(qū)域大小動態(tài)分配權(quán)重;通過多層語義適配模塊聚合多級語義特征和空間細節(jié)信息。該網(wǎng)絡(luò)在可見數(shù)據(jù)集上的分割效果較好。

6)基于階梯結(jié)構(gòu)的U-Net 結(jié)腸息肉分割算法[18]。時永剛等[18]采用克羅內(nèi)克(Kronecker)乘積,擴展標準空洞卷積核,彌補傳統(tǒng)空間卷積丟失的相關(guān)細節(jié)特征;應(yīng)用具有階梯結(jié)構(gòu)的融合模塊,獲取上下文信息和多尺度聚合特征。該算法在部分基準數(shù)據(jù)集上取得了不錯的效果。

7)全局和局部交互式注意力網(wǎng)絡(luò)[19]。任莉莉等[19]在U-Net[7]的基礎(chǔ)上加入了全局和局部交互式注意力融合模塊。其中:全局注意力通過線性層和歸一化層實現(xiàn),以加強空間維度的特征提取能力;局部注意力采用了局部跨通道交互策略。該網(wǎng)絡(luò)能夠分割出大部分息肉區(qū)域,但存在分割不完整問題。

本文提出的FFRNet 使用Res2Net[20]作為主干網(wǎng)絡(luò),對圖像進行下采樣并建立多級跳級連接。在連接過程中,加入濾波增強模塊(Filter Enhancement Module,F(xiàn)EM)來獲取前景和背景的變化強度,并添加到原始特征中,從而提高目標與其他區(qū)域的對比度,增強息肉結(jié)構(gòu)信息。采用多尺度反轉(zhuǎn)注意力融合機制(Multiscale reverse Attention Fusion Mechanism,MAFM),結(jié)合全局特征和上采樣特征獲得反向注意力權(quán)重,并通過多層反向注意力模塊和多尺度權(quán)重疊加,建立和加強息肉區(qū)域與邊界之間的關(guān)系。

2 FFRNet

輸入圖像x∈RH×W×C及其灰度圖像g∈RH×W×C,空 間分辨率為H×W,通道數(shù)為C。通過FFRNet,輸出大小為H×W× 1 的相應(yīng)像素級標簽圖。圖1 為FFRNet 的網(wǎng)絡(luò)結(jié)構(gòu),其中包含卷積(Convolution,Conv)、正則化(Batch Normalization,BN)、線性整流函數(shù)(Rectified Linear Unit,ReLU)等。首先,通過編碼器獲得圖像的高級特征表示;接著,在解碼器部分引入FEM 和MAFM,提取目標區(qū)域。

圖1 FFRNet的網(wǎng)絡(luò)結(jié)構(gòu)Fig.1 Network structure of FFRNet

2.1 濾波增強模塊

如圖2(c)所示,通過觀察結(jié)腸鏡下的息肉圖像,可以發(fā)現(xiàn)息肉與其周圍黏膜的邊界十分模糊,前景與背景的對比度非常低,對其分割具有一定難度。當對輸入圖像進行下采樣時,目標結(jié)構(gòu)信息丟失嚴重,無法有效提取息肉特征。

受到Liu 等[21]提出的圖像金字塔引導網(wǎng)絡(luò)(Image Pyramid Guidance Network,IPG-Net)和Yin 等[22]提出的深度引導網(wǎng)絡(luò)(Deep Guidance Network,DGNet)的啟發(fā),本文在網(wǎng)絡(luò)中增加了FEM,使用原圖與其相對應(yīng)的灰度圖作為輸入,用來補償在下采樣過程中的結(jié)構(gòu)和細節(jié)損失并提高前景的對比度。具體地,將大小為x∈RH×W×C的圖像作為輸入,通過主干網(wǎng)絡(luò)獲得特征fi(i=1,2,3,4);接著,將fi和下采樣得到相同大小的灰度圖像輸入FEM。

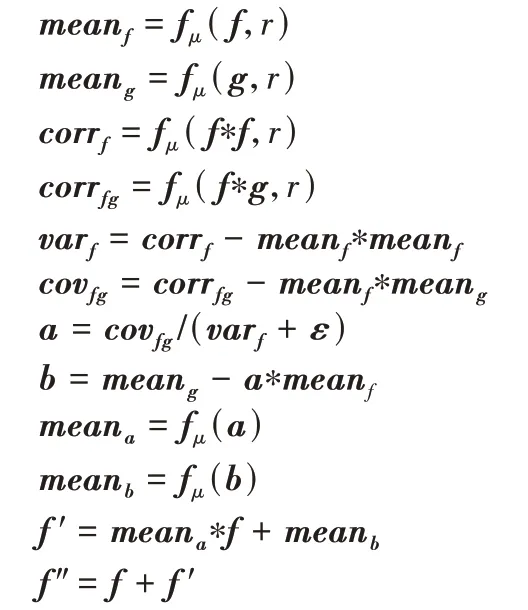

FEM 對輸入特征圖f、相應(yīng)灰度圖g和正則化系數(shù)ε進行如下操作:

其中:mean為通過均值濾波輸出的特征圖;f ′為包含變化強度信息的特征圖;fμ(*,r)為以r為窗口大小計算特征均值圖;corr表示相關(guān)性;var表示方差;cov表示協(xié)方差;f″為通過FEM 輸出特征;a、b為線性處理的參數(shù)。

通過均值濾波和線性變換對輸入特征fi和灰度圖像g進行處理,最后輸出f″;通過FEM 獲取目標區(qū)域與邊界之間變化強度并保留到特征圖中,使得特征f″獲得更多的息肉特征信息,彌補部分由于下采樣造成的結(jié)構(gòu)信息丟失。圖2(c)~(d)直觀地展示了FEM 處理前后的效果。

圖2 濾波增強模塊的實驗結(jié)果對比Fig.2 Experimental results comparison of filter enhancement module

通過分析研究和實驗驗證,在網(wǎng)絡(luò)的前兩層加入濾波增強模塊,可使網(wǎng)絡(luò)在訓練和測試中取得不錯的效果。

2.2 多尺度反轉(zhuǎn)注意力融合機制

為了解決網(wǎng)絡(luò)對于息肉區(qū)域分割不足的問題,受文獻[14,23-24]啟發(fā),本文在上采樣過程中引入了反轉(zhuǎn)注意力模塊。與文獻[14]不同的是,本文通過結(jié)合多尺度融合的全局權(quán)重和上采樣生成的初步權(quán)重,細化注意力權(quán)重;接著,通過反轉(zhuǎn)注意力擦除前景對象的方式逐步挖掘有區(qū)別的目標區(qū)域,提升模型的分割效果。

2.2.1 全局圖模塊

如圖3 所示,將編碼層的fi(i=1,2,3)進行元素相乘聚合(Aggregation),并在輸出過程中加入通道注意力和空間注意力[25-26],按順序推導出沿通道和空間兩個獨立維度的注意力圖;然后將注意力圖相乘到輸入特征圖進行自適應(yīng)特征細化,得到最終的全局映射圖。特別地,在聚合特征的同時串聯(lián)兩個注意力,細化特征,使網(wǎng)絡(luò)能更準確地聚焦于目標區(qū)域,得到精細的全局映射圖。

圖3 全局圖模塊處理流程Fig.3 Processing flow of global map module

2.2.2 反轉(zhuǎn)注意力模塊

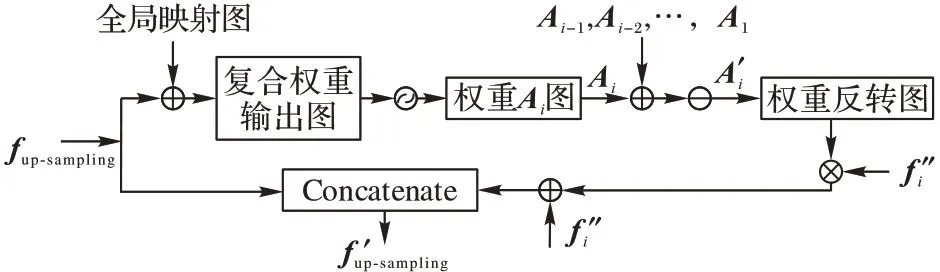

反轉(zhuǎn)注意力模塊的詳細處理過程如圖4 所示。fup-sampling是上采樣過程中的輸出,特征f″由2.1 節(jié)中FEM 獲得。首先,通過fup-sampling獲得初步權(quán)重Ap,并將2.2.1 節(jié)中的全局映射圖作為全局權(quán)重Ag,通過元素相加,得到復合權(quán)重Ai:

圖4 反轉(zhuǎn)注意力模塊處理流程Fig.4 Processing flow of reverse attention module

然后,通過多尺度權(quán)重疊加策略對深層權(quán)重進行上采樣(這里采用雙線性插值的方法),將其疊加至當前權(quán)重。通過這種方式,提高反轉(zhuǎn)注意力模塊對于目標區(qū)域提取的完整性,并補充部分丟失的細節(jié)信息。

通過結(jié)合全局權(quán)重和初步權(quán)重,使得復合權(quán)重能更加有效地挖掘特征圖中前景區(qū)域的結(jié)構(gòu)信息。通過這種自下而上的多尺度反向注意機制擦除方式,F(xiàn)FRNet 最終可以將粗略和低分辨率的預(yù)測圖細化為一個完整的包含探索目標區(qū)域和細節(jié)高分辨率顯著圖。

2.3 感受野塊

在跳級連接的過程中,為了保留特征中更多有用信息的同時減少通道數(shù),使用了感受野塊(Receptive Field Block,RFB)[27]。它是一種多分支卷積,使用不同大小的卷積核來獲取具有不同感受野的特征,如圖5 所示。

圖5 感受野塊處理流程Fig.5 Processing flow of receptive field block

2.4 損失函數(shù)

FFRNet 使用了二進制交叉熵(Binary Cross Entropy,BCE)損失和加權(quán)交并比(weighted Intersection over Union,wIoU)損失。可以表示為:

損失函數(shù)的定義與文獻[14,28-29]中的定義相同。通過?wIoU增加困難樣本的權(quán)重以突出其重要性,并使用?BCE使網(wǎng)絡(luò)在訓練過程中更加關(guān)注困難樣本。

3 實驗與結(jié)果分析

3.1 數(shù)據(jù)集

實驗中采用的訓練數(shù)據(jù)集來自Kvasir[30]和CVCClinicDB[31]中隨機選擇的圖像。為了與現(xiàn)有方法公平比較,提取與文獻[14]相同的訓練數(shù)據(jù)進行模型訓練。其中900張圖像來自Kvasir,550 張來自CVC-ClinicDB。

以下為用于對模型進行最終測試的5 個基準數(shù)據(jù)集,:

1)Kvasir。該數(shù)據(jù)集包含1 000 張息肉圖像,其中900 張用于模型訓練,100 張用于模型測試。與其他數(shù)據(jù)集的區(qū)別在于Kvasir 中圖像大小各不相同,其范圍在332×487 到1 920×1 072;并且圖像中息肉區(qū)域的大小和形狀也各不相同。所以,使用該數(shù)據(jù)集進行測試具有一定的挑戰(zhàn)性。

2)CVC-ColonDB[32]。該數(shù)據(jù)集由結(jié)腸鏡檢查的15 個不同序列中采樣的380 張圖像組成,圖像大小均為574×500。

3)CVC-ClinicDB[31]。該數(shù)據(jù)集由從25 個結(jié)腸鏡檢查視頻中提取的612 張圖像組成,圖像大小均為384×288。其中550 張圖像用于模型訓練,62 張圖像用于模型測試。

4)EndoScene[33]。該數(shù)據(jù)集由從36 名患者的44 個結(jié)腸鏡檢測序列中提取的912 張圖像組成。由于EndoScene 是由CVC-ClinicDB 和CVC-300 結(jié)合而成的,所以使用CVC-300 作為模型的測試數(shù)據(jù)集,共60 張息肉樣本圖像,大小為574×500。

5)ETIS[34]。該數(shù)據(jù)集是從34 個結(jié)腸鏡檢查視頻中提取的196 張圖像,圖像大小均為1 225×966。通過觀察該數(shù)據(jù)集中的圖像可以發(fā)現(xiàn)其目標區(qū)域很小,實驗中先對圖像輸入大小進行調(diào)整,將目標區(qū)域等比例縮小。同樣地,使用模型對其進行分割具有很大的挑戰(zhàn)性。

其中:將可見數(shù)據(jù)集(Kvasir 和CVC-ClinicDB)劃分為訓練集和測試集,使用訓練集對模型訓練;未可見數(shù)據(jù)集(CVC-ColonDB、EndoScene 和ETIS)只作為測試集,未劃分數(shù)據(jù)參與模型訓練,用于測試模型泛化能力。

3.2 評價指標

為了更好地與現(xiàn)有方法作對比,采用與文獻[14,16]相同的評價指標。包括:

1)Dice 相似系數(shù)(Dice Similarity Coefficient,DSC),用于計算預(yù)測目標區(qū)域與實際目標區(qū)域的相似性。本文對測試集中所有測試結(jié)果的相似系數(shù)總和取平均值,記作mDice。相似系數(shù)的計算公式如下:

其中:真陽性TP(True Positive)為預(yù)測目標區(qū)域與實際圖像相同的像素值;假陽性FP(False Positive)為預(yù)測將實際背景區(qū)域預(yù)測成目標區(qū)域的像素值;假陰性FN(False Negative)為預(yù)測將實際目標區(qū)域預(yù)測成背景區(qū)域的像素值。

2)交并比(Intersection-over-Union,IoU)系數(shù),用于計算預(yù)測值和實際值兩個集合的交集與并集的比值。本文對測試集中所有測試結(jié)果的交并比系數(shù)總和取平均值,記作mIoU。交并比系數(shù)的計算公式如下:

3)平均絕對值誤差(Mean Absolute Error,MAE),用于比較預(yù)測值y與實際值之間的逐像素絕對值差異。

4)結(jié)構(gòu)相似性度量Sα(Structure-measure)[35],用于衡量預(yù)測圖像和實際圖像的結(jié)構(gòu)相似性。

5)增強對齊度量(Enhanced-alignment measure)[36]。

6)加權(quán)相似度量系數(shù)(Weighted similarity measure coefficient)[37],用于修正相似系數(shù)中的“同等重要的缺陷”問題。

其中:β為1;Precision為加權(quán)精度值;Recall為加權(quán)召回值。

3.3 實驗環(huán)境參數(shù)與數(shù)據(jù)預(yù)處理

本文模型使用PyTorch 1.10.2 框架實現(xiàn),由TITAN RTX GPU 進行加速。在訓練階段,對圖像進行歸一化、旋轉(zhuǎn)、水平翻轉(zhuǎn)等預(yù)處理操作,輸入到模型的圖像大小統(tǒng)一調(diào)整為352×352。設(shè)置16 個批次batch_size,使用預(yù)熱學習速率,設(shè)定為0.000 1,且使用Adam 優(yōu)化器對模型進行了200 個周期的訓練,并使用多尺度訓練策略{0.75,1,1.25}。

3.4 不同網(wǎng)絡(luò)模型對比實驗

Kvasir[30]是近期發(fā)布的最大的數(shù)據(jù)集,其中的圖像的大小各不相同,并且息肉區(qū)域的外觀和紋理也有很大的不同,所以分割這個數(shù)據(jù)集具有很大的挑戰(zhàn)性。對比網(wǎng)絡(luò)模型包括:U-Net[7]、U-Net++[12]、SFA[13]、PraNet[14]、UACANet(S)[16]和UACANet(L)[16],其中S、L 代表網(wǎng)絡(luò)中采用的卷積通道數(shù)大小,結(jié)果如表1 所示。

表1 在可見和未可見數(shù)據(jù)集上不同網(wǎng)絡(luò)的結(jié)果對比Tab.1 Comparison results of different networks on visible and invisible datasets

如表1 所示,其中加粗值為最優(yōu)值,下劃線為次優(yōu)值。FFRNet 在Kvaisr 上的平均相似系數(shù)為91.4%,其他指標也超過了其他對比網(wǎng)絡(luò),取得了不錯的結(jié)果,尤其是與UACANet(L)相比,相似系數(shù)提升了0.2 個百分點。因此,本文提出的FFRNet 可以在許多具有挑戰(zhàn)性和復雜的場景中準確定位和分割息肉區(qū)域。在CVC-ClinicDB 上,F(xiàn)FRNet 相較于UACANet(L)提升了0.5 個百分點。

圖6 展示了FFRNet 和其他方法在5 個不同基準數(shù)據(jù)集上的部分分割結(jié)果,可以直觀看出FFRNet 對不同大小息肉區(qū)域的分割結(jié)果接近實際標簽結(jié)果,效果最好。

圖6 5個不同基準數(shù)據(jù)集上不同網(wǎng)絡(luò)的部分分割結(jié)果對比Fig.6 Comparison of partial segmentation results of different networks on five different benchmark datasets

使用未可見的數(shù)據(jù)集(CVC-ColonDB、EndoScene、ETIS)測試模型的泛化能力(模型訓練數(shù)據(jù)僅來自Kvasir 和CVCClinicDB),實驗結(jié)果如表1 所示。FFRNet 在這些數(shù)據(jù)集上均取得了不錯的結(jié)果。當將圖像調(diào)整到352×352 后,在ETIS中,大部分圖像中息肉目標區(qū)域的占比非常低,因此,預(yù)測時對息肉區(qū)域進行分割非常困難且具有很大的挑戰(zhàn)性。此時,F(xiàn)FRNet 在ETIS 上mDice 為76.2%,與UACANet(L)[16]相當,與UACANet(S)[16]相比,提升了6.8 個百分點。綜上所述,本文提出的FFRNet 具有較好的泛化能力。

3.5 消融實驗

對FFRNet 進行消融實驗,在可見和未可見數(shù)據(jù)集上測試FFRNet 的各個組件,結(jié)果如表2 所示,其中,Backbone 模塊為使用骨干網(wǎng)絡(luò)進行訓練(不包含任何組件)。

如表2 所示,可以發(fā)現(xiàn)在Kvasir 和EndoScene 上,主干網(wǎng)絡(luò)在加入FEM 后,mDice 和mIoU 等評價指標有著小幅提升。由此可知,F(xiàn)EM 發(fā)揮了一定的作用,恢復部分下采樣造成的結(jié)構(gòu)損失,提高了網(wǎng)絡(luò)的分割能力。加入MAFM 后,mDice和mIoU 等評價指標有著明顯提升。因此,使用MAFM 可以提高網(wǎng)絡(luò)挖掘邊界信息的能力,準確分割息肉區(qū)域。而FEM和MAFM 兩者結(jié)合的實驗結(jié)果取得了91.4%和90.2%的mDice,所有評價指標明顯高于其他的實驗結(jié)果。由此可知,兩個模塊結(jié)合能夠更加有效地提高網(wǎng)絡(luò)的性能。本文提出的FFRNet 對腸道息肉具有良好的分割性能。

表2 不同模塊的消融實驗結(jié)果Tab.2 Ablation experimental results of different modules

4 結(jié)語

本文針對目前現(xiàn)有方法在腸道息肉分割中存在息肉區(qū)域分割不全等問題,提出了一個融合濾波增強模塊和多尺度反轉(zhuǎn)注意力融合機制分割網(wǎng)絡(luò)FFRNet 用于結(jié)直腸道息肉分割。首先,在編碼層輸出時,加入濾波增強模塊,用于解決下采樣過程中目標區(qū)域結(jié)構(gòu)信息缺失問題;然后,在解碼層,結(jié)合全局特征和上采樣輸出的初步特征生成反轉(zhuǎn)注意力權(quán)重,用于挖掘特征圖中息肉區(qū)域,區(qū)別其他區(qū)域,提高網(wǎng)絡(luò)對于息肉邊界的分割能力,解決對息肉區(qū)域過度分割和欠分割問題。為了與現(xiàn)有方法作對比,網(wǎng)絡(luò)模型的輸入圖像采用了相同的固定大小;然而,不同數(shù)據(jù)集圖像大小各異,固定大小會明顯影響最終的分割結(jié)果,尤其是在對于有些息肉小目標區(qū)域的分割效果不是特別理想。未來將針對小目標問題,對網(wǎng)絡(luò)作進一步改進。