基于多尺度變形卷積的特征金字塔光流計算方法

范兵兵 葛利躍 張聰炫 李 兵 馮 誠 陳 震

光流是指圖像序列中運動目標或場景表面像素點的二維運動矢量,其不僅包含了物體或場景的運動參數,還攜帶了圖像中運動目標豐富的結構信息,因此,針對圖像序列光流計算技術的研究一直是圖像處理、計算機視覺等領域的研究熱點.相關研究成果廣泛應用于目標跟蹤[1]、圖像配準[2]、表情識別[3]、運動遮擋檢測[4]和機器人視覺導航[5]等高級視覺任務.

自 Horn和 Schunck 提出變分光流計算技術以來,圖像序列光流計算技術在光流計算精度和魯棒性方面已經取得顯著提升[6].然而,隨著圖像序列包含的場景任務日益復雜,光流計算的難度越來越大.例如,當圖像序列中包含運動遮擋、大位移以及非剛性形變等困難復雜場景時,當前光流計算方法在精度與魯棒性方面仍亟需進一步提高.特別在圖像與運動邊緣區域,現有光流計算方法普遍存在較為嚴重的信息丟失與模糊問題.針對該問題,傳統變分光流計算方法通常采用在能量泛函中附加約束項[6]或設計邊緣保護策略來改善該問題[7].例如,Zhang 等[8]提出一種基于三角網格的遮擋檢測約束項并將其與變分能量泛函耦合,通過補償光流計算中損失的遮擋信息,顯著提升了圖像與運動邊緣區域光流計算精度.Mei 等[9]將局部優化策略與全局優化策略相結合,提出一種局部與全局耦合的加權正則變分光流計算模型,提高了光照變化場景光流計算的精度與魯棒性.針對大位移運動場景光流計算準確性較低問題,Chen 等[10]將塊匹配策略與由粗到細的光流計算方案相結合,提高了大位移運動光流計算精度,但該方案易導致邊緣模糊和細節結構信息丟失.為此,Deng 等[11]提出一種新穎的可微鄰域搜索上采樣模塊,并將其與由粗到細光流計算方案結合,較好地保護了圖像與邊緣結構.后續,文獻[12] 在光流金字塔分層優化過程中集成結構引導濾波,利用結構引導濾波具有邊緣保護的作用,實現光流計算運動邊緣的保護.Dong 等[13]進一步將濾波技術與非局部項相結合,提出一種非局部傳播的濾波光流優化方案,在減少光流計算異常值的同時保留了豐富的上下文信息.

近年來,隨著人工智能與深度學習技術的飛速發展,基于深度學習的光流計算技術得到廣泛關注.Dosovitskiy 等[14]率先將卷積神經網絡引入光流計算,提出 FlowNet 深度學習光流計算模型,該模型通過采用編碼-解碼結構極大地縮短了光流計算所需的時間,同時也奠定了深度學習光流計算網絡的基本結構.然而,FlowNet 的網絡結構比較簡單,光流計算精度較低.后續,Ilg 等[15]將FlowNet 網絡結構進行多次堆疊,并將堆疊后的網絡命名為 Flow-Net 2.0,與 FlowNet 相比,FlowNet 2.0 網絡深度更深,光流計算精度也更高.但多次堆疊操作使得FlowNet 2.0 網絡結構過于臃腫復雜,模型訓練不僅困難而且易陷入過擬合.為了在光流計算精度與模型尺寸之間尋求平衡,Sun 等[16]將特征金字塔、變形操作、成本體積代價集成在統一的光流計算網絡框架中,提出 PWC-Net 光流計算方法.該方法在簡化網絡尺寸的同時大幅提高了光流計算的精度與魯棒性.然而,上述方法均為有監督深度學習光流計算方法,需要提供大量具有真實標簽的樣本數據用于模型訓練,因此難以應用于真實任務場景.受傳統變分光流中的能量泛函啟發,Yu 等[17]通過設計基于數據項與平滑項相結合的損失函數,實現了基于無監督學習的光流計算.這在一定程度使深度學習光流計算模型擺脫了對標簽樣本數據的依賴,但光流計算精度大幅落后于有監督學習方法.為此,Liu 等[18]借鑒知識蒸餾思想,提出一種基于數據驅動的蒸餾學習無監督光流計算模型 DDFlow.該方法通過數據驅動自動學習和預測光流,在提高光流計算精度的同時實現了實時無監督光流計算.

現階段,基于深度學習的光流計算方法雖然已取得較大進展,光流計算精度不斷提高.但是,由于大位移、運動遮擋以及非剛性運動違背了網絡模型設計的先驗知識,因此光流計算在圖像與運動邊緣區域存在模糊的問題仍未得到妥善解決.Hur 等[19]通過引入遮擋真實值,設計一種遮擋解碼器對遮擋區域特征學習并利用學習到的遮擋信息約束遮擋區域的光流計算,一定程度緩解了該問題.然而,包含遮擋真實值的數據集較少,難以滿足大規模使用.為了克服該問題,Zhao 等[20]提出一種不需要遮擋真實值的非對稱特征匹配模塊學習遮擋掩膜,以約束遮擋區域光流計算.Meister 等[21]借鑒變分遮擋光流計算策略,設計一種前后一致性損失函數用于指導網絡學習遮擋特征信息,有效保護了圖像與運動邊緣.

當前,基于深度學習的光流計算網絡模型大多都致力于研究新的先驗知識來設計光流計算網絡結構.然而,相對于之前的網絡,這些網絡結構往往非常復雜且難以訓練,不僅大幅增加了深度學習光流計算的難度,而且還進一步提高了計算成本.針對上述問題,本文從圖像特征提取網絡模型的設計入手,提出一種基于多尺度變形卷積的特征提取模型,并將其與特征金字塔光流計算網絡耦合,在少量增加原有網絡結構復雜度的同時提高編碼器網絡的特征提取能力,從而獲取更加準確的圖像特征.此外,為了保護圖像與運動邊緣,本文又設計一種結合圖像與運動邊緣約束的混合損失函數,來指導模型學習更加精準的邊緣信息.實驗結果證明,本文方法具有更高的光流計算精度,有效解決了光流計算的邊緣模糊問題.

1 基于多尺度變形卷積的特征金字塔光流計算模型

1.1 多尺度變形卷積特征提取網絡

當前,深度學習光流計算網絡模型普遍采用標準卷積實現圖像特征提取.然而,標準卷積具有較為顯著的平滑作用,導致提取的圖像特征過于平滑.同時,標準卷積對規則區域的特征信息捕獲較為準確,在不規則區域往往無法獲取完整的圖像特征.因此,僅利用標準卷積構建圖像特征提取網絡難以獲取準確的圖像特征信息.

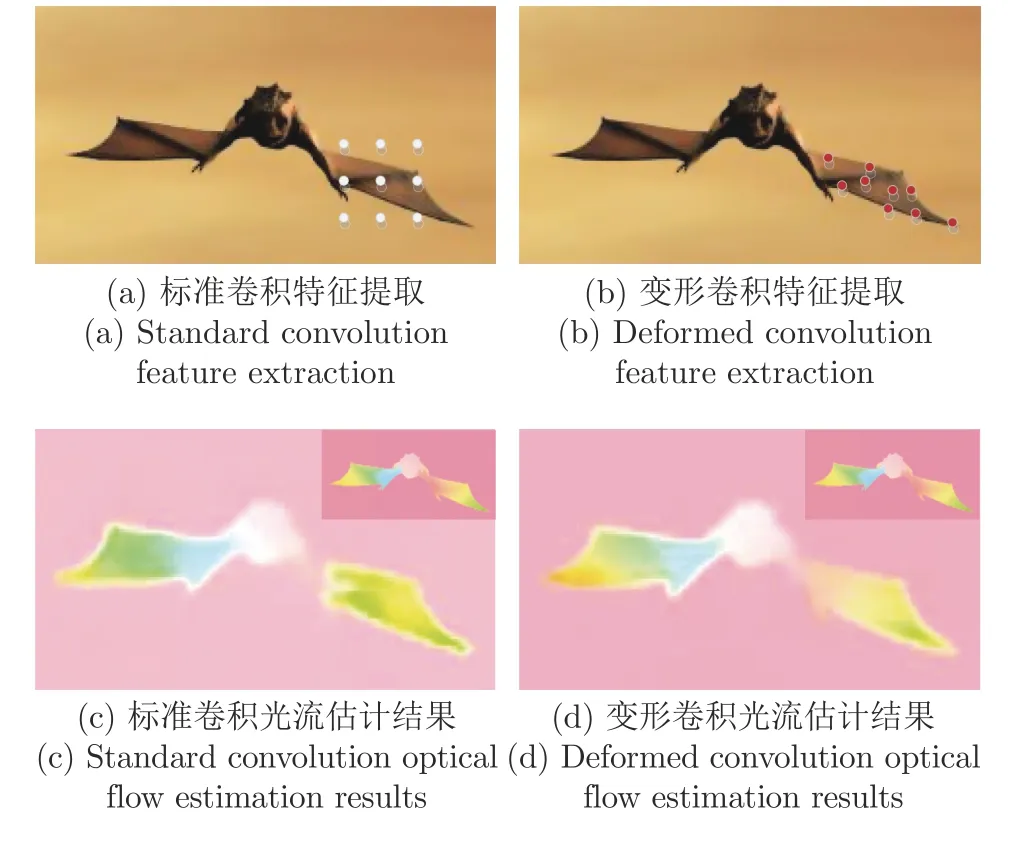

針對該問題,本文從圖像特征提取策略出發,提出一種多尺度變形卷積特征提取網絡.通過聚合多尺度圖像特征信息,讓多尺度變形卷積感受野可以擬合不同尺寸和形狀的目標,從而更加精準地提取出圖像特征.圖1 展示了標準卷積與變形卷積在運動目標翅膀區域圖像特征提取示意圖與對應模型光流計算結果.從圖1(a)、圖1(b) 中可以看出,標準卷積相對變形卷積捕獲了更多非目標的像素點信息,而變形卷積通過擬合翅膀區域形狀捕獲了更加準確的圖像特征,特別是邊緣區域更貼近真實圖像邊緣.圖1(c)和圖1(d) 分別展示了使用兩種卷積提取特征后的模型光流計算結果,圖中右上角為光流真實值.從圖中可以看出,在運動目標的翅膀區域,使用變形卷積提取特征的光流計算結果與真實值更加接近且未出現中斷.而使用標準卷積的光流計算結果在翅膀區域與真實值存在較大差異且存在明顯的中斷.說明變形卷積通過擬合翅膀區域形狀捕獲更加準確的圖像特征信息,對提高光流計算的精度具有較好的促進作用.

圖1 標準卷積與變形卷積圖像特征提取示意圖與對應模型光流計算結果Fig.1 Schematic diagram of standard convolution and deformed convolution image feature extraction and corresponding model optical flow estimation results

圖2 展示了本文所提的多尺度變形卷積特征提取網絡結構示意圖.從圖中可以看出,在輸入原始圖像序列后,首先使用標準卷積獲取稠密的初始圖像特征,該步驟一定程度起到圖像預處理作用.然后,使用不同尺度的變形卷積對稠密的初始圖像特征進行細化,以提取不同尺寸的目標特征信息.其中,變形卷積特征提取網絡包含3 條并行的分支,每條分支均包含1 個變形卷積層.且變形卷積核尺寸分別為 3×3、5×5和 7×7,每條分支的輸出均為12 通道的特征圖.最后,對每個變形卷積提取的特征使用 3×3 標準卷積,并通過1 個標準 3×3 卷積層將每條分支的輸出特征圖進行通道拼接,以聚合所有分支捕獲的圖像特征信息.由于在連續幀的圖像序列中,即使是相同運動目標,它的大小和形狀也有可能不同.因此,本文通過引入變形卷積使卷積層的感受野可以靈活改變,以適合運動目標不同的大小和形狀,從而獲取不同范圍內不同尺度的圖像特征信息.

圖2 多尺度變形卷積特征提取網絡結構示意圖Fig.2 Schematic diagram of multi-scale deformed convolution feature extraction network structure

在圖2 中虛線方框區域,本文先使用變形卷積再使用標準卷積的原因有兩方面:一方面,盡管變形卷積對目標有更好的適應性,但是在多尺度特征提取網絡模型中,隨著圖像尺度的減小,圖像中目標的形態輪廓信息逐漸損失變得模糊.此時變形卷積難以準確地擬合不同尺寸和形狀的目標,并且隨著擬合精度的下降還會引入大量噪聲與異常值.因此,為了緩解進而改善該問題,本文在變形卷積之后對應增加了 3×3 標準卷積操作,其作用是在提高低分辨率特征提取精度的同時進行濾波以去除提取特征中的噪聲與異常值.另一方面,變形卷積由于具有擬合不同尺寸和形狀的目標的特性,因此,變形卷積相對傳統卷積包含更多的參數.如果單一使用變形卷積構建多尺度特征提取模型將大幅增加模型尺寸,訓練參數也將大幅增加,導致模型訓練困難,難以收斂擬合.

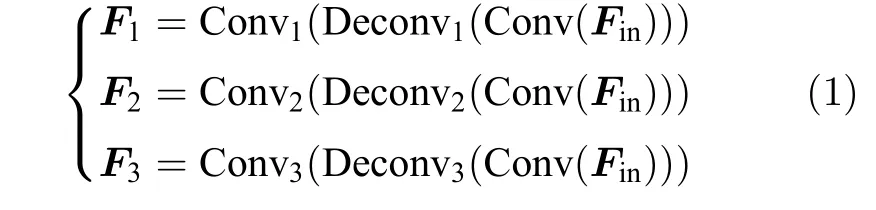

將上述過程公式化:令Fin表示多尺度變形卷積特征提取網絡的輸入,多尺度變形卷積特征提取網絡的3 條平行分支的輸出計算公式可以表示為

式 (1) 中,F1,F2,F3分別代表第1、2、3 條分支的輸出,運算符號 C onv1,C onv2,C onv3代表第1、2、3條分支的標準卷積運算,運算符號 D econv1,D econv2,Deconv3代表第1、2、3 條分支對應的變形卷積運算,運算符號 C onv 代表3 條并行分支之前的標準卷積運算.將各條分支的輸出特征拼接起來進行信息聚合,多尺度變形卷積特征提取網絡的最終輸出可以表示為

式(2)中,C onvf是一個 3×3 標準卷積,代表最終聚合信息的卷積操作,c oncatenate 是通道拼接操作.圖3 展示了本文方法特征提取結果與僅使用標準卷積特征提取結果的可視化對比,其中,標簽A、B、C 分別對應運動目標不同的三個邊緣區域.從圖3(e)中可以看出,僅使用標準卷積構建的多尺度特征提取網絡模型,所獲取的圖像特征在邊緣區域明顯模糊,且異常值較多.而本文所提的多尺度變形卷積特征提取網絡獲取的圖像特征在邊緣區域更為清晰,異常值與噪聲也較少,并且獲取的圖像特征值更大.

圖3 本文方法特征提取與標準卷積特征提取結果可視化對比Fig.3 Visual comparison of feature extraction results of the method in this paper and standard convolution feature extraction results

1.2 基于多尺度變形卷積的特征金字塔光流計算網絡

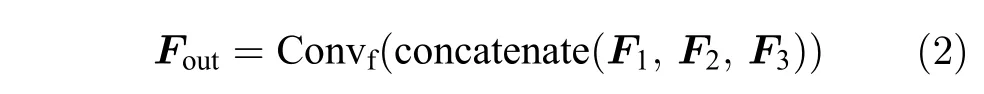

本文將多尺度變形卷積特征提取網絡與特征金字塔光流計算網絡耦合,構建基于多尺度變形卷積的特征金字塔光流計算模型,以實現高精度的光流計算.圖4 展示了本文提出的基于多尺度變形卷積的特征金字塔光流計算網絡模型.從圖中可以看出,網絡模型主要由編碼器網絡與解碼器網絡組成.其中,編碼器網絡由基于多尺度變形卷積的特征提取網絡和編碼器組成.解碼器網絡由解碼器和上下文信息聚合網絡組成.在光流計算過程中,首先將連續兩幀圖像輸入多尺度變形卷積特征提取網絡進行圖像特征提取,然后將獲取的圖像特征輸入下采樣因子為0.5 的編碼器進行更加細化的特征提取.最后,從最小分辨率特征圖所在的金字塔頂層計算相關度,并將相關度輸入解碼器計算光流.

圖4 基于多尺度變形卷積的特征金字塔光流計算網絡模型Fig.4 Feature pyramid optical flow computing network model based on multi-scale deformed convolution

在金字塔的每一層,本文首先計算第一幀圖像特征圖與第二幀經上一層光流變形后的特征圖的相關度,然后通過光流解碼器計算該層的光流,并使用上下文網絡進行優化.該層光流經過上采樣后作為初始光流送入金字塔下一層,進行下一層的光流計算.經過對應特征金字塔層數的迭代后,模型將輸出原分辨率1/4 大小的光流計算結果,最后通過插值上采樣運算,將光流計算結果恢復為輸入圖像的原始分辨率.

在實際計算過程中,本文只在分辨率最大的底部兩層使用了多尺度變形卷積特征提取網絡.這是因為變形卷積改變感受野是通過偏置因數來實現的,偏置因數對運動目標的輪廓較為敏感,而下采樣操作會丟失圖像中大量的空間信息,使得運動目標輪廓會變得模糊,甚至丟失.圖5 展示了不同層數多尺度變形卷積對光流計算在運動邊緣的影響.圖中標簽區域為邊緣輪廓區域與其對應放大圖.從圖中可以看出,使用4 層多尺度變形卷積模型與使用2 層多尺度變形卷積模型相比,其光流計算結果在標簽區域中的手部存在明顯的模糊與邊緣擴張,手指邊緣輪廓計算效果明顯低于使用2 層多尺度變形卷積模型的光流計算效果.因此,本文只在分辨率最大的底部兩層使用,以發揮多尺度變形卷積特征提取的能力,提高運動邊緣處光流計算精度.

圖5 不同層數多尺度變形卷積模型光流計算結果對比Fig.5 Comparison of optical flow calculation results of multi-scale deformed convolution models with different layers

2 混合損失函數

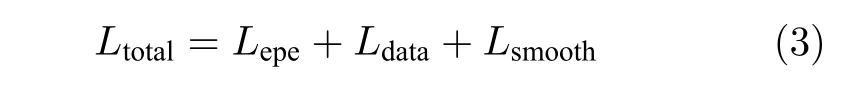

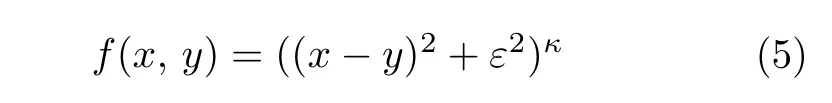

現階段,大部分深度學習光流計算網絡模型的損失函數由端點誤差函數構成.由于端點誤差損失函數更關注光流計算的整體效果,難以對運動邊緣區域進行引導訓練,導致光流計算結果易產生邊緣模糊現象.為了約束運動邊緣處光流計算,本文設計了一種結合圖像與運動邊緣約束的混合損失函數,該損失函數由端點誤差損失、數據項損失以及根據圖像與運動邊緣控制光流擴散方式的正則化項共同組成.計算公式如下

式 (3) 中,Lepe代表端點誤差,Ldata代表數據項損失,Lsmooth代表正則化項 (平滑項).端點誤差的計算公式如下

式 (4) 中,Flowout(x,y)和Flowgt(x,y) 分別代表光流計算值和真實值在像素點坐標 (x,y)T處的值,|·|2代表L2范數運算.f(x,y) 是一種廣義的魯棒 Charbonnier 懲罰函數,主要作用是懲罰異常值,計算公式如下

為了使懲罰函數能夠發揮最佳性能,本文依據文獻[22]的參數設置方法,將參數ε和κ分別設置為ε=0.001,κ=0.4.

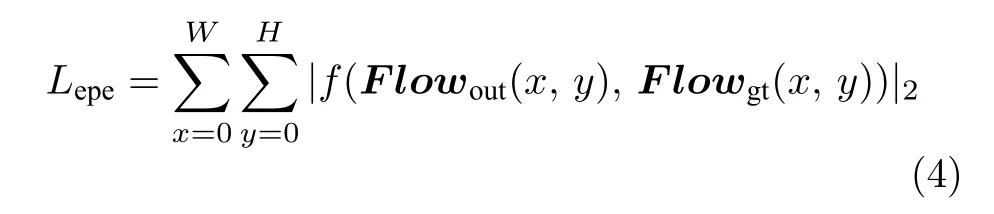

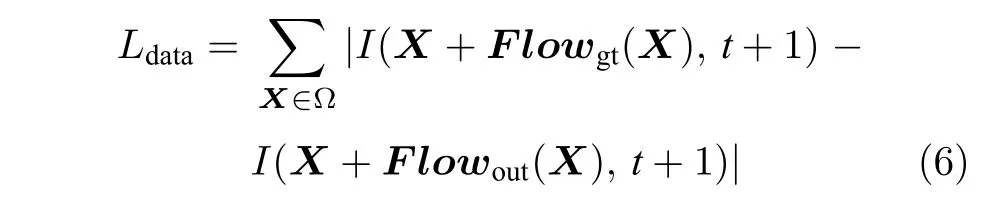

數據項損失計算公式如下

式 (6) 中,X=(x,y)T表示在圖像區域 Ω 中的像素點坐標,I(X+F lowgt(X),t+1) 代表使用真實光流值變形的第二幀圖像在像素點X處的亮度值.I(X+F lowout(X),t+1)代表使用計算光流值變形的第二幀圖像在像素點X處的亮度值.真實光流與計算光流變形第二幀圖像時,通常會在錯誤的光流計算區域出現較大差別,因而使用數據損失的目的是對錯誤的大位移運動區域進行二次監督,以提高模型的光流計算精度.

正則化項計算公式如下

式 (7) 中,?d表示在d方向上進行求導,α是控制光流平滑的邊緣系數,I(t) 是第一幀圖像的亮度值.正則化項通過控制光流的擴散形式保護運動邊緣,當運動邊緣處的圖像導數較大時使 e-α|?dI(t)|變小,以減少光流擴散,從而保護運動邊緣.當運動邊緣處的圖像導數較小時使 e-α|?dI(t)|變大,以增加光流擴散程度,保護背景光流.通過將該正則化項與端點誤差損失、數據項損失聯合指導光流計算模型訓練,使模型學習到更加精準的邊緣信息.

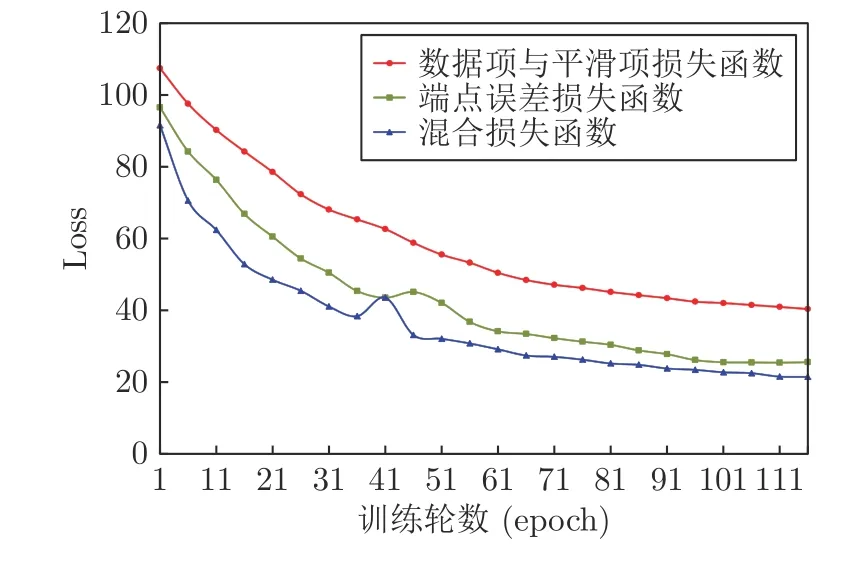

圖6 展示了使用不同損失函數對模型訓練的影響.從圖中可以看出,使用數據項與平滑項作為損失函數訓練模型,可以引導模型收斂但模型收斂速度較慢,收斂效果不佳.其原因在于數據項與平滑項組成的損失函數參考了變分光流能量泛函的設計,其在最小化過程中需要一定的迭代計算且易陷入局部最優,因而收斂速度較慢,收斂效果也相對較差.使用端點誤差損失函數訓練模型,模型收斂速度和收斂效果優于數據項與平滑項損失函數.其原因是端點誤差損失本質上就是求解計算值與真實值之間的最小誤差,其計算過程簡單、耗時較少且又有真實值作為參考,所以收斂效果優于前者.使用本文所提的混合損失函數訓練模型,模型整體不僅收斂速度較快,而且收斂效果也明顯優于前兩種損失函數.因此,通過將端點誤差損失、數據項損失與平滑項損失結合,既可以加快模型收斂速度又可以提高模型訓練效果.

圖6 不同損失函數訓練模型Fig.6 Training models with different loss functions

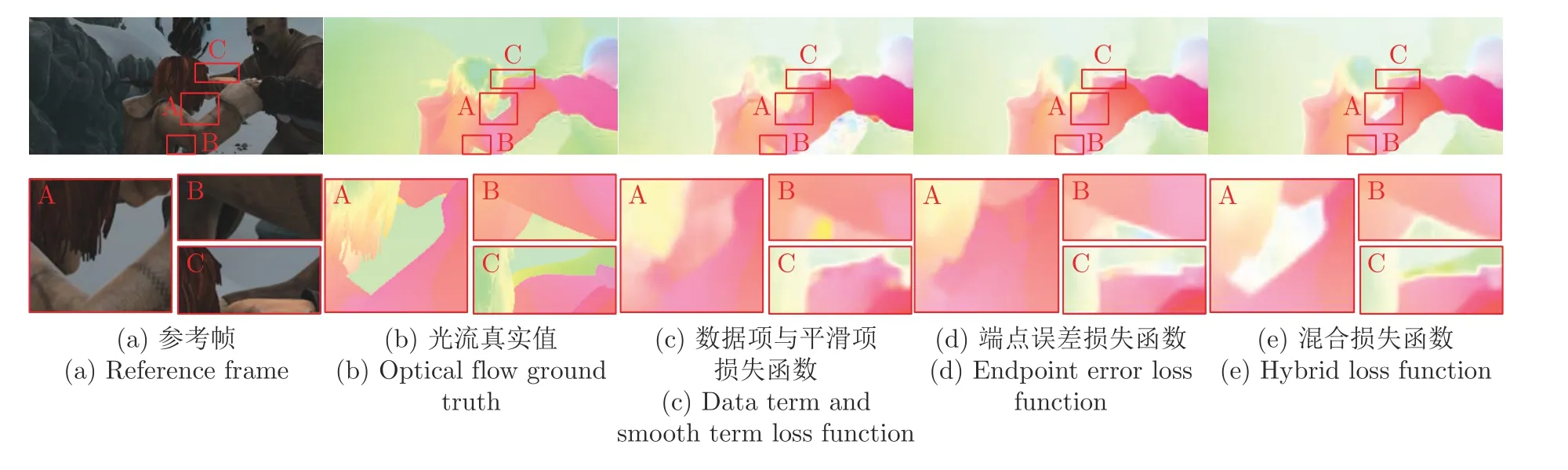

為了展示混合損失函數不同組成部分對邊緣區域的保護效果,圖7 展示了不同損失函數訓練模型后的光流計算結果可視化對比.其中,圖中第二行為第一行圖像標簽區域的局部放大圖.從圖中可以看出,使用數據項與平滑項損失函數訓練后的模型光流計算結果可以計算出目標的完整輪廓與邊緣,但結果中包含較多異常值且存在明顯的模糊現象.使用端點誤差損失函數訓練后的模型光流計算精度相對較高,但仍然存在較為明顯的邊緣模糊,例如圖7(d) 中的A 區域.而使用混合損失函數訓練后的模型光流計算結果達到了最佳的光流估計效果,特別在標簽區域的邊緣,既消除了異常值又實現了高精度的邊緣保護.說明將端點誤差損失、數據項損失與平滑項損失結合用于模型訓練,不僅可以加快模型收斂速度,還可以學習到更多邊緣信息.

圖7 不同損失函數訓練模型后的光流計算結果可視化對比Fig.7 Visual comparison of optical flow calculation results after training models with different loss functions

3 實驗與分析

3.1 評價指標

實驗采用當前光流計算技術研究領域內具有權威性的 MPI-Sintel[23]與 KITTI2015[24]測試圖像數據集進行算法性能測試.分別采用端點誤差和異常值百分比兩種量化評價指標對本文方法光流計算的準確性和魯棒性進行量化評價.其中,端點誤差是光流計算領域評價光流精度最常用的一種指標,表示的含義是計算光流與真實光流的幾何距離誤差.其計算公式如下

上式中,N是整張圖像中總的像素點數量,ugt是水平方向上的真實光流值,uout是水平方向上的計算光流值,vgt是垂直方向上的真實光流值,vout是垂直方向上的計算光流值.

異常值百分比指標常用于 KITTI2015 測試圖像數據集的光流計算結果評價,計算公式如下

式中,N是整張圖像中總的像素點數量,Fl表示光流異常值百分比,P(EPE >τ) 表示光流端點誤差大于τ的像素點,其中τ=3.

3.2 對比方法

為了驗證本文方法光流計算精度和邊緣保護效果,分別選取具有代表性的 FlowNet 2.0[15]、PWCNet[16]、IRR-PWC_RVC[19]、FastFlowNet[25]、Lite-FlowNet[26]、FlowNet3[27]、Semantic_Lattice[28]、OAS-Net[29]、LSM_RVC[30]以及 FDFlowNet[31]等深度學習光流計算方法進行綜合對比分析.其中,FlowNet 2.0 通過堆疊多個 FlowNet 結構提高網絡深度,成為首個超越傳統變分光流計算精度的深度學習光流計算方法.PWC-Net 通過將特征金字塔、變形操作以及成本體積代價集成于統一框架,在簡化網絡結構減少訓練參數的同時顯著提升了光流計算精度.IRR-PWC_RVC 是首個采用遮擋真實值計算遮擋掩膜來提高遮擋區域光流計算精度的方法.FastFlowNet 采用新的增強池化金字塔特征提取器增強高分辨率金字塔特征,并引入中心密集擴張相關層構建緊湊的代價量,在保持精度的同時極大地提升了光流計算速度.LiteFlowNet 通過使用短程匹配產生一個光流場對原始光流場進行優化,提高了大位移運動區域的光流計算精度.FlowNet3 將遮擋、光流和視差進行聯合學習,提出了一種有效的可學習的遮擋區域計算方法,不僅大幅提高光流計算精度也有效保護了運動邊緣.Semantic_Lattice 定義了一種廣義的卷積方式,并將這種廣義的卷積方式應用到解碼器中減少邊緣偽影,保護光流的運動邊緣.OAS-Net 提出了一個新的遮擋感知采樣模塊,抑制噪聲對遮擋區域的影響,從而提高遮擋區域的光流計算精度,以實現光流運動邊緣保護.LSM_RVC 提出了學習子空間最小化框架,利用卷積神經網絡生成一個子空間約束取代正則化項,增強了網絡模型的泛化能力.FDFlowNet 使用 U 形網絡融合特征代替原有的金字塔特征,并提出一種新的局部全連接結構,平衡了模型的尺寸、計算成本和網絡性能,顯著提升了光流計算精度與速度.

3.3 MPI-Sintel 測試圖像數據集實驗

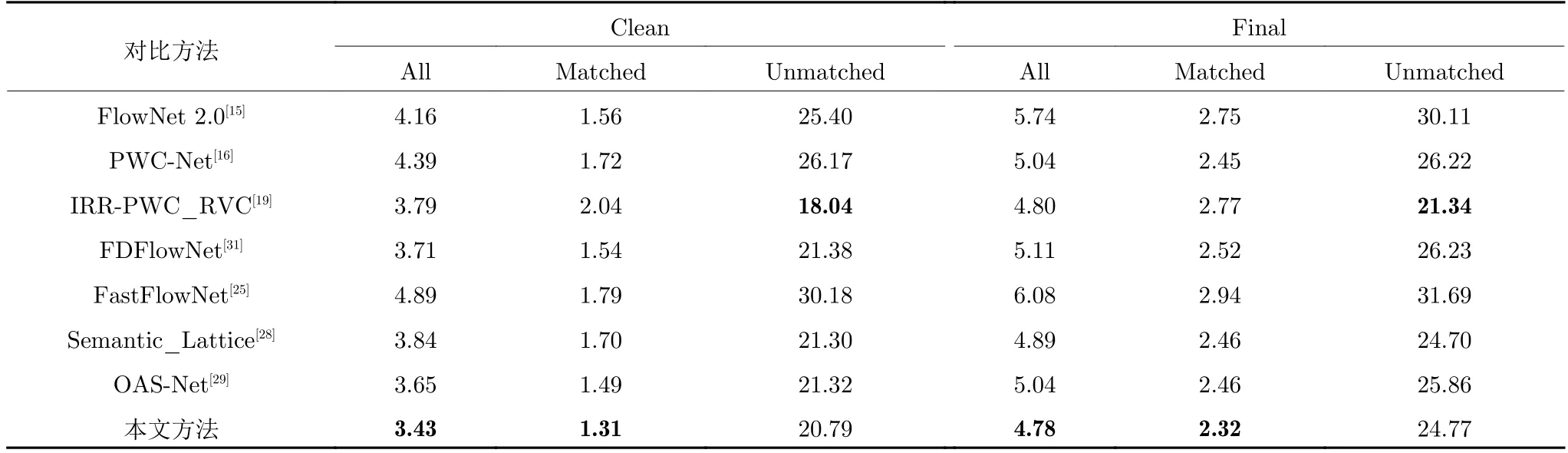

MPI-Sintel[22]測試圖像數據集是一種開源的合成光流數據集,包含了大位移、運動遮擋以及非剛性大形變等困難場景.該測試集分為 Clean和 Final兩個數據集,其中 Final 數據集相對 Clean 數據集包含了大量的運動模糊、光照變化以及大氣效果等挑戰性元素,光流計算難度較大.表1 展示了本文方法與對比方法針對 MPI-Sintel 測試圖像數據集的光流計算結果.其中,All 代表所有像素點的平均端點誤差,Matched 代表圖像序列中非遮擋像素點的端點誤差,Unmatched 代表圖像序列中遮擋像素點的端點誤差.

從表1 可以看出,本文方法在 Clean和 Final子數據集的 All和 Matched 指標上均取得了最優表現,IRR-PWC_RVC 在 Unmatched 指標取得最佳的光流計算精度.OAS-Net 方法在 Clean 數據集的光流估計精度除低于本文方法外,整體性能優于其他對比方法,這源于該模型的遮擋感知采樣模塊既抑制了噪聲又提高了遮擋區域的光流估計精度.在 Final 數據集上,IRR-PWC_RVC 方法的光流計算精度與本文方法接近,主要原因是 IRRPWC_RVC 方法在圖像特征提取骨干網絡中引入遮擋檢測模塊,通過在特征提取的過程中加入遮擋信息以補償運動遮擋產生的信息丟失,進而提高圖像特征提取精度.此外,該方法在端點誤差損失函數的基礎上設計了一種包含遮擋損失項的復合損失函數,使得遮擋信息能夠引導模型得到充分訓練.本文方法通過構建多尺度變形卷積圖像特征提取模型,并設計包含邊緣結構信息的混合損失函數,使得光流估計模型的特征提取精度與邊緣保護效果得到有效改善.二者的相同點在于都遵循了相似的網絡模型設計思路,通過提高圖像特征提取精度和利用率的方式實現高精度光流估計.區別在于本文方法側重于光流邊緣結構的保護,而 IRR-PWC_RVC方法關注于遮擋區域光流信息的獲取.因此,雖然本文方法與 IRR-PWC_RVC 方法的光流估計精度相近,但兩種方法提高光流估計性能的具體方式和側重點具有很大區別.

表1 MPI-Sintel 數據集圖像序列光流計算結果Table 1 Optical flow calculation results of image sequences in MPI-Sintel dataset

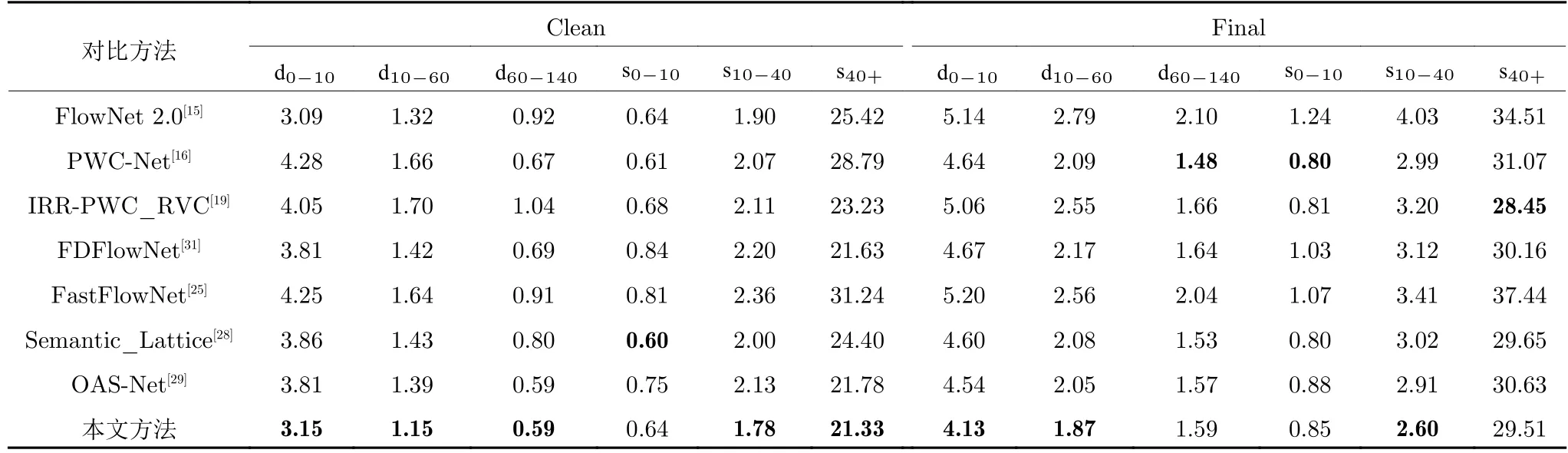

上述指標從宏觀角度對比了各方法光流計算性能,為了更加細化地對各方法光流計算效果進行對比分析,本文使用 MPI-Sintel 測試圖像數據集提供的 d0-10,d10-60,d60-140以及 s0-10,s10-40,s40+指標進行量化對比分析.其中,d0-10,d10-60,d60-140代表距離運動邊緣不同距離像素點的端點誤差,s0-10,s10-40,s40+代表不同位移速度像素點的端點誤差.實驗結果如表2 所示,從表2 可以看出,針對 Clean 子數據集,本文方法在 d0-10,d10-60,d60-140等衡量運動邊緣光流計算效果的指標上取得了最佳的光流計算精度.在挑戰性較大的 Final數據集,本文方法在 d0-10,d10-60,d60-140指標上的整體性能仍然優于其他對比算法.說明本文方法在運動邊緣區域具有較高的光流計算精度與魯棒性.此外,在 Clean 數據集的 s10-40,s40+指標和Final 數據集的 s10-40指標也顯著優于對比方法,說明本文方法針對大位移運動場景也具有較高的光流計算精度.但在 s0-10指標上,本文方法未取得最優的光流計算精度,這說明在小位移運動光流計算方面,本文方法仍然存在一定限制.此外,在具有挑戰性的 Final 數據集,本文方法在 d60-140和 s40+指標存在一定性能下降,產生該現象的原因可能是圖像序列中的運動模糊效果導致本文方法難以捕捉更加精準的像素運動信息.

表2 MPI-Sintel 數據集運動邊緣與大位移指標對比結果Table 2 Comparison results of motion edge and large displacement index in MPI-Sintel dataset

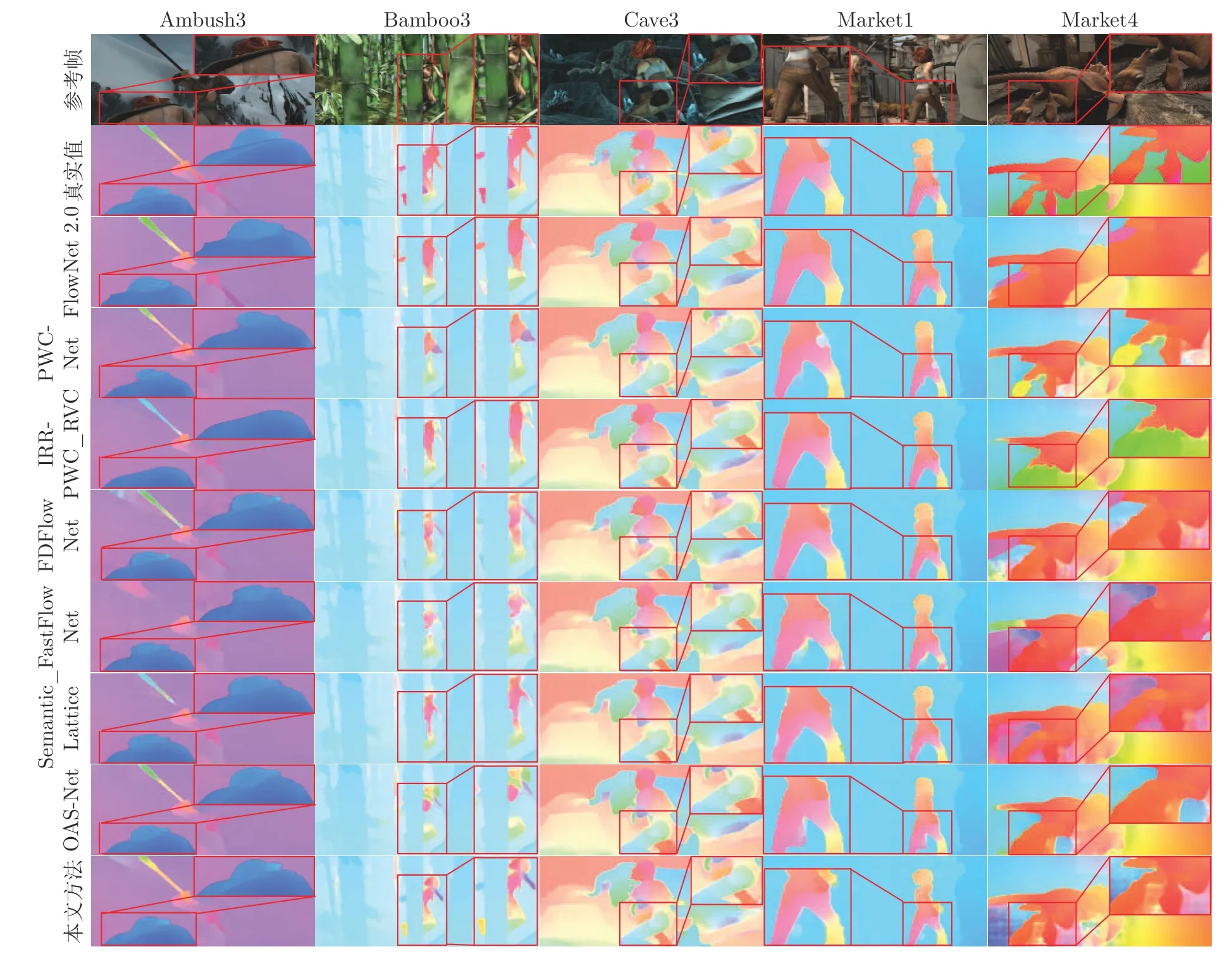

為進一步定性對比分析本文方法光流計算效果,本文分別選取如圖8 所示的圖像序列進行光流結果可視化展示.其中方框區域為典型的運動邊緣區域,并且為了便于觀察對比,本文對該區域進行局部放大.從圖中可以看出,FlowNet 2.0 光流計算結果在運動邊緣區域呈現過度平滑,這是因為FlowNet 2.0 堆疊了多個包含大量標準卷積操作的FlowNet 結構所致;PWC-Net 光流計算結果存在明顯邊緣擴張;OSA-Net 光流計算精度較高,但在Bamboo3 人物身體和 Market4 龍的尾部區域光流計算存在明顯的錯誤估計;IRR-PWC_RVC 方法在標簽區域存在明顯信息丟失.與各對比方法相比,本文方法光流計算精度最優,特別在 Ambush3 標簽區域、Bamboo3 人物的身體區域、Cave3 龍角處、Market1 人腿部區域和 Market4 龍的尾部區域,本文方法不僅更加準確地計算出上述區域光流信息,而且還有效緩解了運動邊緣模糊問題.

圖8 MPI-Sintel 數據集光流結果可視化對比圖Fig.8 Visualization comparison of optical flow results in MPI-Sintel dataset

3.4 KITTI2015 測試圖像數據集實驗

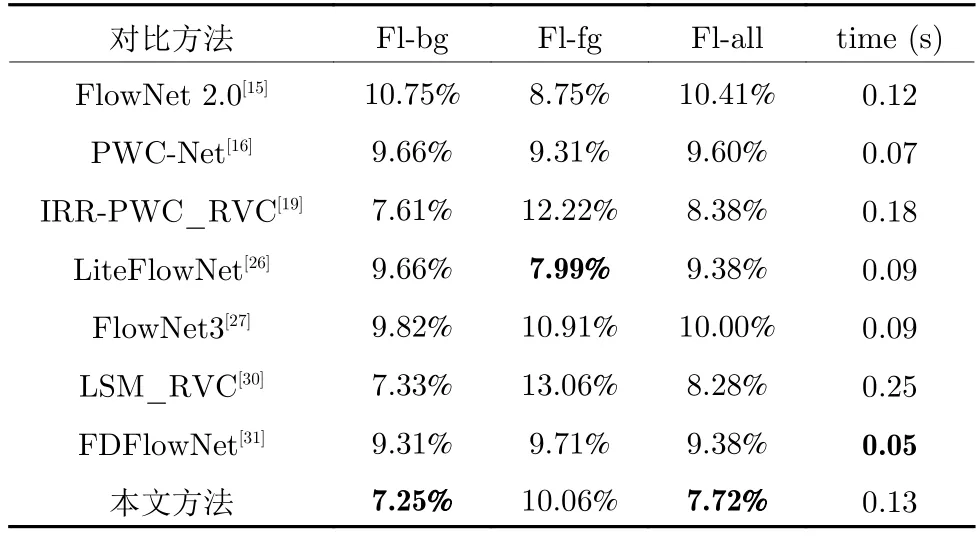

KITTI2015[23]測試圖像數據集是包含大量真實道路場景的數據集,其主要用于測試算法針對真實場景任務時光流計算的準確性與魯棒性.因此,對算法的性能要求較高,挑戰性更大.表3 展示了本文方法與對比方法針對 KITTI2015 數據集圖像序列光流計算異常值百分比結果對比.表中 Fl-bg代表圖像中背景光流異常值百分比,Fl-fg 代表圖像中前景光流異常值百分比,Fl-all 代表圖像中平均光流異常值百分比.從表3 可以看出,FlowNet 2.0光流計算精度最低,說明僅通過堆疊網絡提高模型深度方式,難以應對真實復雜場景光流計算的需求.LSM_RVC 光流計算精度與本方法較為接近,但在Fl-fg 指標誤差明顯高于本文方法.相對于其他方法,本文方法整體光流計算精度較高,僅 Fl-fg 指標略低于對比方法,產生該現象的原因是真實場景包含較為強烈的光照變化與陰影等情況,使得運動目標輪廓信息發生一定變化,致使本文方法所使用的變形卷積在擬合目標形態時產生一定的偏差.為了驗證本文方法針對真實場景圖像序列光流計算在運動邊緣區域的保護效果,選取 KITTI2015 數據集中具有代表性的4 幀連續圖像序列對本文方法和對比方法進行綜合對比.

表3 KITTI2015 數據集計算結果Table 3 Calculation results in KITTI2015 dataset

圖9 展示了本文方法與各對比方法針對測試圖像序列的光流計算誤差可視化對比,標簽區域為運動邊緣區域.為了更好地觀察圖中各對比方法在運動邊緣區域光流計算效果,本文對標簽區域進行了局部放大.從圖中可以看出,在光照不足且邊緣輪廓信息缺乏的 KITTI15_000000 序列,本文方法取得了最佳的光流計算效果,在汽車邊緣輪廓區域異常值面積占比最小.在 KITTI15_000005 序列,本文方法在左側汽車頂部區域光流計算效果較好,FlowNet3 在右側白色背景區域取得了最佳的光流計算效果,說明本文方法針對缺乏紋理信息的場景光流計算存在一定限制.在包含大位移運動的KITTI15_000006和 KITTI15_000014 序列,本文方法取得了最佳的光流計算精度,特別在汽車邊緣輪廓區域包含了較少的異常值.說明在真實場景光流計算中,本文方法仍然能夠表現出較高的光流計算準確性,且對運動邊緣具有較好的保護效果.

圖9 KITTI2015 數據集光流誤差結果對比圖Fig.9 Comparison of optical flow error results in KITTI2015 dataset

表3 列出了本文方法與對比方法在 KITTI2015數據集的平均光流計算時間.從表3 中可以看出,FDFlowNet 方法的計算效率最高,本文方法提出的多尺度變形卷積特征提取網絡由于使用了較多變形卷積操作,因此時間消耗相對較長.在基于深度學習的光流計算中,隨著網絡復雜度和參數量的增加,光流估計模型往往犧牲計算效率換取光流計算精度的提高,而本文方法在不大幅增加時間消耗的基礎上顯著提升了光流計算精度,綜合性能較優.

3.5 消融實驗

為了進一步分析本文提出的多尺度變形卷積特征提取網絡模型和混合損失函數對光流計算性能提升的作用,本文采用消融實驗進行綜合對比分析.實驗采用 MPI-Sintel 數據集中的 Clean 子數據集對各消融實驗模型進行測試對比分析,各消融實驗模型實驗數據結果如表4 所示.其中,baseline 為基準模型,baseline_loss 為基準模型加混合損失函數模型,baseline_md 為基準模型加多尺度變形卷積特征提取網絡模型,full model 是基準模型加上混合損失函數和多尺度變形卷積特征提取網絡模型.從表4 可以看出,相比于單獨去除多尺度變形卷積特征提取網絡的 baseline_loss 模型和單獨去除邊緣損失函數的 baseline_md 模型,全模型在Clean 數據集的所有指標上取得了最好的光流計算效果.并且從 d0-10,d10-60,d60-140運動邊緣指標可以看出,通過分別增加多尺度變形卷積特征提取網絡和混合損失函數,可以有效提升光流運動邊緣計算精度.當多尺度變形卷積特征提取網絡與混合損失函數共同作用時,可以顯著提高網絡光流計算精度,二者的協同作用進一步提升了 d60-140指標精度.這進一步說明,本文所提方法各模塊可以有效提高網絡的光流計算精度,保護運動邊緣.此外,從baseline_loss 模型數據可以看出,在全模型之外,該模型得到了最高的光流計算精度.反映出本文提出的混合損失函數對模型光流計算精度的提升具有明顯的積極作用.

表4 MPI-Sintel 數據集上消融實驗結果對比Table 4 Comparison of ablation experiment results in MPI-Sintel dataset

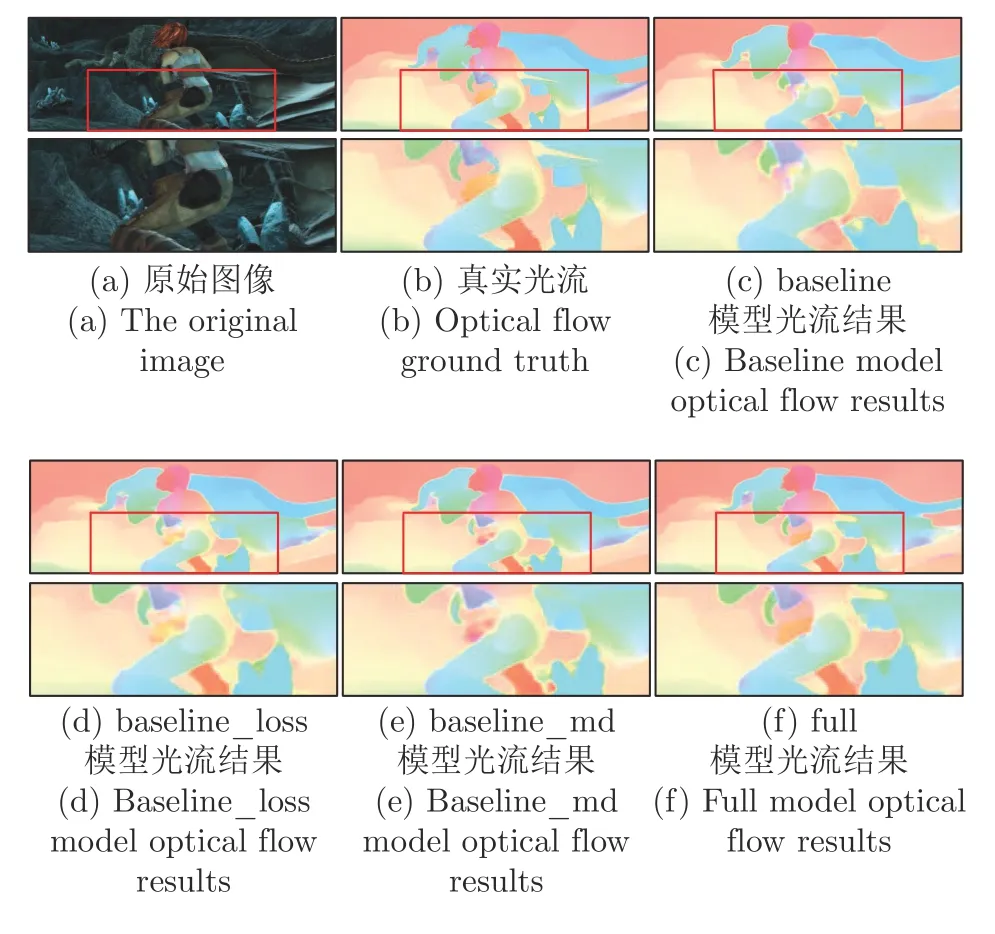

同樣,為了更直觀地展示各模塊的工作性能,同時,定性分析本文提出的模型各組成模塊對光流計算運動邊緣的保護效果.本文將消融實驗中各模型針對 Cave3 序列光流計算結果進行可視化對比,結果如圖10 所示.其中,圖10 中標簽區域為圖像序列場景中對應的圖像與運動邊緣區域.從圖10中可以看出,本文方法所提各模塊在去除異常值方面均具有較好的效果,相對于 baseline 模型較為準確地計算出人腿部附近區域的光流信息.同時,本文提出的各模塊對于圖像與運動邊緣區域光流計算精度均具有明顯提升.例如,圖中龍角與人物腿部的中間區域圖像邊緣模糊現象得到有效抑制,并且光流估計結果邊緣結構更加清晰.這也從側面說明本文提出的多尺度變形卷積特征提取網絡可以捕獲更加準確的圖像特征信息,所提出的混合損失函數能夠更好地約束運動邊緣區域的光流計算.

圖10 各消融模型光流計算結果可視化對比圖,第2、4 行為標簽區域放大圖Fig.10 Visual comparison of optical flow calculation results for each ablation model,the second and fourth rows are enlarged images of the label area

4 結論

本文通過構建多尺度變形卷積特征提取網絡并將其與特征金字塔光流估計網絡模型耦合,提出了一種基于多尺度變形卷積的圖像序列光流計算方法.該方法首先通過多尺度變形卷積特征提取網絡獲取準確的圖像特征信息.然后,設計了一種新的混合損失函數,將圖像與運動邊緣約束正則化項、數據項損失和端點誤差結合,用以指導網絡模型學習更加精準的圖像與運動邊緣信息,使損失函數可以更好地約束圖像與運動邊緣區域光流計算.通過大量實驗對比分析,表明本文方法具有較高的光流計算精度,特別在運動邊緣區域具有較好的保護效果.