SECU-Net:一種結合SE 和CRF 的皮膚病圖像分割網絡

陳旋,蔡宇佳,冉文兵,張利

(貴州大學 大數據與信息工程學院,貴陽 550025)

0 引言

皮膚癌是常見的致命癌癥類型之一,約占癌癥病例的三分之一,其早期診斷尤其重要。皮膚鏡是檢查皮膚病變最重要的技術之一,可以捕獲皮膚的高分辨率圖像。然而,即使在有經驗的皮膚科醫生中,僅用人類視覺檢測黑素瘤可能是主觀和不準確的。尤其是皮膚病變的大小、形狀和顏色變化很大,毛發的存在會部分覆蓋病變,破壞局部環境,一些病變與正常皮膚的對比相對較低,導致模糊邊界,使開發計算機輔助診斷(Computer Aided Diagnosis,CAD)系統獲得準確和突出的組織級分割極具挑戰性。

卷積神經網絡作為計算機視覺領域的主要技術,已經成功地應用于醫學圖像分類[1-2]、分割[3-4]和檢測任務[5-6]中。自2015 年提出FCN[7]后,吸引了大量的研究者進入語義分割鄰域。其中,UNet[8]就是在FCN 的基礎上最獲成功的改進語義分割模型之一,目前已成為醫學圖像分割領域應用最為廣泛的模型,以U-Net 為骨干網絡的變體[9-10]在各種醫學圖像分割任務中取得了一系列可觀成果。例如,UNet++[10]通過重新設計跳過連接以利用圖像分割中的多尺度,由此來實現不同語義尺度的特征融合,并對固定深度的U-Net 網絡進行改進。Alom 等人[11]提出的基于U-Net 網絡和遞歸殘差卷積神經網絡的模型,通過短跳躍連接來加強特征融合。Jha 等人[12]使用ResNet 和DeepLabv3+作 為UNet 的主干網絡來完成息肉分割任務。Oktay 等人[13]提出的Attention Unet 模型,使用門控注意力來過濾掉特征圖中不相關的反應。Isensee 等人[14]提出nnU-Net 實現自適應醫學圖像語義分割。Res-UNet[15]模型將殘差模塊與U-Net 相結合來實現特征融合,完成了視網膜分割任務。但目前技術均偏向于基于紋理、而不是結構邊界來提取特征,這就限制了CNN 獲取目標區域形狀信息的能力,使得當前的技術不能很好地進行皮膚病灶分割。

針對上述算法存在的一些局限性,本文基于UNet 網絡框架,提出一種融合擠壓和激勵機制并用CRF 來做分割后處理的算法。通過融合SE 模塊自適應地為特征重新分配權重,關注重要特征、同時抑制無關特征,并利用CRF 來保持目標區域的結構邊界,實現邊界精確定位。

本文的主要貢獻如下:

(1)提出了一種結合擠壓激勵機制和條件隨機場的皮膚病圖像分割模型SECU-Net,將概率圖形模型與深度學習模型結合.

(2)擠壓和激勵機制(SE)[16]使得模型能夠自適應地重新校準通道特征,突出重要特征。同時CRF[17]能細化分割。

(3)在具有挑戰性的ISIC2017 數據集上驗證了所提出模型的有效性。

1 相關工作

分割是醫學圖像分析中識別和定位疾病、監測形態變化、提取鑒別特征以便進一步診斷的關鍵。皮膚癌的早期診斷對徹底清除體內惡性腫瘤至關重要。其中,基于人工智能的分割方法因其良好的準確性、魯棒性和可靠性而被廣泛探索和采用。在過去的幾年里進行了大量的研究。例如,Nasr -Esfahani 等人[18]提出了一種新的密集全卷積網絡(DFCN),利用新的密集池層對病變區域進行分割。Mirikharaji 等人[19]提出了從噪聲中分割皮膚病變的方法,通過空間自適應的重加權方法,在損失函數中運算處理干凈的和噪聲的像素級注釋,提高深度網絡對噪聲標注的魯棒性。Wang 等人[20]提出了一種新的邊界感知轉換器(BAT),通過邊界注意門(BAG)提供大量的空間信息來捕獲更多的局部細節。Basak 等人[21]提出了一種新的皮膚病變分割框架,稱為多焦點分割網絡(MFSNet),通過聚焦于多個尺度的圖像信息產生最終的分割掩碼。MFSNet采用Res2Net 骨干,用于獲取深度特征,以獲得分割掩碼的全局特征圖。盡管上述基于CNN 的方法取得了成功,然而,由于分割皮膚病變在大小、形狀、質地、位置和邊界方面存在巨大差異,使得此類分割任務是頗具挑戰性的。

概率圖形模型結合CNN 已經成為語義分割鄰域的基線模型。作為模型的有效組件,CRF 在解決定位問題、產生準確的語義分割結果和恢復對象邊界方面有著明顯優勢。Rother 等人[22]使用CRF 來平滑噪聲分割圖。Chen 等人[23]使用雙線性插值將特征映射放大到原始圖像分辨率,此后應用一個完全連接的CRF 來細化分割結果,更好地捕獲對象邊界。Kamnitsas 等人[24]結合全聯CRF 提出了一種高效的卷積神經網絡,在腦部分割病變中實現更結構化的預測。Kr?henbühl 等人[25]提出一個全連通CRF模型的近似推理算法,其中成對邊緣勢由高斯核的線性組合來進行定義。Szummer 等人[26]使用圖切割來學習CRF 的最大間隔學習方法,包括結構化輸出支持向量機、近似邊際推理和基于梯度的優化方法來學習CRF 中的參數。雖然CRF 與神經網絡結合已成為圖像語義分割領域較為成功的范例,然而,CRF 還沒有得到在醫學圖像分割應用上的驗證。

受以上研究啟發,本文提出一種能夠自適應為特征分配權重和細化分割結果的網絡模型。主干網絡采用U-Net 模型,來進行特征提取。然后利用SE模塊來重新校準通道特征。最后利用CRF 模塊來細化分割。

2 方法理論

整體網絡結構主要由CNN 和CRF 兩部分組成。模型框架設計如圖1 所示。這里擬展開研究論述如下。

圖1 SECU-Net 模型概述圖Fig.1 Overview of the SECU-Net model

2.1 主干網絡

模型采用U-Net 作為骨干網絡。U-Net 網絡是全卷積神經網絡結構,初始卷積組中有64 個濾波器,卷積濾波器大小為3×3,平均池化濾波器大小為2×2,通過收縮網絡和擴張網絡構成一個U 型結構,對輸入樣本進行特征提取。該結構可以使得模型能依賴較少的訓練樣本獲得較好的分割準確度。通過沿著擴展路徑使用一系列上采樣層來生成與原始圖像相同分辨率的分割圖,U-Net 沿著擴展路徑重復地將不同層次的特征通道串聯起來,并在擴展路徑的最后一階段基于大量的特征通道生成最終的分割圖。同時,長跳躍連接可使得解碼端能利用淺層特征圖,豐富了特征信息。

2.2 擠壓和激勵機制

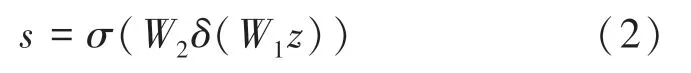

SE 模塊是一個計算單元,將卷積運算的輸出結果進行處理,重新為不同的特征自適應地匹配權重,如圖2 所示。

圖2 SE 模塊Fig.2 SE module

SE 可以建立輸入X∈映射到特征U∈RH×W×C的變換上,將該變換定義為Ftr:X→U,Ftr是一卷積操作。通過全局平均池化的方式將全局空間信息擠壓到一個通道。壓縮后的特征向量z∈RC,對于z中的第c個元素zc,計算方式如下:

接下來通過2 個非線性完全連接層將uc重新校準。參數化表示如下:

其中,δ表示ReLU函數;W1∈;W2∈。最后得到重新的輸出為:

SE 模塊通過全局平均匯集來排除空間依賴性,從而通過顯式建模通道之間的相互依賴性,學習信道特定描述符來重新校準通道,提高對相關特征的靈敏度,自適應地重新校準通道特性響應。

2.3 CRF 實現相鄰像素建模

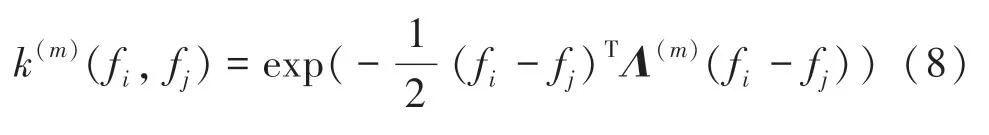

CRF 是一種判別類圖形模型,適用于空間信息或相鄰狀態影響當前預測的任務。在本節中,將簡要描述CRF 的公式,具體描述以及符號表達遵循文獻[17]。在圖像分割任務中,所有像素被分為多個不同的類{1,...,C},其中C是類的數量。每張圖像I(在本文中,I是皮膚鏡圖像)中所有像素的取值χi構成一組隨機變量χ={χ1,...,χN},N是圖像中像素的數量。模型訓練時,χi被轉換成長度為C的分類向量,χi滿足全局馬爾可夫性。由先驗吉布斯分布表征的全連接成對CRF 模型P(X,I):

其中,ζ=(V,Ε)是描述隨機場X的無向圖,φ是每個團的勢函數。通過最大后驗概率(MAP)估計X,其最小化相應的吉布斯能量E(X=x |I):

其中,i和j的范圍從1到N。式(5)的第一項是一元勢函數,由分類器為每個像素獨立計算,該分類器在給定圖像特征的標簽分配上產生分布。式(5)的第二項是二元勢函數,表示為:

其中,μ(χi,χj)是描述不同類別對之間交互影響的標簽兼容性函數;ω(m)是不同k(m)的線性組合權重,并且是標簽兼容性函數;K是核的總數。每個k(m)是具有特定特征向量f的修正高斯核:

其中,fi和fj是任意特征空間中像素i和j的特征向量。每個核k(m)由對稱的正定精度矩陣Λ(m)來表征,該矩陣定義了相應的形狀。在語義分割中,通常使用強度(I)和位置特征(p)的組合:

其中,外觀核由ω1控制,平滑核由ω2控制。參數θα、θβ和θγ控制相應特征空間的影響。通過來自CNN 特征圖的新特征向量來更新隨機場X。

3 實驗與分析

3.1 數據集與實驗細節

本文采用ISIC2017皮膚病數據集[27]。ISIC2017 是Kaggle 競賽公開的數據集,是皮膚癌診斷領域最知名的數據集之一,該數據集包括2 000張圖像和帶注釋的掩模。每個樣本的原始尺寸為576×767 像素。以7∶2∶1 的比例將所有數據集隨機劃分為訓練集、測試集和驗證集。數據樣本如圖3 所示。圖3(a)~圖3(e)皆為數據集樣本示例。圖3(a)~圖3(e)中,第一張為原始圖像,第二張為對應的真實值。可以看出,皮膚病病灶具有面積和顏色變化大、結構邊界不清晰以及毛發覆蓋等特點,為分割帶來巨大挑戰。

圖3 數據樣本Fig.3 Data samples

本次實驗基于Ubuntu18.04 系統,使用NVIDIA GTX 2080Ti GPU 在公共Pytorch 框架上實現本文設計提出的網絡,實驗將所有數據集的圖像大小統一調整為512×512。圖像中的所有像素值都歸一化為0~1。對于數據擴充,通過將所有的數據進行水平翻轉、垂直翻轉以及混合水平與垂直翻轉的方式,各種圖像變換可以緩解過度擬合問題。通過結合廣泛的圖像采集條件,提高了模型的魯棒性,對網絡進行訓練時,批次大小設置為4,初始學習率設置為10-6,使用ReLU激活函數。

3.2 評價指標

為了綜合評估本文提出方法的性能,采用5 個常見的語義分割度量評價指標,包括:準確性(Accuracy,AC)、敏感性(Sensitivity,SE)、特異性(Specificity,SP)、F1-Score、精 確率(Precision,PC)以及Jaccard相似性(JS)。下面將給出闡釋解析如下。

(1)準確性(AC)。顯示正確預測的百分比,該值可由如下公式計算求出:

其中,TP(True -Positive)表示真陽性,即診斷為陽性的陽性病例;TN(True -Negative)表示真陰性,即診斷為陰性的陰性病例;FP(False -Positive)表示假陽性,即診斷為陽性的陰性病例;FN(False -Negative)表示假陰性,即診斷為不利的陽性病例。

(2)特異性(SP)。衡量模型正確識別的FP的比例,該值可由如下公式計算求出:

其中,式(11)中各項的數學含義同式(10)。

(3)敏感性(SE)。衡量模型正確識別的預測TP的比例,該值可由如下公式計算求出:

其中,式(12)中各項的數學含義同式(10)。

(4)F1-Score。是精度和召回率的加權平均值,該值可由如下公式計算求出:

其中,式(13)中各項的數學含義同式(10)。

(5)Jaccard相似性(JS)。用來衡量預測值X和真實值Y之間的相似性,該值可由如下公式計算求出:

其中,式(14)中各項的數學含義同式(10)。

3.3 實驗結果與分析

3.3.1 消融研究

為了充分說明網絡中不同模塊對分割性能的影響,對不同網絡結構的性能進行比較,見表1。表1中,“The proposed”表示U-Net 融合SE 和CRF 兩個模塊、即SECU-Net 網絡模型。仍需指出的是,表1中的粗體表示最優結果。

表1 不同網絡結構的性能比較Tab.1 Performance comparison of different network structures

由表1 可知,U-Net 基礎網絡能獲得不錯的分割結果,但各項指標都不是很高,通過融合SE 和CRF 模塊,其中F1、SP、AC以及JS指標,均有明顯的提升,表明提出的SE 模塊和CRF 模塊對病灶特征有更好的提取能力。最后將兩者結合,可以明顯地觀察到SECU-Net 提高了預測分割結果與真實掩碼的重疊區域,保留了更多的病灶邊界信息,充分驗證了本文分割算法的有效性。

3.3.2 不同算法對比分析

為了驗證所提出SECU-Net 網絡的性能,在ISIC2017 數據集上將本文模型與有代表性的其他分割網絡進行了比較。包括U-Net[8]、AttU-Net[28]、DAGAN[29]、TransUNet[30]以及 MedT[31]。其中,TransUNet 是基于Transformer 的方法。

ISIC 2017 數據集上的性能比較結果見表2。表2中,粗體表示最優結果。由表2 可以明顯看出,擬提出模型能獲得較好的綜合性能。F1分數為0.860,SE為0.878,AC為0.924,JS為0.754。與經典的U-Net 網絡模型相比,F1分數高出3.4%,SE高出0.3%,SP高出2.5%,AC高出1.9%,JS高出5.0%。一方面證明所提出方案的有效性。另一方面,UNet 網絡是SECU-Net 的主干網絡,這也證明了改進策略的有效性。

表2 ISIC 2017 數據集上的性能比較Tab.2 Performance comparison on ISIC 2017 dataset

3.3.3 定性結果分析

為了更直觀地顯示改進算法的病灶分割效果,除以上的定性分析外,圖4~圖6 給出了SECU-Net網絡的定性分割結果,從視覺上能直接觀察到,在面對各種復雜情況下的皮膚病病灶分割時,本文模型都能取得較好效果。圖4 是列舉SECU-Net 網絡在面對目標區域形狀和面積變化大的情況下的分割,圖5 是列舉SECU-Net 網絡在面對目標區域顏色變化大和毛發存在情況下的分割,圖6 是列舉SECUNet 網絡在面對目標區域邊界結構不清晰情況下的分割。圖4~圖6中,各圖皆為不同的測試像本,每一行由左到右分別代表輸入測試樣本原始圖像、真實值(GT Mask)和預測分割結果(pre Mask)。可以看出,本文模型能得到質量很高的分割掩碼,可以很好地完成形狀、面積和顏色變化大,以及毛發存在的皮膚病圖形分割任務。

圖4 形狀和面積變化大的樣本分割結果示例Fig.4 Example of samples segmentation results with large variation in shape and area

圖5 毛發存在和顏色變化大的樣本分割結果示例Fig.5 Examples of segmentation results for samples with large hair presence and color changes

由圖6 可以看出,雖然SECU-Net 在處理模糊邊界上,局部細節上不能實現很好的分割,但很明顯可看出,即使是在樣本邊界非常模糊的情況下,仍能對目標區域的整個輪廓和邊界進行很好的分割,其結果可為臨床診斷提供指導。

圖6 邊界不清晰的樣本分割結果示例Fig.6 Examples of samples segmentation results with unclear boundaries

4 討論與展望

本文提出了用于皮膚病圖像分割的SDCUNet,通過在U-Net 網絡中添加SE 模塊,能自適應地為特征分配權重,即:強化需要關注的特征、抑制無關特征。同時使用CRF 來做后處理,細化分割,提高模型的表示學習能力,從而獲得更好的分割性能。實驗結果表明,與列舉的其他方案相比,SDCUNet 的性能優于其他模型,這一點從表2 即能看出。從定性結果來看,即使是針對頗具挑戰性的圖像,SDCU-Net 也能產生較好的分割掩碼。這一點從圖5 中就可以看到。同時,從其他定性結果也可以看出,該模型產生了高質量的分割掩碼。在未來的工作中,擬繼續探索將SDCU-Net 模型用于其他分割任務中,并探索提升模糊邊界分割效果的新方案。

5 結束語

在本文中,提出的SDCU-Net 以U-Net 作為骨干網絡,融合SE 模塊,并用CRF 來做后處理的皮膚病病灶分割模型。針對皮膚病病灶面積和形狀不規則、顏色變化大,以及病灶與背景對比度低等問題,都能實現較好的分割。首先,通過SE 模塊處理卷積操作輸出的特征層,經過全局平均匯集來排除空間依賴性,從而通過顯式建模通道之間的相互依賴性,學習信道特定描述符來重新校準通道,提高對相關特征的靈敏度,自適應地重新校準通道特性響應。同時,CRF 能建模相鄰像素之間的關系,為相同屬性的像素分配一樣的標簽,盡管是對具有挑戰性的皮膚病樣本,SDCU-Net 也能得到良好的分割性能。