基于潛在低秩表示的紅外和可見光圖像融合

孫 彬,諸葛吳為,高云翔,王梓萱

〈圖像處理與仿真〉

基于潛在低秩表示的紅外和可見光圖像融合

孫 彬1,2,諸葛吳為1,2,高云翔1,2,王梓萱1,2

(1. 電子科技大學 航空航天學院,四川 成都 611731;2. 飛行器集群感知與協同控制四川省重點實驗室,四川 成都 611731)

紅外和可見光圖像融合廣泛應用于目標跟蹤、檢測和識別等領域。為了保留細節的同時增強對比度,本文提出一種基于潛在低秩表示的紅外和可見光圖像融合方法。潛在低秩分解將源圖像分解為基層和顯著層,其中基層包含主要內容和結構信息,顯著層包含能量相對集中的局部區域。進一步利用比例金字塔分解得到低頻和高頻的基層子帶,并針對不同層的特點設計對應的融合規則。利用稀疏表示表達低頻基層較分散的能量,設計L1范數最大和稀疏系數最大規則,加權平均融合策略保留不同的顯著特征;絕對值最大增強高頻基層的對比度信息;而顯著層則利用局部方差度量局部顯著性,加權平均方式突出對比度較強的目標區域。在TNO數據集上的定性和定量實驗分析表明方法具有良好的融合性能。基于低秩分解的方法能夠增強紅外和可見光融合圖像中目標對比度的同時保留了豐富的細節信息。

潛在低秩表示;顯著性分解;稀疏表示;圖像融合

0 引言

圖像融合將來自不同傳感器的圖像整合得到包含更多有效信息的融合圖像,其中紅外和可見光圖像融合被廣泛使用在監控、軍事以及人臉識別等領域[1]。紅外圖像由于依靠物體熱輻射進行成像,可以在低光照、煙霧等惡劣情況下捕捉到目標,但分辨率通常較低,且成像會受環境溫度等因素的影響。可見光圖像在理想的情況下可以得到分辨率較高、細節豐富的高質量圖像,但通常受到光照、天氣、能見度等影響。利用紅外和可見光間互補特性的圖像融合,可以充分保留紅外圖像中顯著的目標信息和可見光圖像中的紋理細節等背景信息[2]。

圖像融合依據處理層次可以大致分為像素級、特征級以及決策級3類[3],目前主流圖像融合算法研究集中在像素級。文獻[4]中基于方法論將像素級圖像融合算法分為基于多尺度分解、稀疏表示、深度學習、顯著性以及混合類型5類。

基于多尺度和稀疏表示的圖像融合方法,通常包含分解、融合和重構3部分,不同之處在于多尺度方法一般是解析的固定函數變換,而稀疏表示的方法通過訓練得到字典來表達圖像中的豐富信息。隨著深度學習的發展,Liu Yu等人[5]將卷積稀疏表示方法用于圖像融合領域。Ma Jiayi等人將圖像融合問題視為一種優化問題[6],通過博弈盡可能使得融合結果與紅外圖像相似,且保留可見光中的梯度信息,并系統總結[7]深度學習方法在圖像融合中的應用。

基于紅外和可見光的差異,研究者提出了基于顯著性分層的融合方法。D. P. Bavirisetti等人[8]使用均值和中值濾波結果的差值,度量視覺顯著性生成融合系數。Li Hui等人[9]使用潛在低秩表示(latent low-rank representation,LatLRR)分解得到顯著層和基層,更好地利用紅外圖像與可見光圖像的互補特性。Zhang Xingchen等人[3]提出一個可見光和紅外圖像融合數據集,并系統比較了20種開源融合方法的客觀指標平均值,其中LatLRR方法在3個指標上達到最優,但顯著層采用簡單的求和融合,損失了部分對比度和細節信息。

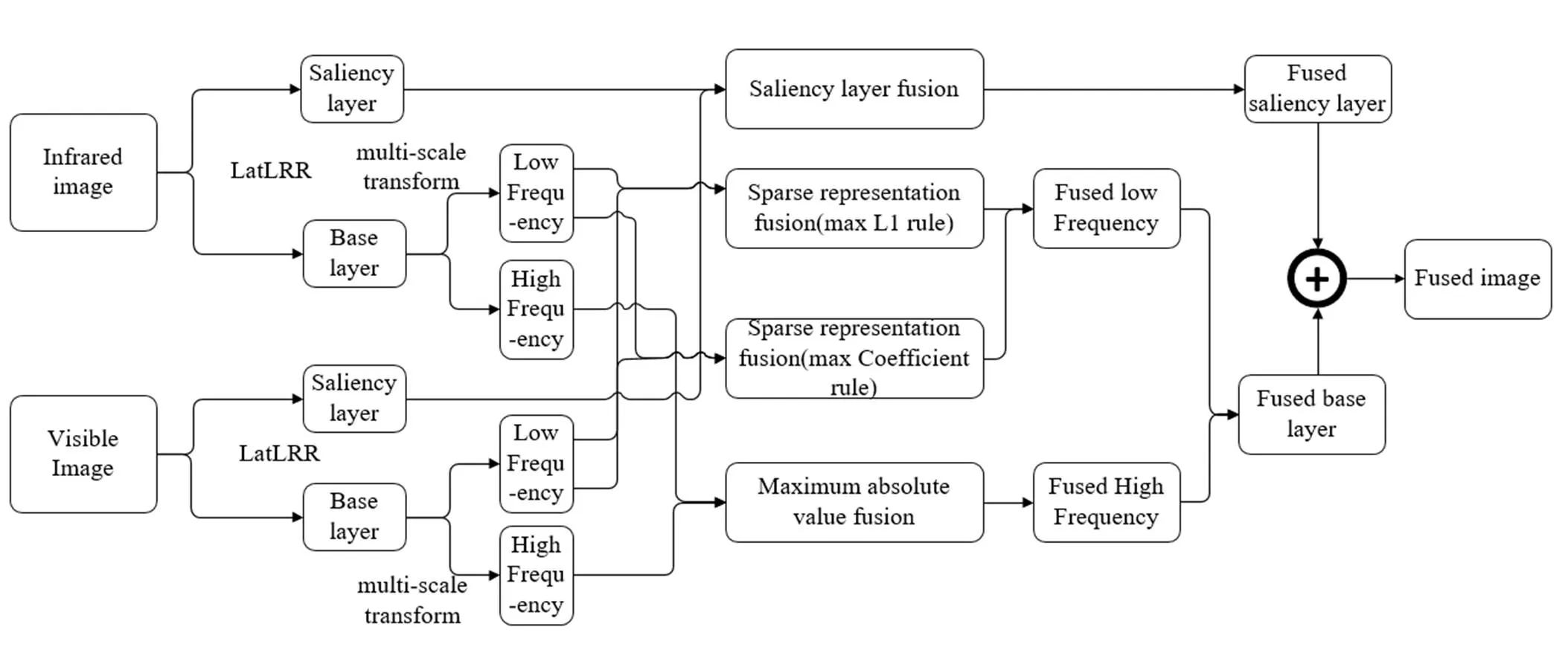

本文針對紅外和可見光融合圖像目標區域對比度較小、細節保留不足的問題,提出一種基于LatLRR分解的紅外可見光圖像融合框架。源圖像經過LatLRR和多尺度分解得到顯著層、基層低頻和基層高頻,其中顯著層包含能量相對集中的局部顯著區域,基層低頻主要包含能量較為分散的全局信息,基層高頻主要包含輪廓、紋理等結構信息。根據分層特點設計對應的融合規則。針對顯著層設計突出對比度信息的加權融合規則,以更好保留顯著性信息;使用金字塔尺度分解得到基層低頻部分,針對基層低頻設計基于L1范數和稀疏系數的融合規則,保留源圖像不同區域的互補信息;針對基層高頻選取絕對值最大保留結構信息。

1 相關理論

1.1 潛在低秩表示

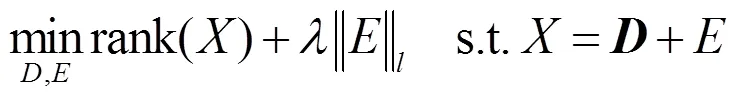

LatLRR是Guangcan Liu等人[10]在低秩表示(low-rank representation,LRR)基礎上提出的。低秩表示[11]是一種從觀測矩陣中恢復原始矩陣的技術,其基本假設是原始數據滿足低秩,將觀測矩陣分解為一個低秩矩陣和噪聲矩陣,該問題被描述為:

LRR無法提取局部結構信息,而LatLRR通過求解公式(2)的優化問題,可以從原始數據中提取全局結構和局部結構信息。不僅可以將噪聲分離出來,還將顯著性信息提取出來,作為一個單獨的子空間,其問題描述如下:

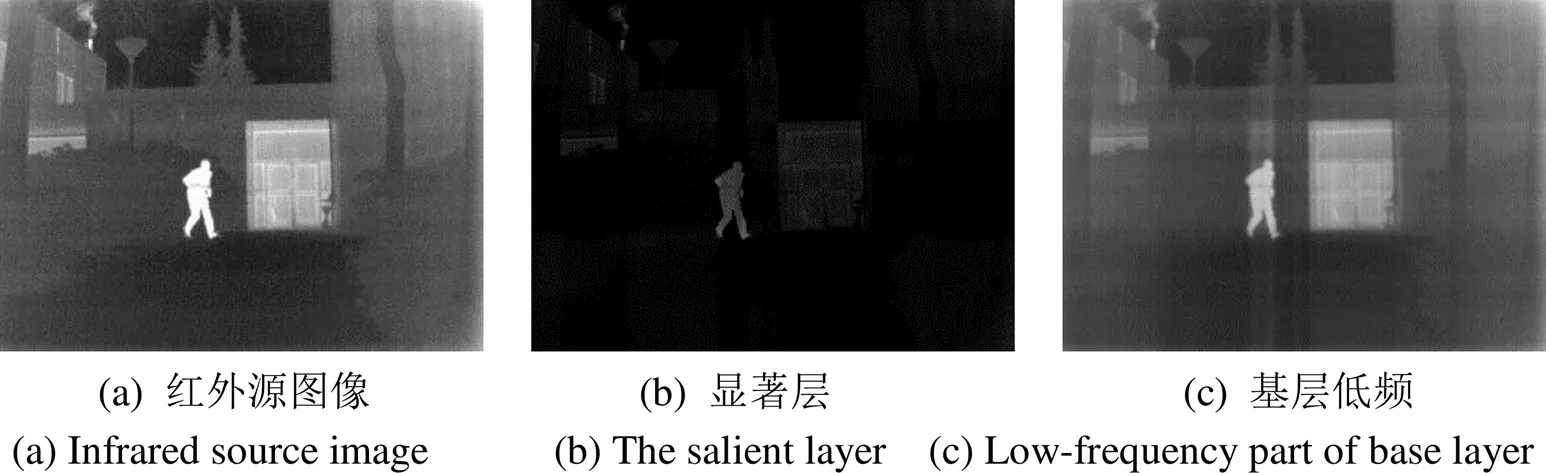

L式中:l為大于零的常數;為矩陣1范數;X為觀察得到的矩陣;XZ為分離出來的基層;LX為提取出來的顯著層,E為噪聲。從圖1中可以看出,顯著層包含局部顯著區域,是紅外和可見光圖像融合中重點保留的信息,對融合結果中目標區域的對比度強弱有關鍵影響;基層由于顯著性區域部分能量被分解到了顯著層,圖像整體亮度下降,主要包含目標整體以及背景細節。

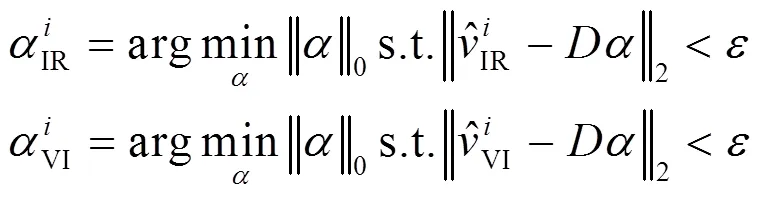

1.2 稀疏表示

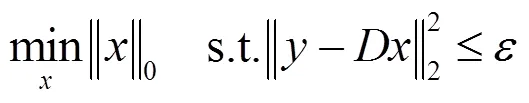

稀疏表示基于所有信號都可以被一組原子線性組合近似的假設,原子組成的矩陣被稱為字典,且僅利用少數原子可表示,即系數存在稀疏性。稀疏表示的優化式[12]為:

稀疏表示僅適用于低維度向量,因此需要利用滑窗技術對圖像進行分塊,而融合中常用的“最大L1范數”易受高頻噪聲的影響,造成空間不一致性,因此稀疏表示方法更適用于處理低頻分量[13]。

1.3 多尺度變換

多尺度變換通過尺度分解得到不同分辨率、方向子帶圖像,并針對子帶圖像特點設計對應的融合規則。經典的方法包括[14]金字塔變換、小波變換、多分辨率幾何變換等。

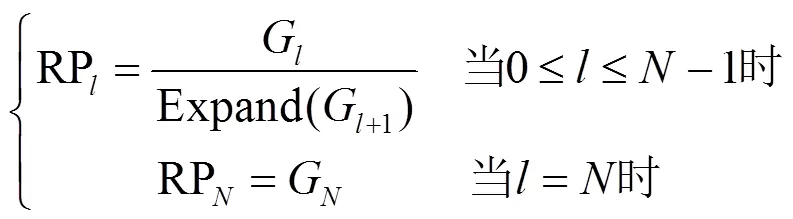

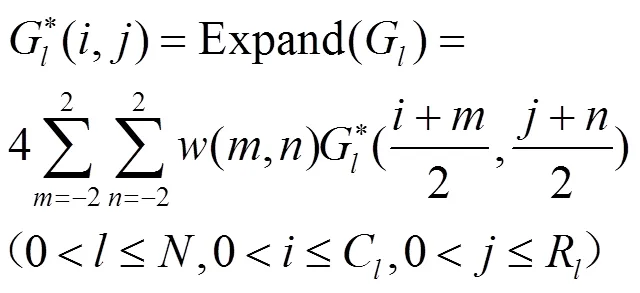

其中比率金字塔通過相鄰兩層之間的比率實現尺度分解,能夠突出對比度信息。分解和重建過程如公式(4)、(5)和(6):

式中:RP為比例低通金字塔各層的圖像;(,)為有低通特性的窗口函數;G為高斯金字塔第層圖像;Expand()為放大算子;C、R為對應層長和寬。重建過程表示為:

2 改進后的融合方法

本文提出的圖像融合框架如圖2所示,首先利用LatLRR分解得到相應的顯著層和基層,并將基層進一步分解為高頻和低頻部分。以紅外圖像源為例,分解后得到的各層示意圖如圖3所示,其中顯著層提取到能量較為集中的局部顯著區域,表現為亮度和對比度突出的目標區域;基層低頻包含圖像的主要內容,表現為較平滑的全局信息,而基層高頻部分則包含圖像輪廓、邊緣等細節信息。

圖2 提出的算法框架圖

圖3 各層分解示例

2.1 基層融合

源圖像經過LatLRR分解之后得到的紅外和可見光基層分別表示為IRbase和VIbase,如圖4所示。進一步利用比率金字塔分解將圖像基層分解為高頻部分IRbase-high和VIbase-high以及低頻部分IRbase-low和VIbase-low,較好地保留和增強圖像對比度。

2.1.1 基層低頻融合

紅外和可見光進行融合時,源圖像的同一位置區域可能有不同的亮度和對比度。傳統方法針對低頻部分通常采用加權平均方式,但平均的融合規則對于不同模態的融合容易造成能量的損失。

稀疏表示的方法對低頻部分具有良好的表達能力。本文利用稀疏表示對基層低頻部分進行融合,并設計利用不同的融合規則加權融合保留不同的顯著特征,具體步驟如下:

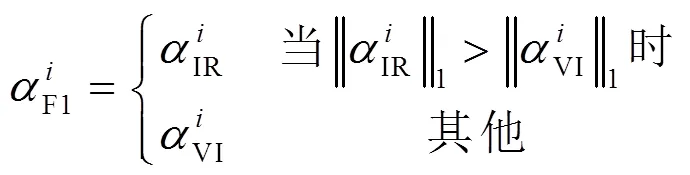

2)稀疏系數的融合分別采用“最大L1范數”和“最大稀疏系數”融合規則。

①“最大L1范數”以稀疏向量的L1范數衡量特征的顯著程度:

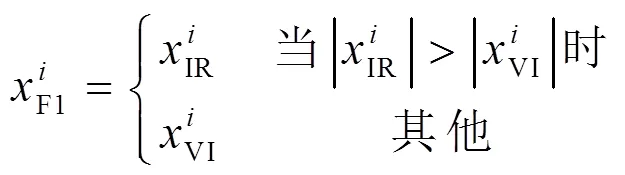

②“最大稀疏系數”以稀疏系數的絕對值大小反映了該特征的顯著程度:

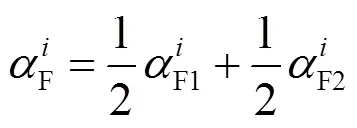

③對不同融合規則得到兩個對應的稀疏系數向量F1和F2進行加權平均,得到融合后的稀疏系數F,即:

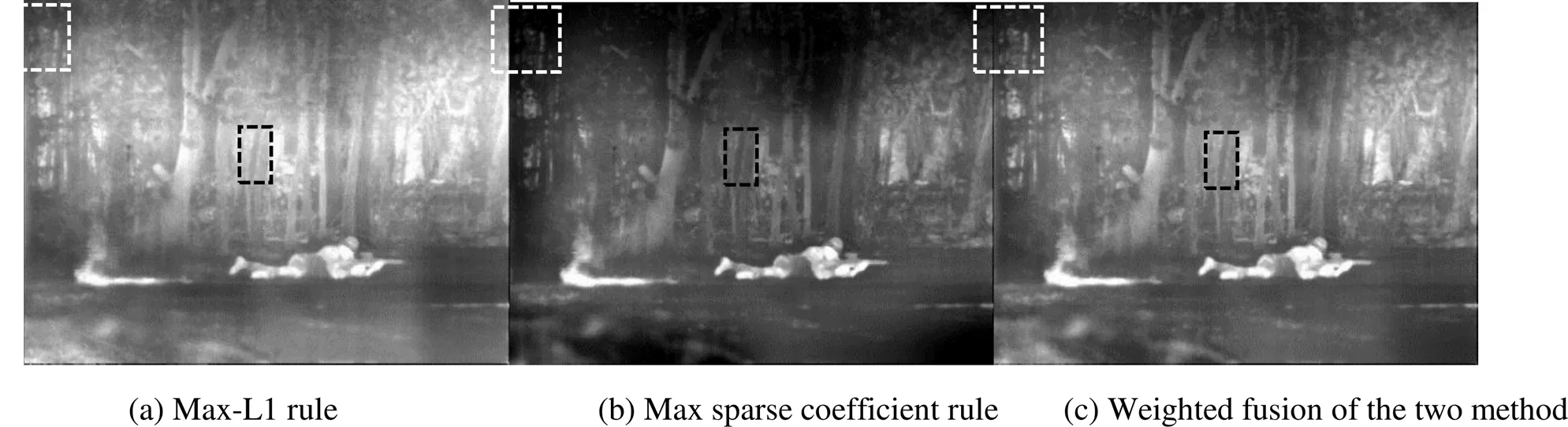

圖5示意了不同規則下基層圖像的融合效果。從結果來看,兩者在圖像中的目標區域特征保留情況相近,但在背景細節紋理上具有互補性。其中“最大L1范數”取自同一個源圖像的圖像塊,在該例中傾向于保留較亮的細節特征,但損失了一定的對比度。而“最大稀疏系數”將每個原子對應的特征作為一組,選擇保留來自兩個源圖像中更顯著的系數對應的原子特征,組合為新的圖像塊。經過加權融合之后的結果保證圖像對比度的同時,保留了豐富的細節。

利用字典得到融合向量F=F并進行重建得到基層低頻分量融合結果base-low。

2.1.2 基層高頻融合

基層高頻部分包含了圖像中的邊緣細節,對于比率金字塔分解之后得到的不同尺度高頻子帶,利用像素絕對值度量活躍程度,并使用絕對最大值的融合規則保留高頻細節信息。

2.1.3 基層重建

將融合后的低頻分量base-low和高頻分量base-high根據公式(6)進行重建,得到融合后的基層圖像base。

2.2 顯著層融合

顯著層包含了各個源圖像中能量集中的顯著區域,其融合規則會直接影響紅外和可見光融合的效果。Li Hui等人[9]指出顯著層信息需要沒有損失地保留在融合結果中,并利用逐像素加和方式融合,總權重為2。

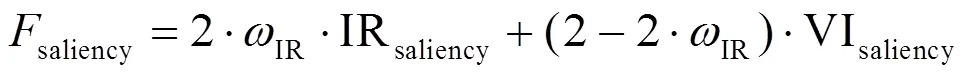

本文設計基于滑窗的局部方差度量顯著性,權重和為2以突出圖像源中的局部顯著性,具體公式如下:

3 實驗結果與分析

3.1 實驗設定

實驗數據主要源自TNO數據集[15],包含不同應用場景的10對紅外可見光圖像對,如圖6所示。第一、三行是紅外圖像,第二、四行是對應的可見光圖像。

圖5 不同融合規則融合結果

圖6 使用的10對源圖像

本文選擇了8種經典的圖像融合算法,分別為ADF(anisotropic diffusion fusion)[16]、CSR(convolutional sparse representation)[5]、TE-MST(target-enhanced multiscale transform decomposition)[17]、FPDE(fourth order partial differential equations)[18]、GF(gradientlet filter)[19]、TIF(two-scale image fusion)[20]、LatLRR(latent low-rank representation)[9]以及MSVD(multi-resolution singular value decomposition)[21]對數據集中的圖像進行圖像融合,與提出的方法進行定性和定量比較分析。

實驗在AMD Ryzen 5 4600H 3.00GHz,16GB RAM的計算機上運行,其中金字塔分解層數為5。

3.2 融合結果及分析

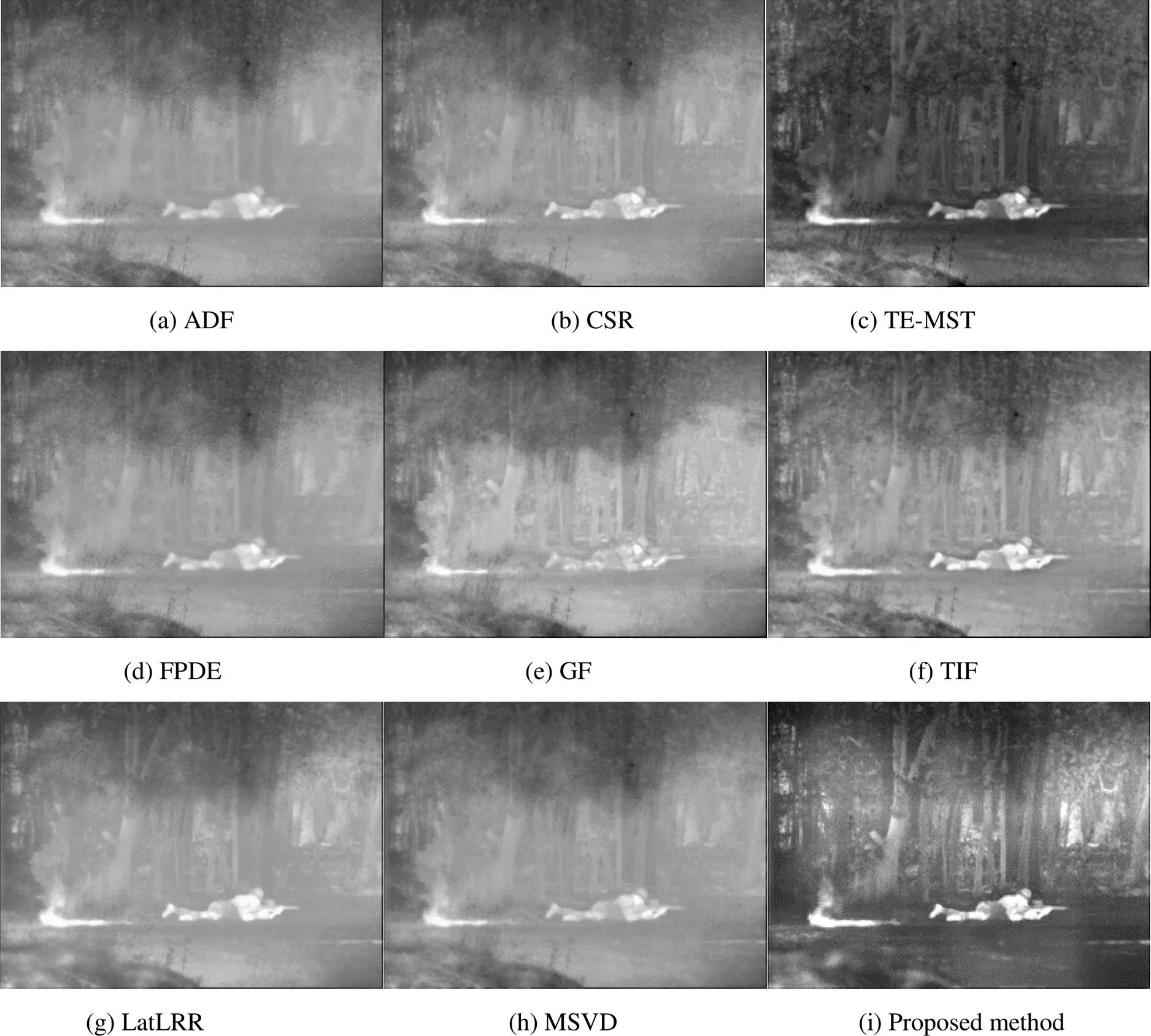

圖7為源圖像“soldier behind smoke”的各個方法融合結果。紅外源圖像中包含主要目標以及豐富的背景信息,可見光圖像中主要是煙霧。從對比結果中可以看出,ADF,FPDE,GF,MSVD得到的士兵部分邊緣細節十分模糊;CSR得到的融合結果目標區域對比度不強;TE-MST完整保留了紅外圖像中的士兵,但是背景細節和目標區域對比度損失較多;TIF和LatLRR目標區域對比度較強,但背景信息損失較大;本文提出的方法較好地保留了背景細節以及士兵區域的完整信息,且對比度較強。

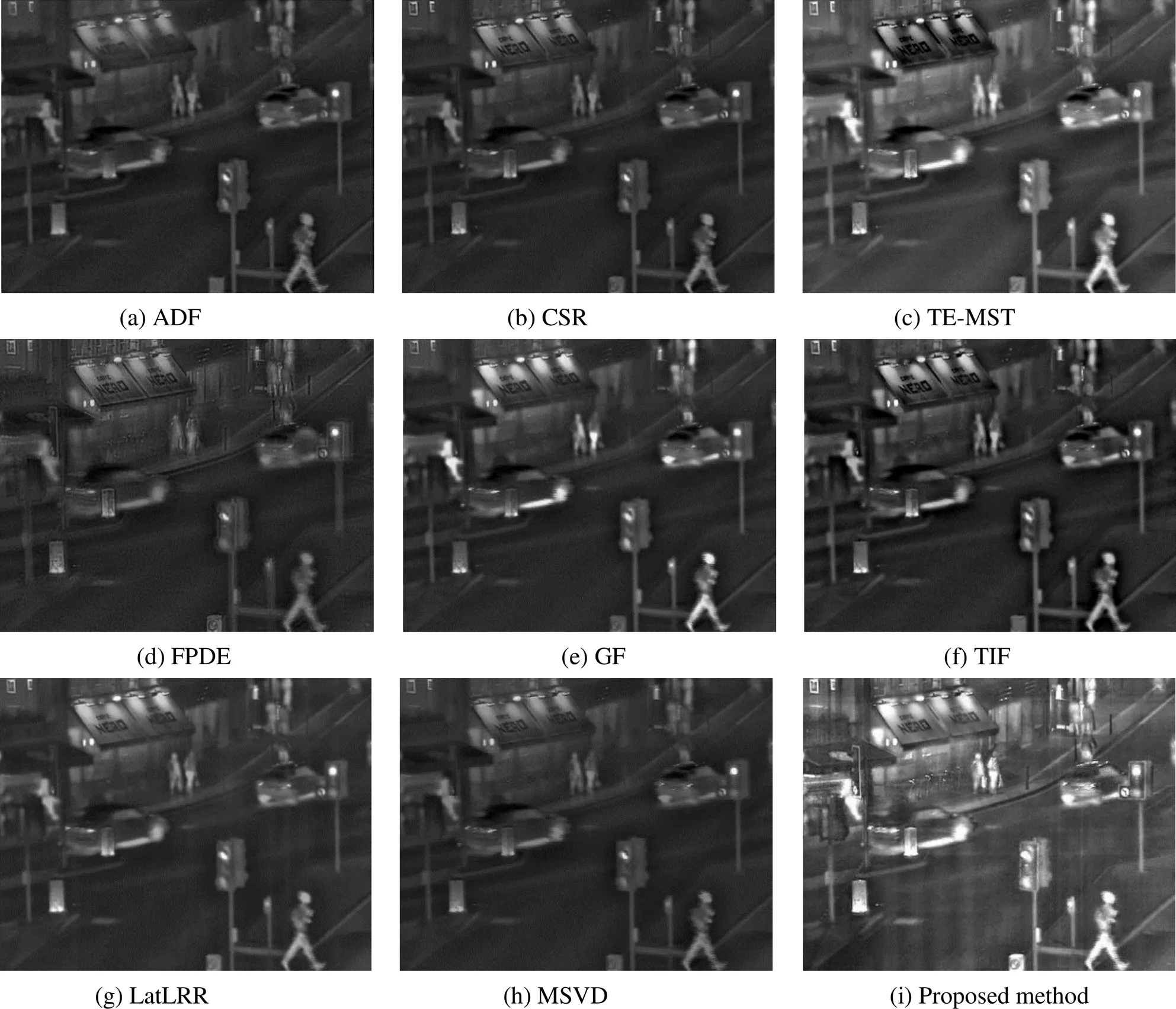

圖8和圖9分別為圖像“street”和“boat”的融合對比結果。圖像“street”,本文方法的融合結果在行人處整體亮度較亮,對比度顯著,而在商店周圍,則保留了豐富的細節如燈牌上的文字等。對于圖像“boat”,ADF、CSR、FPDE、TIF、LatLRR、MSVD和GF等融合結果對比度普遍較低,TE-MST和本文方法得到結果中船與背景對比度較強,同時沒有因為顯著部分過亮導致船上細節信息的損失,保留了豐富的背景紋理信息。

圖7 9種方法在‘soldier behind smoke’上的結果

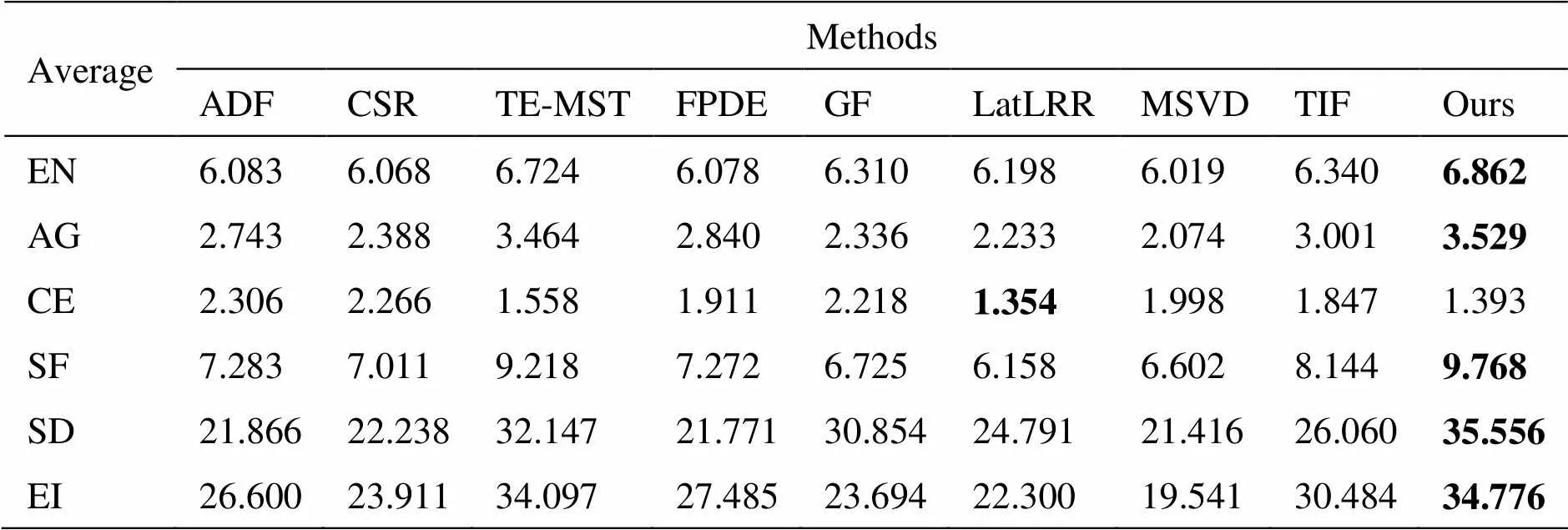

本文采用EN(entropy)、AG(avgerage gradient)、CE(cross entropy)、SF(spatial frequency)、SD(standard deviation)和EI(edge intensity)6種客觀評價指標定量評估各種方法的融合質量[22]。EN度量圖像中的信息量;AG表示圖像的平均梯度,用于描述圖像中細節和紋理的豐富程度;CE為結果與源圖像的交叉熵,衡量的是融合之后的圖像與源圖像的相似程度,CE越小圖像間的差異越小;SF描述的是圖像在空間上的活躍程度;SD反映圖像的對比度;EI度量圖像中細節信息多少的客觀指標。

表1為圖像“soldier behind smoke”、“street”和“boat”9種方法融合結果的客觀指標評價結果,表中加粗數值表示該指標下的最優值。圖像“soldier behind smoke”客觀評價指標中TE-MST和本文方法分別有3個指標最優,與定性分析的結論基本一致。圖像“street”所提算法的大部分指標均排名靠前。

圖8 9種方法在“street”上的結果

不同客觀評價指標在不同源圖像上的評價排名上有差異,為了對比TNO中10對圖像源的融合效果,表2統計了不同圖像對的客觀指標平均值。從統計結果來看,提出的融合算法能夠保留豐富的圖像細節,表現為EN、AG、SF和EI等反映圖像特征豐富程度的客觀指標排名靠前,在反映融合結果與源圖像的相似程度的CE指標上排名次優,在反映圖像對比度的SD指標上表現很好,綜上分析達到了保留細節的同時增強圖像對比度的效果。

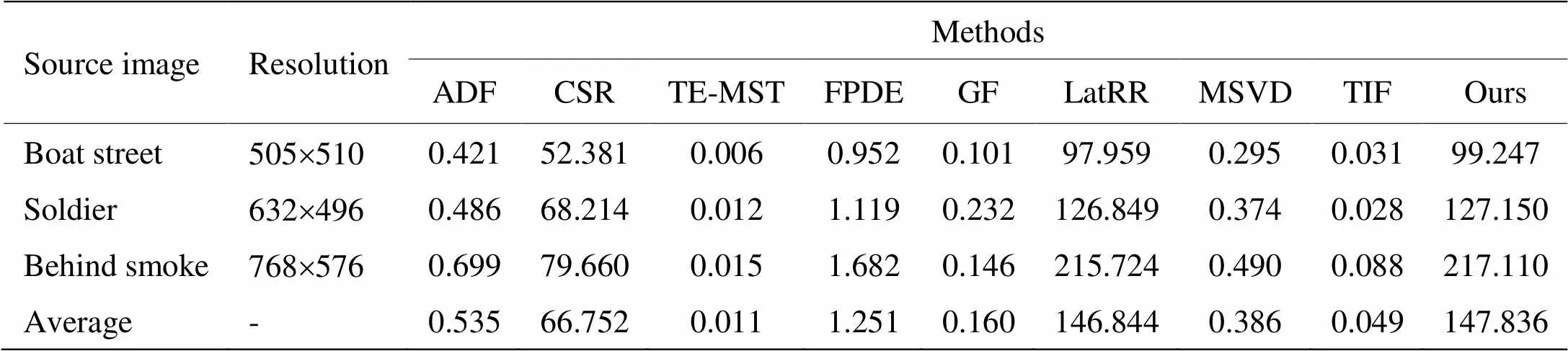

表3對比不同算法對不同分辨率源圖像進行融合的運行時間,以及它們的均值。其中CSR、LatLRR方法和本文提出的方法由于需要對大量圖像塊進行稀疏或低秩分解,算法復雜度非常高,運行時間較長。從統計結果來看,以60fps為標準,除了TE-MST、TIF方法外,大部分融合算法在未加速的情況下,均無法達到實時處理,如何在保證融合效果的同時,提升圖像融合算法的計算效率,是影響融合算法未來應用的重要因素。

表2 9種方法在10對源圖像上的客觀指標平均值

表3 9種方法在3種不同分辨率源圖像上的運行時間以及平均值

4 結論

紅外和可見光圖像融合應用中,紅外圖像通常包含對比度較強的目標信息,而可見光圖像包含背景中較豐富的紋理和細節信息。基于多尺度、稀疏、深度學習等融合算法通常采用尺度變換、固定字典或深度特征來表示源圖像中的有效信息。本文利用低秩和多尺度分解得到基層低頻、基層高頻、顯著層,分別表達圖像中的全局信息、結構和局部顯著性。針對各層的特點設計不同的融合規則,其中對比度較低的基層分別采用稀疏表示和比率金字塔處理低頻和高頻部分;能量相對集中的顯著層,設計方差最大融合規則增強局部顯著性。在TNO數據集的定性和定量實驗分析表明,本文算法保留了較多的圖像細節并增強目標區域的對比度。由于基于低秩分解的方法算法復雜度較高,無法達到實時處理的要求,研發快速融合方法滿足應用需求將是未來紅外和可見光圖像融合的重點。

[1] 沈英, 黃春紅, 黃峰, 等. 紅外與可見光融合技術的研究進展[J]. 紅外與激光工程, 2021(9): 1-16.

SHEN Y, HUANG C H, HUANG F, et al. Infrared and visible image fusion: review of key technologies [J]., 2021(9): 1-16 .

[2] 楊孫運, 奚崢皓, 王漢東, 等.基于NSCT和最小化-局部平均梯度的圖像融合[J]. 紅外技術, 2021, 43(1): 13-20.

YANG S Y, XI Z H, WANG H D, et al. Image fusion based on NSCT and minimum-local mean gradient [J]., 2021, 43(1): 13-20.

[3] ZHANG X, YE P , XIAO G. VIFB: A Visible and Infrared Image Fusion Benchmark[C]//, 2020: 468-478.

[4] CHEN J, WU K, CHENG Z, et al, A saliency-based multiscale approach for infrared and visible image fusion[J]., 2021, 182(4): 107936.

[5] LIU Y, CHEN X, Ward R K, et al. Image fusion with convolutional sparse representation[J]., 2016, 23(12): 1882-1886.

[6] MA J Y, CHEN C, LI C , et al. Infrared and visible image fusion via gradient transfer and total variation minimization[J]., 2016, 31: 100-109.

[7] ZHANG H, XU H, TIAN X, et al. Image fusion meets deep learning: A survey and perspective[J]., 2021, 76(11): 323-336.

[8] Bavirisetti D P, D Huli R. Two-scale image fusion of visible and infrared images using saliency detection[J]., 2016, 76: 52-64.

[9] LI H , WU X J. Infrared and visible image fusion using latent low-rank representation[J/OL] [2018-04-24]. arXiv preprint. https://arxiv.org /abs/ 1804.08992.

[10] LIU G, YAN S. Latent low-rank representation for subspace segmentation and feature extraction[C]//, 2011:1615-1622.

[11] 劉琰煜, 周冬明, 聶仁燦, 等. 低秩表示和字典學習的紅外與可見光圖像融合算法[J].云南大學學報: 自然科學版, 2019, 41(4): 689-698.

LIU Y Y, ZHOU D M, NIE R C, et al. Infrared and visible image fusion scheme using low rank representation and dictionary learning[J].:Natural Sciences Edition, 2019, 41(4): 689-698.

[12] 王凡, 王屹, 劉洋.利用結構化和一致性約束的稀疏表示模型進行紅外和可見光圖像融合[J]. 信號處理,2020, 36(4): 572-583.

WANG F, WANG Y, LIU Y. Infrared and visible image fusion method based on sparse representation with structured and spatial consistency constraints[J]., 2020, 36(4): 572-583.

[13] LIU Y, LIU S, WANG Z. A general framework for image fusion based on multi-scale transform and sparse representation[J]., 2015(24): 147-164.

[14] LI S, KANG X, FANG L , et al. Pixel-level image fusion: a survey of the state of the art[J]., 2017, 33: 100-112.

[15] Toet Alexander. The TNO Multiband image data collection[J]., 2017, 15: 249-251.

[16] Bavirisetti D P, Dhuli R. Fusion of infrared and visible sensor images based on anisotropic diffusion and Karhunen-Loeve transform[J]., 2015, 16(1): 203-209.

[17] CHEN J, LI X J, LUO L B, et al. Infrared and visible image fusion based on target-enhanced multiscale transform decomposition[J]., 2020, 508: 64-78.

[18] Ba Virisetti D P. Multi-sensor image fusion based on fourth order partial differential equations[C]//20(Fusion), 2017: 1-9.

[19] MA J Y, ZHOU Y. Infrared and visible image fusion via gradientlet filter[J]., 2020, 197: 103016.

[20] Bavirisetti D P, D Huli R. Two-scale image fusion of visible and infrared images using saliency detection[J]., 2016, 76: 52-64.

[21] Naidu V. Image fusion technique using multi-resolution singular value decomposition[J]., 2011, 61(5): 479-484.

[22] 劉智嘉, 賈鵬, 夏寅輝.基于紅外與可見光圖像融合技術發展與性能評價[J].激光與紅外,2019, 49(5): 123-130.

LIU Z J, JIA P, XIA Y H, et al. Development and performance evaluation of infrared and visual image fusion technology[J]., 2019, 49(5): 123-130.

Infrared and Visible Image Fusion Based on Latent Low-Rank Representation

SUN Bin1,2,ZHUGE Wuwei1,2,GAO Yunxiang1,2,WANG Zixuan1,2

(1.,,611731,;2.,611731,)

Infrared and visible image fusion is widely used in target tracking, detection, and recognition. To preserve image details and enhance contrast, this study proposed an infrared and visible image fusion method based on latent low-rank representation. The latent low-rank representation was used to decompose the source images into base and significant layers, in which the base layers contained the main content and structure information, and the salient layers contained the local area with relatively concentrated energy. The ratio of low-pass pyramid was also adopted to decompose the base layer intolow-frequency and high-frequency layers. The corresponding fusion rules were designed according to the characteristics of the different layers. A sparse representation was used to express the relatively dispersed energy of the low-frequency base, and the rules of the maximum L1 norm and maximum sparse coefficient were weighted averages to retain different significant features. The absolute value of the high-frequency part of the base layer was used to enhance the contrast. Local variance was used for the salient layer to measure significance, and the weighted average was used to highlight the target area with enhanced contrast. Experimental results on the TNO datasets show that the proposed method performed well in both qualitative and quantitative evaluations. The method based on low-rank decomposition can enhance the contrast of the targets and retain rich details in infrared and visible fusion images.

latent low-rank representation, saliency decomposition, sparse representation, image fusion

TP391

A

1001-8891(2022)08-0853-10

2021-08-20;

2021-09-25.

孫彬(1984-),副教授,主要研究方向為信息融合、圖像處理、導航定位。E-mail: sunbinhust@uestc.edu.cn。

四川省科技計劃資助(2020YFG0231);四川省中央引導地方科技發展專項(2020ZYD016);電子科技大學基于項目的研究生創新培養計劃建設項目(XMZ20203-9)。