結合D-SIFT和區域PPWLD的人臉表情識別方法

付思亞 胡西川

(上海海事大學信息工程學院 上海 201306)

0 引 言

隨著人工智能、模式識別在人們生活中的應用場景不斷增加,表情識別技術受到廣泛關注。人臉表情識別是一個復雜的過程,一般包括預處理、人臉檢測、特征提取描述和分類識別等步驟。其中最重要的是對特征的描述方法。

當下在人臉表情識別方面的常用特征描述方法有局部二值模式(Local Binary Pattern,LBP)[1]、主成分分析(Principal Component Analysis,PCA)[2]、Gabor小波變換[3]、尺度不變線性變換(Scale Invariant Feature Transform,SIFT)[4]、韋伯局部描述子(Weber Local Descriptor,WLD)[5]、線性判別分析(Linear Discriminant Analysis,LDA)[6]等。同時,隨著深度學習的發展,借助神經網絡提取特征并分類的方法也層出不窮。

全局特征PCA[2]和LDA[6]方法的優勢是對全臉輪廓的描述,但兩者在局部信息描述力、光照變化魯棒性方面都有所不足。而描述局部頻率信息的Gabor特征[3]所提取的是多尺度多方向特征,產生的高維特征不利于實時處理。LBP[1]局部特征具有灰度和旋轉不變性,受光照影響較小,但傳統的LBP算法很難精確描述不同表情區域的灰度變化,得到的特征不具有方向性,對圖像的描述力不足。神經網絡提取特征并分類的方法雖然具有較高的識別率,但是對訓練樣本依賴度高。如何俊等[7]提出將深度殘差網絡與支持向量機結合以實現表情識別,徐琳琳等[8]提出構建并行神經網絡提取特征,這些方法均對訓練樣本依賴度高,圖像預處理用時久,容易出現過擬合或欠擬合的情況。

SIFT局部特征提取方法在1999年由Lowe[4]提出,所提取的特征對旋轉、縮放、光照具有良好魯棒性,描述能力較強,提出之后便得到廣泛的使用。如Soyel等[9]將SIFT方法選取的極值點作為特征點,實現特征點匹配。然而原始的SIFT方法通過構建尺度空間來獲取特征點,這些特征點的分布位置隨機,不一定分布在與表情密切相關的區域,同時提取的特征點個數不一,容易對后續的分類造成困難。因而,Zheng等[10]提出基于分塊的SIFT特征提取方法,不用預先標注特征點,但分塊的數目及大小難以選擇,描述方法對姿態變化比較敏感;Hu等[11]用預先定義的83個特征點進行SIFT描述,實現表情識別;黃忠等[12]提出用AAM[13](Active Appearance Models)定位特征點后進行特征描述。這些方法針對特征點進行描述,對面部特征描述不夠全面,識別率不足,過高的特征維數也導致實時性不佳。

2010年Chen等[5]基于韋伯定律提出WLD特征,通過像素點在鄰域中的灰度變化進行描述以提取特征,WLD特征對光照和噪聲具有良好的魯棒性,在紋理分類、人臉識別等方向受到廣泛應用。但原始WLD特征僅描述中心像素點和周圍鄰域像素的變化,對圖像細節信息描述不足。許多針對原始WLD特征的改進由此被提出。如Li等[14]對原始WLD的差分激勵算子進行頻域加權,增加激勵的對比度;Dawood等[15]提出基于多尺度WLD和多級信息融合的方法;Cui等[16]將WLD直方圖與方差直方圖結合以提取特征;Ojala等[18]采用高斯拉普拉斯算子提取局部窗內的灰度變化,用均勻局部二值模式[19](uniform Local Binary Pattern,uLBP)代替方向算子,增強對噪聲的魯棒性;郭仙草等[20]利用局部窗內像素點間灰度變化的正負梯度構建紋理特征描述符,用uLBP提取灰度等級變化的空間分布結構信息,將差分激勵算子與uLBP[19]結合進行特征提取。

為了更好地對表情圖片進行特征提取和表情分類,本文首先使用級聯回歸樹檢測關鍵點,篩選與表情密切相關的關鍵點作為特征點,進行基于快版SIFT方法的特征描述,產生D-SIFT特征描述向量;同時將人臉劃分為四個表情關鍵子區域,使用Prewitt算子對原始WLD特征描述符作出改進,對每個子區域進行改進后的WLD特征描述。將得到的兩種特征進行融合,送入SVM分類器進行最終的表情分類。

1 相關工作

1.1 級聯回歸樹

級聯回歸樹(Ensemble of Regression Trees)方法由Kazemi等[21]在2014年提出。該方法使用兩層回歸來建立數學模型。

第一層回歸的迭代公式為:

(1)

式中:S是形狀向量,存儲著所有臉部關鍵點的位置;γt是一層的回歸器。每經過一級級聯回歸器,就會對所有關鍵點位置進行一次更新來達到更正確的位置。第二層回歸采用Gradient Tree Boosting Algorithm的方法得到一系列回歸樹。

級聯回歸樹的人臉圖像關鍵點檢測效果如圖1所示。

圖1 定位關鍵點

1.2 SIFT特征

傳統SIFT方法首先通過高斯金字塔對圖像建立尺度空間提取特征點,計算特征點在鄰域內的梯度直方圖,將所有特征點的計算結果級聯,得到具有尺度不變性、旋轉不變性的SIFT特征。

但傳統方法下提取的特征向量特征點數目過多,導致維數過高,特征提取的實時性有所欠缺,而且所提取出的特征點數量不一,不便于直接用于分類,快版變體Dense-SIFT特征因此被提出。Dense-SIFT算法指的是通過指定步長和大小的patch塊對圖像進行遍歷,以每個patch塊的中心作為特征點,在每個patch塊中通過SIFT描述方法對特征點進行描述。

Dense-SIFT算法解決了傳統SIFT算法得到的特征點數目過多且數目不一的問題,有良好的實時性,并可以根據特征提取的需要調節步長、patch塊大小,因此更加適合用于表情圖像的特征提取。

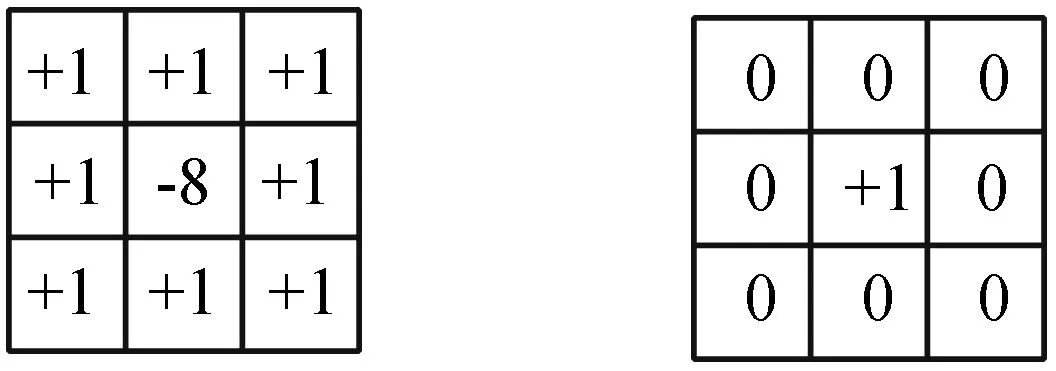

1.3 Prewitt算子

Prewitt算子是一階微分算子的邊緣檢測算子。利用像素點水平、垂直及對角線方向相鄰像素點的灰度差描述圖像,對噪聲具有平滑作用。

三種Prewitt算子如圖2所示。

(a) 垂直Prewitt算子 (b) 水平Prewitt算子

1.4 WLD特征

韋伯定律指出,刺激的增量閾值和原始刺激之間的比值是一個常量,Chen等[5]因此提出WLD特征,通過分別計算像素點的差分激勵ξ(xc)和梯度方向θ(xc)以描述圖像。

WLD特征使用兩個3×3算子f00和f01計算當前像素在其鄰域內的差動激勵ξ(xc),使用兩個3×3算子f10和f11計算當前像素的梯度方向。算子如圖3所示。

(a) 刺激變化算子f00 (b)原始刺激算子f01

利用算子求出該點差動激勵ξ(xc)及梯度方向θ(xc)如下:

(2)

(3)

(4)

(5)

θ′由θ計算得出:

(6)

(7)

求出的WLD特征是一個2D直方圖{WLD(ξj,Φt)},不便直接用于分類。因此對每個像素用T個梯度方向均勻劃分成為T個一維直方圖H(t)(t=0,1,…,T-1),每個一維直方圖H(t)(t=0,1,…,T-1)代表它在該方向的差分激勵,再將H(t)(t=0,1,…,T-1)均勻劃分為M個區間,得到Hm,t(m=0,1,…,M-1)。

最后將每個差分激勵的子區間進一步劃分為S個小段,即Hm,t={hm,t,s},s=0,1,…,S-1。hm,t,s的值計算公式如下:

(8)

(9)

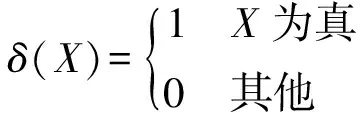

有Kronecker差分方程:

得到最終M×T×S維WLD一維直方圖:

H={hm,t,s}m=0,1,…,M-1

t=0,1,…,T-1,s=0,1,…,S-1

(10)

2 特征提取及描述

2.1 D-SIFT特征

雖然Dense-SIFT方法解決了傳統SIFT方法所提取的特征點數目不一的問題,但Dense-SIFT方法是通過用patch塊遍歷圖像的方式提取特征點,從而導致所提取的特征點位置是由patch塊大小和步長決定,在圖像上呈現為均勻分布。因此可能存在與表情無關的特征點(比如個別特征點處于頭發區域),或是忽視對表情極為重要的特征點,無法充分描述表情信息,也無法對和表情密切相關的五官處區域進行細節的描述。

因此提出D-SIFT方法:預先通過級聯回歸樹方法提取出人臉關鍵點,篩選出其中與表情密切相關的特征點,用SIFT方法對這些特征點進行描述。通過級聯回歸樹方法提取出68個人臉關鍵點,并對其進行標號,結果如圖4所示。

圖4 68個人臉關鍵點

由于人臉輪廓對于表情表達影響較小,只留下與表情表達相關度高的51個關鍵點作為特征點。將該51個特征點作為patch中心形成patch塊。

本文按照Lowe[4]建議,將所選patch塊劃分為4×4個子區域,每個子區域作為一個種子點,得到16個種子點,對每個種子點計算其梯度幅值m(x,y)、方向θ(x,y)和該區域內每個像素點的權重值w(x,y)。w(x,y)計算如下:

(11)

將梯度方向均分為8個方向,通過求出的每個像素點梯度值,累計該種子點在8個方向上的權重值,得到該種子點的梯度直方圖。對每個種子點繪制其梯度直方圖,得到該特征點的4×4×8維的D-SIFT特征描述。

2.2 區域PPWLD特征

由圖3可知,原始WLD特征方法在計算梯度方向時,僅考慮中心點像素上、下、左、右的四個鄰域像素,對圖像的局部紋理信息以及空間結構信息描述有所欠缺,丟失了水平方向和垂直方向以外的其他鄰域像素的變化信息。

以圖5為例,對圖5(a)而言,其本身的像素變化平緩,根據原始WLD特征方法可求出:

(4-3)+(3-3)+(3-3)+(3-3)]=3

對圖5(b)而言,其本身像素變化差異很大,根據原始WLD特征方法可求出:

(1-5)+(1-5)+(1-5)+(1-5)]=-32

(a) 變化平緩 |(b) 跳躍變化圖5 像素變化不同的變化趨勢示意圖

可以看出,原始WLD特征方法的激勵算子對變化平緩的像素會求出較高的激勵值,對變化較大的像素則得到很低的激勵值,兩者結果均與圖像本身的變化不符。可知原始WLD特征方法在計算時,可能會出現正負相抵消等情況,導致對圖像灰度變化信息體現較差,對紋理細節的描述力度不足,而且無法很好地抑制噪聲。

由于Prewitt算子能夠考慮到中心像素的所有鄰域像素,相較原始WLD方法的方向算子和激勵算子而言,可以更好地提取圖像方向信息、空間結構信息并抑制噪聲。因此本文提出PPWLD方法,使用對角線Prewitt算子代替原始WLD方法中的梯度方向算子,用垂直Prewitt算子和水平Prewitt算子代替原始WLD方法中的差分激勵算子,從而更加有效地提取出圖像的空間結構信息及局部紋理信息。

PPWLD方法的差動激勵ξ(xc)計算:

(12)

PPWLD方法的梯度方向θ(xc)計算:

(13)

由于PPWLD特征通過計算出的直方圖對圖像進行特征描述,因此該特征對位置信息和直方圖的劃分區間較為敏感。兩幅不同的圖像在統計整幅圖的像素點所屬區間上或許會計算出相同的直方圖結果,從而造成分類結果出現錯誤。

同時,人臉表情圖像本身具有一定相似性,在對表情進行描述時更需要關注的是細節信息。而圖像拍攝條件、光照等因素也會對直方圖特征的識別結果造成影響。因此,相較于對整幅圖像利用直方圖描述,將圖像分塊之后對每個分塊分別進行描述更加具有細節描述力和對噪聲的抑制力。

通過實驗嘗試不同的分塊方式,根據不同分塊方式下的識別率,選擇使用對關鍵表情區域劃分的方式進行區域PPWLD特征描述,將子區域描述符級聯得到4×(M×T×S)維的特征向量。

3 特征融合

D-SIFT通過計算五官處特征點鄰域的梯度方向對圖像進行特征描述,缺失對圖片中特征點以外的區域的描述,因此使用對關鍵表情區域進行描述的PPWLD彌補D-SIFT的不足,提出結合預先提取關鍵點,篩選后進行描述的D-SIFT特征與通過Prewitt算子對原始WLD進行改進的PPWLD特征,將兩種特征向量融合,得到最終特征描述符的人臉表情識別方法。具體步驟如下:

(1) 使用級聯回歸樹提取出人臉圖像的68個關鍵點,根據關鍵點與表情的相關度篩選出51個特征點;

(2) 每個特征點的8×8鄰域劃分為該點對應的patch塊,將每個patch塊分成4×4的子區域,計算每個子區域的梯度直方圖,級聯得到該特征點的4×4×8維D-SIFT特征;

(3) 對人臉圖像劃分出眉毛、眼睛、鼻子和嘴巴4個關鍵表情子區域;

(4) 計算出每個子區域的差分激勵和方向激勵,將得到的2D直方圖轉化為一維直方圖,得到該子區域的M×T×S維描述向量;

(5) 將該圖像的所有子區域的描述向量按照五官分布順序直接進行級聯,得到4×(M×T×S)維的PPWLD特征;

(6) 將D-SIFT特征和PPWLD特征直接級聯得到最終的特征向量。

4 實 驗

4.1 實驗環境

本文實驗環境為Windows 10操作系統,Intel Core i5處理器,8 GB內存,用Python語言實現。

4.2 數據預處理

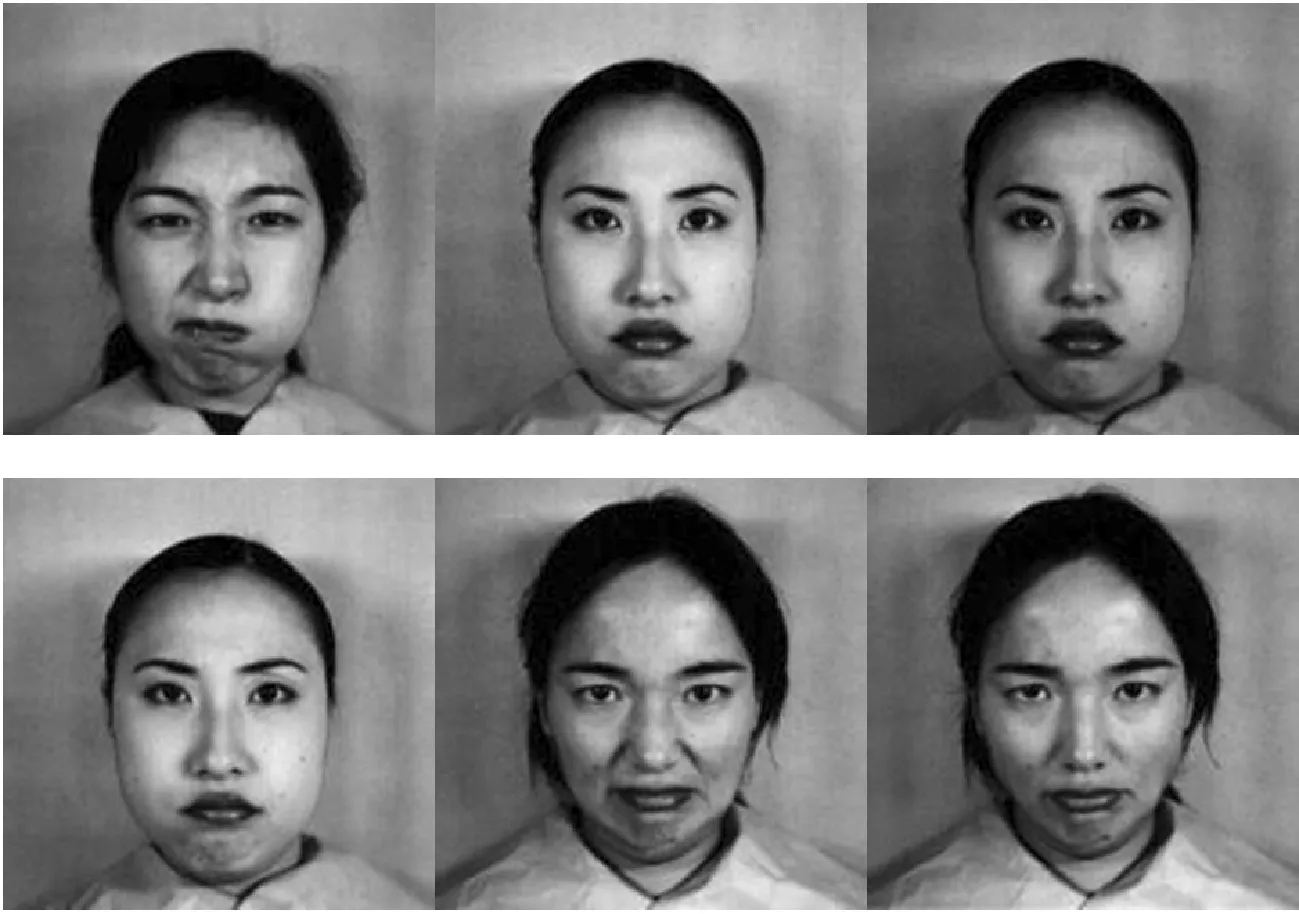

實驗使用JAFFE人臉表情數據集、CK+人臉表情數據集進行測試分析。

(1) JAFFE數據集。JAFFE數據集由10位日本女性的7種基本表情(憤怒、厭惡、恐懼、高興、悲傷、驚訝及中性)構成,每人每種表情包括3~4幅圖像,總共213幅。部分原始圖像如圖6所示。

圖6 JAFFE數據集樣本

(2) CK+數據集。CK+數據集包括123個人,593個表情序列。每個表情序列均從平靜狀態開始,情緒逐漸增強,總共2 940幅。本文選取7種表情(憤怒、蔑視、厭惡、恐懼、快樂、悲傷及驚訝)進行實驗。部分原始圖像如圖7所示。

圖7 CK數據集樣本

首先使用級聯回歸樹在原始圖像上檢測出人臉區域,標記出雙眼位置坐標進行人臉校正,使校正后的每幅圖像的雙眼均處于水平位置。校正效果如圖8所示。

(a) JAFFE數據集

對校正后的人臉圖像進行裁剪,裁去與表情密切度不高的區域。對裁剪后的圖像進行灰度化,得到預處理后的圖像,如圖9所示。

(a) JAFFE數據集

4.3 D-SIFT對比實驗

為了對比D-SIFT特征相對于原始SIFT特征的改進效果,使用JAFFE數據集進行測試。

選取每人每種表情2~3幅圖像進行訓練,余下進行測試。以表情的識別率作為衡量指標,同時使用原始SIFT特征方法與D-SIFT特征描述方法進行實驗,兩種方法的patch尺寸均取16。實驗結果如表1所示。

表1 不同特征方法下的識別率(%)

可以看出,D-SIFT方法的識別率高于SIFT方法,說明先提取關鍵點,并結合Dense-SIFT的改進方法提高了表情識別的識別率,是有效的改進。

4.4 區域分塊PPWLD對比實驗

目前圖像識別領域常用的分塊方法為4×4分塊、行分塊、列分塊及關鍵區域分塊等,考慮到人臉圖像在水平方向具有對稱性,列分塊方式會造成對稱性的損失;同時,表情識別的識別效果和面部五官區域的關聯度較高,因此選擇行分塊和關鍵區域分塊的方法在JAFFE數據集上進行實驗比較。

圖10所示為行分塊的結果圖像,本文采用1、3、6分塊數目下的識別結果進行對比(1行分塊即為原始圖像)。

(a) 3行分塊

圖11所示為關鍵區域分塊的結果圖像(本文選取眉毛、眼睛、鼻子和嘴巴區域作為關鍵表情區域)。

圖11 JAFFE數據集眉眼唇鼻區域結果圖

實驗選取每人每種表情2~3幅圖像進行訓練,余下進行測試。以PPWLD特征描述方法的表情識別率作為衡量每種分塊方式優劣的指標,同時使用WLD特征方法進行同樣的實驗,兩者均使用相同的M、T、S值,以對比PPWLD的改進效果。實驗結果如表2所示。

表2 不同分塊方式下的識別率(%)

可以看出,PPWLD方法的效果整體優于原始WLD方法,說明引入Prewitt算子是有效的改進方法。同時,在PPWLD方法下,行分塊方式在1塊時識別效果最低,僅有64.28%,隨著分塊數目增加,識別率升高,6塊時PPWLD特征描述方法的識別率達到95.24%。與行分塊方式相比,關鍵表情區域分塊方式具有更高的識別率,對WLD方法也有同樣的結論。可知關鍵區域分塊效果優于行分塊方式。因此采用關鍵區域分塊方式進行人臉圖像的表情識別。

4.5 結合D-SIFT與區域PPWLD實驗

4.5.1 在JAFFE數據集的結果分析

隨機將JAFFE數據集與分成5份,每次選擇其中4份為訓練集,余下的作為測試集。采用5折交叉驗證方式進行實驗。

使用patch尺寸為16的D-SIFT特征;使用M=6,T=8,S=3的PPWLD特征。將5次的平均識別率作為在JAFFE數據集上的識別結果。得到的表情識別率如表3所示。

表3 JAFFE數據集的表情識別率(%)

可以看出,本文算法在5次交叉實驗中取得的平均識別率是97.39%,其中憤怒、厭惡、悲傷的錯誤識別相對較多,出現將憤怒識別為中性,將厭惡識別為恐懼的情況,由此檢查原始圖片發現,混淆表情多在五官表達方面有所類似,比如都會撇下嘴角、皺起眉頭,情緒表達十分細微,容易造成誤判。

4.5.2 在CK+數據集的結果分析

隨機將CK+數據集分成5份,每次選擇其中4份為訓練集,余下的作為測試集。采用5折交叉驗證方式進行實驗。使用patch尺寸為16的D-SIFT特征;使用M=6,T=8,S=3的PPWLD特征。將5次的平均識別率作為在CK+數據集上的識別結果。實驗得到表情識別率如表4所示。

表4 CK+數據集的表情識別率(%)

可以看出,本文算法在5次交叉實驗中取得的平均識別率是99.35%,其中憤怒和蔑視的錯誤識別相對較多,出現將憤怒識別為恐懼,將蔑視識別為悲傷的情況,由此查看原始圖片發現誤識別的表情在情緒的表達中都有皺眉頭、皺鼻子的表現,識別時容易出現誤判。

4.6 與其他方法進行對比

將本文算法和其他表情識別算法進行比較,結果見表5。

表5 不同算法的分類準確率對比(%)

可以看出,本文算法在JAFFE數據集的識別率低于在CK+數據集上的識別率,這或許是因為JAFFE數據集是針對日本女性采集,而亞洲人的表情相對來說比較含蓄,不像CK+中包含的歐洲等國家的人的表情情緒明顯。同時,在JAFFE數據集和CK+數據集的識別率優于其他對SIFT特征和WLD特征方法進行改進的方法,與同樣利用Dense-SIFT進行改進的方法相比,具有更高的識別率;相較于兩種卷積神經網絡方法的識別率也具有一定優勢。

與單獨使用D-SIFT方法及單獨使用區域PPWLD方法的表情識別率對比,結合區域PPWLD和D-SIFT的識別效果更優,證明利用兩者結合的改進是有效的。

5 結 語

針對傳統SIFT特征方法提取的特征點數目過多、位置隨機,快版SIFT對表情識別針對性不足,以及傳統WLD特征算法無法充分反映圖像灰度變化的空間分布結構信息,容易受噪聲干擾的問題,提出結合D-SIFT特征描述和PPWLD特征描述的表情識別方法。將特征點D-SIFT特征和關鍵表情區域PPWLD特征進行融合,使用SVM分類器分類。實驗在CK+和JAFFE數據集分別得到99.35%和97.39%的識別率,說明本文方法在改進原有方法的不足的同時取得了較高識別率。然而,即使提前定位特征點已經對SIFT算法的計算量進行減少,D-SIFT方法的計算量相比于其他方法而言仍舊略高,如何進一步降低計算量同時保持較高識別率仍有待研究;對于本身具有一定相似性的表情,會造成誤差的微表情的區分也需要加強。