基于Transformer編碼器的智能電網虛假數據注入攻擊檢測

陳 冰 唐永旺

1(河南工業大學漯河工學院電氣電子工程系 河南 漯河 462000) 2(中國人民解放軍戰略支援部隊信息工程大學信息系統工程學院 河南 鄭州 450002)

0 引 言

智能電網以其可靠、高效和經濟的傳輸特點成為現代電力系統最重要的組成部分,然而智能電網嚴重依賴數據通信和大規模數據處理技術,容易遭到各種惡意網絡攻擊[1]。盡管已經頒布了很多針對智能電網安全的通信標準、官方指南和監管法律(如IEC 61850-90-5、NISTIR7628等),惡意網絡攻擊仍活躍于智能電網中。

虛假數據注入攻擊(False Data Injection Attacks,FDIA)是Liu等[2]提出的惡意網絡攻擊技術,被證明是一種對智能電網狀態估計產生嚴重影響的惡意網絡攻擊行為。其通過規避現有數據注入監測系統,篡改電網的狀態估計數據,誘導電網控制中心作出錯誤決策,導致整個智能電網出現故障。如何高效地檢測 FDIA,對于保障智能電網安全運行具有重要意義。

傳統的FDIA檢測思路主要歸為兩種[3-4]。一種是策略性的保護部分關鍵基礎測量數據的安全,避免惡意數據注入的發生。如:Kim等[5]提出兩種快速貪婪算法分別用于選擇待保護的測量子集數據和尋找存儲安全相量測量單元的位置。Bi等[6]利用圖形分析研究方法引入到FDIA檢測中,提出精確、低復雜度的近似算法來選擇保護系統中最小的數據測量值。另一種是通過獨立檢驗每個狀態變量進行FDIA檢測。例如:Liu等[7]考慮到電網狀態時間測量的內在低維度以及FDIA的稀疏性質,將FDIA檢測視為低秩矩陣分離問題,并提出核規范最小化和低秩矩陣分解兩種優化方法來解決該問題。Ashok等[8]提出了一種在線FDIA檢測算法,該算法利用統計信息和狀態變量的預測來檢測量測異常。

近年來隨著智能電網通信數據量級的增加和FDIA方法的不斷升級,傳統方法在進行FDIA檢測時越來越力不從心。機器學習以及深度學習算法逐漸應用在智能電網惡意網絡攻擊檢測中,并較傳統檢測方法檢測性能有明顯提高[9-13]。Ozay等[14]利用監督和半監督機器學習方法完成對高斯分布式攻擊的分類。Esmalifalak等[15]設計了一種基于分布式支持向量機的標簽數據模型和一種無監督學習的統計異常檢測器。He等[11]采用條件深度信念網絡有效學習了FDIA的高維時間行為特征。Niu等[16]利用卷積神經網絡提取和長短時記憶網絡(Long Short Term Memory Network,LSTM)學習量測狀態序列的時間和空間關系特征,進而實現FDIA檢測。James等[17]基于小波變換和單向門控循環單元(Gated Recurrent Unit,GRU)進行系統狀態連續估計,檢測序列狀態中的FDIA。Wang等[18]利用3層LSTM作為序列編碼器,學習FDIA樣本的特征,在測試數據中準確率高達90%。深度學習算法可以自動學習電網中各節點的狀態量測數據特征,發現異常狀態序列或對異常序列分類,整個過程不需要人工設定特征。

然而,現有基于循環神經網絡[16-18](Recurrent Neural Network,RNN)的FDIA檢測方法在訓練量測值時僅使用了多層單向的RNN訓練框架,單向的RNN模型在處理序列數據時只能利用已經出現過的序列元素,忽略了未來的序列信息,導致模型性能下降,影響特征最終的提取效果。這些方法中只選取RNN最后一個時刻的隱狀態或者各時刻隱狀態的拼接作為提取的特征,無法突出注入攻擊數據的特征。因為注入攻擊向量不一定會對狀態量測數據的每一維都均勻地注入攻擊,有可能只對一部分維數的數據進行攻擊。另外,這些方法只針對單個樣本參數(電壓、電流、有用功、支路電流等)進行分析,沒有考慮連續時間樣本參數之間的關聯關系。再者,RNN的順序性決定其訓練緩慢,因為長序列需要更多的處理步驟,反復循環的結構也使訓練更加困難。

Transformer[19]是當前機器翻譯領域的主流模型,利用基于注意力機制的編碼器和解碼器直接學習源語言內部關系和目標語言內部關系。相較于RNN,Transformer無循環結構,可以并行處理序列中的所有元素,從整個樣本序列中挖掘與當前預測元素關系緊密的上下文元素,Transformer編碼器具有更強的特征提取能力。

考慮到Transformer以上優點以及量測數據序列元素互相依賴、關系緊密的特點,本文提出一種基于Tansformer編碼器的FDIA檢測框架,輸入兩個連續時間量測樣本,對后一時刻的樣本進行檢測。首先,對連續時間樣本數據進行歸一化處理,結合連續時間樣本中元素相對位置信息得到連續時間樣本向量。然后,采用Tansformer編碼器對量測序列進行建模,通過多頭自注意力機制計算長距離依賴關系,挖掘結合樣本中和樣本間測量值的特征表示。最后,將該特征表示輸入到全連接神經網絡層和Softmax層,輸出后一時刻樣本受到注入攻擊的概率,完成FDIA檢測。

1 相關背景

1.1 虛假數據注入攻擊

在電力系統中,待估計的狀態變量包括電壓幅值V∈Rn和相位角θ∈([-π,π])n,n是總線數量。令z=[z1,z2,…,zm]T∈Rm表示量測向量,x=[x1,x2,…,x2n]T∈R2n代表狀態變量,e=[e1,e2,…,em]T∈Rm代表量測誤差向量。在標準直流系統下,可忽略電阻,電壓幅值均為1,僅考慮帶有相位角的狀態變量,量測值和狀態變量的關系如式(1)所示。

z=Tx+e

(1)

式中:T是m×n的拓展結構雅可比矩陣。求使加權殘差平方和最小的狀態估計變量x,目標函數如式(2)所示。

j(x)=(z-Tx)TR-1(z-Tx)

(2)

式中:R是協方差矩陣。利用加權最小二乘法求解式(2)的目標函數,如式(3)所示。

(3)

1.2 注意力機制

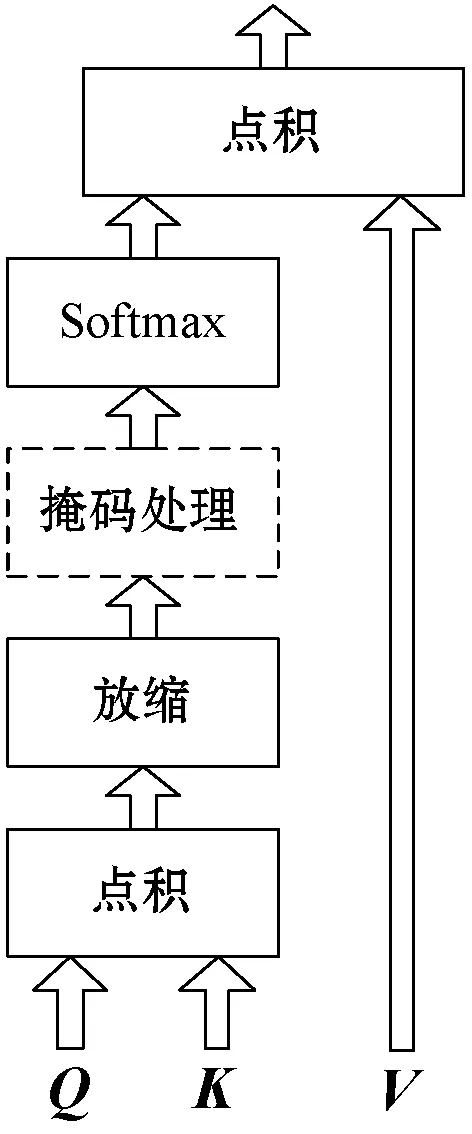

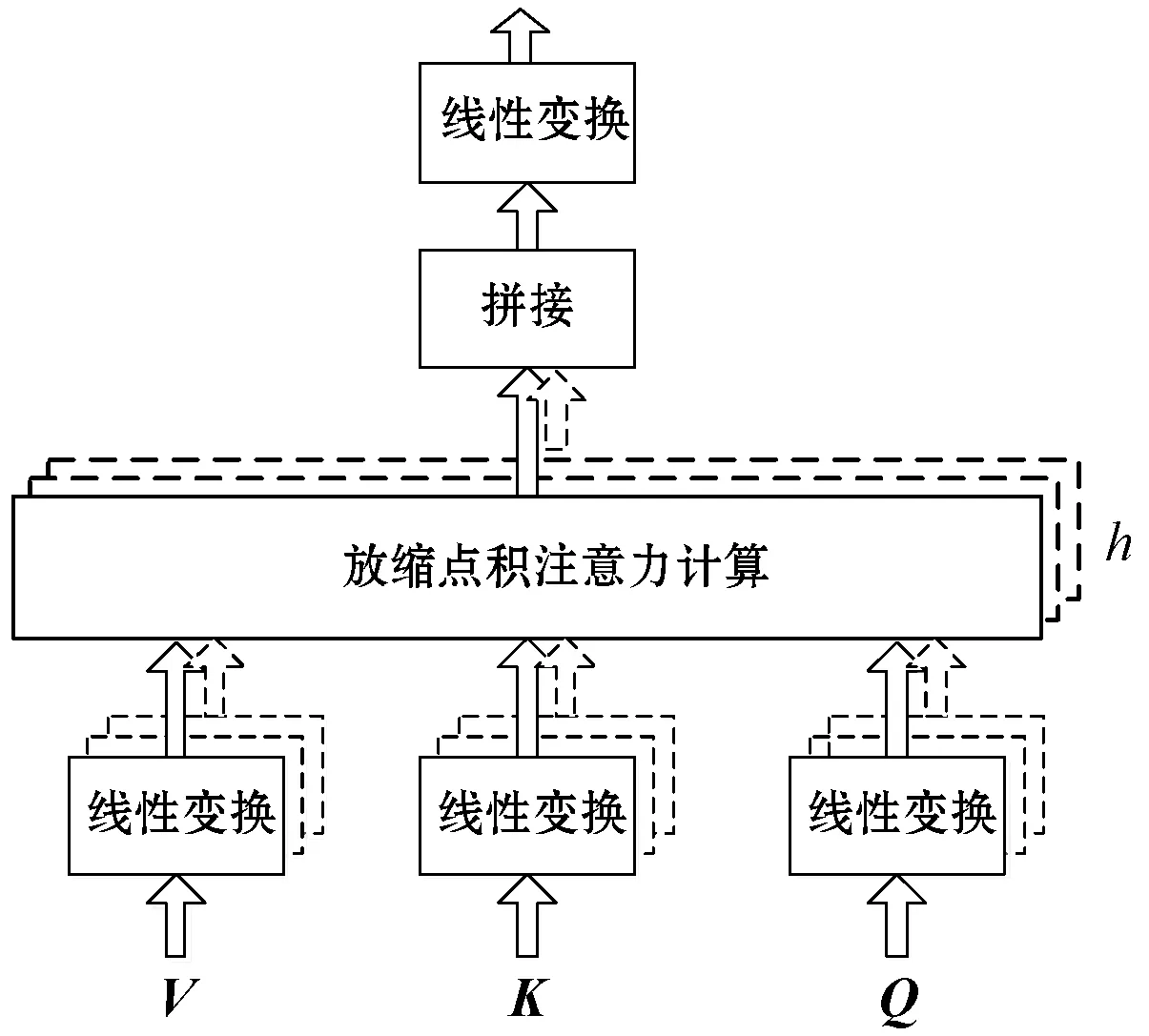

注意力機制的本質是將一個查詢向量和一組鍵值向量對映射到輸出,查詢向量與鍵向量用于計算每個值向量對應的權重,值向量的加權和為輸出。常用的注意力函數為加法注意力(additive attention)和點乘注意力(dot-product attention)[21],由于點乘注意力可以利用高度優化的矩陣乘法運算,高效且更加節省空間,因此本文選取放縮點積注意力,其計算流程如圖1所示,其中:Q代表查詢向量矩陣;K代表鍵向量矩陣;V代表值向量矩陣;Q和K中每個向量的維度為dk,V中每個向量維度為dv。

圖1 放縮點積注意力計算流程

(4)

2 基于Transformer的FDIA檢測方法

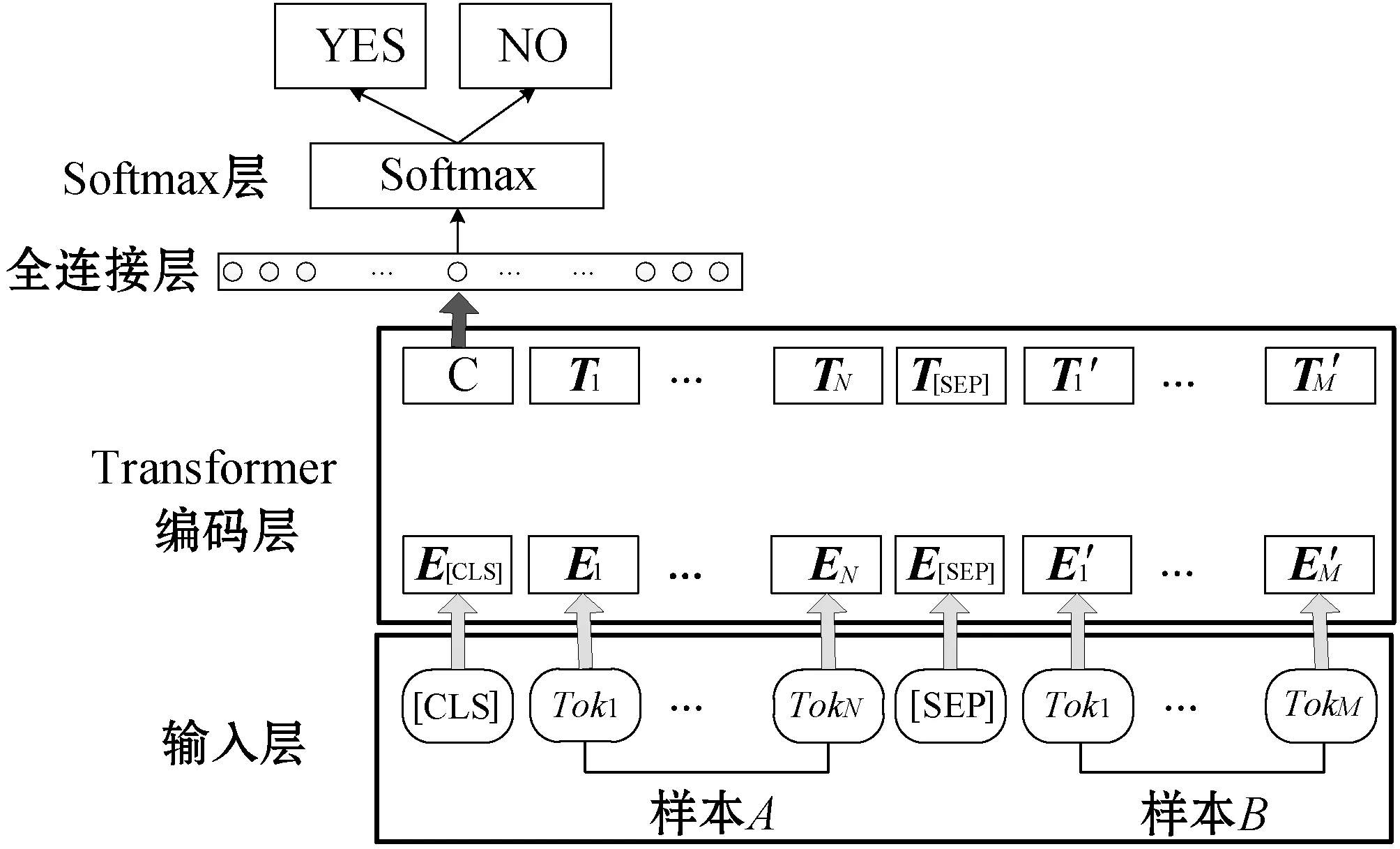

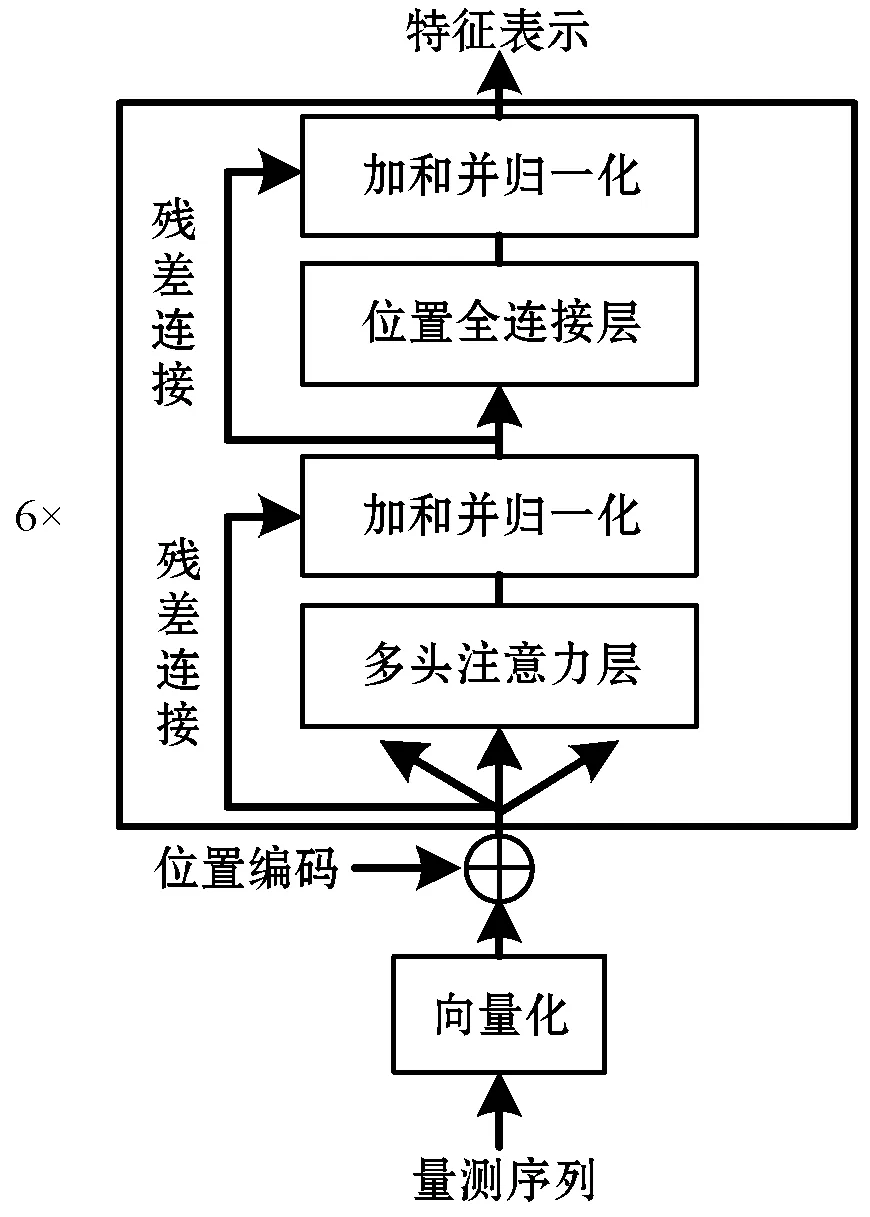

本文利用Transformer編碼器提取攻擊樣本的特征,提出基于Transformer編碼器的FDIA檢測框架,其訓練結構如圖2所示。

圖2 本文提出的FDIA檢測模型框架

該框架主要分為輸入層、Transformer編碼層、全連接層和Softmax層四大部分,[CLS]是樣本之間的分類符,表示樣本A之后的連續時間樣本B是否受到虛假數據注入攻擊。[SEP]是樣本之間的分隔符,為便于區分連續時間樣本的切割點。該訓練框架將連續時間樣本A、B作為模型輸入,通過Transformer編碼層提取單樣本各測量值之間的特征和兩個連續時間樣本A、B整體之間的特征,用于判斷樣本B是否被注入攻擊。

2.1 輸入層

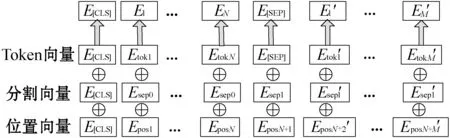

輸入層的作用是將樣本A、B向量化,將Toki的向量、相應的位置向量、分割向量進行求和[22],如圖3所示。

圖3 輸入層向量化的過程

由于Transformer編碼器中沒有循環或者卷積結構,無法使用序列元素的位置信息,因此對序列編碼時需要添加位置信息。相對位置編碼表示如下:

PE(pos,2i)=sin(pos/10 0002i/dmodel)

(5)

PE(pos,2i+1)=cos(pos/10 0002i/dmodel)

(6)

式中:pos代表位置;i代表維度。相對位置編碼的每個維度均采樣于正弦曲線,根據式(7)和式(8)可知任意位置的編碼PE(pos+k)都可由PE(pos)的線性函數表示,該特點為模型捕捉序列元素之間的相對位置關系提供便利。

sin(α+β)=sinαcosβ+cosαsinβ

(7)

cos(α+β)=cosαcosβ-sinαsinβ

(8)

2.2 Transformer編碼層

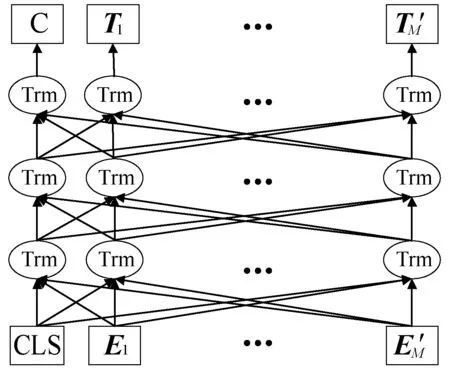

Transformer編碼層由三層的雙向Transformer編碼器構成,具體結構如圖4所示。

圖4 Transformer編碼層

圖4中每個Trm均代表一個Transformer編碼器;Ei表示輸入的詞向量,由Toki的向量、位置向量、分割向量的和組成;Ti表示第i個Token在經過Transformer編碼層處理之后得到的特征向量,其模型結構如圖5所示。

圖5 Transformer編碼器

Transformer編碼器由6個相同的編碼層堆疊而成,每個編碼層又包括兩個子層,分別為多頭自注意力層和位置全連接層。為了更好地優化深度網絡,整個網絡使用了殘差連接和層歸一化。因此,每層輸出可以表示為LayerNorm(x+Sublayer(x)),其中Sublayer(x)為各層的功能函數。為了使模型正常訓練,模型中的所有子層以及嵌入層都需要產生維度dmodel的輸出。

(1) 多頭注意力機制。一次自注意力計算關注到的序列關系有限,而量測數據中的功率、電壓、電流、有用功率、無用功率、總功率和分支功率等數據之間關系多樣,因此本文采用多頭注意力使編碼器同時關注來自不同位置的不同表示子空間的信息,其具體計算流程如圖6所示。

圖6 多頭注意力機制計算流程

圖6中,首先將Q、K、V線性變換后分h次輸入到放縮點乘注意力模型,h即為多頭注意力的頭數,每次線性變換的參數矩陣不同。然后將h次的放縮點積注意力結果拼接后再進行一次線性變換得到多頭注意力的結果。計算公式如下:

Multihead(Q,K,V)=Concat(head1,head2,…,headh)WO

(9)

(10)

(2) 位置全連接前饋網絡。位置全連接前饋網絡分兩層,用于處理每個位置的多頭注意力計算結果,其輸入和輸出的維度相同。第一層的激活函數是ReLU,第二層是線性激活函數,如果多頭注意力層輸出表示為X,則FFN可表示為:

FFN(x)=max(0,XW1+b1)W2+b2

(11)

式中:W1、b1和W2、b2分別是兩個激活函數的參數。Transformer編碼器通過對輸入的序列不斷進行注意力機制層和普通的非線性層交疊得到最終的序列表示。

2.3 全連接層和Softmax層

對于量測數據訓練集C,給定輸入樣本A:x1,x2,…,xN,樣本B:x1,x2,…,xM和對應標簽y。[CLS]在最后一個Transformer編碼器的隱藏層輸出記為C∈Rdmodel,經過全連接層和Softmax層后對y進行預測:

P(y|||x1,x2,…,xN,x1,x2,…,xM)=Softmax(CWf+b)

(12)

式中:Wf是全連接層的權重矩陣;b為偏置;P(y|||x1,x2,…,xN,x1,x2,…,xM)是Softmax層計算的概率結果。則模型訓練的目標為最大化目標函數L(C):

(13)

FDIA檢測模型訓練完畢后,就可以對連續時間的量測數據樣本進行檢測。

3 實 驗

3.1 實驗數據

本文選擇該領域主流的IEEE 14-bus和IEEE 30-bus節點測試系統作為測試環境,系統網絡拓撲、節點數據、支路參數等均從Matpower中獲得。在每個環境中利用Matpower軟件仿真生成150 000對連續時間的正常量測數據樣本和50 000對后一時刻量測值被注入攻擊的樣本,標簽分別為-1和1。IEEE 14-bus中每個樣本包括54個量測值,IEEE 30-bus中每個樣本包括112個量測值。每個測試系統的量測值包括電壓幅值、總線相位角、總線注入有功功率和無功功率、各支路注入有功功率和無功功率等,將正常樣本和FDIA樣本進行去均值和歸一化處理,分別按照7 ∶3的比例隨機抽取樣本制作訓練集和測試集。

3.2 評測標準

本文采用準確率、漏報率和誤報率三個FDIA檢測領域通用的評測指標驗證本文方法的可行性和有效性,首先定義以下變量:

真負類(Ture Negative)表示將正常量測樣本正確地識別成正常量測樣本的數量,記為Tn。

假負類(False Negative)表示將正常量測樣本誤識別成FDIA樣本的數量,記為Fn。

真正類(Ture Positve)表示將FDIA樣本正確地識別成FDIA樣本的數量,記為Tp。

假正類(False Positive)表示將FDIA樣本誤識別成正常量測樣本的數量,記為Fp。

(1) 準確率(記為Ac)計算表達式為:

(14)

式(14)表示所有被正確判斷的樣本數量占所有樣本的百分比,準確率越高,算法越好。

(2) 正報率計算表達式為:

(15)

式(15)表示在所有被檢測為FDIA樣本中,被正確預測FDIA樣本所占的百分比。正報率越高,算法越好。

(3) 誤報率計算表達式為:

(16)

式(16)表示在所有被檢測為正常樣本中,被錯誤預測樣本所占百分比,誤報率越高,算法越差。

3.3 實驗設置與分析

本文選取文獻[15,18]的方法作為對比方法,文獻[15]利用標簽數據的監督學習訓練分布式支持向量機對FDIA樣本檢測,測試結果記為SVM;選取文獻[18]提出的方法,基于三層雙向LSTM模型學習單個樣本狀態量測值序列的特征,測試結果記為Bi-LSTM。另外,將三層雙向Transformer編碼器作為編碼器,測試結果記為Bi-TRAM。

本文方法首先分別將IEEE 14-bus和IEEE 30-bus環境中獲取的單個樣本歸一化處理為60維和120維(54維和112維數據通過補零變為60維和120維,方便后續處理)的序列向量,則輸入為120維和240維的連續時間序列向量。使用TensorFlow深度學習框架構造模型結構。根據模型訓練經驗,選取多頭注意力的頭數為10,在訓練IEEE 14-bus環境樣本時dk=dv=dmodel/h=6,在訓練IEEE 30-bus環境樣本時,dk=dv=dmodel/h=12,全連接層的隱藏節點數量為768。優化算法選取Adam[23],令β1=0.9,β2=0.98,ε=10-9,epochs設置為100,每批數據batch_size大小為256,學習速率為2e-5,本文連續時間樣本訓練的方法測試結果記為CON-TRAM。

實驗硬件配置為Intel Xeon E5-2650,128 GB內存的服務器、配備12 GB的雙GTX 1080Ti獨立顯卡進行加速訓練。

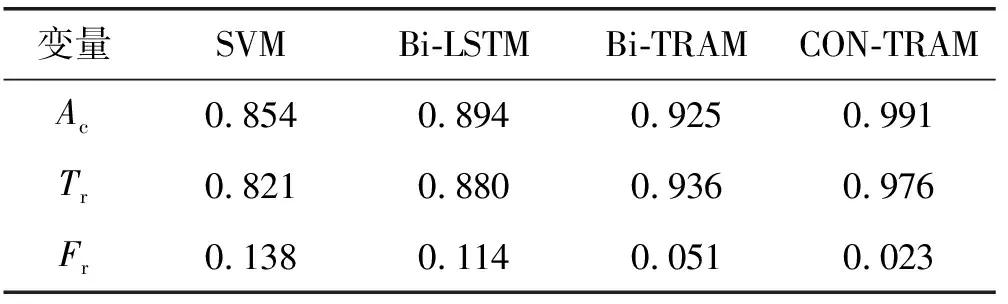

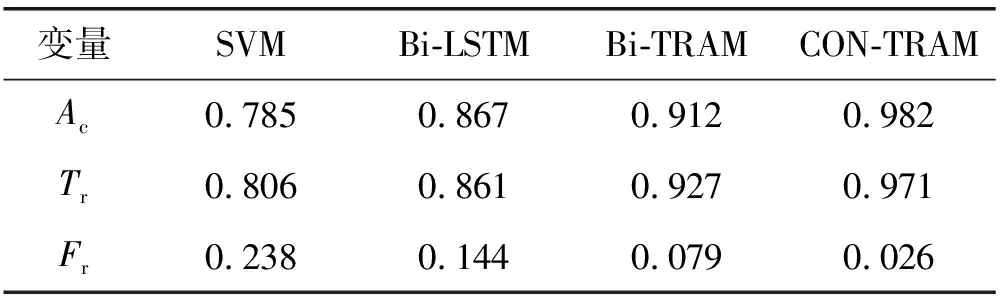

(1) 綜合對比實驗。本文方法與各對比方法測試結果如表1和表2所示。

表1 IEEE 30-bus綜合實驗結果

表2 IEEE 14-bus綜合實驗結果

可以看出,Bi-LSTM的測試結果優于SVM,這是因為RNN網絡在處理高維度序列數據方面比SVM更有優勢。Bi-LSTM在計算時刻t的隱狀態時只利用了量測序列前向t-1時刻和后向t+1時刻的隱狀態,而基于自注意力機制的Transformer編碼器可以同時利用所有時刻的隱狀態,可以輕松捕獲長距離的特征,提取量測序列中電壓、電流、功率、有用功、無用功、輸入功率、輸出功率等多種序列關系特征,經過多頭注意力層和位置全連接層的多次迭代訓練,最終得到量測序列的向量表示。該向量表示可以更加準確地代表量測樣本,因此Bi-TRAM三項的評測指標優于Bi-LSTM。本文CON-TRAM不僅關注樣本內部特征,還著重考慮了連續時間樣本之間的關聯特征,利用正常連續內電壓、電流、功率、有用功、無用功、輸入功率、輸出功率等變化的特征判斷注入攻擊行為。因此CON-TRAM的測試結果與對比方法相比有較顯著的提升,與次優結果相比,準確率平均提高7.41%,正報率平均提高4.51%,誤報率平均降低60.99%。

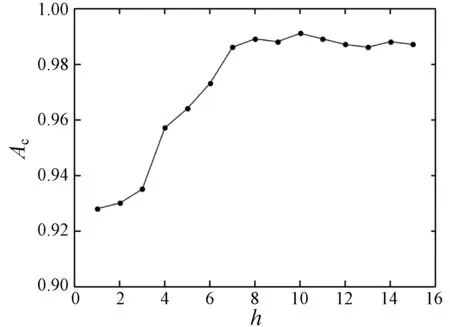

(2) 多頭注意力機制中頭數h的分析。多頭注意力計算中頭數h是Transformer編碼器的關鍵一步,因此本節以IEEE 30-bus環境的實驗數據分析h對FDIA檢測的影響。令h在[0,15]內取值,以1為步長訓練FDIA檢測模型,在測試集進行檢測任務,以評測指標準確率分析,結果如圖7所示。

圖7 準確率隨著h的變化分析

可以看出,在[0,10]的區間內,準確率的總體趨勢是隨著h的增加而增加,從FDIA樣本提取的特征關系也越來越多樣,說明多頭注意力機制對提升檢測性能有重要作用。當h為10時達到峰值,隨后趨于平穩,可以推測量測樣本數據中的電壓幅值、總線相位角、總線注入有功功率和無功功率、各支路注入有功功率和無功功率等有10種左右的內在關系,符合數據的真實特征。

4 結 語

本文通過引入Transformer編碼器,解決了當前基于單向多層RNN的FDIA檢測方法中無法同時利用樣本序列前后參數信息的問題。另外,本文提出基于連續時間的量測樣本訓練FDIA檢測模型,利用連續時間樣本之間的關聯特征進行檢測,提高了FDIA檢測性能。下一步準備在電網節點規模更大的模擬環境中測試本文方法的有效性。