基于多尺度標(biāo)簽傳播的小樣本圖像分類

汪 航 田晟兆 唐 青 陳端兵,3,4

1(電子科技大學(xué)大數(shù)據(jù)研究中心 成都 611731) 2(中國石油西南油氣田分公司通信與信息技術(shù)中心 成都 610051) 3(成都數(shù)之聯(lián)科技股份有限公司 成都 610041) 4(四川省社會科學(xué)數(shù)字文化與傳媒重點研究基地 成都 611731)

隨著科技的不斷發(fā)展以及大數(shù)據(jù)時代的到來,深度學(xué)習(xí)(deep learning)[1]作為機(jī)器學(xué)習(xí)領(lǐng)域中的一個重要分支,在技術(shù)層面上得到了快速發(fā)展,并在人工智能領(lǐng)域取得了重大突破,尤其是在計算機(jī)視覺[2]、語音識別[3]、文本分類[4]以及對抗博弈[5]等方面取得了巨大的成功.一般來說,深度學(xué)習(xí)的成功歸因于3個因素:強(qiáng)大的計算資源(GPU,TPU)、先進(jìn)的模型算法(卷積神經(jīng)網(wǎng)絡(luò)[2])和大型數(shù)據(jù)集(ImageNet[6],Pascal-VOC[7]).然而在某些特定的應(yīng)用場景,例如醫(yī)療、軍事[8]和金融等領(lǐng)域,由于隱私、安全性等原因,不太可能獲得大量數(shù)據(jù),即使存在大量數(shù)據(jù),在對數(shù)據(jù)進(jìn)行有效標(biāo)注時將耗費大量人力、物力,無法獲取足夠的帶標(biāo)簽的訓(xùn)練樣本.在數(shù)據(jù)樣本較少時,深度學(xué)習(xí)容易產(chǎn)生過擬合.與之相反,人類可以在數(shù)據(jù)樣本較少的情況下快速學(xué)習(xí)新事物.例如:一個孩子從未見過斑馬,但如果給他看過1張或幾張斑馬的照片后,當(dāng)他去動物園看到真正的斑馬后,可以馬上認(rèn)出動物園里的斑馬是他曾經(jīng)在圖片上見到過的“斑馬”.這就是人類與機(jī)器的區(qū)別,人類可以通過一組非常少的樣本學(xué)習(xí)新事物,但機(jī)器需要大量的實例來學(xué)習(xí)事物特征.因此,如何利用少量樣本,使深度學(xué)習(xí)模型能夠有效學(xué)習(xí)和泛化,讓機(jī)器學(xué)習(xí)的性能更加接近人類思維,成為目前深度學(xué)習(xí)領(lǐng)域中亟待解決的問題,該問題被稱為小樣本學(xué)習(xí)(few-shot learning, FSL).

為了解決小樣本學(xué)習(xí)這一難題,研究人員提出了多種方法,這些方法大致分為2類:度量學(xué)習(xí)和元學(xué)習(xí).一般來說,度量學(xué)習(xí)[9-17]是學(xué)習(xí)成對的相似性度量S(·),在這種度量下,相似的樣本對具有較高的得分,不相似的樣本對具有較低的得分;元學(xué)習(xí)[18-24]主張跨任務(wù)學(xué)習(xí),并且所有任務(wù)均遵循相同的任務(wù)范式,通過在不同任務(wù)上學(xué)習(xí)后適應(yīng)新任務(wù),即在任務(wù)層面進(jìn)行學(xué)習(xí)而不是在樣本層面,并且學(xué)習(xí)與任務(wù)無關(guān)的模型,而不是特定于任務(wù)的模型.其中,度量學(xué)習(xí)可看作是元學(xué)習(xí)的一種特殊形式,通過元學(xué)習(xí)跨任務(wù)的形式進(jìn)行相似性度量,使度量結(jié)果可以在不同的任務(wù)之間傳遞,并且2類方法都在小樣本圖像識別領(lǐng)域取得了不錯的成果.但這些方法主要關(guān)注關(guān)系度量、外部知識轉(zhuǎn)移和優(yōu)化表示等,并沒有解決小樣本圖像識別的根本問題:低數(shù)據(jù)(low-data),即缺少足夠的訓(xùn)練樣本或特征.為解決低數(shù)據(jù)問題,Liu等人[25]提出了標(biāo)簽傳播網(wǎng)絡(luò)(transductive propagation network, TPN),通過直推式學(xué)習(xí)方法假設(shè)查詢集(未標(biāo)記數(shù)據(jù))為測試數(shù)據(jù),并且將支持集和查詢集數(shù)據(jù)通過嵌入網(wǎng)絡(luò)映射到向量空間,計算其相似度,將標(biāo)簽從支持集傳播到查詢集,該方法為使用直推式學(xué)習(xí)的方法.隨后Li等人[13]提出了深度近鄰神經(jīng)網(wǎng)絡(luò)(deep nearest neighbor neural network, DN4),通過比較圖像與類別之間的局部描述子(local descriptor)來尋找與輸入圖像最接近的類別,將其作為查詢樣本的標(biāo)簽.Xue等人[14]提出了區(qū)域比較網(wǎng)絡(luò)(region compare network, RCN),學(xué)習(xí)支持集和查詢集圖像中相互關(guān)聯(lián)的特定區(qū)域用于識別查詢集的類別.Wang等人[15]提出了基于特征融合和加權(quán)多尺度決策網(wǎng)絡(luò)(multi-scale decision network, MSDN),利用多尺度度量信息,通過投票對查詢集進(jìn)行分類;Chen等人[16]提出多尺度自適應(yīng)任務(wù)注意機(jī)制網(wǎng)絡(luò)(multi-scale adaptive task attention network, MATANet),通過生成不同尺度上的多個特征查看整個任務(wù)的上下文,學(xué)習(xí)不同尺度上與任務(wù)相關(guān)的局部特征,通過相似度量模塊獲得查詢集分類結(jié)果.Yu等人[17]提出的回溯網(wǎng)絡(luò)(looking-back network),通過在特征提取網(wǎng)絡(luò)中利用其多層內(nèi)部特征捕獲其他信息,提高預(yù)測性能.在標(biāo)簽傳播算法方面,Liu等人[25]開創(chuàng)性地提出了標(biāo)簽傳播網(wǎng)絡(luò)算法用于將支持集樣本之間的相似度傳播到查詢集樣本;Yu等人[17]在文獻(xiàn)[25]的研究基礎(chǔ)上,利用淺層卷積層提取的特征進(jìn)行標(biāo)簽傳播,但其傳播的分類結(jié)果僅用于更新模型權(quán)重,并沒有將其作為分類結(jié)果中的一部分,無法衡量淺層特征對分類結(jié)果的重要性.在多尺度算法方面,Li等人[13]認(rèn)為將1張圖片的特征信息壓縮到1個特征圖會損失許多有區(qū)分度的信息,即將1張圖片通過卷積神經(jīng)網(wǎng)絡(luò)獲得的表示圖片的3維特征向量(C,H,W)進(jìn)行flatten操作,其中C表示通道數(shù),H表示高度,W表示寬度,用C×H×W個1×1的小特征圖表示圖像會丟失許多圖像信息,而采用多個局部描述子可以有效避免信息丟失問題,因為每一個局部描述子都充分利用多尺度通道信息,即將圖像特征reshape為(H,W,C)后,共有H×W個C維局部描述子用于表示圖像特征.Xue等人[14]借鑒局部描述子的思想,通過對不同圖像之間局部描述子的相似性比較獲得相似性得分,從而推斷數(shù)據(jù)類別.盡管局部描述子在通道上增加了對特征的度量,但其僅是在一個尺度大小上通過利用多通道信息,其分類結(jié)果仍具有一定偏差.而Wang等人[15]同樣利用淺層卷積層提取的特征進(jìn)行相似性度量,并將每一個淺層度量結(jié)果與深層度量結(jié)果結(jié)合,通過投票策略獲得最終分類結(jié)果,但通過分析發(fā)現(xiàn),往往深層特征的度量結(jié)果在投票中會占據(jù)主導(dǎo)地位.Chen等人[16]通過設(shè)計深層多尺度提取器提取多組深層特征,用多組深層特征度量取代淺層特征度量,并通過1維卷積自適應(yīng)融合方式融合多組深層度量結(jié)果,獲得最終分類結(jié)果,有效提高了分類準(zhǔn)確率.

通過文獻(xiàn)[13-17,25]的分析可以發(fā)現(xiàn),小樣本學(xué)習(xí)可以通過附加信息(即多尺度信息)緩解低數(shù)據(jù)帶來的問題.目前常用的多尺度信息僅通過特征提取器中淺層卷積獲得,該信息僅包括圖像的淺層信息(如邊角、紋理、顏色等),即目前大多數(shù)方法僅通過特征提取器中的不同卷積層獲得多尺度的附加信息,該附加信息與深層信息相比,其無法表達(dá)特定圖像復(fù)雜的特征.為了更好地獲得圖像的深層特征,并將深層特征用于相似度計算并與標(biāo)簽傳播算法相結(jié)合,本文以標(biāo)簽傳播算法為基礎(chǔ),提出了基于多尺度標(biāo)簽傳播網(wǎng)絡(luò)(multi-scale label propagation network, MSLPN)的度量學(xué)習(xí)模型,利用多尺度生成器生成不同尺度的特征,捕獲多尺度附加信息,緩解低數(shù)據(jù)問題.具體而言,首先,通過多尺度生成器生成不同尺度的圖像特征;其次,計算在各個尺度上的特征與特征之間的高斯相似度,并利用該多尺度度量信息進(jìn)行標(biāo)簽傳播,獲得不同尺度下的標(biāo)簽傳播分?jǐn)?shù);再次,集成不同尺度下的標(biāo)簽傳播分?jǐn)?shù)獲得最終的標(biāo)簽傳播分?jǐn)?shù)和分類結(jié)果;最后,所有訓(xùn)練參數(shù)都通過反向傳播進(jìn)行端到端的更新.

本文的主要貢獻(xiàn)包括3個方面:

1) 提出了一種新的度量學(xué)習(xí)方法,利用多尺度生成器生成不同尺度的特征,即從不同粒度上捕獲圖像的內(nèi)在特征.與現(xiàn)有研究中僅通過特征提取器獲得的特征相比,多尺度特征能從不同角度對支持集和查詢集數(shù)據(jù)進(jìn)行相似性度量.

2) 采用類似于關(guān)系網(wǎng)絡(luò)[12]的度量模塊對特征相似度進(jìn)行度量,即在場景訓(xùn)練的過程中通過神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)的方式進(jìn)行相似性度量.該方式不僅能更好地適應(yīng)小樣本圖像分類中的不同任務(wù),還可以將其作為一個用于衡量樣本與樣本之間相似度的特定模塊,取代傳統(tǒng)的距離函數(shù)(如余弦距離、歐氏距離等)相似性度量方法.

3) 利用多尺度信息的標(biāo)簽傳播結(jié)果,通過簡單的加權(quán)計算方式獲得最后的標(biāo)簽傳播分?jǐn)?shù)及分類結(jié)果.分類效果優(yōu)于已有算法結(jié)果.

1 相關(guān)工作

1.1 基于度量學(xué)習(xí)的方法

在小樣本學(xué)習(xí)中,度量學(xué)習(xí)的通用方法是在特征嵌入空間中,通過相似性度量模塊對支持集和查詢集的特征嵌入進(jìn)行相似性比較,其中,相似性度量模塊只要能夠估計樣本或特征之間的成對相似度即可.一般的相似性度量模塊可以是簡單的距離函數(shù)度量、復(fù)雜的網(wǎng)絡(luò)度量或其他可行的度量方法.Koch等人[9]提出孿生神經(jīng)網(wǎng)絡(luò)(siamese neural network),通過共享權(quán)重的卷積神經(jīng)網(wǎng)絡(luò)度量樣本之間的相似性,用于解決one-shot問題,該網(wǎng)絡(luò)是將深度神經(jīng)網(wǎng)絡(luò)引入小樣本學(xué)習(xí)的研究.Vinyals等人[10]提出匹配網(wǎng)絡(luò)(matching network),通過使用不同的長短期記憶網(wǎng)絡(luò)(long short term memory, LSTM)對支持集和查詢集進(jìn)行編碼,并使用基于注意力的加權(quán)度量函數(shù)度量特征之間的相似度.Snell等人[11]提出原型網(wǎng)絡(luò)(prototypical network),其核心觀點為每個類別的數(shù)據(jù)在嵌入空間中都存在一個特征向量原型(類別中心點),通過計算支持集的特征均值來學(xué)習(xí)嵌入空間,以獲得每類的原型表示,利用距離函數(shù)計算查詢集與原型的距離獲得分類結(jié)果.Sung等人[12]提出關(guān)系網(wǎng)絡(luò)(relation network),采用可學(xué)習(xí)的卷積神經(jīng)網(wǎng)絡(luò)度量特征相似性,取代傳統(tǒng)的非參數(shù)度量方法.文獻(xiàn)[9-12]所提的方法都是基于圖像級的特征計算,而Li等人[13]提出的深度最近鄰網(wǎng)絡(luò)、Xue等人[14]提出的區(qū)域比較網(wǎng)絡(luò)、Wang等人[15]提出的多尺度決策網(wǎng)絡(luò)、Chen等人[16]提出的多尺度自適應(yīng)任務(wù)注意機(jī)制網(wǎng)絡(luò)、Yu等人[17]提出的回溯網(wǎng)絡(luò),均表明豐富的低維特征比圖像級特征具有更好的特征表示能力.

1.2 基于元學(xué)習(xí)的方法

元學(xué)習(xí)的主要思想是通過合理利用已有的知識或經(jīng)驗,指導(dǎo)模型在新任務(wù)中更快、更準(zhǔn)確地學(xué)習(xí).Santoro等人[18]提出基于記憶增強(qiáng)的神經(jīng)網(wǎng)絡(luò)LSTM模塊和神經(jīng)圖靈機(jī)來控制網(wǎng)絡(luò)與外部存儲模塊的交互,解決單樣本學(xué)習(xí)問題.Finn等人[19]提出未知模型元學(xué)習(xí)算法(model-agnostic meta-learning, MAML),通過跨任務(wù)訓(xùn)練策略找到神經(jīng)網(wǎng)絡(luò)中對每個任務(wù)損失較為敏感的初始化參數(shù),使基學(xué)習(xí)器能夠利用少量的支持樣本快速適應(yīng)新任務(wù)類別.Ravi等人[20]采用優(yōu)化的方法,利用基于LSTM的元學(xué)習(xí)器作為優(yōu)化器來訓(xùn)練另一個分類器,幫助分類器學(xué)習(xí)一個較好的初始化參數(shù),使模型能在新的小樣本數(shù)據(jù)上快速收斂.Shyam等人[21]提出了一種基于注意力機(jī)制的循環(huán)神經(jīng)網(wǎng)絡(luò)來實現(xiàn)樣本間的動態(tài)比較.Mishra等人[22]提出軟注意力機(jī)制的時序卷積網(wǎng)絡(luò),將模型看到的所有任務(wù)存儲到記憶模塊中,即聚集先前看到的信息,最終通過該記憶模塊精確定位特定信息并獲得分類結(jié)果.

盡管基于度量學(xué)習(xí)和元學(xué)習(xí)的方法已經(jīng)取得了突出的效果,但依舊存在一些不足.例如,在度量學(xué)習(xí)中,僅考慮任務(wù)中的每一個查詢集樣本和每一類支持集的關(guān)系,并沒有考慮每一個查詢集樣本和每一個支持集樣本的關(guān)系;而在元學(xué)習(xí)中,其復(fù)雜的記憶結(jié)構(gòu)很難訓(xùn)練,訓(xùn)練過程復(fù)雜.與這些方法相比,本文提出的MSLPN算法,不僅能度量每一個查詢集樣本和支持集樣本之間的相似度,而且還能在多個尺度上進(jìn)行度量,充分獲得圖像的低維信息,并且該網(wǎng)絡(luò)以端到端的方式進(jìn)行訓(xùn)練,最后對不同尺度的多個相似度結(jié)果進(jìn)行綜合分析得到最終的分類結(jié)果.

2 多尺度標(biāo)簽傳播算法

2.1 問題定義

目前,小樣本學(xué)習(xí)通常采用元學(xué)習(xí)訓(xùn)練策略,即跨任務(wù)訓(xùn)練機(jī)制,每一個任務(wù)稱為元學(xué)習(xí)任務(wù)并且遵循相同的訓(xùn)練范式N-wayK-shot.具體來說,元學(xué)習(xí)數(shù)據(jù)集分為基類數(shù)據(jù)和測試數(shù)據(jù).基類數(shù)據(jù)中包含了很多類別,每個類別中有多個樣本,并且基類數(shù)據(jù)不包含測試數(shù)據(jù)(即測試數(shù)據(jù)和基類數(shù)據(jù)類別不相交),且每類測試數(shù)據(jù)中僅包含幾個樣本.在訓(xùn)練過程中,從基類數(shù)據(jù)中隨機(jī)抽取N個類別數(shù)據(jù),并且每個類別僅有K個樣本,這些樣本構(gòu)成一個元學(xué)習(xí)任務(wù),作為元學(xué)習(xí)器(模型)的支持集輸入,隨后再從選定的N個類的剩余樣本中抽取部分樣本,作為元學(xué)習(xí)器的查詢集輸入(即預(yù)測樣本).小樣本學(xué)習(xí)的目的就是如何從一系列不同的元學(xué)習(xí)任務(wù)中進(jìn)行學(xué)習(xí),使元學(xué)習(xí)器學(xué)會如何區(qū)分這N個類別,并對查詢集數(shù)據(jù)進(jìn)行預(yù)測.在測試過程中,測試數(shù)據(jù)同樣也分為支持集和查詢集,通過將其輸入元學(xué)習(xí)器對其查詢集圖像進(jìn)行分類.

支持集S、查詢集Q和元學(xué)習(xí)任務(wù)T分別定義為:

(1)

(2)

(3)

其中,xi和yi分別表示圖像及其對應(yīng)的標(biāo)簽,N表示圖像類別個數(shù),K表示支持集中每個類別包含的圖像個數(shù),q表示查詢集中每個類別包含的圖像個數(shù),m表示元學(xué)習(xí)任務(wù)的個數(shù).

2.2 多尺度標(biāo)簽傳播網(wǎng)絡(luò)

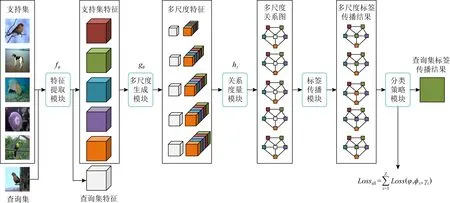

本文提出的多尺度標(biāo)簽傳播網(wǎng)絡(luò)如圖1所示.該網(wǎng)絡(luò)由5個部分組成:1)特征提取模塊用于學(xué)習(xí)輸入數(shù)據(jù)的局部特征表達(dá);2)多尺度生成模塊用于生成不同尺度的多組特征;3)關(guān)系度量模塊用于度量不同尺度下的支持集和查詢集的相似度;4)標(biāo)簽傳播模塊用于計算不同尺度下查詢集圖像的預(yù)測結(jié)果;5)分類策略模塊是對不同尺度的標(biāo)簽傳播結(jié)果進(jìn)行綜合計算獲得查詢集分類結(jié)果.其核心在于多尺度生成模塊、關(guān)系度量模塊和分類策略模塊,其中多尺度生成模塊用于生成不同尺度的圖像特征,每個尺度的特征都能單獨表示其提取圖像的特征,并且能從不同粒度上反映圖像的內(nèi)在特征.通過多尺度生成模塊,能獲得更多的用于表示圖像的特征來增加特征樣本量,緩解低數(shù)據(jù)問題.而關(guān)系度量模塊是對不同尺度的特征進(jìn)行相似性度量,將多尺度生成模塊獲得的不同尺度的特征輸入對應(yīng)尺度大小的關(guān)系度量模塊中獲得相似性得分.關(guān)系度量模塊能從不同尺度上反映查詢集樣本和支持集樣本之間的相似度,并且每一個尺度的相似性得分結(jié)果均對最終的分類結(jié)果有一定影響.因此,分類策略模塊通過加權(quán)計算方式獲得最后的標(biāo)簽傳播分?jǐn)?shù)及分類結(jié)果,即融合多個尺度的預(yù)測分?jǐn)?shù),平衡不同尺度之間的預(yù)測結(jié)果,使預(yù)測正確的得分較高而預(yù)測錯誤的得分相對較低,并且該結(jié)構(gòu)的輸入是支持集和查詢集的聯(lián)和輸入,即Input=Ti.

Fig. 1 Multi-scale label propagation network model (5-way 1-shot)圖1 多尺度標(biāo)簽傳播網(wǎng)絡(luò)模型(5-way 1-shot)

2.2.1 特征提取模塊

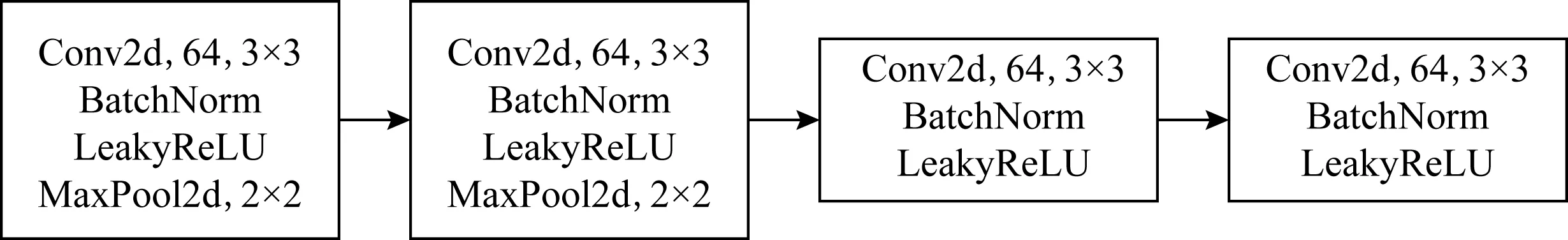

為了與目前最先進(jìn)的方法進(jìn)行比較,本文采用常用的4層卷積模塊作為特征提取器.如圖2所示,每一層卷積模塊由卷積層(卷積核大小為3×3,通道數(shù)為64)、BatchNorm層和LeakyReLU非線性激活層組成,并且在前2個卷積模塊中的激活層后增加2×2大小的最大池化層.

單張圖片通過特征提取模塊,可獲得一個3維的特征向量fφ(xi)∈C×H×W.在本文中,將支持集和查詢集同時輸入特征提取器,可獲得4維特征向量,其定義為fφ(S∪Q)∈(N×K+N×q)×C×H×W,其中,C表示通道數(shù),H和W分別表示輸出特征的高和寬.

Fig. 2 Feature extractor圖2 特征提取器

值得注意的是,本文提出的方法是與體系結(jié)構(gòu)無關(guān)的,即特征提取器可以是其他類型的網(wǎng)絡(luò)結(jié)構(gòu),如ResNet-12[20].

2.2.2 多尺度生成模塊

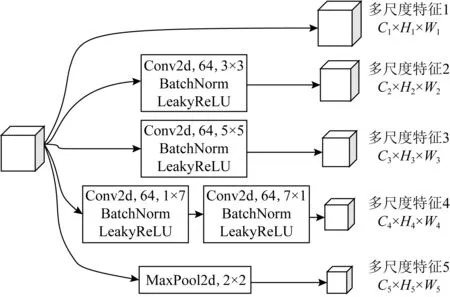

多尺度生成器是MSLPN的關(guān)鍵模塊,該模塊的目的是生成不同尺度的多組特征,其輸入為特征提取模塊的輸出.本文提出的多尺度生成器借鑒Chen等人[16]的多尺度生成模塊,如圖3所示.該模塊包含5個子模塊:第1個模塊對輸入不做任何處理,直接將輸入作為輸出,保留原始特征信息;第2個模塊為卷積模塊,該模塊卷積核大小為3×3,通道數(shù)為64;第3個模塊為卷積模塊,該模塊卷積核大小為5×5,通道數(shù)為64;第4個模塊為2層卷積模塊,卷積核大小分別為1×7和7×1,通道數(shù)均為64;第5個模塊為2×2大小的最大池化層.

單張圖片通過多尺度生成模塊,可生成5組不同尺度的特征向量gφ(fφ(xi))∈Cz×Hz×Wz,z∈{1,2,3,4,5}.在本文中,通過多尺度生成模塊,可獲得4維特征向量gφz(S∪Q)∈(N×K+N×q)×Cz×Hz×Wz,z∈{1,2,3,4,5}.

Fig. 3 Multi-scale generation module圖3 多尺度生成模塊

Fig. 4 Multi-scale relational network architecture圖4 多尺度關(guān)系網(wǎng)絡(luò)結(jié)構(gòu)

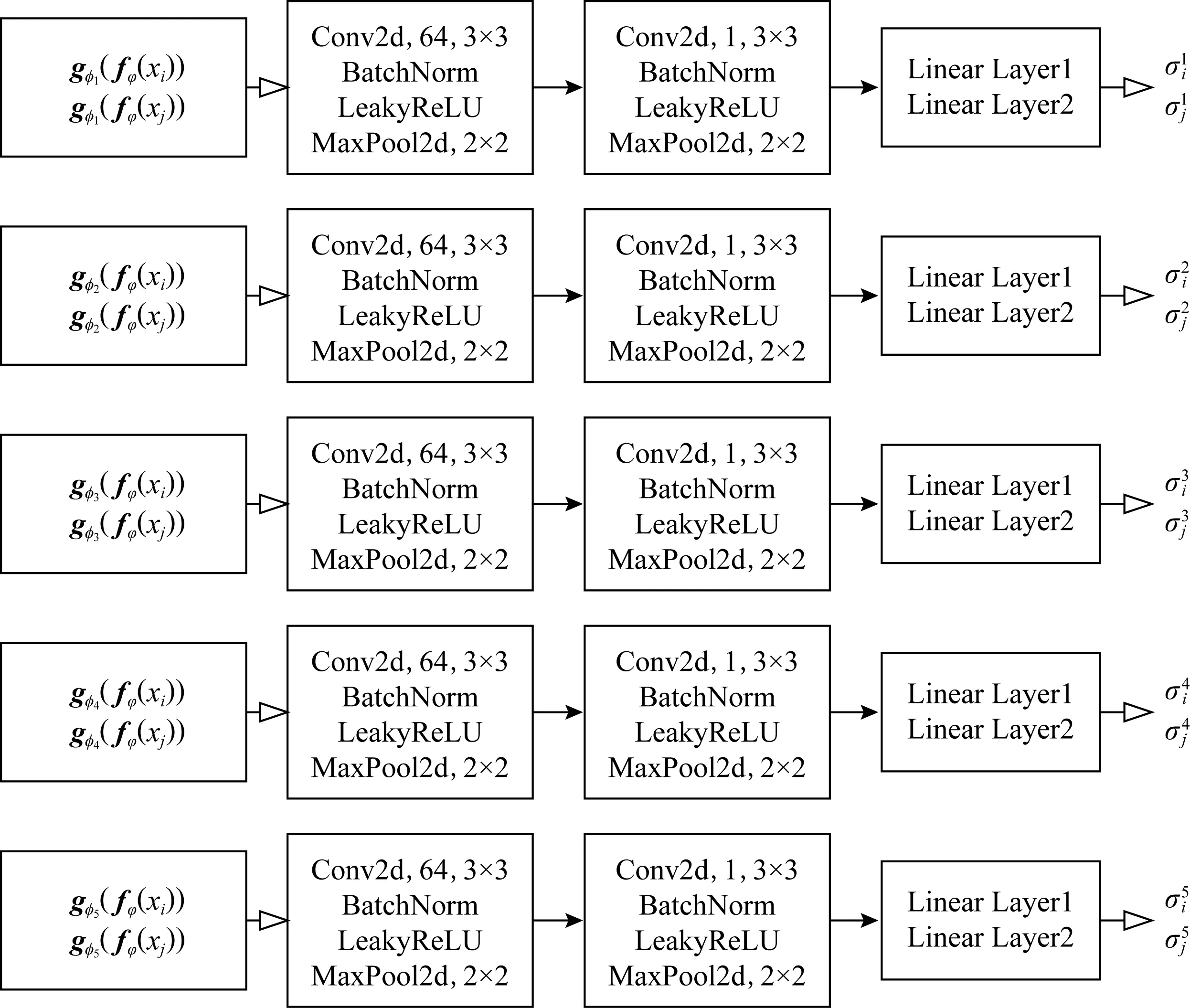

2.2.3 關(guān)系度量模塊

在標(biāo)簽傳播網(wǎng)絡(luò)TPN[25]中,該文作者在關(guān)系網(wǎng)絡(luò)[12]的基礎(chǔ)上提出了一種新的成對的相似性度量函數(shù),其通過關(guān)系網(wǎng)絡(luò)計算獲得尺度參數(shù),用于構(gòu)建合適的相似度鄰居圖.

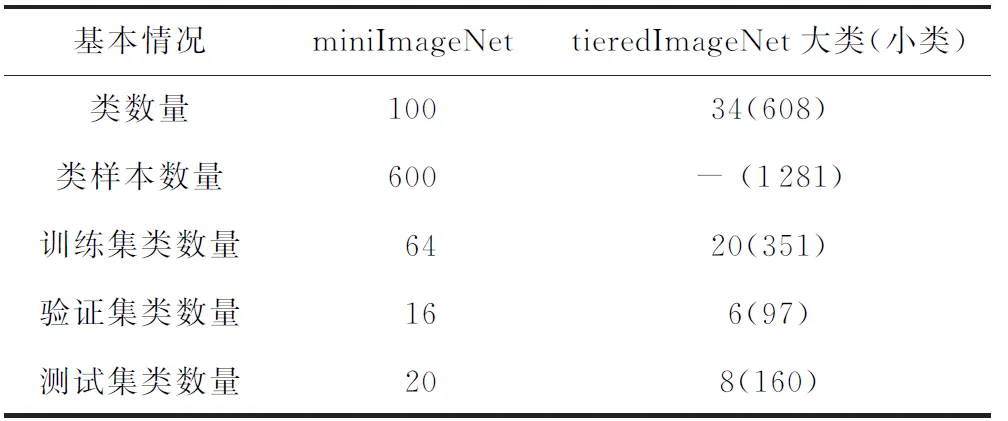

本文采用的策略與TPN類似,但本文中的關(guān)系度量模塊不是單一的,而是多尺度的關(guān)系度量模塊.因為不同尺度的特征嵌入的維度和信息內(nèi)容是不同的,采用分尺度的關(guān)系度量模塊可得到不同尺度下的尺度參數(shù)和特征相似度矩陣,使后續(xù)的標(biāo)簽傳播可在不同尺度上同時進(jìn)行,從而提升最終的分類效果.本文相似性度量函數(shù)定義為

(4)

其中,|Wij|z∈(N×K+N×q)×(N×K+N×q)表示在尺度z下樣本xi和xj的相似度,gφz(fφ(·))為尺度z下的樣本特征,|σ|z為尺度z下的尺度參數(shù),該參數(shù)通過對應(yīng)尺度z的關(guān)系網(wǎng)絡(luò)計算獲得.多尺度關(guān)系網(wǎng)絡(luò)結(jié)構(gòu)如圖4所示,該模塊同樣由5個子模塊組成,每個子模塊的輸入為對應(yīng)多尺度生成模塊不同尺度的輸出,且每一個子模塊結(jié)構(gòu)都是2層卷積模塊(包括卷積層、BatchNorm層、LeakyReLU非線性激活層和最大池化層)和2層全連接層(神經(jīng)元個數(shù)分別為8和1).值得注意的是,尺度參數(shù)是通過跨任務(wù)機(jī)制訓(xùn)練獲得的,可很好地適應(yīng)不同的任務(wù),并且該關(guān)系網(wǎng)絡(luò)結(jié)構(gòu)可修改為其他類型的網(wǎng)絡(luò)(多尺度關(guān)系網(wǎng)絡(luò)結(jié)構(gòu)中每一個子模塊都是單獨的卷積神經(jīng)網(wǎng)絡(luò)和全連接層,子模塊參數(shù)之間不進(jìn)行權(quán)值共享).

通過多尺度關(guān)系網(wǎng)絡(luò)和相似性度量函數(shù)計算獲得不同尺度下的相似性度量矩陣Wz后,與TPN設(shè)置相同,保留相似性度量矩陣中每一行前k個最大值來構(gòu)造k-最近鄰圖(本文中k=20).隨后,對該近鄰圖進(jìn)行拉普拉斯正則化,獲得最終的相似性度量矩陣Lz,即Lz=Dz-1/2WzDz-1/2,其中,Dz為對角線矩陣,其對角線元素(i,i)為Wz的第i行元素的和.

2.2.4 標(biāo)簽傳播模塊

在構(gòu)建好不同尺度下的相似性度量矩陣后,通過標(biāo)簽傳播算法[26]計算不同尺度下查詢集樣本的預(yù)測標(biāo)簽分?jǐn)?shù).

一般的標(biāo)簽傳播定義為:令Y0∈(N×K+N×q)×N為初始化標(biāo)簽矩陣,當(dāng)且僅當(dāng)樣本xi屬于支持集且其標(biāo)簽yi=j時否則即初始化標(biāo)簽矩陣中只包含支持集樣本標(biāo)簽,而沒有查詢集樣本標(biāo)簽.隨后,從初始化標(biāo)簽矩陣開始進(jìn)行迭代標(biāo)簽傳播,傳播公式為

Yt+1=αLYt+(1-α)Y0,

(5)

其中,Yt為對應(yīng)時間戳t的預(yù)測標(biāo)簽分?jǐn)?shù),L為正則化的相似性度量矩陣,α∈(0,1)控制傳播的信息量,本文中α=0.99.并且,式(5)可近似化為閉合形式的解:

Y*=(I-αL)-1Y0,

(6)

其中,Y*為最終的預(yù)測標(biāo)簽分?jǐn)?shù),I為單位矩陣.

2.2.5 分類策略模塊

本文通過最簡單的分?jǐn)?shù)加權(quán)方式,將標(biāo)簽傳播模塊得到多尺度下的預(yù)測標(biāo)簽分?jǐn)?shù)進(jìn)行加權(quán),獲得最終的預(yù)測分?jǐn)?shù).其目的是融合多個尺度的預(yù)測分?jǐn)?shù),平衡不同尺度之間的預(yù)測結(jié)果,使預(yù)測正確的得分較高而預(yù)測錯誤的得分相對較低.該加權(quán)方式為

(7)

并且最終的分類結(jié)果通過Softmax函數(shù)獲得:

(8)

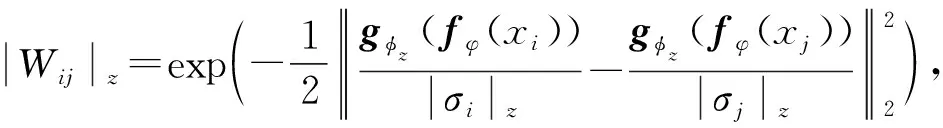

而損失函數(shù)為不同尺度下的交叉熵?fù)p失和:

(9)

(10)

其中,I(·)表示推斷函數(shù),當(dāng)且僅當(dāng)條件為真時,I(·)=1,否則I(·)=0,yi表示樣本的真實標(biāo)簽值,而φ,φz,γz分別表示特征提取模塊、多尺度生成模塊和多尺度關(guān)系度量模塊中可訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)參數(shù),所有的這些參數(shù)都是通過跨任務(wù)訓(xùn)練并且以端到端的形式進(jìn)行更新.

3 實驗和分析

本文用2個經(jīng)典的數(shù)據(jù)集miniImageNet和tieredImageNet對MSLPN的效果進(jìn)行了測試,并和其他先進(jìn)方法進(jìn)行了對比分析.我們的實驗源碼可在https://github.com/wanghang-97/MSLPN獲得.

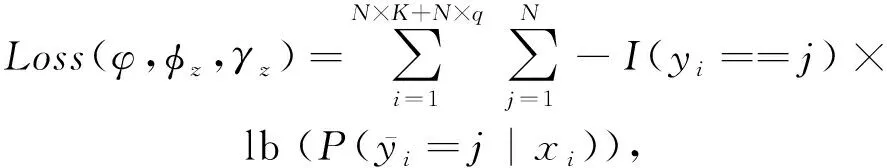

3.1 數(shù)據(jù)集

數(shù)據(jù)集基本情況如表1所示:

Table 1 Basic Information of the Data Set表1 數(shù)據(jù)集基本情況

數(shù)據(jù)集miniImageNet作為ImageNet的一個子集,共包含100個類,每個類有600張圖片.為了和其他小樣本學(xué)習(xí)方法進(jìn)行比較,本文同樣根據(jù)Vinyals等人[10]提出的數(shù)據(jù)集分割方式將該數(shù)據(jù)集劃分為64類訓(xùn)練集、16類驗證集和20類測試集,并且所有的圖片大小均調(diào)整為84×84.

與miniImageNet相似,數(shù)據(jù)集tieredImageNet同樣是ImageNet的一個子集,但它擁有更多的類,并且具有更廣泛的類別層次結(jié)構(gòu).該數(shù)據(jù)集共有34個大類,608個小類,共779 165張圖片,可將其劃分為20個大類訓(xùn)練集(共351個小類,448 695張圖片)、6個大類驗證集(共97個小類,124 261張圖片)和8個大類測試集(共160個小類,206 209張圖片).該數(shù)據(jù)集通過層次劃分后,其訓(xùn)練集、驗證集和測試集在語義上完全不同,該數(shù)據(jù)集在小樣本學(xué)習(xí)中更具挑戰(zhàn)性.同樣,該數(shù)據(jù)集中所有圖片大小也調(diào)整為84×84.

3.2 實現(xiàn)過程與實驗設(shè)置

本文所有實驗均在Ubuntu19.10系統(tǒng), TITAN RTX(24 GB) GPU,PyTorch(1.5.1)深度學(xué)習(xí)框架環(huán)境下運行.

網(wǎng)絡(luò)參數(shù)具體設(shè)置在2.2節(jié)進(jìn)行了詳細(xì)描述,本文在訓(xùn)練和測試階段均按照標(biāo)準(zhǔn)的元學(xué)習(xí)跨任務(wù)機(jī)制,即在訓(xùn)練和測試的每一個任務(wù)中數(shù)據(jù)嚴(yán)格按照N-wayK-shot形式.具體來說,對3.1節(jié)所提的數(shù)據(jù)集均采用5-way 1-shot和5-way 5-shot的形式.在訓(xùn)練過程中,從訓(xùn)練集中隨機(jī)抽取210 000個任務(wù),每個任務(wù)為1個mini-batch,并且每100個任務(wù)作為一個Epoch,共2 100個Epoch,即訓(xùn)練次數(shù)為2 100次.利用跨任務(wù)機(jī)制訓(xùn)練MSLPN模型,并且每個5-way 1-shot(5-way 5-shot)任務(wù)中,除了每個類的1(5)張圖片外,還會從每個類別中剩余圖像中選取15(15)張圖片作為查詢集.即對于一個5-way 1-shot任務(wù),在每一個訓(xùn)練集中將會有5張支持集圖像和75張查詢集圖像.在測試過程中,從測試數(shù)據(jù)集中隨機(jī)抽取600個任務(wù),以Top-1的平均準(zhǔn)確率作為評價標(biāo)準(zhǔn),重復(fù)10次,并報告最終的平均精度.

在訓(xùn)練時,使用Adam優(yōu)化器,初始學(xué)習(xí)率為0.001,其余參數(shù)為默認(rèn)值,即betas=(0.9,0.999),eps=1E-08,weight_decay=0,amsgrad=False.對于miniImageNet數(shù)據(jù),每訓(xùn)練10 000個任務(wù)后,即訓(xùn)練100次后,學(xué)習(xí)率降低一半;對于tiered-ImageNet數(shù)據(jù),由于該數(shù)據(jù)集規(guī)模較大并且類別復(fù)雜,每訓(xùn)練25 000個任務(wù)即訓(xùn)練250次后,學(xué)習(xí)率降低一半.

值得注意的是,本文提出的MSLPN方法是以端到端的形式進(jìn)行訓(xùn)練,不需要在測試階段微調(diào).

3.3 實驗結(jié)果與分析

我們對提出的MSLPN方法與當(dāng)前基準(zhǔn)度量學(xué)習(xí)和元學(xué)習(xí)方法進(jìn)行了比較,包括Matching Network[10],Prototypical Network[11],Relation Network[12],DN4[13],RCN[14],MSDN[15],MATANet[16],Looking-Back[17],TPN[25],MAML[19],Meta-Learner LSTM[20],SNAIL[22],并且所有的小樣本學(xué)習(xí)方法的特征提取部分均是4層卷積神經(jīng)網(wǎng)絡(luò),如本文2.2.1節(jié)所述.

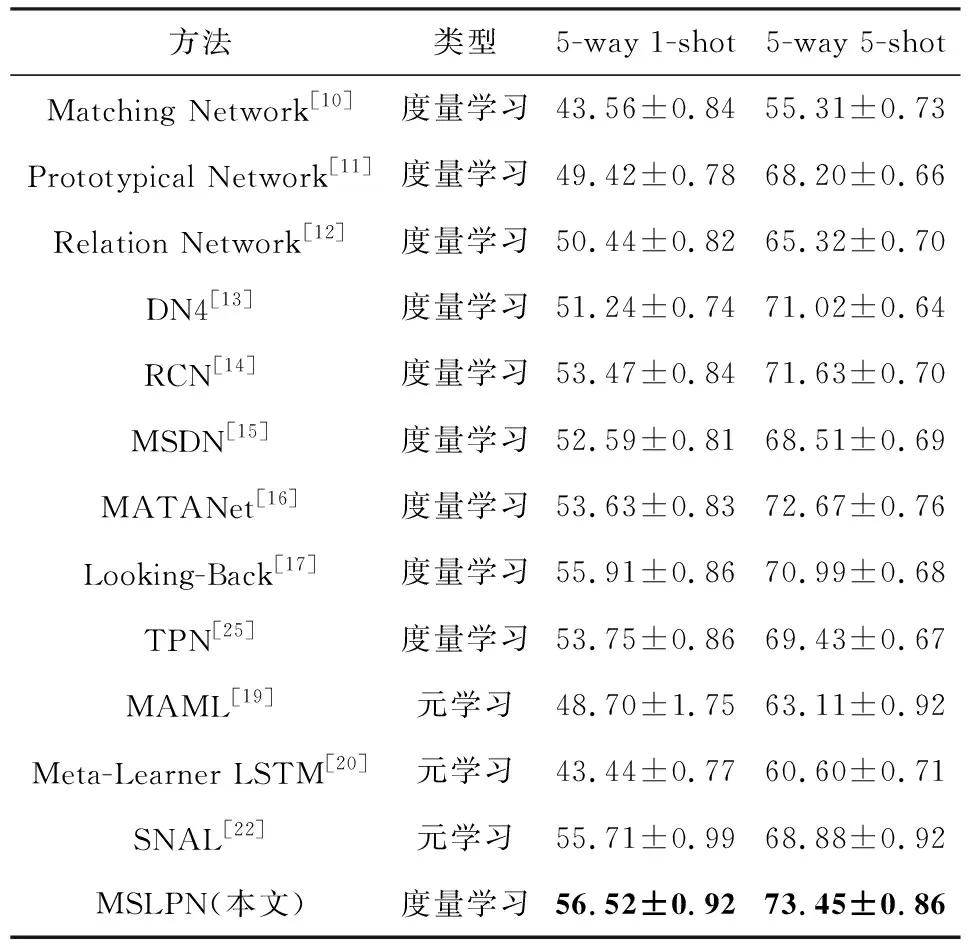

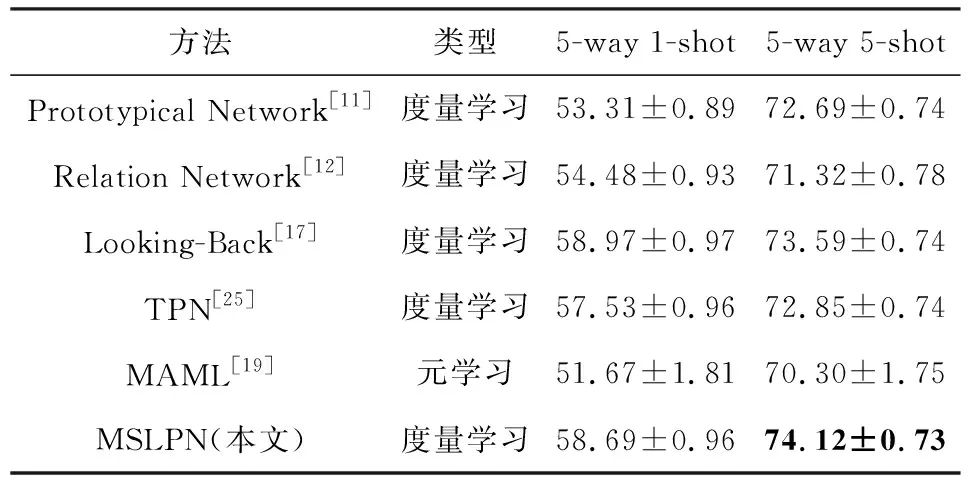

遵循3.2節(jié)實驗設(shè)置的描述,本文考慮5-way 1-shot和5-way 5-shot這2種設(shè)置進(jìn)行比較,準(zhǔn)確率為600個任務(wù)場景的平均值,并且置信區(qū)間為95%,在miniImageNet和tieredImageNet數(shù)據(jù)集上實驗結(jié)果分別如表2和表3所示:

Table 2 Comparison of miniImageNet Experimental Results表2 miniImageNet實驗結(jié)果對比 %

信區(qū)間的置信度;黑體數(shù)值表示最好的實驗結(jié)果.

Table 3 Comparison of tieredImageNet Experimental Results表3 tieredImageNet實驗結(jié)果對比 %

信區(qū)間的置信度;黑體數(shù)值表示最好的實驗結(jié)果.

從表2和表3中可以發(fā)現(xiàn),本文提出的多尺度標(biāo)簽傳播算法在5-way 5-shot情況下,與所有基準(zhǔn)方法相比,在2個數(shù)據(jù)集上均取得了最好的結(jié)果,并且與標(biāo)簽傳播算法TPN相比,準(zhǔn)確率分別提高了4.02%和1.27%,與Looking-Back方法相比,準(zhǔn)確率分別提高了2.46%和0.53%;而在5-way 1-shot情況下,在miniImageNet數(shù)據(jù)集上,與所有基準(zhǔn)方法相比,取得了最好的結(jié)果,與標(biāo)簽傳播算法TPN相比,準(zhǔn)確率提高了2.77%,與Looking-Back方法相比,提高了0.61%.而在tieredImageNet數(shù)據(jù)集上,其準(zhǔn)確率超過了除Looking-Back方法外的所有基準(zhǔn)方法,與標(biāo)簽傳播算法TPN相比,準(zhǔn)確率提高了1.16%.通過分析可知,本文提出的算法充分利用多尺度功能獲得圖像的低維信息,不僅能夠解決圖像低數(shù)據(jù)問題,而且還能使模型在不同尺度下獲得有利于圖像分類的有效特征信息,并且通過多尺度模塊提取的特征在不同數(shù)據(jù)集中仍然具有較強(qiáng)的表示能力;同時,與已有算法相比,通過多尺度模塊提取的圖像低維信息,對于體積小且易混淆的物體能夠捕獲豐富的細(xì)節(jié)信息;并且,通過多尺度標(biāo)簽傳播模塊和加權(quán)分類策略獲得的標(biāo)簽得分,不僅能夠融合多個尺度的預(yù)測分?jǐn)?shù),還能平衡不同尺度之間的預(yù)測結(jié)果,使分類結(jié)果更加精確.因此,本文提出的模型可以獲得更高的識別精度.

4 結(jié)論與展望

本文提出了一種基于多尺度標(biāo)簽傳播網(wǎng)絡(luò)(MSLPN)的小樣本圖像識別方法.該方法通過多尺度生成模塊捕獲輸入數(shù)據(jù)不同尺度的局部描述信息,著重強(qiáng)調(diào)可學(xué)習(xí)的深度局部描述信息即數(shù)據(jù)的低維信息,通過該信息豐富圖像特征,解決小樣本低數(shù)據(jù)問題,提高預(yù)測準(zhǔn)確率.本文結(jié)合標(biāo)簽傳播算法,利用多尺度信息,通過加權(quán)形式獲得最終的預(yù)測標(biāo)簽分?jǐn)?shù).在miniImageNet和tieredImageNet數(shù)據(jù)集上均獲得了很好的結(jié)果,與TPN相比,在數(shù)據(jù)集miniImageNet上,5-way 1-shot和5-way 5-shot設(shè)置中的分類準(zhǔn)確率分別提高了2.77%和4.02%;而在數(shù)據(jù)集tieredImageNet上,5-way 1-shot和5-way 5-shot設(shè)置中分類準(zhǔn)確率分別提高了1.16%和1.27%.通過對實驗結(jié)果的分析,本文提出的多尺度生成模塊在小樣本圖像分類算法的度量學(xué)習(xí)方向能有效解決小樣本低數(shù)據(jù)問題,提高預(yù)測準(zhǔn)確率.在未來的小樣本研究中,在獲取圖像特征時,仍然可以利用多尺度生成模塊,通過提取不同尺度的圖像特征來表示不同粒度的圖像內(nèi)在特征,不僅可以豐富圖像特征,還能有效解決低數(shù)據(jù)問題.除此之外,受多尺度生成模塊的啟發(fā),還可以從多維度的度量學(xué)習(xí)方法入手,通過集成不同的度量學(xué)習(xí)方法,修改分類策略模塊,以簡單的加權(quán)分類策略為基礎(chǔ)進(jìn)行擴(kuò)展,設(shè)計靈活的度量學(xué)習(xí)模塊和分類策略模塊,提高分類準(zhǔn)確率.

因此,未來工作展望主要分為3個方面:

1) 利用注意力機(jī)制替換簡單的加權(quán)分類策略,研究每一個尺度下的局部信息對分類結(jié)果的影響;

2) 利用集成學(xué)習(xí)的思想,集成不同的度量學(xué)習(xí)方法,提高分類準(zhǔn)確率;

3) 利用卷積圖神經(jīng)網(wǎng)絡(luò)設(shè)計更高效的標(biāo)簽傳播算法.

作者貢獻(xiàn)聲明:汪航提出算法主要研究思路和實驗方案,完成實驗并撰寫論文;田晟兆完成文獻(xiàn)調(diào)研、實驗改進(jìn)和論文修改;唐青負(fù)責(zé)實驗實現(xiàn)和論文修改;陳端兵提出論文修改思路,指導(dǎo)論文寫作,參與論文校對.