基于WGAN-GP的微多普勒雷達(dá)人體動作識別

屈樂樂, 王禹桐

(沈陽航空航天大學(xué)電子信息工程學(xué)院, 遼寧沈陽 110136)

0 引言

人體動作識別技術(shù)已廣泛應(yīng)用于智能安防、智慧養(yǎng)老和人機(jī)交互等多個領(lǐng)域。與其他傳感器相比,雷達(dá)在人體動作識別上的優(yōu)勢主要表現(xiàn)在:可對人體進(jìn)行全天候的監(jiān)測,可以有效地防止外界因素的干擾和避免目標(biāo)的隱私泄露問題。微多普勒效應(yīng)指的是雷達(dá)探測物除平動多普勒頻率之外因振動、旋轉(zhuǎn)等微運(yùn)動而產(chǎn)生的額外頻率調(diào)制的物理現(xiàn)象,由目標(biāo)運(yùn)動產(chǎn)生的微多普勒效應(yīng)可有效地應(yīng)用于人體動作識別。

目前,隨著深度學(xué)習(xí)的快速發(fā)展,各種深度學(xué)習(xí)方法被廣泛應(yīng)用于基于雷達(dá)圖像的人類動作識別,其中深度卷積神經(jīng)網(wǎng)絡(luò)(Deep Convolutional Neural Network, DCNN)已成為人類動作識別的首選方法。但DCNN大都需要充足的雷達(dá)數(shù)據(jù)進(jìn)行訓(xùn)練實(shí)現(xiàn)人體動作識別,但是在實(shí)際工作中,由于雷達(dá)數(shù)據(jù)采集成本過高,數(shù)據(jù)量往往有限,因此無法有效訓(xùn)練 DCNN。針對雷達(dá)數(shù)據(jù)過少而導(dǎo)致深度學(xué)習(xí)模型訓(xùn)練受限制的問題,目前主要的方法有三種:采用遷移學(xué)習(xí)技術(shù)對基于微多普勒特征的人體動作識別、采用動作捕捉(Motion Capture, MOCAP)合成微多普勒雷達(dá)數(shù)據(jù)和采用生成對抗網(wǎng)絡(luò)(Generative Adversarial Network,GAN)進(jìn)行雷達(dá)數(shù)據(jù)增強(qiáng)。但微多普勒雷達(dá)圖像與光學(xué)圖像有根本的不同,基于光學(xué)圖像的遷移學(xué)習(xí)技術(shù)能否有效地應(yīng)用于雷達(dá)圖像上還有待于進(jìn)一步的研究。采用MOCAP合成微多普勒雷達(dá)數(shù)據(jù)仍然受到人力、時間和數(shù)據(jù)收集成本的限制,并且合成的數(shù)據(jù)未考慮到周圍復(fù)雜環(huán)境的影響。利用GAN進(jìn)行雷達(dá)數(shù)據(jù)增強(qiáng)同樣可以解決雷達(dá)圖像數(shù)據(jù)過少的問題,但是需要注意生成圖像的質(zhì)量和多樣性。文獻(xiàn)[8-9]采用深度卷積生成對抗網(wǎng)絡(luò)(Deep Convolutional GAN,DCGAN)進(jìn)行雷達(dá)圖像數(shù)據(jù)增強(qiáng),提高動作識別準(zhǔn)確率。文獻(xiàn)[10-11]提出采用輔助分類器生成對抗網(wǎng)絡(luò)(Auxiliary Classifier GAN,ACGAN)和DCNN對不同環(huán)境下的人體動作進(jìn)行識別,識別準(zhǔn)確率得到提升。 雖然 DCGAN 和 ACGAN 可以解決雷達(dá)數(shù)據(jù)不足的問題,但是其訓(xùn)練過程并不穩(wěn)定,常常需要訓(xùn)練多次才能達(dá)到平衡,并且需要平衡網(wǎng)絡(luò)結(jié)構(gòu)和調(diào)整超參數(shù)。本文提出利用基于梯度懲罰的沃瑟斯坦生成對抗網(wǎng)絡(luò)(Wasserstein Generative Adversarial Network-Gradient Penalty,WGAN-GP)進(jìn)行微多普勒時頻譜圖像增強(qiáng)。相較于 DCGAN和ACGAN,WGAN-GP提供了一個更穩(wěn)定的訓(xùn)練過程,對于模型架構(gòu)和超參數(shù)的選擇不敏感,生成的圖像質(zhì)量更高,多樣性更強(qiáng)。

本文首先對5種不同的人體動作線性調(diào)頻連續(xù)波雷達(dá)回波數(shù)據(jù)進(jìn)行預(yù)處理獲得相應(yīng)的微多普勒時頻譜圖像,然后介紹了基于GAN的時頻譜圖像增強(qiáng)方法,并對比了DCGAN、ACGAN 和WGAN-GP 對微多普勒時頻譜圖像的數(shù)據(jù)增強(qiáng)效果。最后實(shí)驗結(jié)果表明,使用WGAN-GP對微多普勒時頻譜圖像進(jìn)行數(shù)據(jù)增強(qiáng),可有效地解決DCNN 由于數(shù)據(jù)量有限導(dǎo)致的過擬合問題,提高動作識別準(zhǔn)確率。

1 雷達(dá)信號采集與預(yù)處理

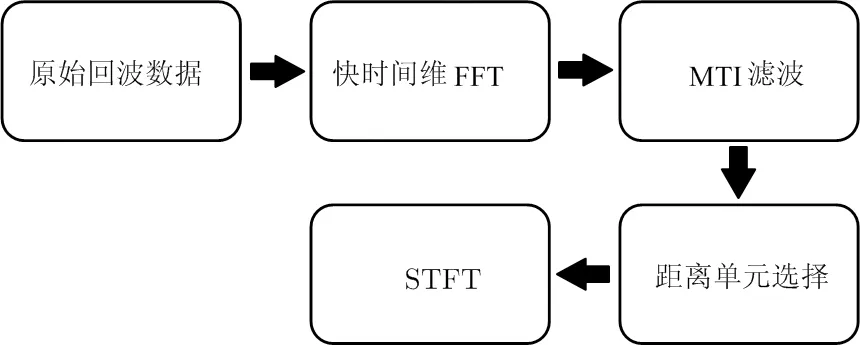

實(shí)驗數(shù)據(jù)使用格拉斯哥大學(xué)提供的公開雷達(dá)數(shù)據(jù)集,該數(shù)據(jù)集通過中心頻率為5.8 GHz,帶寬為400 MHz的線性調(diào)頻連續(xù)波雷達(dá)采集不同人體動作的回波數(shù)據(jù)得到。本文使用的數(shù)據(jù)包含40名男性志愿者,分別進(jìn)行喝水、拾取物體、行走、站立、坐下五種人體動作,每個動作重復(fù)測量3次,其中行走的動作測量時間為10 s,其余動作為5 s。每個動作共得到120個雷達(dá)回波數(shù)據(jù),共計120×5=600個數(shù)據(jù)。對5種人體動作的原始回波數(shù)據(jù)進(jìn)行預(yù)處理,得到相應(yīng)的微多普勒時頻譜圖像,回波數(shù)據(jù)預(yù)處理流程如圖1所示。

圖1 回波數(shù)據(jù)預(yù)處理流程

將每個動作對應(yīng)的回波樣本數(shù)據(jù)表示為×維矩陣,其中為快時間采樣個數(shù),即為每個調(diào)頻周期對應(yīng)的數(shù)據(jù)采樣點(diǎn)數(shù),為慢時間采樣個數(shù),即為每個動作樣本數(shù)據(jù)對應(yīng)的 chirps數(shù)量。首先對數(shù)據(jù)矩陣的每一列在快時間維進(jìn)行快速傅里葉變換(Fast Fourier Transform,F(xiàn)FT)得到距離像信息。然后使用4階截止頻率為0.007 5 Hz的Butterworth高通濾波器作為MTI濾波器對背景雜波進(jìn)行抑制。根據(jù)人體目標(biāo)與雷達(dá)之間的距離選擇的距離單元范圍為10~30,對每一個距離單元沿慢時間維進(jìn)行短時傅里葉變換(Short Time Fourier Transform,STFT),然后對每個距離單元的STFT結(jié)果進(jìn)行相干疊加得到微多普勒時頻譜圖像,其中STFT采用長度為 0.2 s,重疊系數(shù)為95%的Hamming窗。

得到的微多普勒時頻譜圖像大小為464×400像素,為了降低網(wǎng)絡(luò)訓(xùn)練的計算復(fù)雜度,將時頻譜圖像統(tǒng)一縮放為64×64像素,如圖2所示。

圖2 人體各動作微多普勒時頻譜圖像

2 基于GAN的微多普勒時頻譜圖像增強(qiáng)2.1 DCGAN

GAN最早由Ian Goodfellow在2014年首次提出。GAN是一種有效的數(shù)據(jù)生成網(wǎng)絡(luò),其中包括生成器(Generator, G)和判別器(Discriminator, D),通過生成器和判別器的對抗訓(xùn)練可以生成效果相當(dāng)逼真的圖像數(shù)據(jù),解決數(shù)據(jù)量不足的問題。GAN的結(jié)構(gòu)如圖3所示,其優(yōu)化過程則是一個極大極小博弈過程,最終使判別器和生成器達(dá)到納什均衡。

生成器和判別器的對抗訓(xùn)練優(yōu)化過程可用式(1)表示:

(1)

圖3 GAN結(jié)構(gòu)

DCGAN是將卷積神經(jīng)網(wǎng)絡(luò)和GAN的一種結(jié)合。相較于原始的GAN,DCGAN主要對生成器和判別器的網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行改進(jìn),一方面通過采用卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)替代GAN中的多層感知機(jī)從而提高判別器判別圖像的能力,另一方面通過采用轉(zhuǎn)置卷積神經(jīng)網(wǎng)絡(luò)提升生成器生成圖像的效果。

2.2 ACGAN

ACGAN將噪聲和相關(guān)的類別標(biāo)簽混合作為生成器的輸入,并使判別器既判斷真假又判斷類別。 通過對生成圖像類別的判斷,可以使得生成器更加準(zhǔn)確地找到類別標(biāo)簽對應(yīng)的噪聲分布。其生成器和判別器的網(wǎng)絡(luò)結(jié)構(gòu)使用深度卷積網(wǎng)絡(luò)結(jié)構(gòu)。ACGAN的目標(biāo)函數(shù)包括兩部分:

=[log(=|)]+

(2)

=[log(=|)]+

(3)

式中,為數(shù)據(jù)樣本來源判別正確的最大似然估計,為數(shù)據(jù)樣本類別判別正確的最大似然估計。判別器最大化+,生成器最大化-。 ACGAN通過添加標(biāo)簽約束來提高生成數(shù)據(jù)的質(zhì)量。

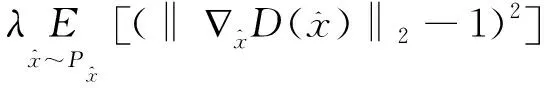

2.3 WGAN-GP

如果 GAN 中的生成器生成數(shù)據(jù)的概率分布與真實(shí)數(shù)據(jù)的概率分布幾乎是沒有重疊部分或者兩分布重疊部分可以被忽略,則JS散度無法衡量生成數(shù)據(jù)分布和真實(shí)數(shù)據(jù)分布的距離,這時通過優(yōu)化JS散度訓(xùn)練GAN將導(dǎo)致找不到正確的優(yōu)化目標(biāo),容易產(chǎn)生訓(xùn)練梯度不穩(wěn)定和模式坍塌的問題。

為解決上述問題,沃瑟斯坦生成對抗(Wasserstein GAN , WGAN)網(wǎng)絡(luò)提出使用Wasserstein距離作為訓(xùn)練GAN的優(yōu)化方法。 為了滿足Lipschitz連續(xù)性,WGAN使用了將權(quán)重限制在一定范圍內(nèi)以強(qiáng)制滿足Lipschitz連續(xù)性的方法,但這會導(dǎo)致生成結(jié)果不佳。WGAN-GP是基于梯度懲罰的 WGAN。WGAN-GP改善了Lipschitz連續(xù)性約束條件,使用梯度懲罰代替WGAN中的權(quán)重裁剪。

WGAN-GP的目標(biāo)函數(shù)為

(4)

(5)

2.4 微多普勒時頻譜圖像數(shù)據(jù)增強(qiáng)

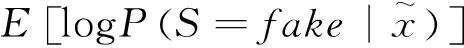

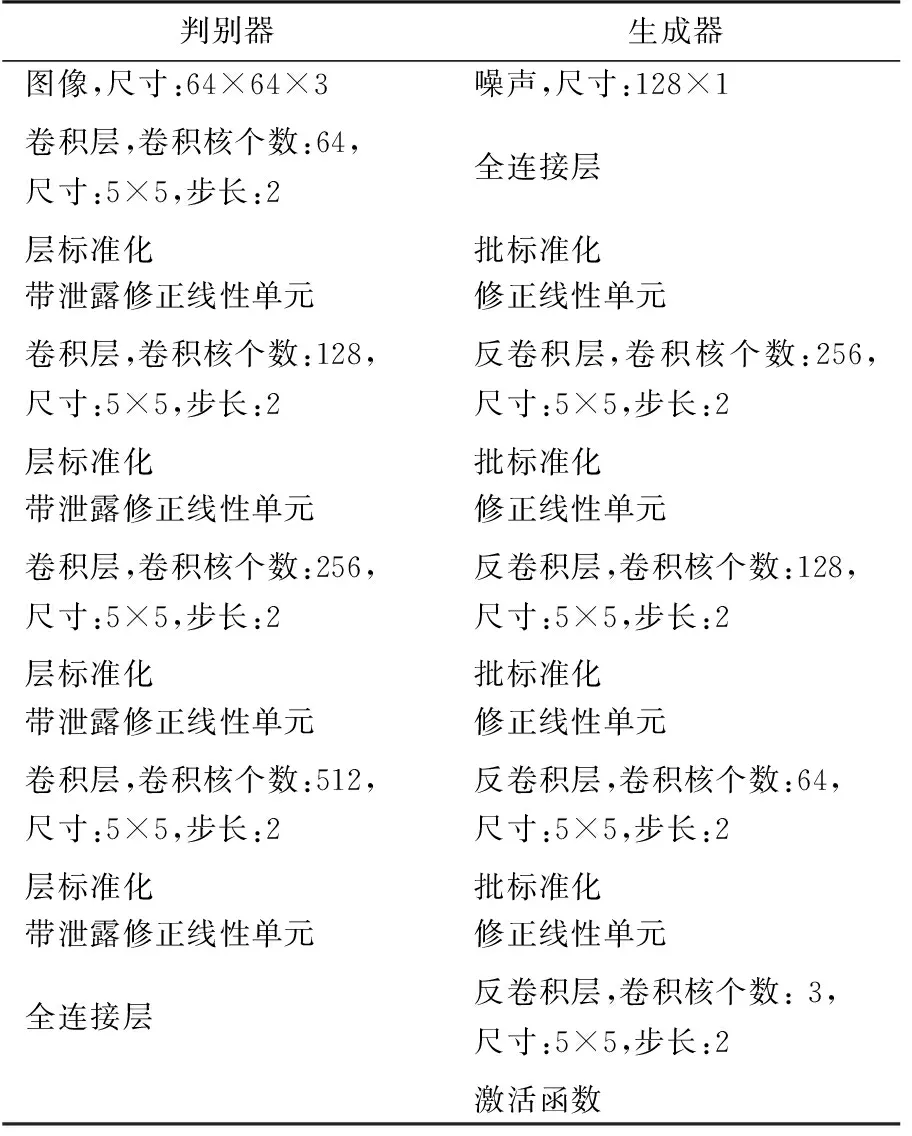

本文采用的WGAN-GP網(wǎng)絡(luò)中判別器和生成器使用DCNN結(jié)構(gòu),具體的網(wǎng)絡(luò)結(jié)構(gòu)如表1所示。

表1 WGAN-GP結(jié)構(gòu)

本文使用的深度學(xué)習(xí)框架為TensorFlow,CPU為AMD R9 3900X,同時使用NVIDA GTX 2060和CUDA加速訓(xùn)練。WGAN-GP模型中所有的參數(shù)初始化服從均值為0,標(biāo)準(zhǔn)差為0.2的正態(tài)分布,判別器和生成器的學(xué)習(xí)率設(shè)置為0.000 2,采用Adam優(yōu)化算法,帶泄露修正線性單元斜率設(shè)置為0.2,批大小設(shè)置為32,梯度懲罰項系數(shù)為10。

將原始數(shù)據(jù)劃分成訓(xùn)練集和測試集,訓(xùn)練集每個動作包含96幅時頻譜圖像,共計96×5=480幅圖像。測試集每個動作包含24幅時頻譜圖像,共計24×5=120幅圖像。使用WGAN-GP對訓(xùn)練集中的每個動作分別進(jìn)行時頻譜圖像增強(qiáng),WGAN-GP的判別器和生成器損失值曲線如圖4所示,雖然損失值曲線在一定程度上反映了判別器和生成器的訓(xùn)練進(jìn)程,但是其并不能衡量生成圖像的質(zhì)量,需通過視覺分析生成圖像的質(zhì)量。為了進(jìn)一步對比WGAN-GP生成圖像的質(zhì)量,在同等條件下,使用DCGAN和ACGAN對雷達(dá)圖像數(shù)據(jù)進(jìn)行生成,其判別器和生成器結(jié)構(gòu)與表1類似。

(a) 判別器損失值曲線

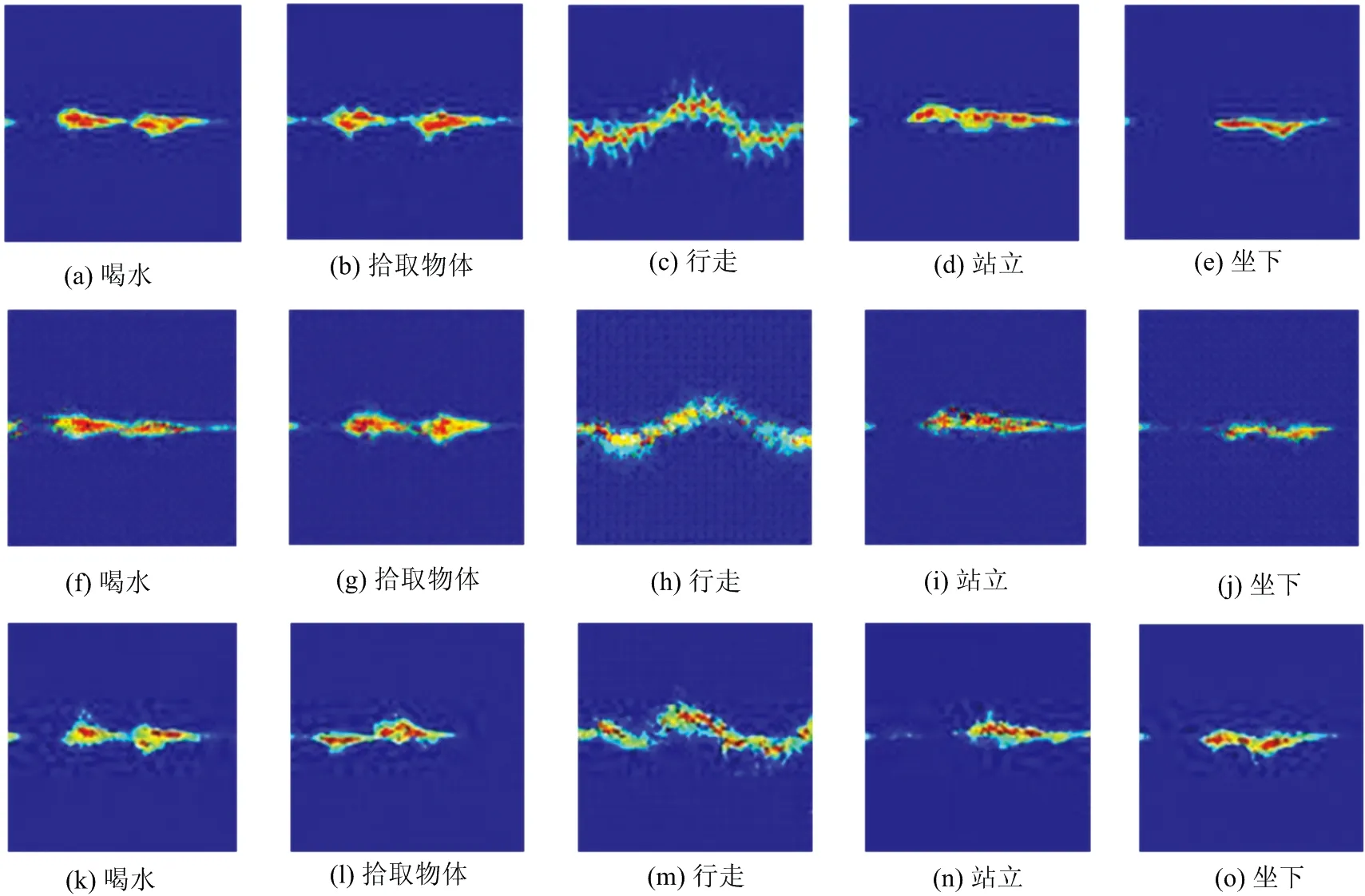

圖5展示了3種不同GAN的生成圖像。對比圖5和圖2可以看出,WGAN-GP生成的圖像與真實(shí)的微多普勒時頻譜圖像在宏觀上非常相似,并且訓(xùn)練過程較為穩(wěn)定,未發(fā)生模式坍塌。DCGAN和ACGAN生成的圖像質(zhì)量低于WGAN-GP,特別是軀干對應(yīng)的低頻部分很模糊。DCGAN和ACGAN在訓(xùn)練過程中均發(fā)生了模式坍塌,生成了大量相同的圖像,并且ACGAN生成了很多錯誤類別的圖像,例如行走類別的生成圖像里含有許多其他動作的生成圖像。

圖5 WGAN-GP,DCGAN和ACGAN生成圖像((a)~(e) 為WGAN-GP生成圖像,(f)~(j)為DCGAN生成圖像,(k)~(o)為ACGAN生成圖像)

DCGAN和ACGAN需要平衡生成模型和判別模型的訓(xùn)練進(jìn)程,避免模式坍塌,達(dá)到納什平衡,并且需要經(jīng)過大量的可視化分析篩選出符合運(yùn)動特征的生成圖像,這將導(dǎo)致工作量的激增。而WGAN-GP擁有更穩(wěn)定的訓(xùn)練過程,并能生成更高質(zhì)量的樣本圖像。

3 基于DCNN的人體動作識別

目前,DCNN在圖像分類上顯示了巨大潛力。DCNN具有獨(dú)立學(xué)習(xí)圖像特征并建立分類邊界的能力。本文采用DCNN-10來驗證WGAN-GP在人體動作識別中的性能。DCNN-10包括7個卷積層和3個全連接層,每一個卷積層后都包含有批標(biāo)準(zhǔn)化和修正線性單元,具體的網(wǎng)絡(luò)結(jié)構(gòu)如圖6所示。訓(xùn)練時采用Adam優(yōu)化算法,批大小設(shè)置為32,學(xué)習(xí)率設(shè)置為0.000 5。

圖6 DCNN-10網(wǎng)絡(luò)結(jié)構(gòu)

首先使用原始訓(xùn)練集(96×5=480)訓(xùn)練DCNN-10,使用測試集測試DCNN-10的準(zhǔn)確率。測試集準(zhǔn)確率曲線如圖7所示,當(dāng)?shù)喆纬^120后,測試集準(zhǔn)確率趨于穩(wěn)定,達(dá)到93.3%。

圖7 僅使用原始訓(xùn)練集時測試集準(zhǔn)確率

為了測試添加的生成圖像數(shù)量對于DCNN-10準(zhǔn)確率的影響,接下來將原始訓(xùn)練集分別與不同數(shù)量的WGAN-GP生成圖像混合在一起,組成新訓(xùn)練集,使用混合后的新訓(xùn)練集分別重新訓(xùn)練DCNN-10,并用相同的測試集測試DCNN-10的分類準(zhǔn)確率,測試結(jié)果如圖8所示。

圖8 各比例生成圖像的測試集準(zhǔn)確率

向原始訓(xùn)練集中添加4倍數(shù)量的生成圖像時測試集準(zhǔn)確率最高,達(dá)到95.8%。但當(dāng)加入6倍的生成圖像時準(zhǔn)確率驟降為86.7%。這是因為生成圖像與真實(shí)的微多普勒雷達(dá)圖像雖然看起來十分相似,但圖像質(zhì)量仍不如真實(shí)的微多普勒雷達(dá)圖像,如果訓(xùn)練集中的生成圖像超過一定數(shù)量時會影響DCNN-10對微多普勒雷達(dá)圖像特征的學(xué)習(xí),導(dǎo)致測試集準(zhǔn)確率降低。當(dāng)原始訓(xùn)練集中加入的生成圖像在一定數(shù)量內(nèi)時,隨著加入的生成圖像越多,DCNN-10的分類準(zhǔn)確率越高,生成圖像可有效地增強(qiáng)DCNN-10的泛化能力,提高識別準(zhǔn)確率。

為了對比不同生成對抗網(wǎng)絡(luò)的生成圖像對于DCNN-10準(zhǔn)確率的影響,向原始訓(xùn)練集中分別加入4倍數(shù)量的DCGAN和ACGAN的生成圖像,組成新訓(xùn)練集,分別重新訓(xùn)練DCNN-10,使用相同的測試集測試其準(zhǔn)確率。測試集準(zhǔn)確率曲線如圖9所示,當(dāng)?shù)喆纬^120后,加入DCGAN生成圖像后的測試集準(zhǔn)確率穩(wěn)定在91.7%左右,加入ACGAN生成圖像后的測試集準(zhǔn)確率穩(wěn)定在90.8%左右,加入WGAN-GP生成圖像后的測試集準(zhǔn)確率穩(wěn)定在95.8%左右。測試集中每種動作的準(zhǔn)確率如表2所示。

圖9 不同生成對抗網(wǎng)絡(luò)的測試集準(zhǔn)確率

表2 DCNN-10測試結(jié)果 %

利用DCGAN和ACGAN進(jìn)行數(shù)據(jù)增強(qiáng)后,測試集的準(zhǔn)確率相比于僅使用原始訓(xùn)練集均有所下降,其中加入ACGAN的生成圖像后準(zhǔn)確率最低。這是由于加入的DCGAN和ACGAN的生成圖像質(zhì)量和多樣性過低所導(dǎo)致的,并且ACGAN的生成圖像里混有錯誤標(biāo)簽影響了分類準(zhǔn)確率。而利用WGAN-GP進(jìn)行數(shù)據(jù)增強(qiáng)后,訓(xùn)練出的DCNN-10在測試集上的準(zhǔn)確率相比于僅使用原始訓(xùn)練集明顯提高。

4 結(jié)束語

本文基于生成對抗網(wǎng)絡(luò)提出采用WGAN-GP對微多普勒時頻譜圖像進(jìn)行數(shù)據(jù)增強(qiáng)。實(shí)驗結(jié)果表明,相比于DCGAN和ACGAN,使用WGAN-GP對微多普勒時頻譜圖像數(shù)據(jù)增強(qiáng),可有效地增強(qiáng)DCNN的泛化能力,提升測試集識別準(zhǔn)確率。在下一步工作中,將結(jié)合自動篩選方法繼續(xù)完善基于GAN的雷達(dá)圖像增強(qiáng)技術(shù),提升生成圖像的質(zhì)量,提高人體動作的識別準(zhǔn)確率。