由形狀結構和位姿特征學習的稠密點云重建

楊永兆,張玉金,張立軍

上海工程技術大學 電子電氣工程學院,上海201620

隨著深度學習技術深入發展,3D 感知作為計算機視覺的熱門研究方向,吸引著越來越多研究人員。點云作為3D 目標表示形式之一,一直被用于目標三維重建,如自動駕駛、AR/VR、工業控制、醫學診斷等。生活中,不僅能從單視角圖像預測目標三維形狀,而且還能捕捉它的細節信息,但對計算機來說,從單視角圖像重建目標的高分辨率三維結構形狀是一項較有意義且極具挑戰的工作。

基于體素的重建方法是將圖像映射到幾何模型。在3D-CNNs 的幫助下,從一張2D 圖像通過神經網絡生成具有規律性、順序性的3D 體素化占據網格結構。然而,體素在表示3D 結構時,存在著大量物體表面結構性數據,并且3D-CNNs 運算量很大,這給網絡訓練和預測推理時增加了額外的開銷。相比于體素重建方法,點云是一個更加有效的選擇。當點云在目標物體表面被采樣時,點云中每個點包含著豐富的位置信息。此外,點云還能夠有效地捕捉更加詳細的目標表面信息,不需要重建目標內部結構形狀。但點云的固有屬性無序性也給網絡在處理點云時帶來了挑戰,傳統CNNs(convolutional neural networks)是用于相對有序的數據分析和處理上,如圖像、體素等。最近在這方面的研究工作主要通過設計網絡結構和損失函數等方法來處理3D 點云和重建。

然而,現有工作在使用點云作為圖像三維重建的描述方法時仍面臨些問題。一方面,在重建稀疏點云時,大多方法都是在做2D 特征提取,忽略圖像中目標在不同方向視角下的內容特征是不同的,并且網絡訓練樣本數據量較大和輸入圖像中的每個通道值也具有不一樣的特征。因此在稀疏重建后,模型的形狀相對有所破損。而重建稠密點云是在稀疏點云基礎上完成的,這也在另一方面影響最終稠密重建后的3D 點云模型并沒有達到理想狀態。

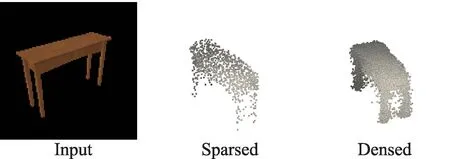

本文圍繞上述問題提出一個兩階段重建稠密點云的網絡模型。首先在三維重建網絡模型階段,基于雙注意力機制構建了提取目標形狀特征的2D 圖像編碼網絡,同時構建了基于PointNet++的位姿特征網絡學習潛在式3D 點云位姿特征,接著特征融合網絡模塊對形狀和位姿特征融合,通過反卷積的解碼網絡將融合特征解碼為1 024 個稀疏點云模型。在網絡模型的第二階段,本文把第一階段輸出的稀疏點云模型作為稠密點云處理網絡的輸入,根據PUNet工作思想,本文按照上采樣因子為4 的原理生成16 384 個點的稠密點云。最后,在預訓練這兩個階段的模型之后,組合這兩個模型形成端到端的網絡,并且運用深度學習方法微調這個模型獲得最終的稠密點云。算法流程如圖1 所示。

圖1 不同階段重建點云Fig.1 Reconstruction of point cloud at different stages

1 相關工作

1.1 3D 重建

近年來,越來越多的研究者開始著手研究3D 視覺中基于單張圖像的三維重建任務。之前一段時間,在3D-CNNs 的幫助下,研究者們圍繞用3D 體素輸出去描述重建結果的工作而展開研究。Yang 等人提出一種新的基于生成對抗網絡(generative adversarial networks,GAN)的3D-RecGAN,它能夠從一張深度圖恢復3D 結構。文獻[7]探索基于自動編碼器網絡學習潛在的特征。3D-R2N2是一個令人記憶深刻的方法之一,因為它通過使用3D 長短時記憶網絡(LSTM)學習體素數據潛在的描述,然后把單個或者多個2D 圖像投影到3D 體素中。

最近,Fan 等人介紹通過使用多層感知器的變體來預測無序點云和一種有效度量兩個點集之間損失的方法,其網絡最終重建的結果比體素方法要優勝。文獻[9]和文獻[10]提出從單個圖像學習三維重建的自由形式的變形方法。Mandikal 等人提出了一種將圖像編碼與點云編碼相結合的潛在空間學習網絡。該方法把圖像映射到三維空間并學習三維點云潛在式特征,以提高點云重建精度。Zhang 等人先通過在合成數據集中檢索與輸入圖像相似匹配的點云模型,然后組合點云特征和具有復雜背景的單張圖像特征以重建點云。Lin 等人把輸入圖像合成新的深度圖以優化網絡并獲得更稠密的點云。一些其他工作是用投影、深度圖和變形網絡等2D 監督方法對部分點云或深度圖補全的3D 點云重建。

1.2 點云處理

在無規則空間中,根據點云的無序性和稀疏性原則,在2D 圖像中使用的卷積神經網絡不能直接處理點云。PointNet首先是在空間轉換網絡里將無序點云對齊到相應的點云特征中,然后運用了多層感知機模塊和全局池化層提取點云全局特征。而PointNet++是在此基礎上使用具有層次性特征學習網絡結構提取點云全局特征和局部特征。Wang 等人提出了邊緣卷積網絡結構,通過在點和特征空間中尋找鄰近區域去提取局部特征。Wu 等人提出PointConv 和PointDeconv,兩種卷積是對2D 空間卷積的一種延伸,使它應用到3D 空間中點云。Yu 等人的PU-Net是對點云做上采樣操作的網絡。

在前人的工作中,Mandikal等人和Lu 等人分別通過深度金字塔網絡和稠密點云生成網絡分階段逐級對稀疏點云稠密重建。首先兩個網絡在第一階段重建出稀疏點云模型,然后作為輸入送入第二階段網絡,最后在第二階段網絡中分兩次增加其稠密化重建,其中每次4 倍的密度,最后生成16 倍稠密點云。然而,本文模型與其有幾點不同。首先在三維重建這個階段,所提出的模型有兩個并行輸入,且這兩個并行輸入的網絡結構也不相同,每個輸入網絡是由各自網絡結構的特點和其提取什么樣的特征而決定。其次在網絡結構組成上,文獻[19]和文獻[20]分別是基于VGGNet編碼網絡和基于殘差注意力編碼網絡。而本文模型是由基于Dual-Attention圖像形狀編碼網絡、基于PointNet++點云姿態編碼網絡和特征融合網絡結構組成的編碼網絡,同時基于PU-Net的解碼網絡生成稀疏點云。最后,DensePCR需要訓練兩次稠密重建網絡,一次是從1重建出4點云,接著從4重建出16點云。因此,網絡在時空復雜度上比較大,中間需要提供兩次Ground Truth。相反,本文網絡在稠密點云處理這個階段只需要一次輸入,不需要額外的輸入或者輸出,因此本文第二階段的點云處理網絡能夠直接預測一個16稠密點云(=1 024)。

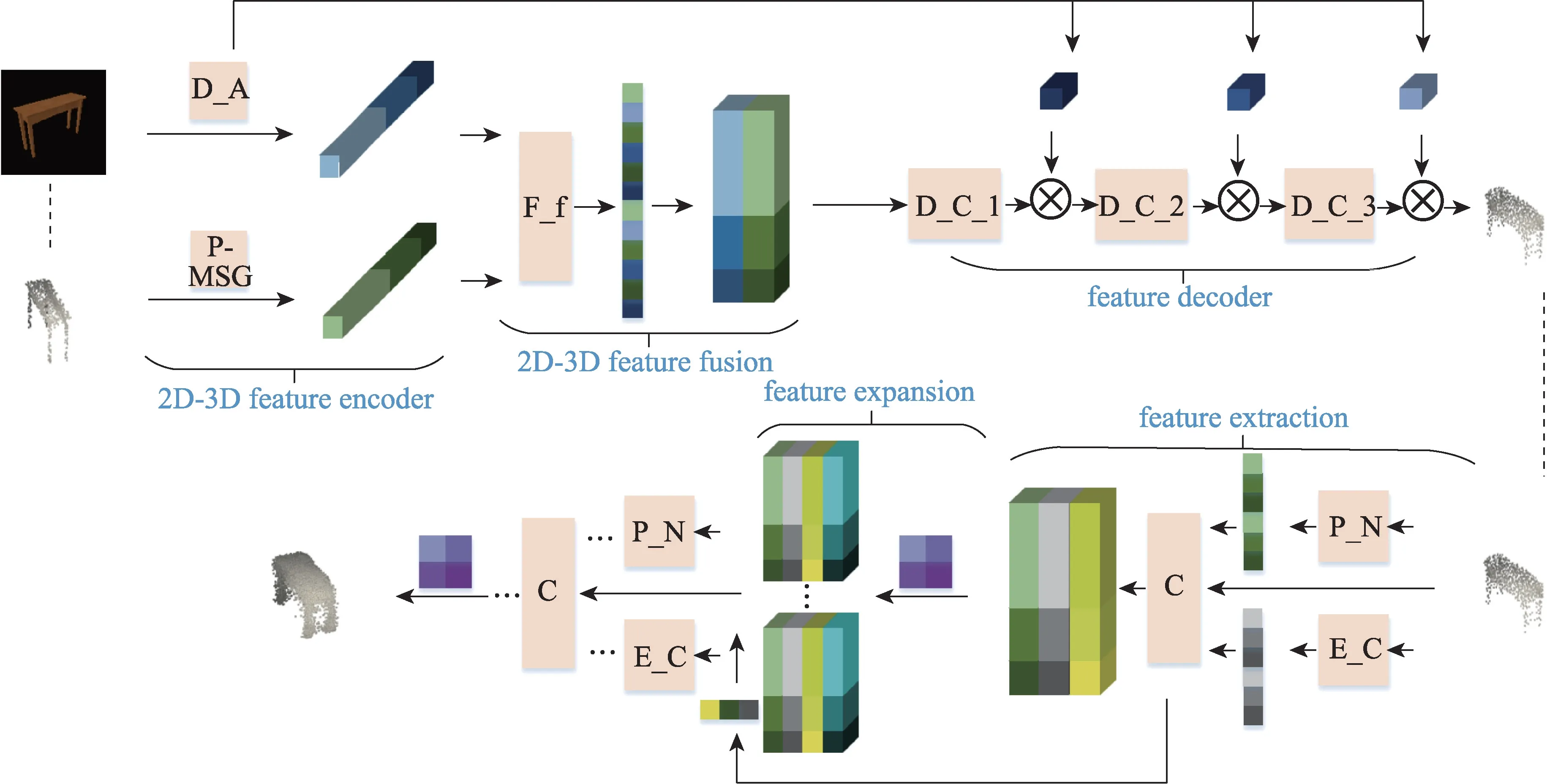

2 方法

本文目標是要重建高分辨率稠密點云。因此提議模型要從單張RGB 圖像中使用稠密點云方法預測密實的幾何體形狀表面。算法網絡結構如圖2 所示。從圖中可以看出,為了重建出稠密3D 點云并且是從一張單視角RGB 圖像,算法需要先重建出稀疏點云,然后在此基礎上重建出稠密3D 點云。因而這要求算法模型不僅能從輸入圖像中學習2D 形狀特征內容,還要能感知3D 姿態特征信息。為此把模型分為兩個階段,首先在3D 重建網絡階段生成稀疏點云,接著將稀疏點云作為輸入經過點云處理網絡產生稠密點云。下面詳細描述每個模型組件。

圖2 網絡整體結構圖Fig.2 Overall network structure diagram

2.1 基于圖像的3D 點云重建網絡

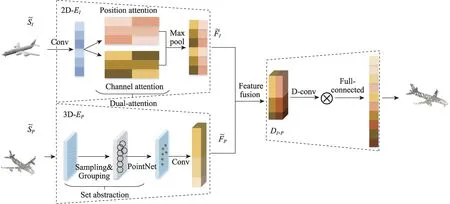

在本文算法第一階段,稀疏點云產生是基于預訓練3D 點云編碼網絡和殘差雙注意力機制網絡。其中點云編碼網絡是基于PointNet++模塊的編碼網絡,而基于雙注意力機制的殘差網絡是疊加3 個雙注意力機制模塊。在3D 點云編碼網絡結構中,編碼器主要學習某個視角下3D 點云中關于圖像目標的潛在式3D 姿態特征。而以圖像作為輸入的殘差雙注意力網絡是學習圖像目標的2D 形狀特征,通過融合這兩種特征形成新的多樣性潛在特征。最后由反卷積層和卷積層的相互交替解碼網絡重建出稀疏點云。詳細結構如圖3 所示。

圖3 3D 點云重建網絡Fig.3 3D point cloud reconstruction network

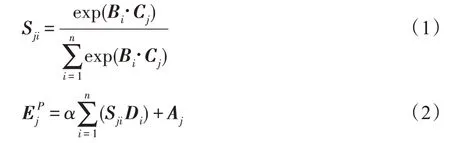

雙注意力機制網絡模型由圖3 中空間注意力和通道注意力兩部分組成。因為實驗輸入是RGB 圖像,如果只對圖像單通道特征分析而忽略其他通道特征,那么圖像中的一些隱含信息可能被忽略。借鑒隱寫術思想,本文基于雙注意力網絡模型構建殘差雙注意力模塊,不僅可以關注去除背景后圖像目標的形狀特征,還可以自適應包含不同通道之間特征依賴性,其相關必要性分析也可在實驗3.4 節中可見。圖3 中Position attention 是空間注意力網絡,其主要對卷積后新特征和計算相應矩陣乘法獲得空間注意力特征圖,然后特征圖和第三分支卷積特征再做乘法運算,最后與原始特征加權求和。上述過程可以用公式表示如下:

基于U-Net結構,算法的解碼器(D)由卷積、反卷積和全連接層組成。以往的方法中使用全連接層作為解碼器的組成部分,但是與全連接層相比,基于U-Net 的反卷積解碼器和編碼器相結合,從而增強特征。并且反卷積與卷積是對稱操作,將編碼網絡的特征信息加入解碼網絡中,這樣通過它可以逐級恢復不同尺寸細節信息特征。例如,圖像編碼網絡中2D 形狀特征是圖像目標部分結構信息,而點云編碼網絡中3D 姿態特征是目標的三維結構特征,這樣不同成分特征都是重建稀疏點云的重要組成部分,相應每個細節特征都不能缺少。最后通過全連接層輸出重建稀疏點云的尺寸1 024×3,其張量形式是(,1 024,3)。

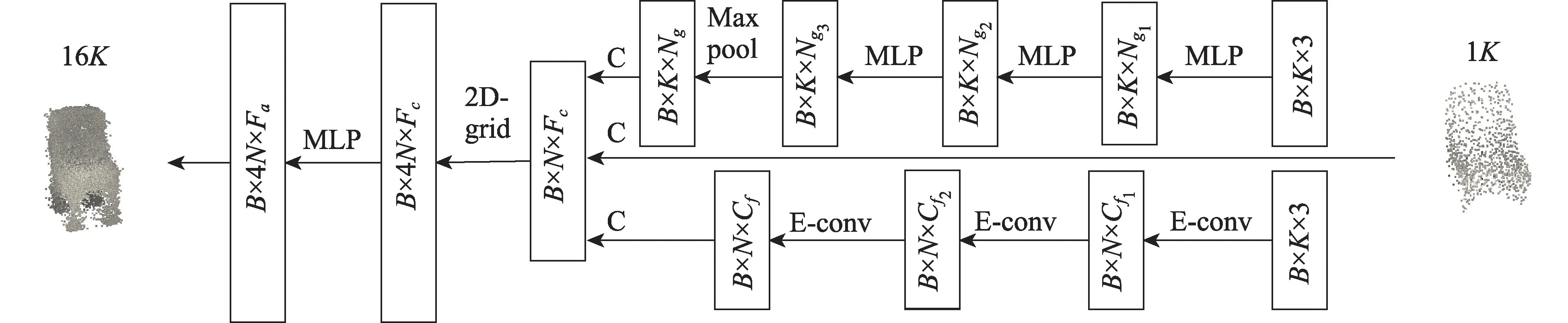

2.2 稠密點云生成網絡

算法第二階段是當給定稀疏點云時,模型可以有效生成稠密點云。因此本文在前人的基礎上重新引入稠密點云生成網絡。圖2 和圖4 中,3D 重建網絡的輸出被送入稠密點云處理網絡后,首先對其特征提取,在獲得點的全局特征和局部特征融合后,算法把相關點特征送到采樣因子為4 的上采樣網絡中,然后對融合點云特征做上采樣處理操作,同時引入網格變換使得生成點能夠均勻分布形成4 倍稠密點云。然后重復執行上述網絡生成16 倍稠密點云。

圖4 稠密點云生成網絡Fig.4 Dense point cloud generation network

為了能讓稠密點云表面均勻,模型對稀疏點云提取全局特征和局部特征。如圖2,圖中P_N 網絡是基于PointNet網絡模塊,采用類似MLP 結構處理點云上每個點的特征。并且該結構是由一個共享MLP操作集組成,然后對稱式最大池化層應用在最后一層將特征平鋪。當輸入1×3(=1 024)稀疏點云時,一組共享MLP 卷積是對點云中每個點做卷積計算,最后逐點式池化層獲得了全局特征向量,其特征維度為(,,N),而每個點維度為1×N。 N是MLP 最后一層的卷積核數量,是點的數量,是batch_size。然而PointNet++是通過FPS(最遠點采樣)對點云中獨立區域點采樣,這對于計算全局特征復雜度高,并且點與點之間相關性沒有考慮。本文根據文獻[17]和文獻[20],在特征空間中通過KNN 算法計算采樣點距離建立局部相鄰區域,接著邊緣卷積學習其局部特征。與FPS 不同,KNN 簡單易用且適用于數量多的點,同時文獻[20]和本文實驗也說明,在特征空間中采用KNN 計算局部相鄰的方法與采用FPS 計算局部特征的DensePCR相比是有效的。當輸入給定點云形狀是×3 或者×F,通過對輸入點云中每個點的局部相鄰域使用一組邊緣卷積,獲得了包含全部特征的張量,其形狀為×C。其中,F是輸入點云中點的特征維度,C是最后一組邊緣卷積的卷積核數量。最后把全局特征、局部特征和輸入點云的原始特征通過級聯的方式獲得級聯特征,其特征向量形狀為×F。最后把這個特征送入點云上采樣網絡。

點云稠密化采樣是在上采樣因子為4 的網絡中對先前特征向量重建出維度是4×F的新特征向量,其中F=3+C+N。同時為了防止點在稠密化過程中出現簇擁在一起,算法把個2D 坐標網格應用到上采樣點和重疊點。通過改變2D 網格從2×2到4×1,讓其維度與現有的tensor 維度一致。這樣,網絡可以在不使用排斥損失的情況下,學習擬合稠密點云,并且引導重建稠密的點分布在目標曲面周圍,而效果可視化分析可見實驗3.5 節描述。在2D 網格幫助下,每個點獲得了4×1 的網格特征。最終輸入的級聯特征向量在一組共享MLP 稠密處理后生成4×F稠密點云,其中F=3+C+N+1。

3 實驗

本文從定量和定性兩方面評估提議方法。除了與先前工作比較外,本文也分析了算法模型中各個組成成分的重要性。

3.1 數據準備

ShapeNet 數據集被用于訓練和評估本文算法性能。它是由ShapeNet和WordNet組織的三維CAD模型集合。ShapeNet 包含來自13 個目標類44 000 個模型,每個模型從24 個不同方向角度預渲染成24 張2D 圖像。作者將圖像裁剪到128×128 分辨率,然后作為輸入再通過網絡傳輸。在本次實驗中,所有訓練測試數量按5∶5 比例進行。為了產生Ground Truth點云,使用最遠點采樣算法對模型表面均勻地采樣成1、4和16點云,其中=1 024。

3.2 評價指標

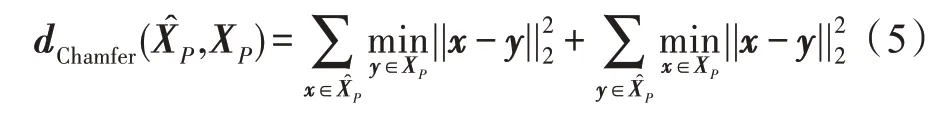

近年來,在3D 重建領域,CD(Chamfer distance)和EMD(earth move's distance)已經成為兩個重要廣泛使用的評估方法。因此,本文記錄CD 和EMD度量值作為模型定量評估結果。CD 作為損失函數表達為:

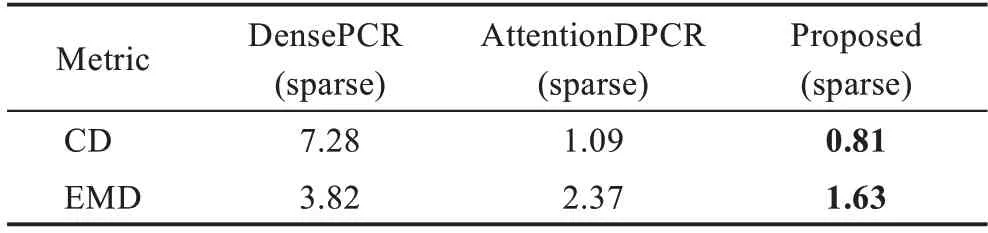

3.3 對比實驗

本文考慮DensePCR和AttentionDPCR作為本次對比實驗,對于稠密點云重建生成。復現它們在相同數據集和5∶5 訓練、測試比例,這樣為了公平對比。由于這兩個實驗方法與本文算法類似,它們也是由兩個階段的網絡組成稠密點云重建網絡,因此本文也考慮稀疏點云重建階段各自網絡模型的不同,把本文算法在稀疏點云重建的實驗結果和DensePCR、AttentionDPCR 進行對比。這樣可以驗證形狀和位姿特征學習對于稠密點云重建的有效性。

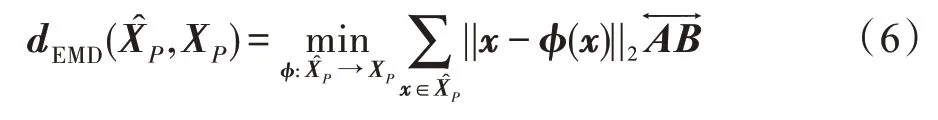

3.4 消融實驗

為了分析網絡模型中不同組件重要性,本節進行了消融實驗。考慮到實驗復雜性,實驗在稀疏點云重建下進行。圖5 是在3D 重建模型基礎上把雙注意力網絡換成單注意力機制和在此基礎上去除位姿特征網絡模塊、特征融合網絡結構后繪制不同網絡結構的CD/EMD 結果圖。3D 重建模型主要包括形狀特征網絡模塊、位姿特征網絡模塊和特征融合網絡結構。具體的“d_a+p”是完整模型,“d_a”是只有雙注意力的形狀特征網絡,“a+p”是單注意力的形狀特征網絡、位姿特征網絡和特征融合結構的組合,“a”是只有單注意力形狀特征網絡。對于本文方法引入雙注意力機制的必要性分析,由圖5 可以看到,“d_a+p”的平均CD/EMD 值低于“a+p”,說明雙注意力網絡模型比單注意力機制的效果較好;其次,在去除位姿特征和融合網絡結構后,由圖5 結果可以說明位姿特征網絡和特征融合網絡結構能更好地提升點云重建效果。

圖5 3D 重建網絡的消融研究Fig.5 Ablation of 3D reconstruction network

3.5 在ShapeNet數據集上評測

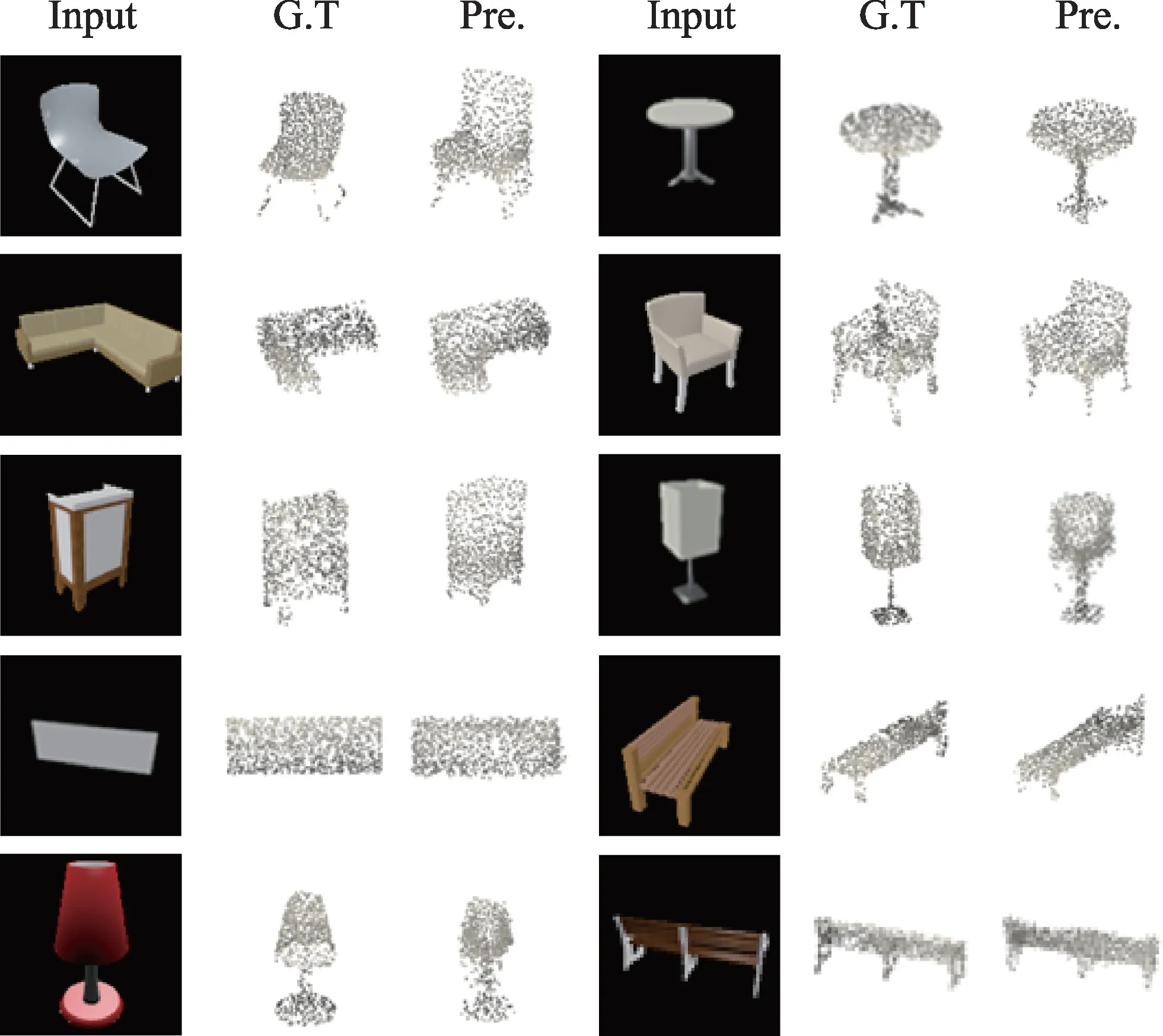

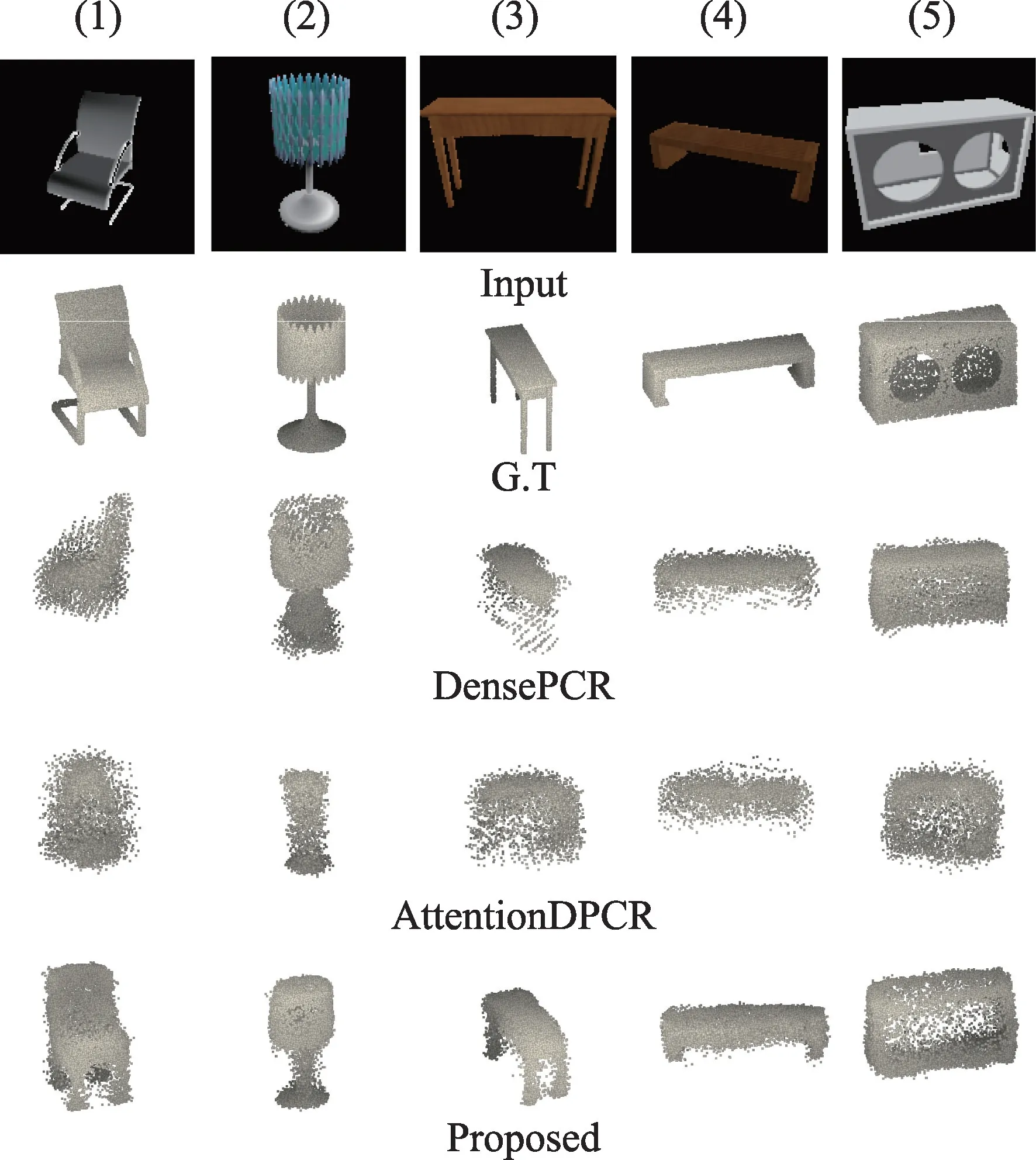

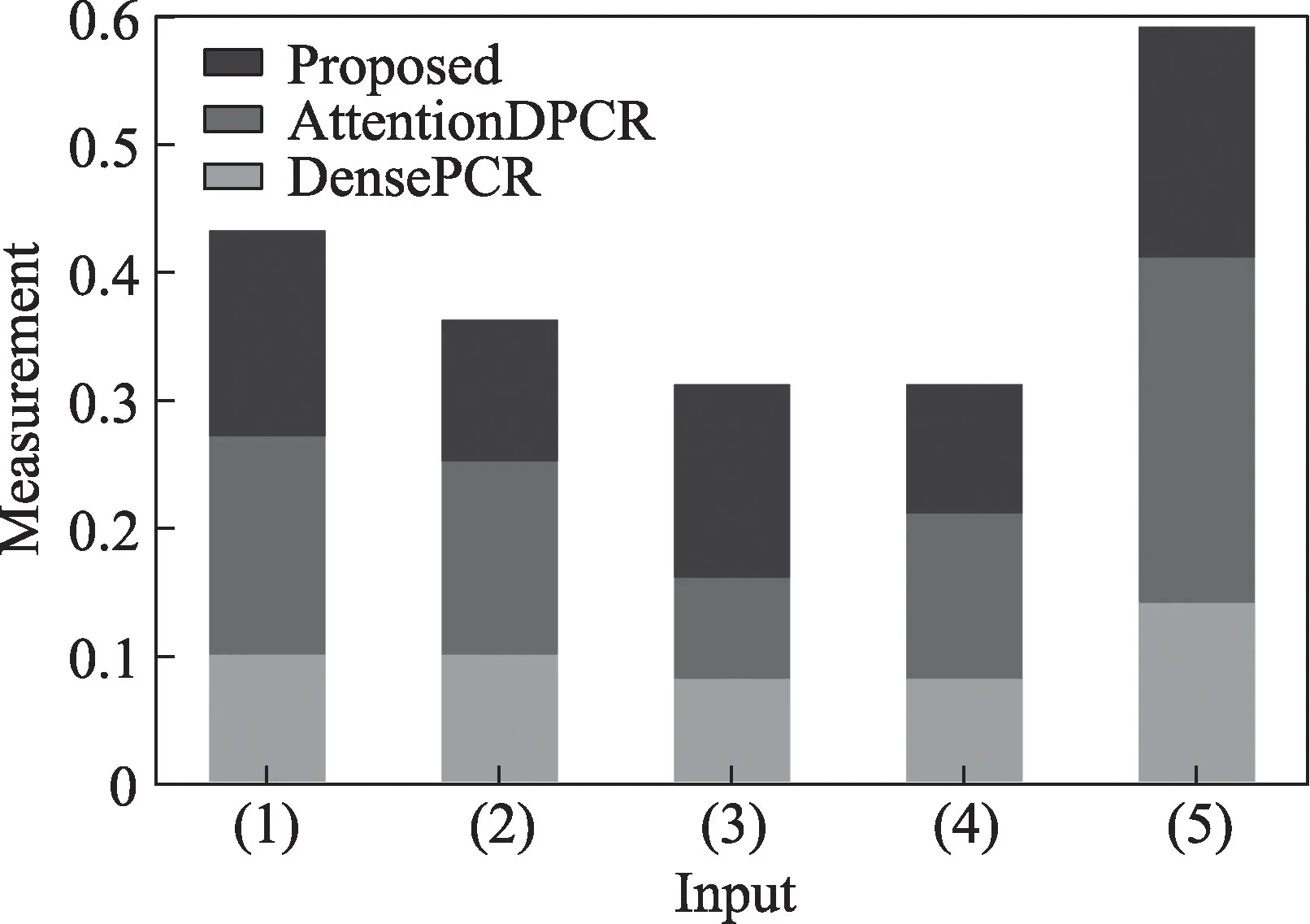

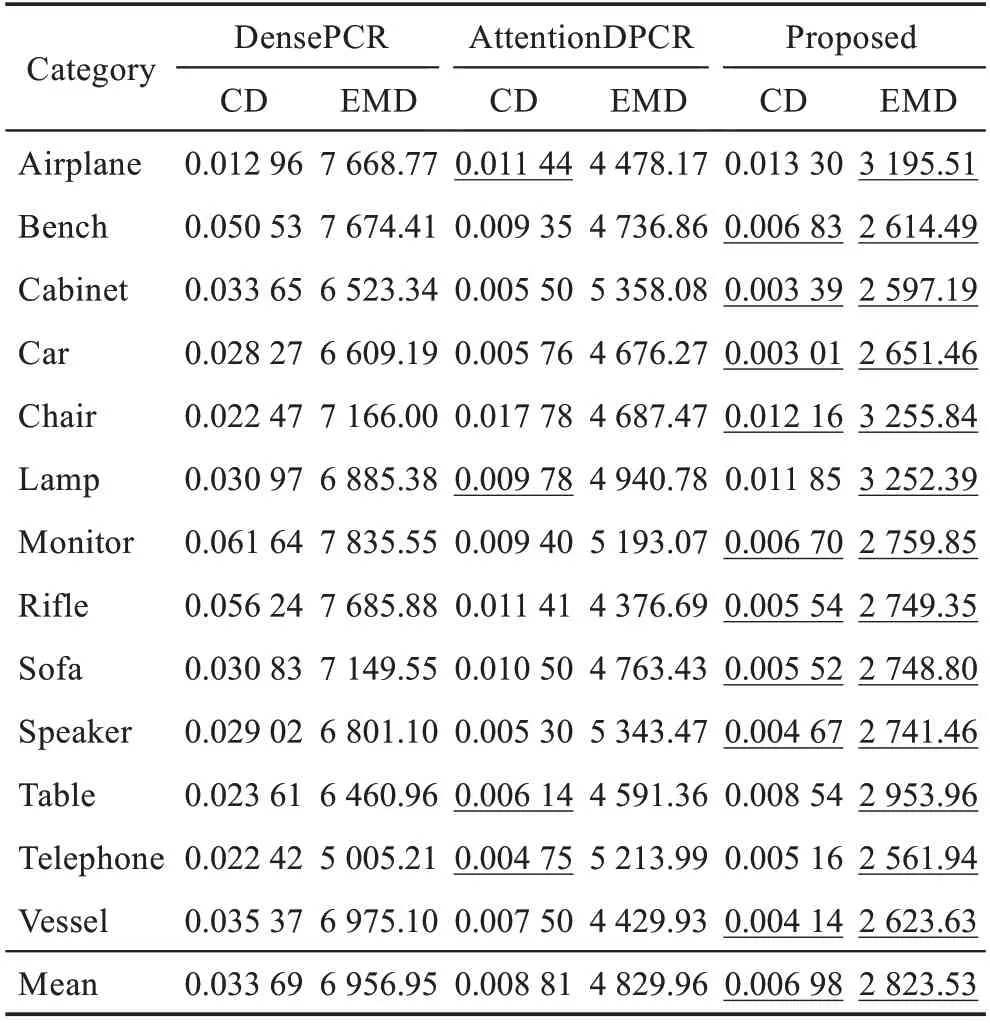

本文在ShapeNet 數據集上評估算法有效性。把單個RGB 圖像作為輸入,然后在稀疏點云重建網絡作用下生成1(=1 024)點云,接著經過稠密點云處理網絡生成一個16稠密點云。為了與DensePCR、AttentionDPCR 相比較,和其在第一階段相比較的結果詳見表1。在表1 中本文記錄了3 個模型對稀疏點云重建的結果,并且本文也給出提議算法在重建稀疏點云時部分定性結果,如圖6 中可視化圖片。從定量和定性結果中可以驗證本文算法要勝過另外兩個重建稀疏點云方法。雖然本文方法在稀疏重建定性結果方面有些不完整的地方,但結果中整體形狀和中間Ground Truth 相比還是較接近。對比實驗數據都是在相同的epoch 條件下得出。相反地,根據之前文獻呈現數據和對比仿真實驗數據觀察,DensePCR和AttentionDPCR 在與原先8∶2 比例的實驗數據結果相比有明顯下降現象。本文推測DensePCR可能對于樣本的依賴程度比較高,而AttentionDPCR 與原先結果有相反的變化,可能歸因于引用了注意力機制。表2 是在預訓練稀疏點云重建網絡和稠密點云處理網絡上最終Finetune 的結果。從表中看到在13 個類中,提議方法除其中4 個類的CD 值比AttentionDPCR對應類的CD 值高0.002 外,其余類的CD 值和所有EMD 值都低于DensePCR 和AttentionDPCR。同時為驗證提議模型稠密重建效果和對其可視化分析,本文對重建結果進行可視化,并和DensePCR、Attention-DPCR 在如圖7 中做重建效果定性對比。從圖7 可以看到,相比其他兩種對于目標結構形狀和表面細節重建方法,提議模型獲得了不錯效果。雙注意力編碼結構使得網絡更加關注目標形狀結構,例如椅子、臺燈和長椅的整體主干形狀;而通過位姿特征學習使網絡加強對椅子的腿、扶手和臺燈底座等一些細節預測的描述。并且從圖7 也可以看出模型重建點云效果與表2 中定量結果的CD/EMD 值成正相關。另外,也從點云Ground Truth(G.T)和Predicted(Pre.)的可視化圖像做相似性度量分析。具體是用圖7 中G.T 的可視化二值圖像與不同方法預測的可視化二值圖像分別做均方誤差值計算,其計算相應度量值如圖8 所示。如果均值低可以說明兩個圖像相似度高,從而相應點云之間的相似度也比較接近。從圖8可以看出,本文提議方法的度量值比其他兩個方法的度量值較低,因此可側面反映出本文方法引導重建點云效果要稍優于前兩者方法。DensePCR 在重建稠密點云時,過多的噪點和沒有聚集性的點分布在模型周圍,使得三維模型變形或者重建不出完整模型。AttentionDPCR 在重建效果圖中也并沒有表現出其模型相關性,在表2 中雖有幾個類的CD 值低于本文方法中相應類的CD 值0.002,但其模型生成的稠密點云與之CD 值成相反關系。在5∶5 比例樣本下,本文算法模型結果都勝過前兩者,從結果可以驗證由形狀和位姿特征學習對重建點云是有效的,并且也從側面反映出本文算法對于小樣本數據訓練的魯棒性較好。另外,本文也探索了方向角度對模型性能影響。按照官方給定24 個渲染角度擴充采樣實驗數據中Ground Truth 內容,同時設置每個G.T 和其對應圖像角度一致的訓練、測試實驗方式。因考慮到實驗復雜性,這部分實驗是在稀疏點云重建階段進行。度量結果可見表3。觀察表3 發現,本文模型在方向角度對齊的條件下,CD/EMD 值相比沒有方向角度對齊的條件各提升0.2 左右。其次,實驗數據也可說明方向角度對于點云重建有些影響,同時本文方法在方向角度條件下對于點云重建性能有點提升。除了上述模型外,本文方法也有失敗案例,分析認為模型從預測稀疏點云時與Ground Truth 有些距離,接著在進行稠密處理時,稠密重建網絡對于稀疏點云的特征無法從輸入中獲得,即使在后面2D 網格作用下也無法使得點與點之間相關性得到很好的聯系。

圖6 稀疏點云重建結果Fig.6 Reconstruction results of sparse point cloud

圖7 各種算法在ShapeNet上定性結果比較Fig.7 Comparison of qualitative results of various algorithms on ShapeNet

圖8 各種算法與Ground Truth 相似性度量結果比較Fig.8 Comparison of similarity measurement results between various algorithms and Ground Truth

表1 與DensePCR、AttentionDPCR 在sparse階段的比較Table 1 Comparison with DensePCR and AttentionDPCR in sparse phase

表2 各算法在ShapeNet上定量結果比較Table 2 Comparison of quantitative results of various algorithms on ShapeNet

表3 提議模型在有無方向角度下定量結果比較Table 3 Comparison of quantitative results of proposed model with or without angle

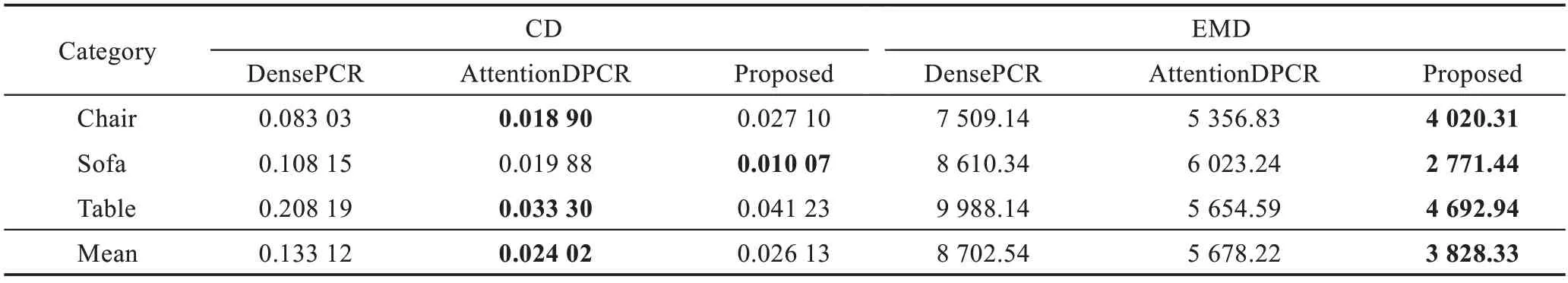

3.6 在Pix3D 數據集上評測

為了驗證模型算法在真實圖像Pix3D數據集上泛化能力和魯棒性表現,在Pix3D 數據集上評估本文方法性能。Pix3D 數據集由大量的現實圖像、相關的mask 圖像和3D Ground Truth 模型組成。在Shape-Net 數據集上訓練提議模型,然后直接在Pix3D 數據集的chair、sofa 和table 這3 個類上做測試。因為這3個類也都重復出現在ShapeNet 數據集上。在測試之前,排除這3 個類中有遮擋、截斷的圖像,然后用它提供的mask 掩蓋住每張關聯圖像的背景,最后裁剪至128×128 分辨率大小的形狀作為網絡輸入。表4 包含本文方法和對比方法在Pix3D 上CD 值和EMD 值的測評結果。從結果看出,本文除了在chair、table 兩個類中CD 值稍低0.01 以外,其余CD 與EMD 值都勝過DensePCR、AttentionDPCR。而從圖9 定性結果得知,本文模型對于單張真實圖像的點云重建效果和模型泛化能力與DensePCR、AttentionDPCR 相比稍優勝,而且也可以看出本文模型的定量結果與定性結果成正相關。DensePCR 對于樣本量的依賴性可能比較大,其CD 和EMD 值都比較大,且從定性結果同時得出模型對于目標的三維輪廓、形狀結構重建不夠完整。AttentionDPCR 在定量結果中雖有兩個類的CD 值稍高0.01,但是其模型對于點云重建的定性結果與之成相反關系。

表4 各算法在Pix3D 數據集上定量結果比較Table 4 Comparison of quantitative results of various algorithms on Pix3D dataset

圖9 各種算法在Pix3D 數據集上定性結果比較Fig.9 Comparison of qualitative results of various algorithms on Pix3D dataset

4 結束語

本文提出一個將目標2D 形狀特征與3D 位姿特征融合分階段重建稠密點云的網絡模型。在這個模型中,首先基于雙特征提取構建點云重建編解碼網絡和重新引入稠密點云生成網絡,然后分別預訓練這兩個模型,最后finetune 這兩個模型形成端到端的網絡。本文在公開數據集ShapeNet 和Pix3D 上將本文算法和現有工作進行對比,定量和定性兩方面結果顯示本文算法的性能優于一些現有工作。從實驗結果也可以看出,本文與現有工作的不足,即對目標重建的分辨率還不夠高,目標中紋理信息還不能夠完全表示出,且模型在訓練過程中易受到光照、方向角度、模型表面復雜程度等因素的影響。在今后的工作中,將提高本文算法對目標內容的學習,減少其他因素的影響,提高模型的魯棒性。