機器人與機器視覺的垃圾分揀系統設計

梅志敏,陳 艷,胡 杭,張 融

(1.武昌工學院機械工程學院,湖北 武漢 430065;2.武漢輕工大學機械工程學院,湖北 武漢 430023;3.綠色風機制造湖北省協同創新中心,湖北 武漢 430065)

1 引言

近年來,以機器視覺為載體的機器人技術與裝備在智能制造行業的應用越來越廣,它使工作過程更自動化與智能化,改善了工作環境,也提高了產品精度[1]。同時,垃圾分類是長期困擾人民生活和環境治理的綜合議題,亟待通過科學技術手段解決。

絕大部分垃圾為流通商品消耗后造成的,外包裝均含由中國編碼中心審定發行的條碼,通過視覺識別條碼獲取產品名稱,將其與訓練集匹配,輸出垃圾分類結果,數據傳輸給機器人執行末端即可實現分揀,對垃圾分類的智能化研究提供了重要的理論和應用基礎。

國內外學者開展了一些相關研究。文獻[2]設計了基于視覺的建筑垃圾分類和回收的機器人系統,具有高度自動化巡邏、檢測和回收等特點;文獻[3]設計了基于ROS和計算機視覺的智能垃圾分類系統,通過深度學習訓練模型,按顏色、形狀、大小進行區分,識別率70%。

文獻[4]開展了基于圖像視覺的垃圾分類機器人識別控制系統算法設計研究,對瓶罐類垃圾進行分揀機械手臂控制系統設計。對此,本設計以流通商品為研究對象、建立商品條碼數據庫,將采集到的圖像識別后與數據庫匹配,結果傳輸給機器人本體,調用IRB1410的運控程序完成目標物的精確分揀。

2 系統組成與逆運動學方程求解

2.1 系統組成

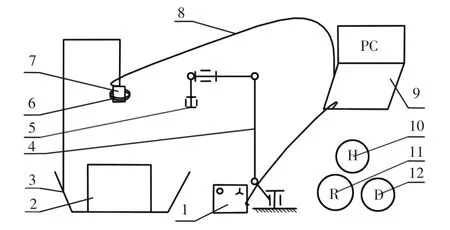

本設計主要由IRB1410 機器人工作站、待分揀垃圾輸送裝置、視覺采集?識別?通訊平臺、MCGS人機界面和三類垃圾收集箱(可回收垃圾、干垃圾和有害垃圾)組成,其中機器人工作站包括本體、控制器和示教器,如圖1所示。

圖1 系統結構示意圖Fig.1 Schematic Diagram of the System Structure

2.2 系統工作原理

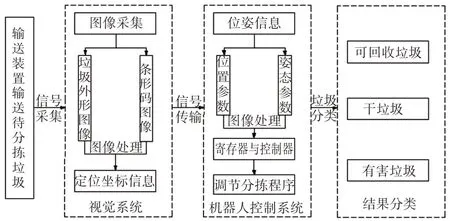

當輸送裝置將待分揀的流通商品垃圾送至視覺檢測平臺采集區域時,傳感器發送采集信號,視覺系統獲取外形輪廓圖像、條碼圖像和位置信息,將識別的條碼號與流通商品條碼數據庫和垃圾分類訓練集進行匹配[5]。

將位姿(位置和姿態)和分類結果信息傳輸給機器人控制器,根據逆運動學計算各關節參數,調用PROC 程序抓取待分揀垃圾,放至對應垃圾箱,機器人可設置運行速率適應待分揀垃圾節拍,期間無停頓。系統工作原理圖,如圖2所示。

圖2 系統工作原理圖Fig.2 Schematic of the System

2.3 IRB1410機器人逆運動學求解

本設計是將圖像的位姿信息經控制器發送給機器人末端,根據關節變換矩陣求解各關節的位置和姿態,故采用逆運動學法求解,驅動各關節電機[6]。

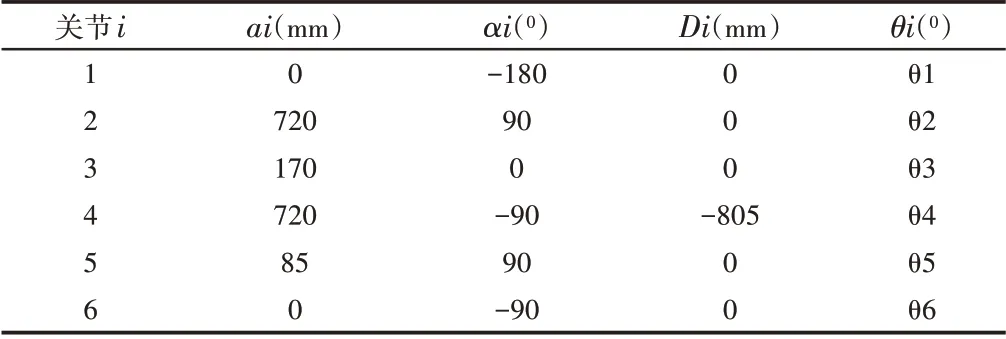

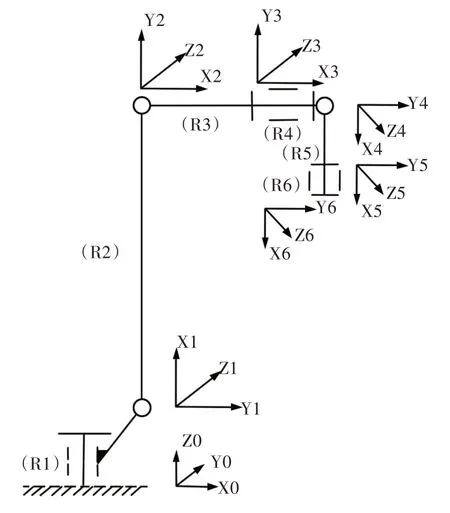

IRB1410機器人連桿參數,如表1所示。機構運動簡圖及各關節坐標系,如圖3所示。

表1 IRB1410機器人連桿參數Tab.1 IRB1410 Rod Parameters

圖3 IRB1410機構運動簡圖及各關節坐標系Fig.3 IRB1410 Schematic Diagram of Mechanism Motion and Coordinate System of Each Joint

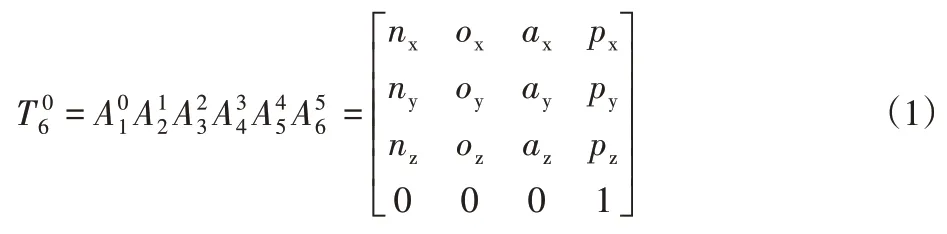

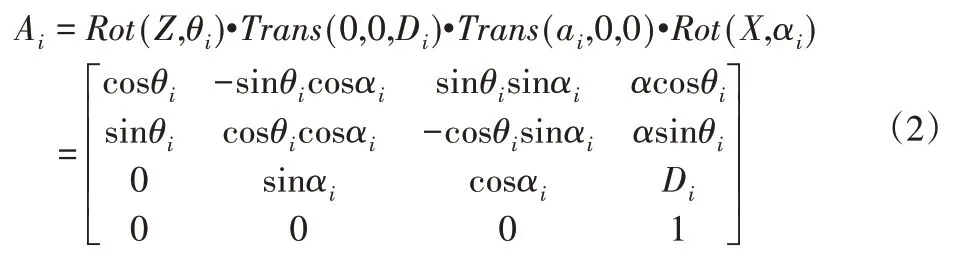

逆運動學方程如下:

已知T6矩陣和各連桿參數,求各關節轉角θ1?θ6:

式中:Ai—關節i的位姿變換矩陣;Rot—旋轉算子;Trans—平移算子。

由解析法求得各關節角度:

式中:pi—連桿長度在i方向的分量;c—cos;s—sin。

綜上,本設計通過視覺定位獲取垃圾的位姿后,傳輸給R6,各關節執行參數實現分揀。

3 視覺系統與圖像處理

3.1 視覺系統與工作原理

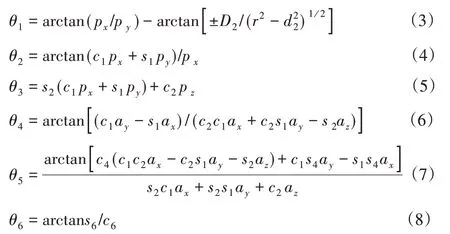

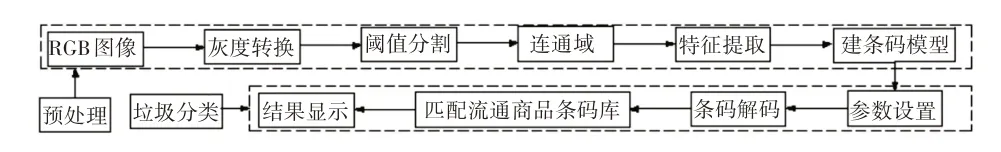

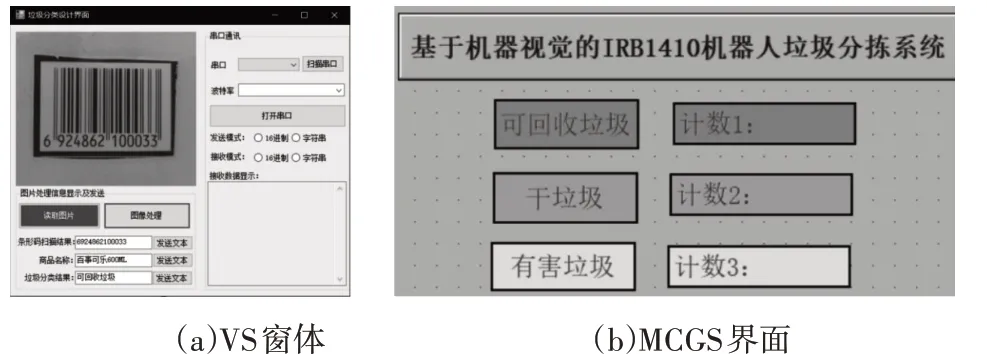

視覺系統由圖像采集裝置、圖像處理系統、機器人分揀工作站和控制通訊傳輸系統組成。圖像采集由光源、鏡頭和相機組成[7],其中光源采用環形白色光、相機像素1.3萬;圖像處理系統采用Halcon機器視覺處理平臺,將處理結果通過C#混合編程轉換至VS2010 的Winform 窗體,經TCP/IP 通信至MCGS 界面中予以顯示和統計,如圖4所示。

圖4 視覺處理流程Fig.4 Visual Processing Flow

工作時,輸送帶將不同種類的流通商品經過光電傳感器時,觸發傳感器信號輸出,相機實時拍照,將圖像發至Halcon處理平臺,經過RGB灰度轉化、HSV轉換、閾值分割、連通域閉運算、特征提取、數據庫匹配解碼、顯示等過程,提取包裝上外觀和條碼信息,將求解算法以C#格式輸出至VS2010窗體,同步至人機界面上顯示類型并計數,機器人完成分揀。

3.2 圖像處理

上述環節中,圖像采集前需調整好光源和相機目標區域一致,消除因輸送帶干擾拍照效果,拍照幀數大于輸送帶運動頻率。將采集的RGB圖灰度轉化成灰度圖和HSV圖,顯化顏色判別和提取特征[8?9]。

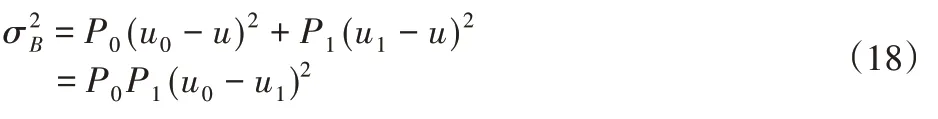

特征提取重點是從得到的HSV 圖中選取比較明顯的灰度圖,通過閾值分割和連通域運算后,提取輪廓和條碼區域,難點是輪廓的擬合與EAN條碼解碼,將求取的數值與已知數據庫比對,匹配出訓練集的最佳值。機理如下:

3.2.1 灰度轉化

式中:(fx,y)—待處理的數字圖像;

g(x,y)—處理后的數字圖像;

T—定義了f的操作。

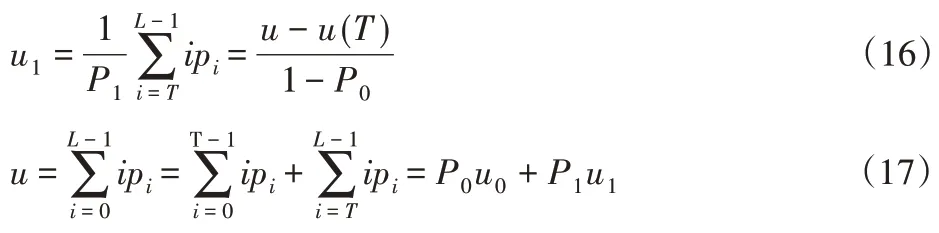

3.2.2 閾值分割(最大類間方差法)

將灰度值為i∈[0,L?1]的像素定義為ni,則:

各灰度值出現的概率為:

對于pi有:

把圖像像素用閾值T分成A和B兩類,A由灰度值在[0,T?1]像素中組成,則B在[T,L?1]像素中組成,概率分別為:

用u表示整幅圖像平均灰度,所屬的區域A、B的平均灰度分別:

區域總方差為:

式中:N—灰度值;

P—概率;

u—平均灰度;

—區域總方差。

讓T在(L?1)區間內取值,使最大的T即為最佳區域閾值,圖像處理效果最佳。

3.2.3 Canny邊緣

Canny邊緣檢測算子是一種具有較好邊緣檢測性能的算子,利用高斯函數的一階微分性質,把邊緣檢測問題轉換為檢測函數極大值的問題,能在噪聲抑制和邊緣檢測之間取得較好的折中[8]。

式中:f—圖像數據;

H—省略系數的高斯函數;

G—濾波后的平滑圖像。

垃圾外包裝的條碼圖像處理過程,如圖5所示。可正確讀取并顯示結果文本。

圖5 圖像處理流程Fig.5 Image Processing Flow

3.3 MCGS界面設計

為便于結果可視化,將圖像分析結果在MCGS人機界面上實時顯示[9]。

將Halcon 平臺上算法以C#格式導出,同步至VS 2010 的Winform 窗體下,通過TCP/IP 通信協議下載到MCGS 人機界面,實現垃圾種類和數量可視化,如圖6所示。

圖6 通信調試界面Fig.6 Communication Debugging Interface

4 試驗與分析

4.1 試驗材料與環境

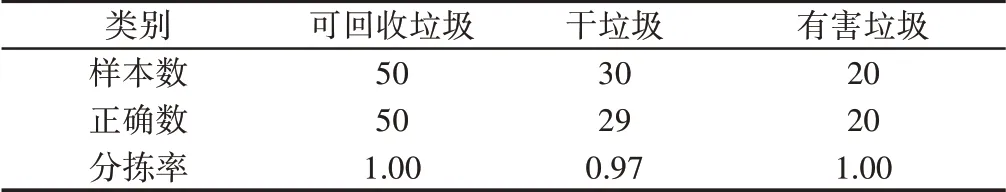

試驗樣本來自某超市售賣的流通商品,外包裝表面均有條形碼,根據垃圾分類標準,試驗獲取流通商品數據庫含4765種垃圾信息,因各類垃圾基數相差較大,分別選取可回收垃圾50種、干垃圾30種和有害垃圾20種,長寬高或直徑尺寸均小于100mm,隨機混裝在試驗用托盤中,如圖7所示。

圖7 試驗環境Fig.7 Test Environment

4.2 機器人系統初始化

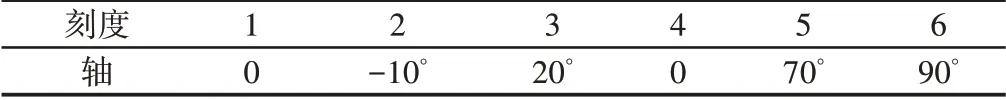

調試前,將機器人初始化[8]。設置機器人校準位置,使霍爾傳感器信號為0,其他位置為1,各軸顯示刻度,如表2所示。根據右手法則新建工具坐標系Tool 1,使原點位于夾爪中心,Z軸垂直于法蘭盤端面。

表2 機器人各軸校準刻度Tab.2 Calibration Scales for Robot Axes

4.3 試驗結果

設置輸送帶在V=100mm/s速度下,對3類共100種垃圾進行隨機分揀測試結果,如表3 所示。可知測試中機器人分揀率達97.0%以上。采集條碼與數據庫匹配平均時間0.002s,表明本設計具有較高的準確性與穩定性。

表3 試驗結果Tab.3 Test Results

5 結語

以Halcon機器視覺為載體的ABB機器人運動控制平臺,對流通商品外包裝垃圾進行實時分揀。

介紹了系統組成與工作原理,求解了IRB1410機器人本體的逆運動學方程,優化了視覺系統圖像處理的技術流程,包括圖像采集、灰度轉化、閾值分割、流通域和匹配解碼等,采用Canny算法改善邊緣信息處理效果,設計了Winform 窗體和MCGS 界面,通過上位機串口通訊的方式將分析結果輸出給機器人,執行末端實現精準分揀。

經試驗,本系統分揀率達97.0%以上,表明該系統可達較高的準確度和可行性,在實際工程中具有一定的推廣價值。