基于差分隱私的聯邦學習數據隱私安全技術*

黃精武

(中國電子科技集團公司第七研究所,廣東 廣州 510310)

0 引言

隨著大數據技術日益發展,數據泄露、數據非法訪問、數據篡改等數據安全問題越來越受到世界各國的關注,對用戶數據的隱私和安全日益嚴格的管理將是世界趨勢[1]。聯邦學習(Federated Learning,FL)是一種分布式機器學習策略,通過學習從多個分散的邊緣客戶端所掌握的訓練數據來生成全局模型,有效解決了“數據孤島”問題[2]。隨著聯邦學習技術的發展,聯邦學習在保護用戶訓練數據、實現數據“可用不可見”的基礎上,獲得了性能上較大的提高,并越發接近數據集中式學習的性能[3]。

訓練高精度的聯邦學習模型需要大規模、高質量的數據支撐,而高質量數據的數據采集、數據清洗和數據標注等預處理工作需要投入高昂的人力、物力,且由于聯邦學習中各方數據難以直接獲取,聯合建模需要多方協調配合,因此聯邦學習任務本身需要較高的商業成本。因此,隱私保護是聯邦學習系統尤為重要的一個話題。隱私攻擊是聯邦學習系統面臨的一個主要威脅[4],惡意攻擊者竊取用戶原數據或訓練好的模型參數等隱私信息,發起隱私攻擊,將會危害聯邦學習模型的機密性(Confidentiality)。

聯邦學習一經提出,便備受關注。國內外已有大量針對聯邦學習中隱私保護技術的性能、安全隱患及其缺點的研究。早在2018年,Rahman[5]便指出了聯邦學習中對全局更新貢獻較大的參與成員,以及近似推理了原始訓練數據。Geiping等人[6]指出了在聯邦學習更新過程中,能夠從產生的梯度信息近似推理并重構出客戶端的原始訓練數據。Mothukuri等人[7]在不干涉本地訓練過程的前提下,運用成員推斷攻擊,并通過篡改其在通信過程中傳輸的梯度,減弱了全局模型的效能。

本文主要針對聯邦學習可能面臨的安全和隱私威脅進行分析,著重闡述隱私安全問題,總結了一些防御措施。在這些防御措施中,本文重點對差分隱私進行介紹,分析其隱私安全性能,以期進一步減小聯邦學習系統中的隱私風險。此外,還利用基于拉普拉斯機制[8]的差分隱私算法設計了一個聯邦學習的隱私保護方法,并通過實驗分析了該方法對模型性能的影響。

1 聯邦學習概述

聯邦學習是一種分布式機器學習算法,但在學習過程中,各個參與方不會共享自身的訓練數據,每個聯邦學習利用多個計算節點進行聯合訓練,旨在提高性能、保護隱私信息,并使其可以擴展到更大規模的訓練數據和更大規模的模型[9]。聯邦學習打破了“數據孤島”,實現了數據隱私保護和共享分析的平衡,即“數據可用不可見”的數據應用模式。

1.1 聯邦學習的定義

聯邦學習中的角色主要包括客戶端(參與方)和服務器。假設有k個客戶端參與了聯邦學習,第i個客戶端為Ci,所擁有的訓練數據集為Di,本地模型為Mi,其中i=1,2,3,…,k。聯邦學習的目標是從所有訓練數據組成的數據集中訓練出一個全局模型MGlobal。目前聯邦學習系統中常用的聚合策略包括聯邦平均(Federated Averaging,FedAvg)和聯邦隨機梯度下降(Federated Stochastic Gradient Descent,FedSGD)等。然而,不同于直接利用數據集D本身來訓練一個中心化模型MCentral,在聯邦學習中,第i個客戶端不能訪問數據集假設模型的效果為V,則聯邦學習系統的優化目標為:

式中:||·||為某種范數或距離度量。

一般地,基本的聯邦學習系統至少包括初始化(分發全局模型)、本地更新和全局聚合3個步驟。[10]

1.2 聯邦學習的分類

聯邦學習系統中,每個參與方Ci只擁有其本地的訓練數據集Di,并且這些數據集在樣本空間和特征空間上有不同程度的重合,造成了聯邦學習系統進行學習的依據不同。根據學習依據,聯邦學習系統分為橫向聯邦學習、縱向聯邦學習和聯邦遷移學習3類。

橫向聯邦學習按照樣本空間對數據集進行劃分,并取出特征相同而樣本不同的部分來進行訓練。縱向聯邦學習與橫向聯邦學習相反,是根據特征分布來進行學習的。聯邦遷移學習適用于參與方的數據集中特征空間和樣本空間重疊都很少的情況。聯邦遷移學習中,不對數據進行切分,而是利用遷移學習[11]的方法來解決數據及標簽不足的問題。

2 聯邦學習面臨的隱私威脅

盡管聯邦學習系統中各個參與方的訓練過程是獨立進行的,且沒有原始訓練數據的傳輸,可以保證一定的隱私安全,但這并非絕對安全的。惡意的參與方可以從更新信息中推理出較為活躍的成員信息,甚至可以重構訓練數據。

2.1 聯邦學習中的隱私威脅

聯邦學習中的參與方往往容易受到模型提取攻擊[12]和模型逆向攻擊[13]這兩大類攻擊。聯邦學習系統中一般假定服務器端是非惡意的,但這樣的假設不能防范“誠實但好奇”(Honest but Curious)[6]的服務器,這類服務器端雖然確實完成了應有的聚合任務,不會對模型性能發起攻擊造成破壞,也不會破壞模型的可用性,但是會嘗試竊取參與方本地數據集中的數據,破壞參與方數據的機密性,威脅數據參與方的隱私安全。

2.2 模型提取攻擊

在模型提取攻擊中,攻擊者試圖竊取模型的參數、超參數等,破壞了模型的機密性。

一般而言,模型提取攻擊中,攻擊者試圖構建一個與原模型相似的替代模型。因為攻擊者缺少對模型結構的了解,所以此類攻擊一般為黑盒攻擊。首先,攻擊者利用一組數據X={X1,X2,…,Xn}對被提取的模型發起查詢操作,并獲得查詢結果Y={Y1,Y2,…,Yn},由此構造出一個訓練數據集D={(X1,Y1),(X2,Y2),…,(Xn,Yn)};其次,攻擊者將利用數據集D來訓練替代模型,直到替代模型的效果達到了攻擊者的預期。模型提取攻擊的基本原理如圖1所示。

在實際應用過程中,聯邦學習模型的訓練代價與成本都是較高的,而模型提取攻擊使得攻擊者能夠以極低的訓練代價獲得一個與原始模型性能相近的替代模型,嚴重損害了聯邦學習參與方的隱私安全和商業利益。

2.1.2 模型逆向攻擊

在模型逆向攻擊中,攻擊者一般試圖通過在訓練完畢的模型中不斷地查詢,獲得一些統計信息,進而推理出用戶的隱私信息。根據攻擊者推理的信息,可以將模型逆向攻擊分為屬性推理攻擊(Property Inference Attack,PIA)[14]和成員推理攻擊(Member Inference Attack,MIA)[15]。在屬性推理攻擊中,攻擊者的目標在于判斷參與方的訓練數據集中是否含有某個特征。在成員推理攻擊中,攻擊者的目標在于判斷某一條數據記錄是否包含在參與方的訓練數據集中。

除上述推理攻擊,近幾年一些基于生成對抗網絡(Generate Adversarial Networ,GAN)的推理攻擊[16]也成為一種較常見的逆向攻擊的手段。

3 防御隱私威脅的措施

聯邦學習的隱私防護工作需要從參與方和服務器兩大主體分別進行。從原理上來看,多數聯邦學習隱私安全的方法都是基于密碼學的。

基于密碼學的聯邦學習隱私安全方法主要包括安全多方計算[17]、同態加密[18]等,主要用于模型訓練階段的隱私保護,可以防御一些模型逆向攻擊。這些方法可以用來防御惡意的或“誠實但好奇”的參與方和服務器端,且在傳輸信息被截獲的條件下,仍然能從密碼方面保障安全。這些保護措施的安全性主要體現在密碼學算法的安全性,同時需考慮密碼學算法的時空效率。

另外有一些不基于密碼學的隱私安全方法,例如差分隱私(Differential Privacy,DP)[19],主要用于模型訓練完畢后的隱私保護,其可以通過加噪的方法防御一些模型提取攻擊和推理攻擊。這些保護措施的安全性的高低主要體現在能否使得明文信息能夠推理出盡量少的敏感信息。

4 差分隱私方法概述

4.1 差分隱私的基本定義

在介紹差分隱私的定義之前,首先介紹鄰近數據集(Adjacent Dataset)的定義。設有兩個數據集D與D',若它們的對稱差中元素的數量滿足|DΔD'|=1,則稱D與D'互為鄰近數據集。

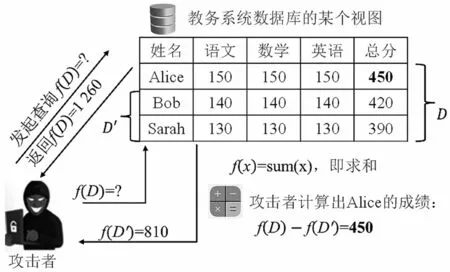

差分隱私在提出的初期,主要應用于數據庫安全保護。設f為一個查詢函數,即一個映射,可以是求和、求平均、求最值或其他查詢操作,則攻擊者多試圖通過比較f(D)與f(D')的差異來推理出數據庫中的敏感信息。一個推理攻擊的示例如圖2所示。

圖2 推理攻擊示例

對于鄰近數據集D與D',設有一隨機算法M,PM為該算法所有可能的輸出,對于任意SM?PM,都有:

則稱隨機算法M滿足?-差分隱私。式中:e為自然對數的底數;?為隱私預算。當隱私預算?的值越小,隨機算法M在D和D′上獲得相同的輸出結果的概率也就越接近,所以當用戶對數據集進行查詢的時候,無法通過輸出結果區分這條數據是來自鄰近數據集中的D還是D',即無法察覺到這個數據集中微小的變化。反之,?的值越大,隱私保護效果也就越弱。因此,可以得出,過大的隱私預算會導致無法達到預期的隱私保護效果,過小的隱私預算雖然能達到隱私效果,但加噪力度太大容易導致查詢結果完全無法使用。

若隨機算法對于D與D'滿足:

其中,δ>0,則稱隨機算法M滿足(?,δ)-差分隱私。δ是一個松弛項,表示差分隱私可以接受一定程度的不滿足。

4.2 差分隱私的敏感度分析

為了獲知對于特定的隨機算法函數M,需要添加多少噪聲才能滿足(?,δ)-差分隱私,并且需要獲知該算法在當前數據集中刪除一條數據引起的查詢結果的最大改變量。差分隱私算法有兩種敏感度,分別是全局敏Gt感度(Global Sensitivity)和局部敏感度(Local Sensitivity)。

4.2.1 全局敏感度

設一映射f:D→Rd,其輸出為d維實向量,則全局敏感度定義如下:

全局敏感度為一個l1范數定義的表達式,由函數本身決定,而和D與D'無關。當全局敏感度較小時,只需要添加較小的噪聲,就能使函數M滿足(?,δ)-差分隱私。

4.2.2 局部敏感度

由于全局敏感度較大時,需要添加強度足夠大的噪聲才能保證隱私安全,這可能導致數據不可用,因此Nissim等人定義了局部敏感度,則f在數據集D上的局部敏感度具體為:

可以發現局部敏感度與全局敏感度的關系如下:

局部敏感度通常比全局敏感度要小很多,并且局部敏感度取決于映射f本身與原始數據集D,然而,局部敏感度在一定程度上體現了數據集的分布特征,因此只用局部敏感度來確定噪聲強度大小,仍然容易造成隱私泄露。

4.3 差分隱私的實現方法

在具體實現差分隱私時,需要根據不同的隨機算法采取不同的實現機制。常見的機制包括指數機制(Exponential Mechanism)和拉普拉斯機制(Laplace Mechanism)等。

4.3.1 拉普拉斯機制

拉普拉斯機制是向確定的查詢結果中加入服從拉普拉斯分布的噪聲。此分布有兩個參數,包括尺度參數λ和位置參數μ,其分布密度函數為:

將該分布記作Lap(μ,λ)。如向查詢結果中添加尺度參數的服從拉普拉斯分布的噪聲n能夠形成一個隨機算法M,即M(D)=f(D)+n,則可以證明隨機算法M提供了?-差分隱私保護[8]。其中,Δf指的是f的敏感度。

一般來說,拉普拉斯機制適合數值型結果的保護。

4.3.2 指數機制

在許多應用場合,查詢結果都是非數值的,例如一個實體對象。設r為隨機算法的輸出,q(D,r)為一個用來評估輸出優劣性的可用性函數,Δq為q(D,r)的敏感度。可以證明[20],如隨機算法M能夠以正比于的概率輸出r,則算法M能夠提供?-差分隱私保護。

5 利用差分隱私保護聯邦學習系統安全

在安全保護領域的隱私保護機器學習(Privacy-Preserving Machine Learning,PPML)技術中,主要有兩種攻擊者:一種是“誠實但好奇”的攻擊者,這種攻擊者會誠實地遵守協議,但會試圖從接收到的信息中獲取更多輸出結果以外的信息內容;另一種是惡意的攻擊者,這種攻擊者不遵守規定的協議,會試圖發起任意的攻擊行為。本文采用拉普拉斯機制來實現差分隱私,提出了一種差分隱私方法,并簡要分析了方法的合理性。

5.1 聯邦學習服務器對隱私安全的保障

為了滿足以上隱私保護的目的和要求,本文在協調方發送給各個參與方的全局模型上實施差分隱私保護。在本文的聯邦學習系統中,聚合算法采用聯邦平均算法,其表達式為:

式中:t為全局模型更新的輪次;G t和G t+1為第t輪次和第t+1輪次更新的全局模型參數;η為全局模型更新λ的學習率;n為客戶端的數量;m為當輪被選擇參與本輪全局模型更新的客戶端數量;為在第t+1迭代輪次中被選中的第i個參與方在本地數據訓練后的本地模型;為第t+1迭代輪次中被選中的第i個參與方在本地數據訓練的更新梯度。

因此,當“誠實但好奇”的參與方或是惡意的參與方對模型發起成員推理攻擊,威脅參與方隱私安全和數據安全時,所要查詢的就是協調方發送給各個參與方的全局更新模型G t+1,所以可以得知查詢函數為:

為了防止服務器發出的全局更新被攻擊者推理出敏感信息,服務器將在聚合時對模型梯度添加噪聲。這里采用的是拉普拉斯機制。服務器端的聚合方法如下:

其中,查詢函數敏感度的一個邊界為:

式中:M'為參與方集合M的用戶鄰近數據集,即集合M'與集合M相比,有且僅有一個參與方不同;||Δk||1為第k個參與方更新梯度的l1范數。

式(11)中,當||Δk||1≤C時,式子中的分母會取到1,裁剪出來的梯度Δ與裁剪前的梯度Δk相同,滿足裁剪邊界||Δk||1≤C;當||Δk||1≥C時,分母的值會取到,于是裁剪后的度的值就為,也同樣滿足裁剪邊界||Δk||1≤C,因此,該裁剪方法是合理的。

5.2 聯邦學習參與方對隱私安全的保障

對于一個非惡意的服務器而言,如4.1節所述,其隱私保護的主要目的是防御惡意的參與方或外部攻擊者實施推理攻擊。同樣地,作為一個聯邦學習參與方,也需要防范一些非善意的參與方或服務器試圖破壞隱私安全的行為。因此,參與方在上傳其梯度更新時,也將對梯度進行一些諸如梯度裁剪的處理,以保護其隱私安全。

對于參與方而言,通過對裁剪梯度,可以做到本地差分隱私(Local Differential Privacy,LDP)[19]。在這種方式之下,參與方對自己上傳至協調方的梯度進行擾動,對梯度進行裁剪再上傳至協調方可以在協調方不受到信任的時候能夠有效地對本地數據進行保護,將已混淆的數據發布至不受信任的協調方可以有效地保護參與方用戶的隱私安全和數據安全。同樣地,據3.3節所述,下列算法能夠做到(?,δ)-差分隱私。

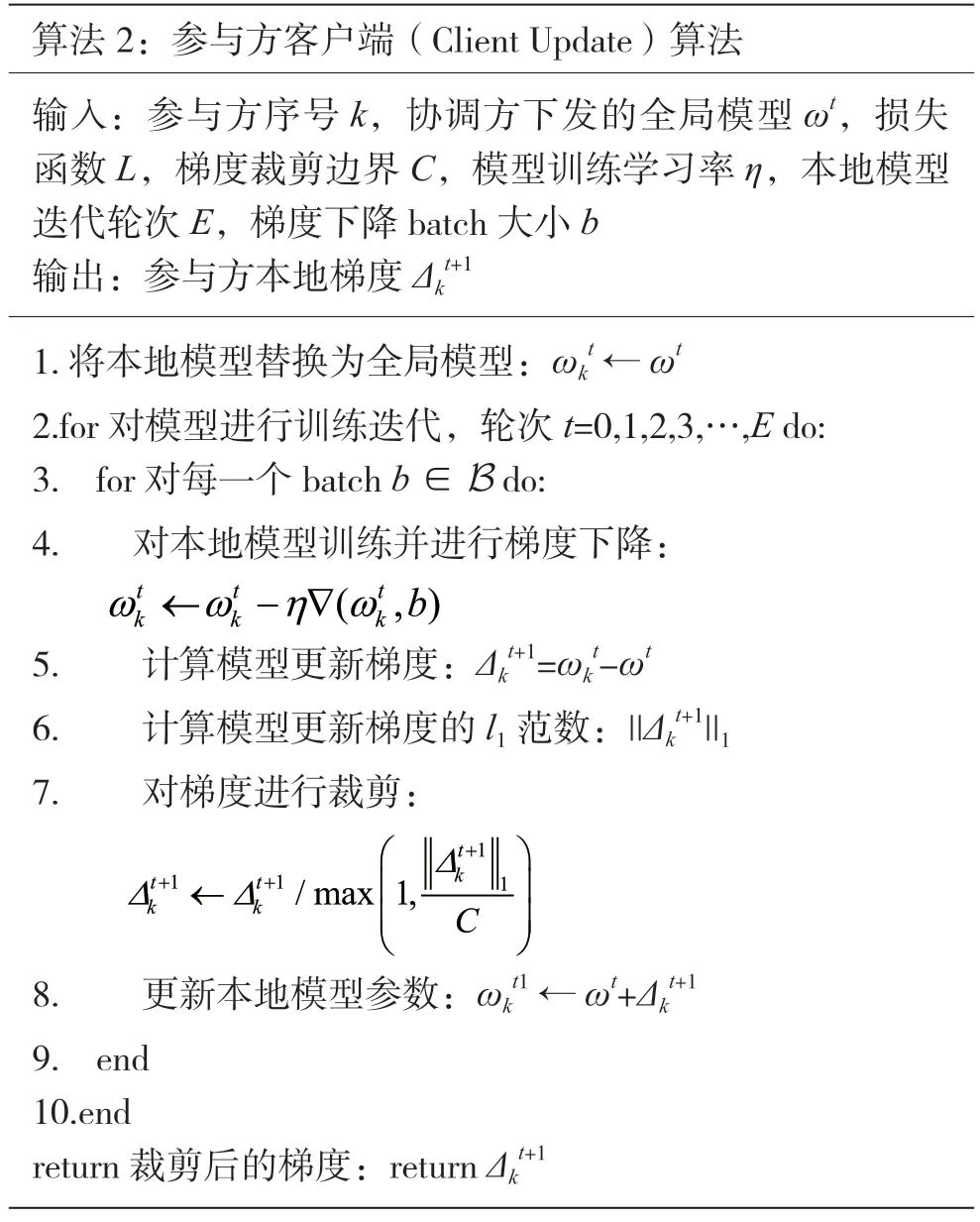

參與方所完成的任務是訓練本地模型并上傳更新梯度,上傳更新的算法如下:

5.3 實驗分析

據5.1節與5.2節所述,算法1和算法2在理論上能夠做到差分隱私。下文將分析差分隱私對聯邦學習性能的影響度,這里采用的實驗數據集為CIFAR-10,采用的圖片分類模型為卷積神經網絡(Convolutional Neural Network,CNN)的ResNet-18網絡結構。

5.3.1 收斂效率與準確率分析

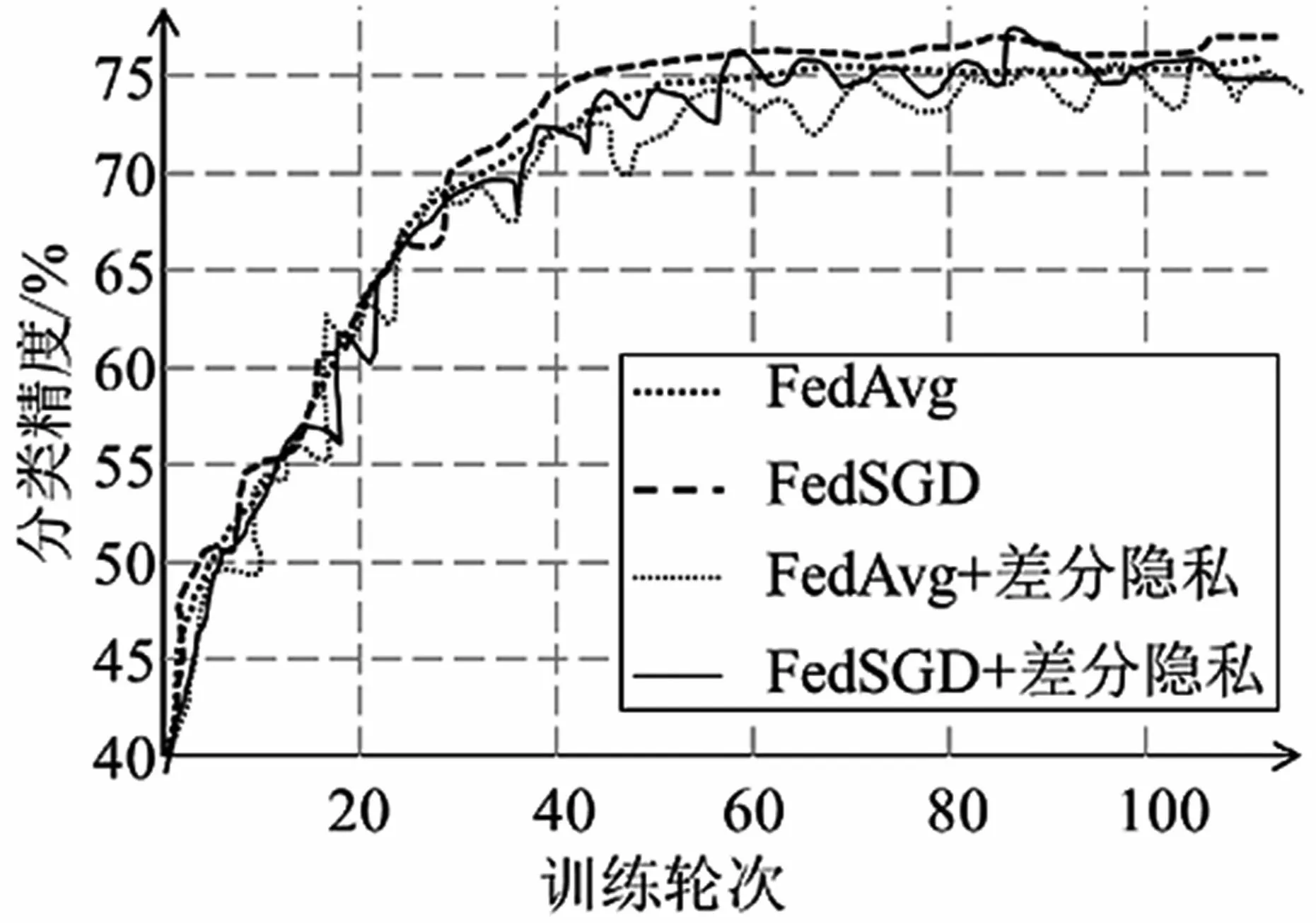

本節分別對比了聯邦聚合算法FedAvg和FedSGD在加入差分隱私前后的性能。將聯邦平均算法FedAvg的參數設置為:全局模型迭代輪次(epochs)E=100,參與方總數N=10,每輪選擇參與訓練的參與方數量n=3,參與訓練的用戶方本地訓練輪次e=3。聯邦梯度下降算法FedSGD參數設置為:全局模型迭代輪次E=100,參與方總人數N=10,每輪選擇參與訓練的參與用戶數量n=10,參與訓練的用戶方本地訓練輪次e=1。基于拉普拉斯噪聲的差分隱私算法的參數設置為:拉普拉斯噪聲的標準差σ=0.001,參與方上傳的梯度的裁剪閾值c=1。

實驗結果如圖3所示。由圖3可知,圖中所示訓練方法的模型準確率都隨訓練輪次的增加而逐漸增加,最后都穩定在75%左右,且兩種聚合算法FedAvg和FedSGD的收斂速度和準確率無明顯區別。同時發現,添加了差分隱私的兩種聯邦平均算法與不添加差分隱私的原始算法的收斂速度與準確率也無明顯差距。這說明,差分隱私一般不會顯著影響模型的收斂性能。

圖3 聯邦聚合算法FedAvg和FedSGD在加入差分隱私前后的性能對比

5.3.2 差分隱私參數的變化影響分析

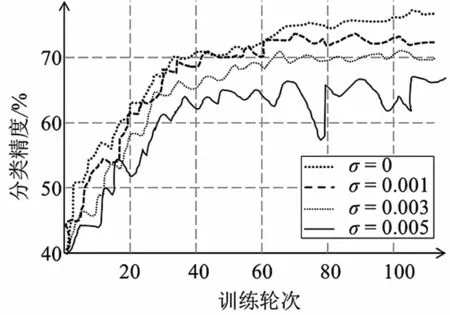

本節分析的參數是隱私預算,這里通過調整拉普拉斯噪聲的標準差σ來控制隱私預算,所用的聚合算法是FedAvg,其參數設置為:全局模型迭代輪次E=100,參與方總數N=10,每輪選擇參與訓練的參與用戶數量n=3,參與訓練的用戶方本地訓練輪次e=3,參與方上傳的梯度的裁剪閾值c=1。對添加拉普拉斯噪聲的大小按一定間距設置,并進行對比。

實驗結果如圖4所示。從圖中可以看出,在同樣的迭代輪次中,隨著添加的拉普拉斯噪聲標準差逐漸增大,即隨著隱私預算的減小,訓練模型的準確率有明顯的降低。若要使聯邦學習訓練模型達到同樣的準確率和性能大小,需要訓練更多的輪次才可達到這樣的效果。結合圖3可以發現,雖然差分隱私措施對于模型的收斂性可能無顯著影響,但收斂后的最優效果可能隨著隱私預算的減小而出現顯著損失。

圖4 添加的拉普拉斯噪聲的大小對聯邦學習模型準確率的影響

5.3.3 裁剪閾值的變化影響分析

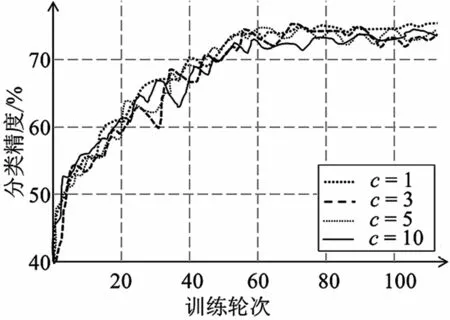

本節對裁剪閾值的變化進行分析,所用的聚合算法是FedAvg,其參數設置為:全局模型迭代輪次E=100,參與方總人數N=10,每輪選擇參與訓練的參與用戶數量n=3,參與訓練的用戶方本地訓練輪次e=3,模型添加的噪聲σ=0.001。對用戶上傳梯度的裁剪閾值按一定間距設置,并進行對比。

實驗結果如圖5所示。可以發現,不同參與方上傳的梯度裁剪閾值下的曲線幾乎重合,即參與方上傳的梯度裁剪的閾值的不同對模型的性能無顯著影響,即不會顯著影響模型訓練的準確率和模型收斂性。

圖5 裁剪參與方上傳梯度的閾值對聯邦學習模型準確率的影響

綜上實驗結果分析表明,這里提出的差分隱私算法,除了在理論上能夠保證差分隱私,也不會對被保護模型的收斂性能有顯著影響。然而,拉普拉斯噪聲的添加會導致模型準確率的下降,且隨著噪聲標準差的增大,模型準確率的下降愈發劇烈。此外,梯度裁剪方法不會對模型準確率產生顯著的影響,這是因為梯度裁剪算法并沒有向梯度信息中添加噪聲。在簡單模型和數據集上,差分隱私算法的添加也不因聚合算法的不同而顯著影響模型的收斂性能和準確率。因此,可以得出,上述的聯邦學習差分隱私算法在不顯著影響模型準確率的前提下能實現隱私保護。

6 結語

本文主要研究了差分隱私在聯邦學習隱私保護中的一些應用,探討了差分隱私的不同實現機制及其適用條件。最后本文討論了差分隱私對聯邦學習系統中不同角色的應用方法,簡要分析了具體算法,并得出聯邦學習中差分隱私方法能夠在不顯著影響模型準確率的前提下實現隱私保護。

此外,聯邦學習本身雖然有一定的隱私保護屬性,但仍存在一定的隱私風險。在聯邦學習系統中,差分隱私方法中裁剪的閾值和噪聲的大小決定著對參與方本地數據隱私和用戶隱私的保護強度,裁剪閾值越小則對本地數據隱私保護的強度越強,噪聲大小越大則對用戶隱私的保護強度越強。