基于深度強化學習的密集物體溫度優先推抓方法*

陳 滿, 李茂軍, 胡建文, 賴志強, 李俊日

(長沙理工大學 電氣與信息工程學院,湖南 長沙 410114)

0 引 言

機器人的抓取在冶金、鋼鐵和原子能等工業中有著廣泛的應用。上述工業中的抓取對象常具有形狀不規則、危險系數高(高溫、強輻射等)、密集堆疊等特性;有時還需優先考慮溫度因素,即抓取動作需有溫度優先性(在抓取過程中最大程度地優先抓取高溫物體,以降低對設備與環境的危害)。這里重點考慮形狀不規則、密集堆疊,需要優先考慮溫度因素的動作場景,提出了一種基于深度強化學習的密集物體溫度優先推抓(high-temperature priority pushing and grasping method for dense objects,TPG)方法,提高了抓取完成率和抓取成功率,并且具有優先抓取溫度較高物體的能力。

1 相關研究

機器人抓取的主要方法有基于模型方法和無模型的數據驅動方法。傳統的基于模型方法主要包括有Sanz P J提出的接觸面建模法,通過對機器人和抓取對象的接觸面進行力學建模來完成抓取操作[1],這類方法難以應用于非結構化場景。隨著機器學習的發展,無模型的數據驅動方法成為了熱門研究方向,主要思路是提取對象的特征,建立特征和機器人關節或末端執行器之間的映射關系,無需建立物理模型便可完成抓取任務,Zeng A等人使用全卷積網絡(fully convolutional network,FCN)提取對象的特征并指導機器人抓取物體[2]。基于深度強化學習(deep reinforcement learning,DRL)的抓取方法也是一種數據驅動方法,在機器人抓取方面取得了出色的成果,Zeng A等人首次將推動和抓取動作進行聯合處理,提出了基于DRL的推抓方法,得到了更好的抓取效果[3]。

本文針對密集堆疊、需要考慮溫度因素的高難度抓取場景,提出了TPG方法。建立以FCN為基礎的端到端映射,將紅外圖像添加到映射輸入;建立推動和抓取的聯合框架,改善了抓取效果;在獎勵函數中考慮溫度因素,使其適用于溫度優先的抓取場景;創建溫度優先度指標,評估動作的溫度優先性。

2 深度強化學習簡介

基本的強化學習以馬爾科夫決策過程(Markov decision process,MDP)為理論框架:在t時刻獲取狀態st,智能體根據策略π選擇并執行動作at,然后過渡到新的狀態st+1并獲取獎勵r(st,at)。最終目的是找到一個最優策略π*,該策略可以最大化未來獎勵之和

(1)

式中γ∈[0,1)為未來獎勵的折扣系數。狀態-動作值函數可以表示為

(2)

依據最優策略π*可以得到最佳的狀態—動作值函數Qπ*(st,at),用貝爾曼最優性方程表示為[4]

(3)

式中a′為狀態st+1能夠執行的所有動作。

為解決傳統強化學習(RL)的感知能力不強的問題,DeepMind團隊提出了深度Q網絡(deep Q network,DQN)模型[5]。DQN使用深度神經網絡(DNN)作為非線性函數近似器來近似Q值,并通過目標Q網絡計算目標值yt,以此更新Q網絡參數,yt表示為

(4)

式中θ′為目標Q網絡的參數。

3 密集物體溫度優先推抓方法

3.1 場景分析

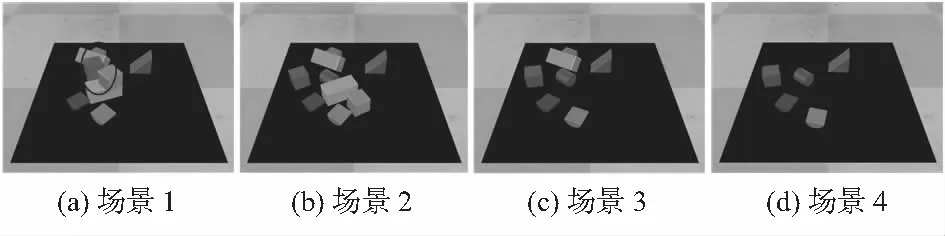

如圖1中場景1所示,橢圓內物體之間密集排列且相互堆疊,為直接抓取造成了難度;溫度優先抓取則需要最大程度地優先抓取溫度較高的物體,若該物體位于堆疊物體下部,則抓取軌跡會被阻擋,普通抓取動作難以完成任務。TPG方法可以先對物體進行推動,為抓取動作提供足夠的空間,部分后續抓取場景效果圖如圖1(b)~(d)所示。

圖1 抓取場景效果

3.2 模型建立

3.2.1 TPG方法總體描述

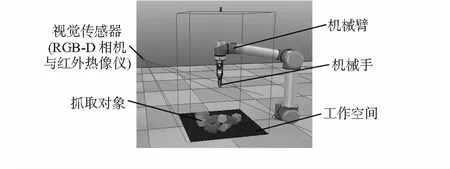

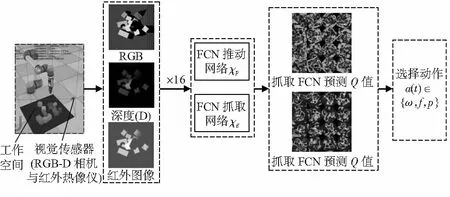

TPG方法總體描述如下:1)首先由RGB-D相機與紅外熱像儀提取環境狀態,經過點云匹配與正交變換轉換成高度圖;2)將高度圖旋轉16次(原因見3.2.3節),再分別經過兩個FCN輸出所有像素點的Q值;3)依據Q值和ε—貪婪策略指導動作,并獲得獎勵;4)不斷通過目標Q網絡進行訓練。主要仿真設備環境如圖2所示,TPG方法流程圖如圖3所示,下面分別對狀態、動作、狀態—行為值函數、獎勵函數進行建模。

圖2 仿真設備環境

圖3 TPG方法流程圖

3.2.2 狀 態

(5)

狀態st經過3D點云匹配和重力方向投影生成高度圖,其中高度圖的邊緣是依據末端執行器的工作空間來定義的,工作空間為一個面積為S的正方形(圖2中黑色區域),取S=4482mm2。

3.2.3 動 作

動作at包括三個要素:1)動作類型ω,有推動和抓取兩種類型;2)動作方向f,f反映了末端執行器的旋轉角度,由于直接建立從狀態到旋轉角度的映射較為困難,因此,將輸入高度圖旋轉16次(每隔22.5°旋轉一次),對應輸出16張Q值圖,采用這種方法使機器人對旋轉方向的選擇近似為對16張Q值圖的選擇;3)動作位置p,動作位置是末端執行器推動或抓取的像素點。因此動作at描述為

at={ω,f,p}

(6)

3.2.4 狀態—動作值函數——FCN

使用FCN進行狀態—動作值函數近似。如圖3所示,設置兩個FCN(推動網絡χp和抓取網絡χg),將推抓動作聯合在同一個框架內。對兩個網絡輸出的16張Q值圖進行拼接,最終在兩張Q值圖(均由16張圖片拼接而成)中選擇最大Q值的像素點作為最佳動作點。

χp和χg具有相同前向傳遞結構。首先兩個網絡的DenseNet—121分別在ImageNet上預訓練,然后經過通道級聯和兩個1×1的卷積層(每層包括一個批量歸一化BN層和一個非線性激活函數ReLU層)。DenseNet由多個Dense Block組成,每一層的輸入都與前面所有卷積層的輸出有關。

3.2.5 獎勵函數

(7)

式中I為紅外圖像的熱值,L為熱像儀的熱平,R為熱像儀的熱范圍,X為偽彩色值。再利用熱值與絕對溫度的關系,可得出對應點的溫度值[6]

tp=B/log[(Aτξ/I+1)]

(8)

式中τ為透射率;ξ為物體發射率;A,B為熱像儀標定曲線常數;tp為溫度值。由上述式(7)、式(8)可知,抓取點偽彩色值和溫度的關系為非線性關系。溫度獎勵Rg-hot為

(9)

式中tmax為所有像素點的最大溫度值,ρ為獎勵因子,取值為7.5。

綜合以上三部分獎勵,可得獎勵函數

(10)

3.3 訓練過程

使用Huber損失函數進行訓練

(11)

在訓練過程中使用的動量梯度下降方法,具體參數為:動量0.9,權重衰減2-5,學習率10-4;未來獎勵折扣γ恒定為0.5;使用優先經驗重播方法,對于不同的經驗集設置不同的采樣權值,采樣權值與經驗集的時間差分有關;使用ε—貪婪策略,貪婪因子ε為隨機選擇下一步動作的概率,在前500次動作中取值為0.5,在500~1 500次動作中從0.5逐步衰減到0.1,并在后續訓練中保持不變。

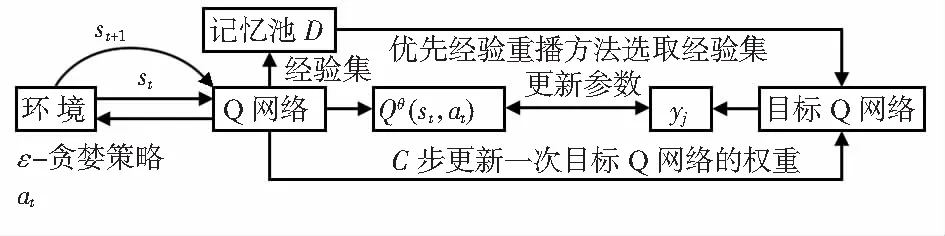

綜上可得基于深度Q網絡的機器人密集物體溫度優先推抓決策算法,用該算法進行訓練,算法流程圖如圖4所示。

圖4 算法1流程圖

輸入:未來獎勵折扣γ、學習率、權重衰減、動量、目標網絡權重參數更新周期;

初始化:容量為N的記憶池D;初始化經驗集;初始化Q網絡并隨機權重θ;初始化目標Q網絡和權重θ′,使θ′=θ

Begin

1)For episode=1,Mdo

2)初始化機器人工作空間,獲取初始狀態s1

3)Fort=1,tmaxdo

4)使用ε—貪婪策略選取動作

5)執行動作at,過渡到新狀態空間,st+1并獲得獎勵r(st,at)

6)如果記憶池D的經驗集為N,則刪除最早的經驗集

7)組成經驗集〈st,at,r(st,at),st+1〉存入D中

8)更新經驗集的被采樣概率

9)使用優先經驗重播方法從D中抽取一個經驗集j

10)依據經驗集j計算目標值yj

11)ifsj+1為最終狀態

yj=rj+1

else

yj=rj+1+γmaxa′Qθ′(s′,a′)

12)使用動量梯度下降方法更新Q網絡的權重參數θ

13)隔C步更新一次目標Q網絡權重參數,使θ′=θ

14)更新貪婪因子ε// 500~1 500次迭代

15)End for

16)End for

End for

4 實驗與結果分析

4.1 仿真實驗

使用RTX 2080Ti顯卡進行訓練,使用V-REP仿真軟件中的UR5機械臂和RG2機械手進行動作,使用內部的V-REP逆運動學模塊進行運動規劃。為了建立與實際場景相似的環境,每次生成溫度、顏色、形狀隨機的10個物體。

4.2 訓練實驗與結果分析

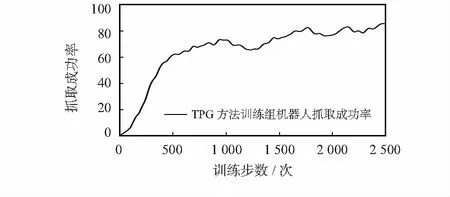

對TPG方法進行了2 500次訓練,并繪制訓練過程中的抓取成功率曲線圖(圖5)。

圖5 機器人抓取訓練過程曲線

由訓練結果可以看出,隨著機器人迭代次數的增加,抓取成功率逐漸上升,其中前500次訓練過程上升效果最為明顯,說明機器人使用TPG方法在該場景下的抓取效果逐漸變好。

4.3 測試實驗與結果分析

設置三組測試實驗:TPG方法,無紅外圖像與溫度獎勵(no temperature factor,PG)方法,無推動(no pushing,TG)方法。對于每組測試實驗進行40次重復測試,每次實驗設置10個隨機物體,均在工作空間內密集堆疊放置5組,計算平均結果。測試實驗的結果也與文獻[4]中的結果進行對比。

設置四個主要評價指標:1)平均完成率C;2)平均抓取成功率GC;3)溫度相關度TR,表征機器人抓取動作對高溫對象的優先性,具體公式為

(12)

E=num(obj)/num(all)

(13)

式中num(obj)為抓取對象的數量,num(all)為所有動作數量之和。

由表1可知,TPG方法、PG方法和VPG方法均可以成功抓取所有物體,而TG方法存在抓取未完成現象,這表明推抓方法在整體完成率上要由優于僅抓取方法。平均抓取成功率GC方面:TPG方法和PG方法分別高于TG方法11.2 %和8.6 %,表明推抓方法可以提升抓取成功率,此外TPG方法的GC分別高于PG方法和VPG方法2.6 %和1.7 %,TG方法的GC高于Grasping-only方法2.4 %,這是由于紅外圖像的加入豐富了輸入特性,有利于機器人充分提取環境信息,從而選擇更好的動作,提升抓取成功率。

表1 測試實驗結果對比 %

平均溫度相關度TR方面:TPG方法和TG方法均顯著高于PG方法,PG方法僅為-6.3 %,這符合無溫度獎勵情況下TR期望為0的預期,說明加入紅外圖像和溫度獎勵后,溫度優先性得到顯著提高;TPG方法的TR高于TG方法18.4 %,這是由于TG方法沒有推動動作,而部分溫度較高物體位于堆疊物體下部,抓取軌跡受到阻擋,TG方法難以優先抓取高溫物體。平均動作效率E方面:TPG方法和PG方法分別高于TG方法4.5 %和8.9 %,這表明推抓方法的動作效率優于僅抓取方法,值得注意的是,TPG方法相比于PG方法和VPG方法有所降低(分別為4.4 %和3.6 %),這是由于TPG方法考慮了溫度因素,需要執行推動動作為溫度較高物體創造足夠的抓取空間,從而導致num(all)上升,動作效率E下降。

由上述實驗結果和分析可知,本文提出的TPG方法對溫度優先的密集物體抓取場景具有較好的效果。TPG方法和PG方法在完成率、抓取成功率和動作效率方面均優于TG方法。雖然TPG方法的動作效率E相比于PG方法略有降低,但是平均溫度相關度TR明顯優于PG方法,因此,在溫度優先抓取的場景下,TPG方法不失為一種較好的選擇。

5 結 論

對于物體密集堆疊、需要優先考慮溫度因素的高難度抓取場景,提出了TPG方法。該方法以DRL為基礎,使用兩個FCN,將推動和抓取放在一個框架內聯合動作,并設置溫度獎勵,使抓取具有溫度優先性。仿真實驗結果表明:該方法抓取效果優于無推動的方法,并且具有優先抓取溫度較高物體的功能。