基于三維卷積神經網絡的肺結節分類

王衛兵 王卓 徐倩 孫宏

摘 要:為提高不易分割診斷的毛玻璃結節的分類準確率,同時針對VGG16網絡結構卷積層數深,參數多的問題,提出一種基于灰度增強、紋理和形狀濾波增強的三維深度卷積神經網絡用于肺結節分類。對VGG16網絡結構進行優化,提出的模型在肺結節公開數據集LIDC-IDRI上進行訓練和測試。結果表明,采用灰度增強、紋理和形狀濾波增強相結合的方法圖像分類精度最高,準確率為91.7%,其他評價指標包括敏感性和特異性也略有提高,優于現有方法。

關鍵詞:肺結節;深度學習;卷積神經網絡

DOI:10.15938/j.jhust.2021.04.012

中圖分類號:TP391.41

文獻標志碼:A

文章編號:1007-2683(2021)04-0087-07

Abstract:In order to improve the classification accuracy of ground glass nodules that are difficult to segment and diagnose and at the same time, the VGG16 network structure has deep convolutional layers and many parameters, A 3D deep convolutional neural network based on intensity, texture, and shape-enhanced images for pulmonary nodule recognition was proposed. The VGG16 network structure was optimized, and the proposed model was trained and tested on the public nodule dataset of lung nodules LIDC-IDRI. The results showed that the proposed method using the composition of intensity, texture and shape-enhanced has the highest image classification accuracy, with an accuracy of 91.7%. Other measures, including sensitivity and specificity, also improved slightly, It is superior to existing methods.

Keywords:pulmonary nodule;deep learning;convolutional neural network

0 引 言

國際癌癥研究機構制定的癌癥發病率和死亡率報告顯示,肺癌是最常見的癌癥,且是死亡率較高的癌癥之一[1]。中國人口眾多,肺癌的發病率和死亡率同樣居高不下,我國男性肺癌發病率和死亡率均排名前列[2]。引起肺癌的原因除了遺傳因素外,主要與大氣污染、大量吸煙、工作壓力和精神因素有關。早期準確的診斷在肺癌治療中起著重要的作用。然而,由于良性和惡性肺結節之間的細微差別,即使對于醫學專家來說,肺癌診斷也是一項艱巨的任務。此外,放射診斷的準確性也各不相同,在很大程度上取決于臨床醫生的主觀經驗。計算機輔助診斷(computer aided diagnosis,CAD)是指通過醫學圖像處理技術以及其他可能的生理、生化手段,結合計算機的分析計算,輔助發現病灶,可以有效降低誤診概率和提高診斷準確率。因此,為了降低醫生的誤診概率以及減少醫生的工作壓力,需要發展計算機輔助診斷系統,以幫助醫生對肺結節檢測作出正確診斷,進行針對性治療,提高治愈幾率具有重要意義。

近年來,深度學習在計算機視覺、自然語言處理、音頻識別等領域取得突破性進展。卷積神經網絡是一種深度的監督學習下的神經網絡,局部感知和共享權值的獨特結構使CNN在圖像識別和處理領域具有獨特的優勢。局部感知使圖像的局部空間像素聯系的更加緊密,共享權值則減少了網絡訓練參數的個數,降低了計算的復雜程度[3]。與舊的傳統框架相比,深度學習具有多種優勢。首先,深度學習可以直接從訓練數據中發現特征,特征提取過程大大簡化,相對簡單的端到端訓練過程,以及更容易對系統性能進行調整。Bengio[4]系統地介紹了深度學習所包含的網絡結構和學習方法。卷積神經網絡的局部連接、權值共享及池化操作等特性使之可以有效地降低網絡的復雜度,減少訓練參數的數量[5]。在圖像處理方面,Long等[6]構建端到端全卷積網絡,該網絡接收任意大小的輸入并通過有效的學習產生相應大小的輸出。且后續提出的深度卷積神經網絡(deep convolutional neural network,DCNN)在目前最大的圖像識別數據庫ImageNet上取得了超出之前最先進成果要好得多的成績[7]。2018年,Unar等[8]提出一種通過利用圖像的視覺和文本特征來檢索相似文本圖像的新方法。第一步提取視覺特征,然后在下一步中檢測和識別文本,基于內核的方法將視覺和文本信息融合。隨后,2019年,Unar等[9]提出結合視覺和文本特征來檢索分類相似的圖像的CBIR方法,支持三種檢索模式:圖像查詢、關鍵字以及二者的組合。在4個數據集上的實驗結果表明了所提出的視覺和文本圖像方法的效率和準確性。

當前針對肺結節的分類方法大致分為兩類。一是基于傳統的機器學習算法的肺結節分類,即通過人工提取特征,使用隨機森林、直方圖特征、支持向量機(support vector machine,SVM)等分類器完成分類。Messay T等[10]提出一種新的CAD系統用于肺結節檢測,通過放射科醫師對肺結節公開數據集(the lung image database consortium and image database resource initiative database,LIDC-IDRI)的84幅CT影像進行手動分割,使用LIDC-IDRI數據集進行7倍交叉驗證性能,分析顯示CAD靈敏度為82.66%。Jacobs C等[11]對所提出的CAD系統進行性能優化,由經驗豐富的放射科醫師對CAD系統的輸出進行回顧性分析,所提出的系統達到80%的靈敏度,表明CAD系統能夠找到篩選數據庫中未包含的亞實性結節。以上方法雖取得良好的實驗結果,但需要專業人員的專業知識,且提取特征所需的人力需求高,耗時費力,需要復雜的檢測過程。二是基于深度學習的肺結節分類,該方法由網絡模型自己學習特征。Shen等[12]提出一種新的卷積神經網絡MC-CNN模型對肺結節的惡性程度進行分類,所提出的方法不依賴于結節分割。Sun等[13]設計并實現了三種多通道提取ROI(region of interest, ROI)的深度結構化算法,性能顯著高于傳統計算機輔助診斷系統。Setio等[14]提出一種多視圖卷積神經網絡,在公開的LIDC-IDRI數據集的888次掃描中,該方法在每次掃描達到90.1%的高檢測靈敏度。Li等[15]提出一種卷積神經網絡(E-CNNs)集成框架,省去了分割過程,避免了傳統檢測方法中的肺結節丟失,并利用該框架顯著降低了假陽性。Zhou等[16]提出一種用于醫學圖像分割的網絡結構UNet++,將UNet++與多個醫學圖像分割結構進行了比較,取得更好的效果。劉露等[17]將深度置信網絡(deep belief network, DBN) 用于肺結節良惡性分類任務當中,將新提出的DBN模型與基于紋理特征和多分辨率直方圖特征的SVM模型進行對比,在不考慮醫學特征的情況下,DBN模型的識別準確率高達86%。Xie等[18]通過反向傳播神經網絡和AdaBoost構建集成分類器,融合3個整體分類器的決策,分別對3個特征進行訓練,在LIDC-IDRI數據集上性能優異。Gu等[19]提出了一種3D檢測深卷積神經網絡與多尺度預測策略相結合的方法,包括多尺度立方體預測和立方體聚類,以檢測肺結節。

以上關于肺結節的分類研究已經取得了較好的成果,然而,對于肺部結節中的微小結節仍然存在特征提取難,診斷難的問題,如毛玻璃結節,因此對于毛玻璃結節的分類非常重要。

針對以上問題,主要介紹3個貢獻來提高毛玻璃結節分類準確率的問題。首先,本文提出一種基于灰度增強、紋理和形狀濾波增強的三維深度卷積神經網絡,以經典的VGG16網絡結構為基礎,構建適用于毛玻璃結節分類的網絡結構,對LIDC-IDRI數據集進行預處理,對數據集進行分割得到肺實質圖像,將數據歸一化并對數據進行增強操作,完成特征提取;并引入一種從結節中提取任意數量視圖的方法,在目標域數據集訓練分類器,將特征提取的輸出作為分類器的輸入,對模型進行微調,通過無監督學習方法從數據集中學習特征。并在LIDC-IDRI數據集上進行訓練和測試,得到分類結果;此外,為了比較深度學習架構與經典分類器分類方法的性能,訓練了K最近鄰(k-nearest neighbor, KNN),隨機森林(random forest, RF)和支持向量機(SVM)分類器,與本文所提出的基于灰度增強、紋理和形狀濾波增強相結合的三維深度卷積神經網絡方法進行對比。實驗結果表明,所提方法針對毛玻璃結節具有最高的分類準確率,其他評價指標也有小幅度提高,具有最好的分類性能。

1 肺結節分類

1.1 實驗數據

實驗數據集為LIDC-IDRI,LIDC-IDRI為美國癌癥研究所公開數據集[20]。LIDC-IDRI數據集包含1018個研究實例,每個實例包含臨床肺部CT圖像和相關的XML文件,其中每個圖像包含一個或多個肺結節。對于每個實例中的圖像,都由4位經驗豐富的放射科醫師進行兩階段的診斷標注。

CT圖像的亮度值是Hu(Hounsfield unit單位),CT圖像的Hu值反映組織對X射線吸收值(衰減系數u),參考肺窗設定值,在0到255的范圍內執行數據之間的數據歸一化,使得肺結節在CT圖像上可見。

1.2 數據預處理

基于數據集提供的位置坐標,以二維的候選結節的像素中心為質心,提取固定尺寸的結節三維塊作為分類網絡訓練集數據。

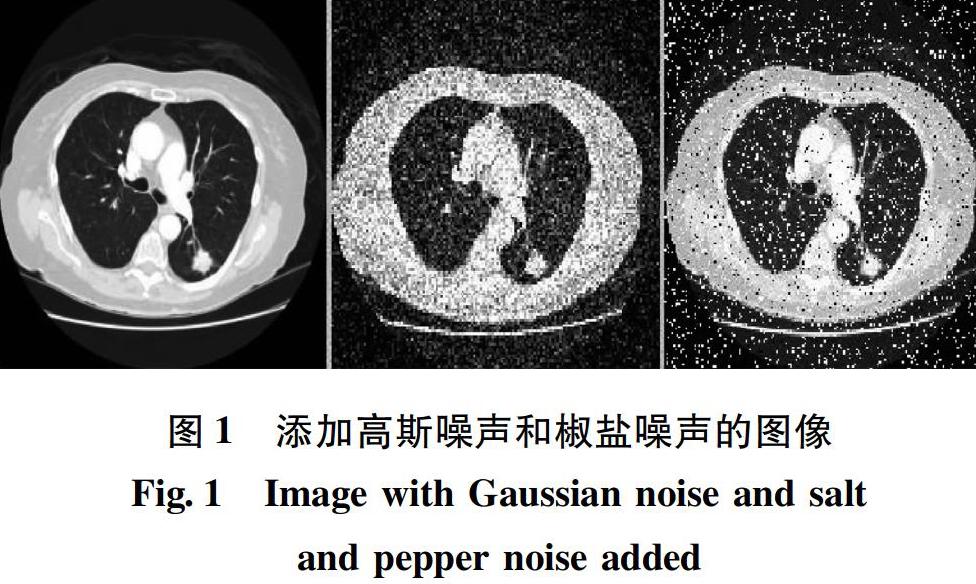

為了解決數據之間的不平衡和過擬合問題,執行數據增強操作,陽性樣本圍繞X、Y和Z軸為標準,隨機旋轉,增加數量,直到其為樣本數量的100倍,并且將陰性樣本也隨機旋轉為樣本數量的100倍,對其進行隨機采樣,以解決可能因數據不對稱導致的模型過擬合問題。向圖像中的RGB通道添加隨機擾動(噪聲)。常用的噪聲是高斯噪聲和椒鹽噪聲。添加噪聲的圖像如圖1所示。

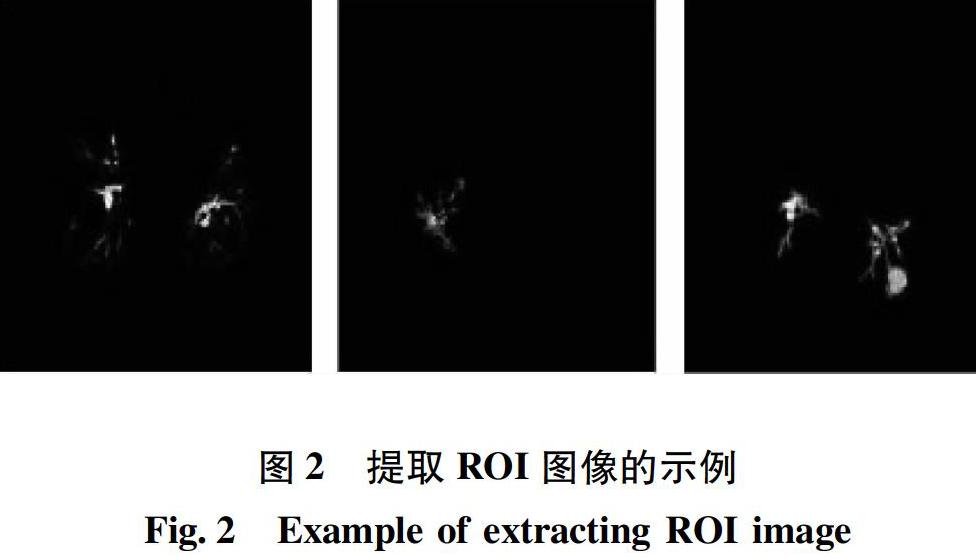

在該研究中,從CT圖像中手動提取感興趣區域(ROI),重新訓練CNN模型。從具有多個卷積層和池化層的深度卷積網絡中獲取固定大小的feature maps,使用可以反映毛玻璃結節特征的ROI作為輸入圖像。對于卷積神經網絡分類所需的圖像特征,使用全局圖像特征提取。例如清晰度、顏色直方圖和亮度直方圖。對于一般的圖像分類,可以通過分析圖像的二維信息獲取所需的特征。然而,在CT圖像中檢測病變部位,病變部位的形狀特征是多樣的,因此圖像的空間特征非常重要。本研究中,對于圖像中R、G和B 3個通道中的每個通道,通過將結節候選者的軸向、冠狀和矢狀圖像分配到紅色、綠色和藍色通道,生成偽彩色圖像。因為圖像數據含有空間的信息,所以通過DCNN以學習更多特征,減少假陽性的判斷。提取ROI圖像的示例如圖2所示。

初始分割采用的算法是Fast Marching,分割肺實質,對結節進行檢測,并對其分別進行灰度增強、紋理和形狀濾波增強,突出毛玻璃結節邊緣特征。

在圖像分割步驟之后,找到圖像中毛玻璃結節的坐標。使用OpenCv連通域處理函數connectedComponentsWithStats()。此函數返回連通域圖和相應連通域重心坐標。獲取假陽性結節,以提高分類準確率。

將分好的數據集進行預處理,采用python的pillow庫中crop操作,設定固定的裁剪區域將所有圖像的尺寸都裁剪為224×224。為了減少圖像的方向依賴性,通過對所有CT圖像使用線性插值法,使z軸方向上的間隔與x和y軸方向上的間隔一致。對數據進行預處理,將數據歸一化。數據歸一化采用組歸一化方式,對數據沿通道進行歸一化。按照每連續3張圖像來建立一個子文件夾,將連續的3張224×224圖像作為VGG網絡的輸入。將二維圖像依次疊加,轉換為224×224×3三維圖像。

1.3 模型設計

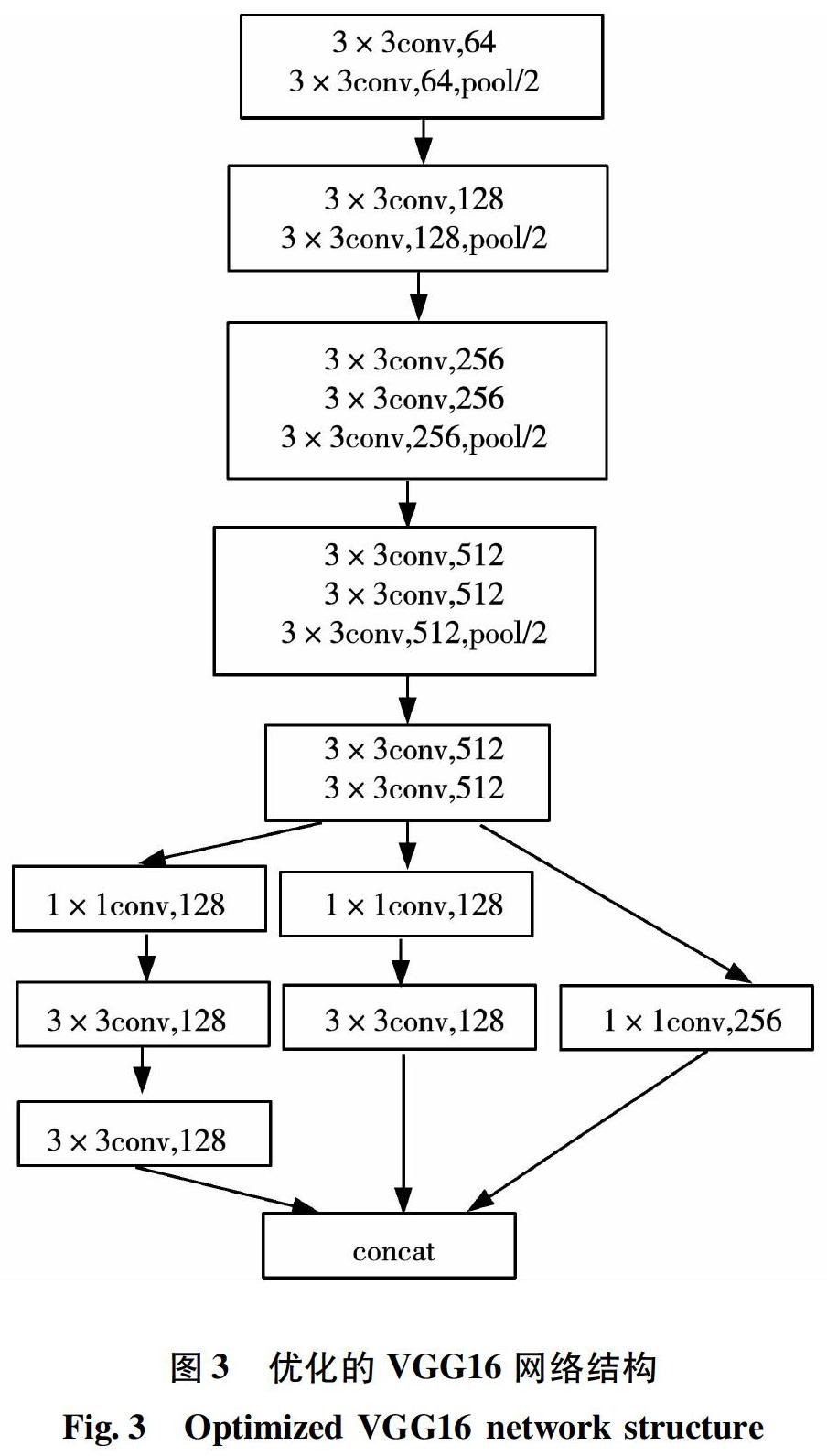

現有的肺結節分類方法,只利用一個網絡結構進行訓練,存在一定的局限性。且提取的毛玻璃結節邊緣的紋理特征對于區分惡性結節和良性結節及正確分類至關重要。為了提取毛玻璃結節的特征,需要將多分辨率影像作為信道信息使用,或將輸入影像的部分區域作為特征圖使用。因此提出一種基于灰度增強、紋理和形狀濾波增強的三維深度卷積神經網絡,將獲得的特征圖在內部網絡結構進行集成和訓練。本文以經典的VGG16網絡結構為基礎,設計適用于毛玻璃結節分類的模型。

VGG16探索了卷積神經網絡的深度與其性能之間的關系,通過反復堆疊3×3的小型卷積核和2×2的最大池化層,錯誤率大幅下降[21]。VGG16通過約100萬張自然圖像進行訓練學習,由13層卷積層和池化層組成的特征提取結構,從輸入圖像中提取4 096維的特征向量。

通過對灰度增強、紋理和形狀濾波增強的結節信息和去除血管和胸壁的信息相結合,作為所構建網絡結構的輸入圖像。輸入層用于數據輸入,所包含的神經元個數等于特征向量的維數。輸入層是數據進入卷積神經網絡的第一層,在該層進行數據的均值化、歸一化、降維和白化。將不同形式、不同規則的數據進行標準化,以便于準確抽取特征和構建評價。每個輸入圖像使用軸向、冠狀和矢狀平面來反應三維空間信息,以便最能反映毛玻璃結節的特征。

各輸入圖像通過13個卷積層(convolution layer)和3個全連接層(fully-connected layer)組成的整合模塊。卷積層執行卷積運算,并生成特征圖。優化的適用于肺結節分類的VGG16的網絡結構如圖3所示。池化層采用最大池化(max-pooling)操作,通過使用max-pooling可以提高計算效率,max-pooling通過選擇鄰域的最大值來總結輸出神經元[22]。輸出層對輸入圖像進行分類所采用的方法為Softmax回歸。在卷積層激活函數采用線性整流函數ReLU,加快網絡收斂速度,減少消耗的計算資源和訓練時間[23]。

對卷積層的前16層未做改動,將第17層卷積塊替換成3個分開的卷積塊,分開的卷積塊最后再結合,得到所需的特征圖。優化的網絡結構17層參數數量總數704 512,相較于原始的VGG16網絡結構第17層參數數量2 359 296明顯減少。且提出的優化網絡結構每個卷積塊之后都可以增加一個ReLU激活函數,可以學習到更多特征,魯棒性更強。

Keras和TensorFlow是深度學習的框架,允許使用圖形進行各種數值計算并且支持GPU運算。本研究基于Keras和TensorFlow完成實驗,Keras作為前端,TensorFlow作為后端。在這項工作中防止卷積神經網絡過擬合的方法是Dropout方法。Dropout在每次訓練的時候,通過在每個訓練中隨機省略一半特征檢測器[24]。這樣做是為了減少每次迭代中具有不同連接的網絡訓練節點之間的相互依賴性,防止過擬合。新的權重值可以通過反向傳播算法使用兩個概率和標注數據0或1來更新。當精度達到預定值或收斂條件時,終止訓練過程。然后,使用常規的反向傳播算法進行監督訓練,以對整個網絡進行微調。通過構建的VGG16的網絡體系結構和數據預處理,實現特征提取和選擇。最后,使用訓練模型對測試數據進行評估分析。

1.4 實驗與分析

評價標準采用肺結節分類方法常用的敏感性、特異性、準確性、受試者工作特征(receiver operating characteristic, ROC)曲線作為評價標準。為了評估毛玻璃結節的分類性能,分類準確性、敏感性和特異性方程由以下等式表示。

式中:TP為毛玻璃結節正確分類個數;TN為非毛玻璃結節正確分類的個數;FP為毛玻璃結節錯誤分類個數;FN為非毛玻璃結節錯誤分類的個數。

對于所提方法進行實驗,訓練數據集和測試數據集以4:1的比例隨機組成,圖像的尺寸裁剪為224×224,切片間隔為1 mm。定義的兩個數據集之間沒有患者或結節的任何重疊,并基于相同比例分布兩組中的結節類型。

使用隨機梯度下降法進行學習,最大限度地減少交叉熵的分類損失。學習率:0.001,批尺寸:20。使用加權交叉熵作為損失函數。LIDC-IDRI數據集使用5折交叉驗證進行評估,4個子集用于訓練/驗證,1個用于測試。提出的網絡結構使用Adadelta優化器進行訓練,在公開的LIDC-IDRI數據集上預訓練。從頭開始訓練最大迭代次數設置為150。

采用MATLAB 2016中的現成KNN和RF算法。當決策樹數目設置為100時,該算法取得了較好的效果。采用深度學習工具Matconvnet,該工具是由Vedaldi A等人為MATLAB設計的[25]。

為了比較輸入圖像對毛玻璃結節分類結果的影響,分別構建基于原始圖像作為輸入圖像的實驗方法、基于灰度增強作為輸入圖像的實驗方法、基于紋理和形狀濾波增強作為輸入圖像的方法,前三種方法采用單輸入圖像,另構建本文所提出的基于灰度增強、紋理和形狀濾波增強的多輸入圖像實驗方法。表1給出了采用不同實驗方法的肺結節分類的性能。

基于原始圖像作為輸入圖像的實驗方法和基于灰度增強作為輸入圖像的實驗方法的分類準確率分別為68.3%和74.3%。基于紋理和形狀濾波增強作為輸入圖像的方法的準確率為82.8%,在單輸入圖像中分類性能最好,但毛玻璃結節的分類準確率仍不高。本文所提出的基于灰度增強、紋理和形狀濾波增強的多輸入圖像實驗方法準確率為91.7%,敏感性為85.3%,特異性為88.5%。敏感性和特異性也均有提高,在所有方法中顯示出了最好的分類性能。

通過優化VGG16網絡結構,減少模型參數,加快網絡收斂速度,減少了模型的過擬合問題。同時,對于本文所提出的方法,研究比較了與三種傳統分類器的分類性能,包括K最近鄰(KNN),隨機森林(RF)和支持向量機(SVM),其中SVM具有最佳性能。表2給出了3種分類器對毛玻璃結節的分類性能。

由表2可知,SVM具有最好的分類性能,其準確率、敏感性、特異性分別為90.7%、83.3%、85.5%,在3種分類器中性能最佳,但3種評價指標均低于本文提出的方法。

此外,采用ROC曲線來檢驗分類性能,ROC曲線如圖4所示。ROC曲線圖是反映敏感性與特異性之間關系的曲線。曲線下部分的面積被稱為AUC(area under curve),用來表示預測準確性,AUC值越高,曲線下方面積越大,說明預測準確率越高。

由圖4可知,本文所提方法對毛玻璃結節分類效果良好,且相比于傳統分類器的分類性能更好。

最后,將本文所提方法與同使用LIDC-IDRI數據集的肺結節分類方法進行比較,驗證方法同使用5折交叉驗證,其準確率、敏感性和特異性對比如表3所示。

由表3可知,其他三種方法的準確率和敏感性皆低于本文提出的基于灰度增強、紋理和形狀濾波增強的三維深度卷積神經網絡用于肺結節(毛玻璃結節)分類方法。本文所提方法可有效提高毛玻璃結節分類性能。特異性高意味著誤診率低,本文所提方法在特異性上略低于文[12]和文[18],但相比于準確率和敏感性的提高是可以接受的。出現這種情況可能是因為數據分割及標注過程出現的誤差所致,說明本文方法倚賴于良好的結節分割,這也是后續研究需要重點克服的困難。

2 結 論

本文研究了基于三維卷積神經網絡的肺結節分類,創新的提出一種基于灰度增強、紋理和形狀濾波增強的方法,并對VGG16網絡模型進行優化。與原始圖像、僅使用灰度增強和使用紋理和形狀濾波增強的方法相比,結果表明所提出的基于灰度增強、紋理和形狀濾波增強的三維深度卷積神經網絡分類方法可以更好地從三維圖像中提取毛玻璃結節特征,并有效地將其特征用于識別分類結節,優于當前幾種傳統分類器算法。

本文的不足是該方法在很大程度上依賴于良好的結節分割。一旦對肺結節區域的描述不正確,該方法可能性能有所下降。論文對圖像ROI的提取采用的是基于人工的方法,部分實驗研究工作量較大。因此下一步是解決ROI的自動提取問題和對三維網絡結構進一步優化,加深網絡層,提取高維特征,提高分類性能。

早期的肺結節檢測對于發現肺部病變以提高患者治療幾率并增加生存率非常重要,因此肺結節檢測分類具有重要意義。此外,理論上本文提出的方法可以通過遷移學習,應用到其他醫學影像或者更多領域的數據集之中。

參 考 文 獻:

[1] BRAY F,FERLAY J, SOERJOMATARAM I, et al. Global Cancer Statistics 2018:GLOBOCAN Estimates of Incidence and Mortality Worldwide for 36 Cancers in 185 Countries[J].CA:a Cancer Journal for Clinicians,2018, 68(6):394.

[2] CHEN W, ZHENG R, BAADE P D, et al. Cancer Statistics in China, 2015[J].CA:a Cancer Journal for Clinicians,2016, 66(2):115.

[3] 李蘭英,孔銀,陳德運.一種新的卷積神經網絡的ECT圖像重建算法[J].哈爾濱理工大學學報,2017,22(4):28.

LI Lanying,KONG Yin,CHEN Deyun. A New ECT Image R Econstruction Algorithm Based on Convolutional Neural Network[J]. Journal Of Harbin University of Science and Technology,2017,22(4):28.

[4] BENGIO Y. Learning Deep Architectures for AI[J]. Foundations and Trends in Machine Learning,2009, 2(1):1.

[5] 周飛燕,金林鵬,董軍.卷積神經網絡研究綜述[J].計算機學報,2017,40(6):1229.

ZHOU F Y, JIN L P, DONG J. Review of convolutional neural network [J]. Chinese Journal of Computers. 2017, 40(6):1229.

[6] LONG J, SHELHAMER E, DARRELL T. Fully Convolutional Networks for Semantic Segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2015:3431.

[7] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet Classification with Deep Convolutional Neural Networks[C]//Advances in Neural Information Processing Systems,2012:1097.

[8] UNAR S, WANG X, ZHANG C. Visual and Textual Information Fusion Using Kernel Method for Content Based Image Retrieval[J]. Information Fusion,2018,44:176.

[9] UNAR S, WANG X, WANG C, et al. A Decisive Content Based Image Retrieval Approach for Feature Fusion in Visual and Textual Images[J]. Knowledge-Based Systems,2019,179:8.

[10] MESSAY T, HARDIE R C, ROGERS S K. A New Computationally Efficient CAD System for Pulmonary Nodule Detection in CT Imagery[J]. Medical image analysis,2010,14(3):390.

[11] JACOBS C, van RIKXOORT E M, TWELLMANN T,et al. Automatic Detection of Subsolid Pulmonary Nodules in Thoracic Computed Tomography Images[J]. Medical Image Analysis, 2014, 18(2):374.

[12] SHEN W, ZHOU M, YANG F, et al. Multi-crop Convolutional Neural Networks for Lung Nodule Malignancy Suspiciousness Classification[J].Pattern Recognition,2017,61:663.

[13] SUN W, ZHENG B, QIAN W. Automatic Feature Learning Using Multichannel ROI Based on Deep Structured Algorithms for Computerized Lung Cancer Diagnosis[J]. Computers in Biology and Medicine, 2017, 89:530.

[14] SETIO A A A, CIOMPI F, LITJENS G,et al. Pulmonary Nodule Detection in CT Images:False Positive Reduction Using Multi-view Convolutional Networks[J]. IEEE Transactions on Medical Imaging,2016, 35(5):1160.

[15] LI C, ZHU G, WU X, et al. False-positive Reduction on Lung Nodules Detection in Chest Radiographs by Ensemble of Convolutional Neural Networks[J]. IEEE Access, 2018, 6:16060.

[16] ZHOU Z, SIDDIQUEE M M R, TAJBAKHSH N, et al. Unet++:A Nested U-net Architecture for Medical Image Segmentation[M]//Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support. Springer, Cham, 2018:3.

[17] 劉露,楊培亮,孫巍巍,等.深度置信網絡對孤立性肺結節良惡性的分類[J].哈爾濱理工大學學報,2018,23(3):9.

LIU Lu,YANG PeiIiang,SUN Reiuwei,et al. DBN Classifier for Classification of Benign and Malignant Solitary Pulmonary Nodule[J]. Journal Of Harbin University of Science and Technology,2018,23(3):9.

[18] XIE Y, ZHANG J, XIA Y, et al. Fusing Texture, Shape and Deep Model-learned Information at Decision Level for Automated Classification of Lung Nodules on Chest CT[J]. Information Fusion, 2018,42:102.

[19] GU Y, LU X, YANG L, et al. Automatic Lung Nodule Detection Using a 3D Deep Convolutional Neural Network Combined with A Multi-scale Prediction Strategy in Chest CTs[J]. Computers in Biology and Medicine, 2018,103:220.

[20] JACOBS C, van RIKXOORT E M, MURPHY K, et al. Computer-aided Detection of Pulmonary Nodules:A Comparative Study Using the Public LIDC/IDRI Database[J]. European Radiology, 2016, 26(7):2139.

[21] SIMONYAN K, ZISSERMAN A. Very Deep Convolutional Networks for Large-scale Image Recognition[J]. arXiv Preprint arXiv:1409.1556, 2014.

[22] GONG Y, WANG L, GUO R, et al. Multi-scale Orderless Pooling of Deep Convolutional Activation Features[C]//European Conference on Computer Vision. Springer, Cham, 2014:392.

[23] XU B, WANG N, CHEN T, et al. Empirical Evaluation of Rectified Activations in Convolutional Network[J]. arXiv Preprint arXiv:1505.00853, 2015.

[24] HINTON G E, SRIVASTAVA N, KRIZHEVSKY A, et al. Improving Neural Networks by Preventing Co-adaptation of Feature Detectors[J]. arXiv Preprint arXiv:1207.0580, 2012.

[25] VEDALDI A, LENC K. Matconvnet:Convolutional Neural Networks for Matlab[C]//Proceedings of the 23rd ACM International Conference on Multimedia.ACM, 2015:689.

(編輯:溫澤宇)