基于深度學習的司機疲勞駕駛檢測方法研究

李小平,白 超

(蘭州交通大學 機電工程學院,甘肅 蘭州 730070)

隨著全世界鐵路運輸里程及汽車營運數量的快速增長,火車司機和汽車司機人數也快速增加,同時由于司機疲勞駕駛引起的交通事故也逐年增高,以美國為例,交通事故中有25%~35%與疲勞駕駛有關[1-2],每年大約有1 500多人喪生于疲勞駕駛引起的車禍[3]。因此對司機疲勞駕駛狀態進行檢測并做出相應的預警,對于保障交通運輸安全至關重要。

目前的疲勞駕駛檢測主要有基于司機的測量方法及基于車輛的測量方法,基于司機的測量方法又分為生理特征、視覺特征[4]和語音特征[5]等多種方法。基于車輛的檢測方法受路況及駕駛員技能的影響,準確性較差[6];基于生理特征的疲勞檢測由于使用了昂貴的傳感器,并且傳感器的侵入可能引起司機不適,不便于普及推廣[7-8];基于語音特征的疲勞檢測只適用于采用標準呼叫應答的駕駛場景且語音標記樣本數據較為稀缺;基于視覺特征的疲勞檢測具有非接觸性及可直接根據司機面部特征(如眼睛睜閉、打哈欠等)反應其疲勞狀態等優點,成為目前研究的主流方向[9]。傳統的基于機器視覺的司機疲勞檢測算法主要采用人工設計特征加分類器的方式,通過手動特征設計、制定檢測標準來進行疲勞判斷,檢測速度較慢、準確性較低[10];隨著以卷積神經網絡CNN為代表的深度學習模型在計算機視覺領域的成功應用,如面部器官檢測[11]、人體姿態估計[12]等,基于視覺特征深度學習的司機疲勞檢測成為該領域的研究熱點。

在基于視覺特征深度學習的疲勞駕駛檢測研究領域,文獻[13]提出了一種基于RNN的司機疲勞檢測技術;文獻[14]提出了一種類Haar特征和極限學習的疲勞檢測方法;文獻[15]基于嘴部特征疲勞檢測,應用了功能校準深度卷積模型RF-DCM,解決了說話和打哈欠的區分問題;文獻[16]提出了一種基于MSP模型的多任務分層CNN疲勞檢測系統,實現了面部檢測及眼睛和嘴巴狀態檢測;文獻[17]通過直方圖預訓練梯度模型HOG和支持向量機SVM提取眼睛、鼻子和嘴巴的位置并評估眼睛長寬比、張口比和鼻子長度比率進行疲勞檢測;文獻[18]提出了一個深層級聯LSTM的駕駛員疲勞檢測方法;文獻[19]提出了應用多面特征融合雙流卷積網絡的司機疲勞駕駛檢測模型,實現了動態圖像與靜態圖像的綜合檢測;文獻[20]提出了基于多形態紅外特征與深度學習的實時疲勞檢測方法,解決了夜間駕駛疲勞的檢測問題。

綜上所述,目前基于視覺特征深度學習的司機疲勞檢測算法主要有基于RNN的方法[13]、基于CNN的方法[14-17]以及RNN與CNN的融合方法[18-20],一般采用滑動窗口加分類器方式,由于輸入圖像較大而導致系統耗時多[21],檢測效率不高,而且當司機頭部姿態變化(如側臉、有遮擋等)時成像質量較差,準確率不高。針對上述問題,本文在前人研究的基礎上,提出一種基于MTCNN-PFLD-LSTM深度學習模型的司機疲勞檢測算法,首先采用多任務卷積神經網絡(Multi-task Cascaded Convolutional Networks,MTCNN)對視頻圖像幀的目標區域內人像進行由粗到細的定位[22],提高定位效率,降低后續輸入圖像的尺寸;然后對人臉圖像采用精度高、速度快的PFLD(Praclical Facial Landmark Detector)模型[23]進行68個關鍵點定位;最后根據P80原則計算出每幀圖像的眼部、嘴部、頭部3個疲勞參數,融合PFLD檢測出每幀圖像中人臉關鍵點的3個空間姿態角(偏航角,俯仰角,滾轉角)共6個參數,輸入長短期記憶網絡(Long Short-Term Memory,LSTM)進行疲勞檢測。該算法由于采用由粗到細的方法建模,加上PFLD模型結構小,并通過合理設計6個疲勞檢測參數及加權累積損失函數,使得司機疲勞檢測的準確率和效率得到了有效提升。

1 臉部疲勞狀態表征

1.1 臉部輪廓定位

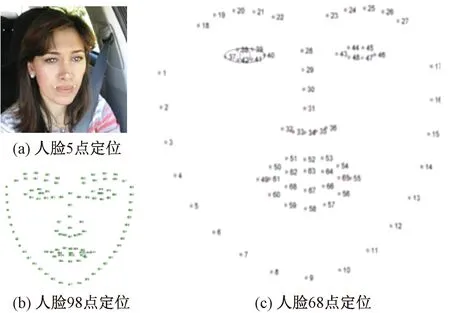

常見的人臉輪廓定位方法有5點、68點、98點定位,見圖1。圖1(a)中,5點定位僅包含左眼、右眼、鼻子、左嘴角、右嘴角5個位置,只能進行人臉輪廓定位,無法判斷是否處于疲勞狀態;圖1(b)中,98點定位包含的人臉信息過多,會導致系統運算量大、識別效率低、實時性較差;圖1(c)中,68點定位可以比較準確地描述人的臉部輪廓以及眼睛、嘴巴等局部特征,又減少了運算時間,提高了人臉識別的實時性[24]。在68點定位中,左眼有6個關鍵點(37~42),右眼有6個關鍵點(43~48),嘴巴有20個關鍵點(49~68),其余為臉部輪廓關鍵點。

圖1 人臉面部輪廓定位(圖中人像來源于YawDD數據集[25])

1.2 眼部疲勞狀態表征

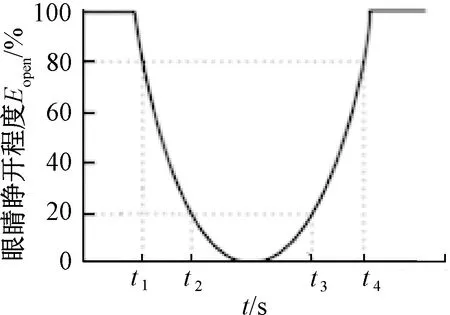

眼部特征是一個重要的疲勞表征參數,可以直觀反映司機是否處于疲勞狀態。本文采用PERCLOS原則[26]判斷眼部的睜閉狀態,當眼瞼遮住瞳孔的面積超過80%時就記為眼睛閉合。為基于PERCLOS原則的眼睛睜閉曲線見圖2。

圖2 基于PERCOLS原則的眼睛睜閉曲線

圖2中,縱軸為眼睛的睜開程度Eopen,橫軸為時間t,0~t1為眼睛從完全睜開到20%閉合所用的時間,t1~t2是眼睛從20%閉合到80%閉合所用的時間,t2~t3是眼睛完全閉合所用的時間,t3~t4是眼睛從20%睜開到80%睜開所用的時間。設這一時段內眼睛閉合時間所占的百分比為fp,則

(1)

眼睛可以看作是兩個嵌套的橢圓,見圖1(c)。假設眼睛睜開的寬度為w,上下眼瞼的垂直距離為h,則眼睛的面積近似為S=πwh。以左眼為例,根據眼部采集到的關鍵點,人眼部的w、h的計算式為

(2)

式中:x37、x40為人左眼兩端的關鍵點橫坐標;y41、y39為人左眼眼瞼上下右側的關鍵點縱坐標。右眼同理,則眼部睜開百分比計算為

(3)

式中:wmax、hmax分別為眼睛完全睜開時的寬度、高度。將計算得到的Eopen按照PERCOLS原理計算出t1、t2、t3、t4,代入式(1)即可計算出fp,fp輸入LSTM網絡進行訓練即可判斷司機是否處于疲勞狀態。

1.3 嘴部疲勞狀態表征

嘴部的狀態通常有3種:閉合、說話、打哈欠,人在疲勞時會較為頻繁地打哈欠,因此嘴部的特征也是疲勞判定的一個重要參數。

嘴部的寬度wmouth、高度hmouth計算式為

(4)

式中:x49、x55為嘴部左右的兩個關鍵點的橫坐標;y51、y53、y57、y59分別為嘴部上下的4個關鍵點的縱坐標,通過計算其坐標的平均值獲得嘴部高度。

司機在疲勞打哈欠時嘴巴的張開程度最大,嘴部會出現高度增加,寬度減少,為了衡量這兩種指標表征的疲勞狀態,引入嘴部縱橫比Kmouth,其計算式為

(5)

將Kmouth輸入LSTM網絡進行訓練即可判斷司機是否處于疲勞駕駛狀態。

1.4 頭部疲勞狀態表征

人在疲勞時頭部容易出現頻繁點頭或者長時間低頭的情況,因此可以將點頭(低頭)情況作為疲勞表征參數。人在低頭時,攝像頭拍攝的照片中兩眼中點到達嘴巴的距離會比抬頭時出現明顯的縮短,故采用該距離的變化作為點頭(低頭)姿態的變化。

在圖1(c)中,設

(6)

則兩眼的直線函數為

(7)

式中:xleft、xright、yleft、yright分別為人左右眼中點的橫縱坐標;x、y為兩眼的直線函數橫縱坐標。將式(7)化為標準型Ax+By+C=0時,可得到A,B,C的值為

(8)

再利用人臉兩眼中點52號點計算到該直線的距離,即

(9)

d為圖像上兩眼中點到達嘴巴的距離。再以視頻第一幀的pitch1計算俯仰角為0時的dmax,即

(10)

當d≤0.8dmax時可認定為司機處于低頭狀態。若低頭超過3 s則直接判定為處于疲勞狀態,若小于3 s則記入時間,計算頭部低頭時間所占時間的百分比,即

(11)

式中:tdown為低頭時間;t為總時間;hdown為低頭百分比,該數值越大則疲勞程度越深,hdown同樣可以作為LSTM的輸入進行疲勞狀態判斷。

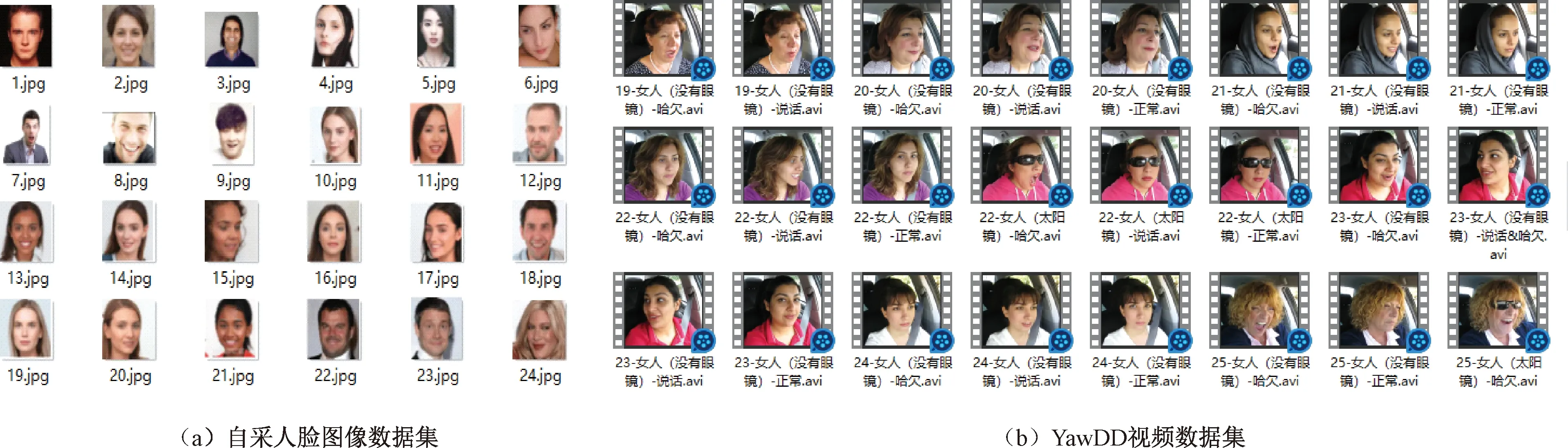

2 基于MTCNN-PFLD-LSTM的疲勞駕駛檢測模型

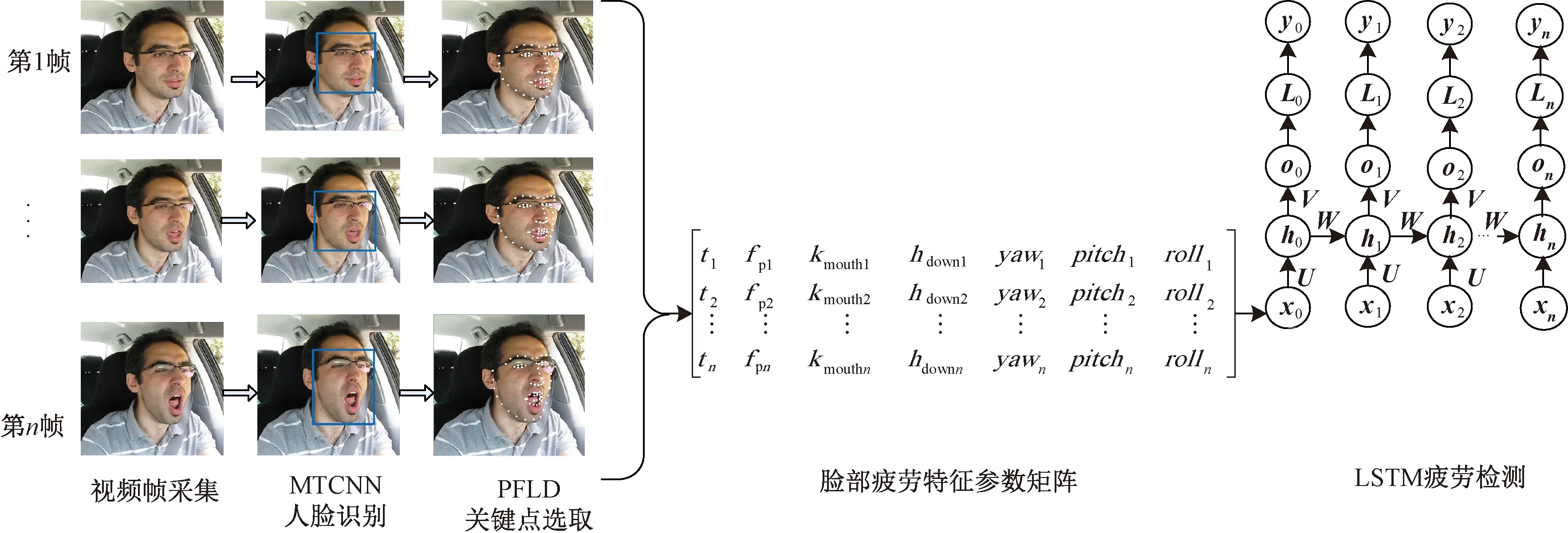

基于MTCNN-PFLD-LSTM的疲勞駕駛檢測模型見圖3。

圖3 基于MTCNN-PFLD-LSTM的疲勞駕駛檢測模型(圖中人像來源于YawDD數據集[25])

首先通過車載攝像設備實時獲取司機的視頻關鍵幀圖像,通過MTCNN確定司機人臉的區域,然后將檢測出的人臉區域采用PFLD模型進行人臉關鍵點檢測,最后計算生成臉部疲勞特征參數矩陣,并按照視頻時間序列將參數矩陣輸入LSTM模型進行疲勞檢測,通過softmax分類輸出疲勞與非疲勞狀態。

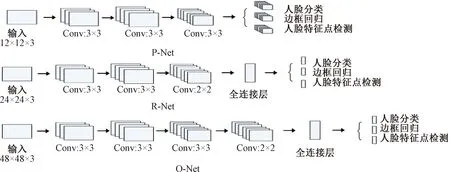

2.1 人臉區域檢測

MTCNN是基于級聯思想的深度學習模型,由P-Net(Proposal Network)、R-Net(Refine Network)、O-Net(Output Network)三層網絡構成,能兼顧性能和準確率,可實現由粗到細的人臉檢測。MTCNN的圖像金字塔可以進行初始圖像的尺度變換,P-Net模型用于生成大量的候選目標區域框,R-Net模型對目標區域框進行精選和邊框回歸,進而排除大部分的負例,O-Net網絡對剩余的目標區域框進行判別和區域邊框回歸,從而實現人臉區域的5關鍵點檢測定位,MTCNN模型結構見圖4。

圖4 MTCNN模型結構

(1)構建圖像金字塔

對圖片進行Resize操作,將原始圖像縮放成不同的尺度,生成圖像金字塔,便于實現多尺度人臉檢測。

(2)P-Net網絡

(12)

(3)R-Net網絡

(13)

(4)O-Net網絡

(14)

最終,MTCNN的損失函數L1為3個損失函數的加權累加,即

(15)

2.2PFLD人臉關鍵點檢測

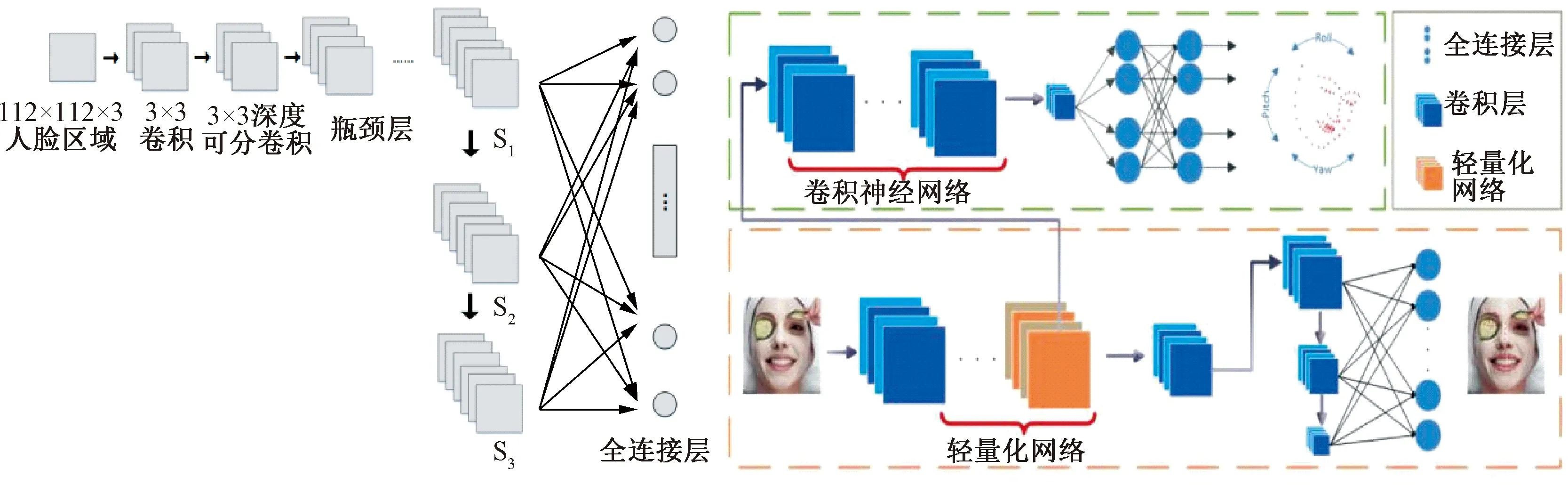

PFLD人臉關鍵點檢測模型具有精度高、速度快、模型小的特點,特別適合算力不強的嵌入式移動設備,見圖5。

圖5 PFLD模型

PFLD不僅可以通過主網絡輸出人臉的68個關鍵點,還可以通過輔助網絡輸出人臉的3個姿態角(偏航角yaw,俯仰角pitch,滾轉角roll)。通過68個關鍵點及姿態角,可以根據式(1)、式(5)、式(11)計算出疲勞參數fp,Kmouth及hdown。

PFLD損失函數L2表示為

(16)

2.3 臉部疲勞狀態參數矩陣

人的臉部疲勞狀態可以根據眼睛(睜、閉)、嘴巴(閉合、說話、打哈欠)及頭部偏航角yaw、俯仰角pitch、滾轉角roll來綜合表達。

在PFLD獲得人臉的68個關鍵點后,對于連續時間節點序列(t1,t2,…,tn)上采集的視頻圖像幀(第1幀,第2幀,…,第n幀),每一幀圖像可根據眼部、嘴部和頭部關鍵點及yaw、pitch、roll角度計算出狀態參數,生成臉部疲勞狀態參數矩陣Xt為

(17)

2.4 基于LSTM網絡的疲勞檢測

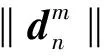

LSTM模型是一種時間遞歸神經網絡,旨在解決RNN的長期依賴與梯度消失問題,LSTM網絡能夠記住長期依賴關系,將前一時刻的網絡輸出選擇性地記憶下來,為后續的網絡學習提供豐富的事件關聯性。LSTM網絡見圖6。

圖6 LSTM網絡

LSTM在t時刻的表達形式如下:

輸入門為

it=σ(Wi×[ht-1,xt]+bi)

(18)

遺忘門為

ft=σ(Wf×[ht-1,xt]+bf])

(19)

記憶元胞單元為

(20)

(21)

輸出門為

ot=σ(Wo×[ht-1,xt]+bo)

(22)

ht=ottanh(Ct)

(23)

在司機疲勞檢測中,監控視頻可以按幀分解成圖片序列,按照時間順序將每一幀圖片的臉部疲勞狀態參數矩陣Xt輸入LSTM,即可實現運動狀態下的司機疲勞狀態判斷。

LSTM輸出為是否疲勞的分類狀態,故采用softmax損失函數,由于softmax損失函數在分類時主要將不同類之間的差異最大化,但對于同類之內的樣本差異不一定最小化,因此會使得模糊樣本的特征提取效果不佳,從而影響分類的準確率,為此,本文引入中心損失函數Lcenter為

(24)

式中:xi為第i個視頻疲勞特征矩陣;f(xi)為LSTM預測值;ci為該視頻樣本所屬聚類的中心,聚類中心在初始階段為隨機確定;m為處理批次的大小,本文選用m=128,在之后每批次中更新聚類中心。則

L3=Lsoftmax+λLcenter

(25)

式中:L3為LSTM損失函數;Lsoftmax為softmax 交叉熵損失函數;Lcenter為中心損失函數;λ為中心損失權重。

采用加權累積方法計算MTCNN-PFLD-LSTM模型的損失函數L,則有

(26)

式中:J為訓練樣本數;k∈{1,2,3};ωk為MTCNN、PFLD、LSTM 3個處理過程中的損失函數權重值。

3 試驗驗證

基于視覺特征的火車司機和汽車司機疲勞檢測需要在司機駕駛臺上方安裝視頻采集裝置,本文算法的原理相同,但由于采集裝置、采集環境以及所采數據集的不同,導致MTCNN-PFLD-LSTM深度學習模型的訓練參數會有所不同。由于篇幅限制,本文僅對汽車疲勞駕駛進行試驗,以對算法的有效性進行驗證。

3.1 試驗環境及實驗數據集

試驗平臺采用Intel(R)Core(TM)i5-4210,主頻1.70 GHz,8 GB內存,配置較低。在Windows10環境下使用Tensorflow深度學習框架,采用Adam優化器,未使用GPU加速。

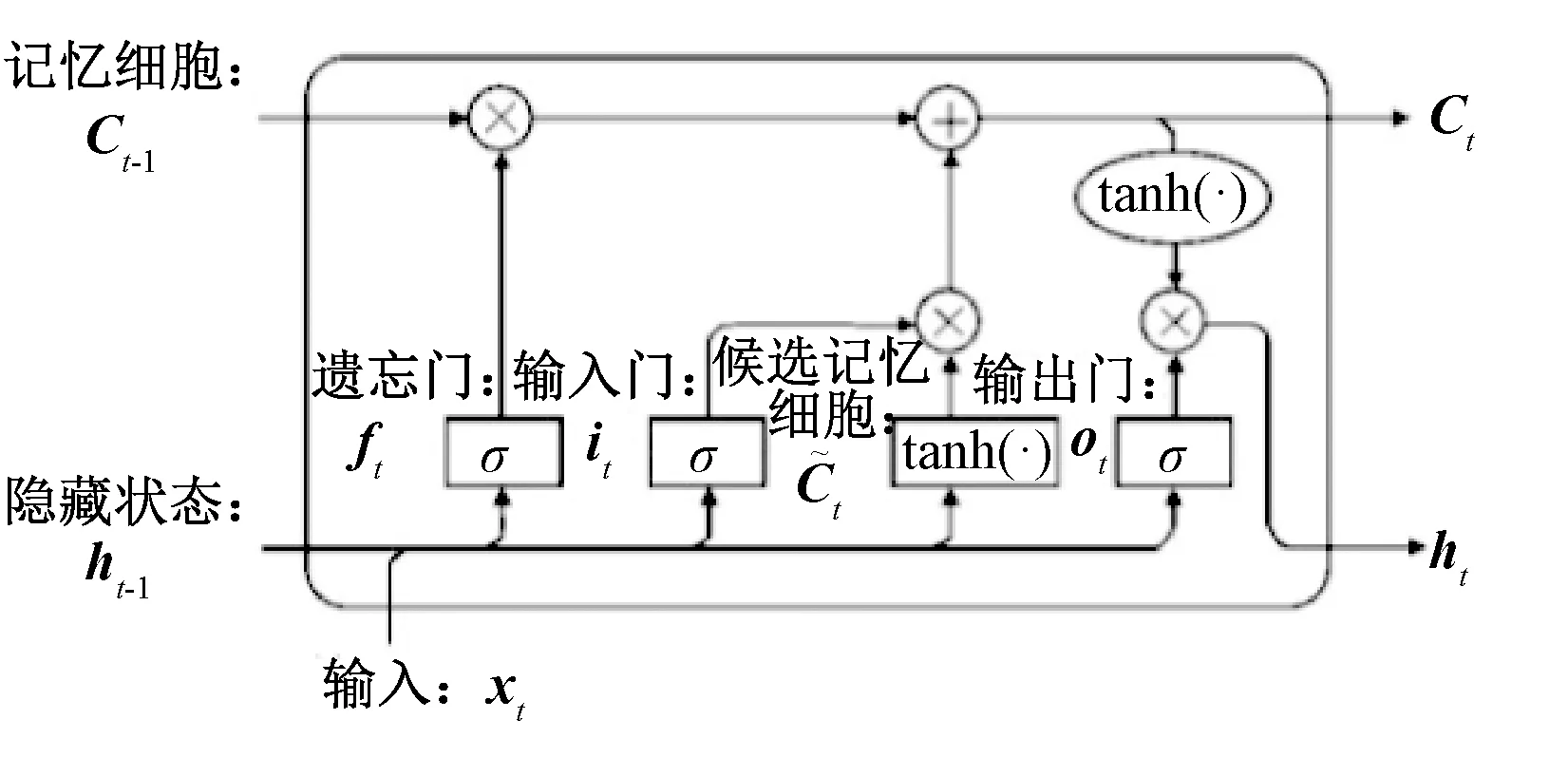

試驗數據集使用YawDD視頻數據集[25]和自采人臉圖像數據集。YawDD數據集是一個公開的視頻數據集,共有351個汽車司機駕駛視頻,每個視頻都標注了正常、說話、唱歌和疲勞打哈欠4種狀態,本文將正常、說話、唱歌的狀態標注為非疲勞狀態,將疲勞打哈欠標注為疲勞狀態[27]。人臉定位的精確度對于疲勞檢測的結果至關重要,由于YawDD數據集中司機人數相對較少,用這些視頻關鍵幀圖像訓練MTCNN模型時,樣本數量略顯不足,因此,本文從網絡上不同的人臉圖像數據集中采集了4 792張不同的人臉照片構成自采數據集,通過大量自采樣本數據提高MTCNN模型訓練質量,訓練好的MTCNN網絡模型直接用來對YawDD視頻數據集中的關鍵幀圖像進行人臉定位檢測,彌補YawDD數據集樣本較少的缺陷。圖7為自采人臉圖像數據集和YawDD數據集部分示例。

圖7 自采人臉圖像數據集和YawDD數據集(部分)

3.2 試驗過程

Step1自采數據集人臉區域及關鍵點標注

樣本標記的精確度對于深度學習的準確性至關重要,Labelimg是一個可視化的圖像標定工具,通過可視化操作可保證標注的準確性,因此本文選用Labelimg軟件為自采人臉數據集的4 792張照片添加人臉框以及關鍵點位置。自采集數據集中1419.jpg的Labelimg標注示例見圖8。

圖8 自采圖像1419.jpg人臉區域及68關鍵點標記Labelimg標記

Step2MTCNN模型訓練

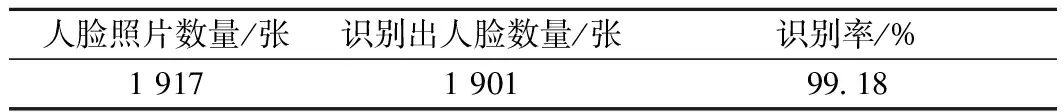

將Step1中標注好的自采數據集的50%作為訓練集,10%作為驗證集,40%作為測試集。將訓練集數據引入MTCNN進行訓練,訓練好的模型用驗證集數據進行模型過擬合驗證,然后用測試數據集進行測試,測試識別結果見表1。

表1 人臉區域識別結果

由表1可知,通過自采數據集對MTCNN模型進行訓練,人臉區域識別率達到99.18%,取得了較好的訓練效果。

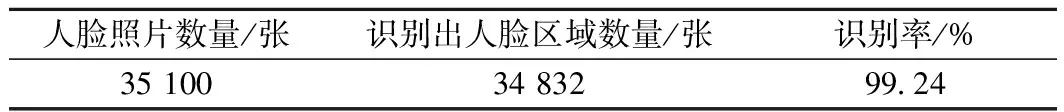

Step3YawDD數據集中人臉區域識別

將YawDD數據集的每個視頻文件按照關鍵幀分解出100張圖片,共35 100張照片,輸入訓練好的MTCNN模型進行人臉區域檢測,識別結果見表2。

表2 YawDD數據集中人臉區域識別結果

表2的識別率達到99.24%,比表1的識別率增加了0.06%,這也反映了雖然MTCNN模型參數不變,但數據集不同,網絡輸出結果會有一定程度的變化。

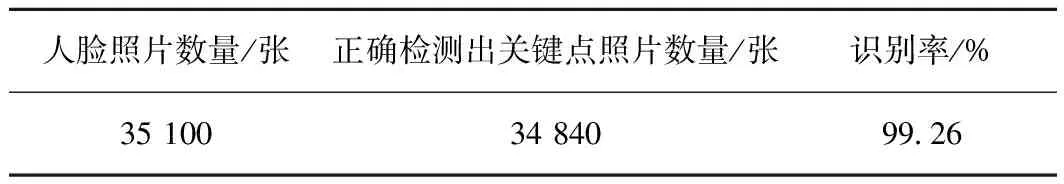

Step4YawDD數據集中人臉關鍵點檢測

將Step3中檢測出的人臉區域引入PFLD網絡檢測68個關鍵點,可得到所有關鍵幀照片的人臉關鍵點坐標,視頻24-FemaleNoGlasses-Normal.avi中第10幀圖像的人臉關鍵點坐標及姿態角見圖9。

圖9 24-FemaleNoGlasses-Normal第10幀圖像人臉關鍵點坐標及姿態角

圖9(a)為視頻24-FemaleNoGlasses-Normal.avi中第10幀圖像的人臉關鍵點及姿態角,藍色關鍵點為標記點,紅色關鍵點為檢測點。35 100張視頻幀照片的關鍵點檢測結果見表3。

表3 人臉關鍵點檢測結果

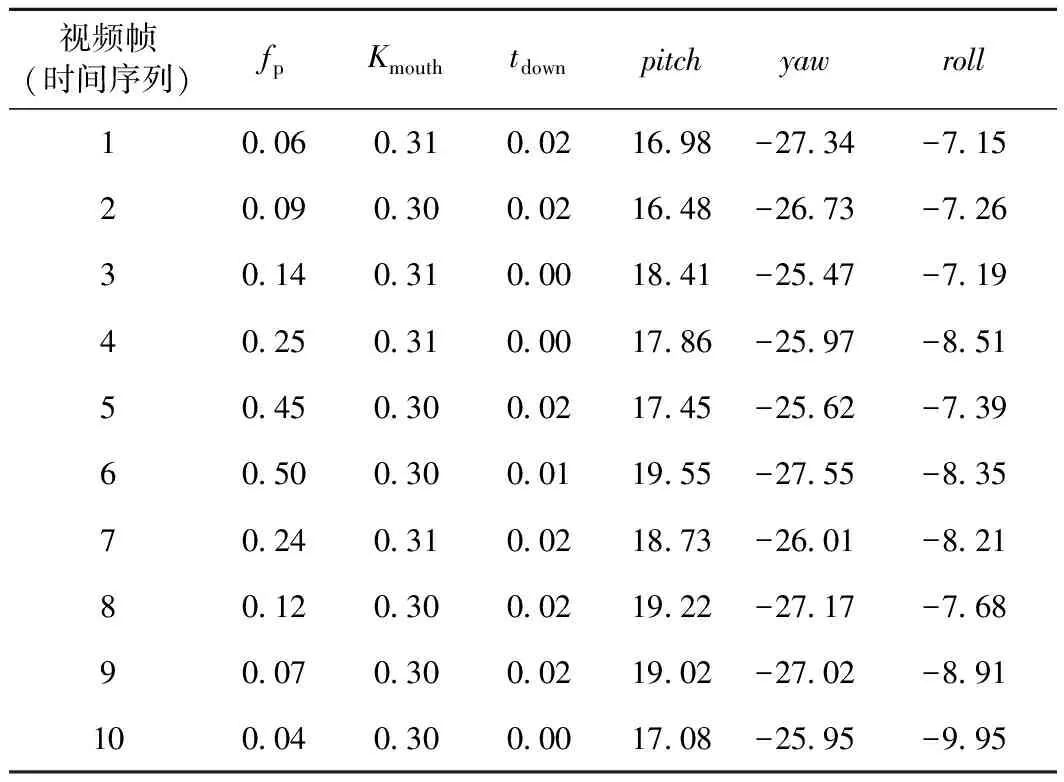

Step5計算疲勞參數矩陣

將Step4中檢測出的關鍵點坐標及姿態角按照式(1)、式(5)、式(11)可以計算出相應的疲勞特征參數。視頻24-FemaleNoGlasses-Normal.avi的疲勞參數計算結果見表4(前10幀)。

表4 視頻24-FemaleNoGlasses-Normal疲勞參數計算結果(前10幀)

Step6LSTM疲勞檢測

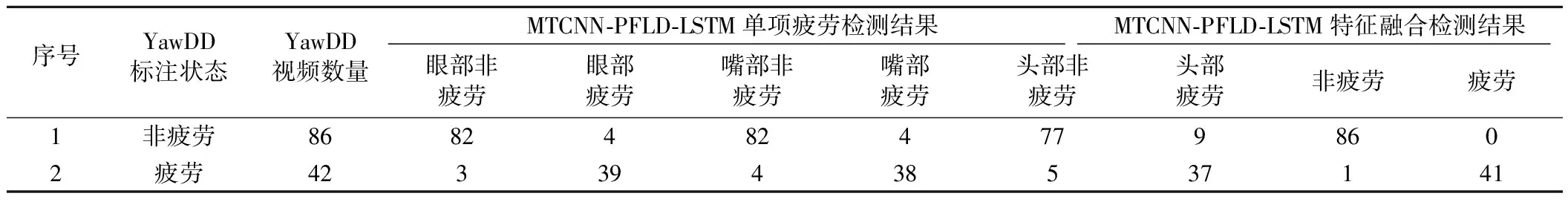

將Step5中計算出的疲勞參數輸入LSTM網絡,其中將223個視頻(63.5%)作為訓練集,128個視頻(36.5%)作為測試集,學習率為0.001,最后通過softmax得到疲勞檢測結果,見表5。

表5 疲勞檢測結果

3.3 試驗結果分析

司機疲勞狀態檢測屬于分類問題,可以采用準確率以及檢測幀率FPS來進行評估[28]。

根據表5可以計算出MTCNN-PFLD-LSTM疲勞檢測準確率,結果見表6。

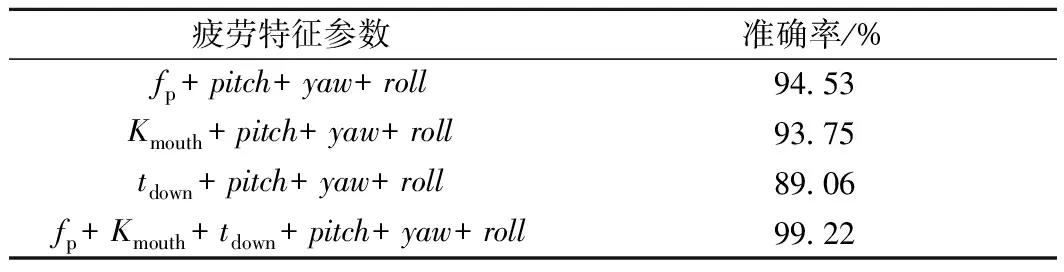

表6 MTCNN-PFLD-LSTM疲勞檢測準確率

從表6可以看出,分別使用fp、Kmouth、hdown與3個空間姿態角yaw、pitch、roll共4個參數訓練網絡時,檢測準確率分別為94.53%、93.75%、89.06%,而將fp、Kmouth、hdown與yaw、pitch、roll角度共6個參數輸入網絡訓練時,檢測準確率達到99.22%。

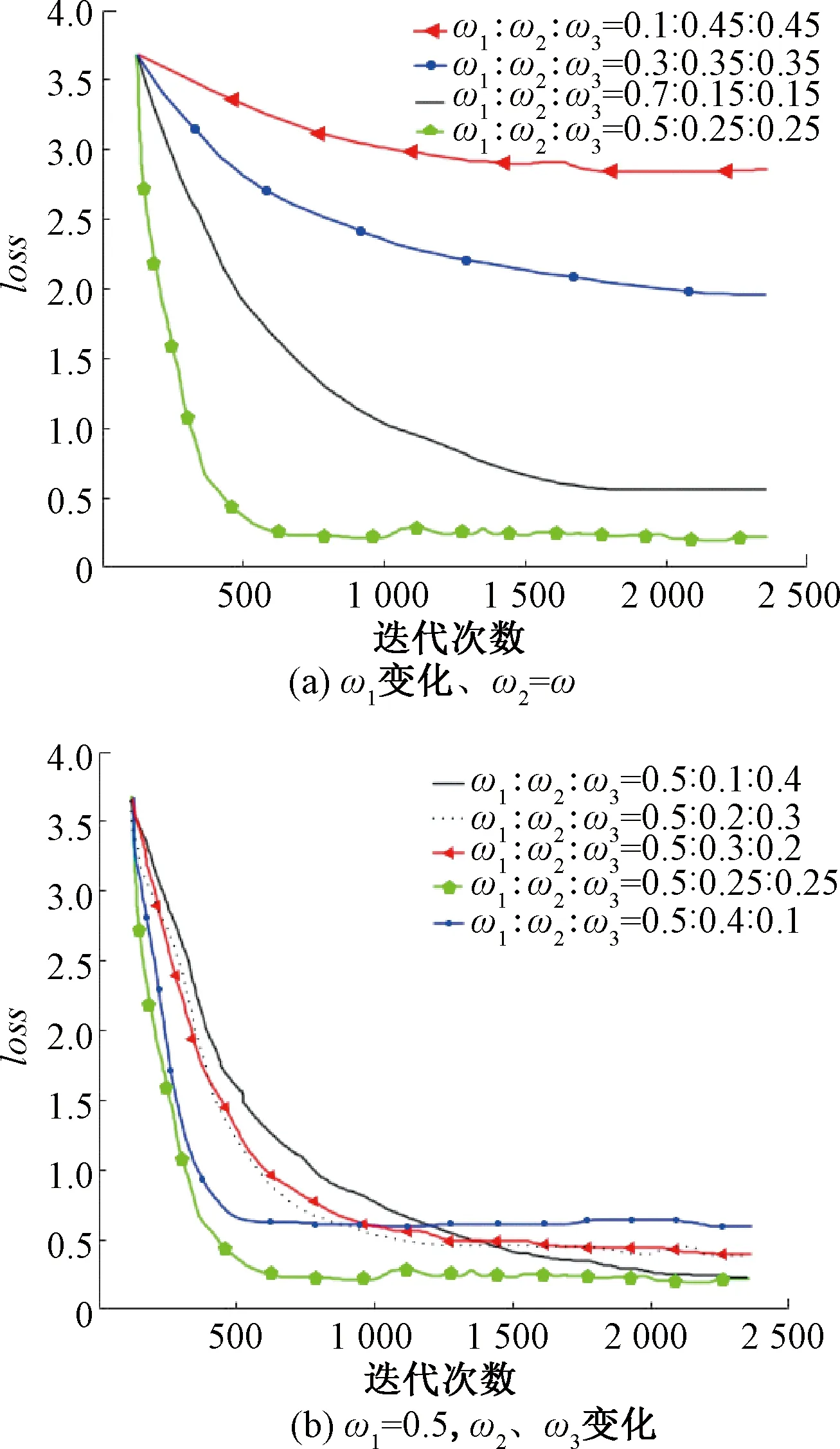

3.4 損失函數loss

損失函數loss用來表現預測值和實際值之間的差異程度,權重ωk的不同取值對于實驗結果影響較大。假定ω1變化、ω2=ω3,分析ω1的變化對loss的影響,選取ω1∶ω2∶ω3=0.1∶0.45∶0.45、ω1∶ω2∶ω3=0.3∶0.35∶0.35、ω1∶ω2∶ω3=0.5∶0.25∶0.25、ω1∶ω2∶ω3=0.7∶0.15∶0.15,損失函數圖像見圖10(a),可以看出,當ω1權重較低時模型收斂速度較慢,損失函數loss增大、準確率降低,故應增大ω1的權重,充分驗證了人臉圖像分割精度對于疲勞檢測的重要性,但當ω1取值過高時(如ω1=0.7),模型收斂速度反而又會降低,經過反復試驗,當ω1=0.5時模型收斂速度快、準確率高。當ω1=0.5時,分析ω2、ω3變化對loss函數的影響,分別取ω2=0.1、ω3=0.4,ω2=0.2、ω3=0.3,ω2=0.25、ω3=0.25,ω2=0.3、ω3=0.2,ω2=0.4、ω3=0.1,loss曲線見圖10(b),可以看出,當ω2=ω3=0.25時模型收斂速度快、準確率高。經過反復試驗,最終確定權重ωk的取值為ω1∶ω2∶ω3=0.5∶0.25∶0.25。

圖10 權值ωk取不同值時的loss曲線

當ω1∶ω2∶ω3=0.5∶0.25∶0.25時,通過損失函數曲線可以看出該模型收斂速度較快,在訓練了500張圖像時的損失值和訓練2 500張圖像時的損失值相差不大,在訓練到2 500張圖像時損失函數波動很小,顯示出模型具有較好的魯棒性。

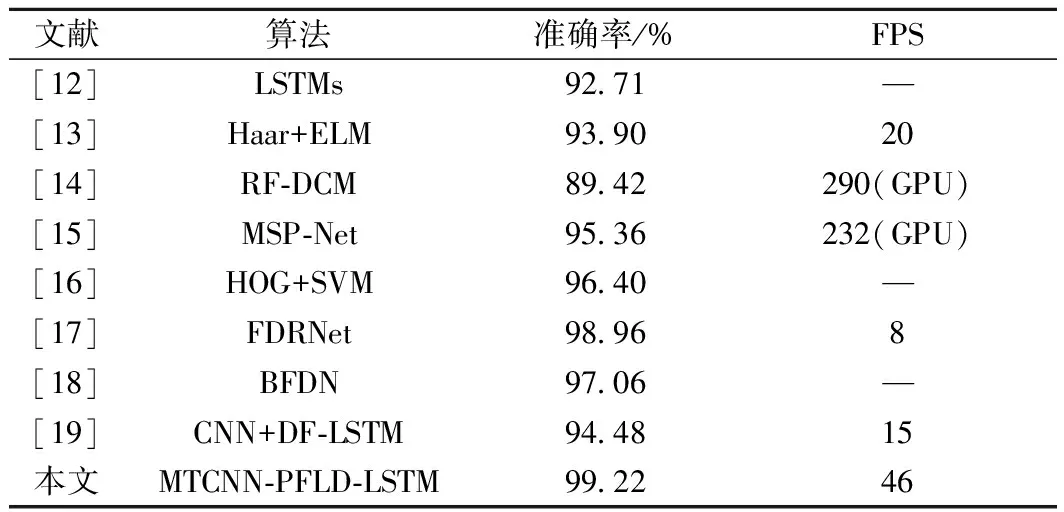

為驗證本文算法的優越性,和其他最新的疲勞檢測算法進行對比,結果見表7。

表7 對比實驗結果

由表7可以看出,本文在低算力設備及無GPU加速情況下,采用MTCNN-PFLD-LSTM算法,準確率達到99.22%,檢測幀率達到46;本文檢測準確率比第2的模型(文獻[17])增加了0.26%,檢測幀率FPS比性能第2的模型(文獻[13])增加了1.3倍。文獻[14]和文獻[15]由于采用了GPU加速,所以FPS較高,但是硬件配置要求較高;文獻[17]的檢測準確率較高,但是檢測幀率為8,運算效率較低。對比試驗結果表明,本文提出的算法在低算力設備上應用時耗時較少,檢測準確率較高,綜合檢測效果較好。

4 結論

本文采用MTCNN-PFLD-LSTM模型進行司機疲勞駕駛檢測,無須GPU加速,便于在移動設備等低算力設備上應用。通過優化MTCNN-PFLD-LSTM模型在不同階段任務的損失函數權重,在YawDD數據集中的檢測準確率達到99.22%,檢測幀率達到46,檢測的效率與準確性較好,能夠滿足基于視覺特征的司機疲勞駕駛檢測要求。