基于視覺顯著性和卷積神經網絡的機場目標快速檢測

張一民 韓現偉 張世超 高偉

基于視覺顯著性和卷積神經網絡的機場目標快速檢測

張一民 韓現偉*張世超 高偉

(河南大學物理與電子學院,開封 475000)

針對現有的機場目標檢測算法用于大幅面遙感圖像時檢測速度慢、準確率低的問題,文章提出了一種基于視覺顯著性和卷積神經網絡相結合的高效、精確的機場目標檢測方法。首先,根據機場形狀特征,采用基于直線分布特征的視覺顯著性檢測方法提取候選區域,對機場的可能位置進行粗定位;然后,設計了一種改進的卷積神經網絡分類模型判斷候選區域是否為機場;最后,使用非極大值抑制的方法去除冗余的預測框,獲得最終的檢測結果。利用從谷歌地球收集的圖像數據集對該神經網絡模型進行訓練和測試,結果表明其在精準率和召回率上均具有較大優勢。此外,文章所提算法在來自不同衛星平臺的大量大幅面遙感圖像上進行了機場目標檢測,結果顯示其適應性強且檢測效率有大幅度提升。

遙感圖像 機場目標 視覺顯著性 卷積神經網絡 遷移學習 遙感應用

0 引言

近年來,機場目標檢測作為遙感應用的一個重要分支,在軍事偵察和民用導航領域均體現出較大的應用價值。隨著科學技術的不斷發展,衛星遙感圖像地面分辨率越來越高[1],圖像尺寸越來越大,靠人眼分析和解譯的難度也越來越高,另外對地觀測的遙感信息又有著較高的識別難度和時效性,所以借助于高性能計算機實現對遙感圖像快速準確的識別成為了關鍵。目前,國內外學者在機場目標檢測領域已經開展了大量的研究工作,得到多種有效的算法。這些算法大致可分為三類:一類是基于傳統特征匹配算法技術[2],另一類則是基于深度學習的卷積神經網絡特征識別提取,第三類是利用傳統方法進行特征提取并利用卷積神經網絡進行目標識別[3-7]。基于特征匹配的傳統目標識別技術存在很多弊端,受不同天氣、地域等環境因素的影響,待識別目標常常與目標模板圖像存在較大差異;利用傳統圖像匹配、定位的方法很難確保匹配的精度和識別的正確性。卷積神經網絡的發展起源于人工神經網絡,是處理圖像信息的一種多層感知器。近年來,基于卷積神經網絡的目標檢測算法如RCNN[8]、Fast RCNN[9]在高分辨率圖像中的大目標檢測領域取得了突破性的提升,該方法會對每個候選區域使用卷積神經網絡提取特征,尤其對復雜圖像特征的提取。基于深度學習的卷積神經網絡特征識別提取算法通過低層的濾波器來獲取圖像的局部特征,利用高層的濾波器將這些局部特征組合成全局特征,整個過程都是通過網絡訓練來獲得,不需要人工提取、設計目標特征。第三類算法利用傳統方法對候選區域進行特征篩選和提取,減少預測網絡的輸入數量,再利用卷積神經網絡對提取的候選區域進行識別、分類,使檢測速度得到進一步加快。如文獻[10]、[11]對候選區域提取流程進行了改進,利用機場的線性特征進行了篩選,然后利用卷積神經網絡進行目標識別、提取;文獻[12]采用AdaBoost分類器代替RCNN,選擇性搜索目標框來獲取候選區域;文獻[10]、[11]與文獻[12]都是通過減少候選框的輸入數量來加快卷積神經網絡的檢測速度,以提高對應的算法性能,但上述方法依然存在機場分類檢測準確率低、耗時長等問題。

針對大幅面遙感圖像機場檢測準確率低、耗時長的問題,本文提出了一種基于視覺顯著性[13-14]和卷積神經網絡的機場檢測算法。利用機場的直線顯著性特征替代Fast RCNN中選擇性搜索(Selective Search)候選區域生成方法,從而大大降低候選區域數量。采用VGG-16[15]作為主干特征提取網絡,并改進全連接層以更好的檢測機場目標。相比其他同類機場檢測算法,本文算法在準確性和效率方面有了大幅度提升。

1 機場目標檢測算法

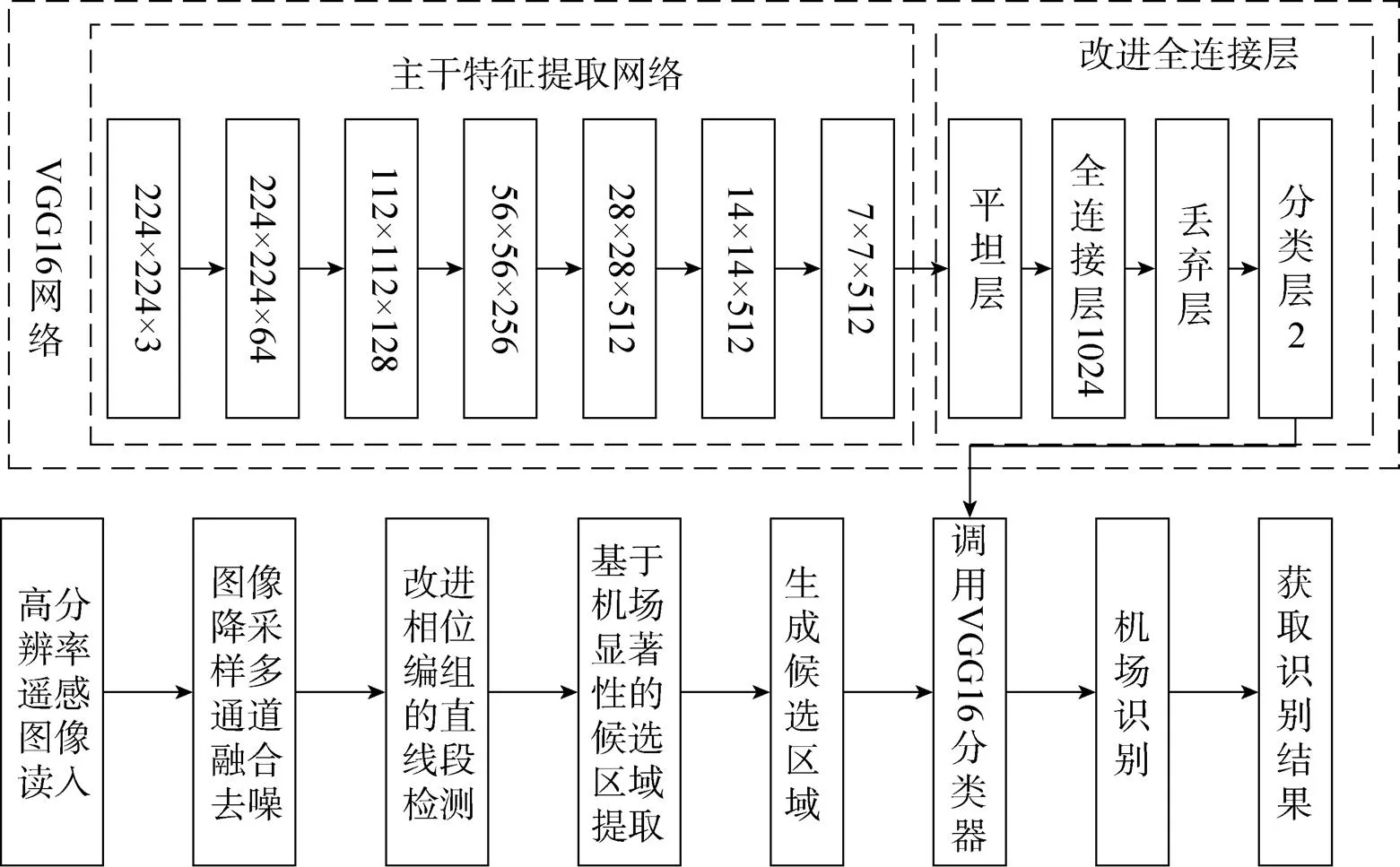

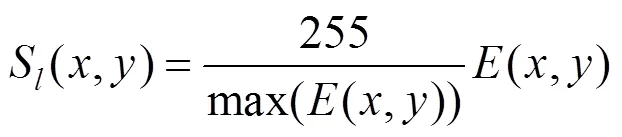

本文的機場目標檢測算法以Fast RCNN為基本模型框架,以基于機場直線顯著性特征的候選框提取算法取代Fast RCNN中選擇性搜索候選區域生成方法對大幅面遙感圖像進行候選區域提取;以改進的VGG-16模型作為分類模型,實現機場目標的分類;最后,將機場目標在原遙感圖像中進行映射定位。本文算法主要由2部分組成:首先,利用基于直線段加權長度密度分布的視覺顯著性[14]進行機場可能區域的粗提取,得到大大減少的候選區域。然后,以VGG-16卷積神經網絡[16]為基礎,保持模型主干特征提取網絡的結構不變,分別對全連接層的層數、神經元個數、分類數進行調整;利用遷移學習[17]思想,保持主干特征網絡參數不變,對改進的全連接層進行參數訓練。算法整體流程如圖1所示,下文將分別論述基于視覺顯著性的候選區域定位和改進的VGG-16卷積神經網絡。

圖1 本文算法流程

1.1 基于視覺顯著性的機場區域定位

高分辨遙感圖像由于數據量大、背景復雜,且待識別的目標通常只占很少比例。采用選擇性搜索方法在每幅圖像上提取約2000個目標候選區域[18],這些區域中只有非常少的一部分包含目標,并且大部分候選區域與目標差異較大,利用簡單的目標特征就能排除。RCNN、Fast RCNN等模型針對大幅面遙感圖像機場檢測時存在耗時長、計算量大、效率低等問題。針對機場所具有的直線特征,本文采用以直線加權長度密度分布為基礎的視覺顯著性模型來檢測圖像中的顯著性區域,以減少目標候選框,提高目標識別效率。

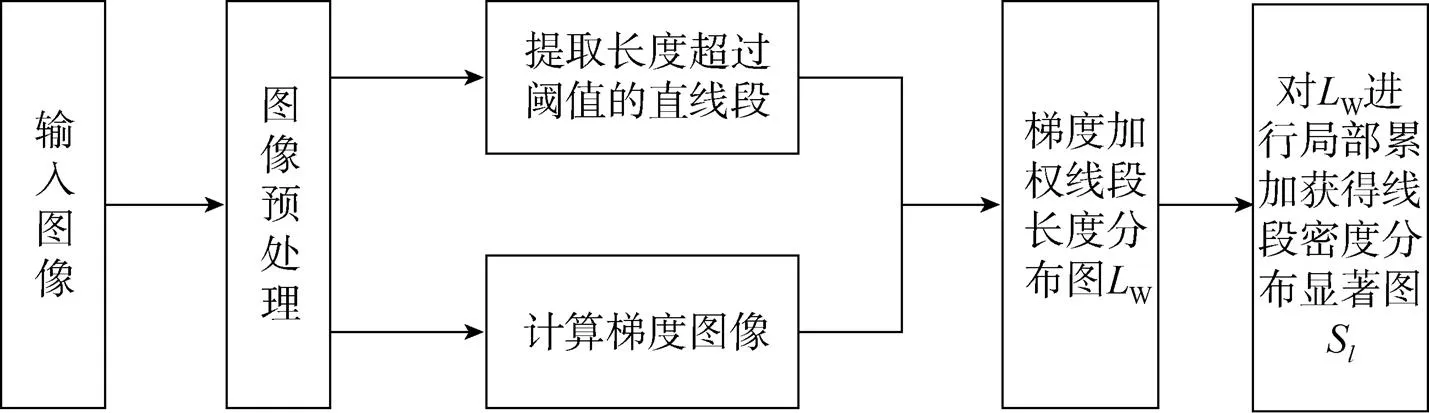

遙感圖像的空間分辨率對不同類型目標檢測的準確性有著很大的影響[19-21]。對于機場目標而言,當分辨率較高時,很多小地物目標的直線特征會突顯,從而增加候選區域的數量,增大后期目標判別的計算量,降低算法效率。因此,本文首先對輸入的高分辨率遙感圖像根據圖像進行降采樣,使圖像的空間分辨率達到10m左右,這樣既可以有效檢測機場目標,又能夠提高算法效率。將降采樣后的圖像進行預處理,采用多通道融合算法[22]進行去噪、灰度化,根據機場跑道灰度值較高的特征,選擇伽馬變換對圖像進行增強,以強化圖像高灰度部分的邊緣信息。對預處理后的圖像進行直線段提取,然后再利用直線段加權長度分布密度顯著性進行機場可能區域提取。具體步驟如圖2所示。

圖2 基于直線段分布密度的顯著圖提取流程

1.1.1 基于直線特征的顯著性檢測

(1)直線段檢測與連接

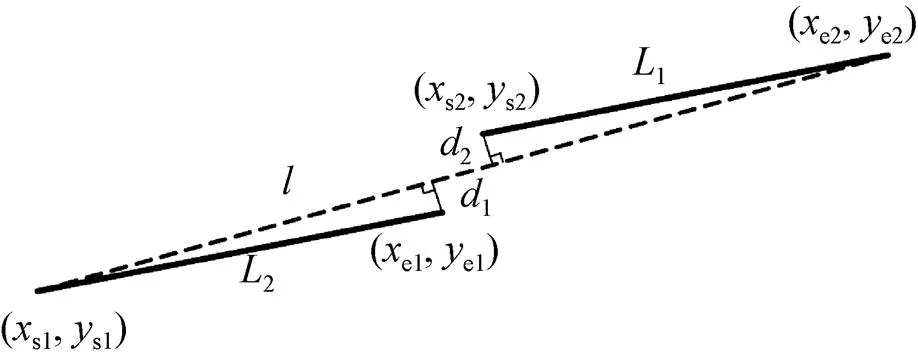

2)共線性。當兩條直線段的傾斜角度1、2差值Δ小于某一閾值2時,認為它們可能共線。

圖3 直線擬合誤差定義

當上述三個條件同時滿足時,可認為直線段1、2屬于同一條直線段,將它們連接起來形成一條新的直線段。

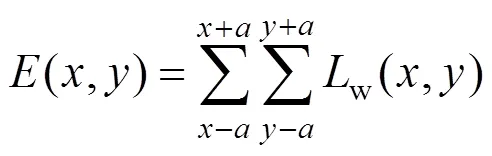

(2)顯著圖計算

直線段檢測、連接完成之后,利用式(1)構造加權線段長度分布圖w

式中map(,)為圖像各像素點的梯度值;map(,)為圖像中大于設定閾值長度的直線段構造出的直線段檢測圖;L為各線段長度數組。

式中為鄰域半徑;(,)為線段w上任意一點。

計算直線w上所有像素點的能量值,并對能量值進行歸一化,即用各點能量值除以能量值的最大值。為了以灰度圖像(一般灰度圖像最大灰度值為255)來顯示該歸一化結果,將歸一化的值再乘以255,得到最終的直線段長度密度分布顯著圖S(,),即

1.1.2 候選區域生成

得到顯著圖之后,機場目標候選區域按照如下步驟獲得:1)將顯著圖S進行閾值分割,得到二值圖像mark;2)對二值圖像mark進行連通區域標記(以白色為目標區域),去除面積較小的目標區域,得到顯著二值圖像ROI;3)根據直線段連接的結果,查看顯著二值圖像ROI中每個目標區域的外接矩形Rect中所包含的直線段端點,找出這些端點所對應的所有直線段,將這些直線段和Rect外接矩形作為一個候選區域。

1.2 基于改進VGG-16的機場識別

VGG-16是由牛津大學的K.Simonyan和A.Zisserman提出的卷積神經網絡模型,該模型詮釋了隱藏層增多對預測精度的提高有幫助,在ImageNet數據集中達到了92.7%的測試精度。ImageNet數據集的圖像超過1 400萬幅,共1 000個類別。VGG-16是一個包含多個隱藏層的深度卷積神經網絡,其所有卷積層有相同的配置,即卷積核大小為3×3,步長為1,共有5個最大池化層,大小都為2×2,步長為2;共有三個全連接層,前兩層都有4 096個神經元,第三層共1 000個神經元代表1 000個標簽類別。

獲得候選區域之后,本文采用VGG-16網絡作為Fast RCNN的分類網絡進行區域特征提取并分類識別。保持VGG-16卷積層和池化層網絡模型參數不變,對全連接層網絡模型進行參數調整。本文將VGG-16網絡第一層全連接層神經元個數由4 096改為1 024,添加dropout層,防止過擬合,并去掉第二層全連接層,最后的預測層神經元個數為2,只對機場進行單一目標識別和判斷。

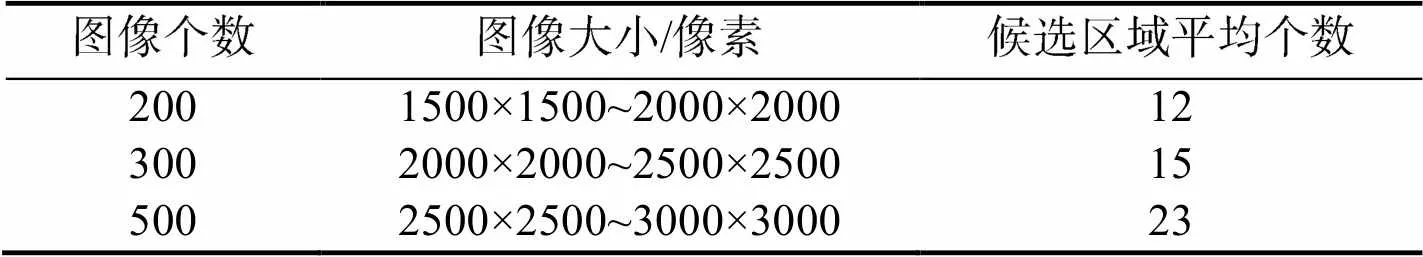

全連接層模型是通過有標簽樣本學習來確定自定義全連接層層數、神經元個數。在監督式學習中,機器學習算法通過學習多個樣本,并不斷嘗試找出可以最大限度減少損失的模型,這一過程稱之為經驗風險最小化。保持VGG-16的卷積層和池化層模型結構、參數不變,利用遷移學習方法對全連接層進行參數訓練。通過自定義訓練過程可視化函數,獲取訓練過程的可視化準確率,以該數據判斷網絡是否存在過擬合等情況,對網絡模型進行改進調整以確定最終的全連接層。當前自定義模型改進調整方式主要采用增加全連接層層數和增加全連接層的神經元個數兩種方式。模型訓練具體流程如圖4所示。當其損失值和準確率達到預期要求,并且隨著全連接層和神經元個數變化,損失值和準確率沒有明顯改善時,即可將模型應用于實際目標分類。

圖4 模型訓練過程

2 試驗結果與分析

本文選用大幅面高分辨率遙感衛星圖像來評估提出方法的性能。試驗數據源包括Google Earth、WorldView-3衛星和“高景一號”衛星,其中從Google Earth上收集1000張遙感衛星圖像,用于卷 積神經網絡的訓練、驗證和測試;收集來自Google Earth、WorldView-3衛星和“高景一號”衛星的100張包含機場的全色圖像,用于評估本文算法對不同衛星平臺、不同位深度和不同分辨率圖像的適用性。

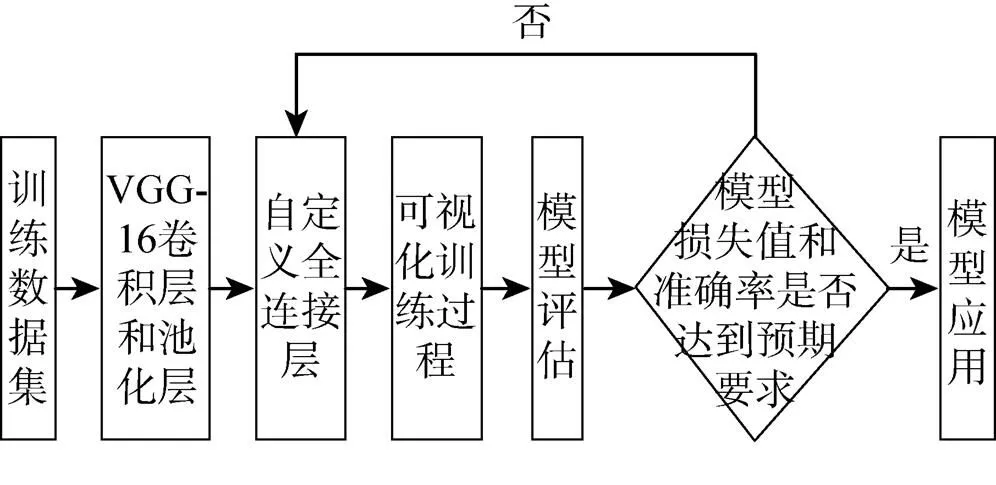

2.1 顯著性區域提取實驗

將Google Earth上收集的1000張分辨率為10m、圖像大小在1500×1500像素到3000×3000像素之間的包含機場的遙感衛星圖像,進行基于視覺顯著性算法候選區域的提取。其中直線段連接采用的規則為:1)鄰近性,兩條直線段4個端點之間的最短距離st1<15像素;2)共線性,兩條直線段的傾斜角度1、2差值Δ<0.4;3)擬合誤差,st2=max(1,2)<2像素。對加權線段長度w>20像素的線段進行提取,并根據式(2)計算像素能量值,根據式(3)對像素值進行歸一化,得到直線段長度密度分布顯著圖,最后進行二值化等相關操作獲得候選區域,并將候選區域提取結果在原圖上進行標注。圖5為某一提取實例關鍵環節的處理結果,其中圖5(d)為檢測獲得的顯著圖,顯著圖中的顏色越亮,表示顯著性越高。圖6為對應圖5的候選區域檢測結果,可以發現機場區域在顯著圖中表現出較高的顯著性而被準確地提取處理。根據機場不同的地理位置,以及周圍的環境,候選區域個數也會有所差別。1000張包含機場的遙感圖像集經過基于直線的顯著性提取得到約18 400個候選區域。不同大小的圖像提取的平均候選區域個數如表1所示,由表1可知候選區域個數隨著圖像的大小的提升也會相應的增加。

圖5 直線段密度分布顯著性檢測

圖6 顯著性線性目標提取

表1 候選區域個數

Tab.1 Number of candidate regions

2.2 本文神經網絡模型訓練與測試

2.2.1 數據準備

采用谷歌第二代機器學習系統TensorFlow 提供的tf.data模塊,進行數據集構建,數據集分為訓練集、驗證集和測試集。具體步驟為:1)讀取圖像文件,采用one hot編碼方式構建標簽數據集,設置機場區域的one hot標簽為1,背景區域的one hot標簽為0;2)將圖片尺寸歸一化為224像素×224像素大小,并標準化,以防止圖像像素值差別過大而導致無法進行特征訓練;3)亂序,將數據集打亂,以便模型網絡可以更好的提取特征;4)將數據集按照訓練集、驗證集和測試集所占比例進行劃分。經過以上4步,數據集準備完成。

2.2.2 確定VGG-16網絡結構

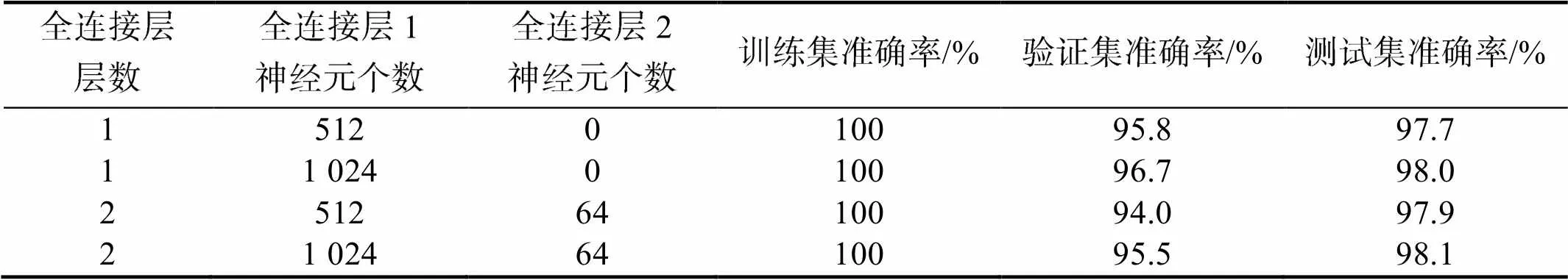

使用上述數據集構建方法,進行小樣本數據集構建,對不同全連接層的神經網絡進行訓練,以確定全連接層結構。在相同的數據樣本(訓練集480張、驗證集120張、測試集50張)、不同的全連接層神經元個數和層數條件下,通過試驗得到模型的準確率結果如表2所示。

表2 不同條件訓練結果

Tab.2 Training results under different conditions

由表2可知,當模型的準確率較高時,通過增加全連接層數和增加神經元個數對模型進行改善,其改善作用較小,甚至會造成過擬合。

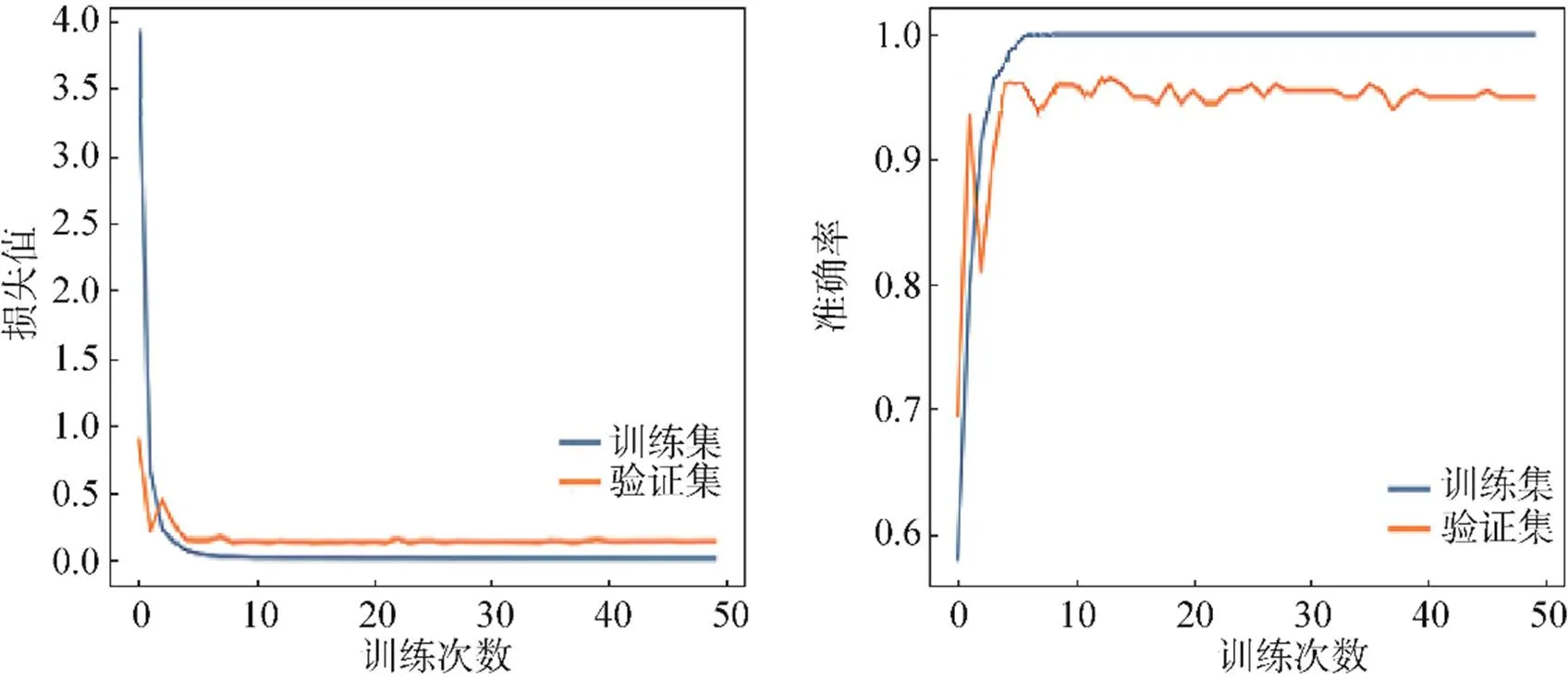

2.2.3 模型訓練與驗證

將視覺顯著性提取得到的18 400個候選區域,按照機場和非機場區域1∶1的比例選出1000張圖像,進行數據集構建,其中訓練集、驗證集和測試集數量分別是600、200、200。對確定好的VGG-16卷積神經網絡進行訓練,圖7是經過50次訓練后的損失函數和準確率曲線。由圖7可知,模型驗證集的準確率在96%上下波動。將測試集數據傳入神經網絡,得到的識別準確率為98.0%。

圖7 損失值和準確率曲線

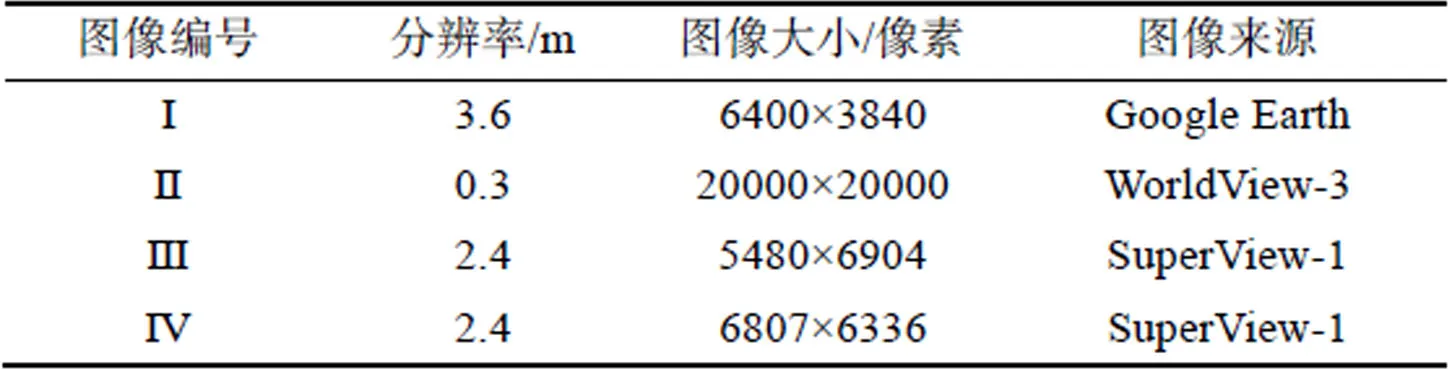

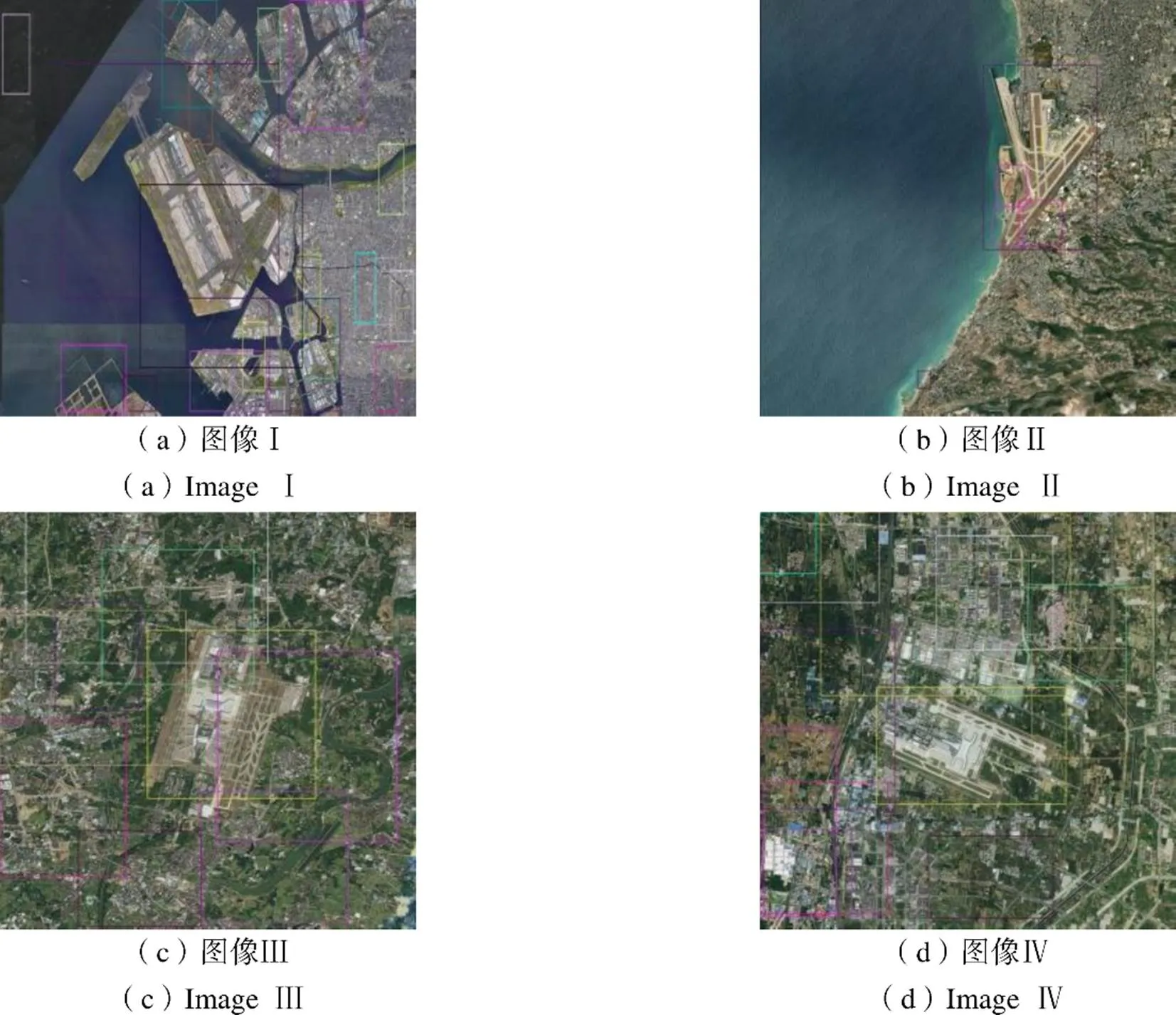

2.3 機場檢測算法測試

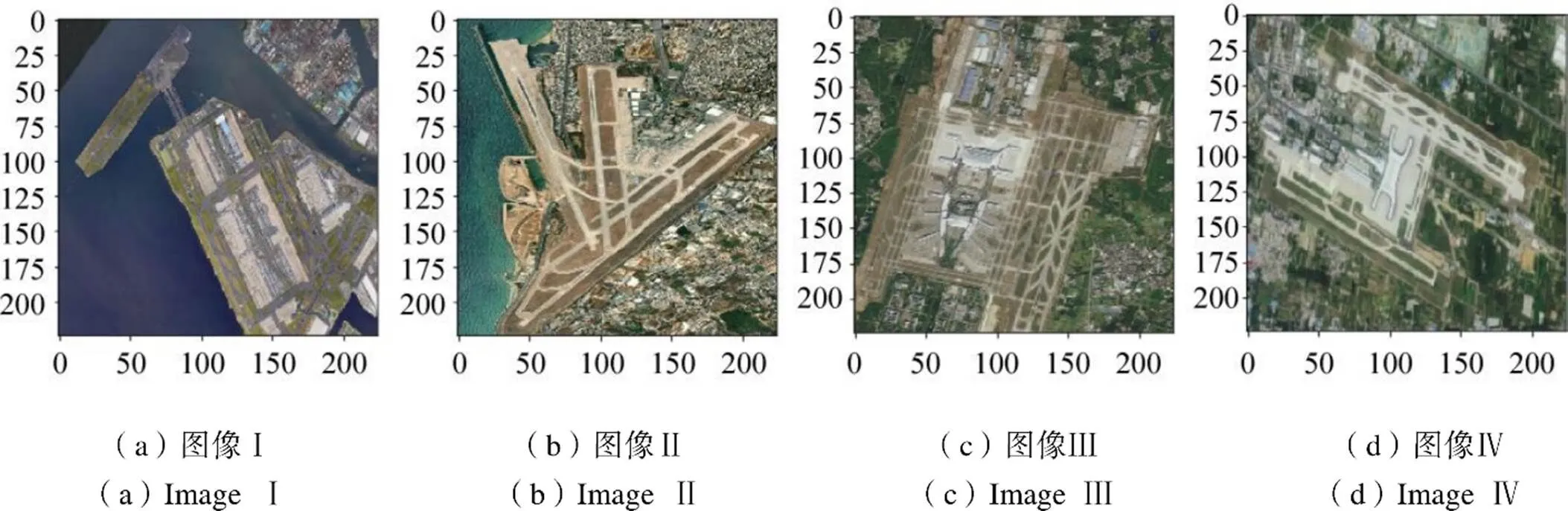

將來自不同衛星平臺的100張遙感圖像使用本文的機場檢測算法進行測試,驗證算法的可行性。首先,對傳入的圖像根據尺寸大小進行降采樣,使其空間分辨率達到10m左右。然后,進行基于視覺顯著性的候選區域提取,表3為選取的4張不同衛星平臺、不同分辨率遙感圖像的相關信息,圖8給出了這些圖像對應的候選區域提取結果。由提取結果可知,機場因其直線顯著性,可被準確的提取到候選區域。將提取的候選區域傳入訓練好的VGG-16卷積神經網絡進行機場分類識別,其中機場區域分類的結果如圖9所示。由圖9可知,改進的VGG-16網絡可準確的識別并提取出機場區域。由圖10所示的最終的檢測結果可知,本文的改進Fast RCNN算法可高效、準確的檢測出機場區域。

針對同一幅影像,Fast RCNN模型、文獻[11]的改進Fast RCNN模型需要計算的候選區域數量分別約為2000、200,而本文方法僅約20,在檢測效率方面具有極大優勢。表4給出了本文方法與文獻[9]改進的Fast RCNN算法在測試性能方面的對比,其中檢測時間為算法在測試集圖像上執行10次之后得到的每幅圖像檢測的平均時間。結果表明,與Fast RCNN模型及其同類計算模型相比,本文算法在檢測效率和準確率上均有較大幅度的提高。這是由于基于直線分布特征的視覺顯著性模型計算速度快,而且大大減少了候選區域的數量,使得后續的VGG-16卷積神經網絡能夠快速完成目標分類,整體上提高了算法效率。

表3 測試圖像信息

Tab.3 Test image information

圖8 顯著性線性目標提取

圖9 預測結果

圖10 目標檢測結果

表4 算法性能比較

Tab.4 Algorithm performance comparison

1)注:改進算法可參見文獻[9]

3 結束語

本文提出了一種基于直線分布特征的視覺顯著性模型結合卷積神經網絡進行機場目標快速檢測的方法,能夠在大幅面高分辨率遙感影像中,實現對不同類別機場目標的快速準確定位。首先使用視覺顯著性算法提取候選區域實現目標粗定位,使得到的候選區域大大減少;然后對預訓練VGG-16網絡模型進行微調,使網絡更加準確、快速地實現機場目標分類;將提取的候選區域傳入訓練好的神經網絡,完成機場的分類識別。試驗結果表明,本文算法在不同衛星平臺的影像上都有較好的適應性,均獲得了較高的準確率和識別率;改進后的RCNN網絡適應性更強,功能更加專一化,使網絡對機場目標識別能力明顯增強。該方法與RCNN和同類算法相比,具有更好的性能和更高的效率,是高分辨率遙感圖像機場目標識別的一個有效解決方案。

[1] 李智勇, 董世永, 楊效軍. 衛星可見光遙感圖像異常原因分析方法初探[J]. 航天返回與遙感, 2009, 30(1): 33-37.

LI Zhiyong, DONG Shiyong, YANG Xiaojun. Problem Location Method Research for Satellite Panchromatic Imaging[J]. Spacecraft Recovery & Remote Sensing, 2009, 30(1): 33-37. (in Chinese)

[2] 林升, 扈嘯, 陳躍躍. 基于卷積神經網絡的機場圖像目標識別[C]//第二十一屆計算機工程與工藝年會暨第七屆微處理器技術論壇. 廈門: 中國計算機學會計算機工程與工藝專業委員會, 2017.

LIN Sheng, HU Xiao, CHEN Yueyue. Airport Image Target Recognition Based on Convolutional Neural Network[C]//The 21st Annual Conference of Computer Engineering and Technology and the 7th Microprocessor Technology Forum.Xiamen: Computer Engineering and Technology Professional Committee of China Computer Society, 2017.

[3] HAN P, ZOU C, HAN B B, et al. Airport Runway Area Detection Based on Multi-feature Optimization in PolSAR Images[C]//2018 IEEE/AIAA 37th Digital Avionics Systems Conference (Dasc), 2018: 553-557.

[4] ZHANG Y, YUAN Y, FENG Y, et al. Hierarchical and Robust Convolutional Neural Network for Very High-resolution Remote Sensing Object Detection[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(8): 5535-5548.

[5] LI S, XU Y L, ZHU M M, et al. Remote Sensing Airport Detection Based on End-to-end Deep Transferable Convolutional Neural Networks[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 16(10): 1640-1644.

[6] HU Y Q, CAO Y F, DING M, et al. Airport Detection for Fixed-wing Unmanned Aerial Vehicle Landing Using a Hierarchical Architecture[J]. Journal of Aerospace Information Systems, 2019, 16(6): 214-223.

[7] ZHANG Q J, ZHANG L B, SHI W Q, et al. Airport Extraction Via Complementary Saliency Analysis and Saliency-oriented Active Contour Model[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(7): 1085-1089.

[8] GIRSHIICK R B, DONAHUE J, DARRELL T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2014: 580-587.

[9] GIRSHICK R. Fast R-CNN[C]//IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 1440-1448.

[10] 牛新, 竇勇, 張鵬, 等. 基于深度學習的光學遙感機場與飛行器目標識別技術[J]. 大數據, 2016, 2(5): 54-67.

NIU Xin, DOU Yong, ZHANG Peng, et al. Airport and Flight Recognition on Optical Remote Sensing Data by Deep Learning[J]. Big Data Research, 2016, 2(5): 54-67. (in Chinese)

[11] 張作省, 楊程亮, 朱瑞飛, 等. 聯合深度卷積神經網絡的遙感影像機場識別算法[J]. 電光與控制, 2018, 25(6): 83-89.

ZHANG Zuoxing, YANG Chengliang, ZHU Ruifei, et al. An Algorithm for Recognition of Airport in Remote Sensing Image Based on DCNN Model[J]. Electronics Optics and Control, 2018, 25(6): 83-89. (in Chinese)

[12] 殷文斌, 王成波, 袁翠, 等. 一種飛機目標的遙感識別方法[J]. 測繪通報, 2017(3): 34-37.

YIN Wenbin, WANG Chengbo, YUAN Cui, et al. A Method of Aircraft Recognition in Remote Sensing Images[J]. Bulletin of Surveying and Mapping, 2017(3): 34-37. (in Chinese)

[13] 李曉斌, 江碧濤, 楊淵博, 等. 光學遙感圖像目標檢測技術綜述[J]. 航天返回與遙感, 2019, 40(4): 95-104.

LI Xiaobin, JIANG Bitao, YANG Yuanbo, et al. A Survey on Object Detection Technology in Optical Remote Sensing Images[J]. Spacecraft Recovery & Remote Sensing, 2019, 40(4): 95-104. (in Chinese)

[14] 韓現偉. 大幅面可見光遙感圖像典型目標識別關鍵技術研究[D]. 哈爾濱: 哈爾濱工業大學, 2013.

HAN Xianwei. Study on Key Technology of Typcal Targets Recognition from Large-field Optical Remote Sensing Images[D]. Harbin: Harbin Institute of Technology, 2013. (in Chinese)

[15] SIMONYAN K, ZISSERMAN A. Very Deep Convolutional Networks for Large-scale Image Recognition[C]//International Conference on Learning Representations, 2015.

[16] 范麗麗, 趙宏偉, 趙浩宇, 等. 基于深度卷積神經網絡的目標檢測研究綜述[J]. 光學精密工程, 2020, 28(5): 1152-1164.

FAN Lili, ZHAO Hongwei, ZHAO Haoyu, et al. Survey of Target Detection Based on Deep Convolutional Neural Networks[J]. Optics and Precision Engineering, 2020, 28(5): 1152-1164. (in Chinese)

[17] PAN S J, YANG Q. A Survey on Transfer Learning[J]. IEEE Transactions on Knowledge and Data Engineering, 2010, 22(10): 1345-1359.

[18] DE SANDE V, KOEN E A, et al. Segmentation as Selective Search for Object Recognition[C]//IEEE International Conference on Computer Vision, ICCV, 2011.

[19] HUANG J, RATHOD V, SUN C, et al. Speed/Accuracy Trade-offs for Modern Convolutional Object Detectors[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 7310-7311.

[20] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet Classification with Deep Convolutional Neural Networks [C]//Advances in Neural Information Processing Systems, 2012: 1097-1105.

[21] SINGH B, DAVIS L S. An Analysis of Scale Invariance in Object Detection Snip[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018: 3578-3587.

[22] 張炳先, 李巖, 何紅艷. 基于多通道融合的遙感影像電子學噪聲去除方法[J]. 航天返回與遙感, 2020, 41(2): 116-121.

ZHANG Bingxian, LI Yan, HE Hongyan. Electronic Noise Removal Method for Remote Sensing Image Based on Multi-channel Fusion[J]. Spacecraft Recovery & Remote Sensing, 2020, 41(2): 116-121. (in Chinese)

Rapid Detection of Airport Targets Based on Visual Saliency and Convolutional Neural Network

ZHANG Yimin HAN Xianwei*ZHANG Shichao GAO Wei

(School of Physics and Electronics, Henan University, Kaifeng 475000, China)

To address the problems of slow detection speed and low accuracy when the existing airport target detection algorithms are applied to large-scale remote sensing images, this paper proposes an efficient and accurate airport target detection method based on visual saliency detection and convolutional neural network. Firstly, according to the shape characteristics of the airports, a visual saliency detection method based on the line segments distribution characteristics is used to extract the candidate regions, and the possible positions of the airport are roughly located. Then, an improved classification model based on a convolutional neural network is designed to determine whether the candidate region is an airport. Finally, the non-maximum suppression method is utilized to remove the redundant prediction bounding boxes. In the experiments, the data- set collected from Google Earth is used to train and test the network model in this paper, and the results show that the model has great advantages in both precision and recall rate. In addition, the presented algorithm in this paper is used to detect airport targets on a large number of large-scale remote sensing images from different satellite platforms. The experimental results indicate that the algorithm has strong adaptability and the detection efficiency has been greatly improved.

remote sensing image; airport targets; visual saliency;convolutional neural network; transfer learning; remote sensing application

P407.8

A

1009-8518(2021)03-0117-11

10.3969/j.issn.1009-8518.2021.03.013

2020-07-16

張一民, 韓現偉, 張世超, 等. 基于視覺顯著性和卷積神經網絡的機場目標快速檢測[J]. 航天返回與遙感, 2021, 42(3): 117-127. ZHANG Yimin, HAN Xianwei, ZHANG Shichao, et al. Rapid Detection of Airport Targets Based on Visual Saliency and Convolutional Neural Network[J]. Spacecraft Recovery & Remote Sensing, 2021, 42(3): 117-127. (in Chinese)

張一民,男,1963年生,2002年獲日本岡山大學博士學位,副教授。研究方向為計算機視覺、智能控制。E-mail:zhangyimin@henu.eud.cn。

韓現偉,男,1982年生,2013年獲哈爾濱工業大學機械電子工程專業博士學位,副教授。研究方向為遙感圖像處理。E-mail: xianweihan@163.com。

(編輯:夏淑密)