基于自注意力的雙向LSTM網絡的情感分析模型

孫璇, 馬暉男, 周勝利, 徐婧, 王成

(上海杉達學院 信息科學與技術學院, 上海 201209)

0 引言

情感分析是自然語言處理領域經典的研究任務之一,主要分析一個句子或段落的情感傾向[1]。近年來,隨著信息技術和互聯網的快速發展,人們不僅享受著數字化帶來的便利,也在不斷地產生新的信息。微博、Twitter、豆瓣等社交媒體平臺成為人們發表對產品、人物和事件等個人觀點的主要平臺。這些文本蘊含了發布者對目標對象的情感信息。通過對這些情感信息進行挖掘,可以幫助客戶更好地理解用戶行為,預測出事件的發展方向或趨勢。

在社交媒體中,這些評論文本呈爆炸式增長,一方面對耗時耗力的人工分析構成了巨大的挑戰,另一方面促進了智能文本分析技術的發展。這對情感分析任務來說尤為重要,因為在社交媒體中用戶評論的情感傾向呈現出了復雜的多維度形態,已經不再是“好,不錯”“我不喜歡”“還可以”這樣簡單的評論,而是對目標對象的某些屬性或方面表達積極、消極或中立的情感傾向。由此,用戶對目標對象的真實評價不再是整條評論上粗粒度的情感傾向分析,而是每條語句上細粒度的情感傾向分析。一般情況下,用戶習慣對目標對象的多個屬性進行評價,有積極、消極或中立等情感傾向,呈現多維度的特點。

先前已有學者對情感分析任務進行了許多研究[2]。但是,相對于一般的文本分析來說,這種屬性級別的情感分析任務具有一定的難度。因此,本文以分析與建模用戶多維度情感傾向為主要研究內容,提出了一種基于自注意力機制的雙向 LSTM 網絡的情感分析模型,該模型采用雙向長短程記憶網絡來對文本序列進行表征學習,同時融入了自注意力機制,更加有效地通過建模文本內部特征的相關性來分析用戶情感傾向。

1 相關工作

情感分析是自然語言處理中的一項基本任務,引起了許多研究者的關注。傳統的文本分類方法,如邏輯斯蒂回歸、支持向量機、決策樹等,雖然能夠用來構建情感分類模型,但是常常依賴繁瑣的特征工程及構建特定領域的情感字典[3]。許多研究表明:依賴特征工程的算法達到了性能瓶頸,能夠為大規模數據分析帶來的性能增益微乎其微[4]。2006年以來,深度學習在許多任務上取得了巨大的成就,如目標檢測、機器翻譯、智能問答、文本挖掘等[5]。因此,基于深度學習技術的情感分析方法顯示出巨大的前景。神經網絡模型的強大之處在于無需任何特征工程就能從數據中學習到文本表征的能力。代表性的文本表征學習方法有遞歸神經網絡、卷積神經網絡、長短程記憶網絡以及樹結構的長短程記憶網絡。文獻[6]利用遷移學習將傳統機器學習模型和深度學習模型相融合,把CNN提取的文本特征用SVM進行分類,在情感分析任務上取得了不錯的效果。文獻[1]認為40%的情感分類錯誤是由于沒有考慮到上下文當中的情感目標詞導致,近期的研究工作特別傾向于在對上下文建模時增強情感目標詞的作用。文獻[7]提出了一種自適應遞歸神經網絡,根據推文數據上的句法關系將情感從上下文單詞傳遞到特定目標屬性詞。文獻[8]將整個上下文分成三個組成部分,即目標屬性詞,左上下文與右上下文,然后使用情感詞典和神經網絡來生成目標相關的特征。文獻[9]將上下文拆分成兩個部分:一個部分由目標屬性詞與其左上下文組成,另一部分由目標屬性詞與其右上下文組成,然后使用兩個長短期記憶網絡模型分別對這兩個部分進行建模,最后使用這兩個部分的特定目標屬性詞的組合表征進行情感分類。文獻[10]采用雙向LSTM網絡分別對微博文本及符號進行編碼,通過將注意力模型和常用網絡用語的微博情感符號庫相結合,有效增強了對微博文本情感語義的捕獲能力,提高了微博情感分類的性能。

2 研究方法

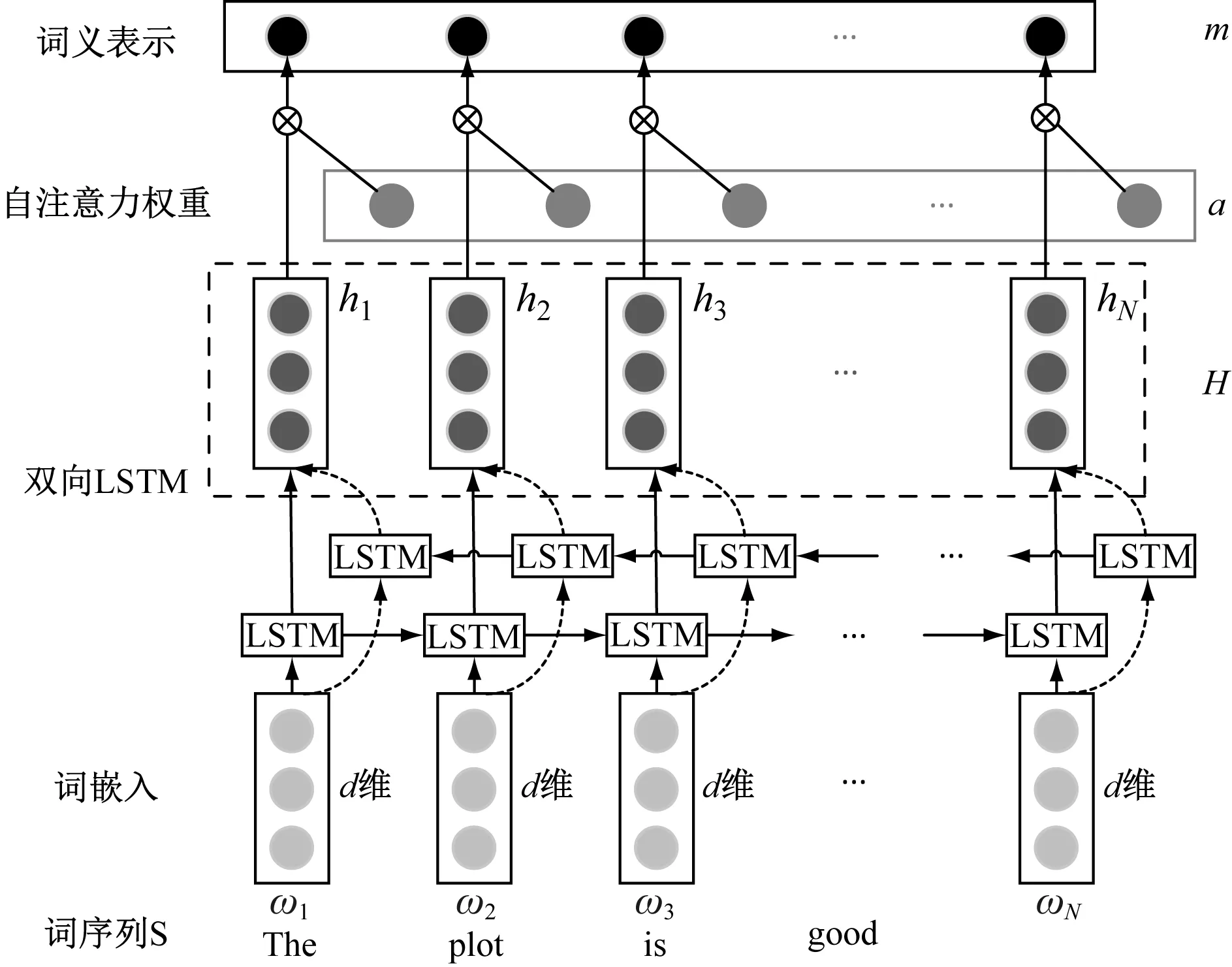

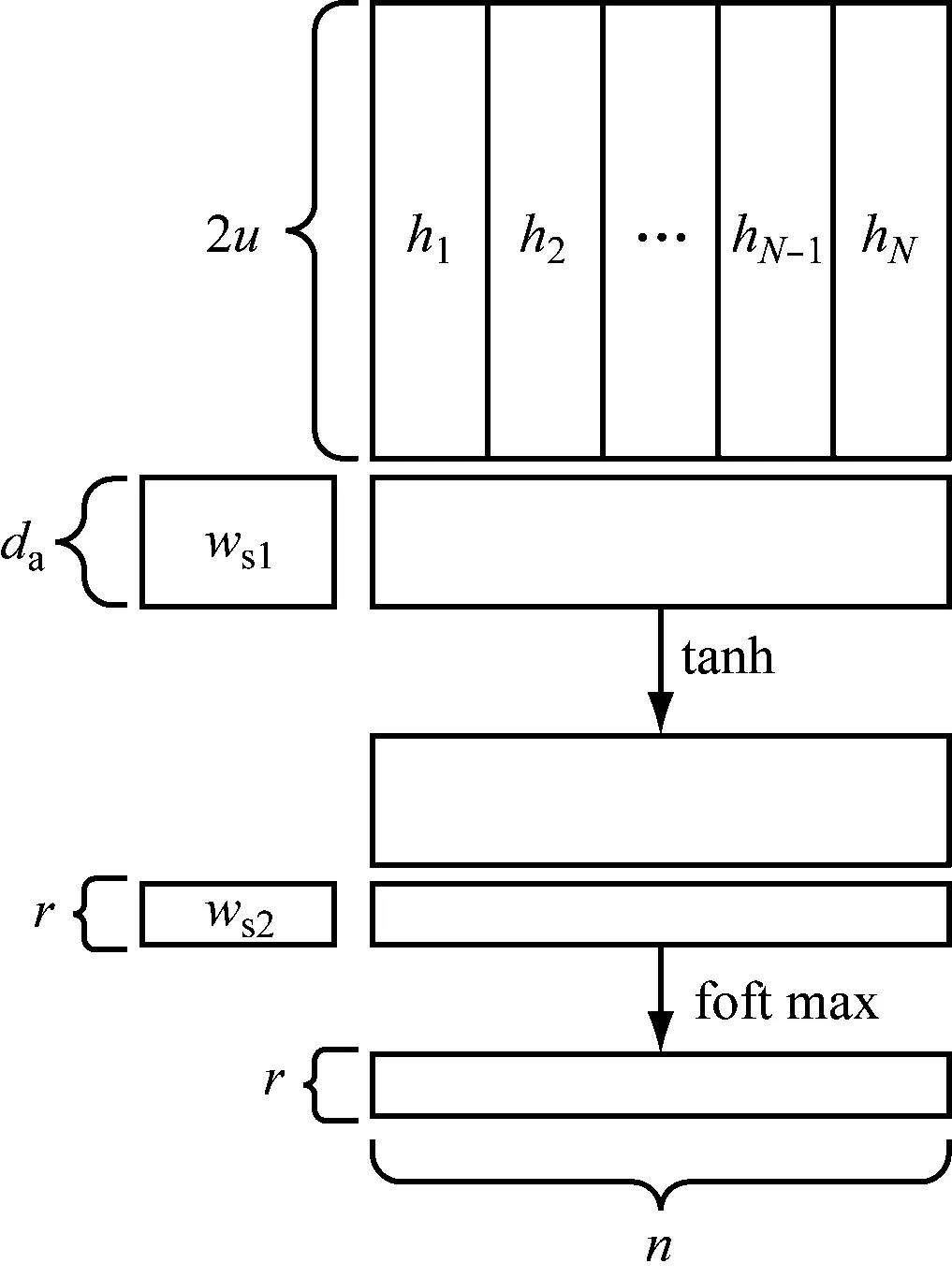

本文針對社交媒體中用戶多維度情感傾向問題進行建模,提出了一種基于自注意力機制的情感分析的深度學習模型SA-LSTM,該模型的總體框架結構如圖1所示。該模型主要由兩個核心組件組成:雙向長短程記憶網絡與自注意力機制。這兩個核心組件讓模型具有更強的信息歸納能力,從而能夠更好地關注序列文本中的重要信息。該模型主要針對目標對象的不同屬性及其所依賴的上下文分別進行建模,大致分為五層,由下往上分別是:(1)詞表示層:將目標對象的屬性詞(或詞組)及其所依賴的上下文的文本映射為向量,其中,每個詞以N維的實值向量表示;(2)雙向長短程記憶網絡層:將目標對象的屬性及其所依賴的上下文的向量表示輸入到雙向LSMT網絡當中,經過深層的LSTM計算,輸出更高級別的抽象的語義表示,稱之為隱藏層狀態;(3)自注意力機制:將雙向LSTM網絡的輸出拼接作為該層輸入,經過一次非線性變換后乘以權重參數向量ws2,得出的結果輸入到softmax層計算LSTM每個時間步的隱藏層狀態的權重;(4)語義表示層:將雙向 LSTM 網絡層每個時間步的隱藏層狀態乘以計算好的自注意力權重得到最終的語義表示;(5)分類器:將最終的語義表示拼接起來,形成一個兩者的最終表示形式,輸入到softmax分類器中,輸出用戶對目標對象的屬性的情感傾向類別。每部分的詳細設計如圖2所示。

圖1 SA-LSTM 模型的總體框架結構圖

圖2 詳細的結構設計圖

2.1 長短程記憶網絡

在許多自然語言處理任務中,長短程記憶網絡常被用來作為文本序列學習的基本模型,因為它能夠有效地緩解梯度消失和梯度爆炸問題,讓模型學習更長的文本序列表示變得可能。長短程記憶網絡的內部結構圖如圖3所示。

圖3 LSTM 單元網絡內部結構圖

LSTM單元網絡主要由三個門控與一個記憶單元組成來控制信息流:輸入門it、忘記門ft、輸出門ot。在模型訓練的過程中,這些門能夠自適應地記住輸入信息、忘記歷史信息以及生成輸出表示。LSTM單元網絡表示如式(1)—式(6)。

it=σ(Wi·[ht-1;xt]+bi)

(1)

ft=σ(Wf·[ht-1;xt]+bf)

(2)

ot=σ(Wo·[ht-1;xt]+bo)

(3)

gt=tanh(Wr·[ht-1;xt]+br)

(4)

ct=it⊙gt+ft⊙ct-1

(5)

ht=ot⊙tanh(ct)

(6)

式中,⊙表示數組元素依次相乘;σ表示sigmoid函數;Wi、bi、Wf、bf、Wo、bo分別表示LSTM單元的輸入門、忘記門、輸出門的參數。[ht-1;xt]操作表示將前一時間步的隱藏狀態ht-1與當前時間步的輸入xt進行拼接合并操作。

本文采用預訓練的word2vec詞嵌入文件,每個單詞用300維的向量表示,最大詞序列長度為n。此時,序列S中的每個詞都是彼此獨立的。為了能夠獲得單個句子中鄰接詞之間的某種依賴,使用雙向LSTM單元網絡來處理文本序列。每一步的隱藏層結果如式(7)、式(8)。

(7)

(8)

H=(h1,h2,…,hn)

(9)

2.2 自注意力機制

注意力機制模仿了生物觀察行為的內部過程, 即一種將內部經驗和外部感覺對齊從而增加部分區域的觀察精細度的機制。注意力機制可以快速提取稀疏數據的重要特征,因而被廣泛用于自然語言處理任務,特別是機器翻譯。而自注意力機制是注意力機制的改進,其減少了對外部信息的依賴,更擅長捕捉數據或特征的內部相關性。

目的是把一個變長的文本序列編碼成一個固定大小的嵌入。通過計算n個LSTM隱藏層向量的一個線性組合來實現。這種線性組合就是通過自注意力機制計算得來。自注意力機制的基本結構如圖4所示。

圖4 自注意力機制的結構圖

自注意力機制取正向與反向LSTM所有時間步的隱藏狀態拼接后的向量組成的矩陣H為其輸入,輸出權重向量如式(10)。

A=softmax(ws2tanh(Ws1HT))

(10)

其中,Ws1為維度為da×2u的權重矩陣;Ws1為維度為r×da的權重矩陣;da為一個任意設置的參數。Ws2也可以是r=1時維度為1×da的向量,這里設置為r=1。因為H的維度為n×2u,那么自注意力權重向量A的大小則為n。softmax函數確保了所有計算得來的權重之和等于1。最后,根據這些權重把所有的LSTM隱藏層向量加起來就得到了輸入序列的向量表示m。此時,m用作softmax分類器的輸入得出最后的情感分類(積極、中立、消極)。

3 實驗與分析

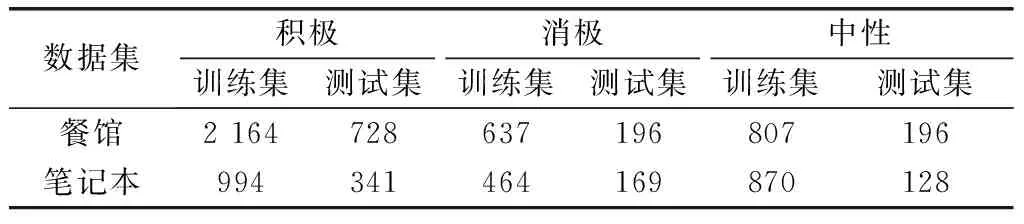

3.1 數據集

為了驗證本文提出的模型在屬性級的情感分析任務上的有效性,采用SemEval2014情感分析評測數據集。該數據集包含了“餐廳”“筆記本”兩大類的用戶真實評論數據。每條評論被標注成“積極”“中立”“消極”等三種情感,同時每條評論中也標注了其中出現的評價對象的一些屬性及其情感傾向。數據集的統計數據如表1所示。

表1 SemEval 2014情感分析評測數據集概覽

3.2 基準模型

為了驗證提出方法的有效性,本文采用以下模型作為對比實驗:

(1) CNN:使用經典的卷積神經網絡提取文本特征,經過最大池化后的使用softmax進行情感分類。

(2) CNN+SVM:使用CNN提取文本特征后,將得到的句子表示使用SVM 進行分類。

(3) LSTM:使用標準LSTM網絡學習句子語義表征,不需要返回所有時間步驟的隱藏層輸出,只保留最后一個時間步驟的隱藏層輸出,將其作為softmax分類器的輸入。

(4) TD-LSTM:一種基于LSTM改進的模型,用兩個LSTM網絡對目標詞所在位置的前后上下文分別進行建模。

(5) AE-LSTM:一種注意力機制模型,將目標詞的詞嵌入直接與句子中的詞嵌入直接拼接在一起,作為標準LSTM網絡的輸入;接著,在對所有的 LSTM網絡的隱藏層輸出使用注意力機制進行加權;最后,將加權后的句子表征作為softmax分類器的輸入進行情感分類。

(6) ATAE-LSTM:將目標詞的詞嵌入與LSTM隱藏層的輸出進行拼接,組合在一起進行注意力,最后輸入到softmax分類器進行情感分類。

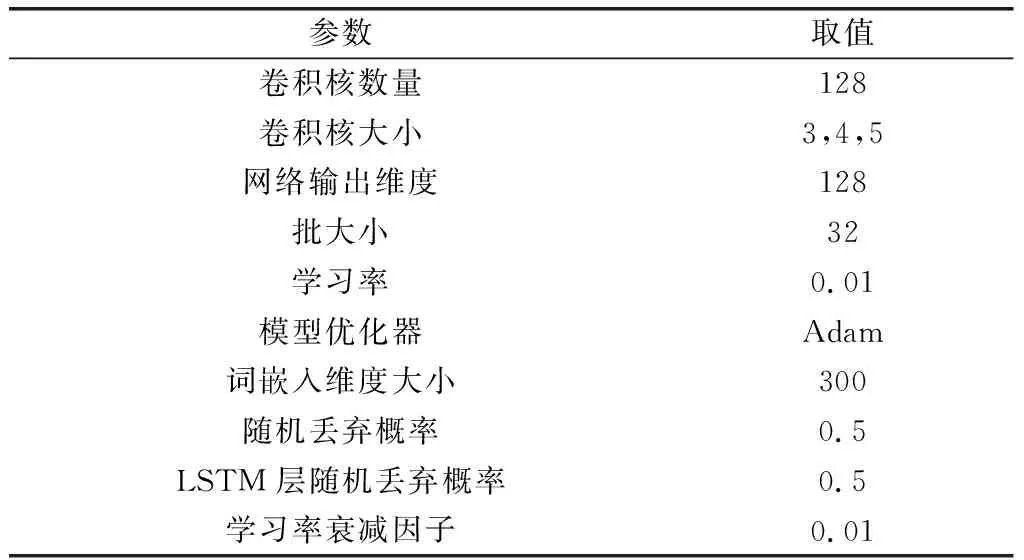

3.3 實驗設置

本實驗采用Python語言編寫,采用Keras框架實現。需要調節的參數如表2所示。

表2 模型訓練參數說明及取值

3.4 實驗結果與分析

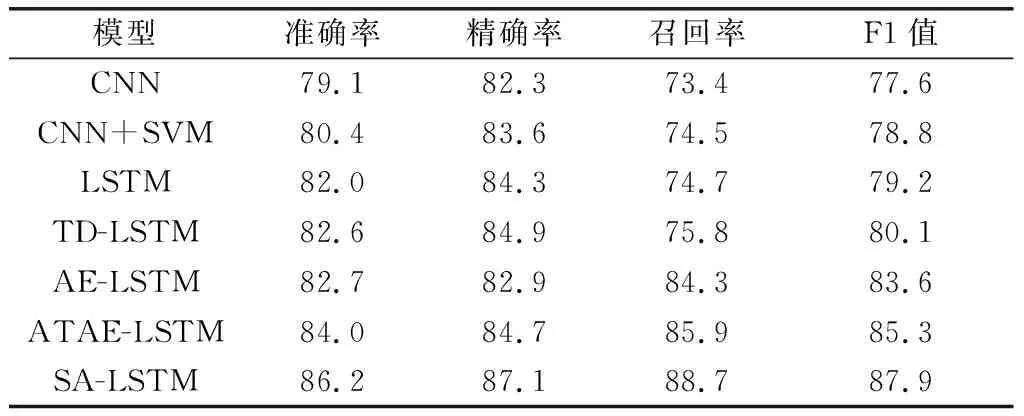

本文主要采用準確率、召回率、精確率、F1值作為評估指標。在所有模型上進行實驗的結果如表3顯示。

從表3可以看到,本文提出的方法取得了最好的實驗結果,相較于ATAE-LSTM模型在準確率、精確率、召回率、F1值上分別提升了2.2%、2.4%、2.8%、2.6%,證明了本文提出模型的有效性。可以從表3中得出結論:(1)相較于依賴外部信息的注意力機制,自注意力機制更加關注文本內部特征的相關性,這種特點顯著地增強了自注意力機制表征學習的能力,豐富了表征的語義;(2)除了采用注意力機制之外,ATAE-LSTM模型取得顯著性能的關鍵在于在詞嵌入層和LSTM輸出結果上都用預訓練好的目標屬性的向量表示進行增強。然而,在本文提出的模型中,并未使用類似的表征拼接方法來增強語義。側面反映了本文提出的模型具有相對更好的性能表現。

表3 實驗結果

4 結束語

本文提出了一種基于自注意力機制的雙向 LSTM網絡的情感分析模型,通過新穎的自注意力機制來對社交媒體中用戶評論的多維度情感傾向進行分析與建模。自注意力機制能夠捕獲評論文本序列的內部特征相關性,有效地增強了模型對于評論文本情感信息的捕獲能力,進而提升了情感分析的性能表現。在SemEval2014的數據集上,本文提出的模型均表現出了最好的性能。但是,本文采用的詞向量是靜態不變的,而不是依據上下文動態可變的。因此,本文下一步的研究工作是采用語境化的詞向量表征模型,以改善模型性能。