利用卷積神經網絡分類乳腺癌病理圖像

于凌濤,夏永強,閆昱晟,王鵬程,曹偉

(哈爾濱工程大學 機電工程學院,黑龍江 哈爾濱 150001)

癌癥是當今世界重要的公共健康問題。根據世界衛生組織國際癌癥研究機構的數據顯示,2018年約有1 810萬新病例和960萬癌癥相關死亡病例,影響到所有國家和地區的人口。尤其是乳腺癌在女性癌癥新發病例占比最高(占比24.2%),而且死亡率非常高[1]。

病理組織學分析仍然是診斷乳腺癌最廣泛使用的方法[2],而且大多數診斷仍由病理學家在顯微鏡下對組織學樣本進行目視檢查來完成,需要專業的病理學家的大量工作,專家之間的診斷一致性平均約為75%[3]。因此運用計算機來進行病理組織學圖像的自動分類可以使乳腺癌診斷更快,而且更不容易出錯。目前關于乳腺癌識別的研究主要分為2種方法:1)基于手工特征提取結合傳統機器學習的方法。Belsare等[4]使用統計紋理特征訓練K-NN(k近鄰)和 支持向量機(support vector machine,SVM)分類器,在一個40倍放大的私人乳腺組織學數據集上達到了70%~100%的準確率。Spanhol等[5]公開了乳腺癌病理圖像數據集 BreaKHis,研究了6種包括鄰接閾值統計[6]在內的手工提取的紋理特征結合包含SVM在內的4種分類器共24組的分類性能,作為區分良性和惡性腫瘤的參考基線,達到了80%~85%的準確率;2)基于深度學習的分類方法,深度學習使得模型可以直接從輸入的圖片中提取特征,避免了人工提取特征的程序,節省了大量的人力物力。近年來,卷積神經網絡(convolutional neural networks,CNN)作為深度學習的重要方法在圖像識別領域取得了巨大的成功,其在醫療圖像分析方面也取得了快速的發展[7]。Araújo等[8]利用卷積神經網絡將乳腺癌病理圖像分成了癌和非癌2大類,最高達到了88.3% 的識別率。進一步劃分為正常組織、良性病變、原位癌和浸潤性癌4類時,最高達到了77.8%的總體準確率。何雪英等[9]使用卷積神經網絡模型對BreaKHis數據集進行了良性和惡性分類,經過數據增強處理之后的識別率最高可達到91%。Spanhol等[10-11]在BreaKHis數據集上采用卷積神經網絡和深度特征的方法將乳腺癌組織病理圖像分為良性和惡性2類,最高分別達到了90%和86.3%的準確度。Bayramoglu等[12]提出了一種與放大系數無關的乳腺癌組織病理圖像分類方法,該方法在BreaKHis數據集上,可同時分類病理圖像的良性或惡性和分類放大倍數,其實驗結果在良性或惡性分類上達到了84.3%的準確度。

為了進一步提高乳腺病理圖像分類精度,本文提出了基于卷積神經網絡的乳腺癌病理圖像分類方法,同時針對高分辨病理圖像提出了圖像分塊的思想,并在BreaKHis數據集上,驗證了此方法的性能。

1 BreaKHis數據集

BreaKHis數據集[5]是巴拉那聯邦大學的Spanhol等論文中發布的公開數據集。該數據集采集自82個病人,其中良性24人,惡性58人。目前為止,該數據集一共包含7 909張圖片,分為4個放大系數40、100、200、400。每個放大系數又可分為良性和惡性腫瘤2大類。具體分布情況如表1所示。

表1 按放大系數和類別的圖像分布Table 1 Image distribution by magnification factor and class

乳腺良性和惡性腫瘤在顯微鏡下又可根據腫瘤細胞的不同分為不同類型,本文只研究不同放大系數下的良性和惡性二元分類問題。圖1展示了40放大系數下的部分病理圖像,圖1(a)~(d)圖像為4種良性腫瘤,圖1(e)~(h)為4種惡性腫瘤。所有圖像存儲格式為三通道RGB格式,固定尺寸為700×460像素。

圖1 乳腺癌組織病理學圖像樣本Fig.1 Sample breast cancer histopathology image

2 圖像分類方法

2.1 基于遷移學習的特征提取和圖像分類

隨著深度學習的快速發展,在圖像識別領域,深度學習方法特別是采用CNN的方法已經優于傳統的機器學習方法。CNN體系結構的主要由3種層構成:卷積層、池化層和全連接層。卷積層是用一組參數可學習的濾波器對輸入圖像進行卷積運算,每個濾波器經過運算產生特征映射。池化層對輸入特征映射進行向下采樣以降低輸入的空間維度。全連接層一般用在模型末端,用來將前邊提取到的特征綜合起來進行分類等操作。通常,完整的CNN架構是通過各種方式疊加這些層來獲得的。LeNet-5模型[13]運用CNN模型結構進行圖像分類實例,它對輸入尺寸為32×32的灰度圖像進行2次卷積加池化操作,最后加上3層全連接層進行圖像的10分類。

目前,各大研究機構相繼發布了一些CNN模型結構,如LeNet、VGG、AlexNet和ResNet等,這些模型都曾在圖像識別上取得過優異的成績。在一些數據集上的識別上,基于這些成熟的模型來構建模型,往往比自己從頭搭建模型效果更好,更方便快捷。如基于AlexNet模型進行了乳腺圖像的特征提取[10],該模型相對簡單,限制了其分類精度。故本文基于結構更加復雜的Inception V3[14]模型搭建模型,進行病理圖像的分類。

如圖2所示,模型由特征提取過程和分類過程構成。因為InceptionV3模型針對圖片大小為299×299搭建,所以采用圖像縮放和Inception V3模型構成特征提取過程,其中InceptionV3模型不包含原模型最后2層全連接層。分類過程由2層新的全連接層神經網絡構成,其中第1層全連接層神經網絡具有512個節點,第2層具有2個節點,并在最后一層神經網絡采用SoftMax函數作為激活函數進行分類。

圖2 圖像基于Inception V3模型分類過程Fig.2 Image classification based on inception V3 model

單張圖像分類具體操作步驟為:1)將圖片通過縮放使尺寸大小固定為299×299;2)將縮放后的圖片送入InceptionV3模型進行計算,取InceptionV3模型最后一層池化層的輸出參數作為圖片的特征向量,其尺寸為1×2 048;3)將特征向量送入全連接層神經網絡進行計算,第2層每個節點的數值經過SoftMax函數計算之后的輸出結果即為輸入圖像屬于某一類的概率;4)將圖像分類到輸出概率最大的類別。

由于數據量的限制,本文只訓練特征提取之后2層全連接層的參數。對于特征提取階段Inception V3模型的參數,采用了遷移學習[15]的方法獲得。遷移學習的是先在1個大型數據集上訓練CNN模型的參數,然后將訓練好的參數作為在新的數據集訓練相同CNN模型的初始化權值,遷移學習又可分為微調和固定權值的2種方式,微調方式在每輪訓練之后對CNN模型的參數進行更新,而固定權值的方式是CNN模型參數在初始化之后便固定不變。

本文采用在ImageNet[16]數據集上訓練的InceptionV3模型參數作為特征提取階段模型的初始化權值。且微調方式導致模型參數的改變,使得每次訓練都需要重新計算圖像的特征向量,計算任務大、訓練時間長,故本文采用固定權值的方法。由此本文在計算出圖像特征向量之后將其存儲為文本文檔,這樣可使本張圖片在下輪訓練過程中,可直接讀取文本文檔獲得特征向量,避免重復特征提取過程的計算,節約計算時間。

在訓練過程中,采用通過構建SoftMax函數的輸出結果與圖像標簽之間的交叉熵作為損失函數,通過梯度下降法進行全連接層神經網絡的參數優化,進而對損失函數進行最小化。單張圖片交叉熵損失函數為:

(1)

式中:pk(x)是輸入圖像x被分類器分為第k類的概率;yk是指示性函數,當輸入圖像x的標簽y是k類時yk=1,否則yk=0。

2.2 基于四叉樹圖像分割的數據增強

在訓練CNN模型時,若使用的數據集的樣本數較少,該網絡容易過度擬合。常用的方法為數據增強。數據增強是通過旋轉、翻轉、滑動窗口等操作提升數據量,本文采用更適合高分辨率圖像的基于四叉樹分割的數據增強方法[17]。四叉樹由1個連續的結構組成,在每一層,將上一層的輸入圖像均等分成4個部分。即在每一級L(L≥1)處,將輸入圖像劃分為(2L-1)2個大小相等且不重疊的塊。這意味著在第1級輸入圖像保持為原始圖像,在第2級輸入圖像被分成4個圖像,在第3級輸入圖像被分成16個圖像,依此類推,如圖3所示。本文對乳腺圖像的第2級和第3級切分結果進行了研究,即每張圖片分割為4塊和16塊。經過分割之后訓練數據分別增加為原數據量的4倍和16倍,在分割之后,每塊子圖像都被認為與原始圖像具有相同的類標簽。

圖3 基于四叉樹方法的圖像分割方法Fig.3 Image cutting method based on quadtree

2.3 融合算法

測試時由于采用了基于四叉樹的圖像分割方法,一張圖片被分割成多個子圖像塊,每個圖像塊在經過模型計算可能產生不同的分類結果,故需要融合算法將所有圖像塊的分類結果整合起來。常用的算法有和規則、乘積規則、最大值規則、多數投票規則等。為了研究不同的融合算法對對乳腺圖像分類結果的影響,本文選取了和規則,乘積規則和最大值規則[18]算法進行了實驗驗證,算法計算過程為:

和規則:

(2)

乘積規則:

(3)

最大值規則:

(4)

式中:pi(k)表示為1張圖片的第i個子圖像塊被模型分為k類的概率值;K表示分類類別總數;N表示1張圖片被切分塊的數量。圖4展示1張病理圖片的完整分類示例過程,在本例中將原始圖像分割為4塊,采用的融合函數為最大值規則。

圖4 圖像完整分類過程Fig.4 Image integrity classification process

3 乳腺病理圖像實驗分析

本文中所有試驗均在相同試驗環境下完成,試驗平臺為1臺CPU為Intel I7-8700,GPU為NVIDIA GTX1060 6 GB顯存,內存為16 GB的計算機,試驗環境為Windows 10操作系統,基于Python語言的TensorFlow架構進行編程。

3.1 實驗細節與評價標準

本文將實驗數據集按照75%、15%、15%的比例切分為訓練集、驗證集、測試集。訓練集用來訓練模型,驗證集用來調節模型的超參數。模型的超參數選定之后,合并使用訓練集和驗證集的數據進行重新訓練模型,利用測試集來輸出測試結果。本文實驗結果為5次測試結果的平均取值,且5次實驗獨立進行,每次實驗前重新隨機劃分訓練集、驗證集和測試集。

實驗結果以乳腺病理圖像在圖像層面和病人層面的分類準確率作為評價標準,并在每個放大系數上獨立評估。基于圖片層面的分類準確率只是考慮分類正確的圖像占全部圖像的比例,圖像層面分類準確率IA為:

(5)

式中:Nim表示全部圖片的數量;Nc是分類正確的圖片數量。

基于病人層面的分類準確率則先對每個患者的多張病理圖像計算分類準確率,再對所有患者的分類準確率取平均值。病人層面分類準確率PA為:

(6)

3.2 實驗結果與對比

3.2.1 實驗結果

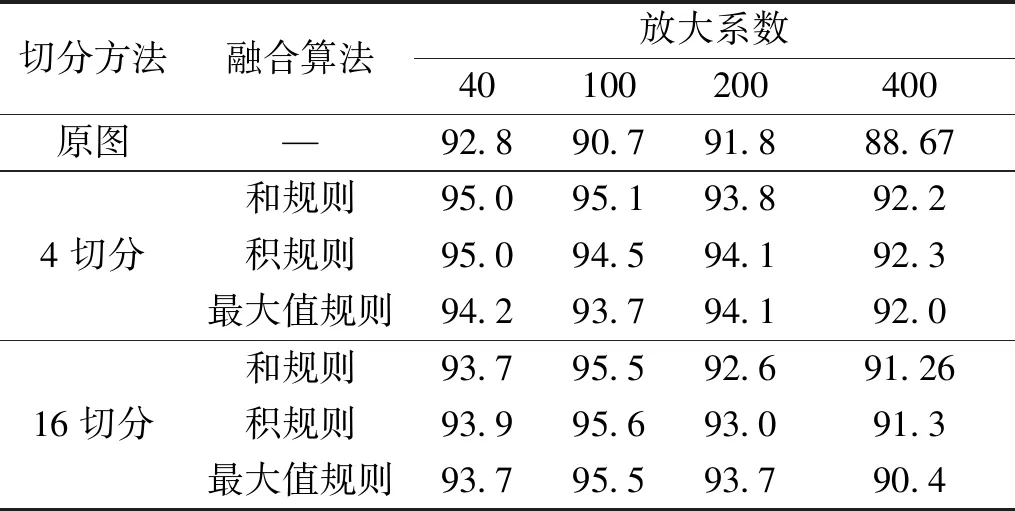

根據3.1節所定義的實驗細節和評價標準,本節在BreaKHis數據集上進行本文提出的乳腺病理圖像識別方法的性能驗證實驗,實驗結果如表2和表3所示。表2和表3分別展示了測試集在圖像層面和病人層面的識別準確度。從實驗結果上看,將圖片基于四叉樹策略分割后,無論4切分還是16切分,準確度都明顯高于原圖,其中4切分提高了2.0%~4.4%的準確率,16切分提高了0.9%~4.9%的準確率。說明圖片分割方法結合融合算法能有效提升乳腺病理圖像識別準確度。

表2 圖像層面的準確率Table 2 Accuracy at picture level

表3 病人層面的準確率Table 3 Accuracy at patient level

而從實驗結果上并不能得出哪一個融合算法更適合本實驗,說明采用不同的融合算法規則對實驗結果的影響很小。通過對比不同放大系數之間的實驗數據,發現100放大系數下的識別率最高,400放大系數下的識別率最低,40放大系數略高于200放大系數的識別率。

圖5展示了100放大系數下使用原圖和16切分的病理圖像在訓練過程中的損失函數隨著訓練步數的變化曲線,為了便于觀察,曲線經過平滑處理。可以看出,在原圖的情況下,本該逐漸減小收斂的損失函數卻在訓練步數大約達到2 000步時達到最小值,隨后開始增大。這說明模型在訓練步數超過2 000時開始過擬合。而在16切分情況下,損失函數是逐漸下降并收斂的,說明圖像切分擴大了訓練數據量,避免了過擬合情況的發生,這也是圖像切分能提高識別準確度的原因之一。

圖5 原圖和16切分圖像的損失函數對比Fig.5 Loss function comparison between original image and 16-sliced image

4切分的結果除了在100放大系數上都要略高于16切分的結果。這是由于在16切分的情況下,圖像切分的相對較小,導致部分單張子圖片所包含的信息不足以體現病理情況。

3.2.2 與其他實驗對比

為了更好的評估實驗結果,我們選取了文獻[5,10-12]和本文中各個放大系數中最好的實驗結果進行對比,如表4所示。文獻[12]中未展示圖片層面識別準確度。從表中可以看到基于卷積神經網絡和四叉樹圖片切分的方法,在各個放大系數上達到了最高的識別準確度。相對文獻[5]中采用手工特征提取和傳統的機器學習的方法,本文的方法提高了9.9%~12.2%的圖像識別準確度;相對文獻[9]采用卷積神經網絡提取特征,旋轉、翻轉的方法增強數據,本文的方法提高了2.3%~5.1%的圖像識別率;相對文獻[10]中采用卷積神經網絡提取特征,滑動窗口數據增強的方法,本文的方法提高了5%~11.5%的圖像識別率;相對文獻[11]中采用深度特征和特征融合的方法,本文的方法提高了8.2%~10.9%的圖像識別率;相對文獻[12]中采用多任務卷積神經網絡的方法,本文方法提高了10.2%~12%的圖像識別率。并且經過試驗結果對比可以得出,基于卷積神經網路特征提取的方法,在分類性能上要優于手工特征提取的方法。

表4 與其他方法的實驗結果比較Table 4 Comparisons with experimental results of other methods

4 結論

1)圖像分割的數據增強方法能夠明顯提高乳腺圖像識別率;4切分的性能要高于16切分。

2)不同融合算法對分塊圖像識別率的影響較小。通過與其他相關方法的對比,驗證了利用深度學習方法提取特征的性能要優于基于視覺的手工特征。

未來將要優化圖像的特征提取方法,如采用多模型提取特征結合特征融合的方法。通過優化圖片的切分方法,數據增強方法,進一步提高分類的精度。在二分類的基礎上,對于良性和惡性腫瘤進行進一步的分類,做到細分。