一種時空特征聚合的水下珊瑚礁魚檢測方法

陳智能,史存存,李軒涯,賈彩燕,黃磊

(1.中國科學院自動化研究所 數字內容技術與服務研究中心,北京100190;2.北京交通大學 計算機與信息技術學院,北京100044;3.百度公司,北京100085; 4.中國海洋大學 信息科學與工程學院,青島266100)

珊瑚礁魚泛指生活在熱帶海洋珊瑚叢中的各種魚,它們種類繁多、形態各異、色彩斑斕,是最富活力和觀賞性的海洋生物群體之一。研究表明,珊瑚礁魚的種類、數量和活動痕跡是否豐富,直接反映了珊瑚礁生態系統的健康狀態和海洋生物多樣性豐富程度[1]。珊瑚礁魚活動的顯著變化,則往往與溫度劇變、水域污染和過度人類活動等事件緊密聯系[2]。通過監測分析珊瑚礁魚的活動,可以快速、準確、精細地掌握海洋生態系統的健康狀況。此外,珊瑚礁魚的分析研究還將有助于幫助海洋生物學家研究不同海洋動物的行為及其之間的相互作用[3]。目前,隨著全球大多數珊瑚礁生態系統呈退化趨勢,這一研究已經得到了廣泛重視。

在海洋科學領域,最初人們主要采取人工撒網法[4]和潛水調查法[5]開展珊瑚礁魚活動調查。人工撒網法先由人在珊瑚礁水域撒網撈魚,再經過海洋生物學家整理得到分析結果。潛水調查法由專業潛水員手持水下攝像機穿越珊瑚礁水域,通過對所拍攝影像進行事后分析,得到調查范圍內的珊瑚和珊瑚礁魚情況。雖然已被沿用很多年,它們的缺點也很明顯:執行一次調查不僅消耗大量人力物力,而且會對魚類活動產生一定影響,此外還難以獲得大面積連續的監測數據。隨著水下成像技術的發展,在珊瑚礁水域特定位置安裝水下攝像機,采集珊瑚礁魚活動影像并進行分析正在成為一種普遍接受的做法。相比于傳統調查方法,水下攝像既不影響珊瑚礁魚行為,同時也為后續分析提供了大量素材。目前,全球多個國家和地區的珊瑚礁水域都部署了水下攝像系統并產生了大量珊瑚礁魚監控影像。對這些影像的分析催生了跨學科交叉研究需求:海洋生物學家手動分析每天產生的大量影像數據是不切實際的,迫切需要智能化的珊瑚礁魚分析技術,能夠從真實水下環境采集的影像中,自動得到珊瑚礁魚的出現位置、種類、數量等信息。

在信息科學領域,視頻大數據智能分析是一個廣受關注的研究課題。特別是近年來,基于深度學習的視頻分析與理解取得了顯著突破,在大規模視頻分類與檢測[6-10]、細粒度圖像分類[11-12]等任務上,深度學習相比于傳統方法性能取得了大幅提升。但是,目前多以消費類視頻圖像及安防、交通等領域的監控視頻為研究對象,對水下影像的分析相對較少。水下影像具有成像質量不高、水下環境復雜等分析難點,此外具體到珊瑚礁魚檢測上,還存在視覺多樣性高、標注數據有限等挑戰,這些困難決定了直接應用其他領域成熟的分析方法并不是最優方案,需要專門研究珊瑚礁魚的有效檢測方法。

目前,已經有一些針對珊瑚礁魚檢測分析的研究工作。早期研究多在受限情況下開展。例如,文獻[13]提出了一種基于輪廓匹配的魚識別方法,文獻[14]提出了一種基于特征變換和支持向量機的羅非魚自動分類方法,他們的實驗都是在已捕撈、拍照時擺放較規則的魚的圖像上開展。針對水下自然環境中生活的魚,文獻[15-16]從不同角度提出了聯合形狀和紋理特征的魚分類方法,結果表明,水下環境魚檢測分類的難度明顯大于之前的受限環境。面對水下珊瑚礁魚成像分辨率低的問題,Wei等[17]提出了一種利用互聯網高分辨率魚圖像進行數據增強的珊瑚礁魚分類方法。圍繞真實水下監控視頻珊瑚礁魚檢測的Sea-CLEF系列國際競賽[18],來自韓國首爾大學[19]、德國耶拿大學[20]的團隊采用了運動前景提取與基于深度學習分類相結合的解決方案,取得了較好成績。近期相關工作更傾向于利用深度學習目標檢測模型來解決珊瑚礁魚檢測問題。例如,文獻[21]提出了一個相鄰層特征融合的全卷積網絡進行珊瑚礁魚檢測。為更好應對水下復雜環境,Zhuang等[22]提出了先用SSD模型[23]檢測珊瑚礁魚,再用ResNet網絡[24]對檢測前景進行分類的方法。印度韋洛爾技術大學的研究團隊[25]評估了不同主干網Faster R-CNN模型[26]在該競賽上的檢測性能。德國杜塞爾多夫大學的學者[27]提出了一種基于YOLO模型[28]的改進方法,取得了較好的檢測效果。

上述研究雖然顯著推動了珊瑚礁魚自動檢測技術的發展,但仍存在一些不足:將珊瑚礁魚檢測視為一個前景提取及分類的任務,或將其視為一個圖像目標檢測加上時序后處理的任務。前者雖然前景提取時能一定程度利用視頻時序信息抑制水下復雜環境造成的負面影響,但其將檢測過程切分成了前景提取和分類2個獨立的子任務,二者無法相互促進和增強,檢測性能受到限制。對于后者,由于檢測時忽視了時序維度,且受目標大小有限、環境復雜等的影響,深度模型難以提取高質量檢測特征,易造成誤檢和漏檢,雖然時序后處理可消除一部分錯誤,但這也很難稱之為視頻時序信息的深入利用。

認識到特征辨識力不足是制約當前檢測精度提升的關鍵因素,本文提出了一種時空特征聚合的水下珊瑚礁魚檢測方法。具體地,設計了一個新穎的卷積網絡結構以提取更具辨識力的時空聯合特征。該網絡從SSD模型發展而來。同時,其包含一個多層視覺特征聚合模塊,以提取更豐富的視覺特征,以及一個時序特征聚合模塊,可結合運動目標生成時序強化的特征表示。通過以上2個模塊實現對空間和時間2個維度特征的聚合,得到了可有效表征水下視覺目標的時空聯合特征。公開數據集上的實驗表明,本文方法可提升真實水下環境珊瑚礁魚檢測的精度。

本文的主要貢獻如下:

1)提出了一個多層視覺特征聚合的深度網絡模塊,設計了自頂向下的切分和自底向上的歸并,可實現不同分辨率多層卷積特征圖的聚合。

2)提出了一個時序特征聚合的深度網絡模塊,可結合運動目標融合相鄰幀的卷積特征圖,從時序維度強化所提取特征。

3)通過集成以上2個模塊,提出了一個時空特征聚合的深度目標檢測網絡,可實現對視頻目標特征的有效提取及檢測。

4)公開數據集的實驗表明,本文方法可以有效檢測真實水下環境中的珊瑚礁魚,相比于傳統方法和模型取得了更好的檢測精度。

1 相關技術

本節對珊瑚礁魚檢測方法中涉及或相關的技術進行簡要介紹,具體包括前景提取及分類、圖像目標檢測和視頻目標檢測3個方面。

1.1 前景提取及分類

前景提取及分類方法將珊瑚礁魚檢測視為一個前景目標提取及分類問題。由于當前水下攝像采集的都是固定場景視頻,借鑒安防、交通監控等領域的分析經驗,利用多幀圖像平均、高斯混合模型[29]等方法可以對這類視頻進行背景建模,進而可以通過背景差減和適當后處理,提取當前幀中的運動區域。將這些區域視為前景目標從圖像中截取出來并歸一化到特定大小,即可作為深度神經網絡或其他機器學習模型的輸入,構建相應分類模型實 現 珊 瑚 礁 魚 檢 測。AlexNet[30]、GoogleNet[31]、ResNet[24]都是現有文獻中用到的分類網絡。

前景提取的效果是這類方法能否取得好的結果的關鍵。由于珊瑚礁魚在圖像中通常只是一小部分,且受到影像分辨率低,以及水流、背景目標運動(如珊瑚擺動)等的影響,所提取的前景通常會有較多噪聲。分類網絡雖然可以濾除其中一部分,但因前景目標提取不完整、提取冗余等因素,不可避免會對分類精度造成一定影響。

1.2 圖像目標檢測

圖像目標檢測方法將珊瑚礁魚檢測視為一個基于單幀圖像的目標檢測問題。圖像目標檢測是隨著深度學習技術發展性能得到顯著提升的領域之一。根據檢測原理的不同,現有檢測方法主要分為兩階段方法和一階段方法兩大類。

兩階段方法一般包含2個網絡:候選區域生成網絡和檢測網絡。首先,使用候選區域生成網絡在圖像特征圖上生成目標候選框;然后,使用檢測網絡對生成的目標候選框進行中心位置和長寬的回歸,并進行分類。典型的兩階段方法包括Faster R-CNN[26]、Cascade R-CNN[32]等。

一階段方法通過對目標位置、大小和長寬比進行密集的采樣來檢測目標。這類方法先在特征圖的每個位置根據不同的大小和長寬比預定義固定數量的默認框,再對默認框的中心位置和長寬進行回歸,并對其包含的物體進行分類判別。典型的一階段方法有YOLO[28]、SSD[23]等。

除以上方法,近年來也有一些考慮目標定位損失[33]和無需預定義默認框[34]的方法被提出來并取得良好檢測性能。此外,強化網絡所提取特征的辨識力也是提升目標檢測性能的重要方向。這方面代表性工作有特征金字塔網絡FPN[35]、默認框可適配學習的RefineDet[36]等。

具體到珊瑚礁魚檢測方面,目前有文獻用到Faster R-CNN[26]、SSD[23]和YOLO[28]。因視頻幀分辨率低、水下環境復雜、魚體態呈多維變化等特點,所提取特征質量不可避免受到影響,制約了以上方法的精度。為此,文獻[22,27]提出利用額外分類器來強化檢測結果,這一做法的效果主要體現在減少誤判上,對漏判則作用不大。

1.3 視頻目標檢測

視頻目標檢測泛指同時利用圖像靜態特征和視頻運動信息實現檢測的各種方法。目前,主要有2類視頻目標檢測方法:第1類是圖像目標檢測及后處理。先在多幀圖像上進行目標檢測,再采取適當后處理,得到視頻級檢測結果。這類方法是圖像目標檢測方法的簡單延伸,其存在難以充分利用檢測結果的時序相關性等不足。第2類方法利用可同時接受視覺和時序信息作為輸入的深度模型進行檢測。目前,已經有一些相關的網絡結構被提出來。例如,利用2個卷積神經網絡分別處理視覺和運動信息的雙流神經網絡[6],利用卷積神經網絡提取單幀圖像視覺特征,進而用長短時記憶神經網絡建模相鄰幀之間相關性的CNN-LSTM結構[7],利用3D卷積提取時空聯合特征的三維卷積神經網絡[9]。這些方法統籌考慮了時空域,因而可以提取到更為強大的特征,從而提升行為識別、視頻分類等多個視頻任務的分析精度。

由于珊瑚礁魚通常只占視頻幀的一小塊區域,且其位置隨著時間變化,構建有效的局部視覺和時序特征表示是視頻目標檢測的關鍵。這方面典型工作有光流引導特征聚合網絡[10],依據光流方向聚合相鄰幀特征圖以強化對當前幀目標的表示,可適當緩解目標因運動模糊、面積過小、罕見姿態等問題導致的檢測困難。此外,也有學者研究了同時進行目標檢測和跟蹤的網絡[37],通過二者的互補提升檢測性能。

2 本文方法

2.1 整體網絡結構

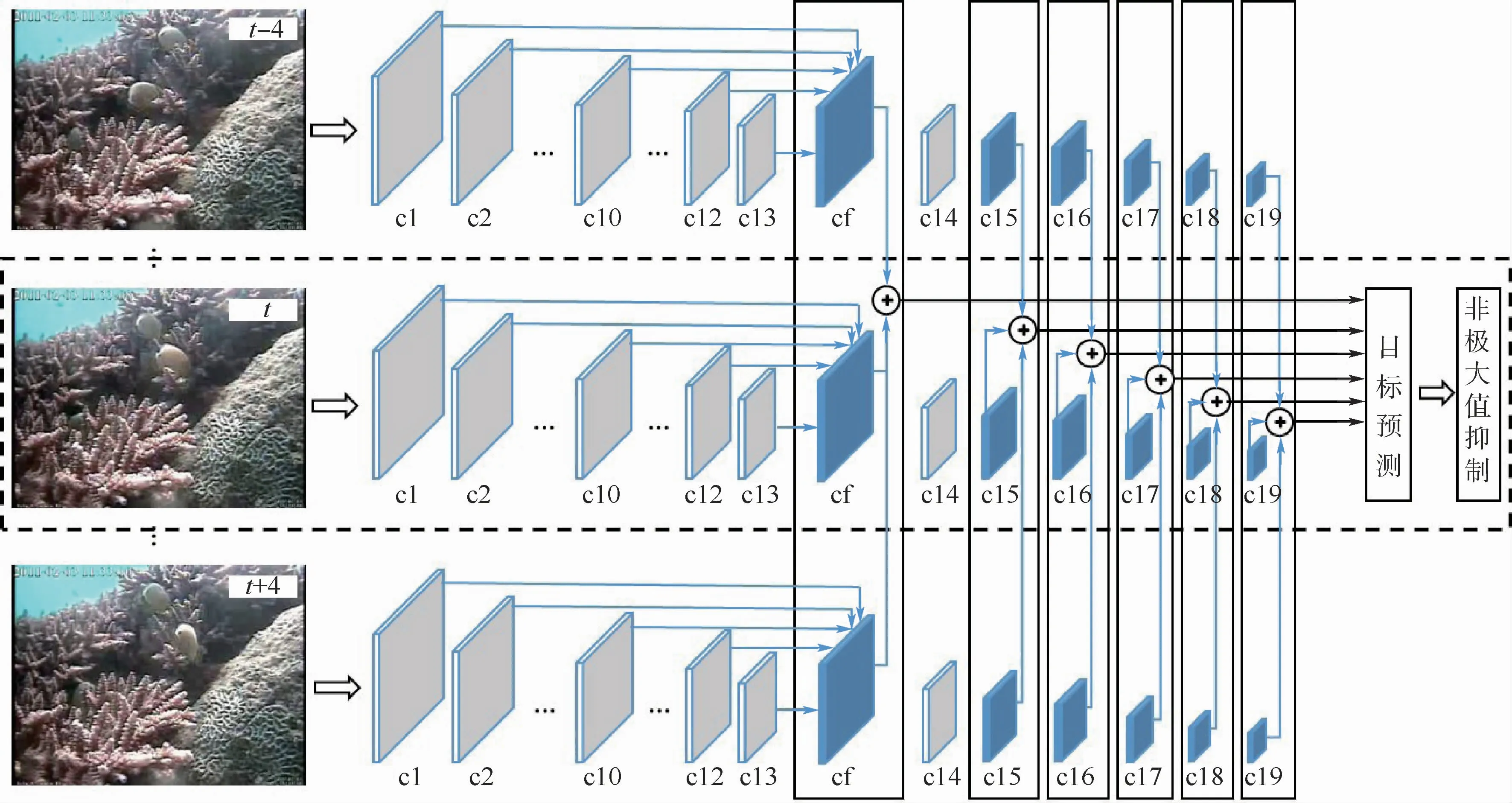

本節介紹提出的時空特征聚合水下珊瑚礁魚檢測方法。圖1給出了時空特征聚合神經網絡的整體結構。可以看到,該網絡接受當前視頻幀及前后相鄰幀作為輸入。當前幀通過圖中c1~cf組成的視覺特征聚合模塊(Visual Feature Aggregation,VFA),生成一個融合了多層卷積特征圖、信息更豐富的新視覺特征圖。同時,對于其中參與目標預測的特征圖(cf,c15~c19),通過圖中實線框表示的時序特征聚合模塊(Temporal Feature Aggregation,TFA)對當前幀及相鄰幀特征圖予以聚合,從而生成具備更強表示能力的時空聚合特征(Visual-Temporal Feature Aggregation,VTFA)。珊瑚礁魚檢測將在空間分辨率逐步降低的多個聚合特征圖上進行。

圖1 本文時空特征聚合神經網絡的整體結構Fig.1 Overall architecture of the proposed spatio-temporal features aggregation neural network

本文網絡可視為一種從SSD模型[23]發展而來的復合結構,在其單幀圖像處理通道中(見圖1中虛線框),類似于 SSD 利用卷積神經網絡VGG16[38]作為特征提取主干網,其中基本卷積層c1~c13與VGG16一致,最后2個全連接層和分類層被截斷,予以替換的是6個空間分辨率逐步降低的新增卷積層(c14~c19)。在SSD中,目標檢測將在c10、c15~c19這6個不同尺度的卷積特征圖上進行。

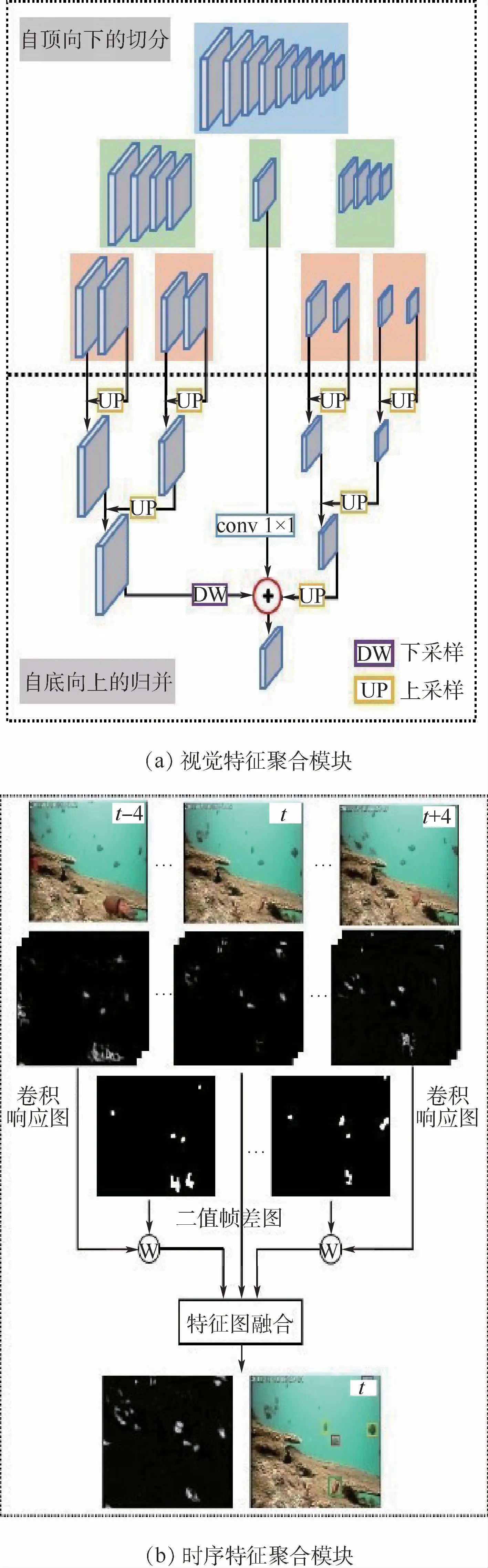

損失函數方面,本文網絡與SSD的形式相同,整個網絡的損失函數定義為

式中:x為記錄預測框和標注框匹配情況的矩陣;c為當前樣本的預測置信度向量;l和g分別為預測框和標注框的坐標信息;N為當前幀預測框數量;Lconf和Lloc分別為類別損失和定位損失;a為一個用于平衡2類損失的參數,本文設置為1。以上損失項的計算公式可參見文獻[23]。

不同于SSD,本文網絡的目標預測是在經過單幀圖像多層特征圖聚合與/或相鄰幀同層特征圖聚合后生成的時空強化特征圖上進行,這2個聚合模塊正是本文的創新之處。

2.2 視覺特征聚合模塊

源自VGG16的基本卷積層中,SSD僅用c10進行預測,忽視了其他層信息。水下監控視頻由于質量低、成像環境復雜且珊瑚礁魚目標通常較小,基本卷積層特征圖上的信息對于檢測來說尤其重要。基于此,本文設計了一個視覺特征聚合模塊對基本卷積層進行更有效的利用,以提高水下復雜環境中的珊瑚礁魚檢測性能。

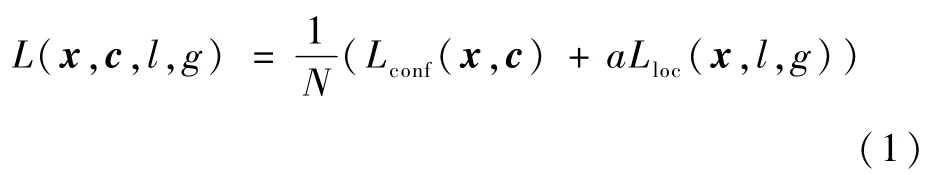

視覺特征聚合模塊由一個自頂向下的切分和一個自底向上的歸并操作組成。切分過程迭代地將卷積層分成不同的組,形成了一個自頂向下的切分結構。在這個結構的最頂層,所有卷積層都在同一組。當卷積層數量n是偶數時,在下一層它們將從中間切分,分成2個各含有n/2個層的組;當卷積層的數量n是奇數時,在下一層最中間的卷積層將被視為一個單獨的組,其左右兩邊的卷積層被分為另外2個組,各含有(n-1)/2個層。基于這一原則,卷積層可以不斷被切分,直至每個組中卷積層的數量小于等于2,此時切分過程停止。圖2(a)的上半部分給出了一個切分的例子。

基于以上切分結果,自底向上的歸并從下往上不斷合并每個組中的特征圖,最終形成了一個聚合了所有卷積特征圖的特征。具體地,卷積層歸并時涉及對2個或3個分辨率和通道數可能不同的特征圖融合。由于卷積神經網絡特征圖從淺層到深層滿足分辨率不變或遞減的規律,對于2個特征圖融合的情況:若分辨率不同,將低分辨率特征圖上采樣到與高分辨率特征圖具有相同大小,再進行融合;若分辨率相同則直接融合。對于3個特征圖融合的情況,先保持中間層特征圖的分辨率不變,若其淺層方向特征圖分辨率大于中間層,則通過下采樣將其降采樣到與中間層特征圖相同分辨率再融合;若其深層方向特征圖分辨率小于中間層,則將其上采樣到與中間層特征圖一樣大小再進行融合;若淺層和/或深層方向特征圖分辨率與中間層的一致,則直接融合。通過迭代進行融合操作,最終所有特征圖將會被融合成一個具有適中分辨率的聚合特征圖,如圖2(a)下半部分所示,該特征圖將會替換c10進行預測。

圖2 本文提出的視覺特征聚合模塊和時序特征聚合模塊Fig.2 The proposed visual feature aggregation module and temporal feature aggregation module

對于融合過程中的特征圖通道數可能不一致的情況,以(三層融合的)中間層或(兩層融合中)淺層方向的特征圖為基準,融合前先通過1×1的卷積將其他層特征圖的通道數予以對齊。注意到,該特征聚合模塊不僅適用于VGG16主干網,也可以推廣到其他卷積主干網。相比于僅利用c10進行預測,以及文獻[21]僅融合相鄰預測層的方案,本文視覺特征聚合模塊以一種合理且可擴展的方式聚合了多個基本卷積層的特征圖,提供了更豐富的局部細節和上下文信息,有利于更好刻畫視頻幀中的珊瑚礁魚目標。

2.3 時序特征聚合模塊

珊瑚礁魚在水下游動時體態呈多維變化,當其部分遮擋或以罕見體態出現時,不可避免會帶來檢測困難。融合相鄰幀特征顯然有利于緩解該問題。基于此,本文設計了時序特征聚合模塊在相鄰幀上融合運動目標相關的特征圖,以生成更強化的特征表示。

時序特征聚合模塊的示意圖如圖2(b)所示。對于輸入到網絡的當前視頻幀及其前后相鄰幀,利用圖1所示的主干網結構提取每幀圖像各個卷積層的特征圖,這些特征圖記錄了目標在當前圖像上的卷積響應值。基于此,在特征圖上計算當前幀與每個相鄰幀的幀差圖,對幀差圖進行灰度化和二值化并結合適當后處理,如圖2(b)所示,記錄了當前幀與其相鄰幀之間運動信息的二值幀差圖。

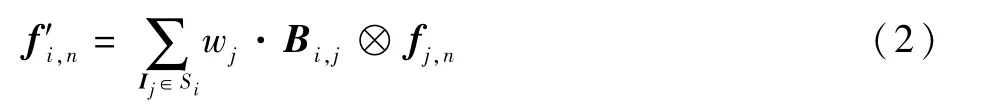

對于網絡中參與目標預測的特征圖,通過以下公式對其進行時序聚合:

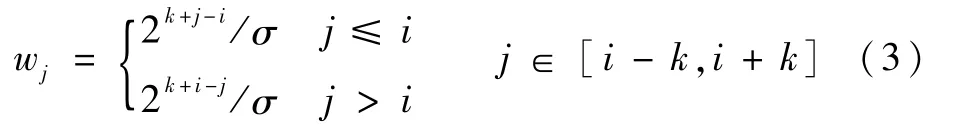

式中:fj,n為視頻幀Ij聚合前的第n層特征圖;f′i,n為視頻幀Ii聚合后的第n層特征圖;Bi,j為Ii與Ij的二值幀差圖,當i=j時,Bi,j為值全為1的矩陣;“?”為對應相乘操作;Si=(Ii-k,Ii-k+1,…,Ii+k)為Ii及其相鄰幀集合,k為鄰域邊界;wj為Ij對應的權重,即

其中:σ為歸一化因子,以確保所有權重之和為1。

式(2)以線性加權的方式,將相鄰幀特征圖中對應幀差運動區域的特征融合到當前幀同層特征圖中。這一做法可以生成一個以當前幀運動目標為中心,適當囊括其周邊區域,時序強化的特征。由于珊瑚礁魚是視頻中的運動主體,這一做法可有效緩解當前幀珊瑚礁魚目標因運動模糊、罕見姿態等帶來的特征表示困難。

以上時序融合在所有6個參與目標預測的卷積特征圖上都將進行,其中包括了一個通過視覺特征聚合模塊生成的預測層。因此,網絡可提取到時空聯合的強化特征更好地進行目標檢測。注意到,文獻[10]也提出了一種光流引導的相鄰幀特征圖融合方法。本文與其有2點區別:①在融合區域確定上,文獻[10]先計算兩幀之間的光流,再依此將每幀光流前景對應的特征圖位移后再與當前幀相應位置疊加融合。與之對應,本文采用了計算代價顯著降低的幀差運算,融合區域也是相對更寬泛的幀差前景區域。采用這一做法主要是考慮到低質量視頻中光流計算誤差較大,容易導致位移估計不準確。此外,認為魚周邊區域的特征也有助于檢測。②在相鄰幀融合的權重上,文獻[10]用余弦相似度動態計算當前幀與相鄰幀的權重,而本文采用的是一個以當前幀為中心的類高斯分布權重,直接賦予與當前幀更鄰近的相鄰幀更大權重。這一做法在降低計算量的同時,也一定程度避免了相似度計算對噪聲敏感的影響。

上述融合中,時序聚合的鄰域k是一個重要參數。大的k值融合的相鄰幀多,但網絡結構更復雜,計算代價更高;小的k值則有時序信息融合不充分的隱患。此外,選定k值后,鄰域中圖像分析的采樣間隔也是一個需要明確的細節。將在消融實驗中論證不同做法的區別。

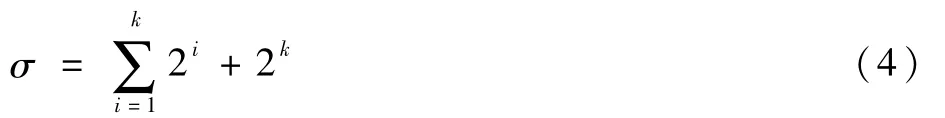

2.4 后處理

基于幀級檢測結果及置信度,本文先利用非極大值抑制消除單幀圖像上的冗余檢測框,再提出了一個時序后處理以提升珊瑚礁魚檢測精度。該后處理旨在改善部分情況下珊瑚礁魚檢測得分置信度過低,易造成漏檢和誤檢的現象。具體地,在得到單幀檢測結果后,先將相鄰幀中滿足檢測類別相同且IoU>0.5的檢測框標記成檢測對,再將檢測對中檢測框得分統一為置信度高的得分。通過這種方式,一定程度利用了目標的時序互補性強化了檢測得分,使檢測結果更穩定。上述非極大值抑制和時序后處理如圖3所示。

圖3 非極大值抑制和本文提出的時序后處理Fig.3 Non-maximum suppression and the proposed temporal post-processing

本文網絡實現時,由于當前幀預測需要利用前后相鄰幀特征圖,為避免重復提取圖像特征,在確定鄰域參數k及其采樣間隔后,將申請一個公共緩存空間存儲以當前幀為中心,鄰域內所有采樣圖像參與預測的卷積特征圖。這樣,每幀檢測時,只需計算當前幀的時空聯合聚合特征圖以開展以當前幀為中心的目標檢測。對一個視頻幀序列,則只需按時序對所有采樣幀重復以上過程,相應調整緩存空間內容,即可依次計算所有采樣幀上的檢測結果。

3 實驗與結果

3.1 數據集

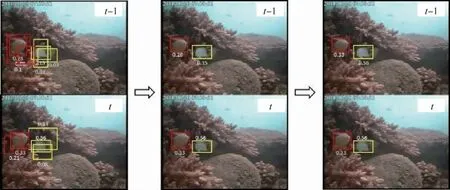

用SeaCLEF國際競賽[18]數據作為本文實驗數據集。該數據集提供了5個不同場景和日期的93個水下監控視頻,給出了其中出現的15種珊瑚礁魚的逐幀標注,包括魚的類別和矩形框形式的位置信息,共有21 396個標注樣例。該數據集涵蓋了圖像分辨率低、水下環境復雜、魚體態變化大等一系列真實水下監控視頻包含的檢測難點。

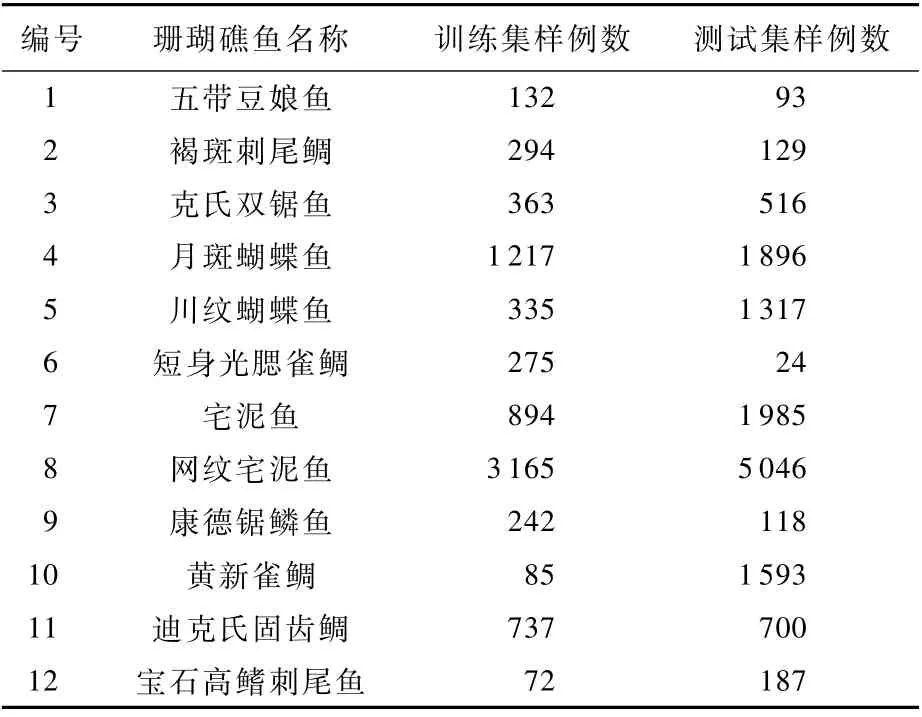

競賽將數據集分成了訓練集和測試集,分別包含20個和73個視頻的13 882個和7 514個標注實例。訓練集和測試集都涵蓋了全部的5個場景。但是,不同魚在數據集中的分布并不均勻,出現次數最多的網紋宅泥魚在訓練集和測試集上分別出現了3165和5 046次,15種魚中黑緣單鰭魚在測試集中僅出現了8次,甚至鏡斑蝴蝶魚和黑鰭粗唇魚在測試集沒有出現。因此參考文獻[21],本文將上述3類魚從檢測任務中去除,構成了一個包含12種珊瑚礁魚的目標檢測任務。表1給出了這些魚的名稱,以及它們在訓練集和測試集中的數量分布情況。

表1 SeaCLEF數據集中不同類別魚的數量Table 1 Numbers of different fish species on SeaCLEF dataset

3.2 實驗設置及評價指標

本文采用一個兩步訓練過程來訓練網絡。第1步基于單幀圖像訓練一個僅包含視覺特征聚合模塊的目標檢測網絡:先讀取ImageNet數據集的預訓練參數,再采用批量隨機梯度下降方法進行訓練,批的大小為32張圖像。設置網絡總共迭代訓練120 000次。先將學習率設置為0.000 1進行1 000次迭代的熱身訓練,完成熱身訓練以后將學習率升至0.001,迭代訓練40 000次和80 000次之后,分別將學習率降低為0.000 1和0.000 01,以使網絡更好地收斂。梯度更新動量值為0.9。第2步訓練基于第1步得到的參數訓練整個網絡結構。由于特征圖相加操作的可導性,整個網絡是端到端可訓練的。第2步同樣采用批量隨機梯度下降的精調訓練,批的大小為1張圖像,迭代輪數設置為60000次,其中前40000次與后20000次的學習率分別為0.000 1和0.000 01。采用了隨機剪裁和調整圖像對比度的數據增強方式。圖像在輸入網絡之前先將大小調整為300×400。全部訓練在一個GTX Titan X GPU上完成,基于TensorFlow平臺完成整個模型訓練需要約34 h。

推理階段,本文網絡接受當前幀及其前后多個相鄰幀作為輸入,輸出當前幀的檢測結果。檢測結果經過2.4節的后處理,可得到視頻級檢測結果。評價指標上,本文用目標檢測領域廣泛使用的平均精度均值mAP,其定義為

式中:APi為第i個目標類別通過改變閾值得到的不同召回率下的平均精度;n為目標類別個數。

3.3 消融實驗

通過消融實驗來驗證視覺特征聚合模塊和時序特征聚合模塊中特征圖的具體融合方式,以及時序融合時當前幀的鄰域及采樣間隔。

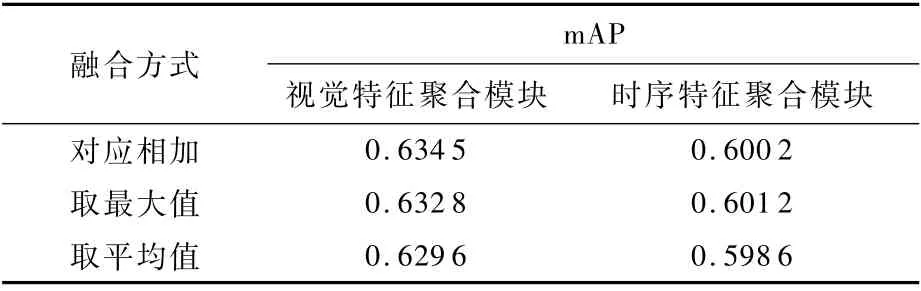

融合方式方面,驗證視覺特征聚合模塊時,將網絡結構設置為僅輸入當前幀Ii的情況,此時網絡僅包含圖1中虛線框的部分。對比了對應相加、取最大值和取平均值3種特征圖融合策略。表2給出了相應的mAP值。可以看到,對應相加取得了更好的性能。

驗證不同融合方式對時序特征聚合模塊的影響。先將網絡固定為輸入{Ii-4,Ii,Ii+4}3幀圖像的情況。為簡化起見,去除了網絡中的視覺特征聚合模塊。表2給出了上述3種情況下的mAP值。結果表明,取最大值進行融合更有利于進行珊瑚礁魚檢測。

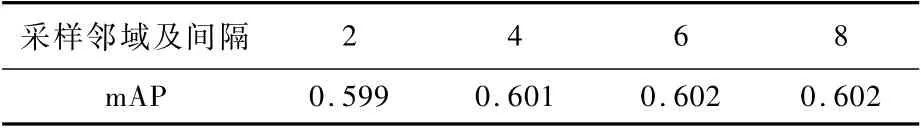

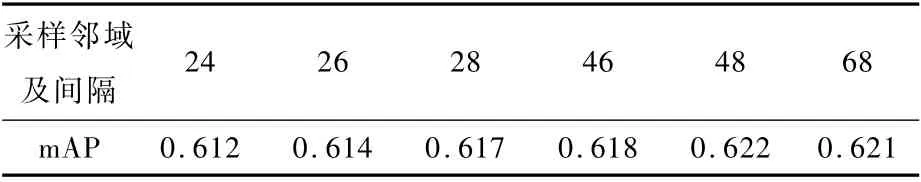

分析采樣鄰域及間隔對結果的影響。受限于計算資源,僅考慮了輸入不超過5個視頻幀的情況。結合不同采樣間隔,將其分成了如表3和表4所示的11種情況,其中2表示考慮{Ii-2,Ii,Ii+2}3幀圖像的情況,46表示考慮{Ii-6,Ii-4,Ii,Ii+4,Ii+6}5幀圖像的情況,其余依此類推。實驗中網絡都未包括視覺特征聚合模塊。

可以看到,輸入5幀圖像可以取得比3幀圖像更好的檢測結果。這一點是符合預期的,因為聚合更多相鄰幀有利于提取更具辨識力的特征。此外,注意到與當前幀間隔為6(3幀情況),以及4和8(5幀情況)時,相比于其他間隔情況下取得了更好的結果。幀數間隔大一般關聯著更大的運動區域,對應到本文網絡則是更大范圍的特征融合。當間隔相對適中時,可使得相鄰特征圖中目標及合適范圍的周邊上下文得到更強化的刻畫,但若間隔過大,則容易融合到更多的噪聲而起到負面作用。基于以上結果,本文網絡結構最終確定為接受{Ii-8,Ii-4,Ii,Ii+4,Ii+8}5幀圖像作為輸入,并將對應相加和取最大值分別作為視覺特征聚合和時序特征聚合中多個特征圖的融合方式。

表2 不同融合方式及性能Table 2 Different fusion methods and their performance

表3 輸入為3幀圖像時不同參數下的網絡性能Table 3 Network perfor mance under different parameters when three-frame images are input

表4 輸入為5幀圖像時不同參數下的網絡性能Table 4 Network perfor mance under different parameters when five-frame images are input

3.4 實驗結果及對比分析

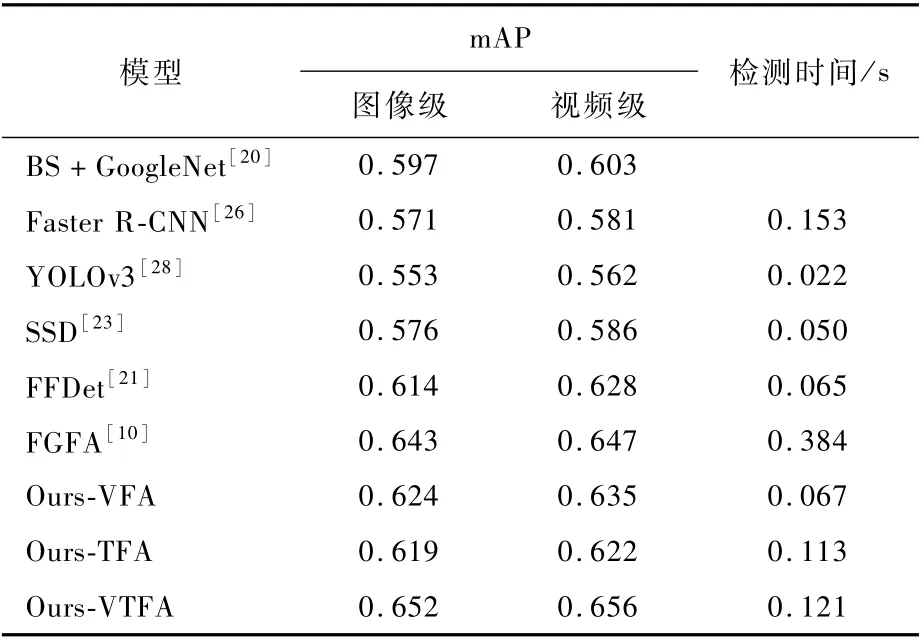

為評估檢測性能,將本文網絡及其衍生結構和幾種主流方法與模型進行了實驗比較。

BS+GoogleNet[20]:德國耶拿大學提出的基于前景提取及分類的珊瑚礁魚檢測方法。

Faster R-CNN[26]、YOLOv3[28]和SSD[23]:采用這3個主流目標檢測模型進行珊瑚礁魚檢測。

FFDet[21]:基于相鄰卷積層特征融合的珊瑚礁魚檢測方法。

FGFA[10]:光流引導的相鄰幀特征圖融合的檢測方法。

Ours-VTFA、Ours-VFA 和Ours-TFA:本 文 網絡,以及本文網絡分別去除時序特征聚合模塊和視覺特征聚合模塊后對應的珊瑚礁魚檢測方法。

表5給出了以上方法的圖像級和視頻級實驗結果及時間消耗。可以看到,Ours-VTFA方法相比于傳統基于前景提取及分類、主流目標檢測模型取得了8.8% ~16.8%的相對性能提升,表明本文時空特征聚合網絡能更好地檢測水下珊瑚礁魚。同時,該方法也取得了比僅考慮其中一種模態聚合的Ours-VFA和Ours-TFA更好的效果,說明從時間和空間2個維度強化特征提取的互補性和必要性。

視覺特征聚合方面,對比于沒有特征融合的SSD和采用相鄰層視覺特征融合的FFDet,Ours-VFA方法取得了更好的檢測性能,說明基本卷積層聚合生成的特征圖可以更好地描述珊瑚礁魚的類別和位置信息,挖掘利用基本卷積層特征對低質量水下視頻中珊瑚礁魚檢測具有重要價值。此外,注意到Ours-VFA方法的檢測速度顯著快于FGFA等高精度方法,僅略遜于精度不如它的SSD和FFDet。Ours-VFA方法不失為一種速度和精度得到較好折中的檢測方案。

表5 不同方法的檢測性能Table 5 Detection perfor mance of differ ent methods

時序特征聚合方面,Ours-TFA方法與SSD的區別在于:前者在網絡中聚合了相鄰幀對應運動區域的特征圖,即獲得了6.3%的mAP相對提升,驗證了時序維度的挖掘利用有助于提升檢測性能。本文基于幀差的相鄰幀聚合方法可以融合相鄰幀目標周邊的上下文區域,有助于提取更加有效的特征。該方法雖然檢測性能低于FGFA,但時間消耗減少了2倍以上,主要是幀差計算的代價顯著低于光流計算。在Ours-VFA方法的基礎上進一步融入時序特征聚合模塊,可繼續提升檢測性能,再次說明了本文網絡可以互補地聚合時間和空間維度的特征。注意到,Ours-VTFA方法可以取得優于FGFA的實驗結果,且檢測時間也縮短了2倍以上,這也再一次凸顯了聚合基本卷積層特征的重要性。此外,所有方法采用了本文后處理技術后,檢測精度均有一定提升,表明網絡內外挖掘的時序信息具有一定互補性,在不同層次利用它們可進一步提升檢測精度。

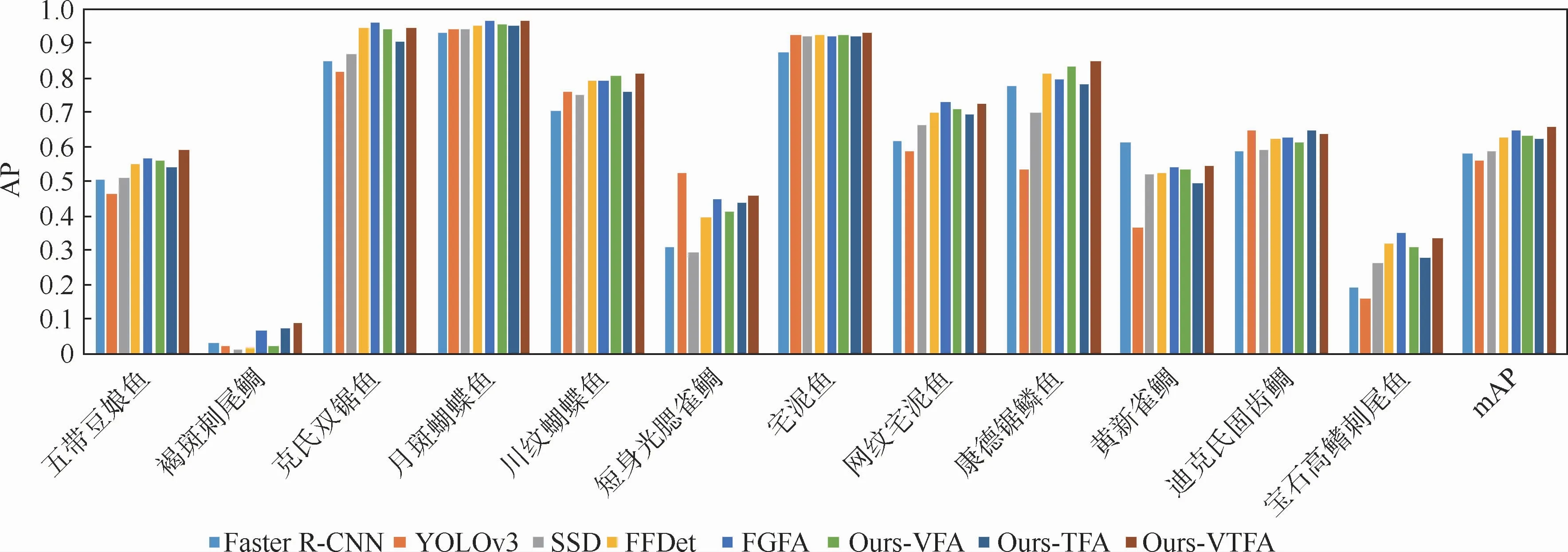

圖4給出了各種檢測模型在不同珊瑚礁魚類別上的檢測結果。其中,每種魚的8個檢測結果從左到右分別是Faster R-CNN、YOLOv3、SSD、FFDet、FGFA、Ours-VFA、Ours-TFA 和 Ours-VTFA 8種方法取得的。可以看到,不同類型魚的檢測結果差異巨大。即使性能最好的方法,在褐斑刺尾鯛上的AP值也不超過0.1。與之對應,無論是哪種方法,在宅泥魚、克氏雙鋸魚和月斑蝴蝶魚上都取得了較高AP值。從兩方面解釋造成以上顯著類間差異的原因:①珊瑚礁魚樣本數量在類別上分布不均。結合表1可看到,AP值高的魚類別樣本較多,而AP低的魚類別樣本較少,訓練數據是否豐富,一定程度上影響了所構建模型的檢測精度。②不同類型魚的視覺辨識難度各不相同,導致檢測難度不一。水下低質量視頻中魚的檢測主要依賴對魚顏色和形態輪廓等的刻畫,在訓練數據相對充足的情況下,部分顏色和形態易于辨識,區分度較大的魚可以被高精度的檢測,宅泥魚和月斑蝴蝶魚均屬于此類。但是,當訓練數據較少,且魚的區分性特征在低質量視頻中不突出,易與其他目標混淆時,如褐斑刺尾鯛,檢測精度則受到嚴重影響。以上實驗表明,水下監控視頻中珊瑚礁魚的高精度檢測仍然是一個極具挑戰的技術難點。

圖4 各種檢測模型在不同珊瑚礁魚類別上的檢測結果Fig.4 Detection results of different coral reef fish species by various detection models

4 結束語

認識到從充滿挑戰的水下監控視頻中檢測珊瑚礁魚的重要價值,本文提出了一種時空特征聚合的水下珊瑚礁魚檢測方法。該方法從時間和空間2個維度出發,分別設計了一個視覺特征聚合模塊以融合多層不同分辨率的卷積特征圖,以及一個時序特征聚合模塊以實現幀差引導的相鄰幀卷積特征圖融合。SeaCLEF數據集上的實驗基本驗證了以上2個特征聚合模塊的有效性。本文基于以上聚合模塊提出的檢測模型相比于多個典型方法和模型,可以取得更好的檢測精度。

檢測性能的提升主要歸功于提取了更具表征力的時空聯合特征。除了特征,數據和模型也是影響檢測精度的關鍵因素。在下一步工作中,一方面將探索如何利用互聯網上公開的珊瑚礁魚視頻圖像,進一步提升低質量水下視頻中珊瑚礁魚的檢測精度。另一方面,還將關注如何利用生成對抗網絡等技術,生成更多高質量和多樣化的珊瑚礁魚訓練樣本,從而構建更加魯棒有效的珊瑚礁魚檢測模型。此外,還計劃在開源深度學習平臺飛槳上復現該方法。