融合詞性和注意力機制的輿情本體非分類關系抽取研究

張 敏,劉勝全,劉 艷,魏浩皓

(1.新疆大學信息科學與工程學院,新疆 烏魯木齊 830046;2.新疆大學軟件學院,新疆 烏魯木齊 830091)

0 引言

大數據時代的來臨,社會輿情信息也凸顯出海量、瞬刻、全息、價值低密、虛實莫辨的大數據特征,當前數據來源越來越復雜,同時不同的數據處理和存儲方式使得這些海量信息在不同層次上產生了異構.對于一些社會熱點事件,往往會激發網民的集體參與感,并通過新聞、微博、微信、論壇等不同類型的網絡平臺來表達對相關社會事件的群體性情緒、意愿、態度和意見.因此,這些多源異構表達自由的輿情信息在網民間快速地相互傳播和影響,這促使政府對輿情的監控以及引導變得極其重要,同時也促進了輿情本體構建相關技術的發展.

關系抽取作為信息提取和自然語言處理的核心任務,其目標是預測句子中概念間的關系.非分類關系又稱為非層級關系,反映了概念間的某些語義關系,其類型多種多樣,同時也是自然語言處理領域一項重要的語義處理任務.概念間非分類關系的抽取對本體的構建和語義的理解起著重要作用,概念間非分類關系的準確抽取有助于本體的構建,同時推動知識圖譜的發展.

目前的信息抽取主要集中在概念抽取、關系抽取、事件抽取等任務上,非分類關系抽取研究主要是解決文本中概念間關系的非分類問題,雖然非分類關系作為分類關系的補充,但因其種類繁多,狀態空間巨大,因此這也為非分類關系抽取任務帶來了一定的難度.盡管已經有相關研究工作來提取非分類關系,這些方法忽略了句法和語義信息,使得提取的非分類關系準確率不高.

輿情本體中非分類關系的獲取一直是本體構建的難點,在一個句子中,包含的相關動詞是最能表達句子狀態的詞匯,適當的動詞可以很好地表示概念對之間的非分類關系.對于非分類關系,本文主要關注基于動詞的非分類關系,因此提出結合詞性信息和注意力機制的雙向長短時記憶網絡,來解決輿情本體概念間非分類關系抽取問題,將富含上下文語義信息的詞向量作為神經網絡的輸入,對句子進行編碼,為了消除噪音數據帶來的影響,在特征向量上構建基于詞級別和基于句子級別的注意力機制,對重要特征賦予較高權重[1],通過詞匯和句子信息相結合以標記非分類關系,最終完成輿情本體概念間的非分類關系抽取.

關系抽取作為自然語言處理重要的子任務而受到廣泛關注.何宇等[2]引入句法分析模型獲取句法特征,使用支持向量機(SVM)在某專利公司的中文新能源汽車領域語料上抽取關系實例;董麗麗等[3]使用改進的候選關系標簽標志方法VF*ICF選擇具有領域的相關動詞,最后使用對數似然比評估抽取的非分類關系.傳統方法手工依賴性較高,導致額外的傳播錯誤且增加計算成本.而隨著深度學習[4]的提出,關系抽取的研究有了進一步的進展.

近年來,深度學習發展迅猛,在國內外都引起了廣泛的關注.因此,眾多學者嘗試將深度學習應用于自然語言處理任務中.如:循環神經網絡(RNN)、卷積神經網絡(CNN)、基于圖神經網絡等[5-7];引入注意力機制和基于張量的遞歸神經網絡模型[8]、對抗訓練的正則化方法[9]、卷積GRU模型[10];基于單詞注意和以實體為中心的遠程監督模型等[11-12].基于深度學習的方法在自然語言處理任務中都取得了比以往研究更好的實驗效果,這些可自動的學習簡單的特征,能夠發現更多隱含的信息,但仍存在不足.

目前的研究是在結構簡單的英文文本上進行關系抽取,對于輿情文本的關系抽取針對性不強.張曉斌等[13]提出基于CNN和雙向LSTM融合的實體關系抽取方法,充分考慮長距離詞之間的依賴性,保留了詞序等特征;蘇錦鈿等[14]將詞性和自注意力機制相結合,提出面向句子情感分類方法;高成亮等[15]使用結合詞性信息的基于注意力機制的雙向LSTM模型解決文本分類任務.CNN考慮了連續詞之間的相關性而忽略了非連續詞之間的相關性,LSTM雖然考慮了長距離詞的相關性,但提取特征不夠充分,同時核心詞表現弱,對于輿情信息而言,語料中包含大量語義信息,不同詞語對于整個句子的語義信息影響大小不同,對所有詞一視同仁,影響關系預測的結果.

現階段對輿情信息關系抽取的研究不夠深入,尤其是對非分類關系的研究更是不足.詞性通常作為一種輔助特征,用于特征選擇,而在以往的關系方法中,忽略了詞性之間的依賴關系.因此,針對目前大多數非分類關系抽取方法忽略詞性和部分局部特征的問題,本文提出結合詞性信息和注意力機制的BiLSTM模型(簡稱本文模型).通過結合詞性信息和詞注意力機制關注句子中相關動詞的語義特征,能夠從語法的角度進一步豐富句子中詞的信息,同時引入句子層注意力機制,計算包含相同概念的句子和預測關系的相關性,結合BiLSTM模型充分利用整個句子的序列信息,提取句子中2個概念之間的動詞作為非分類關系標簽,完成輿情本體概念間非分類關系的抽取.

1 非分類關系抽取問題描述

本文研究概念對抽取合適的動詞表示非分類關系,非分類關系的抽取分為2個步驟,即非分類關系的識別和非分類關系的抽取.非分類關系的識別是指識別出有關系的概念對;非分類關系的標注是指為識別出的有關系概念對抽取合適的動詞,其中動詞作為非分類關系類型名稱,對于輿情信息進行非分類關系的識別和非分類關系的標注,在一定程度上忽視了句法信息和語義信息,導致在非分類關系的識別階段容易抽取出沒有關系的概念對,在非分類關系的標注階段,容易造成概念對標注的動詞不合理.

問題的輸入是網絡輿情文本信息,已經過預處理得到了包含概念及非分類關系標簽的句子,輸出是非分類關系的語義表示.

定義語義關系,語義關系可以用一個三元組(ei,rij,ej)來描述,其中ei,ej表示句子中包含的概念對,rij∈y表示關系的語義標簽,y是所有標簽的集合.

輿情信息中包含的非分類關系可能是無向的,例如從文本信息中發現A和B的朋友關系,在另一些文本中概念對之間的關系是有向的,例如,2018年8月1號,長征四號乙運載火箭在太原發射中心發射成功,其中,太原發射中心與運載火箭是“施力者-受力者”關系.因此,隨著網絡信息的發展,非分類關系可能是主動的(如訪問關系)或是被動的(被訪問關系).這里主要考慮主動的非分類關系.

例如非分類關系類型預測的例子.1879年愛迪生在實驗室創造了第一批白熾燈.

主動的關系表示:(愛迪生,創造,白熾燈).

被動的關系表示:(白熾燈,被創造,愛迪生).

針對問題輸入的文本信息,目標是預測出這個句子包含的非分類關系類型,最終通過最大概率分類器預測最大非分類關系類型的置信度.

2 非分類關系抽取模型

2.1 非分類關系抽取

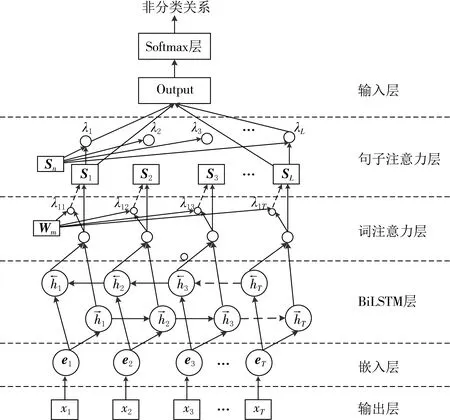

本文將輿情本體概念間非分類關系抽取問題轉化為根據輿情信息定義概念間非分類關系,在已知概念對的情況下,輿情語料中的概念間非分類關系抽取模型如圖1所示.

圖1 結合注意力機制的BiLSTM非分類關系抽取模型

為使模型更好地描述輿情文本的內部結構信息,通過詞嵌入技術(Word2vec)將手工標注得到的輿情文本輸入到模型中.將句子中每個詞語和詞性標簽映射到向量空間中,用以生成能夠表示詞語語義和詞性含義的向量表示,并采用BiLSTM網絡對詞向量進行編碼獲取句子的高維語義信息.通過計算上下文詞語與概念對的相關性,建立詞注意力機制來充分捕捉句子上下文關鍵詞語的語義信息.并結合詞性信息獲取關鍵詞的重要特征,同時通過計算句子與關系的相關程度來建立句子層注意力機制,減少錯誤標簽帶來的噪音問題.對提取的語義信息進行加權求和以及非線性映射和歸一化處理,實現信息流的整合,提高輿情本體非分類關系抽取的效率,并用Softmax實現非分類關系抽取任務.用H代表模型的隱含層,且由BiLSTM構成;w和s分別表示輿情文本中的詞組和簡短句子.

本文結合注意力機制BiLSTM模型,完成輿情本體概念間非分類關系的抽取,利用注意力機制為不同特征分配注意力權重,最后通過分類器獲取非分類關系抽取結果.其中進行輿情本體概念間非分類抽取的結合注意力機制的BiLSTM網絡結構如圖2所示.

該結構包含5個部分:(1)輸入層將句子輸入到該模型中;(2)嵌入層將每一個詞映射成低維向量;(3) LSTM層利用雙向的長短時記憶網絡獲取句子的高級特征;(4)注意力層產生權重向量,關注句子中相關動詞的語義特征,將由LSTM得到的詞級特征合并到句子級特征向量;(5)輸出層經過注意力機制得到的特征向量將用于非分類關系抽取,從而得到最終的非分類關系結果.

圖2 非分類關系結合注意力機制的BiLSTM網絡結構

2.2 向量表示層

給定T個字組成的句子S={x1,x2,…,xT},使用word2vec將每一個字xi轉換為實數向量ei.首先,對于句子S中的每一個字,將其轉換成嵌入矩陣Wword∈Rdw|V|,其中:V是固定大小的詞匯表;dw是字嵌入的大小,是用戶要選擇的超參數;矩陣Wword是要學習的參數,然后,通過使用矩陣向量將字xi轉換為字嵌入向量ei,公式為

ei=Wwordvi.

(1)

其中vi是一個大小為|V|的向量,其值在ei的位置為1,其他位置均為0.然后,將該句子作為實值向量embs={e1,e2,…,eT}送入下一層.

2.3 編碼層

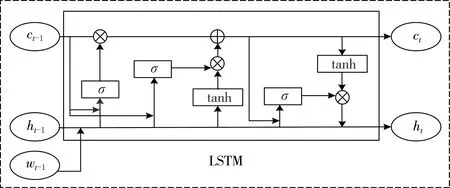

長短時記憶網絡(LSTM)是一種特殊的循環神經網絡,由S.Hochreiter等[16]于1997年提出,主要用于解決梯度消失問題以及針對一般的循環神經網絡存在的長期依賴問題而專門設計出來的(如圖3 所示).LSTM神經網絡模型包含3個門:輸入門it,遺忘門ft以及輸出門ot.

圖3 LSTM網絡結構

公式為:

ft=σ(Wxfxt+Whfht-1+Wcfct-1+bf);

(2)

it=σ(Wxixt+Whiht-1+Wcict-1+bi);

(3)

(4)

(5)

ot=σ(Wxoxt+Whoht-1+Wcoct-1+bo).

(6)

最終該單元的輸出,計算公式為

ht=ot*tanh(ct).

(7)

式中:Wx(f,i,c,o)∈Rd×d,Wh(f,i,c,o)∈Rd×d,Wc(f,i,c,o)∈Rd×d表示LSTM的權重矩陣;b(f,i,c,o)表示偏置項;ct和ht分別表示在t時刻的LSTM的記憶表示和隱含層狀態表示.因此,當前狀態單元ct通過加權和生成,它使用以前的狀態單元,也使用當前時刻單元產生的信息.

循環神經網絡[17]在序列學習問題中獲得廣泛應用,并且成果顯著.然而由于常見的梯度消失和梯度爆炸問題,循環神經網絡通常難以訓練.對于一個輸入序列,在一個時間節點t,LSTM網絡只包含t以前的信息,卻不包含t以后的,但訪問過去和未來的上下文信息都是有益的,因此,本文使用雙向LSTM網絡,其思想是提出一個訓練序列向前和向后2個循環網絡,其具有相同的結構但權重參數不同,將2個序列相加得到最終通過雙向LSTM網絡的最后結果.

本文為了學習文本中包含的詞語之間、詞性之間的依賴特征,通過結合注意力機制的雙向LSTM的文本表示模型處理文本數據(如圖1所示).該網絡包含向前和向后上下文的2個子網絡,同時向前和向后隱含層之間沒有信息流,這使得網絡展開圖是非循環的.第ith個字的輸出表示為

(8)

2.4 注意力層

注意力模型最近幾年在深度學習各個領域被廣泛使用,并取得了不錯的進展.因此,本文使用注意力機制[18],給不同的特征賦予不同的權重,學習不同局部特征的重要性,摒棄一些噪音數據,以此來提高非分類關系抽取結果的高效性和準確性.

2.4.1 詞注意力機制

在非分類關系抽取任務中,對于語義信息并不是所有詞語都有相同的重要性,不同的概念對上下文詞語的重要程度也是不同.尤其是概念對之間的動詞至關重要,因此,使用詞語層注意力機制來充分捕捉重要的語義信息.

設由BiLSTM層產生的輸出向量組成的矩陣H=[h1,h2,…,hT]和概念表示〈he1,he2〉,其中T是句子長度,通過一個待訓練的權重參數w生成對每一個hi的注意力權重.用句子r表示由輸出向量的加權和構成,計算公式為

(9)

μi=tanh(Wwt+Wwthe1+Wwthe2+bwt).

(10)

其中:Wwt為詞語相關性權重矩陣,bwt為偏置.通過Softmax函數將計算的評分結果μ1,μ2,…,μT進行歸一化,從而得到權重值αi,計算公式為

(11)

最后,采用最大池化策略,得到句子的顯著特征.其句子表示為

S=maxpool(r).

(12)

2.4.2 句子注意力機制

為了減少錯誤標注帶來的噪音問題,采用句子層注意力機制的多實例學習[19],計算包含相同概念的所有句子和預測關系的相關性,與關系向量相關性高的句子賦予更高的權重,從而降低噪音句子對關系預測的影響.

設S={s1,s2,…,sk}是包含相同概念k個句子組成的句子集,為了表示所有句子與預測關系的相關程度,將句子向量表示為S中所有句子向量的加權和,公式表示為

(13)

βi=Softmax(siAer).

(14)

其中A是隨機初始化加權對角矩陣,er為關系r的向量表示.

2.5 解碼層

結合詞性信息和注意力機制的BiLSTM模型用于動態捕獲與非分類關系抽取任務相關句子信息,并生成上下文表示,將詞性向量和其他特征結合,充分利用整個句子的序列信息,獲取輿情文本的語義特征,完成輿情本體概念間非分類關系的抽取.

(15)

(16)

(17)

其中:ti∈Rm為使用one-hot表示的真實值;yi∈Rm為使用Softmax函數估計每個關系類別的概率;m為關系類別的數量;λ為L2正則化超參數,同時,將L2正則化和dropout相結合來緩解隱藏單元過擬合問題.

3 實驗結果與分析

3.1 實驗數據

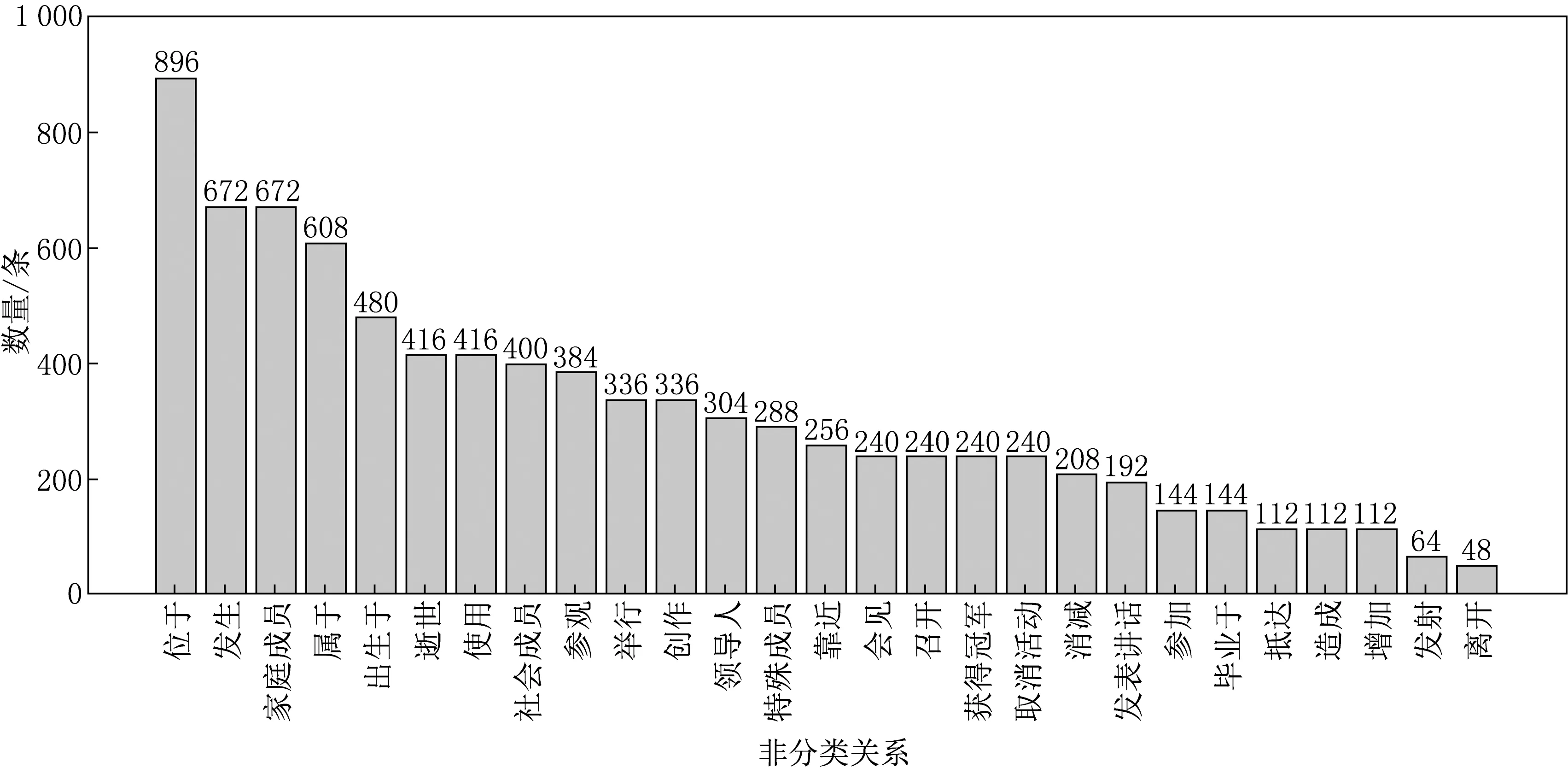

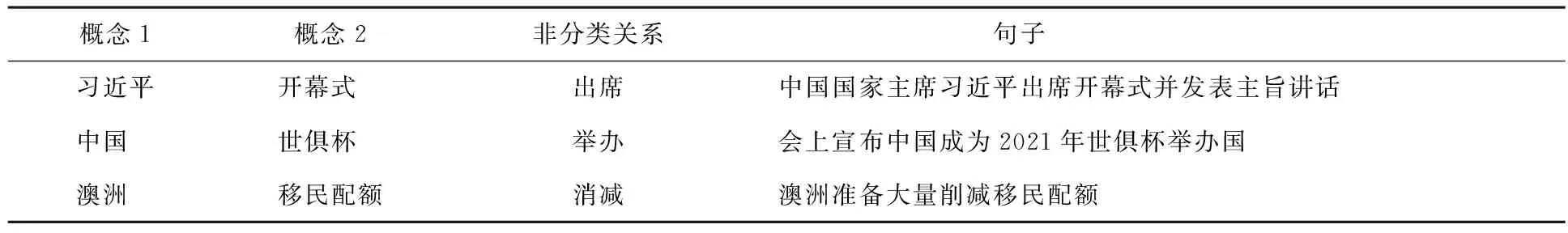

實驗中選取百度、新浪等中文網頁信息作為語料來源.利用網絡爬蟲技術下載輿情文本,對其進行去重、去噪等一系列處理,篩選出包含實體和關系的新聞報道文本,作為實驗語料.該實驗共生成了11 227條樣本數據,其中8 560條用作訓練集,共包含27種非分類關系,如圖4所示,2 667條用作測試集,每條語句中的概念和概念間的非分類關系均已標記,數據結構如表1所示.

圖4 非分類關系類別及數量

表1 數據集樣本示例

3.2 實驗超參數設置

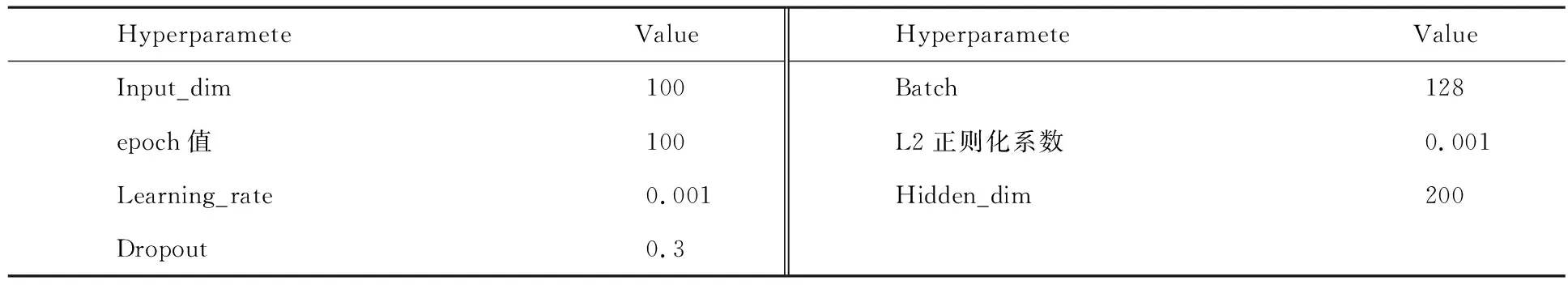

不合理的超參數設置會影響輿情本體概念間非分類關系抽取的結果.超參數設置如表2所示.

表2 超參數設置

2012年,G.E.Hinton[20]提出了Dropout策略.在深度學習的模型中,如果模型的參數太多,而訓練樣本又太少,訓練出來的模型很容易產生過擬合的現象.為了防止過擬合,在正向傳播過程中,Dropout策略通過從網絡中隨機省略特征檢測器的共同作用阻止隱藏單元的自適應性,來提高神經網絡的性能.

因此,在該網絡結構中,Dropout策略主要用于嵌入層、LSTM編碼層,在保持輸入輸出神經元不變的情況下,隨機丟棄隱含層部分神經元.同時在梯度下降后,使用L2正則化進一步減小過擬合問題.模型使用sigmoid作為激活函數,隱含層節點數取200,采用Softmax作為分類器.為防止模型計算過程中出現過擬合現象,利用L2正則化方法對網絡參數進行約束,系數取0.001,訓練過程中引入Dropout策略,丟碼率取0.3,數據批處理量取128,訓練輪數取100.

3.3 實驗評價標準

本文采用準確率(P)、召回率(R)及衡量模型整體性能(F1值)[21]等3種重要指標評測非分類關系實驗結果,P反應模型的準確程度,R反應模型的完備性,F1值是P和R的調和平均.

3.4 實驗分析

3.4.1 對特征的有效性驗證

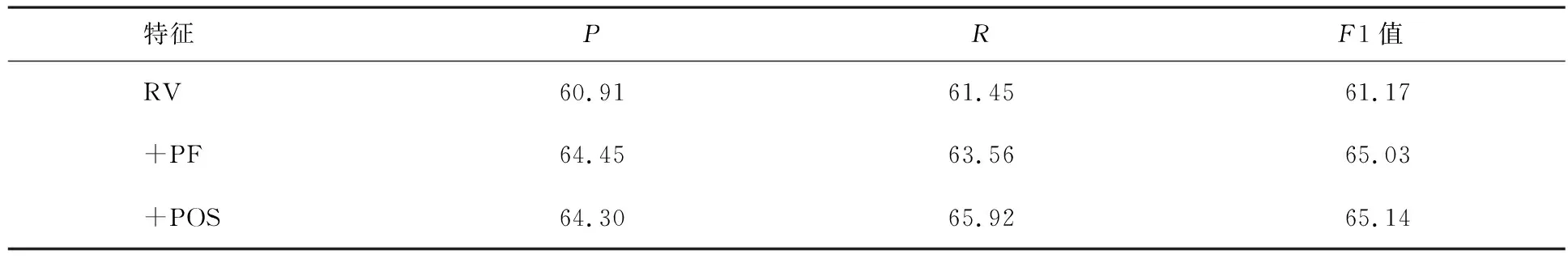

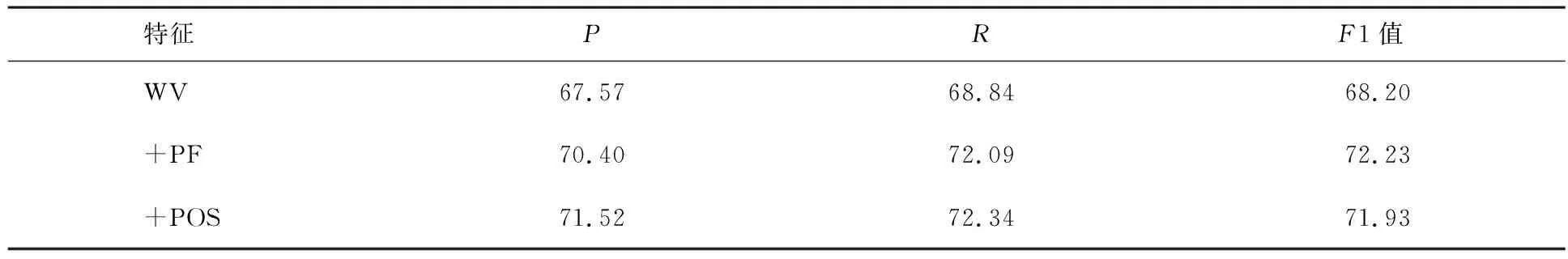

實驗中使用多個特征進行特征表示,如PF(位置特征)、POS(詞性特征),為了研究每個特征對本文模型的貢獻,依次加入不同的特征對模型的性能進行比較,結果如表3和4所示.

表3 以詞向量RV作為比較基線添加其他特征對于訓練模型的影響效果 %

表4 以詞向量WV作為比較基線添加其他特征對于訓練模型的影響效果 %

表3以通用詞向量(RV)作為比較的基線(RV:百度百科通用領域300維詞向量).依次添加其他特征.其中位置特征使F1值提高了3.86%.詞性包含了潛在的語義信息,使F1值提高了3.97%.相比于位置特征,實驗結果表明影響不明顯,但也有所提高.

表4使用詞訓練模型預先訓練好的輿情信息詞向量(WV)以代替隨機向量.相較于使用通用詞向量,F1值提高了7.03%.加入特征實驗F1值均有所提高.實驗結果同樣驗證了多個特征對于捕獲句子中的詞與目標實體的關系信息起著重要作用.

3.4.2 與同類實驗對比

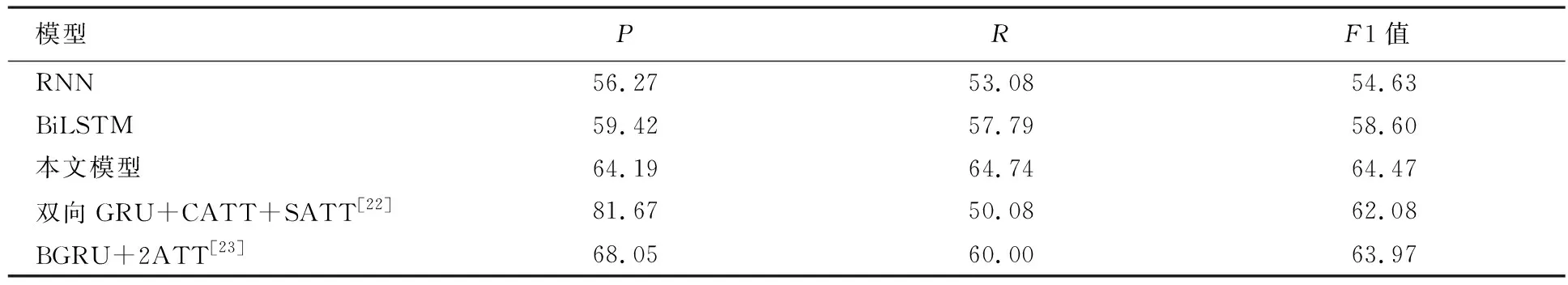

為了驗證結合注意力機制的BiLSTM神經網絡模型在輿情本體概念間非分類關系抽取的效果,使用3.1節的實驗數據和3.2節的參數進行實驗,各模型在測試集上的P,R和F1值如表5所示.

表5 模型性能對比 %

由表5可以得出以下結論:

(1) BiLSTM與RNN對比.使用詞向量和詞性向量作為非分類關系特征的輸入,BiLSTM神經網絡模型的效果優于循環神經網絡模型.RNN能夠處理短距離依賴,對于長距離依賴存在局限性,同時當序列較長時,RNN易產生梯度消失問題.與RNN相比,BiLSTM模型P,R以及F1值分別提高了3.15%,4.71%,3.97%.說明BiLSTM有了記憶模塊,緩解了長距離依賴問題,能夠充分利用整個句子的序列信息,獲取更多的上下文語義知識,使提取到的文本特征更有效,從而使得BiLSTM模型的實驗結果均高于RNN神經網絡模型.

(2) 本文模型和BiLSTM對比.使用詞向量和詞性向量作為非分類關系特征的輸入,本文模型的效果優于BiLSTM神經網絡模型.與BiLSTM相比,P,R以及F1值分別提高了4.77%,6.95%,5.875%.本文模型結合了詞性信息和詞、句子注意力機制的優點,利用詞注意力機制捕獲訓練句子中關鍵動詞的語義信息,通過句子注意力利用包含相同概念句子間的相關性,減少錯誤標注帶來的噪音問題.由此說明,本文模型選擇性地關注句子中重要信息,提高了非分類關系抽取的準確率.從而證實了該方法的有效性.

(3) 基于雙向GRU+CATT+SATT模型[22].該模型采納了只使用字向量作為文本的輸入特征,用雙向GRU進行訓練,并加入基于字級別和基于句子級別的注意力機制,完成中文文本中人物關系的抽取任務.

(4) BGRU+2ATT模型[23].模型采納了使用字向量作為文本的輸入特征,用雙向GRU進行訓練,在字符級和實例級兩個層面中引入了注意力機制,完成中文文本中人物關系的抽取任務.

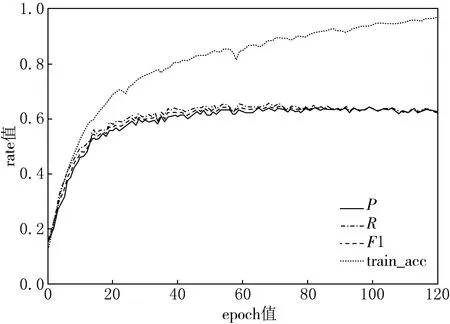

本文模型的P,R和F1隨迭代次數變化曲線 見圖5.由圖5可知,每訓練一定次數,在測試集上驗證數據,并統計P,R和F1值在訓練過程中的變化.當epoch值在0~30之間,P,R和F1以及train_acc值上升速率特別快,由于在訓練數據上隨著訓練次數的增加,模型初始權重不斷更新,訓練集上的準確率不斷增加,模型學習到的知識越多,使得模型在測試集上的準確率不斷提高.當epoch值為100時,結合注意力機制的BiLSTM神經網絡模型的train_acc值收斂趨于穩定,訓練數據進行訓練的準確率達到穩定,同時測試數據的P,R和F1的值收斂趨于穩定,達到了測試過程中的最優結果.由圖5可知,雖然P,R和F1值有一定的波動,但波動不大,最后均收斂趨于穩定.

本文模型的P,R和F1隨訓練準確率變化曲線見圖6.從圖6中可以看出,開始階段train_acc值很低,說明模型學習到的知識少,使得測試集的結果P,R和F1值很低.隨著模型不斷優化,訓練準確率的提高,測試集P和R也逐漸增加,最后收斂趨于穩定,當訓練P達到92.24%時,測試集的P和R取得最優,分別為 64.19% 和64.74%.

圖5 P,R和F1隨迭代次數變化曲線

4 結束語

輿情本體概念間非分類關系的抽取研究有助于推動依賴于本體相關技術的發展,現有的研究多在英文等公開的語料集上進行關系抽取,對于輿情本體的非分類關系研究較少,且現有的輿情語料數據集更少.本文提出結合詞性信息和注意力機制的雙向長短時記憶網絡來抽取輿情本體概念間的非分類關系,通過注意力機制動態地學習不同隱式特征信息在文本分類任務中的貢獻程度,分類函數預測非分類關系類別標簽.

通過與傳統RNN模型、BiLSTM模型進行對比實驗,說明本文模型緩解了長距離依賴問題,同時充分利用詞和句子注意力機制的優點,結合詞性信息和詞注意力機制捕獲訓練句子中關鍵詞語的語義信息,增強包含相同概念句子間的相關性,減少錯誤標注帶來的噪聲問題,進而提取了更有效的文本特征,提高了非分類關系抽取的準確性.雖然實驗效果有進一步的提高,但仍然存在不足之處.手工標注的數據集太少且存在標注錯誤,同時一個包含多個逗號的長句子,存在多種非分類關系如何正確界定問題.接下來將在增加語料的同時可以引入強化學習方法,對模型做進一步的優化,來提高非分類關系抽取的準確性,同時如何將具有相同含義的動詞聚類形成一種新的非分類關系類型也是下一步的研究任務.