基于面部特征分析的疲勞駕駛檢測方法

胡習之, 黃冰瑜

(華南理工大學機械與汽車工程學院, 廣州 510641)

疲勞駕駛是交通事故的主要誘因之一,美國國家高速交通安全管理局統計表明,17%~21%的交通事故與駕駛人員的精神狀態有關[1]。疲勞駕駛問題的根本誘因為駕駛員安全意識薄弱、休息時間不規律、連續高強度集中作業等,僅在規章制度上約束難以根絕此類事故。因此,除了加強駕駛作業管理、合理安排長途運輸,提升相關智能駕駛輔助預警系統的性能是一項重要途徑。針對疲勞駕駛檢測的相關研究中,主要有主觀檢測和客觀檢測兩種辦法。客觀檢測指對駕駛員行駛過程中的生理和心理相關特異性指標進行檢測,如行車數據、生理狀態、視覺特征。行車數據極易受駕駛員個人行為習慣、技術水平、車型及道路狀況影響[2-3],主要作為判定輔助。基于生理信號的疲勞檢測技術通過穿戴設備采集駕駛員的腦電、心電等生理信號,進行清醒及疲勞特征差異分析[4]。生理信號采集需要駕駛員穿戴設備,屬于侵入性檢測,成本也相對高,不利于實際應用推廣。基于視覺特征的疲勞駕駛檢測方法依據視頻采集設備獲得駕駛員實時駕駛圖像,對圖像進行后期處理,可獲得駕駛員面部、頭部、手部等的特征參數,判斷疲勞狀態[5-6]。與前兩種技術手段相比,該方法對硬件設備要求低、可移植性強,算法優化空間大,是疲勞檢測領域的主流檢測方法。

常用的面部疲勞特征檢測方法可分為基于機器學習的檢測算法和基于深度學習的檢測算法。基于機器學習的算法采用滑動窗口的檢測策略,利用灰度積分法、哈爾特征等提取視覺特征,通過支持向量機(support vector machine,SVM)、自適應增強算法(adaptive boosting,AdaBoost)等分類器識別眼睛閉合度、哈欠動作等疲勞特征[7]。該方法原理簡單直觀,易于設計及優化,但人工設計特征的魯棒性不足,檢測精度易受光線變化、遮擋缺失等環境因素影響。基于深度學習的檢測算法利用卷積神經網絡提取隱式特征,對疲勞動作的判別精度大大提高,但復雜的模型結構影響檢測速度,在實時檢測中的應用受到阻礙。

針對實時疲勞駕駛檢測的特點,結合深度學習模型及機器學習模型設計一套基于面部特征分析的駕駛員疲勞檢測系統。在人臉檢測環節,對SSD(single shot multi box detector)目標檢測模型進行優化,后續使用目標跟蹤算法進行駕駛員人臉區域定位,以平衡人臉定位的精度及效率。在人臉定位的基礎上,使用級聯回歸樹模型提取面部特征點,以特征點相對位置的變化作為疲勞檢測依據。計算并使用眼部閉合百分比、最大閉眼時長、眨眼頻率及哈欠次數作為疲勞特征參數,建立多指標融合模型以提高系統準確率及魯棒性。

1 基于改進SSD的人臉檢測算法

1.1 SSD模型結構

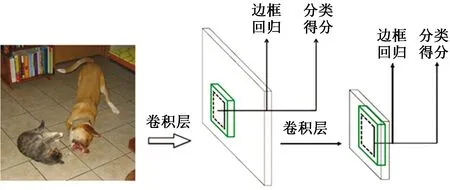

SSD是一種端對端的基于回歸的One-stage目標檢測算法[8],具有檢測速度快、檢測精度高的優點。SSD可針對不同尺度的目標,使用卷積神經網絡直接預測物體位置、判定所屬類別、計算置信度。最后利用非極大值抑制(non maximum suppression,NMS)算法綜合多層特征圖的信息給出檢測結果。SSD模型基本框架如圖1所示。

圖2 基于ResNet50的SSD網絡結構Fig.2 SSD network structure based on ResNet50

圖1 SSD模型基本框架Fig.1 Basic structure of SSD

1.2 改進SSD模型結構

SSD采用VGG-16(visual geometry group-16)[9]作為基礎模型,該網絡結構簡單,由若干卷積層堆疊成較深的網絡。由于結構限制,若進一步加深網絡將面臨梯度消失問題,因此使用ResNet-50(residual network-50)[10]作為主干網絡。

ResNet-50的特點是引進了殘差模塊,釋放了深層網絡的優化潛力。具體做法為,在部分網絡的輸入輸出之間添加一個恒等映射的快捷連接,即在原輸出上做加和,加和部分為原始輸入。其計算公式為

H(x)=F(x)+x

(1)

式(1)中:x為殘差模塊的輸入;F(x)為殘差;H(x)為經過第一層線性變化并激活后的輸出。

更換主干網絡后的SSD模型結構如圖2所示。

1.3 分類損失函數替換

在目標檢測算法中,不處在Ground Truth和背景過渡區域的先驗框稱為易分樣本,具有較大損失值、對網絡收斂具有重要作用的先驗框稱為難分樣本。為避免大量駕駛室的背景樣本抑制少數難分樣本,引入Focal Loss[11]代替原分類損失函數Softmax Loss。

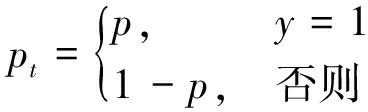

二分類任務的FL(Focal Loss)公式為

FL(pt)=-αt(1-pt)γIn(pt)

(2)

(3)

式(2)中:pt表示模型預測的當前樣本屬于true class的概率;p表示模型預測的當前樣本屬于其中一個類別的概率;y為類別標簽;αt為平衡因子,0<αt<1;γ為權重因子,0<γ<5。

對于二分類任務,αt=0.25,γ=2時有最佳檢測效果。可知,pt越大,(1 -pt)γ權重就越小,從而使模型更關注困難、易錯樣本。

1.4 模型訓練及評估

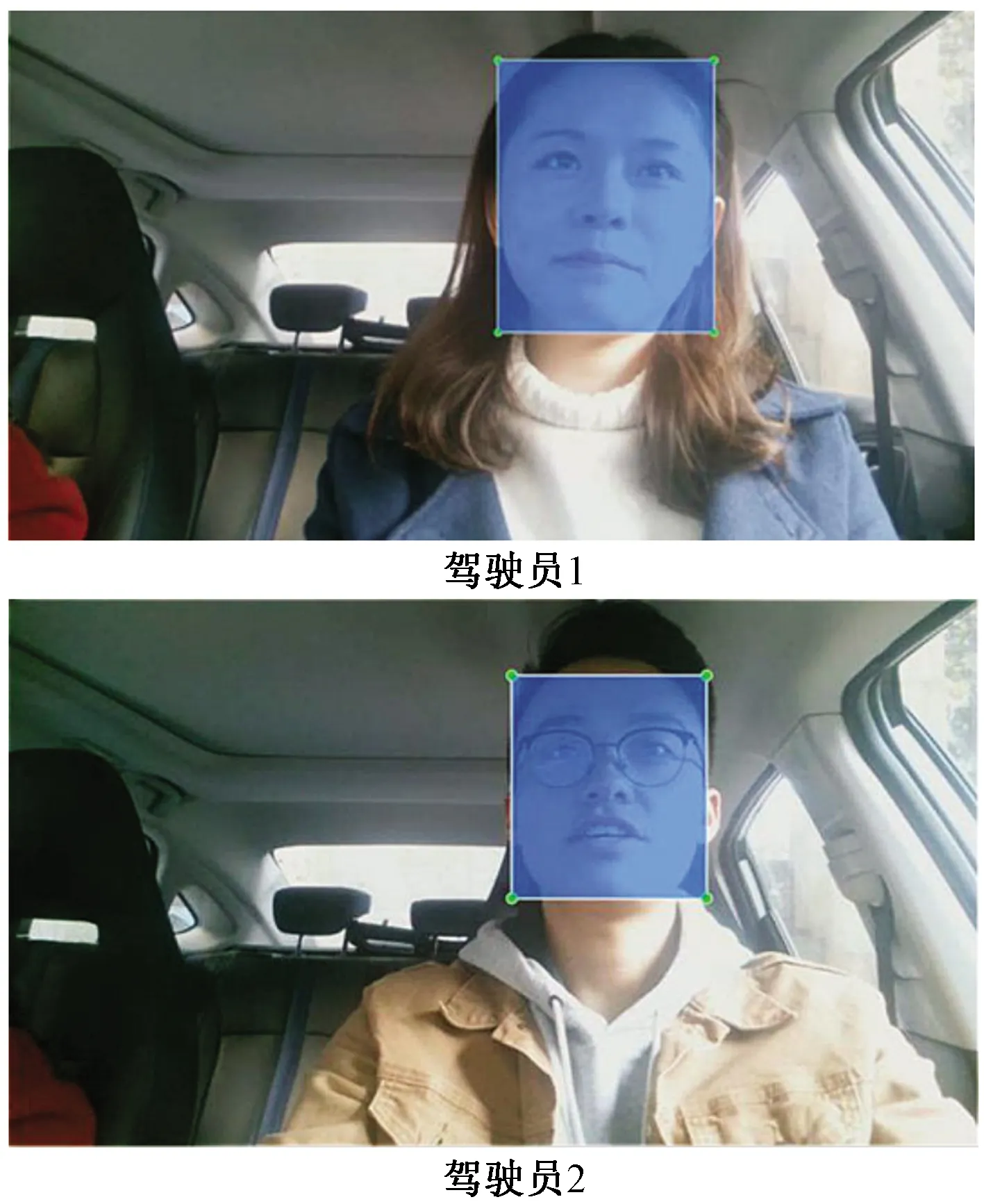

為訓練并驗證模型性能,采集駕駛員人臉圖像以構建實驗樣本集。通過安裝在靜止車輛前方的攝像頭,拍攝駕駛位上的人員的面部視頻。視頻拍攝期間,駕駛員會模擬看左右后視鏡、車內后視鏡、儀表盤等一系列駕駛行為。提取視頻中的圖像并進行手動標注,形成包含5 000張樣本的人臉數據集,標注樣本如圖3所示。

共設置120輪迭代,并采用自適應學習率衰減、數據增強、過擬合早停等技巧。模型訓練環境配置如表1所示。

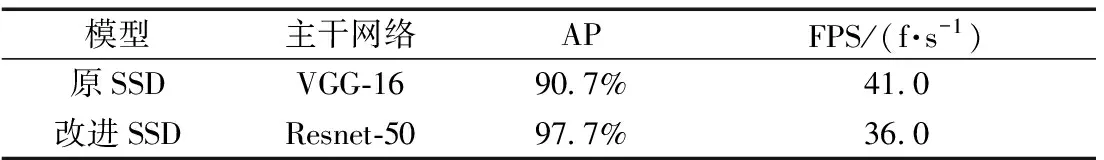

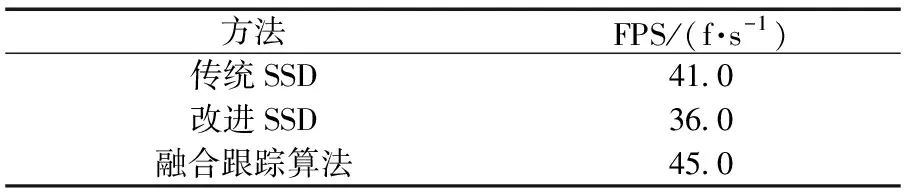

在自建的人臉數據集上驗證改進前后的模型性能。通常用平均正確率(average precision,AP)反映檢測精度,用畫面每秒傳輸幀數(frames per second,FPS)反映圖像處理速度。實驗數據如表2所示。

圖3 標注圖像示例Fig.3 Annotation samples

表1 訓練環境配置

實驗表明,改進SSD算法的檢測精度顯著提升,比原SSD算法提高7.0%的平均正確率。同時,由于卷積層加深,模型檢測速度有一定下降。為提高人臉定位效率,引入CamShift(continuously adaptive MeanShift)跟蹤算法及卡曼濾波機制。

表2 改進前后模型性能

2 基于改進CamShift的跟蹤算法

2.1 改進CamShift的基本原理

將CamShift跟蹤算法[12]與卡爾曼濾波算法[13]相結合,提出一種跟蹤預測算法。

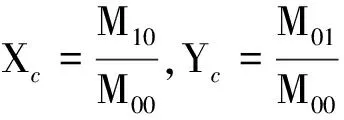

CamShift是由MeanShift算法改進得到的自適應均值漂移算法[10],其原理為使用MeanShift算法在顏色概率密度分布圖進行迭代運算,找出目標在當前幀的位置。設I(x,y)為像素點(x,y)在顏色概率密度分布圖中對應的概率估計值,定義概率密度分布的零階矩M00和一階矩M10、M01分別為

(4)

(5)

(6)

運動目標的質心坐標為

(7)

依據零階矩反映的長寬度調整窗口大小,依據求得的質心坐標調整搜索框的中心到質心位置。

由于CamShift算法對顏色空間敏感度高,易受相近顏色或光線變化干擾,因此增加卡爾曼濾波預測機制。

卡爾曼濾波狀態方程為

Xt=AXt-1+Wt-1

(8)

式(8)中:Xt和Xt-1分別為t時刻和t-1時刻的狀態向量;Wt-1表示過程噪聲。

觀測方程:

Zt=HXt+Vt

(9)

式(9)中:Zt表示t時刻的觀測向量;A為相應的狀態轉移矩陣;H為觀測矩陣;Vt表示測量噪聲。

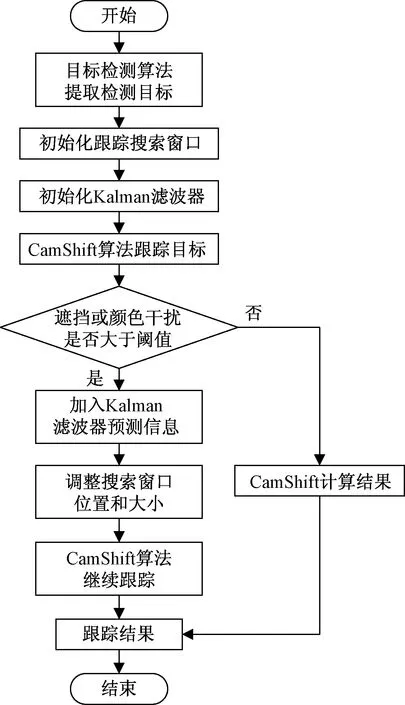

Kalman濾波利用觀測數值對狀態變量的預測估計進行修正,得到狀態值的最優估計。算法融合的具體策略如圖4所示。

圖4 改進CamShift跟蹤預測算法流程圖Fig.4 Flow chart of improved CamShift algorithm

改進CamShift跟蹤預測算法的具體策略為:將初始化人臉區域輸入CamShift進行跟蹤,并實時判斷判斷是否出現顏色干擾或者嚴重遮擋,若有大面積的顏色干擾或遮擋,則用卡爾曼濾波器的預測值作為當前幀的質心位置,并自動更新作為下一幀CamShift跟蹤算法計算的質心位置。

采用巴氏距離來度量跟蹤區域的相似性。巴氏距離計算兩個統計樣本的重疊量,以衡量兩組樣本的相關性[14],其定義為

(10)

式(10)中:pu(f)為測量對象樣本;qu為參考樣本;m為樣本分區數目;u為當前樣本分區;ρ[pu(f),qu]越大,表示所構造模型間相似性越高,取值最大的即為匹配度最高的候選目標模型。

2.2 跟蹤效果實驗

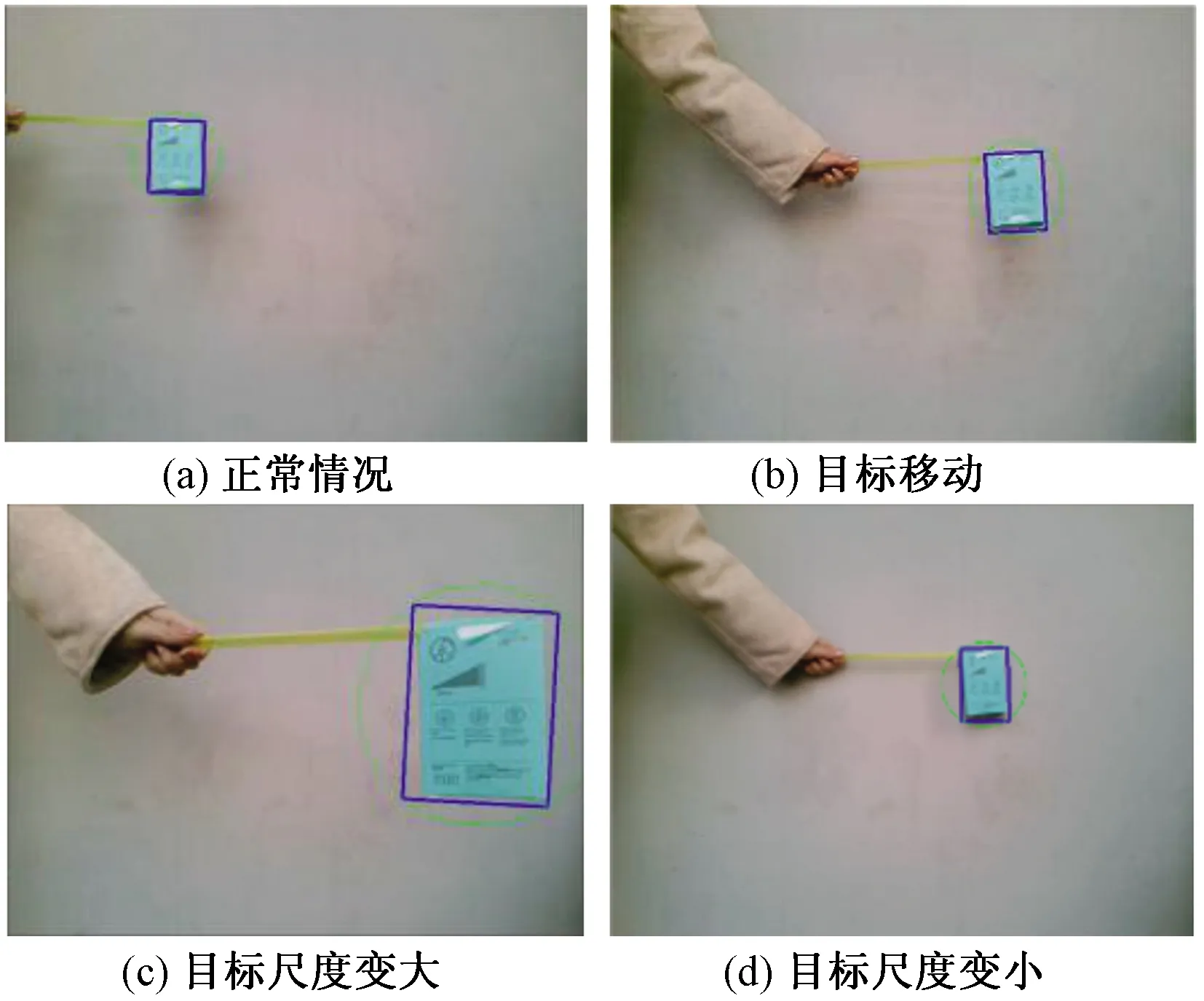

使用改進CamShift算法進行不同情況下的運動目標跟蹤。

2.2.1 一般情況

如圖5所示,藍色框為CamShift算法計算結果,綠色圓圈為卡爾曼濾波器預測結果。運動目標在視頻范圍內移動并發生尺度變化,算法都能很好地完成預期目標物體跟蹤任務。

2.2.2 顏色干擾

顏色干擾實驗過程如圖6所示。顏色干擾靠近目標,算法借助Kalman濾波器預測結果的校正作用,仍能穩定跟蹤目標。當顏色干擾離開目標,搜索框仍保持跟蹤目標不變,并未發生偏離現象。

2.2.3 遮擋干擾

圖5 一般情況跟蹤效果Fig.5 Tracking effects of general condition

遮擋干擾下的實驗結果如圖7所示。遮擋物進入視頻區域后逐漸對目標產生遮擋作用。大范圍遮擋時,仍可勾選畫面中少部分的目標物體。當目標在視頻中消失,搜索框失去跟蹤目標,但當遮擋消失,目標重新出現時,算法重新跟蹤目標。

由實驗可知,增加了卡爾曼濾波機制的改進CamShift跟蹤算法的魯棒性顯著提高,能防止顏色及遮擋干擾帶來的目標誤判或丟失。

2.3 算法融合

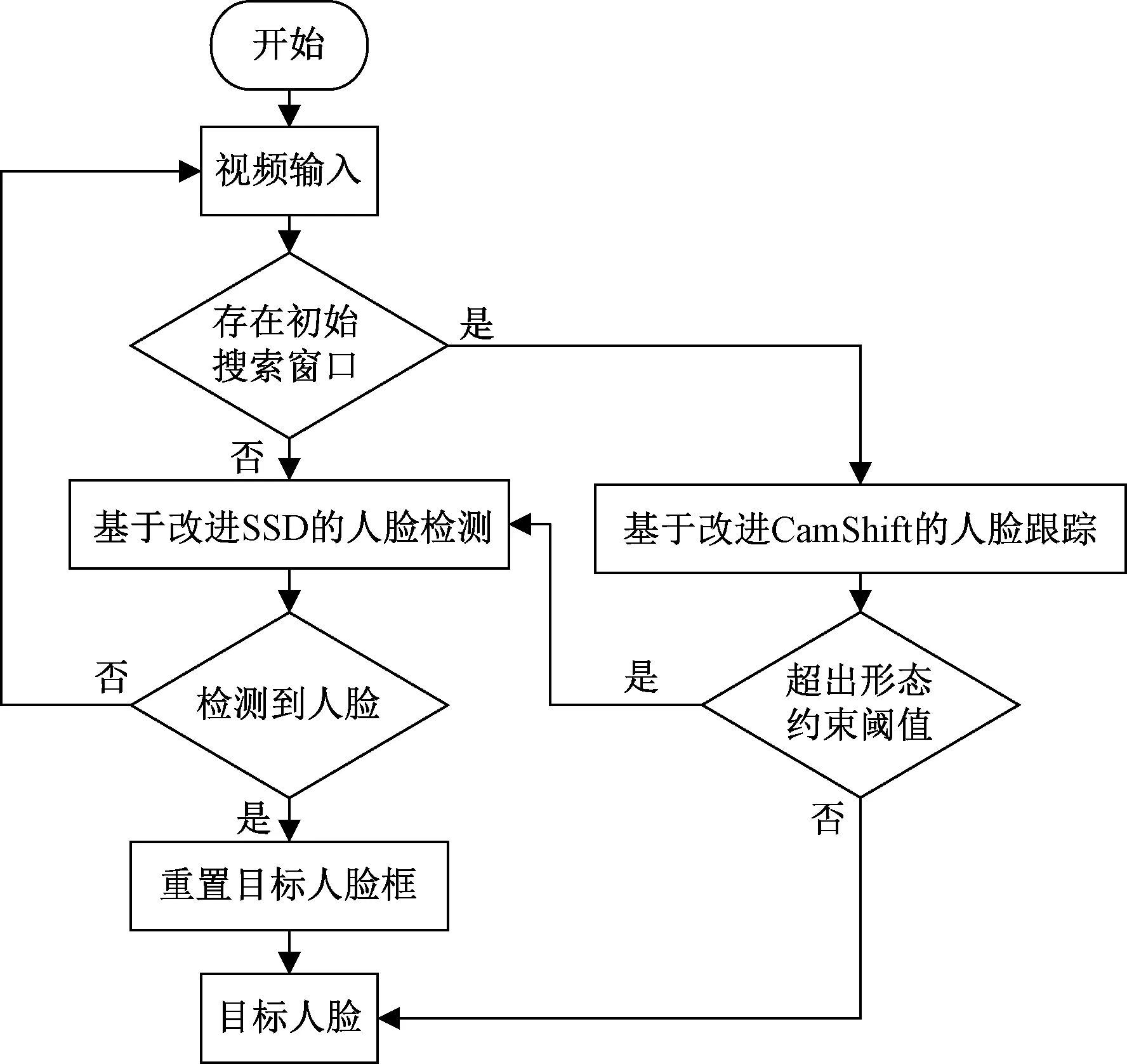

融合基于改進SSD的人臉檢測算法和改進的CamShift算法,使面部區域定位更加準確、高效。融合算法流程如圖8所示,系統包含兩個主要的判定環節。

(1)是否存在初始搜索窗口。當判定不存在初始搜索窗口時,系統啟動人臉檢測算法。判定存在初始搜索窗口時,系統使用跟蹤算法進行預測跟蹤。在進行跟蹤時,判斷人臉區域是否超出形態約束閾值,如果超過,即返回人臉檢測算法,重新檢測人臉;否則,將跟蹤到的人臉作為目標人臉輸入給下一幀圖像,進行后續檢測。

(2)是否檢測到人臉。啟動人臉檢測算法檢測人臉時,如果成功檢測到人臉,即設置檢測結果為目標人臉。否則,代表視頻中不存在有效人臉信息,返回原視頻重新檢測。

圖8 人臉檢測系統流程圖Fig.8 Flow chart of face detection system

表3 算法檢測速度對比

表3為算法檢測速度對比實驗結果。從對比結果(表3)可知,改進SSD算法融合改進CamShift跟蹤預測算法之后,不僅保證了更好地檢測效果的同時,也大幅降低了檢測時間,提高了實時性。

3 駕駛員疲勞特征建模

在基于面部特征的駕駛員疲勞研究中,眼部及嘴部特征具有易提取、變化明顯等優點。因此選取人臉眼睛特征和嘴巴特征,提取相關參數進行駕駛員疲勞狀態的研判。

3.1 實車數據采集

在實際道路駕駛環境下,采集駕駛員在駕駛過程中的面部圖像數據,以分析提取的特征并測試模型的有效性。

共10名具有不同駕駛年齡的駕駛員參與了實際道路試驗,分布不同的年齡段,男性8名,女性2名。在實驗過程中,要求駕駛員盡量減少換道操作,如遇阻擋則以跟車為主,在駕駛過程中盡量避免交談,禁止開車內音樂和廣播。所選取的路線均為一般城市道路,要求駕駛員保持車速在50~80 km/h,一般不超出該范圍行駛。

在獲取視頻樣本后,結合駕駛員事后描述和評價小組的綜合評價結果來標注樣本的疲勞狀態。具體的評判規則實施步驟為:將駕駛員面部視頻進行分割,形成系列時長為30秒的視頻片段(樣本),根據駕駛員面部表情特征對每個樣本中駕駛員的疲勞狀態進行評價。評價時將駕駛員的狀態分為清醒(0分)、疲勞(1分)與嚴重疲勞(2分)三級。樣本情況如表4所示。

表4 實驗樣本集情況

3.2 特征點定位

采取一種基于回歸樹的人臉對齊算法[15],基于特征點定位完成面部疲勞特征的提取。

級聯回歸樹模型的預測原理為

S(k)=S(k-1)+sk(I,S(k))

(11)

式(11)中:S(k)、S(k-1)分別表示當前級及上一級的回歸器預測結果;k表示級聯序號;sk表示當前級的回歸器,回歸器的輸入參數為預測圖像I和上一級回歸器的更新值。

級聯回歸器的預測過程如下:加法模型中的第一棵決策樹利用得到的最優參數,挑選圖像中的隨機像素點對進行閾值對比,判斷分裂方向,將圖像劃分到某個葉結點中,使用葉結點的平均殘差,即位置偏移量更新初始形狀向量,再將結果輸出給下一棵樹。每一級回歸器都經過M′次更新,并輸出位置偏移量。對結果進行級聯回歸更新,得到最終的預測形狀。在實際檢測中,對視頻圖像幀進行灰度化、去噪等預處理,輸入級聯回歸樹模型獲得特征點序列如圖9所示。

圖9 人臉特征點定位Fig.9 Face feature point location

3.3 面部疲勞特征參數

3.3.1 眼睛閉合時間百分比

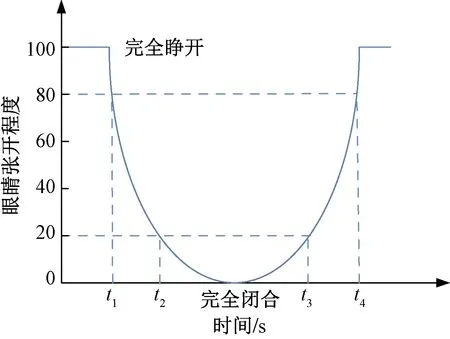

眼睛閉合時間百分比(percentage of eyelid closure,PERCLOS),指在單位時間內眼睛閉合程度超過某一閾值的時間所占百分比[16]。研究采用P80標準,圖10為PERCLOS的基本原理。

圖10 基于PERCLOS P80的測量標準Fig.10 Criterion of PERCLOS P80

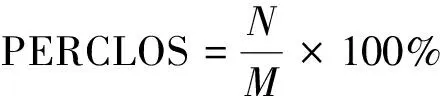

為了提高準確性和簡化計算,使用視頻幀數代替時間,即采用單位時間內閉眼的視頻幀數占視頻總幀數的百分比來代替眼睛閉合時間所占總時長的百分比。

(12)

式(12)中:N表示單位時間內閉眼的視頻幀數;M表示單位時間的視頻總幀數。

3.3.2 閉眼持續時間最大值

閉眼持續時間最大值(maximum duration of eye closure,MDEC)指在特定時間內眼睛閉合狀態持續時間的最大值,其表達式為[17]

MDEC=max{Z1,Z2,…,ZN}

(13)

式(13)中:Z1,Z2, …,ZN表示某時間段內的眼睛閉合持續時間記錄值。

在疲勞狀態下,眼部睜閉時間隨著疲勞程度的加深會大幅延長。因此,可通過統計正常清醒狀態下,駕駛員正常閉眼持續時間最大值作為閾值,當檢測到一段時間內駕駛員閉眼持續時間最大值大于該閾值時可判定為疲勞狀態,否則為清醒狀況。

3.3.3 眨眼頻率

眨眼頻率(blink frequency,BF)是指在1 min內的眨眼次數。通過眼睛的縱橫比(eye aspect radio,EAR)來衡量其張開的程度,并考察其持續的時間,可以對眨眼頻率進行直觀準確的判斷。

眼部特征點如圖11所示。將眼部縱橫比應用在疲勞參數建立中,其計算公式為

(14)

式(14)中:p1、p2、p3、p4、p5、p6為眼部特征點的坐標。

疲勞時人的眨眼頻率會明顯減少,可將清醒狀態下最慢的眨眼頻率統計數據確定為狀態判定的閾值,當檢測出駕駛員眨眼頻率小于該閾值時,認定駕駛員處于疲勞之中,否則,為清醒狀態。

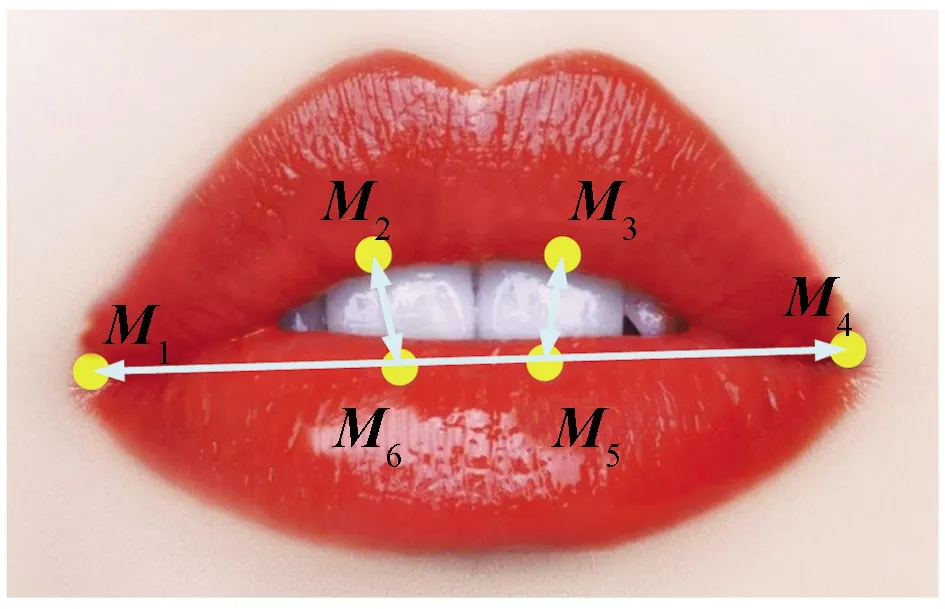

3.3.4 嘴部縱橫比

通過嘴巴的縱橫比來衡量其張開的程度,并考察其持續的時間(一般打哈欠會持續4 s以上)來判斷其是否打哈欠。嘴部特征點如圖12所示。嘴部縱橫比(mouth aspect ratio,MAR)的定義為

圖11 眼部特征點模型Fig.11 Model of eye points

圖12 嘴部特征點模型Fig.12 Model of mouth points

(15)

式(15)中:M1、M2、M3、M4、M5、M6為唇部特征點的坐標。

若MAR超過了正常狀態下的最大閾值,則認為有打哈欠行為。

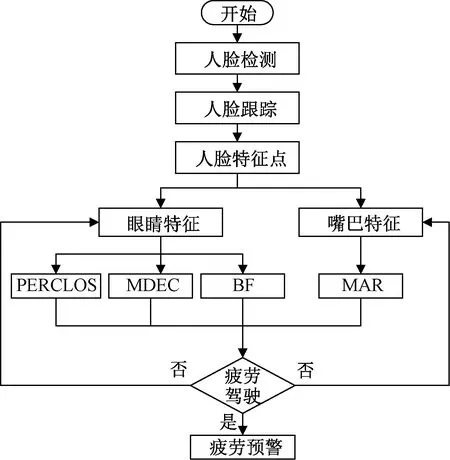

3.4 疲勞判定流程

針對眼睛狀態參數選取PERCLOS參數閾值為0.12,大于此閾值時表明駕駛員出現疲勞;選取MDEC>0.8 s時,表明駕駛員出現疲勞;選取眨眼頻率閾值為15~20次/min,如果未達到該范圍,則認為駕駛員處于疲勞狀態。針對是否打哈欠,選取MAR閾值為0.8,超過即表明駕駛員出現打哈欠。

圖13為疲勞駕駛整體檢測流程。若眼部及嘴部疲勞特征參數不一致,有兩種策略。①當系統檢測到眼睛的參數有兩項或兩項以上超出閾值時,嘴部未出現打哈欠,則以眼睛狀態參數為主要指標,判定為疲勞狀態;②當檢測到嘴部出現打哈欠時,若眼睛狀態參數正常,則以嘴部疲勞狀態為主,判定為疲勞狀態。

由于重度疲勞時駕駛員的面部表情僵滯,頭部姿態變換遲緩,肢體動作緩慢或短時無任何動作,因此,以眼睛狀態參數為主要指標進行判斷。設定有兩項或兩項以上眼部狀態參數超出疲勞狀態閾值的25%時,系統將判定為重度疲勞狀態。

圖13 疲勞駕駛整體檢測流程Fig.13 Flow chart of fatigue driving detection

4 疲勞判定實驗與分析

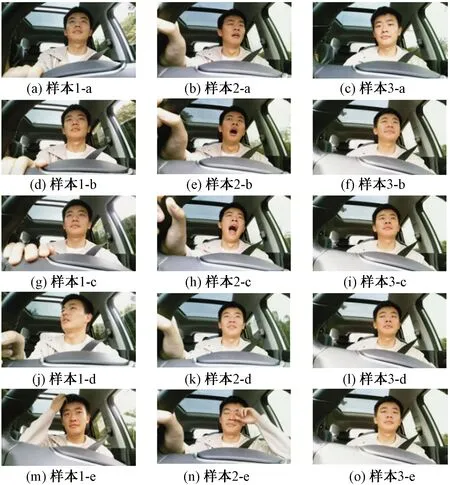

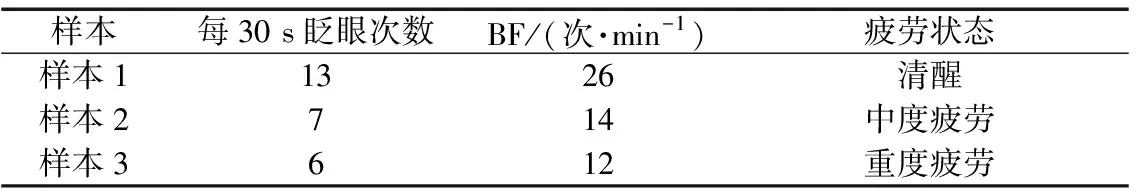

4.1 典型樣本參數分析

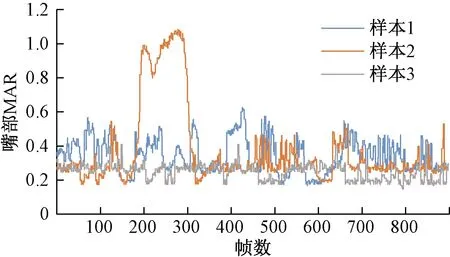

利用獲取的實車數據進行實驗驗證與分析。圖14為來自同一駕駛員的3個典型樣本。圖14中,樣本1、樣本2、樣本3分別標定為清醒樣本、疲勞樣本、重度疲勞樣本。利用所設計疲勞檢測系統進行分析,分析結果如表5~表7所示。

圖15中,樣本1為清醒狀態,樣本2為中度疲勞狀態,樣本3為重度疲勞狀態。實驗結果(圖15)與樣本標定結果一致。

圖14 疲勞檢測樣本Fig.14 Samples of fatigue detection

表5 樣本PERCLOS分析結果

表6 MDEC分析結果

表7 樣本BF分析結果

4.2 樣本集檢測效果

從實車采集的10名駕駛員樣本集中隨機抽取共計200個有效樣本用于分析。將200個有效樣本分別標定,最終得到清醒狀態樣本共142個,疲勞狀態樣本37個,重度疲勞狀態樣本21個。

分別將樣本輸入疲勞檢測系統,系統識別判定結果如表8所示。

圖15 樣本MAR比較Fig.15 MAR comparison of samples

表8 系統識別結果

從實驗結果(表8)可知,對照樣本的人工標定結果,系統對3種疲勞狀態的檢測普遍具有較高的檢測準確率,在區分清醒和非清醒狀態時達到了97.9%的檢測效果。系統的平均識別準確率達到了92.2%,在同類疲勞檢測系統中達到了較高的水平。

5 結論

針對疲勞駕駛檢測的特點,融合多個疲勞特征參數設計了一種高效、可靠的疲勞檢測系統,得出如下結論。

(1)針對復雜的駕駛環境,對SSD目標檢測算法進行結構優化及損失函數改進,改進后的SSD算法在人臉數據集上的平均準確率提高了7.0%。

(2)為提高檢測效率及魯棒性,結合CamShift及卡爾曼算法進行人臉跟蹤預測。顏色干擾實驗及遮擋實驗表明,融合后的算法對環境干擾的魯棒性更強,能避免跟蹤丟失或目標誤判。

(3)利用眼睛和嘴巴的特征點序列,建立疲勞多個特征參數并設定疲勞判定策略。整體系統在實車樣本集上的平均檢測準確率為92.2%,達到了疲勞檢測系統的要求。