基于分割的任意形狀場景文本檢測①

蔡鑫鑫,王 敏

(河海大學 計算機與信息學院,南京 211100)

1 引言

文本是傳遞語義信息的最基本媒介,它在日常生活中無處不在:路牌、商店招牌、產品包裝、餐館菜單等,這種自然環境中的文本被稱為場景文本[1].自然場景中的文本檢測及識別技術可以廣泛地應用到場景分析與理解、視覺障礙導航、智能交通管理、無人駕駛等領域.由于場景文本具有不同的尺度和形狀,包括水平文本、多方向文本和曲線文本,因此對每個文本實例的邊界框或區域進行定位仍然是一項具有挑戰性的任務.基于分割的場景文本檢測方法能夠預測像素級的結果來描述各種形狀的文本,近年來受到了廣泛的關注.然而,大多數基于分割的方法推理速度慢,模型和后處理步驟復雜,限制了它們在真實環境中的部署.同時已有高效的文本檢測器多數是針對四邊形文本實例設計的,在檢測曲線文本時存在不足.

為了解決這些問題,本文提出了一種可以檢測任意形狀文本的方法,同時可以在速度和準確度之間達到很好的平衡.本文方法主要有3 個步驟:(1)使用輕量級的分割網絡提取特征,預測文本的概率圖和閾值圖;(2)根據可微二值化模塊將概率圖和閾值圖結合得到近似的二值圖,自適應地預測圖像中每個位置的閾值,從而很好的區分前景和背景中的像素;(3)對近似二值圖進行簡單后處理,得到文本區域.

2 相關工作

目前基于深度學習的自然場景文本檢測方法可以分為3 類:基于區域建議的方法、基于分割的方法和混合方法[2].

基于區域建議方法的主要思想是先對自然場景文本圖像提取候選框,然后對每個區域進行分類和回歸,最后得到文本檢測結果.Textboxes[3]方法可以快速地計算文本在每個區域存在的可能性,將常用的卷積核修改成1 ×5,使其更適合自然場景文本檢測.Textboxes++方法[4]將Textboxes 水平排列文本檢測器擴展為任意方向排列文本檢測器.基于區域建議的方法通常使用簡單的后處理算法(如非極大值抑制算法NMS),但是大多數方法不能精確的表示不規則文本(如曲線文本)的邊界框.

基于分割的方法主要借鑒了全卷積神經網絡(FCN)的思想,針對圖像中每一個像素點進行分類判斷,以達到語義級別分割的目的.EAST 方法[5]首先通過FCN輸出文本區域像素級檢測結果,然后將上述結果通過NMS 算法獲得文本區域.TextSnake 方法[6]將文本實例描述為一個以對稱軸為中心的重疊圓盤序列,每個圓盤都與潛在的可變半徑和方向相關,這種幾何屬性是通過FCN 模型來估計的.PSENet[7]為每個文本實例生成不同比例的內核,并逐漸將最小比例內核擴展為具有完整形狀的文本實例.基于分割的方法通常需要復雜的后處理,會降低推理速度.

混合方法是將上述的兩種方法相結合來進行場景文本檢測.LOMO 方法[8]可以多次逐步定位文本,通過迭代細化逐步感知整個長文本,考慮文本實例的幾何特性對不規則文本進行精確再現.FTSN 模型[9]從實例感知語義分割的角度,利用語義分割任務和基于區域建議的目標檢測任務的優點,對文本實例進行聯合檢測和分割.

本文方法側重于在不損失推理速度的情況下,將二值化過程包含到訓練周期中來改進分割結果.

3 基于分割的任意形狀場景文本檢測

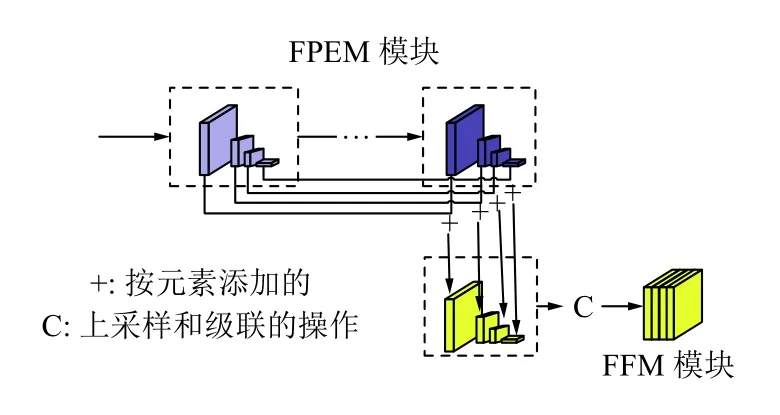

圖1為本文提出方法的總體框架.首先,為了提高效率,本文采用一種計算效率高的分割頭來細化特征.分割頭包括兩個關鍵模塊:特征金字塔增強模塊(FPEM)和特征融合模塊(FFM)[10].如圖1所示,FPEM 是可級聯的,可以附加在主干之后,使不同尺度的特征更深入和更具表現力,然后利用特征融合模塊(FFM)將不同深度的FPEM 產生的特征融合得到最終的分割特征F.其次,利用特征F對概率圖(P)和閾值圖(T)進行預測,根據可微二值化模塊(DB)將概率圖和閾值圖結合得到近似的二值圖(B'),自適應地預測圖像中每個位置的閾值[11].最后,在推理階段,通過邊界框形成從近似二值圖中獲得文本區域的邊界框.

3.1 特征金字塔增強模塊FPEM

FPEM 是一個U 型模塊,如圖2所示,它由兩個階段組成:Up-Scale 增強和Down-Scale 增強.Up-Scale增強作用于輸入的特征,它以步長32,16,8,4 像素在特征圖上迭代增強.在Down-Scale 階段,輸入的是由Up-Scale 增強生成的特征,增強的步長從4 到32,同時該階段輸出的特征就是最終FPEM 的輸出.本文使用分離卷積代替常規卷積來構建FPEM 的連接部分(見圖2虛線部分),因此FPEM 能夠以較小的計算開銷擴大感受野和加深網絡.與FPN 類似,FPEM 能夠通過融合低層和高層信息來增強不同尺度的特征,同時它還有兩個優點:(1)FPEM 是一個級聯模塊,隨著級聯數目m的增加,不同尺度的特征圖融合更充分,特征的感受野變得更大;(2)FPEM 的計算開銷很小,它建立在分離卷積的基礎上,計算量大約為FPN 的1/5.

圖1 總體框架

圖2 FPEM 模塊

3.2 特征融合模塊FFM

采用特征融合模塊FFM 對不同深度的特征F1,F2,···,Fm進行融合,對于語義分割來說,低層和高層的語義信息都很重要,組合這些特征直接有效的方法是對它們進行上采樣和級聯.然而,此方法給出的融合特征圖具有較大的通道數(4×128×m),這會降低最終的預測速度.因此,本文采用另一種融合方法,如圖3所示,首先通過逐元素增加的方法組合相應的尺度特征圖,然后對添加后的特征圖進行上采樣并連接成僅具有4×8 個通道的最終特征圖.

圖3 FFM 模塊

3.3 可微二值化模塊DB

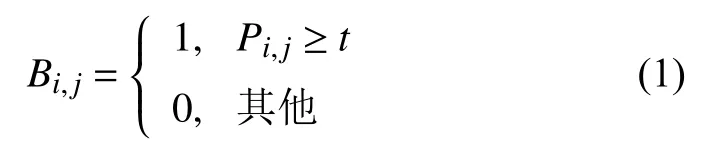

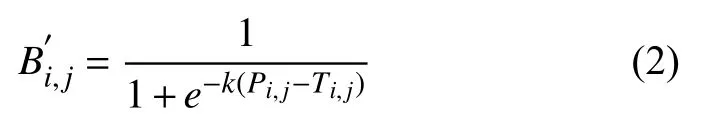

根據分割網絡生成的概率圖P∈RH×W,其中H和W表示圖的高度和寬度,需要將其轉換為二值圖P∈RH×W,其中值為1 的像素被認為是有效的文本區域.通常,這種二值化過程可以描述如下:

其中,t為預定義的閾值,(i,j)表示圖中的坐標點.

式(1)中描述的標準二值化是不可微的,在訓練過程中不能隨著分割網絡進行優化.為了解決這一問題,本文使用步長函數進行二值化:

其中,B'是近似二值圖,T是從網絡中學習的自適應閾值圖,k是放大系數,本文設置為k=50.該近似二值化函數與標準二值化函數相似,但具有可微性,因此可以在訓練期間隨分割網絡進行優化.自適應閾值的可微二值化方法不僅可以區分文本區域和背景,而且可以分離出連接緊密的文本實例.

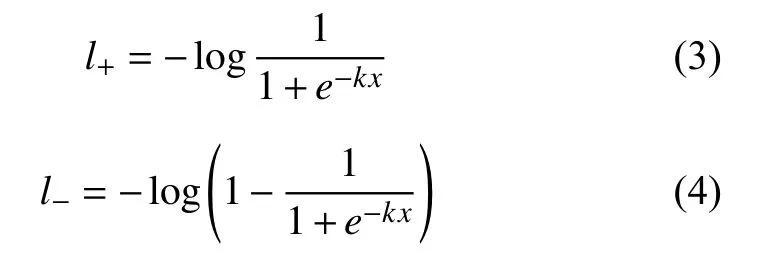

DB 提高性能的原因可以用梯度的反向傳播來解釋,以二元交叉熵損失為例,定義f(x)=1/(1+e?kx)作為本文的DB 函數,其中x=Pi,j?Ti,j,那么正標簽的損失l+和 負標簽的損失l?為:

可以用鏈式法則很容易地計算出損失的微分:

由微分可知:(1)梯度被放大系數k增大;(2)梯度的放大對大多數錯誤預測區域都是顯著的,從而有利于優化和幫助產生更顯著的預測.此外,當x=Pi,j?Ti,j時,P的梯度受到T的影響,并在前景和背景之間重新縮放.

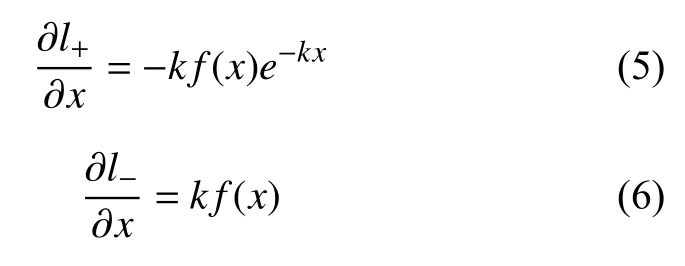

3.4 標簽生成

概率圖的標簽生成是受到PSENet[7]的啟發,如圖4所示,給定一個文本圖像,其文本區域的每個多邊形由一組線段來描述:

式中,n是頂點的數量,在不同的數據集中可能不同,如ICDAR2015 數據集的4 個頂點和Total-Text 數據集的16 個頂點.然后,使用Vatti 裁剪算法將多邊形G縮小到Gs,收縮的偏移量D是由原多邊形的周長L和面積A計算出來的:

其中,r是收縮比,設置為0.4.

通過類似的過程,可以為閾值圖生成標簽.首先將文本多邊形G以相同的偏移量D展開至Gd,將Gs和Gd之間的間隙作為文本區域的邊界,通過計算到G中最接近的線段的距離來生成閾值圖的標簽.

圖4 標簽生成

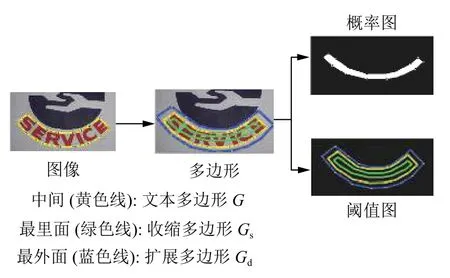

3.5 損失函數

損失函數L可以表示為概率圖Ls的損失、二值圖

Lb的損失和閾值圖Lt的損失的加權和:

根據損失的數值,α 和β 分別設置為1 和10.

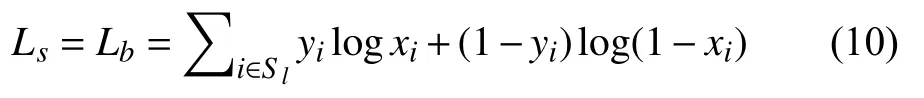

本文對Ls和Lb都應用了二元交叉熵損失(BCE).為了克服正負數的不平衡,在BCE 損失中采用了hard negative mining 的方法.

Sl是 正負比為1 :3的采樣集.

Lt為擴展多邊形Gd內預測和標簽之間的L1距離之和:

其中,Rd是 擴展多邊形Gd內像素的一組索引,y?是閾值圖的標簽.

在推理階段,使用概率圖來生成文本邊界框,框的形成過程包括3 個步驟:(1)將概率圖二值化為常數閾值(0.2),得到二值圖;(2)從二值圖中得到連通區域(縮小后的文本區域);(3)使用Vatti 裁剪算法中的偏移量D'對縮小的區域進行擴展.D'計算為:

其中,A'是收縮多邊形的面積,L'是收縮多邊形的周長,r'設置為1.5.

4 實驗與分析

4.1 數據集

SynthText 是一個包含800 k 圖像的合成數據集,此數據集僅用于對本文的模型進行預訓練.

ICDAR2015 是多方向文本檢測常用的數據集,它由1000 張訓練圖像和500 張測試圖像組成,文本實例以單詞級標注.

Total-Text 是包含各種形狀文本的數據集,包括水平、多方向和曲線文本實例,它由1255 張訓練圖像和300 張測試圖像組成,文本實例以單詞級標注.

4.2 實驗設計

對于所有模型,首先使用SynthText 數據集對它們進行100 k 次迭代預訓練,然后使用1200 epochs 對真實數據集上的模型進行微調,訓練批大小設置為8.本文遵循多學習率策略,當前迭代的學習率Lr=Ir×(1?i/max_i)p,其中初始學習率Ir設置為0.001,p為0.9,權重衰減為0.0001,動量為0.9,m ax_i表示最大迭代次數,這取決于最大的epoch.

訓練數據的數據擴充包括:(1)在(?10°,10°)范圍內隨機旋轉角度;(2)隨機裁剪;(3)隨機翻轉.所有處理后的圖像都重新調整為640×640,以提高訓練效率.

在訓練階段,忽略所有數據集中標記為“DO NOT CARE”的模糊文本區域.在推理階段,保持測試圖像的高寬比,并通過為每個數據集設置合適的高度來重新調整輸入圖像的大小.推理速度測試批大小為1,在單個線程中使用單個1080ti GPU,推理時間包括模型前向傳播時間和后處理時間.

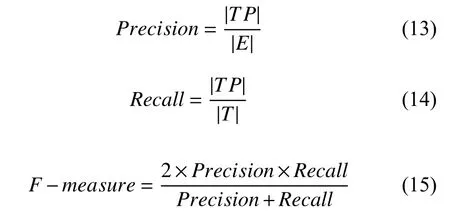

本文檢測性能評測方法主要考慮3 個性能參數:準確率Precision、召回率Recall和綜合評價指標F-measure,其中綜合評價指標是準確率與召回率的調和平均值,該值是評價文本檢測方法性能的綜合指標.定義如下:

其中,TP,E,T分別表示正確的檢測結果集合,檢測結果集合以及Ground-truth 集合.

4.3 實驗結果與分析

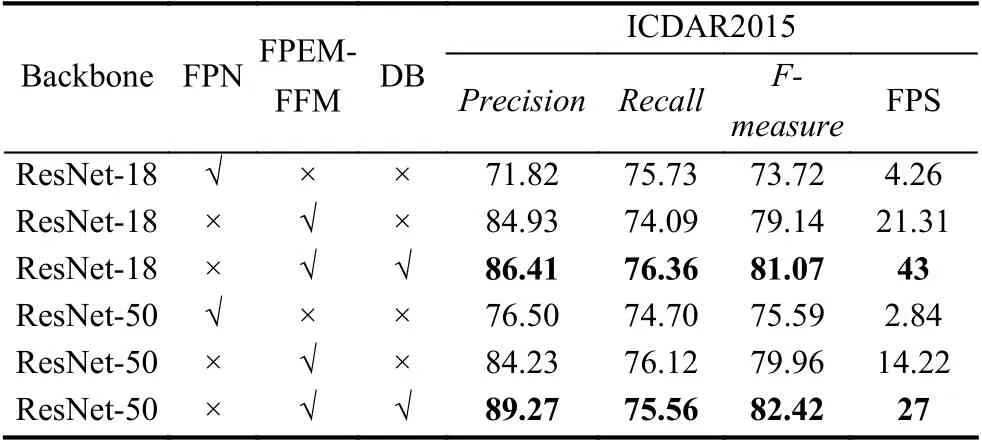

為了驗證特征金字塔增強模塊FPEM 和特征融合模塊FFM 的有效性,在數據集ICDAR2015 實驗中,與特征金字塔FPN 進行了實驗對比,如表1所示,不管主干網絡是ResNet-18 還是ResNet-50,FPEM-FFM 都具有較高的性能(73.72% vs 79.14%,75.59% vs 79.96%)和速度(4.26 vs 21.31,2.84 vs 14.22).

表1 不同設置的實驗結果

為了驗證可微二值化模塊DB 的有效性,在數據集ICDAR2015 實驗中進行了有無DB 模塊的實驗對比,從表1中可以看到DB 顯著地提高了數據集上ResNet-18 和ResNet-50 的性能.對于ResNet-18 主干網,DB 在ICDAR2015 數據集上實現了1.93%的性能提升.對于ResNet-50 主干網,DB 在ICDAR2015 數據集上實現了2.46%的性能提升.此外,在兩個主干網中,有DB 模塊比沒有DB 模塊的速度都提高了約2 倍.

從表1中可以看到ResNet-50 主干網模型比ResNet-18 模型性能更好,但運行速度更慢.具體來說,ResNet-50 模型比ResNet-18 模型的性能高1.35%,但時間成本約為ResNet-18 的1.6 倍.

本文將所提出的方法與之前的方法在兩個標準數據集上進行了比較,包括多方向文本數據集ICDAR2015和曲線文本數據集Total-Text.

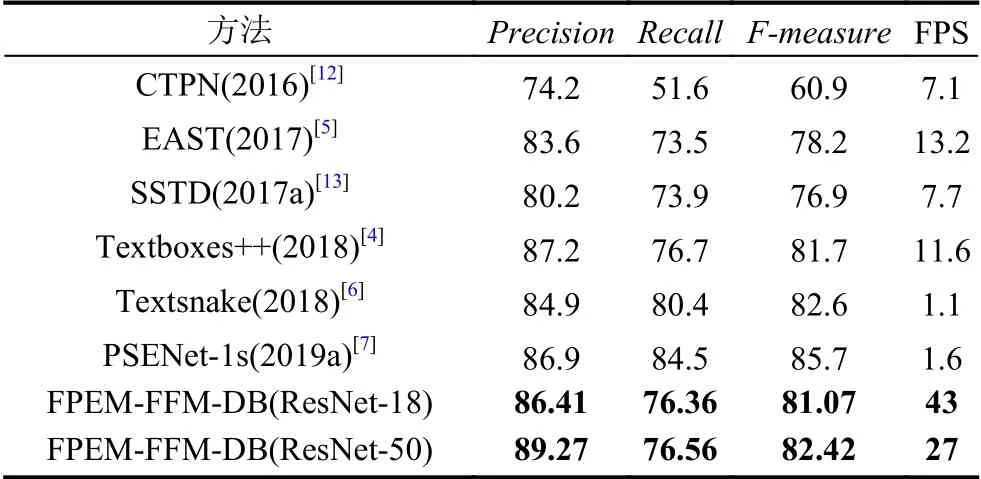

ICDAR2015 數據集是一個面向多方向的文本數據集,它包含許多小的和低分辨率的文本實例.在表2中可以看到,與之前最快的方法EAST 相比,“FPEM-FFMDB(ResNet-50)”的性能比它高4.22%,運行速度快了兩倍.當使用ResNet-18 主干時,“FPEM-FFM-DB(ResNet-18)”速度可以達到43 fps,F-measure為81.07%.

表2 ICDAR2015 數據集上的檢測結果

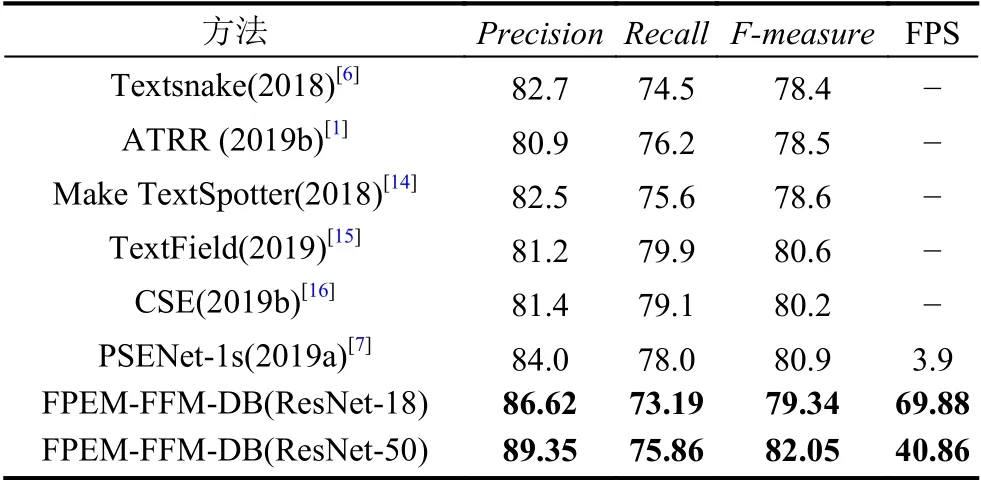

本文在曲線文本數據集Total-Text 上驗證所提出方法的魯棒性,如表3所示,本文的方法在性能和速度上都達到了較好的結果.具體來說,“FPEM-FFMDB(ResNet-50)”在性能上比之前的最新方法高出1.15%,同時運行速度比之前的方法都快.使用ResNet-18 主干網可以進一步提高速度,但性能會有所下降.與最近的基于分割的方法PSENet 相比,“FPEM-FFMDB(ResNet-50)”速度快10.5 倍,“FPEM-FFM-DB(ResNet-18)”速度快17.9 倍.

表3 Total-Text 數據集上的檢測結果

5 結論與展望

本文提出了一種可以高效準確的檢測任意形狀文本的框架,該框架包括由特征金字塔增強模塊和特征融合模塊組成的輕量級分割頭和分割網絡中的可微二值化過程,該分割頭既有利于特征提取,又能帶來較小的額外計算量,可微二值化模塊可以顯著地提高文本檢測的性能.即使使用輕量級主干網絡(ResNet-18),本文的方法也能以較快推理速度在測試數據集上實現可比較的性能.雖然本文的方法呈現出了一個可以與其他先進方法相媲美的效果,但是實現實時精確的自然場景文本檢測任務還面臨諸多挑戰,未來仍有很多工作有待去解決.