基于端到端學習的視覺車道線保持方法研究

張育綺 廖志恒 馮嵐濤 代苑 李小松

摘 要:針對傳統自主駕駛汽車復雜的車道檢測、路徑規劃和運動控制技術問題,基于卷積神經網絡設計了一種視覺車道保持系統,該方法可直接從視覺傳感器中獲取數據以控制車輛轉向。基于消失線方法對圖像進行區域剪切獲取感興趣區域,解決了訓練過程需標記大量的數據集而時間成本高的問題。采用上、下采樣結合及色彩空間轉換方法進行數據增強,避免了數據不平衡和過擬合現象。最后,結合實際情況修正了轉角損失與油門損失權重比。將預處理后的數據饋送到神經網絡進行訓練,通過仿真實驗驗證了方法的可行性,實現了基于端到端學習的DIY小車在所設置軌道上的自主駕駛。

關鍵詞:車道保持;端對端學習;卷積神經網絡;數據增強

中圖分類號:TP391.7? 文獻標識碼:B? 文章編號:1671-7988(2020)22-34-03

Abstract: Aiming at the complex lane detection, path planning and motion control technology of traditional autonomous driving vehicles, a visual lane keeping system is designed based on the convolutional neural network, which can directly obtain data from the vision sensor to control the vehicle steering. Find the region of interest based on the vanishing line method. This solves the problem of requiring a large amount of time to mark a large data set during training. The method of up-down sampling and color space conversion is used to enhance the data, which avoids the phenomenon of data imbalance and overfitting. Finally, the weight ratio between the Angle loss and the throttle loss is corrected according to the actual situation. The pre-processed data were fed to the neural network for training.?The feasibility of the method was verified by simulation experiments, and the autonomous driving of the DIY car on the set track based on end-to-end learning was realized.

Keywords: Lane keeping; End - to - end learning; Convolutional neural network; Enhance the data

CLC NO.: TP391.7? Document Code: B? Article ID: 1671-7988(2020)22-34-03

1 引言

車道保持是自動駕駛汽車的一個基本功能,相比雷達、激光雷達等傳感器,普通彩色相機由于成本低、獲取信息豐富,仍廣泛用于基于視覺的車道線保持系統[1,2]。基于端到端學習的方法可從原始圖片中自適應提取特征,有效避免了人工特征提取的局限性[3]。

2 數據預處理

2.1 基于消失點檢測設定感興趣區域

通過透視投影在世界坐標系中的一組平行線收斂到圖像空間中的一個公共點,在二維圖像像素平面中,當前行駛車道的終點即消失點(VP)[4,5]。先對原圖像進行二值化處理,之后進行Hough變換得到當前車道左、右車道線的斜率和截距為(kl,bl),(kr,br),帶入式(1)求兩條直線的交點縱坐標,即為消失點。由于CNN僅遍歷道路部分,即訓練時間成本會降低。

2.2 數據增強

2.2.1 基于上、下采樣的數據增強

由于人工誤操作致使轉角值為0的數據占比過半,轉角為-1的數據次之,轉角為1的數據只有200個左右,轉角在(-1,0)和(0,1)的彎道數據占比極小。采用這類數據訓練出的駕駛模型更傾向于直線行駛,左轉向過急或者喪失右轉向。本文采用上、下采樣相結合的方法去解決數據不平衡問題。采樣分為上采樣和下采樣,上采樣是把小眾類復制多份,下采樣是從大眾類中剔除一些樣本,處理后轉角在(-1,0)和(0,1)的小批量且重要的數據明顯增強,轉角為零的數據量從之前的4900張左右減至700張左右,數據均衡效果明顯。

2.2.2 HSV色彩空間轉換

本文將圖像從RGB顏色空間轉換到HSV顏色空間,并分別提取出H、S、V分量,V通道使得白色和黃色車道線特征更加明顯,因此選擇V通道作為CNN的輸入。且將V通道元素分別乘以一個在一定范圍內變化的隨機值,也即是加入了隨機光照噪聲,范圍越寬,增強幀與原始幀的差異就越大,這樣經過CNN訓練之后模型對外界環境光照的變化適應性會更強。

2.2.3 添加高斯擾動噪聲

神經網絡學習高頻特征時易發生過擬合,而學習高頻特征對模型提升無幫助。采用具有零均值特性的高斯噪聲,可有效地使高頻特征失真,減弱其對模型的影響。同時會使得低頻成分(重要的特征)受到影響,但神經網絡能夠通過學習而忽略那些影響。當具體給出某一視頻幀時,就會獲取相應的標記轉向角,由于轉向方向是一個連續值,所以標記值不一定是唯一工作的方向,稍微不同的轉向值都可能會起作用。因此在訓練過程中,在標記轉向值中隨機加入輕微的高斯擾動噪聲。通過此方法,在不完全扭曲原始轉向值的情況下,在數據中創建更多的變化,使數據信息量更加豐富。

3 CNN架構

通過激活函數f(x)的非線性運算輸出特征圖Tx。計算公式如(2)所示:

4 實驗結果與分析

4.1 仿真實驗

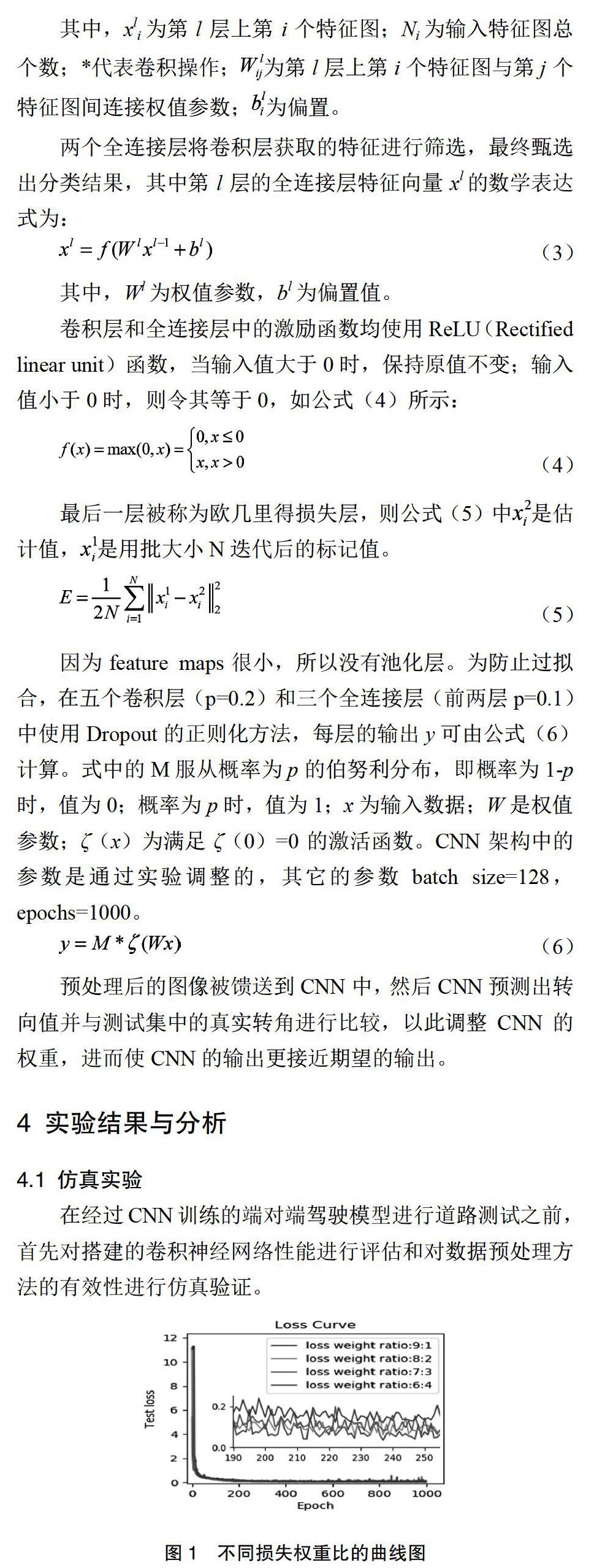

在經過CNN訓練的端對端駕駛模型進行道路測試之前,首先對搭建的卷積神經網絡性能進行評估和對數據預處理方法的有效性進行仿真驗證。

基于前期研究發現,損失權重比設置會影響訓練結果總損失進而影響實驗結果,因此設計四種損失權重比:(1)轉角損失:油門損失=9:1;(2)轉角損失:油門損失=8:2;(3)轉角損失:油門損失=7:3;(4)轉角損失:油門損失=6:4。損失值收斂點是訓練好的神經網絡的一個良好指標,由圖1可直觀觀測出4種情況下訓練結果在1000次迭代后均收斂。

綜合圖2、表1、 2可得出結論:(1)所設計的網絡結構和數據預處理方法均滿足可行性要求;(2)轉角信息對實驗的成功率更重要,因此合理控制轉角損失與油門損失權重比是提高實驗成功率的關鍵。

4.2 道路測試

通過WiFi實現工作站、智能小車、X-Box和智能手機之間的通訊而進行路試。

綜合表3可以得出,智能小車的轉角信息更為重要,較大的轉角損失與油門損失權重比能提高車道線保持的成功率,又結合表2可知,仿真實驗與真實路測得出的結果相同。因此本文所提出的基于端對端學習的車道線保持可以實現。

5 結束語

本文基于端到端學習方法實現了車道線保持,該方法從前置車載視攝像機拍攝的圖像幀中自動生成適當的轉向角控制車輛。針對傳統視覺傳感器使用過程中出現的魯棒性差和神經網絡訓練時間成本高等問題進行了研究,采用尋找消失線的方法對圖像進行感興趣區域剪切。又針對深度學習過程中出現的數據不平衡、數據信息不豐富以及過擬合等問題分別采取了上、下采樣相結合的方法、隨機添加高斯擾動噪聲和將圖片進行HSV色彩空間轉換并提取V通道作為CNN的輸入等方法對數據進行增強。然后綜合實際情況考慮了影響神經網絡訓練損失值結果的因素,并通過仿真實驗和道路實驗驗證了轉角損失與油門損失權重比對實驗結果的影響。

參考文獻

[1] Broggi A.Vision-based driving assistance[J].IEEE Intelligent Sys -tems & Their Applications,1998,13(6):22-23.

[2] 周欣,黃席樾,黎昱.基于單目視覺的高速公路車道保持與距離測量[J].中國圖象圖形學報,2018, 8(5):590-595.

[3] Schmidhuber,Jürgen.Deep learning in neural networks:An overview [J]. Neural Networks, 2015, 61:85-117.

[4] Simond N,Rives P.Homography from a vanishing point in urban sce -nes[C]//Intelligent Robots and Systems,2003.(IROS 2003). Procee -dings.2003 IEEE/RSJ International Conference on. IEEE, 2003, 1: 1005-1010.

[5] Miksik O.Rapid vanishing point estimation for general road detection [C]//Robotics and Automation (ICRA), 2012 IEEE International Conference on. IEEE, 2012: 4844-484.