穿戴式手勢交互系統與識別算法研究

劉璇恒,鄧寶松,裴 育,范博輝,謝 良,閆 野,印二威

1(天津大學 軟件學院,天津 300350) 2(軍事科學院 國防科技創新研究院無人系統技術研究中心,北京100071) 3(北京航空航天大學 軟件學院,北京 100191) 4(華東理工大學 信息科學與工程學院,上海 200237) 5(天津(濱海)人工智能創新中心,天津 300450)

1 引 言

人機交互(Human-Computer Interaction,HCI)是指用戶與計算機之間通過特定的交流手段實現信息交互的方式.手勢識別作為人機交互領域深耕已久的一個研究方向,主要是通過模式識別算法分析出手勢表達的含義,實現人與機器自然和諧的交互.

基于視覺的手勢識別[1,2]與基于傳感器[3,4]的手勢識別是目前主要的兩種實現方式.其中,基于視覺的識別技術發展比較早也相對成熟,但受設備和環境條件的制約較大,攝像頭擺放的位置角度,被遮擋,光線過亮或過暗都會影響攝像頭拍攝的圖片質量[5],從而影響識別準確率.基于慣性傳感器[6]的識別技術不受環境光、背景色的影響,采集數據穩定,信號處理簡單,克服了上述視覺識別技術的缺點,同時該技術還具有微型化、智能化、多功能、高集成度、低功耗、成本低廉和適于大批量生產等諸多優點,提供了復雜環境下穩定可靠的智能交互方式,在醫療康復機器人[7]、手語詞分類[8]、人體活動行為識別[9]等領域也有很大的應用價值.

在手勢識別領域,經典機器學習算法已經應用廣泛.Min等使用K-means聚類算法從訓練集中提取代表性手勢模板,初步用貝葉斯分類器對手勢進行預分類,之后通過使用動態時間規整算法(Dynamic Time Warping,DTW)將輸入手勢與具有相同類別的模板匹配[10].Huang等通過支持向量機(Support Vector Machine,SVM)算法進行手勢的分類,提出了一種手勢識別的實時視頻系統[11].施向軍等利用隱馬爾可夫模型(Hidden Markov Model,HMM)對紅外傳感器輸出的方向距離信息進行動態手勢識別研究[12].Gao等提出了一種具有異構分類器的模糊決策樹(Fuzzy Decision Trees,FDT),每個標志特征對手勢具有不同的區分,呈現對應的分類器以用于對手語屬性的分層決策[13].上述算法都面臨著下面一些挑戰性的問題(1)泛化能力差(2)無記憶性(3)特征工程復雜.與之相比,我們提出的ConvBLSTM框架在更快的學習速度下有著更好的泛化性能以及對于有著時間序列特征數據的強記憶能力[14].

在無人飛行器交互控制方面,大部分是基于傳統搖桿式遙控器為主要硬件的交互方式,少量以智能移動設備為硬件的控制方式,其本質也是內設的軟件模擬傳統搖桿式遙控器的操控方式.基于手部動作姿態的交互的無人機控制,多數都是通過Kinect[15]和Leap Motion[16]等傳感器實現視覺識別控制[17-20].本文研究了一種基于加速度計和陀螺儀的手勢控制無人機方法,基于多傳感器的手勢識別技術可通過傳感器之間的信息互補將傳感器各自的優勢結合起來,以獲取更好的識別結果.所提出的由卷積層和雙向LSTM循環層組成的ConvBLSTM深度學習框架,能夠自動學習原始傳感器數據特征提取空間特征并建模時間依賴性,識別手勢動作分類,以形成對應于無人機各遙控通道控制指令的手勢定義集,再按照手勢定義集將待識別的手勢動作映射為對應的飛行指令,控制無人機完成飛行任務.

2 手勢采集系統

2.1 硬件設計

我們所設計的手勢采集硬件裝置及芯片原理圖如圖1所示.手勢采集硬件裝置的支撐性材料選擇內含精細尼龍纖維編織而成的手套,它不僅保有手套的舒適與彈性,而且十分耐磨,避免反復實驗中的損壞.慣性模塊使用的是LSM6DS3傳感器,包括3軸加速度計和3軸陀螺儀.每個指尖和手背分別放置1個LSM6DS3傳感器,一共6個LSM6DS3傳感器.商業慣性測量單元(Inertial Measurement Unit,IMU),例如Xsens-MTi或Shimmer,其尺寸不夠小,不能精確穩定地放置在手指等關鍵點上,Fang等使用了MPU9250傳感器安裝在實心PCB上,尺寸為10×15×2.6mm,重量約為6g[21],但仍略顯笨重.我們采用的LSM6DS3傳感器,尺寸僅有2.5×3×0.83mm,重量更是只有約0.1g,實現了微型化.在高性能模式下的工作電流為1.25mA,具有在線低功耗特性.高達8KB的動態數據批處理能力,可動態分配重要數據(例如外部傳感器,時間戳等),極大的降低了開發成本.傳統傳感器連接使用復雜接線,在傳感器數量較多的情況下布線很不方便,而且十分笨重.基于無線網絡的通信方式是可移植的,但無線網絡復雜不穩定,數據傳輸速率低.本文通過柔性電路板將所有的IMU連接到微控制單元(Microcontroller Unit,MCU),使用柔性電路板省去了多余排線的連接工作,同時具有重量輕,厚度薄,彎折性好等優點.中央控制單元采用的是STM32L433xx 微控制器.IMU數據通過MCU數字化,經由Micro-USB接口傳輸到外部設備.

圖1 手勢采集裝置及芯片原理圖Fig.1 Gesture acquisition device and chip schematic

2.2 數據傳輸軟件

本文所用數據傳輸軟件由博睿康科技有限公司提供.數據采樣頻率為100Hz,即采樣周期為10ms.該軟件將40ms的數據封裝成幀實時進行發送.數據手套捕獲的手勢數據,通過PC機的COM端口流入數據采集軟件,該軟件通過TCP/IP協議把數據發送到采集程序,完成數據的采集和標記.數據傳輸軟件為用戶提供了友好的用戶圖形界面,可以通過三級菜單欄調整觀測精度(scale)來觀察數據在幅度上更細微的變化,通過調整時間軸分辨率來觀測數據在時間域上更細致的表現,包括6個6軸傳感器共36通道的數據,以及一個事件標記通道,共有37通道數據.事件標記通道的數據一直為零,用于程序調試的輔助debug功能.

3 基于ConvBLSTM神經網絡的手勢識別

3.1 手勢識別流程框架

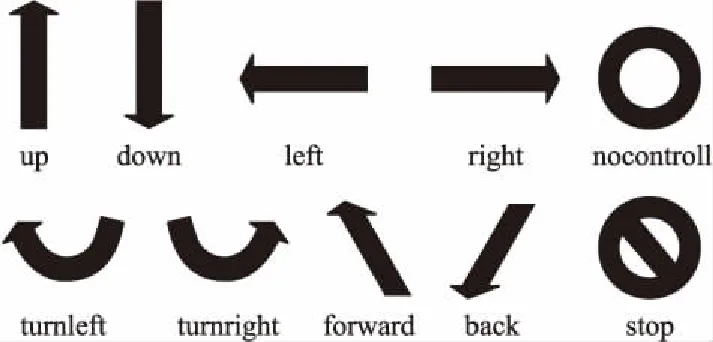

基于ConvBLSTM神經網絡的手勢識別框架可以分為三個步驟.第一階段建立手勢數據庫.無人機控制指令分為上、下、左、右、前、后,左轉、右轉、懸停、無操作共十種手勢.首先,通過所設計的手勢采集系統收集不同手勢的運動數據形成數據集.第二階段進行數據預處理和訓練分類.在手勢數據集的基礎上,我們提取每個手勢的36維手部特征并使用模型訓練.第三階段是實驗和分析.我們收集不同被試者的手勢運動數據,使用訓練好的ConvBLSTM最優模型進行手勢識別.手勢識別流程框架如圖2所示.

圖2 基于ConvBLSTM的手勢識別流程框架Fig.2 ConvBLSTM-based gesture recognition process framework

3.2 手勢數據分析

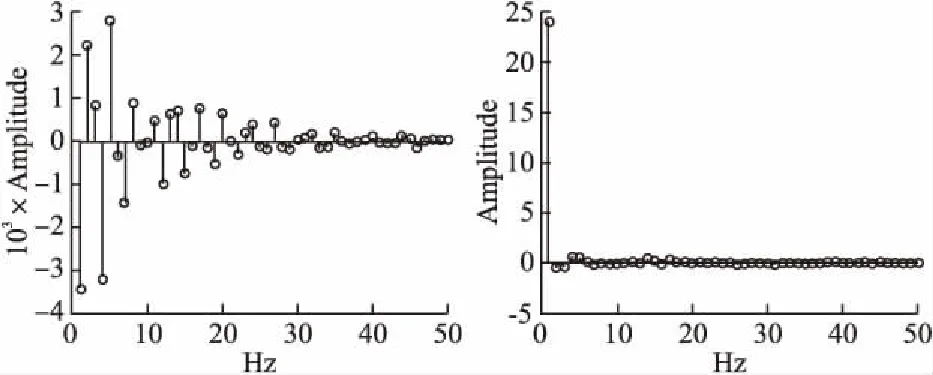

微慣性傳感器通過捕捉一段時間內信號的動態變化,從而實現不同手勢區分,故本文討論基于動態手勢識別,圖3呈現了動態手勢和無操作手勢數據的頻域圖像,二者進行對比,發現手勢動作基本沒有噪聲干擾,故而直接在獲取的原始加速度、角速度數據上進行工作,只需最少的預處理,最大限度的減少工程偏差.后面工作也充分驗證了基于原始數據的優勢,能夠幫助網絡更高效準確的收斂.

3.3 ConvBLSTM神經網絡設計

手勢識別作為一種時序性任務,時序性建模的優劣是識別效果好壞的關鍵因素.傳統的時序建模方法包括HMM、DTW等,通過人工設計的特征作為數據輸入,利用手勢標簽進行模型的訓練,進而實現手勢的分類.但由于傳統方法過程較為復雜,且模型的設計大多基于理想的假設前提,因此存在一定不足.近年來,伴隨著深度學習的迅猛發展,卷積神經網絡(Convolutional Neural Networks,CNN)、循環神經網絡(Recurrent Neural Network,RNN)在各類任務包括圖像分類[22]、人臉識別[23]、機器翻譯[24]、手勢識別[25,26]中取得了突出成績.

圖3 動作手勢和無操作手勢在某通道的頻域圖Fig.3 Frequency domain diagram of action gestures and no operation gestures in a channel

我們提出了一種基于原始陀螺儀和加速度計傳感器數據的手勢識別框架ConvBLSTM.主要由4個卷積層和1個雙向LSTM循環層組成.對于輸入的傳感器數據,由四層卷積層從手勢序列中提取特征并生成特征映射,輸入雙向LSTM層,通過有效計算梯度分量來學習時序數據.

我們所提出的算法結構如圖4所示.輸入數據大小為36×80×1,單個手勢作為一個樣本輸入網絡,包括36通道(6個加速度計x,y,z軸和6個角速度計x,y,z軸)和80時間序列.Conv1和Conv4采用大小為2×2的濾波器,Conv2和Conv3采用大小為3×3的濾波器,步長均為1.使用卷積運算提取特征圖的方法表示為:

(1)

池化層對輸入的特征圖進行壓縮,提取主要特征,可以減少下一層參數和計算量,簡化網絡復雜度,同時也能夠有效地控制過擬合現象.計算公式表示為:

(2)

BiLSTM作為一種傳統RNN改進結構可以通過減輕RNN的梯度消失問題來模擬長期依賴性.我們采用雙向LSTM神經網絡有效地提取手勢運動序列的時間特征.基于BiLSTM的神經網絡的時序建模,根據卷積層提取的手勢特征,在雙向LSTM層,按手勢采集的時間順序將特征一幀一幀正向和反向同時輸入,利用BiLSTM的時序表達能力進行時序編碼,從而獲取手勢樣本的時序特征,每個輸出時刻根據前一輸出時刻的輸出來判斷最優輸出,從而可構建動態手勢的前后動作聯系,最終可得到手勢樣本的對應表達.

雙向LSTM單元主要由一個有記憶能力的細胞態和三種稱為門的結構組成,通過門結構來控制信息通過細胞,選擇性增加和去除通過細胞結構的信息.正向LSTM正序處理手勢數據,反向LSTM逆序處理手勢數據來實現長期記憶能力.

圖4 ConvBLSTM網絡模型Fig.4 ConvBLSTM network model

下面描述所提出的LSTM網絡的細節.

1)首先是決定前一時刻細胞態中的信息去留,稱為遺忘門,該門會讀取前一個LSTM神經網絡模塊的輸出ht-1和當前神經網絡模塊的輸入xt,然后通過sigmoid激活函數輸出0到1之間的數值ft,用于決定有多少分量可以通過.

ft=σ(Wf·[ht-1,xt]+bf)

(3)

it=σ(Wi·[ht-1,xt]+bi)

(4)

(5)

(6)

3)最后是輸出新的記憶信息,稱為輸出門.我們需要基于細胞狀態來確定一個輸出的值,這個輸出值不是原樣輸出,而是經過過濾的版本.首先我們通過Sigmoid層決定我們將要輸出的細胞狀態信息,接著將細胞狀態通過tanh處理,將二者相乘得到我們想輸出的信息.

ot=σ(Wo·[ht-1,xt]+bo)

(7)

ht=ot*tanh(Ct)

(8)

在所有卷積層和雙向LSTM層后都加入批規范化層(Batch Normalization,BN),可以穩定訓練過程并加快學習速度,從而避免梯度消失.

最后由全連接層通過Softmax函數激活,實現由特征到類別的映射關系.

(9)

其中zi表示上一層的輸出,i表示分類維度為C,yi表示預測為第i類的概率.

4 實驗和結果分析

4.1 數據集

為了驗證所提出系統,我們采集了10名被試者的手勢數據,獲得了由10個類別組成的手勢數據集.被試者為10名男性,年齡在22到25歲之間(平均值23.6),在滿足手勢定義的要求下,被試者以他們各自的習慣方式用右手操作上、下、左、右、前、后,左轉、右轉、懸停、無操作共十種手勢,圖5顯示了所確定的10種手勢,十種手勢選擇旨在控制與無人機交互.例如,up和down用于無人機俯仰,turnleft和turnright用于無人機偏航等.每種手勢采集300次,因此,從每名被試者得到了3000個手勢樣本,總共30000個數據樣本.

圖5 定義的十種手勢Fig.5 Ten gestures defined

使用采集程序來同步采集手勢數據,通過刺激界面提示用戶做出相應的十種手勢.每個手勢采集時間為2s,采樣頻率為100Hz,手勢之間休息2s,要求每名被試者在滿足手勢定義的要求下,按照各人的習慣每種手勢采集300次,在每次數據采集之前給每名被試者示范每個手勢動作十次,被試者看了示例手勢并重復相同的手勢10次.被試者坐在椅子上,數據手套通過USB連接到采集電腦進行手勢采集,被試者打開數據采集的刺激界面,通過提示并且與示例手勢類似的速度執行手勢.為了避免連續采集大量數據以及重復手勢帶來的動作變形等不利于實驗結果的影響因素,每種手勢采集十次共100個手勢記錄為一組數據,分時間,分多次在閑暇時候進行數據采集,以提供多樣性的數據.并且為了確保數據的科學嚴謹,每組數據的100個手勢采用隨機出現的方式采集.

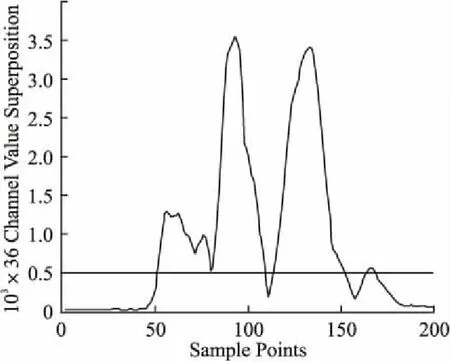

手勢識別首先需要準確檢測手勢時間窗口的起點和終點,從而實時截取有效的手勢信號段.將傳感器數據取絕對值并將36通道數據全部疊加,可以清晰地看到手勢疊加信號如圖6所示,依據實驗經驗,手勢動作約在傳感器數值之和大于500時開始,有效手勢長度為600~800ms.經過反復實驗分析,我們設定閾值為500,即從傳感器數值之和大于500時判定為手勢開始標志并開始截取數據,截取數據長度為800ms.由于單個數據樣本每個手勢截取的手勢時間窗口長度為800ms,采樣頻率為100Hz,單個樣本大小為36×80.

圖6 手勢36通道疊加時域圖以及截取閾值Fig.6 Time domain graph of thirty-six-channel superimposed signal during gesture movements and the corresponding threshold for data segment

4.2 實驗設置

本文所提出的ConvBLSTM模型基于Keras深度學習框架實現,使用TensorFlow作為后端引擎,模型學習和分類在NVIDIA GeForce RTX 2080Ti GPU上運行,顯存為11G.模型按照有監督的方式學習,以Adam優化器為優化規則,以分類交叉熵損失函數為優化方向,學習率(learning_rate)設置為0.0001進行訓練,網絡每次訓練的樣本數(batch_size)大小為20.

4.3 算法性能比較

4.3.1 有訓練

我們將提出的ConvBLSTM算法分別與BiLSTM、KNN和SVM三種典型手勢識別算法進行了比較.具體算法設置為:①SVM算法核函數使用的是rbf,為高斯核,gamma值越小,分類界面越連續;gamma值越大,分類界面越散,分類效果越好,但有可能會過擬合.分類方法為One vs Rest,即一個類別與其它類別進行劃分.②KNN算法使用統一的權重,即在每一個鄰居區域里的點的權重都是一樣的,計算最近鄰居使用ball_tree算法.③BiLSTM算法輸出大小(lstm_size),批處理參數(batch_size),學習率(learning_rate)分別設置為200,160,0.0001.

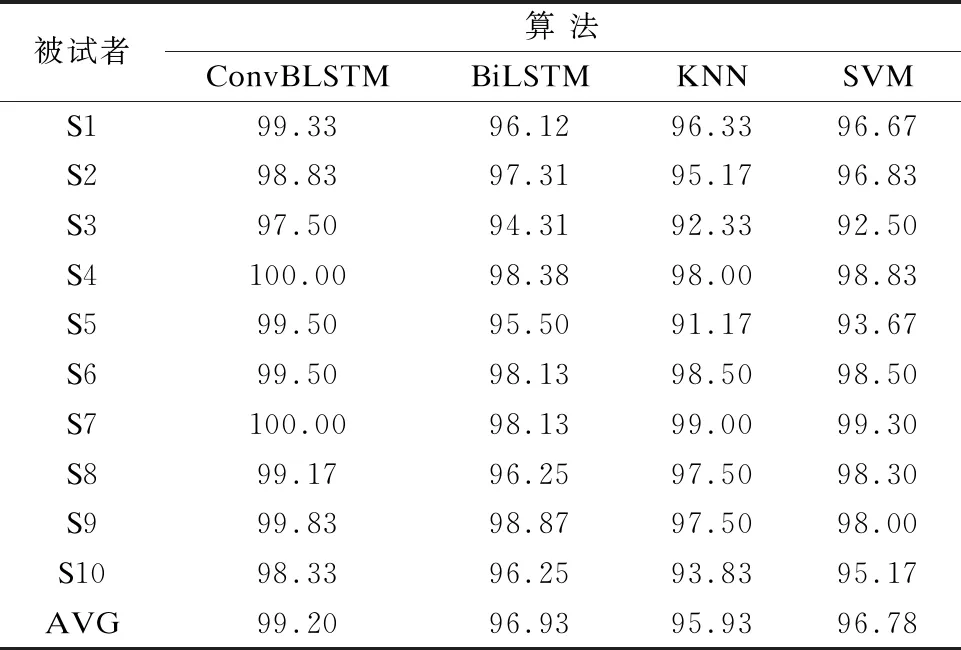

在10名實驗者數據集上執行準確性和有效性實驗.采用5折交叉驗證來測量所提出系統的性能.分別將每名被試者的數據集劃分為5組,其中4組用于訓練,其余用于測試.我們獲得了5折的10個訓練模型準確度,評估結果如表1所示,顯示了每個被試者的4種機器學習算法的準確率以及平均準確率.由于執行手勢的速度和方法不同并且傳感器和手之間的距離對于每個被試者是不同的,因此手勢識別的準確性對于每個被試者而變化.4種算法中ConvBLSTM的平均識別準確率高達99.2%,顯著優于其余三種算法(ConvBLSTM vs.BiLSTM,p<0.0001;ConvBLSTM vs.KNN,p<0.01;ConvBLSTM vs.SVM,p<0.01).當在顯著性水平α=0.05的情況下,ConvBLSTM和其它三種算法分別進行T檢驗時的p值均小于0.05,h均為1,表明可以從統計上斷定算法ConvBLSTM的結果大于BiLSTM、KNN、SVM的結果,即兩組數據均值的比較是有意義的,存在顯著性差異,表明ConvBLSTM樣本間差異小,更加精確和穩定.對于ConvBLSTM、BiLSTM、KNN以及SVM算法,每個被試者的準確率標準差分別為0.75,1.39,2.57,2.19.我們發現第3和第5名被試者的數據集在BiLSTM,SVM以及KNN上的準確率均是十名被試者中最低的,但在ConvBLSTM上的表現依然優秀,表明ConvBLSTM算法具有最佳精度,而且對被試者執行的各種手勢特征具有更強的魯棒性.

表1 每個被試者的4種機器學習算法的準確率以及平均準確率Table 1 Accuracy comparisons among four machine learning algorithms across participants

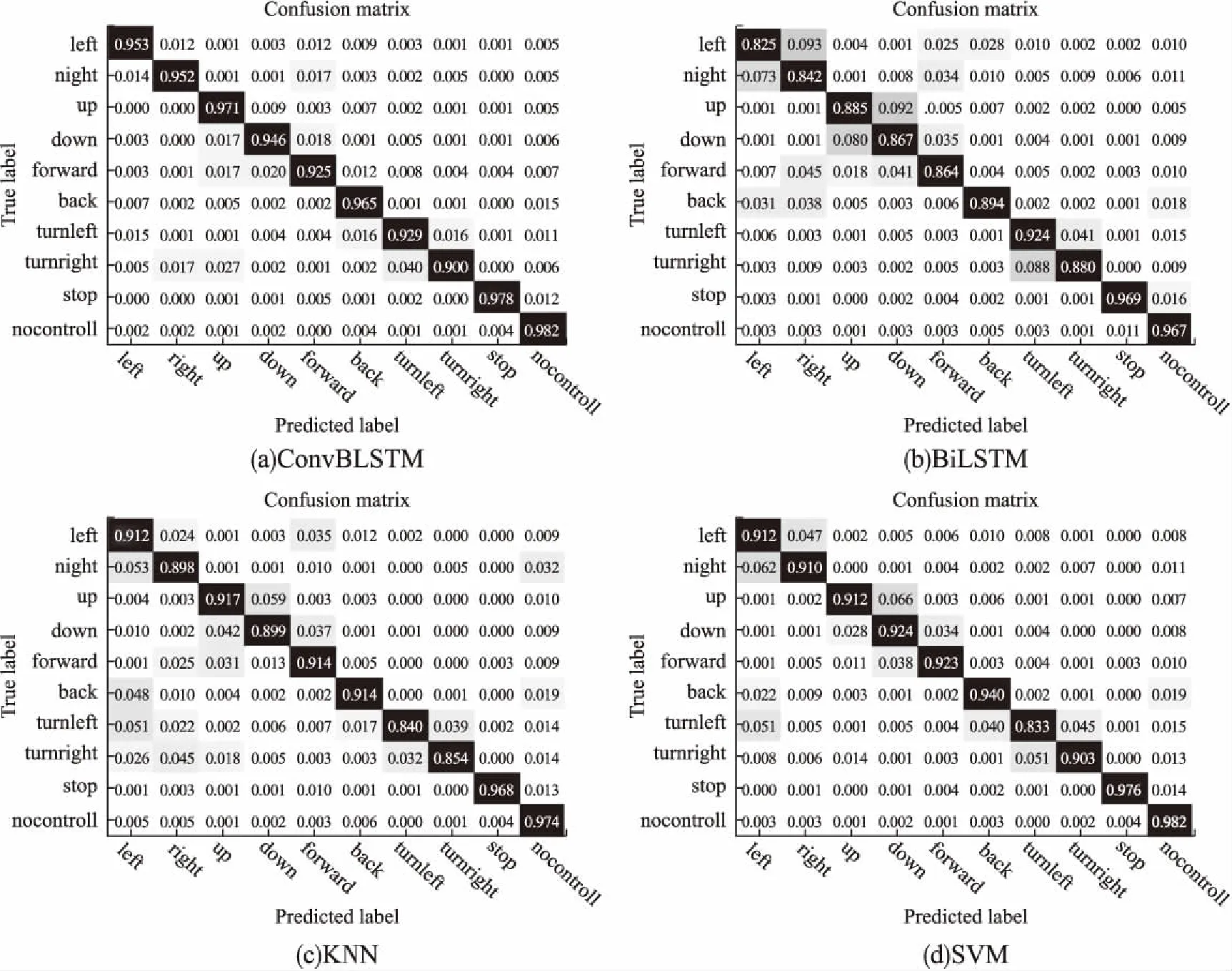

4.3.2 無訓練

為驗證算法的跨被試遷移學習能力,我們將分別將上述S1至S10被試者的手勢數據作為測試集,其余被試者數據混合作為訓練集,得到的每個被試者的ConvBLSTM、BiLSTM、KNN、SVM算法的無訓練模型.通過無訓練的新人驗證試驗,以測試學習模型的泛化能力,得到了10名實驗者的4種機器學習算法混淆矩陣,如圖7所示.

ConvBLSTM模型在無訓練情況下對大多數手勢進行了充分分類,能夠有效地提取特征,對于新被試者它依然保持著95.01%的高識別精度.除此之外,BiLSTM、KNN以及SVM模型也較好的對手勢進行了分類,識別精度分別為89.17%,90.80%,92.15%,但是很大程度的混淆了以類似模式完成的手勢動作,證明了ConvBLSTM模型泛化性能顯著優于其他模型.

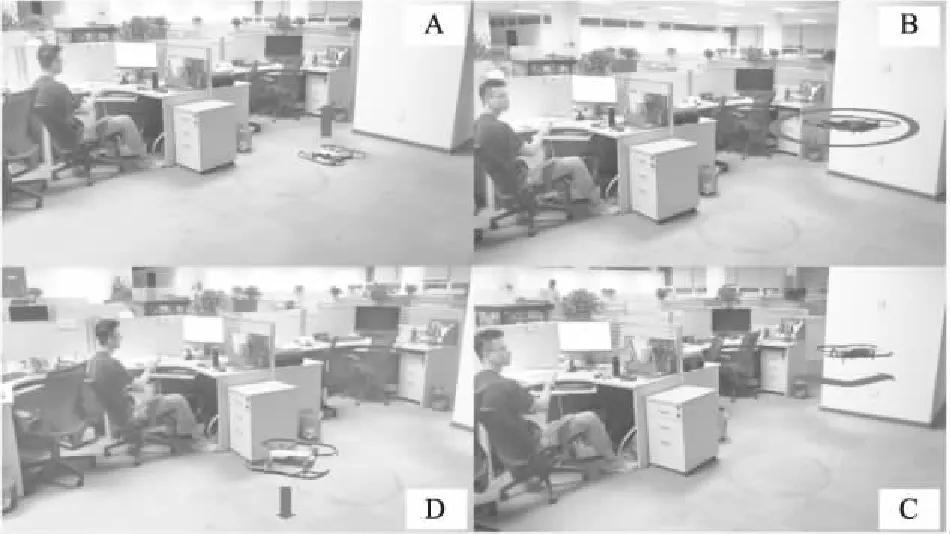

4.5 無人機同步控制

為了驗證手勢控制的效果,我們進行了無人機的同步控制實驗.本文所使用的無人機型號是大疆的Mavic air.是大疆公司旗下的一款旗艦機型.Mavic air機身小巧輕便,自穩性能好,靈敏度高,其內置天線可以增強飛行時信號的收發,在實驗室環境下抗干擾能力強.重量約430g,折疊后的飛行器面積大小與智能手機相當,攜帶方便,飛行姿態可控性強,適合較狹小室內飛行實驗.

手勢動作信號與無人機交互是基于DJI的Windows SDK開發的控制程序.實現了和定義的十手勢分別對應的無人機飛行功能,即上升,下降,前進,后退,左轉,右轉,左移,右移,懸停,無操作.

當同步控制程序啟動時,根據提示界面在規定時間2s內做出任意一個手勢動作,手勢數據傳入神經網絡識別出結果.然后譯為對應飛行指令輸出,發送到無人機.由于在基礎的10手勢中,沒有設計控制無人機起飛和降落對應的手勢動作,我們在程序中設計了復合指令用于擴展指令集.

圖7 10名被試者的4種機器學習算法混淆矩陣Fig.7 Four machine learning algorithm confusion matrices for 10 participant

無人機開啟后在地面處于待命狀態,在第1次執行上升手勢時控制起飛,以及需要降落時執行連續3次下降手勢控制其降落.成功起飛后,無人機懸停于距地面1.2m高度.此時可以執行不同的手勢動作控制無人機進行不同的移動,還可使其懸停在空中.在手勢切換過程中,控制無人機停止上一個動作再而執行當前動作.在與無人機交互期間可以使其隨時起飛或降落并關閉控制程序.

實際控制效果如圖8所示.分為四個部分:A是起飛狀態;B為起飛后的懸停狀態;C是無人機接收到左轉向的指令,執行左轉的狀態;D是控制無人機下降的狀態.

圖8 同步控制無人機Fig.8 Synchronous model for UAV control

10名被試分別基于各自數據集的訓練模型測試10種手勢動作10次,準確率與4.3.1節離線訓練下相近.可能有以下方面原因:1)基于個人數據有訓練情況下,所提出的模型特征學習能力強;2)執行手勢時有明確的開始結束提示信號,交互過程過于理想化.基于上述問題并考慮到實際交互情況,我們進一步討論了連續指令的無人機實時控制.

4.6 無人機實時控制

4.5節驗證了本文所述控制無人機方法的可用性.為了驗證手勢控制方法的普遍適用性,進行了無人機的實時控制實驗.由于實時系統要求系統處理到給出控制交互指令的時間間隔越短越好[27],為了保證在手勢識別精確性的前提下提高無人機控制的實時性,我們進行了手勢數據點長度準確性檢驗.

如圖9所示,顯示了ConvBLSTM和其他三種算法BiLSTM、KNN、SVM對手勢數據點長度和準確率的含誤差線的對比圖,誤差線代表10名被試不同手勢數據點長度準確率在該點的標準差.

可以觀察到ConvBLSTM在每個數據點長度的平均準確率相較于其他機器學習算法均為最高.ConvBLSTM在300ms時平均準確率已經達到了95%以上.用300ms滑動窗口進行實時手勢識別控制無人機實驗.為了避免誤操作,添加空閑態檢測機制,設定輸出閾值為0.5,當最大概率比第二大概率超過設定閾值時輸出為最大概率對應手勢,否則輸出空閑手勢.

圖9 數據點長度準確性檢驗Fig.9 Data point length accuracy test

劃定3m×3m的方形任務區域,以區域一角為起始點,無人機由起始位置起飛,繞區域四個角飛行一圈落回原點,記錄飛行時間.我們將10名被試者樣本均勻混合,采用5折交叉驗證,獲得全體數據集的有訓練模型.參與數據采集的S1-S10被試依次進行三次飛行實驗,每名被試由起飛到降落執行飛行任務平均所用時間如圖10所示.

圖10 每名被試執行飛行任務平均所用時間Fig.10 Average time for each participant to perform a mission

誤差線代表該被試執行三次飛行實驗的標準差,十名被試平均任務時間為122.8s,平均用時最短者為S4(std=7.93),平均用時最長者為S8(std=22.91),S3被試最不穩定(std=45.17).

樣本分布反應了如下情況:1)S4、S7(std=5.56)、S9(std=5.44)三名被試離線準確率最高,實際控制用時最短,樣本數據質量好,ConvBLTM模型表征能力強,手勢區分度顯著,執行任務效率高.2)S3雖然不是平均用時最長者,但標準差為45.17,相較其余被試最不穩定,與離線訓練中較低的識別準確率相對應.3)除被試數據質量好壞有區分度之外,被試適應手勢操控無人機的能力不同,也會在一定程度上影響任務時間.

無人機實時控制驗證了本文所述方法的普遍適用性,達到了預期效果.

5 結 論

本文介紹了用于手勢動作捕捉的數據手套的設計和開發,并使用所提出的ConvBLSTM框架進行手勢識別.采用低成本的慣性傳感器來捕獲手勢,提出了基于6個6軸IMU提出了新型數據手套.微型化與簡單化等優點表明所提出的數據手套優于其他數據手套.性能評估驗證了所提議的數據手套可以準確地捕獲手勢,并且基于ConvBLSTM的方法可以直接工作在原始傳感器數據上并準確地識別手勢,有訓練平均識別準確率達99.2%,無訓練平均識別準確率為95.01%,顯著優于BiLSTM、SVM和KNN方法.進一步,我們提出了一種手勢控制無人機方法,通過手勢裝置來控制無人機,無人機響應預定義的手勢并相應地移動.對手勢控制無人機實驗進行了分析和討論.下一步計劃采用無線模塊,結合EMG和IMU進行手勢識別研究.