基于卷積神經網絡的動作識別骨架特征研究

仇思宇 仇德成 趙國營

(1.武漢數字工程研究所,湖北 武漢 430200;2.河西學院信息技術與傳媒學院,甘肅 張掖 734000;3.中國人民解放軍32738部隊信息服務室,河南 鄭州 450053)

1 緒論

動作識別在計算機視覺中有重要的作用,并具有廣泛的應用,例如人機交互,視頻監視,機器人技術,游戲控制等[1,2].通常,人體可以看作是具有剛性骨骼和鉸接關節的關節系統,而人體的動作可以表示為骨骼的運動[3].目前,基于低成本的深度傳感器與實時骨架估計算法[4,5],可以提供相對可靠的關節坐標,基于這些坐標,已經開發出有效的動作識別方法[3,6,7].

2 研究背景

姿勢隨時間的動態變化可以建模為時間序列問題,這對于連續的動作識別至關重要[8-10].骨骼關節坐標可用于表示人類的姿勢及其關于時間的演變.基于手工提取骨架特征[3,11,12]的方法具有依賴算法設計者對骨架和人體骨骼構造的先驗知識的缺點,且在不同數據集中可能會使模型表現出不同的泛化性能,而基于深度學習技術的方法則可以彌補上述缺點.當前,主要有兩種使用深度學習技術來捕獲骨架序列中的時空信息的方法:循環神經網絡(RNN)和卷積神經網絡(CNN).

2.1 卷積神經網絡

卷積神經網絡直接從骨架序列編碼的紋理圖像中提取信息. Wang P 等的文章中使用關節軌跡圖(JTM)將每個時間實例的身體聯合軌跡(位置、運動方向和運動幅度)編碼為HSV圖像[13].Hou Y等的文章提出在圖像中空間信息由位置表示、動態信息由顏色表示[14].Li C等的文章采用骨架光學光譜(SOS)來編碼動態時空信息[15],采用關節距離作為空間特征,并使用顏色條進行顏色編碼.在圖像中,每一行紋理捕獲空間信息,而每一列紋理捕獲時間信息.當前,用于編碼的空間特征相對簡單.

2.2 循環神經網絡

循環神經網絡又稱遞歸神經網絡,采用循環神經網絡來從提取的空間骨架特征中捕獲時間信息.由于信息的順序流動,性能很大程度上取決于提取的空間骨架特征的有效性.而且,時間信息很容易過分強調,尤其是在訓練數據不足時,容易導致過擬合[13].

3 特征選擇

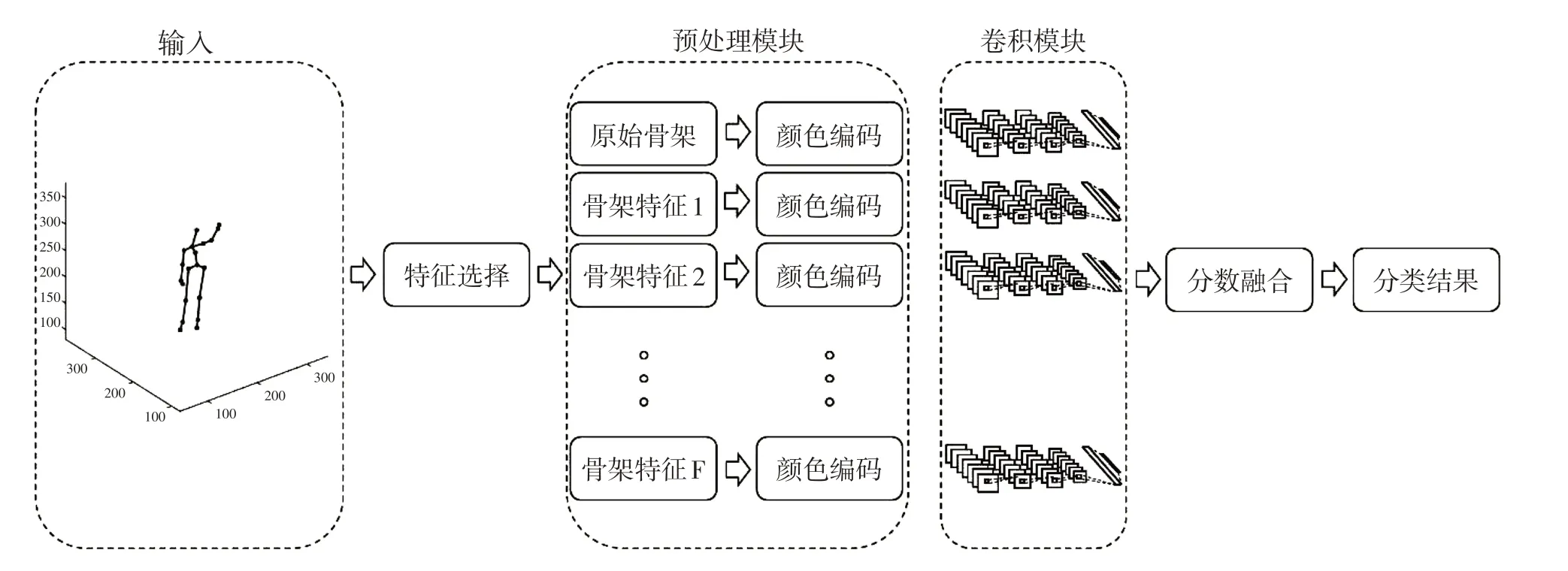

本文使用的方法如圖1所示,包括五個主要組成部分,即從輸入骨架序列中提取空間特征,關鍵特征選擇,從關鍵特征中進行紋理彩色圖像編碼,卷積神經網絡模塊預訓練以及分數融合的神經網絡訓練.

從關節時空位置提取出來的特征有多種,通過選擇特定的關節組合提取特征并進行顏色編碼,可以產生多種紋理圖像.卷積神經網絡會分別在每種圖像上進行訓練,訓練后的卷積網絡作為特征提取模塊放置在網絡的前端.由兩層全連接層組成的分數融合模塊作為網絡的后端,以完成最終的動作識別.

圖1 多特征動作識別模型整體結構

3.1 特征提取

本節研究的空間特征包括在Yang X和Tian YL的文章中介紹的絕對關節位置J 和相對關節位置Jr,以及在Zhang S等人的文章中介紹的關節-關節距離JJd 、關節-關節向量JJv 、關節-關節方向JJo 、關節-線距離JLd 和線-線角LLa[16-18],實驗中使用J 、Jr、JJo、JLd 和LLa 作為姿態序列每一幀的特征.

通過選擇關鍵關節和關鍵線的方式可以減少組合數量來進行特征選擇.關鍵關節和關鍵線的選擇遵循以下原則:所選特征應包含盡可能多的信息,并且對于視點和動作是不變的.基于運動主要位于骨架末端且通常是局部特征才具有識別力的觀點[17],我們采用Zhang S等人的方法從主要動作執行者中選擇39條線,得到612維JLd 特征和741維LLa 特征.

Li C等作者的文章中,彩色紋理圖像被用來編碼空間特征以捕獲動作的時間信息[15].具體而言,圖像中的每一列代表一幀中的空間特征,而每一行代表特定特征的序列.給定具有T 幀的骨架序列,為每幀提取S 維特征,形成的S×T 的特征矩陣編碼為H×W 大小的彩色紋理圖像以作為網絡的輸入.

3.2 網絡結構設定

卷積模塊由多個卷積層和池化層順序組合而成.為防止過擬合,正則化和dropout等方法被應用在神經網絡中.

3.3 多特征模塊的分數融合

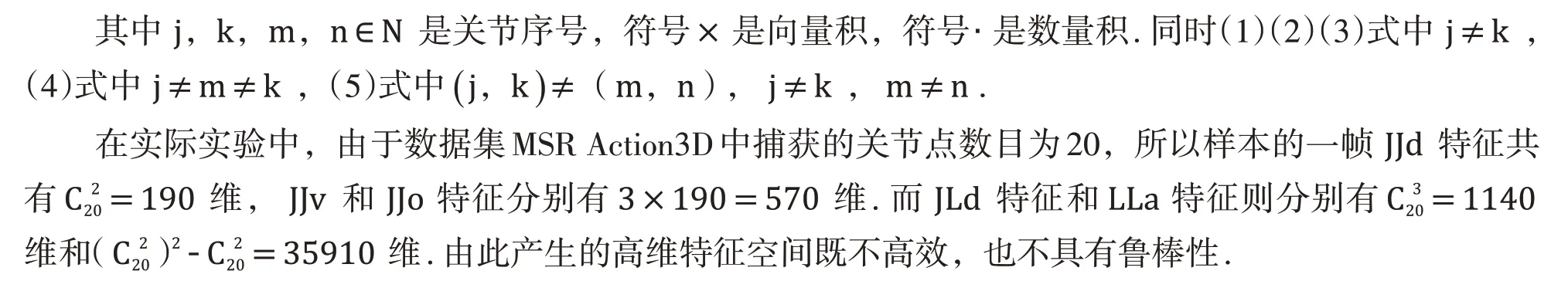

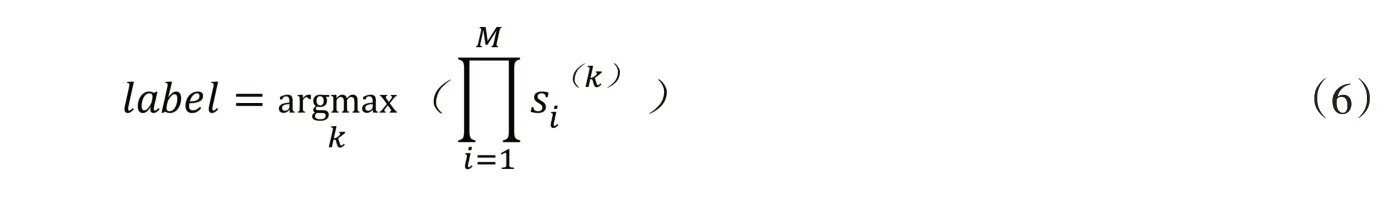

本文采用如圖2所示的網絡結構作為卷積模塊.給定一個測試骨架序列,將生成M 種類型的紋理圖像,并使用訓練后的模型識別每種類型的紋理圖像.然后,通過乘法將卷積模塊的輸出(分數)融合為最終分數,這已得到了驗證[19,20].融合過程如下:

其中s 是卷積模塊輸出的分數向量,k 則代表動作標簽的序號,而arg max(·)是用于找到最大元素的對應序號的函數.

圖2 預處理模塊網絡結構

4 實驗與評估

該模型在MSR Action3D 數據集上進行了評估.該數據集包含用于動作識別的深度點云和關節位置信息.它具有20 個不同動作類別的560 個有效樣本,這些樣本是由20 位動作執行者執行(每組執行3次).此數據集具有挑戰性,且數據量較小,因此不額外劃分驗證集,直接采用測試集作為驗證集.實驗采用跨目標的方法評估模型的準確性:即將50%的動作執行者的樣本劃分為測試集,剩余50%的動作執行者的樣本劃分為測試集.

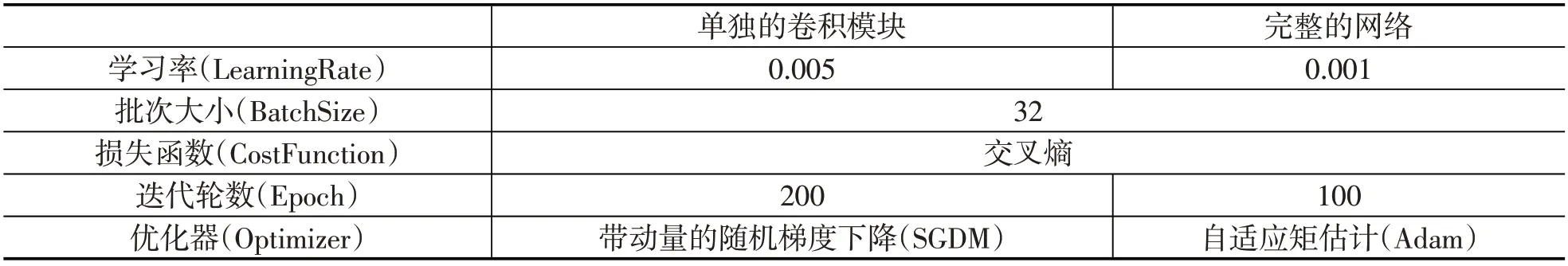

表1 模型訓練參數

4.1 數據集與測試方法

實驗環境是Google公司為深度學習研究者免費提供的Colaboratory服務器.該服務器配備了Tesla T4 GPU,16GB顯存,16GB的內存.實驗模型在此環境下平均每批數據僅需計算353毫秒.訓練中使用的模型訓練參數見表1.

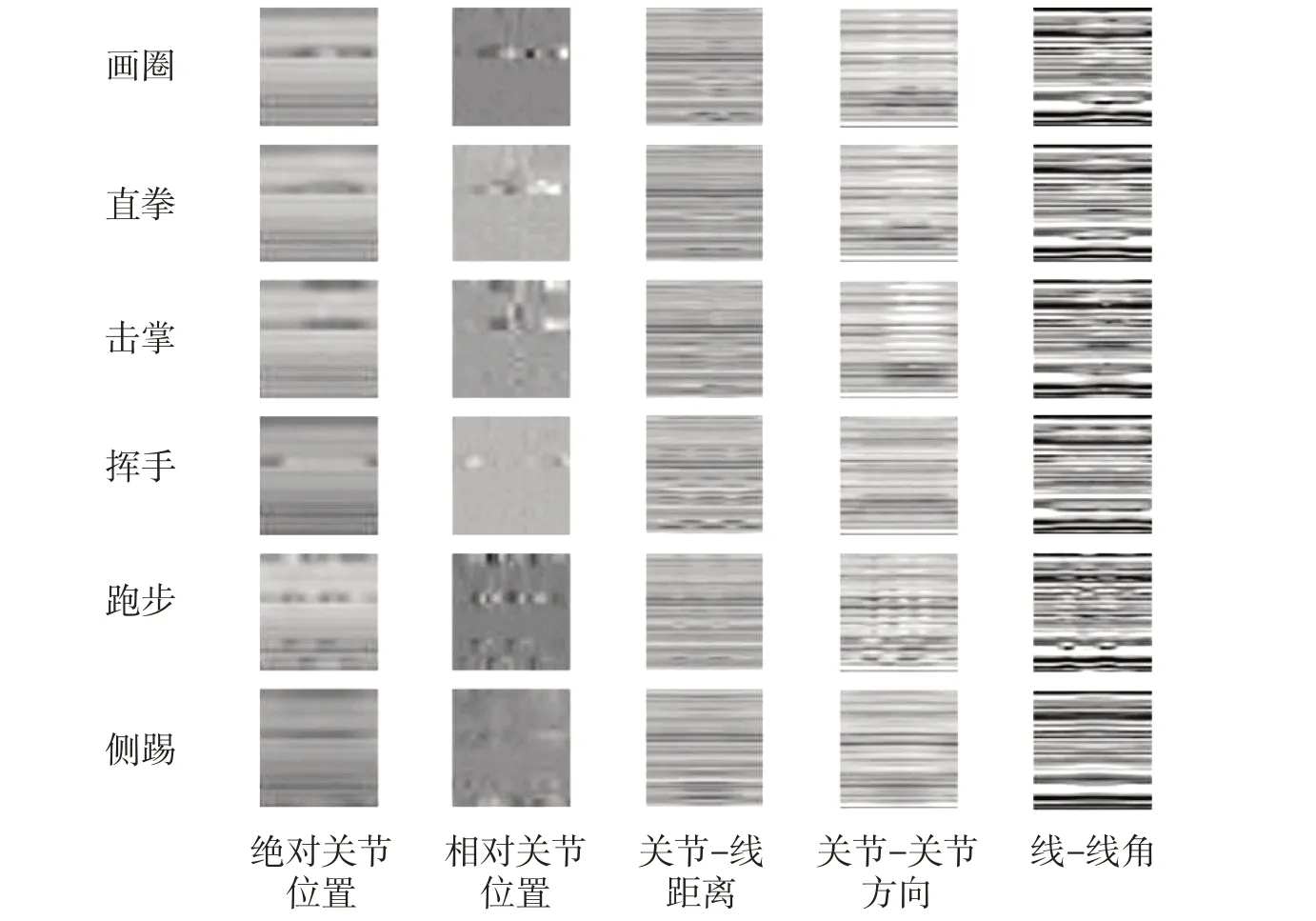

圖3 同一樣本不同特征的圖像編碼結果

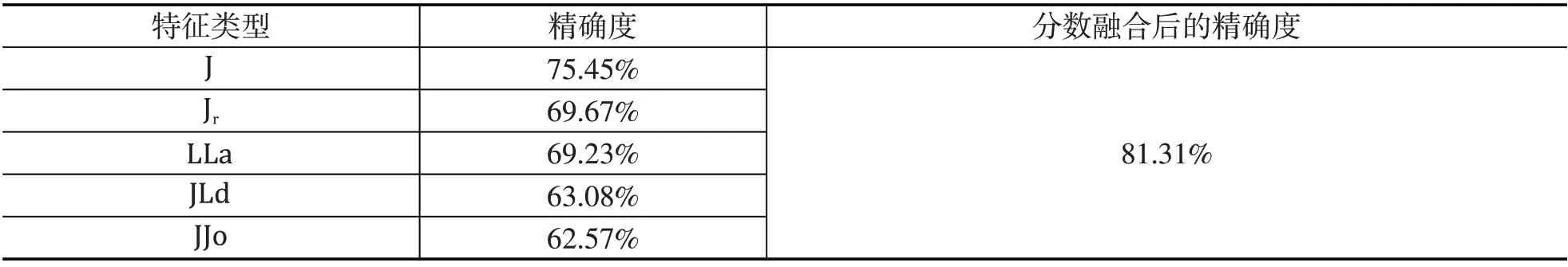

表2 特征提取方法的精確度

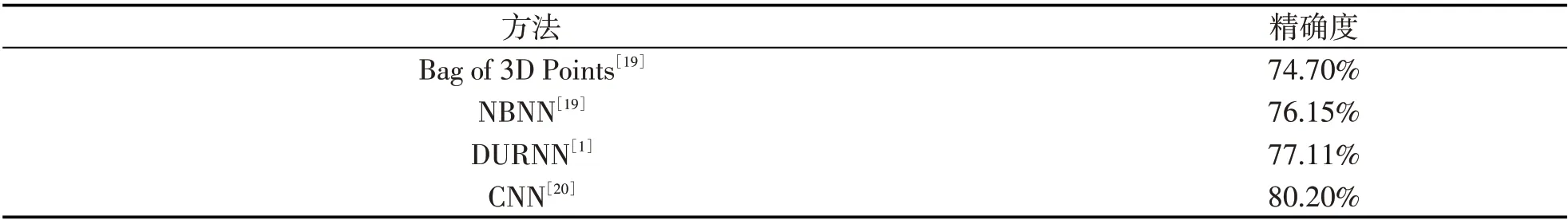

表3 不同模型精確度對比

4.2 模型測試結果

由圖3所展示的不同動作的樣本生成的紋理圖像中可以得出,實驗所選特征是具有辨別力的.

表2列出了各個特征提取方法進行試驗后的結果,以及分數融合的結果.評估的五個特征,對每個特征都使用不同的關節、線的選擇方法進行了評估.從表2中可以看出,基于單個結果和融合結果的比較,JJv 特征是最好的關節-關節特征.而JLd 是五種特征中最好的特征,這與Zhang S等人的結果相吻合.實驗結果表明,對于此任務,某些關節存在噪音.其他不同模型精確度對比結果在表3中,與基于手工特征的方法和基于深度學習的某些方法相比,本文所提出的方法精確度為81.31%,獲得了較好的結果.