基于紅外圖像的低空無人機檢測識別方法*

馬 旗,孫曉軍,張 楊,姜雨辰

(國防科技大學電子對抗學院, 合肥 230037)

0 引言

近年來,隨著電子科技的發展,帶動了無人機行業的興起,并以迅猛的姿態融入了社會生活中的各個方面。與此同時,無人機也對社會安全與軍事安全構成了嚴重威脅。例如,英媒報道2015年上半年有至少9架無人機試圖越過圍墻潛入監獄,并給囚犯投遞藥物和電子設備等。此外,無人機擾航、恐怖襲擊等事件也時有發生。因此,快速準確地檢測識別未知的無人機變得非常重要。由于無人機目標的熱輻射特性,在紅外探測器中能夠較為容易的突顯,因此采用成本較低的紅外探測手段對低空無人機進行檢測識別具有良好的應用前景。

空中無人機檢測識別任務主要有如下幾種方法。文獻[1]提出了一種基于視頻回歸的無人機檢測方法,利用回歸器來穩定運動,并采用固定大小的立方體框來檢測目標。當無人機緩慢飛行時,檢測性能較好,但實際效果表現較差。之后,王靖宇等人[2]提出了一種基于神經網絡的低空弱小無人機目標檢測方法,對不同背景噪聲下無人機能夠較好地檢測,但沒有考慮無人機類型與檢測速度。因此,對未知無人機進行快速準確地定位識別仍面臨許多挑戰。

隨著深度學習技術的迅速發展,利用卷積神經網絡訓練的模型在目標檢測領域具有廣泛的應用,能更快更好地滿足當今社會圖像視頻大數據的要求,并涌現出許多典型的方法,如Faster R-CNN[3]、SSD[4]以及YOLO[5]等方法。對空中的無人機進行定位識別,速度是十分重要的。而其中SSD與YOLO這兩類方法在檢測速度上都能達到實時的檢測。

因此,根據無人機的特征及實際情況,文中提出了一種基于紅外圖像的低空無人機檢測識別方法。該方法通過深度殘差網絡和預測網絡構建深度卷積神經網絡,再結合多尺度模型對空中不同大小的無人機進行類別的判斷和目標的定位。最后利用實際采集的紅外數據集對不同網絡進行訓練和測試,結果表明,文中方法在檢測速度損失較小的情況下,檢測識別性能優于其他方法。

1 檢測識別方法框架

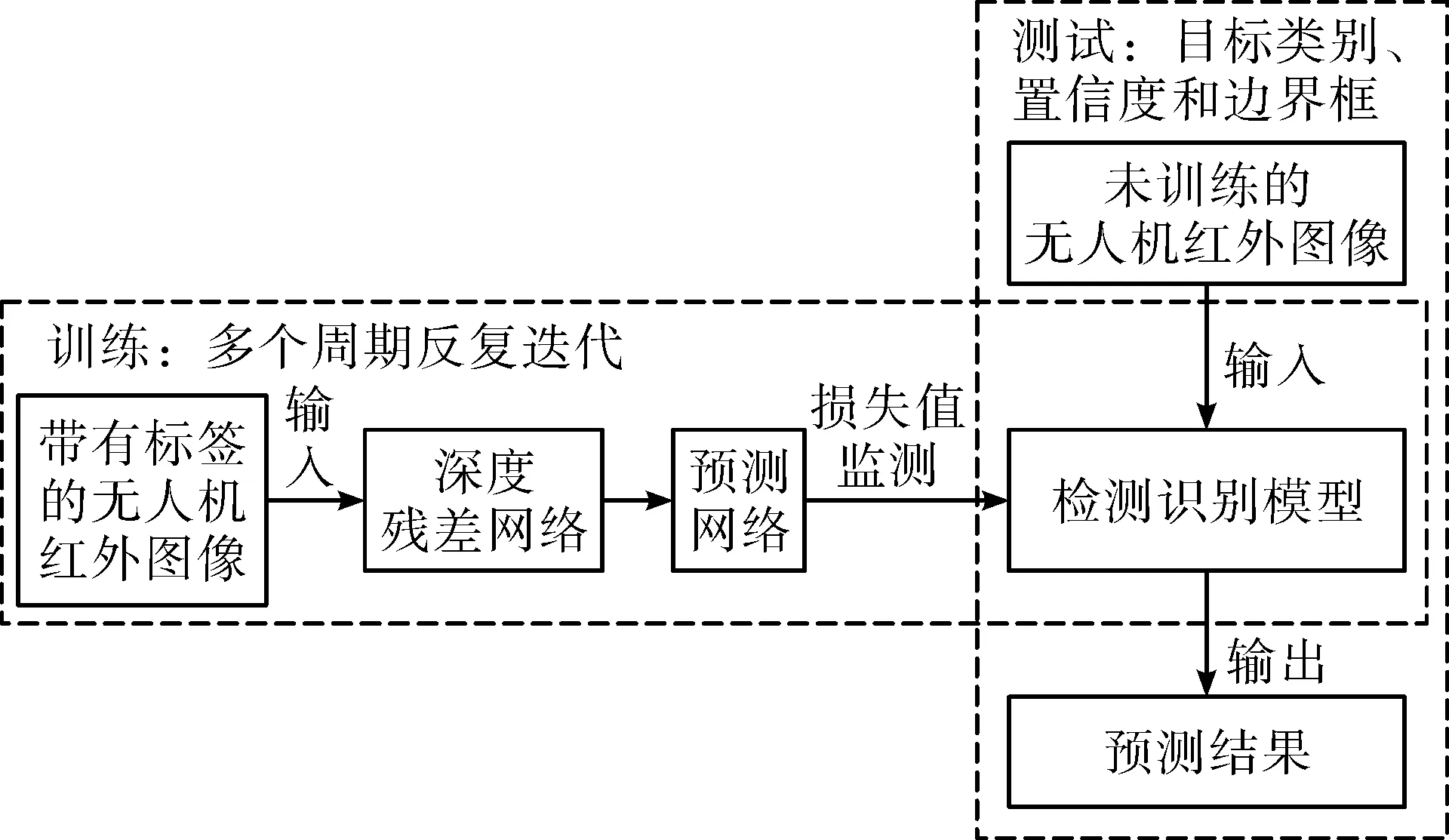

對于低空紅外無人機目標,文中設計了基于深度學習的整體框架圖,主要分為訓練和測試兩個部分。訓練階段,主要是利用監督學習的方法,將帶有標簽的紅外無人機圖像輸入到深度殘差網絡中進行特征提取,然后將深度特征輸入到預測網絡中進行目標的位置回歸和類型識別,經過多個周期的迭代,使得損失值不斷降低至不再變化,最終得到檢測識別模型。測試階段,將未訓練的無人機圖片輸入到模型中,重新加載訓練得到的網絡權重,對新的圖片進行特征提取及結果預測,最終得到目標的類別、置信度及邊界框信息。該方法訓練測試的整體框架如圖1所示。

圖1 無人機目標檢測識別方法框架圖

2 網絡結構及損失函數

2.1 網絡結構

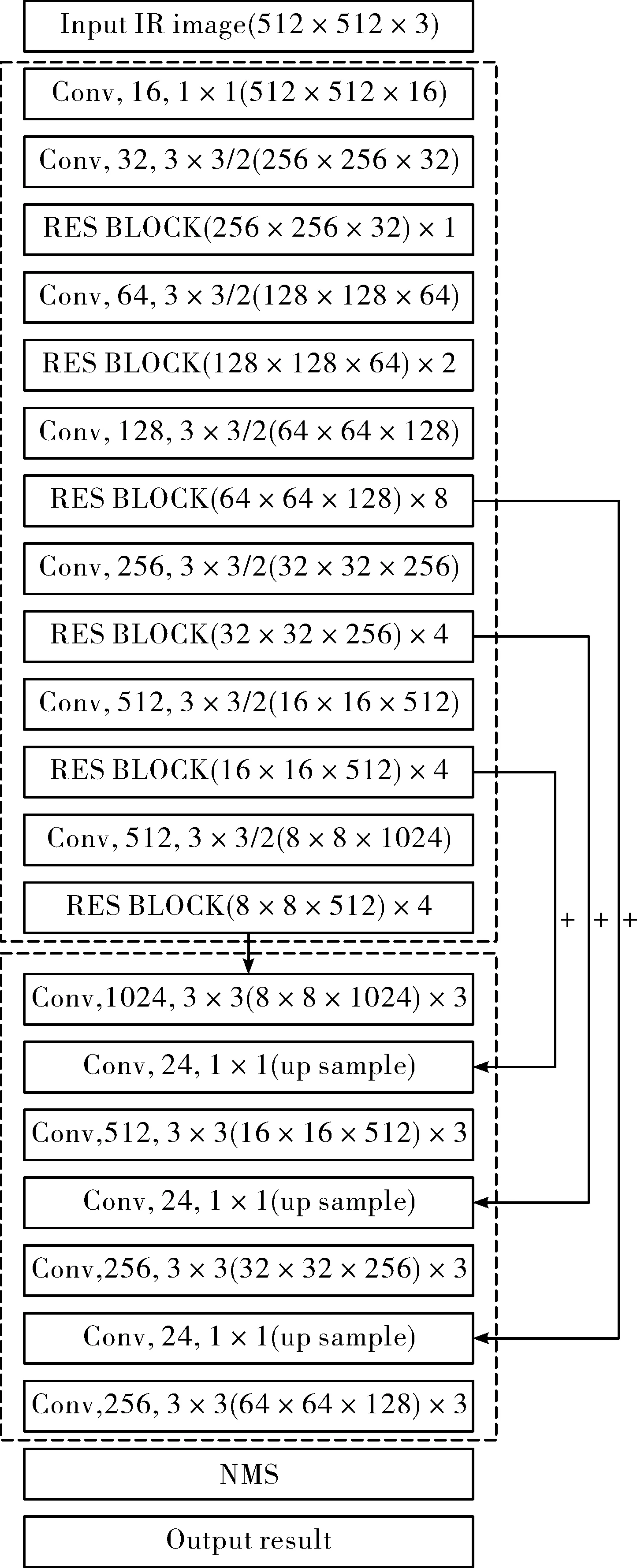

如圖2所示為用于低空無人機檢測識別的卷積神經網絡,分為殘差網絡和預測網絡。深度殘差網絡用兩層殘差的方式來提取紅外圖片中無人機目標的特征,而預測網絡則采用金字塔型的多尺度模型用于無人機目標的檢測識別。最后添加非極大值抑制NMS層剔除多次預測的結果,得到最終的檢測識別結果。

1)殘差網絡。圖2中第一個虛線框內表示的是殘差網絡的結構及參數設置。

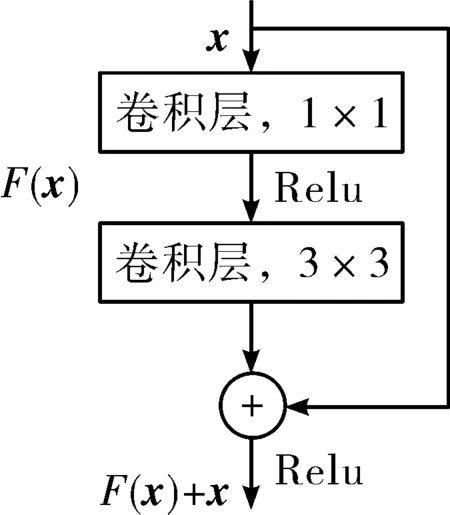

圖中主要組成為Conv塊與RES BLOCK塊。前者表示卷積過程,輸入層以512×512×3的紅外圖像為例,第一層用16個大小為3×3的卷積核進行卷積操作得到512×512×16的特征圖;然后將其輸入到第二層,用32個大小為3×3的卷積核進行步長為2的卷積,替代池化操作。后者表示殘差結構[6],主要由兩層卷積(1×1卷積層和3×3卷積層)與跳躍連接構成,輸出特征圖大小保持不變。具體結構示意圖如圖3所示,跳躍連接由帶加號的實線圓圈表示,其相應的公式如式(1)所示。

xl+1=xl+F(xl,Wl)

(1)

式中:xl和xl+1表示第l個殘差塊的輸入向量與輸出向量,F(xl,Wl)表示殘差結構中的轉換函數。

圖2 殘差網絡與預測網絡結構圖

之后的網絡結構由2、8、4、4和4組不同的殘差塊組成,并分別輸出128×128×64,64×64×128,32×32×256,16×16×512與8×8×1024大小的特征圖。這5組殘差塊都按上述結構組成,只有卷積核與特征圖的大小不同。除此之外,為加速訓練,在所有卷積層上添加了批歸一化層[7]與leakyReLu層。

圖3 殘差塊結構示意圖

2)預測網絡。預測網絡采用了金子塔型的多尺度模型,利用不同尺寸大小的特征圖對不同大小的無人機目標進行預測,使得結果更加準確,網絡結構由圖2中第二個虛線框內所示。多尺度模型結構由4種不同分辨的分支構成(8×8,16×16,32×32與64×64),每一個分支單獨對一類尺度的目標進行預測。且每個分支由3層對應分辨率的卷積層構成。為了提升模型對特征的表達,對于分辨率為16×16,32×32與64×64的分支,執行2倍大小的最近鄰上采樣。此外,為了提升檢測能力,結合上下文的語義信息,實現特征共享,將深度殘差網絡中對應大小的特征圖與這3個分支進行連接,圖中用加號表示。

在結果預測階段,將每幅紅外圖像劃分為4種不同大小的S×S(8,16,32與64)的單元格,每個單元預測3個大小不同的邊界框,每個邊界框對應3個目標類別、1個置信度及4個邊界框的偏移量,對應的張量可以表示為S×S×[3×(4+1+3)]。通過NMS后,將會得到一個模型預測結果。預測結果中目標置信度的計算如式(2)所示。

(2)

2.2 損失函數

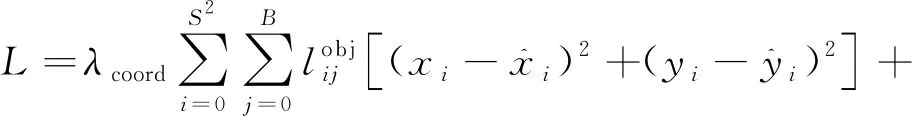

在對網絡進行訓練時,需要設置損失函數來進行不斷的優化。隨著訓練周期的加深,損失值越來越小,得到的模型性能逐漸增強。文中借鑒YOLO的損失函數,采用預測張量與圖像標簽的誤差值和均方值進行訓練的優化。由于沒有目標的單元格占大多數,因此設置不同的比例系數平衡有無目標存在的預測框之間差異性。同時,還引入類別判斷與邊界框偏移的損失系數,讓含有目標的邊界框損失系數具有較高的比例。具體的表達式如式(3)所示。

(3)

3 實驗及結果

3.1 紅外目標數據集

通常數據集多是可見光圖像,紅外源的數據集較少,且應用于無人機方面沒有大型公開的數據集。因此文中利用紅外探測器與3型民用無人機進行了紅外數據集的采集與構建。

1)數據的采集。設備選擇:紅外探測器選擇和普威視的紅外安防監控設備。無人機選擇常見的大疆系列無人機共3型,分別為大疆-精靈3、大疆-御PRO與大疆-S900。采集環境:考慮到安全性等因素,選擇白天不同時間段的學校操場、郊區工地等開闊地進行數據采集。同時,為進一步豐富數據樣本,采集了無人機飛行時的各種姿態,包括平穩飛行、急速升降、遠近飛行等。最終得到5 824張紅外圖像。

2)數據標注及擴增。對于采集的紅外圖像,需要進行標注標簽信息,3型無人機的標簽分別為:DJ-3、DJ-Pro和DJ-S900,標注方式采用手工標注。為確保采集樣本的有效性,對不完整的目標不進行標注。最終篩選出5 500張紅外圖像中的無人機目標,并對其進行邊界框及類別信息的標注。按4∶1的比例將帶有標簽的數據分為訓練集和測試集。

由于數據擴增有助于提升模型的檢測識別性能,因此對訓練數據進行隨機的數據增強操作以擴充樣本量。采用的方式包括亮度、對比度調整,圖像翻轉及±1°~20°的旋轉操作。如果經過處理后的圖像中有目標殘缺或完全丟失情況,則剔除該樣本。

3)紅外數據集構建。通過采集、處理及數據擴增后,紅外數據集中訓練集圖像包含30 000張圖像,測試集包含1 100張圖像。訓練集用于網絡的訓練,測試集用于訓練后模型性能的驗證。

3.2 訓練環境及參數設置

實驗選擇SSD、YOLOv2、YOLOv3方法與文中方法進行效果比較。實驗的環境如下:深度學習框架選擇Caffe與Darknet;服務器工作站配置為Ubuntu 18.04操作系統,Intel(R) Xeon(R) CPU E5-2673 v3 @ 2.40 GHz,搭載GeForce GTX 1080Ti/PCIe/SSE2顯卡,32 GB內存。

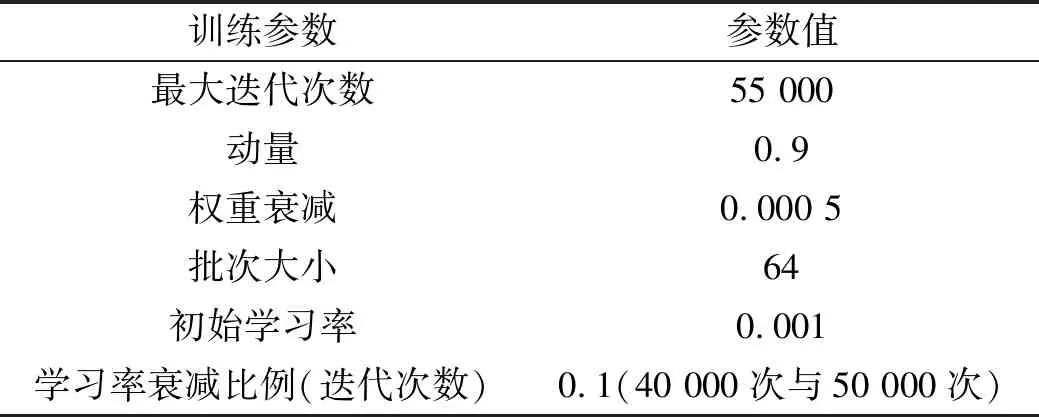

訓練過程中,每種方法的訓練參數設置相同。具體設置如表1所示。

表1 訓練參數設置

根據網絡的配置,需要設置4種尺度12個錨點進行匹配。通過K-means聚類方法[8]對紅外訓練集自動生成對應尺度的錨點,分別為:(20×12),(27×16),(34×22),(48×23),(53×32),(72×38),(98×54),(123×69),(152×81),(203×114),(256×156),(301×184),并且與真實框的平均重疊率為88.12%。

3.3 實驗結果與分析

通過利用測試集對不同的方法進行測試實驗,重點比較對不同類別低空無人機的檢測識別能力,并對結果進行評估分析。

在利用測試集進行實驗時,將紅外測試集圖像輸入訓練好的模型,進行結果預測。當目標的預測框與真實邊界框的IOU(交并比)≥0.5且目標類別判斷正確時,則結果正確,否則錯誤。同時,采用AP(average precision)值(單位:%)、mAP(mean average precision)值(單位:%)和檢測速度(單位:張/s)作為評價指標。該評價指標能較好地反映模型的召回率、準確率和實時性。最終,實驗結果如表2及圖4所示。

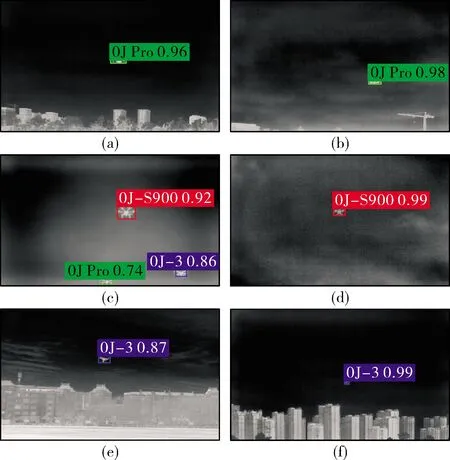

通過表2可以看出,文中方法在AP值與mAP值上都優于其他方法,mAP值達到了78.21%。因此,通過加深網絡結構,構建多尺度模型預測結果能夠提升檢測識別性能。隨著網絡深度的加深,參數量也有所增加,導致在檢測速度上有所下降,達到約28張/s,但仍具有實時檢測的水平。圖4展示了文中方法的部分測試結果。綠色方框為DJ-Pro,藍色方框為DJ-3,紅色方框為DJ-S900,類別右邊的數字為置信度。

表2 不同方法在不同測試集上的評價結果

圖4 文中方法的部分測試結果

4 結論

為降低無人機的低空威脅,提升對無人機的檢測識別能力,文中利用深度學習框架,構建了殘差網絡和預測網絡對紅外數據集進行訓練,并與其他常用的方法進行比較分析。通過殘差網絡提取無人機目標的深度特征使得網絡對無人機的表征能力得到了提升,同時預測網絡的多尺度模型結構與上下文語義信息相結合能夠較好地匹配不同尺寸的無人機目標,這樣使得訓練得到的模型在檢測性能上有較大的提升。雖然網絡深度的加深使得參數量增加,導致檢測速度上有所損失,但模型的整體檢測速度依然能夠維持較快水平。

此外,文中方法還存在一些未驗證的部分。例如,無人機類別數的增加對檢測識別會造成怎樣的影響;在夜間或光線昏暗環境下,無人機的紅外特性更加明顯,性能是否會提升,這些都是將來繼續深入研究的內容。